Helyszíni hálózat csatlakoztatása az Azure-hoz VPN-átjáró használatával

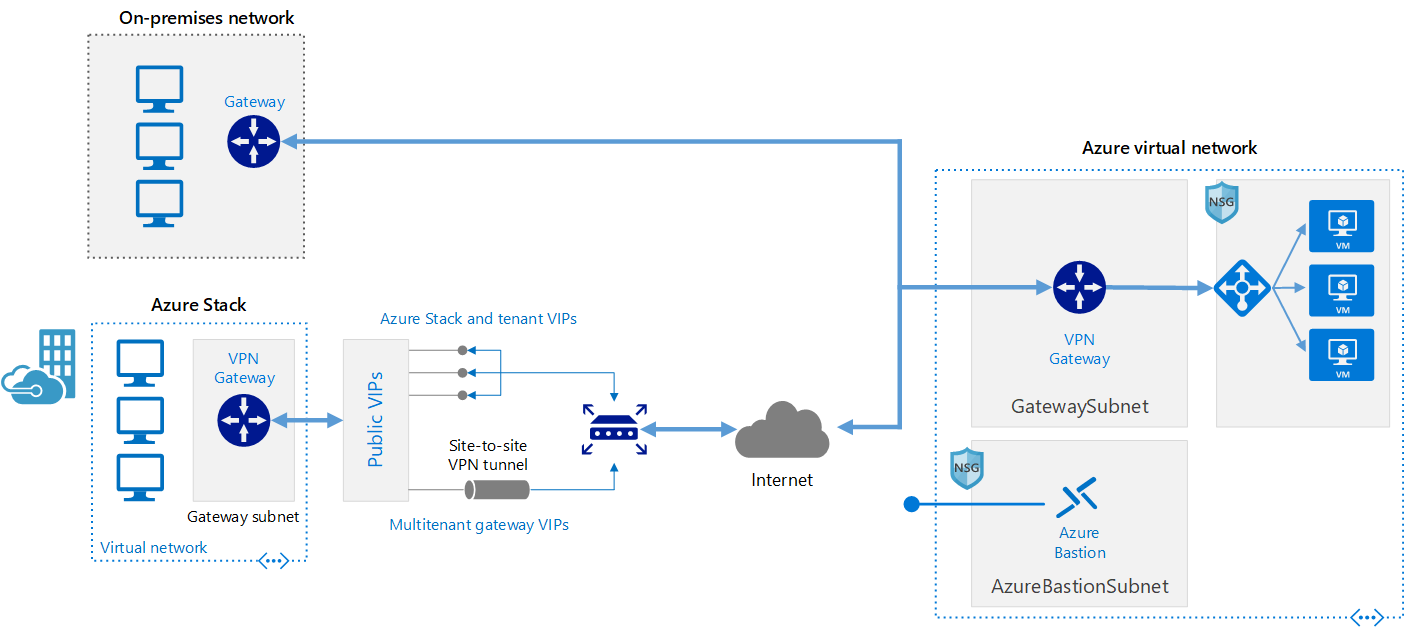

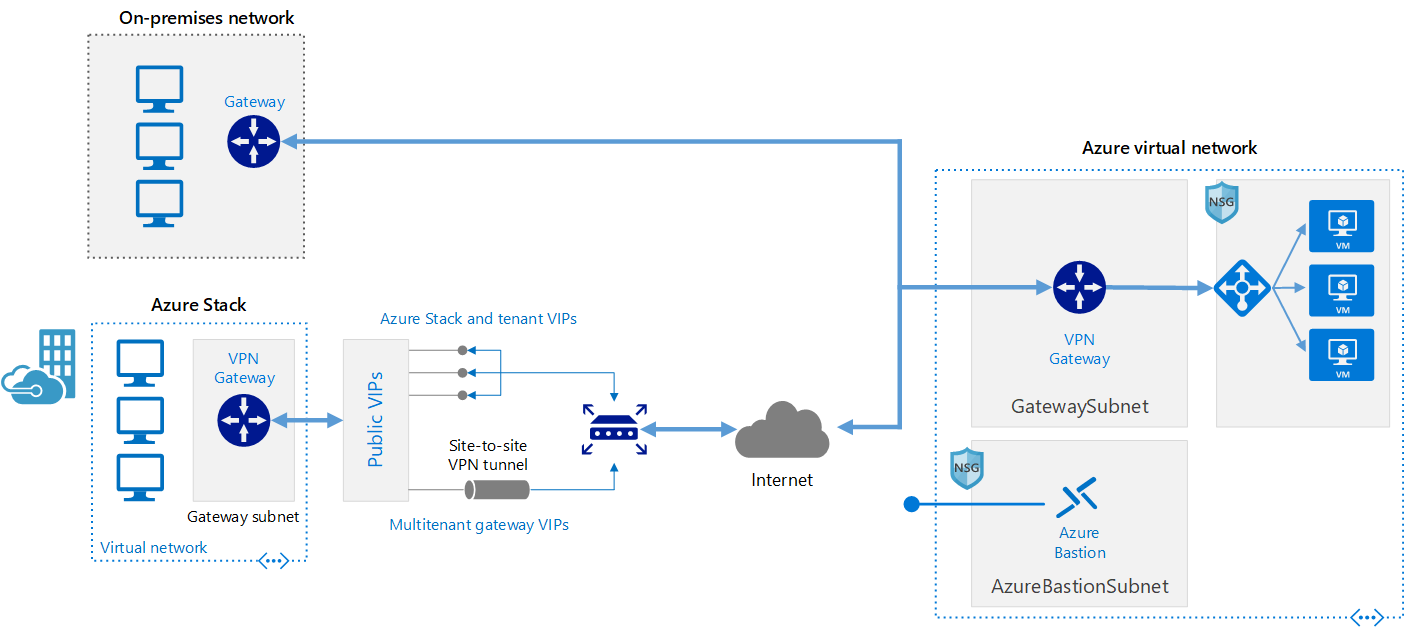

Ez a referenciaarchitektúra bemutatja, hogyan lehet kibővíteni a helyszíni hálózatot az Azure-ra helyek közötti virtuális magánhálózat (VPN) használatával.

Ezt a böngészőt már nem támogatjuk.

Frissítsen a Microsoft Edge-re, hogy kihasználhassa a legújabb funkciókat, a biztonsági frissítéseket és a technikai támogatást.

Megjegyzés

Az oldalhoz való hozzáféréshez engedély szükséges. Megpróbálhat bejelentkezni vagy módosítani a címtárat.

Az oldalhoz való hozzáféréshez engedély szükséges. Megpróbálhatja módosítani a címtárat.

A nagy teljesítményű számítástechnika (HPC), más néven "nagy számítási kapacitás" nagy számú PROCESSZOR- vagy GPU-alapú számítógépet használ összetett matematikai feladatok megoldásához.

Számos iparág használ HPC-t a legnehezebb problémák megoldásához. Ilyenek többek között a következő számítási feladatok:

A helyszíni HPC-rendszerek és a felhőbeli rendszerek közötti egyik elsődleges különbség az, hogy az erőforrások szükség esetén dinamikusan hozzáadhatók és eltávolíthatók. A dinamikus skálázás megszünteti a számítási kapacitás okozta szűk keresztmetszetet, és így lehetővé teszi, hogy az ügyfelek a feladataik követelményeinek megfelelően igazítsák az infrastruktúrájuk méretét.

A következő cikk további részleteket tartalmaz a dinamikus méretezési képességről.

Amikor saját HPC-megoldást tervez megvalósítani az Azure-on, mindenképpen tekintse át a következő témaköröket:

A HPC-rendszer létrehozásához számos infrastruktúra-összetevő szükséges. A számítás, a tárolás és a hálózatkezelés biztosítja a mögöttes összetevőket, függetlenül attól, hogy hogyan kezeli a HPC számítási feladatait.

Az Azure számos, nagy CPU- és GPU-igényű számítási feladatokhoz optimalizált méretet nyújt.

Az N-sorozatú virtuális gépeken NVIDIA GPU-k találhatók, amelyek nagy számítási igényű vagy nagy grafikai igényű alkalmazásokhoz vannak tervezve, például mesterséges intelligencia (AI) tanításához és vizualizációhoz.

A nagy méretű Batch és HPC számítási feladatok olyan adattárolási és hozzáférési igényekkel rendelkeznek, amelyek meghaladják a hagyományos felhőalapú fájlrendszerek képességeit. Az Azure-beli HPC-alkalmazások sebesség- és kapacitásigényét számos megoldás kezeli:

A Lustre, a GlusterFS és a BeeGFS összehasonlításáról az Azure-on további információért tekintse át az Azure-beli párhuzamos fájlrendszerek e-könyvet és az Azure Lustre blogot.

A H16r, H16mr, A8 és A9 virtuális gépek magas teljesítményű, háttérben futó RDMA-hálózathoz csatlakozhatnak. Ez a hálózat javíthatja a Microsoft Message Passing Interface vagy más néven MPI vagy Intel MPI alatt futó, szorosan összekapcsolt párhuzamos alkalmazások teljesítményét.

A HPC-rendszer létrehozása az Alapoktól az Azure-ban jelentős rugalmasságot biztosít, de gyakran nagyon nagy karbantartási igényű.

Ha rendelkezik egy meglévő helyszíni HPC-rendszerrel, amelyet az Azure-hoz szeretne csatlakoztatni, számos erőforrás áll rendelkezésre az első lépésekhez.

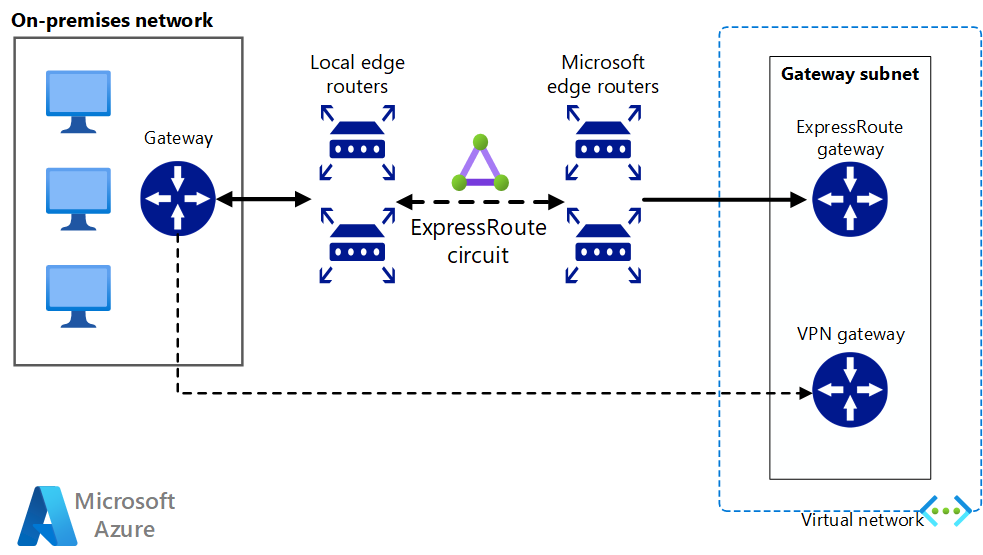

Először tekintse át a dokumentáció A helyszíni hálózat Azure-hoz való csatlakoztatásának lehetőségei című cikkét. Innen további információkat találhat a következő csatlakozási lehetőségekről:

Ez a referenciaarchitektúra bemutatja, hogyan lehet kibővíteni a helyszíni hálózatot az Azure-ra helyek közötti virtuális magánhálózat (VPN) használatával.

Egy helyek közötti, magas rendelkezésre állású és biztonságos hálózati architektúrát építhet ki, amely a VPN-átjáróval feladatátvételt biztosító ExpressRoute használatával összekapcsolt Azure-beli virtuális hálózatból és helyszíni hálózatból áll.

A hálózati kapcsolat biztonságos létrejötte után megkezdheti a felhőalapú számítási erőforrások igény szerinti használatát a meglévő számításifeladat-kezelő teljesítménynövelési képességeivel.

Az Azure Marketplace-en számos számítási feladatkezelő érhető el.

Az Azure Batch egy platformszolgáltatás, amely nagy léptékű párhuzamos és HPC-alkalmazásokat futtat hatékonyan a felhőben. Az Azure Batch számításigényes munkák futtatását ütemezi virtuális gépek felügyelt készletében, és automatikusan képes méretezni a számítási erőforrásokat a feladatok igényeinek megfelelően.

A SaaS-szolgáltatók vagy -fejlesztők a Batch SDK-kal és -eszközökkel HPC-alkalmazásokat vagy tárolókhoz kapcsolódó számítási feladatokat integrálhatnak az Azure-ral, adatokat bocsáthatnak rendelkezésre az Azure-ba, valamint feladat-végrehajtási folyamatokat hozhatnak létre.

Az Azure Batchben az összes szolgáltatás a felhőben fut, az alábbi képen látható, hogyan néz ki az architektúra az Azure Batchtel, és a felhőben futnak a méretezhetőségi és feladatütemezési konfigurációk, miközben az eredmények és jelentések elküldhetők a helyszíni környezetbe.

Az Azure CycleCloud nyújtja a legegyszerűbb módszert a HPC számítási feladatok bármilyen ütemezővel (például Slurm, Grid Engine, HPC Pack, HTCondor, LSF, PBS Pro vagy Symphony) történő kezelésére az Azure-ban.

A CycleCloud a következőket teszi lehetővé:

Ebben a hibrid példadiagramban világosan látható, hogyan oszlanak el ezek a szolgáltatások a felhő és a helyszíni környezet között. Lehetőség van feladatok futtatására mindkét munkaterhelésben.

Az alábbi natív felhőmodell-diagram bemutatja, hogy a felhőbeli számítási feladatok hogyan fognak mindent kezelni, miközben továbbra is fenntartják a kapcsolatot a helyszíni környezettel.

| Funkció | Azure Batch (felhőalapú erőforrás-kezelés) | Azure CycleCloud |

|---|---|---|

| Ütemező | Batch API-k és eszközök és parancssori szkriptek az Azure Portalon (Cloud Native). | Használjon szabványos HPC ütemezőket, például Slurm, PBS Pro, LSF, Grid Engine és HTCondor, vagy bővítse ki a CycleCloud automatikus skálázási beépülő moduljait a saját ütemezőjével való együttműködéshez. |

| Számítási erőforrások | Szoftverszolgáltatási csomópontok – Platforms szolgáltatásként | Platform mint szolgáltatási szoftver – Platform mint szolgáltatás |

| Monitorozási eszközök | Azure Monitor | Azure Monitor, Grafana |

| Testreszabás | Egyéni képkészletek, harmadik fél képei, Batch API-hozzáférés. | Az átfogó RESTful API használatával testre szabhatja és kibővítheti a funkciókat, üzembe helyezheti saját ütemezőjét, és támogatást használhat a meglévő számítási feladatok kezelőiben |

| Integráció | Synapse Pipelines, Azure Data Factory, Azure CLI | Beépített parancssori felület Windowshoz és Linuxhoz |

| Felhasználó típusa | Fejlesztők | Klasszikus HPC-rendszergazdák és -felhasználók |

| Munkatípus | Tétel, Munkafolyamatok | Szorosan összekapcsolt (Message Passing Interface/MPI). |

| Windows-támogatás | Igen | Változó, az ütemező választásától függően |

Az alábbiakban néhány példa látható az Azure-infrastruktúrában futtatható fürt- és számításifeladat-kezelőkre. Önálló fürtöket hozhat létre az Azure-beli virtuális gépeken, vagy ideiglenes bővítést végezhet rájuk egy helyszíni fürtből.

Néhány HPC számítási feladat kezeléséhez tárolók is használhatók. Az Azure Kubernetes Service-hez (AKS) hasonló szolgáltatásokkal egyszerűen helyezhetők üzembe a felügyelt Kubernetes-fürtök az Azure-ban.

A HPC költségeinek kezelése az Azure-on különböző módokon végezhető el. Mindenképpen tekintse át az Azure vásárlási lehetőségeit a cégének legmegfelelőbb módszer kiválasztásához.

Az Azure ajánlott biztonsági eljárásait az Azure Security dokumentációjában találja.

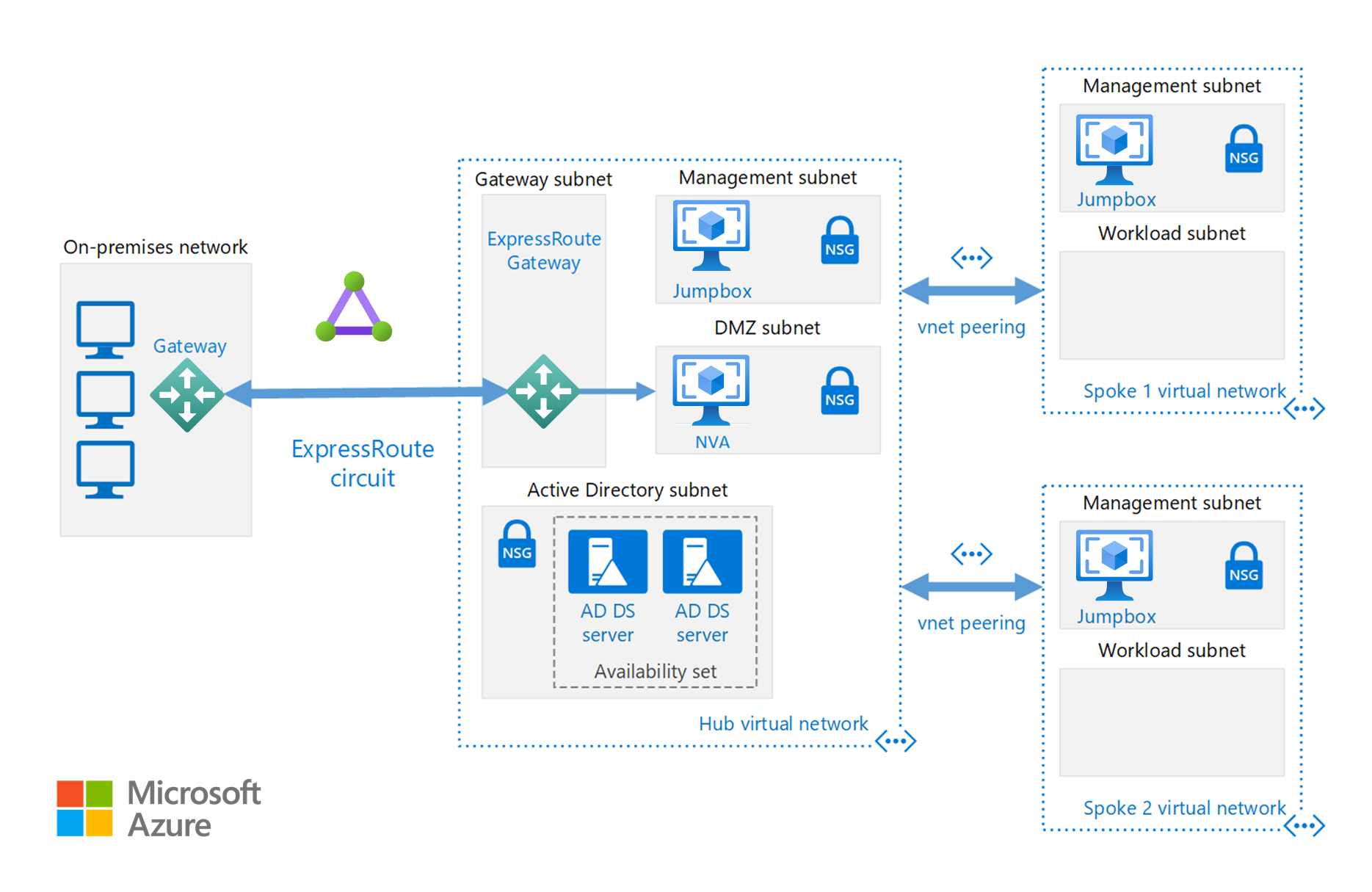

A Cloud Bursting szakaszban elérhető hálózati konfigurációkon kívül egy küllős konfigurációt is implementálhat a számítási erőforrások elkülönítéséhez:

Az Azure-ban lévő központ egy virtuális hálózat (VNet), amely központi kapcsolódási pontként szolgál a helyi hálózathoz. A küllők olyan VNets, amelyek a központhoz kapcsolódnak, és a számítási feladatok elkülönítésére használhatók.

Ez a referenciaarchitektúra az elosztó-küllő referenciaarchitektúrára épül, hogy az elosztóban lévő megosztott szolgáltatások az összes küllő által használhatók legyenek.

Egyéni vagy kereskedelmi HPC-alkalmazások futtatása az Azure-ban. Az ebben a szakaszban szereplő számos példa tesztelve lett, hogy hatékonyan lehessen méretezni további virtuális gépekkel vagy számítási magokkal. Az Azure Marketplace-en üzembe helyezésre kész megoldásokat talál.

Feljegyzés

Minden kereskedelmi alkalmazás szállítójánál érdeklődjön a felhőbeli futtatásra vonatkozó licencelési vagy egyéb korlátozásokról. Nem minden szolgáltató kínál használatalapú elszámolású licencet. Lehet, hogy a megoldásához licenckiszolgálót kell használnia a felhőben, vagy helyszíni licenckiszolgálóhoz kell csatlakoznia.

Futtassa a GPU-alapú virtuális gépeket az Azure-ban a HPC-kimenettel megegyező régióban a legalacsonyabb késés, hozzáférés és távoli vizualizáció érdekében az Azure Virtual Desktopon keresztül.

Sok olyan ügyfél van, aki nagy sikert aratott azzal, hogy az Azure-t használja a HPC számítási feladataihoz. Az alábbiakban néhány ilyen ügyfél esettanulmányát láthatja:

A legújabb bejelentésekért tekintse meg a következő erőforrásokat:

Ezek az oktatóanyagok részletesen ismertetik az alkalmazások Microsoft Batch-en való futtatását: