Mi az az Apache Spark-számítás a Microsoft Fabricben?

A következőkre vonatkozik: adatmérnök és Adattudomány a Microsoft Fabricben

A Microsoft Fabric adatmérnök és Adattudomány élménye teljes mértékben felügyelt Apache Spark számítási platformon működik. Ez a platform páratlan sebességet és hatékonyságot biztosít. A kezdőkészletekkel az Apache Spark-munkamenetek gyors inicializálására számíthat, általában 5–10 másodpercen belül, manuális beállítás nélkül. Emellett rugalmasan testre szabhatja az Apache Spark-készleteket a konkrét adatelemzési és adatelemzési követelményeknek megfelelően. A platform optimalizált és testre szabott elemzési élményt tesz lehetővé.

Kezdőkészletek

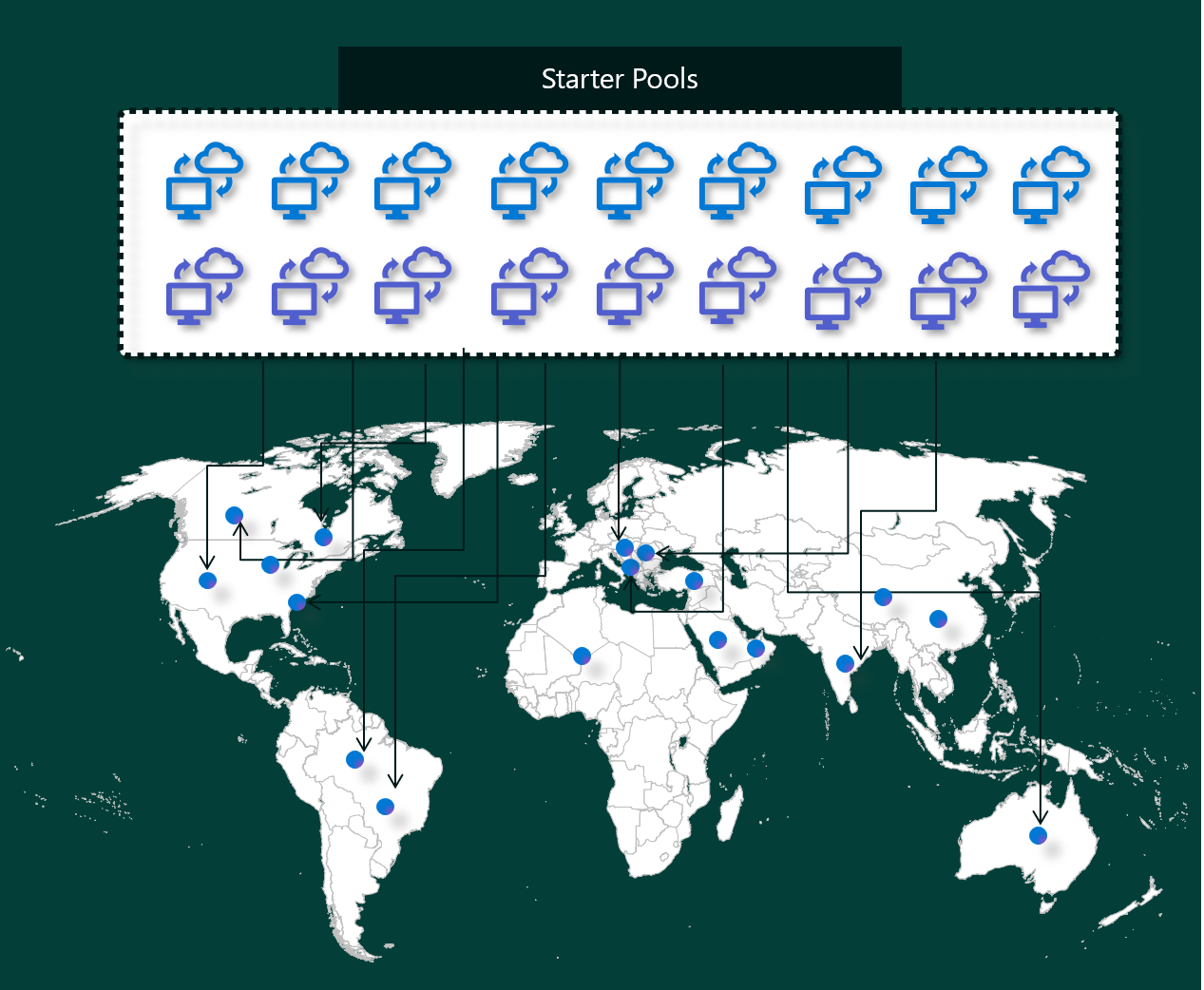

A kezdőkészletek gyors és egyszerű módot jelentenek a Spark másodpercek alatt történő használatára a Microsoft Fabric platformon. A Spark-munkameneteket azonnal használhatja ahelyett, hogy megvárja, amíg a Spark beállítja Önnek a csomópontokat, ami segít az adatokkal való további műveletekben és az elemzések gyorsabb lekérésében.

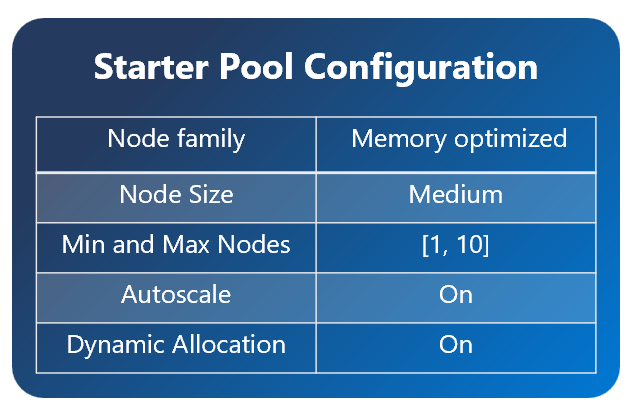

A kezdőkészletek olyan Apache Spark-fürtökkel rendelkeznek, amelyek mindig be vannak kapcsolva, és készen állnak a kérésekre. Közepes csomópontokat használnak, amelyek dinamikusan felskálázhatók a Spark-feladat igényeinek megfelelően.

A kezdőkészletek olyan alapértelmezett beállításokkal is rendelkeznek, amelyek lehetővé teszik a tárak gyors telepítését anélkül, hogy lelassítanák a munkamenet kezdési idejét. Ha azonban további egyéni Apache Spark-tulajdonságokat vagy tárakat szeretne használni a munkaterület vagy a kapacitás beállításai közül, a Spark több időt vesz igénybe a csomópontok beszerzéséhez. Ha a számlázásról és a kapacitáshasználatról van szó, a notebook vagy az Apache Spark-feladatdefiníció végrehajtásakor a kapacitáshasználatért kell fizetnie. A rendszer nem számít fel díjat arra az időre, amikor a fürtök tétlenek a készletben.

Ha például elküld egy jegyzetfüzetfeladatot egy kezdőkészletbe, a rendszer csak arra az időszakra számítja fel a díjat, amelyben a jegyzetfüzet-munkamenet aktív. A számlázott idő nem tartalmazza az üresjárati időt vagy a munkamenet Spark-környezettel való személyre szabásához szükséges időt.

Spark-készletek

A Spark-készlet segítségével meg lehet mondani a Sparknak, hogy milyen típusú erőforrásokra van szüksége az adatelemzési feladatokhoz. Megadhat egy nevet a Spark-készletnek, és kiválaszthatja, hogy hány csomópont és mekkora a csomópontok (a munkát végező gépek) száma. Azt is megmondhatja a Sparknak, hogyan módosíthatja a csomópontok számát attól függően, hogy mennyi munkája van. A Spark-készlet létrehozása ingyenes; Csak akkor kell fizetnie, ha Spark-feladatot futtat a készleten, majd a Spark beállítja Önnek a csomópontokat.

Ha a munkamenet lejárta után 2 percig nem használja a Spark-készletet, a Spark-készlet felszabadítva lesz. Ez az alapértelmezett munkamenet-lejárati idő 20 percre van beállítva, és tetszés szerint módosíthatja. Ha Ön munkaterület-rendszergazda, egyéni Spark-készleteket is létrehozhat a munkaterülethez, és beállíthatja őket az alapértelmezett beállításként más felhasználók számára. Így időt takaríthat meg, és elkerülheti az új Spark-készlet beállítását minden alkalommal, amikor jegyzetfüzetet vagy Spark-feladatot futtat. Az egyéni Spark-készletek indítása körülbelül három percet vesz igénybe, mivel a Sparknak le kell szereznie a csomópontokat az Azure-ból.

Akár egyetlen csomópontos Spark-készleteket is létrehozhat, ha a csomópontok minimális számát egyre állítja, így az illesztőprogram és a végrehajtó egyetlen csomóponton fut, amely visszaállítható HA-val rendelkezik, és kis számítási feladatokhoz alkalmas.

Az egyéni Spark-készletben elérhető csomópontok mérete és száma a Microsoft Fabric-kapacitástól függ. A kapacitás annak mértéke, hogy mennyi számítási teljesítményt használhat az Azure-ban. Ennek egyik módja, hogy két Apache Spark virtuális mag (a Spark számítási teljesítménye) egy kapacitásegységnek felel meg. Egy hálókapacitásÚ F64 termékváltozat például 64 kapacitásegységből áll, ami 128 Spark virtuális magnak felel meg. Ezekkel a Spark virtuális magokkal különböző méretű csomópontokat hozhat létre az egyéni Spark-készlethez, feltéve, hogy a Spark virtuális magok teljes száma nem haladja meg a 128-at.

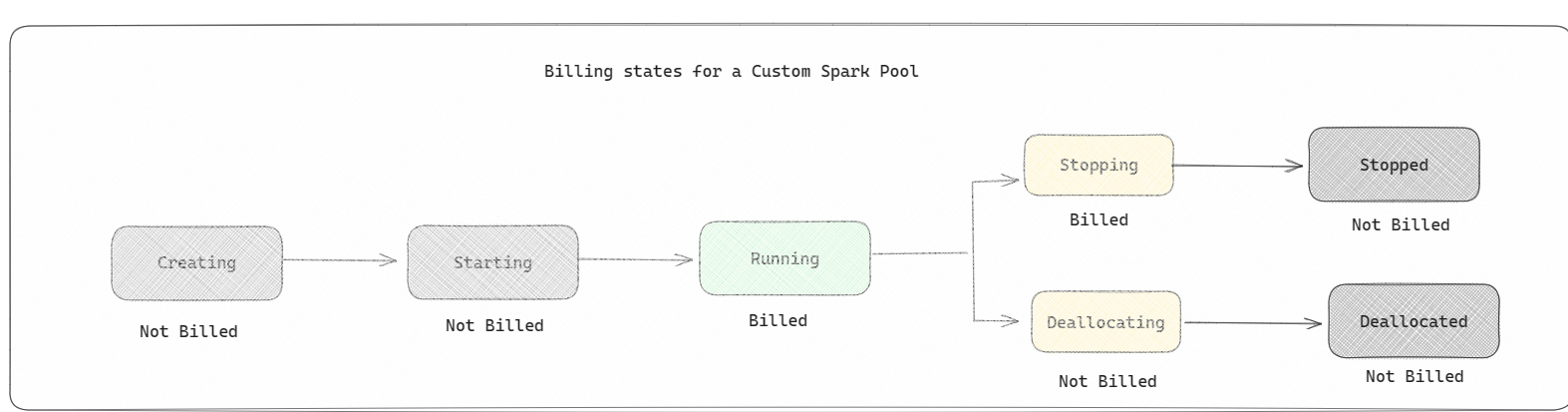

A Spark-készletek számlázása kezdőkészletekhez hasonlóan van kiszámlázva; a létrehozott egyéni Spark-készletekért csak akkor kell fizetnie, ha aktív Spark-munkamenetet hozott létre jegyzetfüzet vagy Spark-feladatdefiníció futtatásához. A számlázás csak a feladatfuttatások időtartamára vonatkozik. A feladat befejezése után nem kell fizetnie az olyan szakaszokért, mint a fürt létrehozása és felszabadítása.

Ha például egy jegyzetfüzet-feladatot egy egyéni Spark-készletbe küld, akkor csak arra az időszakra számítunk fel díjat, amikor a munkamenet aktív. A jegyzetfüzet-munkamenet számlázása leáll, ha a Spark-munkamenet leállt vagy lejárt. Nem kell fizetnie a fürtpéldányok felhőből való beszerzéséhez vagy a Spark-környezet inicializálásához szükséges időért.

Az F64 lehetséges egyéni készletkonfigurációi az előző példa alapján:

| Hálókapacitás termékváltozata | Kapacitásegységek | Spark virtuális magok | Csomópont mérete | Csomópontok maximális száma |

|---|---|---|---|---|

| F64 | 64 | 384 | Small | 96 |

| F64 | 64 | 384 | Közepes | 48 |

| F64 | 64 | 384 | Nagy | 24 |

| F64 | 64 | 384 | X-Nagy | 12 |

| F64 | 64 | 384 | XX-nagy | 6 |

Feljegyzés

Egyéni készletek létrehozásához rendszergazdai engedélyekre van szükség a munkaterülethez. A Microsoft Fabric kapacitásadminisztrátorának pedig engedélyeket kell adnia ahhoz, hogy a munkaterület rendszergazdái méretezzék az egyéni Spark-készleteiket. További információ: Ismerkedés az egyéni Spark-készletekkel a Fabricben

Csomópontok

Az Apache Spark-készletpéldányok egy fő csomópontból és feldolgozó csomópontból állnak, és legalább egy csomópontot elindíthatnak egy Spark-példányban. A fő csomópont olyan további felügyeleti szolgáltatásokat futtat, mint a Livy, a Yarn Resource Manager, a Zookeeper és az Apache Spark-illesztőprogram. Minden csomópont olyan szolgáltatásokat futtat, mint a Node Agent és a Yarn Node Manager. Minden munkavégző csomópont futtatja az Apache Spark-végrehajtó szolgáltatást.

Csomópontméretek

A Spark-készlet olyan csomópontméretekkel határozható meg, amelyek egy kis számítási csomóponttól (4 virtuális mag és 28 GB memória) egy dupla extra nagy számítási csomópontig terjednek (csomópontonként 64 virtuális maggal és 400 GB memóriával). A csomópontméretek a készlet létrehozása után módosíthatók, bár az aktív munkamenetet újra kell indítani.

| Méret | virtuális mag | Memory (Memória) |

|---|---|---|

| Small | 4 | 28 GB |

| Közepes | 8 | 56 GB |

| Nagy | 16 | 112 GB |

| X-Nagy | 32 | 224 GB |

| XX-nagy | 64 | 400 GB |

Automatikus méretezés

Az Apache Spark-készletek automatikus méretezése lehetővé teszi a számítási erőforrások automatikus fel- és leskálázását a tevékenység mennyisége alapján. Az automatikus skálázási funkció engedélyezésekor meg kell adnia a skálázható csomópontok minimális és maximális számát. Az automatikus skálázási funkció letiltásakor a beállított csomópontok száma változatlan marad. Ezt a beállítást a készlet létrehozása után módosíthatja, bár előfordulhat, hogy újra kell indítania a példányt.

Feljegyzés

Alapértelmezés szerint a spark.yarn.executor.decommission.enabled értéke igaz, ami lehetővé teszi a kihasználatlan csomópontok automatikus leállítását a számítási hatékonyság optimalizálása érdekében. Ha a kevésbé agresszív skálázást részesíti előnyben, ez a konfiguráció hamis értékre állítható be

Dinamikus lefoglalás

A dinamikus kiosztás lehetővé teszi, hogy az Apache Spark-alkalmazás több végrehajtót kérjen, ha a feladatok túllépik az aktuális végrehajtók által viselhető terhelést. Emellett a végrehajtókat is felszabadítja a feladatok befejezésekor, és ha a Spark-alkalmazás üresjárati állapotba kerül. A vállalati felhasználók gyakran nehezen hangolhatják a végrehajtó konfigurációit, mert a Spark-feladatok végrehajtási folyamatának különböző szakaszaiban jelentősen eltérnek. Ezek a konfigurációk a feldolgozott adatok mennyiségétől is függnek, amelyek időről időre változnak. A készletkonfiguráció részeként engedélyezheti a végrehajtók dinamikus lefoglalását, amely lehetővé teszi a végrehajtók automatikus lefoglalását a Spark-alkalmazásba a Spark-készletben elérhető csomópontok alapján.

Ha minden elküldött Spark-alkalmazáshoz engedélyezi a dinamikus lefoglalási beállítást, a rendszer a feladatbeküldési lépés során a maximális csomópontok alapján lefoglalja a végrehajtókat. Megadhatja a maximális csomópontokat a sikeres automatikus méretezési forgatókönyvek támogatásához.

Kapcsolódó tartalom

Visszajelzés

Hamarosan elérhető: 2024-ben fokozatosan kivezetjük a GitHub-problémákat a tartalom visszajelzési mechanizmusaként, és lecseréljük egy új visszajelzési rendszerre. További információ: https://aka.ms/ContentUserFeedback.

Visszajelzés küldése és megtekintése a következőhöz: