Adatok olvasása és írása a Pandas használatával a Microsoft Fabricben

A Microsoft Fabric-jegyzetfüzetek támogatják a Lakehouse-adatokkal való zökkenőmentes interakciót a Pandas használatával, amely a legnépszerűbb Python-kódtár az adatfeltáráshoz és -feldolgozáshoz. A jegyzetfüzetekben gyorsan olvashat adatokat, és adatokat írhat vissza a Lakehouse-erőforrásaikba különböző fájlformátumokban. Ez az útmutató kódmintákat tartalmaz a saját jegyzetfüzet használatának megkezdéséhez.

Előfeltételek

Microsoft Fabric-előfizetés lekérése. Vagy regisztráljon egy ingyenes Microsoft Fabric-próbaverzióra.

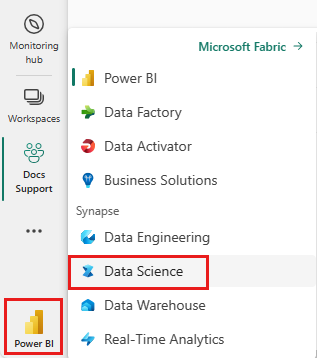

A kezdőlap bal oldalán található élménykapcsolóval válthat a Synapse Adattudomány felületre.

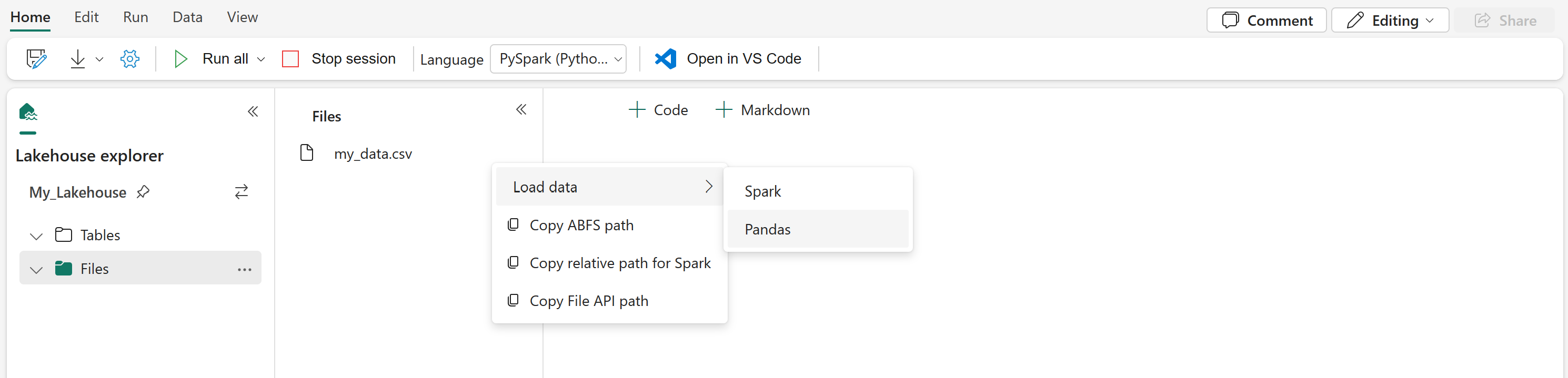

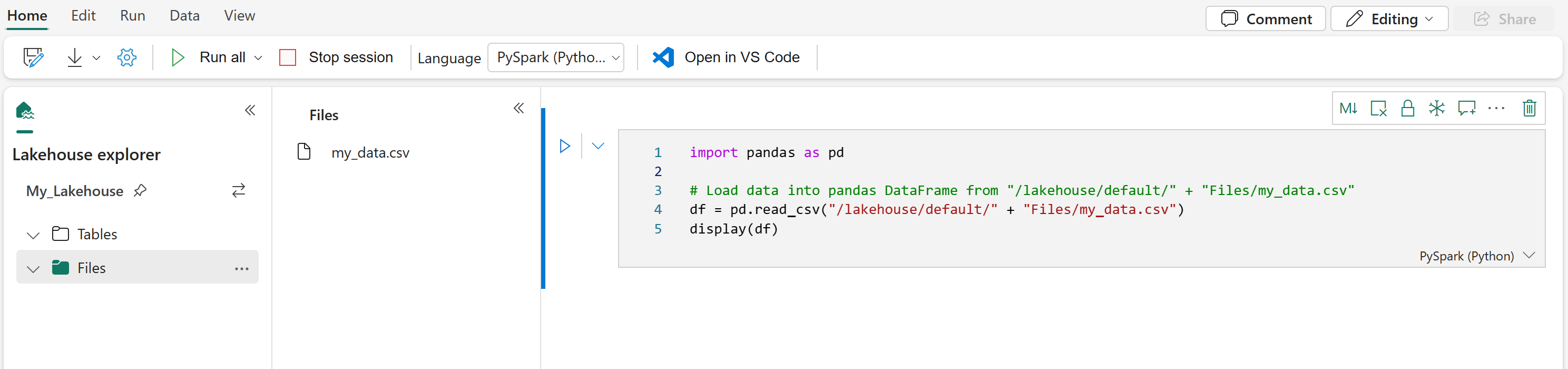

Lakehouse-adatok betöltése jegyzetfüzetbe

Miután csatlakoztatta a Lakehouse-t a Microsoft Fabric-jegyzetfüzethez, anélkül vizsgálhatja meg a tárolt adatokat, hogy elhagyná a lapot, és elolvasná őket a jegyzetfüzetbe, mindezt néhány lépéssel. Bármely Lakehouse-fájlfelület kiválasztása az adatok Sparkba vagy Pandas DataFrame-be való betöltéséhez. A fájl teljes ABFS-elérési útját vagy egy rövid relatív elérési utat is átmásolhatja.

Az "Adatok betöltése" parancsok egyikének kiválasztása egy kódcellát hoz létre, amely betölti a fájlt egy DataFrame-be a jegyzetfüzetben.

Spark DataFrame konvertálása Pandas DataFrame-gé

Ebből a parancsból megtudhatja, hogyan konvertálhat Spark DataFrame-et Pandas DataFrame-gé:

# Replace "spark_df" with the name of your own Spark DataFrame

pandas_df = spark_df.toPandas()

Különböző fájlformátumok olvasása és írása

Ezek a kódminták ismertetik a Pandas különböző fájlformátumok olvasására és írására vonatkozó műveleteit.

Feljegyzés

Ezekben a kódmintákban a fájl elérési útjait kell lecserélni. A Pandas mindkét relatív elérési utat támogatja az itt látható módon, valamint a teljes ABFS-útvonalakat. Bármelyik típusú elérési út lekérhető és másolható a felületről az előző lépésnek megfelelően.

Adatok olvasása CSV-fájlból

import pandas as pd

# Read a CSV file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pd.read_csv("/LAKEHOUSE_PATH/Files/FILENAME.csv")

display(df)

Adatok írása CSV-fájlként

import pandas as pd

# Write a Pandas DataFrame into a CSV file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_csv("/LAKEHOUSE_PATH/Files/FILENAME.csv")

Adatok olvasása Parquet-fájlból

import pandas as pd

# Read a Parquet file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pandas.read_parquet("/LAKEHOUSE_PATH/Files/FILENAME.parquet")

display(df)

Adatok írása Parquet-fájlként

import pandas as pd

# Write a Pandas DataFrame into a Parquet file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_parquet("/LAKEHOUSE_PATH/Files/FILENAME.parquet")

Adatok olvasása Excel-fájlból

import pandas as pd

# Read an Excel file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pandas.read_excel("/LAKEHOUSE_PATH/Files/FILENAME.xlsx")

display(df)

Adatok írása Excel-fájlként

import pandas as pd

# Write a Pandas DataFrame into an Excel file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_excel("/LAKEHOUSE_PATH/Files/FILENAME.xlsx")

Adatok olvasása JSON-fájlból

import pandas as pd

# Read a JSON file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pandas.read_json("/LAKEHOUSE_PATH/Files/FILENAME.json")

display(df)

Adatok írása JSON-fájlként

import pandas as pd

# Write a Pandas DataFrame into a JSON file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_json("/LAKEHOUSE_PATH/Files/FILENAME.json")

Kapcsolódó tartalom

- Adatok megtisztításához és előkészítéséhez használja a Data Wranglert

- Gépi tanulási modellek betanítása

Visszajelzés

Hamarosan elérhető: 2024-ben fokozatosan kivezetjük a GitHub-problémákat a tartalom visszajelzési mechanizmusaként, és lecseréljük egy új visszajelzési rendszerre. További információ: https://aka.ms/ContentUserFeedback.

Visszajelzés küldése és megtekintése a következőhöz: