Bagaimana cara kerja Manajer Orkestrasi Alur Kerja Azure Data Factory?

BERLAKU UNTUK: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tip

Cobalah Data Factory di Microsoft Fabric, solusi analitik all-in-one untuk perusahaan. Microsoft Fabric mencakup semuanya mulai dari pergerakan data hingga ilmu data, analitik real time, kecerdasan bisnis, dan pelaporan. Pelajari cara memulai uji coba baru secara gratis!

Catatan

Workflow Orchestration Manager didukung oleh Apache Airflow.

Catatan

Workflow Orchestration Manager untuk Azure Data Factory bergantung pada aplikasi apache Airflow sumber terbuka. Dokumentasi dan tutorial lainnya untuk Airflow dapat ditemukan di halaman Dokumentasi atau Komunitas Apache Airflow.

Workflow Orchestration Manager di Azure Data Factory menggunakan Directed Acyclic Graphs (DAG) berbasis Python untuk menjalankan alur kerja orkestrasi Anda. Untuk menggunakan fitur ini, Anda perlu menyediakan DAG dan plugin Anda di Azure Blob Storage. Anda dapat meluncurkan UI Airflow dari ADF menggunakan antarmuka baris perintah (CLI) atau kit pengembangan perangkat lunak (SDK) untuk mengelola DAG Anda.

Membuat lingkungan Workflow Orchestration Manager

Langkah-langkah berikut menyiapkan dan mengonfigurasi lingkungan Workflow Orchestration Manager Anda.

Prasyarat

Langganan Azure: Jika Anda tidak memiliki langganan Azure, buat akun gratis sebelum memulai. Buat atau pilih Data Factory yang sudah ada di wilayah tempat pratinjau Workflow Orchestration Manager didukung.

Langkah-langkah untuk membuat lingkungan

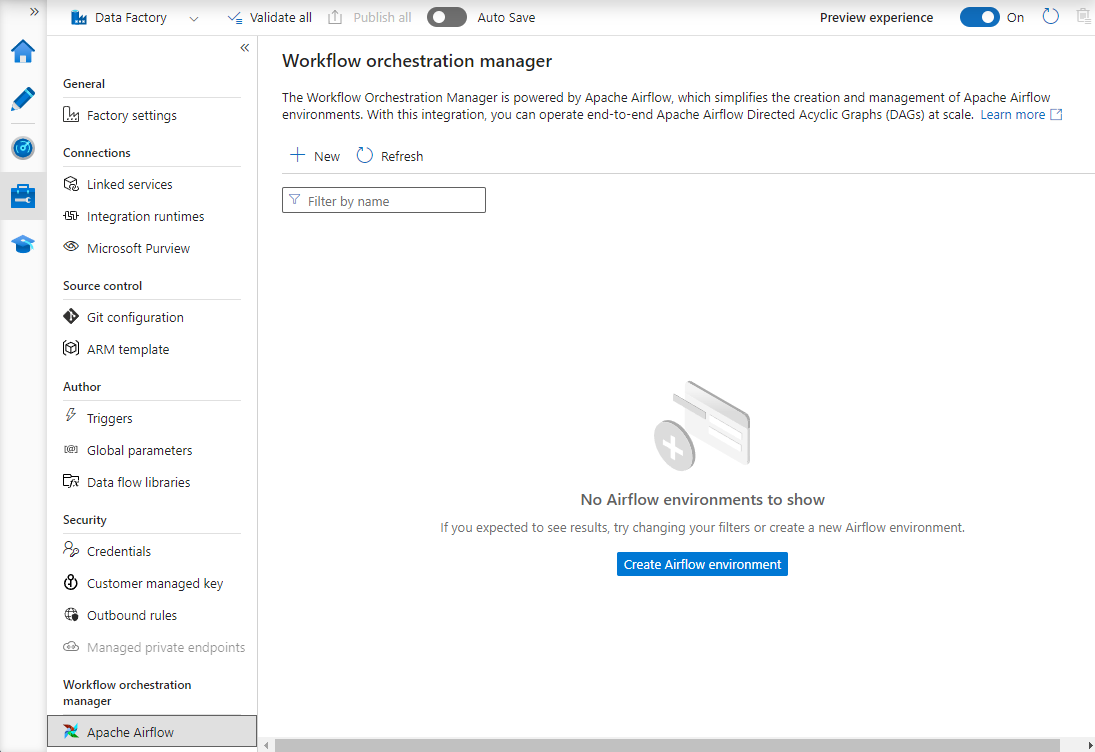

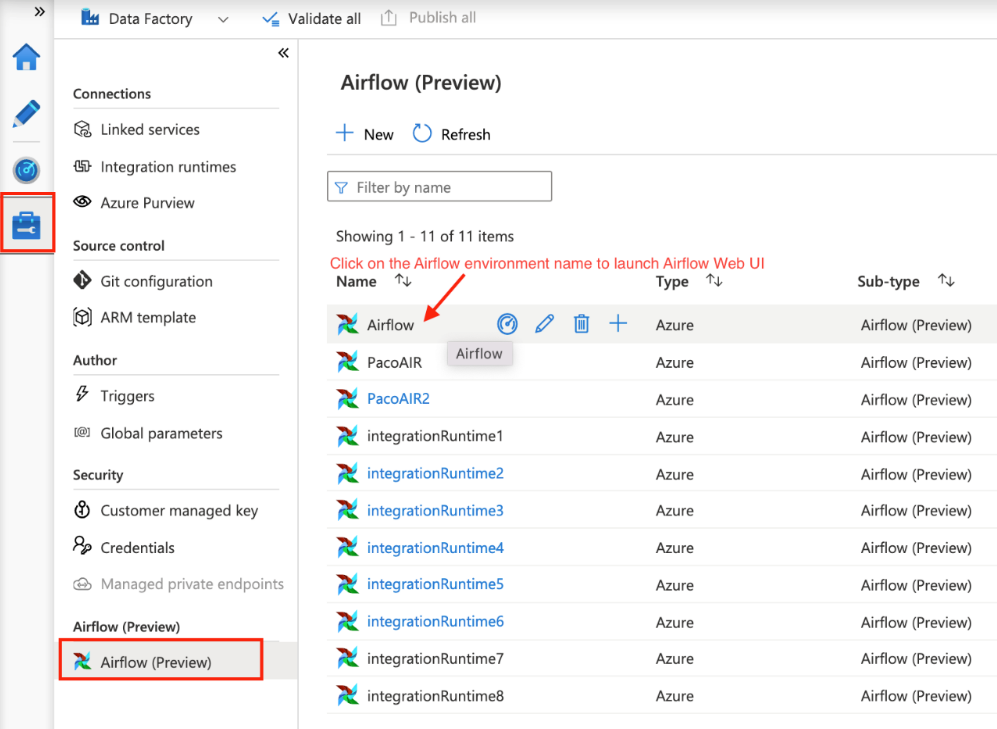

Buat lingkungan Workflow Orchestration Manager baru. Buka Kelola hub ->Airflow (Pratinjau) ->+Baru untuk membuat lingkungan Airflow baru

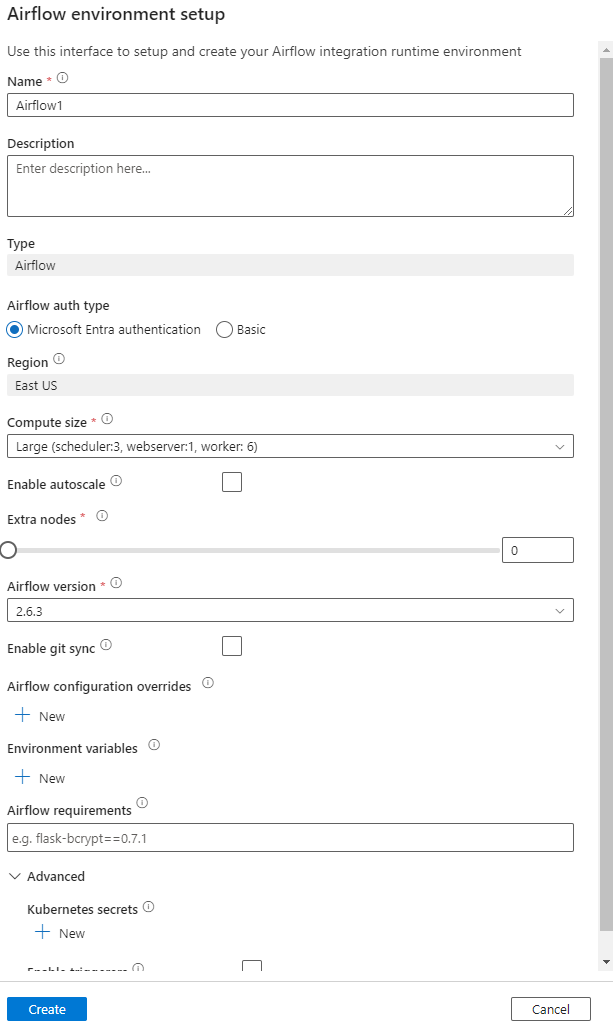

Berikan detail (konfigurasi Airflow)

Penting

Saat menggunakan autentikasi Dasar , ingat nama pengguna dan kata sandi yang ditentukan di layar ini. Ini akan diperlukan untuk masuk nanti di UI Workflow Orchestration Manager. Opsi default adalah ID Microsoft Entra dan tidak memerlukan pembuatan nama pengguna/kata sandi untuk lingkungan Airflow Anda, tetapi sebaliknya menggunakan info masuk pengguna yang masuk ke Azure Data Factory untuk masuk/memantau DAG.

Variabel lingkungan adalah penyimpanan nilai kunci sederhana dalam Airflow untuk menyimpan dan mengambil konten atau pengaturan arbitrer.

Persyaratan dapat digunakan untuk pra-instal pustaka python. Anda juga dapat memperbaruinya nanti.

Impor DAG

Langkah-langkah berikut menjelaskan cara mengimpor DAG ke Workflow Orchestration Manager.

Prasyarat

Anda harus mengunggah dag sampel ke akun Penyimpanan yang dapat diakses (Harus berada di bawah folder dag).

Catatan

Blob Storage di belakang VNet tidak didukung selama pratinjau.

Konfigurasi KeyVault di storageLinkedServices tidak didukung untuk mengimpor dag.

Sampel Apache Airflow v2.x DAG. Sampel Apache Airflow v1.10 DAG.

Langkah-langkah untuk mengimpor

Salin-tempel konten (v2.x atau v1.10 berdasarkan lingkungan Airflow yang telah Anda siapkan) ke dalam file baru yang disebut sebagai tutorial.py.

Unggah tutorial.py ke penyimpanan blob. (Cara mengunggah file ke dalam blob)

Catatan

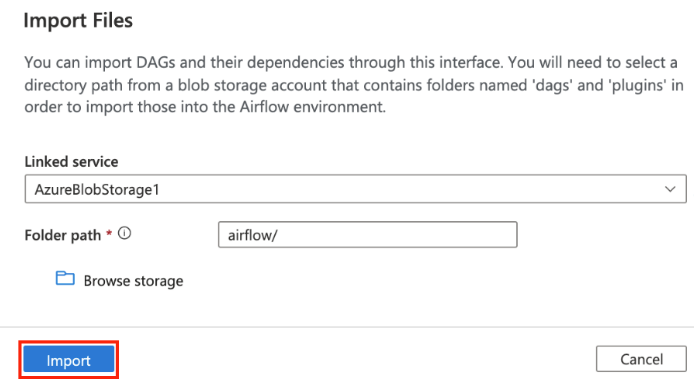

Anda harus memilih jalur direktori dari akun penyimpanan blob yang berisi folder bernama dag dan plugin untuk mengimpornya ke lingkungan Airflow. Plugin tidak wajib. Anda juga dapat memiliki kontainer bernama dag dan mengunggah semua file Airflow di dalamnya.

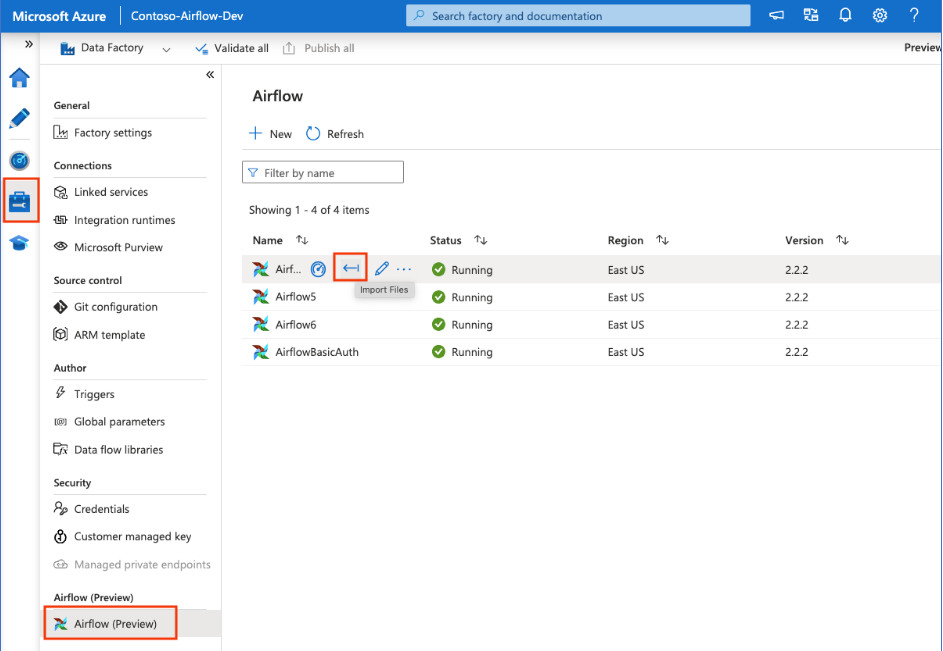

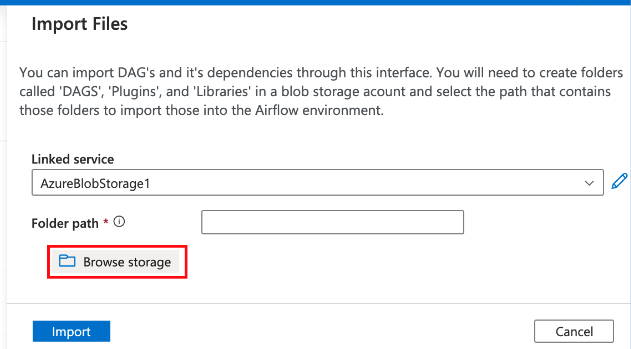

Pilih di Airflow (Pratinjau) di bawah Kelola hub. Kemudian arahkan mouse ke atas lingkungan Airflow yang dibuat sebelumnya dan pilih Impor file untuk Mengimpor semua DAG dan dependensi ke Lingkungan Aliran Udara.

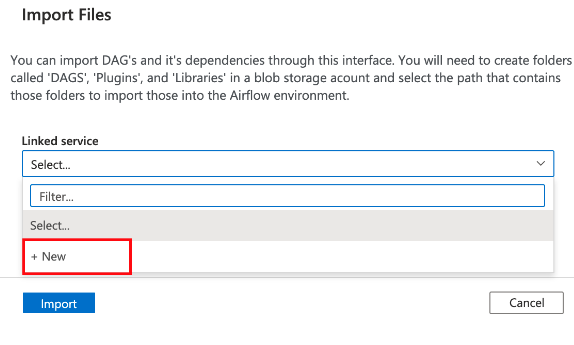

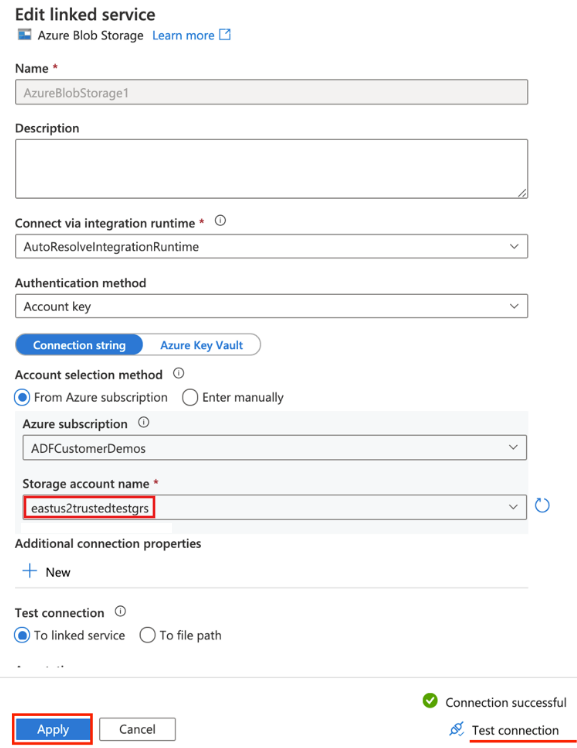

Buat Layanan Tertaut baru ke akun penyimpanan yang dapat diakses yang disebutkan dalam prasyarat (atau gunakan yang sudah ada jika Anda sudah memiliki DAG Anda sendiri).

Gunakan akun penyimpanan tempat Anda mengunggah DAG (periksa prasyarat). Uji koneksi, lalu pilih Buat.

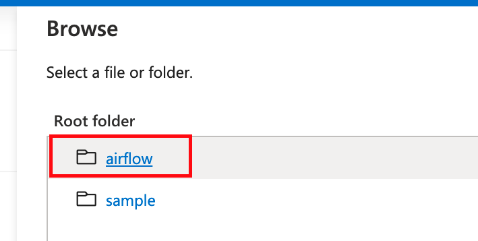

Telusuri dan pilih aliran udara jika menggunakan SAMPEL URL SAS atau pilih folder yang berisi folder dag dengan file DAG.

Catatan

Anda dapat mengimpor DAG dan dependensinya melalui antarmuka ini. Anda harus memilih jalur direktori dari akun penyimpanan blob yang berisi folder bernama dag dan plugin untuk mengimpornya ke lingkungan Airflow. Plugin tidak wajib.

Catatan

Mengimpor DAG bisa memakan waktu beberapa menit selama Pratinjau. Pusat pemberitahuan (ikon bel di UI ADF) dapat digunakan untuk melacak pembaruan status impor.

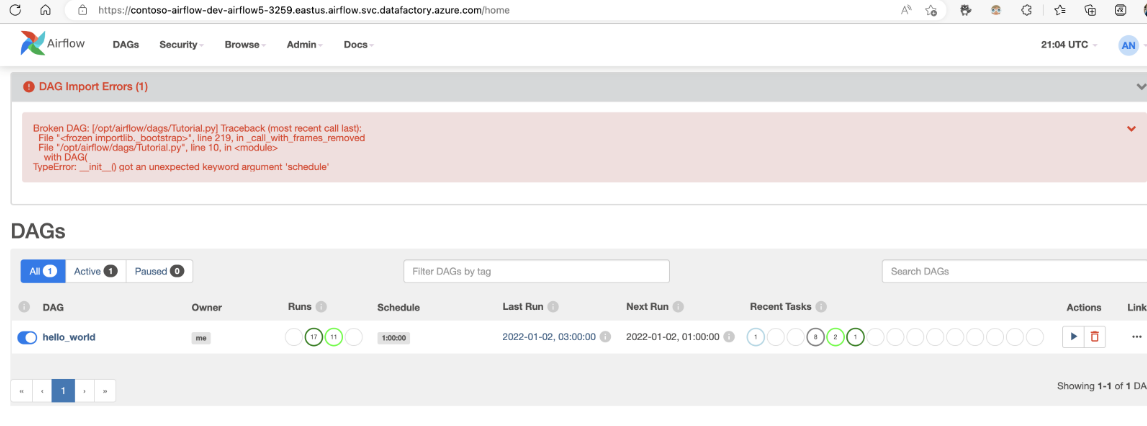

Pemecahan masalah impor DAG

Masalah: Impor DAG mengambil lebih dari 5 menit Mitigasi: Kurangi ukuran DAG yang diimpor dengan satu impor. Salah satu cara untuk mencapainya adalah dengan membuat beberapa folder DAG dengan DAG yang lebih sedikit di beberapa kontainer.

Masalah: DAG yang diimpor tidak muncul saat Anda masuk ke antarmuka pengguna Airflow. Mitigasi: Masuk ke UI Airflow dan lihat apakah ada kesalahan penguraian DAG. Ini bisa terjadi jika file DAG berisi kode yang tidak kompatibel. Anda akan menemukan nomor baris dan file yang tepat, yang memiliki masalah melalui antarmuka pengguna Airflow.

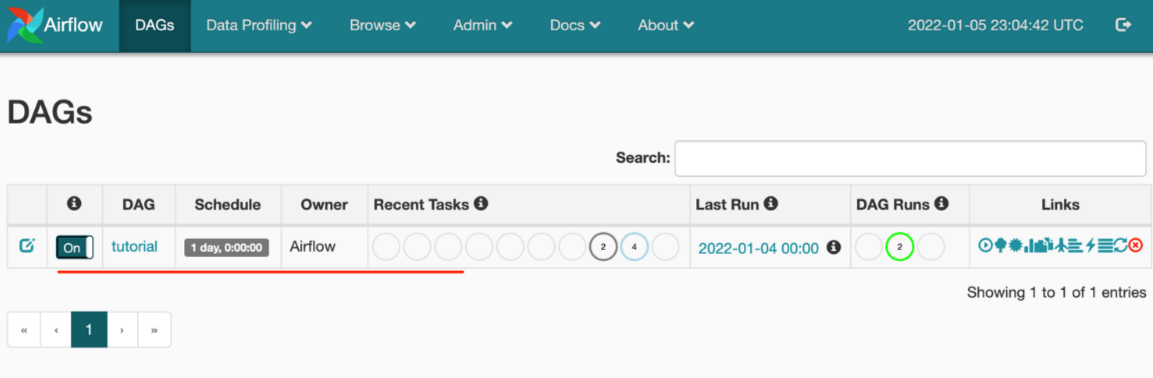

Memantau eksekusi DAG

Untuk memantau DAG Airflow, masuk ke UI Airflow dengan nama pengguna dan kata sandi yang dibuat sebelumnya.

Pilih lingkungan Airflow yang dibuat.

Masuk menggunakan nama pengguna-kata sandi yang disediakan selama pembuatan Airflow Integration Runtime. (Anda dapat mengatur ulang nama pengguna atau kata sandi dengan mengedit runtime Integrasi Airflow jika diperlukan)

Menghapus DAG dari lingkungan Airflow

Jika Anda menggunakan Airflow versi 1.x, hapus DAG yang disebarkan di lingkungan Airflow (IR) apa pun, Anda perlu menghapus DAG di dua tempat berbeda.

- Menghapus DAG dari UI Airflow

- Menghapus DAG di UI ADF

Catatan

Ini adalah pengalaman saat ini selama Pratinjau Umum, dan kami akan meningkatkan pengalaman ini.