Memuat data ke Azure Data Lake Storage Gen2 dengan Azure Data Factory

BERLAKU UNTUK: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tip

Cobalah Data Factory di Microsoft Fabric, solusi analitik all-in-one untuk perusahaan. Microsoft Fabric mencakup semuanya mulai dari pergerakan data hingga ilmu data, analitik real time, kecerdasan bisnis, dan pelaporan. Pelajari cara memulai uji coba baru secara gratis!

Azure Data Lake Storage Gen2 adalah serangkaian kemampuan yang didedikasikan untuk analitik big data yang terpasang ke penyimpanan Azure Blob. Ini memungkinkan Anda untuk berinteraksi dengan data menggunakan sistem file dan paradigma penyimpanan objek.

Azure Data Factory (ADF) adalah layanan integrasi data berbasis cloud yang dikelola sepenuhnya. Anda dapat menggunakan layanan ini untuk mengisi lake dengan data dari sekumpulan penyimpanan data lokal dan berbasis cloud yang kaya serta menghemat waktu saat membangun solusi analitik Anda. Untuk daftar mendetail konektor yang didukung, lihat tabel Penyimpanan data yang didukung.

Azure Data Factory menawarkan solusi pemindahan data terkelola yang diskalakan. Karena arsitektur ADF yang diskalakan, ia dapat menyerap data pada throughput tinggi. Untuk detailnya, lihat Kinerja aktivitas salin.

Artikel ini menampilkan kepada Anda cara menggunakan alat Salin Data di Data Factory untuk memuat data dari layanan Amazon Web Services S3 ke Azure Data Lake Storage Gen2. Anda dapat mengikuti langkah serupa untuk menyalin data dari jenis penyimpanan data lainnya.

Tip

Untuk menyalin data dari Azure Data Lake Storage Gen1 ke Gen2, lihat panduan spesifik ini.

Prasyarat

- Langganan Azure: Jika Anda belum memiliki langganan Azure, buat akun gratis sebelum memulai.

- Akun Azure Storage dengan Data Lake Storage Gen2 diaktifkan: Jika Anda tidak memiliki akun Penyimpanan, buat akun.

- Akun AWS dengan wadah S3 yang berisi data: Artikel ini menunjukkan cara menyalin data dari Amazon S3. Anda dapat menggunakan penyimpanan data lain dengan mengikuti langkah serupa.

Membuat pabrik data

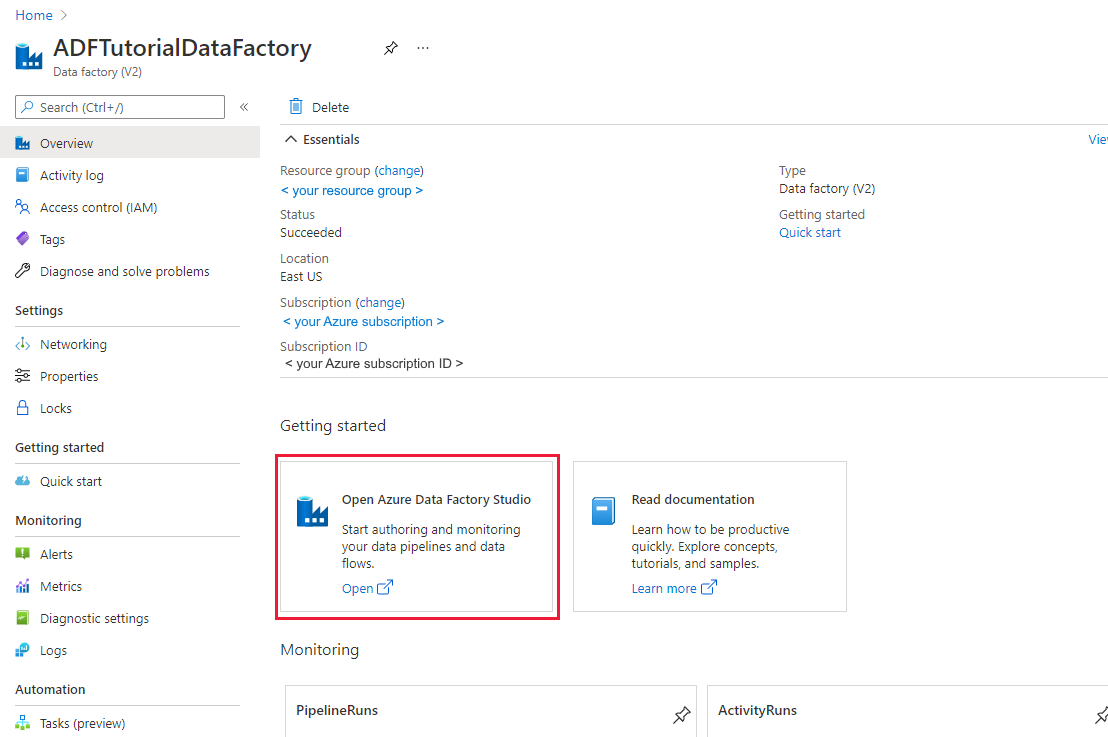

Apabila Anda belum membuat pabrik data, ikuti langkah-langkah di Mulai Cepat: Membuat pabrik data menggunakan portal Azure dan Studio Azure Data Factory untuk membuatnya. Setelah membuat pabrik data, telusuri ke pabrik data di portal Azure.

Pilih Buka pada petak peta Buka Azure Data Factory Studio untuk meluncurkan Aplikasi Integrasi Data di tab terpisah.

Memuat data ke Azure Data Lake Storage Gen2

Di beranda Azure Data Factory, pilih petak peta Penyerapan untuk meluncurkan alat Salin Data.

Di halaman Properti, pilih Tugas salin bawaan di bawah Jenis tugas, dan pilih Jalankan sekali sekarang di bawah Irama tugas atau jadwal tugas, lalu pilih Berikutnya.

Di halaman Penyimpanan data sumber, selesaikan langkah-langkah berikut ini:

Pilih + Koneksi baru. Pilih Amazon S3 dari galeri konektor, dan pilih Lanjutkan.

Di halaman Sambungan baru (Amazon S3), lakukan langkah-langkah berikut:

- Tentukan nilai ID Kunci Akses.

- Tentukan nilai Kunci Akses Rahasia.

- Klik Uji koneksi untuk memvalidasi pengaturan, lalu pilih Buat.

Di halaman Penyimpanan data sumber, pastikan koneksi Amazon S3 yang baru dibuat dipilih di blok Koneksi.

Di bagian File atau folder, jelajahi folder dan file yang ingin Anda salin. Pilih folder/file, lalu pilih OK.

Tentukan perilaku penyalinan dengan mencentang opsi Rekursif dan Penyalinan biner. Pilih Selanjutnya.

Di halaman Penyimpanan data tujuan, selesaikan langkah-langkah berikut ini.

Pilih + Koneksi baru, lalu pilih Azure Data Lake Storage Gen2, dan pilih Lanjutkan.

Di halaman Koneksi baru (Azure Data Lake Storage Gen2), pilih akun yang mendukung Data Lake Storage Gen2 Anda dari daftar menurun, "Nama akun penyimpanan", dan pilih Buat untuk membuat koneksi.

Di halaman Penyimpanan data tujuan, pilih koneksi yang baru dibuat di blok Koneksi. Kemudian di bawah Jalur folder, masukkan copyfroms3 sebagai nama folder output, dan pilih Berikutnya. ADF akan membuat sistem file dan subfolder ADLS Gen2 yang sesuai selama penyalinan jika tidak ada.

Di halaman Pengaturan, tentukan CopyFromAmazonS3ToADLS untuk bidang Nama tugas, dan pilih Berikutnya untuk menggunakan pengaturan default.

Di halaman Ringkasan, tinjau pengaturan, dan pilih Berikutnya.

Pada Halaman penyebaran, pilih Monitor untuk memantau alur (tugas).

Ketika eksekusi alur berhasil diselesaikan, Anda akan melihat eksekusi alur yang dipicu oleh pemicu manual. Anda dapat menggunakan tautan di kolom Nama alur untuk melihat detail aktivitas dan untuk menjalankan ulang alur.

Untuk melihat eksekusi aktivitas yang terkait dengan eksekusi alur, pilih tautan CopyFromAmazonS3ToADLS di bawah kolom Nama alur. Untuk detail tentang operasi pembuatan salinan, pilih tautan Detail (ikon kacamata) di bawah kolom Nama aktivitas. Anda dapat memantau detail seperti volume data yang disalin dari sumber ke sink, throughput data, langkah-langkah eksekusi dengan durasi terkait, dan konfigurasi yang digunakan.

Untuk me-refresh tampilan, pilih Refresh. Pilih Semua eksekusi alur di bagian atas untuk kembali ke tampilan "Eksekusi alur".

Verifikasi bahwa data disalin ke akun Data Lake Storage Gen2 Anda.

Konten terkait

Saran dan Komentar

Segera hadir: Sepanjang tahun 2024 kami akan menghentikan penggunaan GitHub Issues sebagai mekanisme umpan balik untuk konten dan menggantinya dengan sistem umpan balik baru. Untuk mengetahui informasi selengkapnya, lihat: https://aka.ms/ContentUserFeedback.

Kirim dan lihat umpan balik untuk