Tutorial: Menulis ke Tabel Delta yang disimpan di Azure Data Lake Storage Gen2 (Pratinjau Umum)

Tutorial ini menunjukkan bagaimana Anda dapat membuat pekerjaan Azure Stream Analytics untuk menulis ke tabel Delta di Azure Data Lake Storage Gen2. Dalam tutorial ini, Anda akan mempelajari cara:

- Menyebarkan generator peristiwa yang mengirim data sampel ke pusat aktivitas Anda

- Membuat pekerjaan Azure Stream Analytics

- Mengonfigurasi Azure Data Lake Storage Gen2 dengan tabel delta

- Menjalankan pekerjaan Analisis Aliran

Prasyarat

Sebelum memulai, selesaikan langkah-langkah berikut:

- Jika Anda tidak memiliki langganan Azure, buat akun gratis.

- Sebarkan generator peristiwa TollApp ke Azure, gunakan tautan ini untuk Menyebarkan Templat Azure TollApp. Atur parameter 'interval' ke 1. Buat dan gunakan grup sumber daya baru untuk langkah ini.

- Buat akun Data Lake Storage Gen2.

Membuat pekerjaan Azure Stream Analytics

Masuk ke portal Azure.

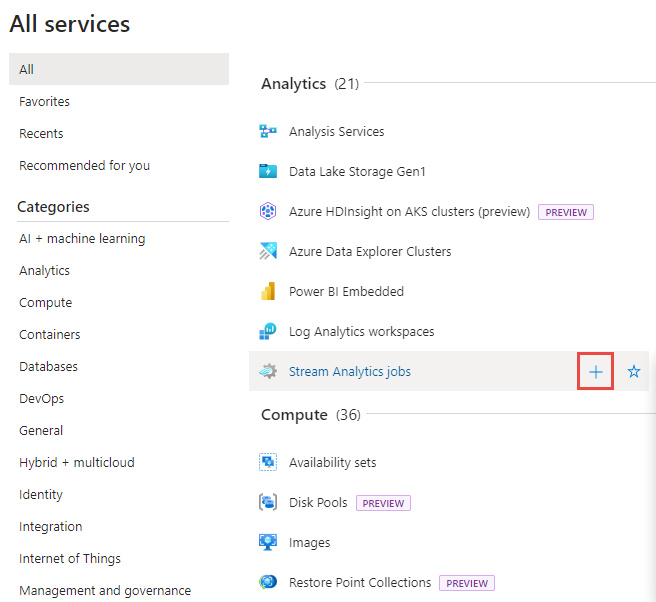

Pilih Semua layanan di menu sebelah kiri.

Pindahkan mouse ke atas pekerjaan Azure Stream Analytics di bagian Analitik , dan pilih + (plus).

Pilih Buat sumber daya yang bisa ditemukan di sudut kiri atas portal Microsoft Azure.

Pilih Analytics>Pekerjaan Azure Stream Analytics dari daftar hasil.

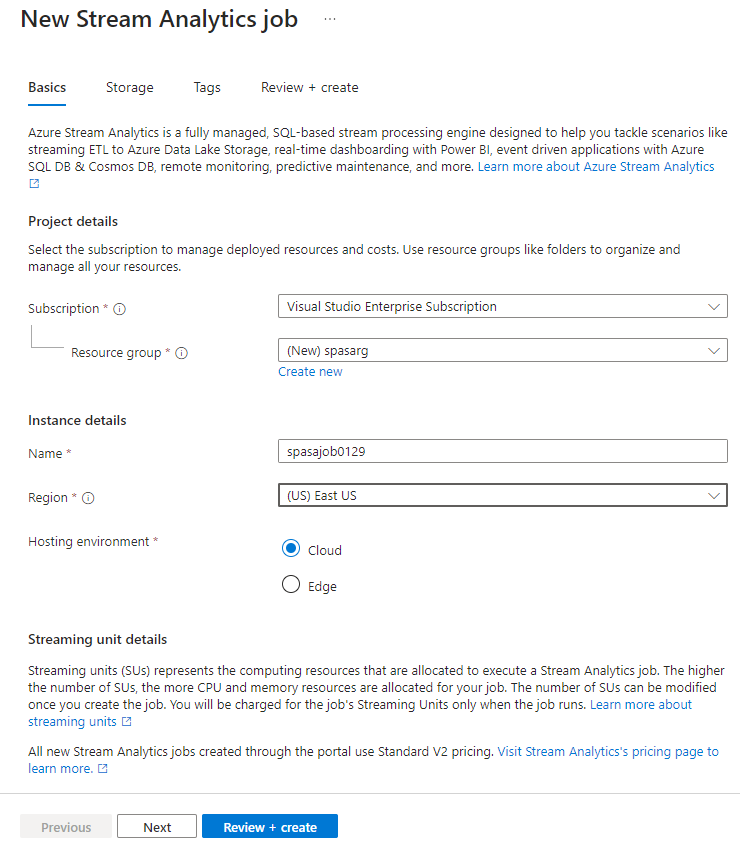

Pada halaman Pekerjaan Analisis Aliran baru, ikuti langkah-langkah ini:

- Untuk Langganan, pilih langganan Azure Anda.

- Untuk Grup sumber daya, pilih sumber daya yang sama dengan yang Anda gunakan sebelumnya di penyebaran TollApp.

- Untuk Nama, masukkan nama untuk pekerjaan. Nama pekerjaan Azure Stream Analytics hanya dapat berisi karakter alfanumerik, tanda hubung, dan garis bawah dan harus berisi 3 hingga 63 karakter.

- Untuk Lingkungan Hosting, pastikan bahwa Cloud dipilih.

- Untuk Unit Stream, pilih 1. Unit streaming mewakili sumber daya komputasi yang diperlukan untuk menjalankan pekerjaan. Untuk mempelajari tentang penskalaan unit streaming, lihat artikel memahami dan menyesuaikan unit streaming.

Pilih Tinjau + buat di bagian bawah halaman.

Pada halaman Tinjau + buat, tinjau pengaturan, lalu pilih Buat untuk membuat halaman Analisis Aliran.

Pada halaman penyebaran, pilih Buka sumber daya untuk membuka halaman Pekerjaan Analisis Aliran.

Mengonfigurasi input pekerjaan

Langkah selanjutnya adalah menentukan sumber input untuk pekerjaan membaca data menggunakan hub peristiwa yang dibuat dalam penyebaran TollApp.

Temukan pekerjaan Azure Stream Analytics yang dibuat di bagian sebelumnya.

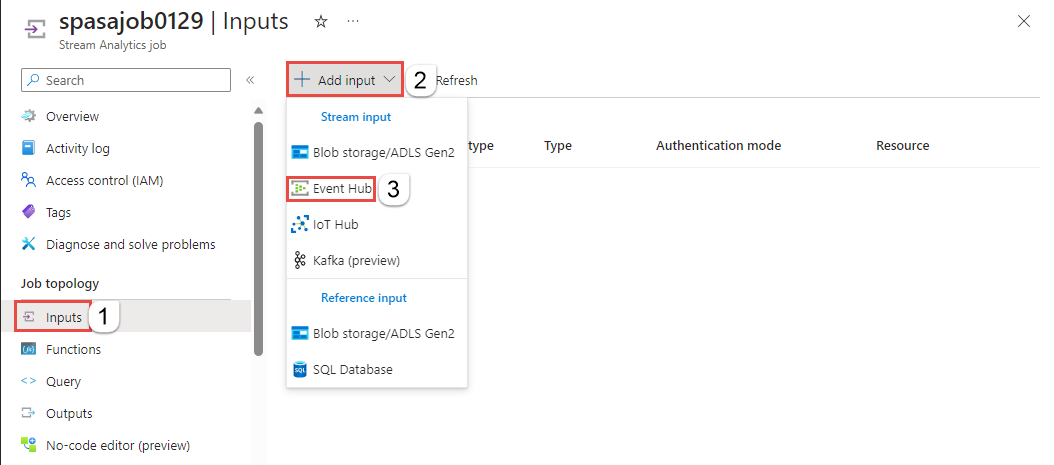

Di bagian Topologi Pekerjaan dari pekerjaan Azure Stream Analytics, pilih Input.

Pilih + Tambahkan input dan Event hub.

Isi formulir input dengan nilai berikut yang dibuat melalui Templat TollApp Azure:

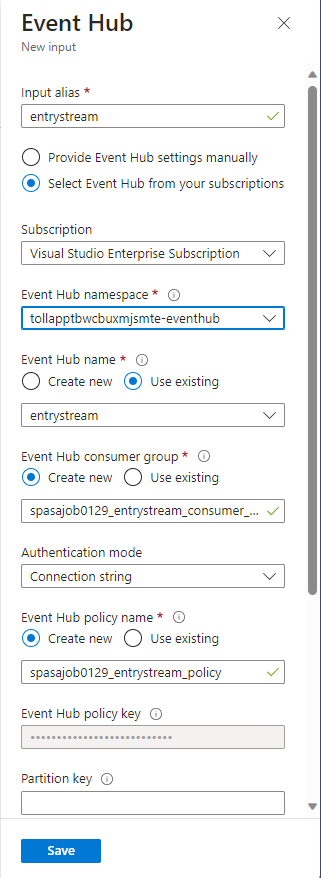

Untuk Alias input, masukkan entrystream.

Pilih Pilih Pusat Aktivitas dari langganan Anda.

Untuk Langganan, pilih langganan Azure Anda.

Untuk namespace Layanan Pusat Aktivitas, pilih namespace layanan pusat aktivitas yang Anda buat di bagian sebelumnya.

Gunakan opsi default pada pengaturan yang tersisa dan pilih Simpan.

Mengonfigurasi output pekerjaan

Langkah selanjutnya adalah menentukan sink output tempat pekerjaan dapat menulis data. Dalam tutorial ini, Anda menulis output ke tabel Delta di Azure Data Lake Storage Gen2.

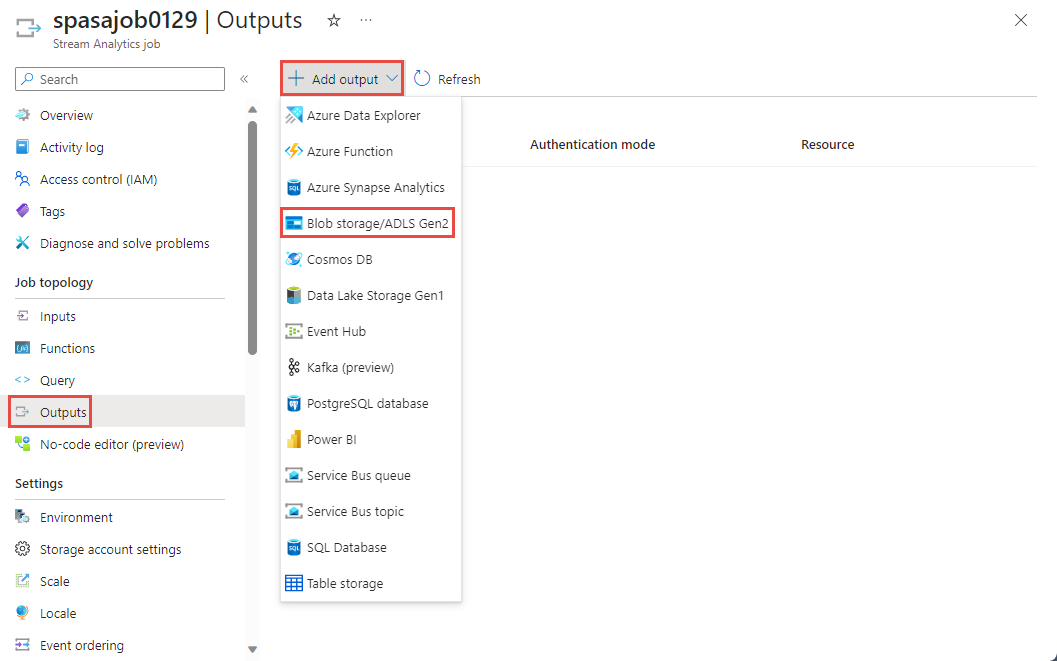

Di bagian Topologi Pekerjaan di pekerjaan Azure Stream Analytics, pilih opsi Output.

Pilih + Tambahkan penyimpanan Blob output>/ADLS Gen2.

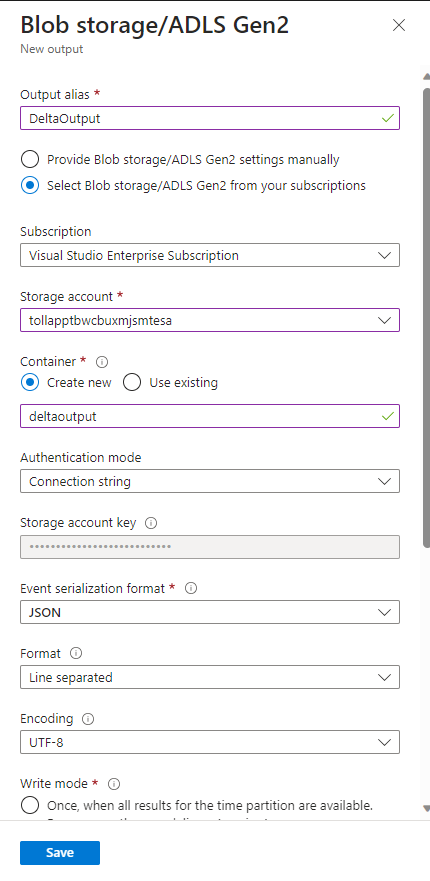

Isi formulir output dengan detail berikut dan pilih Simpan:

Untuk Alias output, masukkan DeltaOutput.

Pilih Pilih Penyimpanan blob/ADLS Gen2 dari langganan Anda.

Untuk Langganan, pilih langganan Azure Anda.

Untuk Akun penyimpanan, pilih akun ADLS Gen2 (akun yang dimulai dengan tollapp) yang Anda buat.

Untuk kontainer, pilih Buat baru dan berikan nama kontainer unik.

Untuk Format Serialisasi Peristiwa, pilih Delta Lake (Pratinjau). Meskipun Delta lake terdaftar sebagai salah satu opsi di sini, ini bukan format data. Delta Lake menggunakan file Parquet versi untuk menyimpan data Anda. Untuk mempelajari selengkapnya tentang Danau Delta.

Untuk jalur tabel Delta, masukkan folder tutorial/tabel delta.

Gunakan opsi default pada pengaturan yang tersisa dan pilih Simpan.

Membuat kueri

Pada titik ini, Anda memiliki pekerjaan Azure Stream Analytics yang disiapkan untuk membaca aliran data masuk. Langkah selanjutnya adalah membuat kueri yang menganalisis data secara real time. Kueri menggunakan bahasa seperti SQL yang memiliki beberapa ekstensi khusus untuk Azure Stream Analytics.

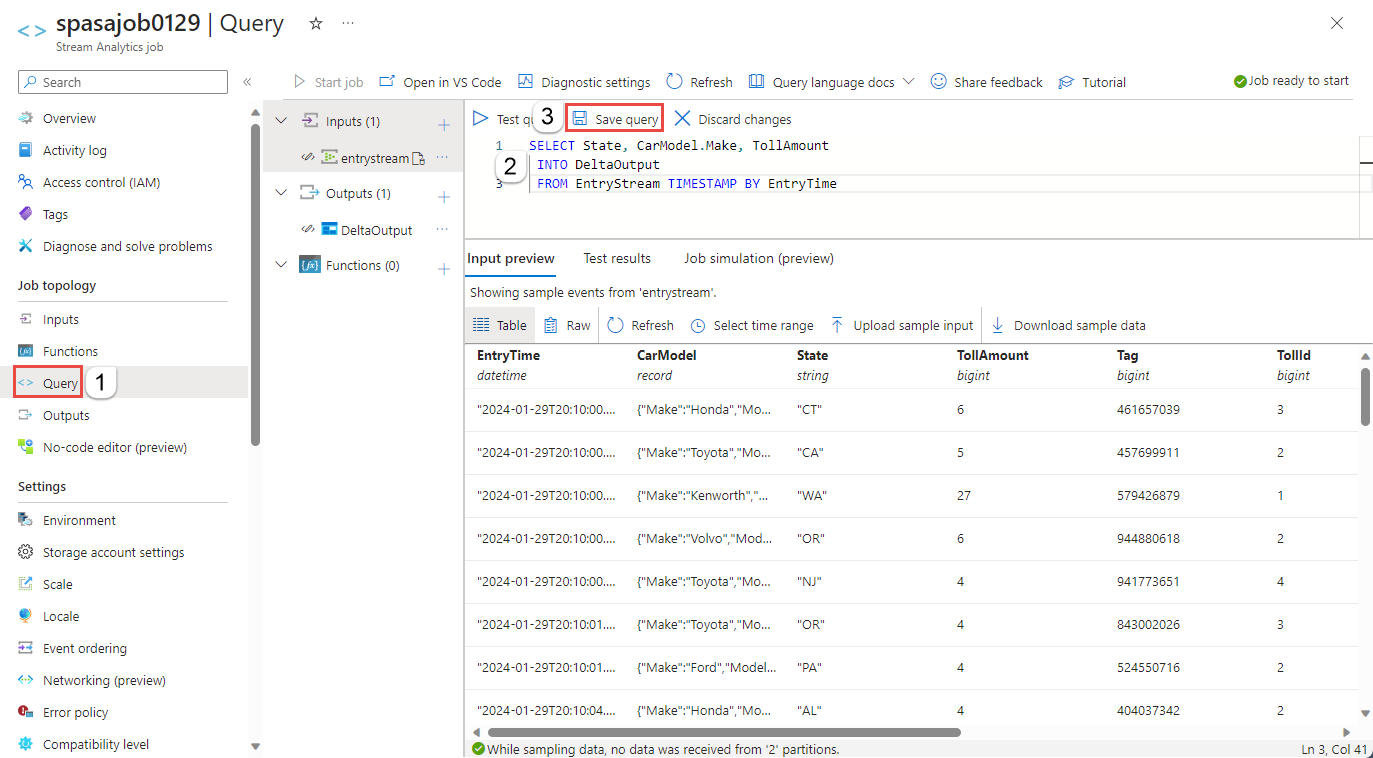

Sekarang, pilih Kueri di bawah Topologi pekerjaan di menu sebelah kiri.

Masukkan kueri berikut ke jendela kueri. Dalam contoh ini, kueri membaca data dari Azure Event Hubs dan menyalin nilai yang dipilih ke tabel Delta di ADLS Gen2.

SELECT State, CarModel.Make, TollAmount INTO DeltaOutput FROM EntryStream TIMESTAMP BY EntryTimePilih Simpan kueri pada bar alat.

Memulai pekerjaan Stream Analytics dan memeriksa output

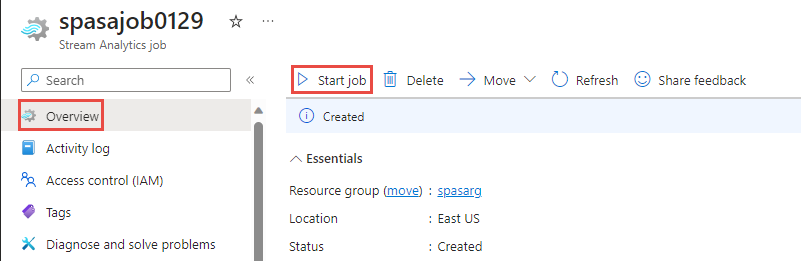

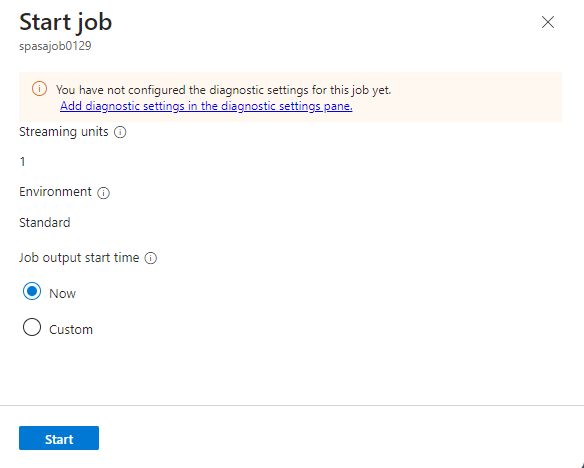

Kembali ke halaman ringkasan pekerjaan di portal Microsoft Azure dan pilih Mulai.

Pada halaman Mulai pekerjaan , konfirmasikan bahwa Sekarang dipilih untuk Waktu mulai output pekerjaan, lalu pilih Mulai di bagian bawah halaman.

Setelah beberapa menit, di portal, temukan akun penyimpanan & kontainer yang telah Anda konfigurasi sebagai output untuk pekerjaan tersebut. Sekarang Anda dapat melihat tabel delta di folder yang ditentukan dalam kontainer. Butuh beberapa menit untuk memulai pekerjaan pertama kalinya, setelah dimulai, pekerjaan akan terus berjalan saat data diterima.

Membersihkan sumber daya

Jika tidak lagi diperlukan, hapus grup sumber daya, pekerjaan Azure Stream Analytics, dan semua sumber daya terkait. Menghapus pekerjaan menghindari tagihan unit streaming yang digunakan oleh pekerjaan. Jika Anda ingin menggunakan pekerjaan di masa depan, Anda dapat menghentikannya dan memulainya kembali nanti ketika Anda membutuhkannya. Jika Anda tidak akan terus menggunakan pekerjaan ini, hapus semua sumber daya yang dibuat oleh tutorial ini dengan menggunakan langkah-langkah berikut:

- Dari menu sebelah kiri di portal Azure, pilih Grup sumber daya kemudian pilih nama sumber daya yang Anda buat.

- Pada halaman grup sumber daya, pilih Hapus, ketik nama sumber daya untuk dihapus dalam kotak teks, kemudian pilih Hapus.

Langkah berikutnya

Dalam tutorial ini, Anda membuat pekerjaan Azure Stream Analytics sederhana, memfilter data masuk, dan menulis hasil dalam tabel Delta di akun ADLS Gen2. Untuk mempelajari selengkapnya tentang pekerjaan Azure Stream Analytics: