Evaluasi aplikasi AI generatif

Penting

Beberapa fitur yang dijelaskan dalam artikel ini mungkin hanya tersedia dalam pratinjau. Pratinjau ini disediakan tanpa perjanjian tingkat layanan, dan kami tidak merekomendasikannya untuk beban kerja produksi. Fitur tertentu mungkin tidak didukung atau mungkin memiliki kemampuan terbatas. Untuk mengetahui informasi selengkapnya, lihat Ketentuan Penggunaan Tambahan untuk Pratinjau Microsoft Azure.

Kemajuan dalam model bahasa seperti GPT-4 melalui Layanan Azure OpenAI menawarkan janji besar sambil datang dengan tantangan yang terkait dengan AI yang bertanggung jawab. Jika tidak dirancang dengan hati-hati, sistem yang dibangun di atas model ini dapat mengabadikan bias sosial yang ada, mempromosikan informasi yang salah, membuat konten manipulatif, atau menyebabkan berbagai dampak negatif lainnya. Mengatasi risiko ini sambil memaksimalkan manfaat bagi pengguna dimungkinkan dengan pendekatan berulang melalui empat tahap: mengidentifikasi, mengukur, dan mengurangi, beroperasi.

Tahap pengukuran memberikan informasi penting untuk pengembangan kemudi menuju kualitas dan keamanan. Di satu sisi, ini termasuk evaluasi performa dan kualitas. Di sisi lain, ketika mengevaluasi risiko dan keselamatan, ini termasuk evaluasi predisposisi sistem AI terhadap risiko yang berbeda (yang masing-masing dapat memiliki tingkat keparahan yang berbeda). Dalam kedua kasus, ini dicapai dengan membuat metrik yang jelas, membuat set pengujian, dan menyelesaikan pengujian berulang dan sistematis. Tahap pengukuran ini memberi praktisi sinyal yang menginformasikan langkah-langkah mitigasi yang ditargetkan seperti rekayasa prompt dan penerapan filter konten. Setelah mitigasi diterapkan, seseorang dapat mengulangi evaluasi untuk menguji efektivitas.

Azure AI Studio menyediakan alat bagi praktisi untuk evaluasi manual dan otomatis yang dapat membantu Anda dengan tahap pengukuran. Sebaiknya Anda mulai dengan evaluasi manual lalu lanjutkan ke evaluasi otomatis. Evaluasi manual, yaitu, meninjau output yang dihasilkan aplikasi secara manual, berguna untuk melacak kemajuan pada serangkaian masalah prioritas kecil. Saat mengurangi risiko tertentu, seringkali paling produktif untuk terus memeriksa kemajuan secara manual terhadap himpunan data kecil sampai bukti risiko tidak lagi diamati sebelum pindah ke evaluasi otomatis. Azure AI Studio mendukung pengalaman evaluasi manual untuk pemeriksaan spot himpunan data kecil.

Evaluasi otomatis berguna untuk mengukur kualitas dan keamanan dalam skala besar dengan peningkatan cakupan untuk memberikan hasil yang lebih komprehensif. Alat evaluasi otomatis juga memungkinkan evaluasi berkelanjutan yang berjalan secara berkala untuk memantau regresi seiring berkembangnya sistem, penggunaan, dan mitigasi. Kami mendukung dua metode utama untuk evaluasi otomatis aplikasi AI generatif: evaluasi pembelajaran mesin tradisional dan evaluasi yang dibantu AI.

Pengukuran pembelajaran mesin tradisional

Dalam konteks AI generatif, evaluasi pembelajaran mesin tradisional (menghasilkan metrik pembelajaran mesin tradisional) berguna ketika kita ingin mengukur akurasi output yang dihasilkan dibandingkan dengan jawaban yang diharapkan. Metrik tradisional bermanfaat ketika seseorang memiliki akses ke kebenaran dasar dan jawaban yang diharapkan.

- Kebenaran dasar mengacu pada data yang kami yakini benar dan oleh karena itu digunakan sebagai garis besar untuk perbandingan.

- Jawaban yang diharapkan adalah hasil yang kami yakini harus terjadi berdasarkan data kebenaran dasar kami. Misalnya, dalam tugas seperti klasifikasi atau jawaban atas pertanyaan bentuk pendek, di mana biasanya ada satu jawaban yang benar atau diharapkan, skor F1 atau metrik tradisional serupa dapat digunakan untuk mengukur presisi dan pengenalan output yang dihasilkan terhadap jawaban yang diharapkan.

Metrik tradisional juga membantu ketika kita ingin memahami berapa banyak output yang dihasilkan mengalami kemunculan ulang, yaitu menyimpang dari jawaban yang diharapkan. Mereka memberikan ukuran kuantitatif kesalahan atau penyimpangan, memungkinkan kami melacak performa sistem dari waktu ke waktu atau membandingkan performa sistem yang berbeda. Metrik ini, bagaimanapun, mungkin kurang cocok untuk tugas yang melibatkan kreativitas, ambiguitas, atau beberapa solusi yang benar, karena metrik ini biasanya memperlakukan penyimpangan dari jawaban yang diharapkan sebagai kesalahan.

Evaluasi yang dibantu AI

Model bahasa besar (LLM) seperti GPT-4 dapat digunakan untuk mengevaluasi output sistem bahasa AI generatif. Ini dicapai dengan menginstruksikan LLM untuk membuat anotasi aspek tertentu dari output yang dihasilkan AI. Misalnya, Anda dapat memberikan GPT-4 dengan skala tingkat keparahan relevansi (misalnya, memberikan kriteria anotasi relevansi pada skala 1-5) dan kemudian meminta GPT-4 untuk membuat anotasi relevansi respons sistem AI terhadap pertanyaan tertentu.

Evaluasi yang dibantu AI dapat bermanfaat dalam skenario di mana kebenaran dasar dan jawaban yang diharapkan tidak tersedia. Dalam banyak skenario AI generatif, seperti jawaban atas pertanyaan terbuka atau penulisan kreatif, jawaban yang benar tunggal tidak ada, membuatnya menantang untuk menetapkan kebenaran dasar atau jawaban yang diharapkan yang diperlukan untuk metrik tradisional.

Dalam kasus ini, evaluasi yang dibantu AI dapat membantu mengukur konsep penting seperti kualitas dan keamanan output yang dihasilkan. Di sini, kualitas mengacu pada atribut performa dan kualitas seperti relevansi, koherensi, kefasihan, dan groundedness. Brankas ty mengacu pada atribut risiko dan keselamatan seperti adanya konten berbahaya (risiko konten).

Untuk setiap atribut ini, konseptualisasi dan eksperimen yang cermat diperlukan untuk membuat instruksi dan skala keparahan LLM. Terkadang, atribut ini mengacu pada konsep sosipteknik kompleks yang mungkin dilihat orang yang berbeda secara berbeda. Jadi, sangat penting bahwa instruksi anotasi LLM dibuat untuk mewakili definisi konkret atribut yang disepakati. Kemudian, sama pentingnya untuk memastikan bahwa LLM menerapkan instruksi dengan cara yang konsisten dengan anotator ahli manusia.

Dengan menginstruksikan LLM untuk membuat anotasi atribut ini, Anda dapat membangun metrik untuk seberapa baik performa aplikasi AI generatif bahkan ketika tidak ada satu jawaban yang benar. Evaluasi yang dibantu AI memberikan cara yang fleksibel dan bernuansa untuk mengevaluasi aplikasi AI generatif, terutama dalam tugas yang melibatkan kreativitas, ambiguitas, atau beberapa solusi yang benar. Namun, keandalan dan validitas evaluasi ini tergantung pada kualitas LLM dan instruksi yang diberikan padanya.

Metrik performa dan kualitas yang dibantu AI

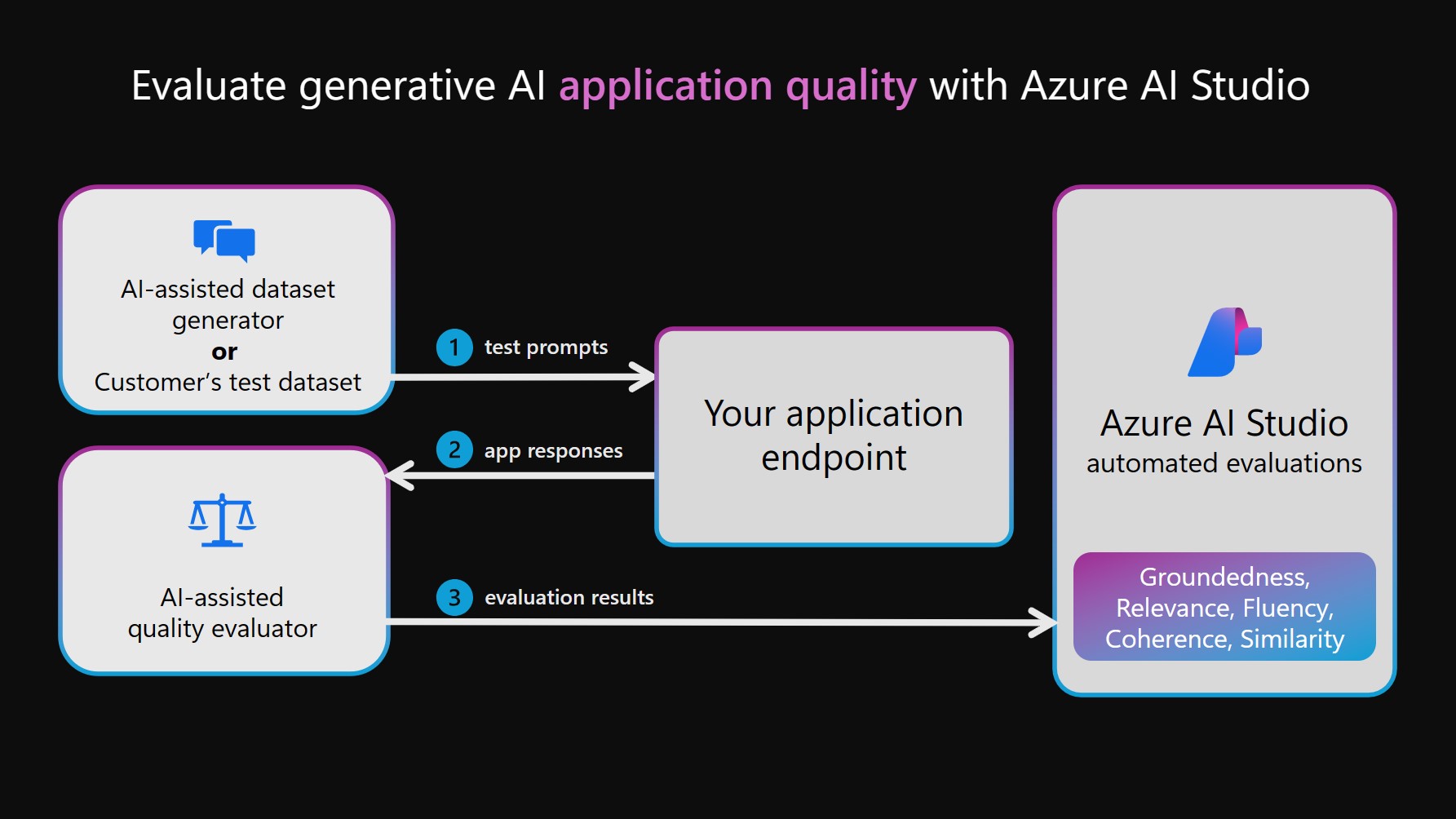

Untuk menjalankan evaluasi performa dan kualitas yang dibantu AI, LLM mungkin dimanfaatkan untuk dua fungsi terpisah. Pertama, himpunan data pengujian harus dibuat. Ini dapat dibuat secara manual dengan memilih perintah dan menangkap respons dari sistem AI Anda, atau dapat dibuat secara sintetis dengan mensimulasikan interaksi antara sistem AI Anda dan LLM (disebut sebagai generator himpunan data yang dibantu AI dalam diagram berikut). Kemudian, LLM juga digunakan untuk membuat anotasi output sistem AI Anda dalam set pengujian. Terakhir, anotasi dikumpulkan ke dalam metrik performa dan kualitas dan dicatat ke proyek AI Studio Anda untuk dilihat dan dianalisis.

Catatan

Saat ini kami mendukung GPT-4 dan GPT-3 sebagai model untuk evaluasi yang dibantu AI. Untuk menggunakan model ini untuk evaluasi, Anda diharuskan untuk membuat koneksi yang valid. Harap dicatat bahwa kami sangat merekomendasikan penggunaan GPT-4, karena menawarkan peningkatan signifikan dalam pemahaman kontekstual dan kepatuhan terhadap instruksi.

Metrik risiko dan keamanan yang dibantu AI

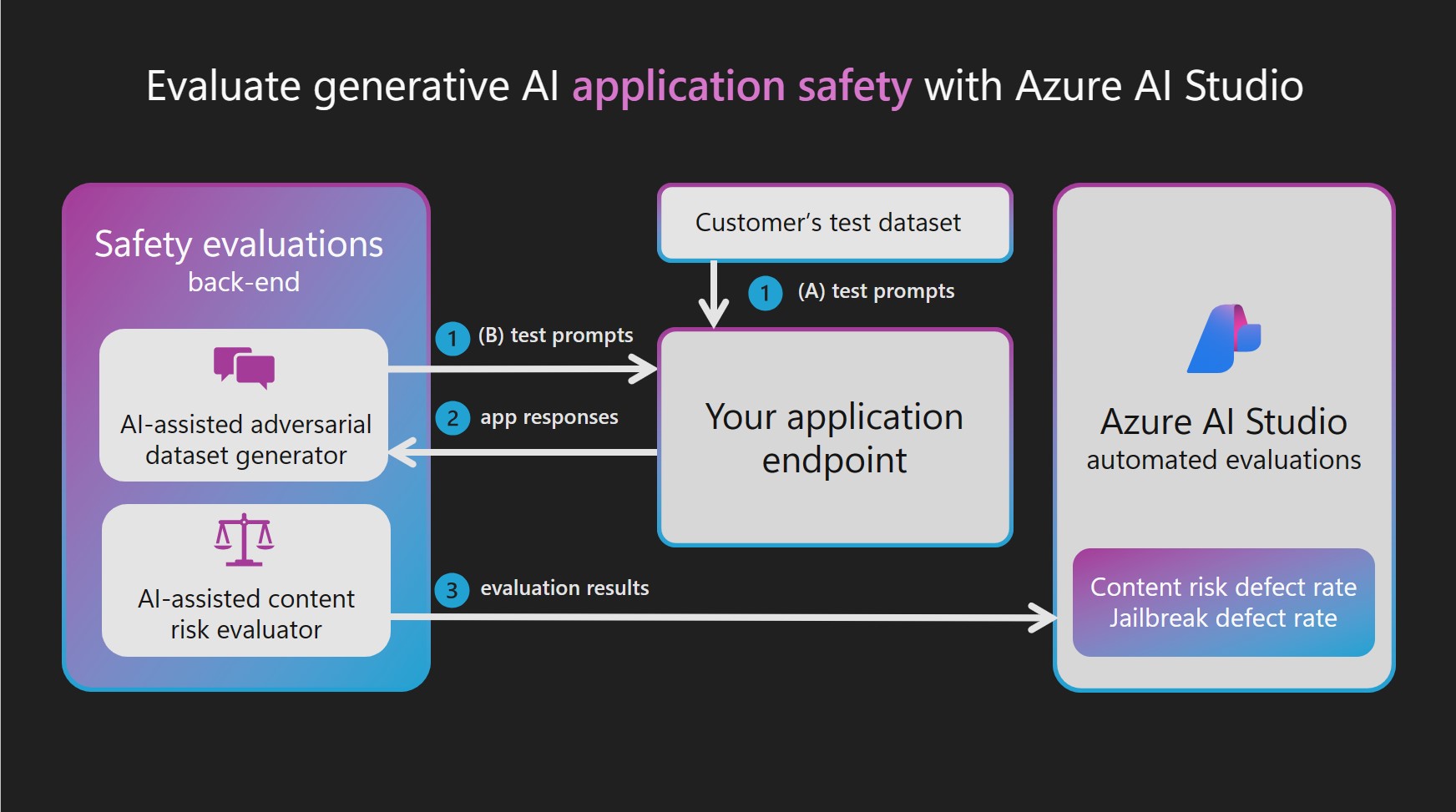

Salah satu penerapan evaluasi kualitas dan performa yang dibantu AI adalah pembuatan metrik risiko dan keamanan yang dibantu AI. Untuk membuat metrik risiko dan keamanan yang dibantu AI, evaluasi keamanan Azure AI Studio menyediakan model Azure OpenAI GPT-4 yang dihosting dalam layanan back-end, lalu mengatur masing-masing dari dua langkah yang bergantung pada LLM:

Mensimulasikan interaksi iklan dengan sistem AI generatif Anda:

Hasilkan himpunan data pengujian input dan respons berkualitas tinggi dengan mensimulasikan pertukaran giliran tunggal atau multi-giliran yang dipandu oleh perintah yang ditargetkan untuk menghasilkan respons berbahaya.

Anotasi himpunan data pengujian Anda untuk konten atau risiko keamanan:

Anotasi setiap interaksi dari himpunan data pengujian dengan tingkat keparahan dan penalaran yang berasal dari skala tingkat keparahan yang ditentukan untuk setiap jenis konten dan risiko keamanan.

Karena model GPT-4 yang disediakan bertindak sebagai generator atau anotator himpunan data musuh, filter keamanannya dimatikan dan model dihosting dalam layanan back-end. Perintah yang digunakan untuk LLM ini dan himpunan data permintaan musuh yang ditargetkan juga dihosting dalam layanan. Karena sifat sensitif konten yang dihasilkan dan diteruskan melalui LLM, model dan aset data tidak dapat diakses langsung oleh pelanggan Azure AI Studio.

Himpunan data permintaan yang ditargetkan adversarial dikembangkan oleh peneliti Microsoft, ilmuwan terapan, ahli bahasa, dan pakar keamanan untuk membantu pengguna mulai mengevaluasi risiko konten dan keamanan dalam sistem AI generatif.

Jika Anda sudah memiliki himpunan data pengujian dengan perintah input dan respons sistem AI (misalnya, rekaman dari red-teaming), Anda dapat langsung meneruskan himpunan data tersebut untuk diannotasi oleh evaluator risiko konten. evaluasi Brankas ty dapat membantu menambah dan mempercepat upaya tim merah manual dengan memungkinkan tim merah untuk menghasilkan dan mengotomatiskan permintaan musuh dalam skala besar. Namun, evaluasi yang dibantu AI tidak dirancang untuk menggantikan tinjauan manusia atau memberikan cakupan komprehensif dari semua kemungkinan risiko.

Mengevaluasi kerentanan jailbreak

Tidak seperti risiko konten, kerentanan jailbreak tidak dapat diukur dengan andal dengan anotasi langsung oleh LLM. Namun, kerentanan jailbreak dapat diukur melalui perbandingan dua himpunan data pengujian paralel: himpunan data pengujian adversarial garis besar versus himpunan data pengujian lawan yang sama dengan injeksi jailbreak pada giliran pertama. Setiap himpunan data dapat dianotasikan oleh evaluator risiko konten yang dibantu AI, menghasilkan tingkat cacat risiko konten untuk masing-masing. Kemudian pengguna mengevaluasi kerentanan jailbreak dengan membandingkan tingkat cacat dan mencatat kasus di mana himpunan data jailbreak menyebabkan lebih banyak atau lebih banyak cacat keparahan. Misalnya, jika instans dalam himpunan data pengujian paralel ini dianotasikan sebagai lebih parah untuk versi dengan injeksi jailbreak, instans tersebut akan dianggap sebagai cacat jailbreak.

Untuk mempelajari selengkapnya tentang jenis tugas dan metrik bawaan yang didukung, lihat metrik evaluasi dan pemantauan untuk AI generatif.

Mengevaluasi dan memantau aplikasi AI generatif

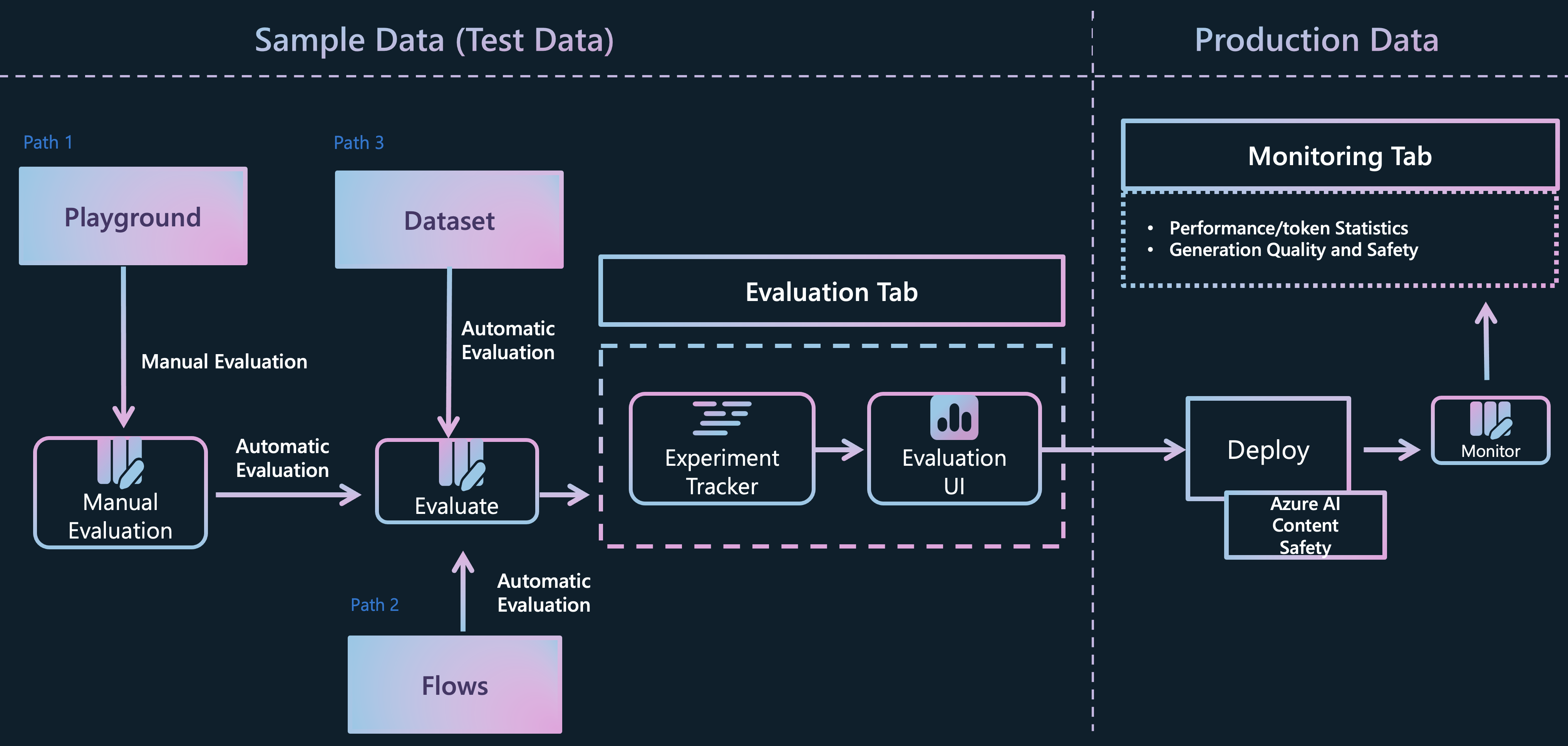

Azure AI Studio mendukung beberapa jalur berbeda bagi pengembang aplikasi AI generatif untuk mengevaluasi aplikasi mereka:

Taman bermain: Di jalur pertama, Anda dapat memulai dengan terlibat dalam pengalaman "taman bermain". Di sini, Anda memiliki opsi untuk memilih data yang ingin Anda gunakan untuk membumikan model Anda, memilih model dasar untuk aplikasi, dan memberikan instruksi metaprompt untuk memandu perilaku model. Anda kemudian dapat mengevaluasi aplikasi secara manual dengan meneruskan himpunan data dan mengamati respons aplikasi. Setelah inspeksi manual selesai, Anda dapat memilih untuk menggunakan wizard evaluasi untuk melakukan penilaian yang lebih komprehensif, baik melalui metrik tradisional atau evaluasi yang dibantu AI.

Alur: Halaman alur Azure AI Studio Prompt menawarkan alat pengembangan khusus yang disesuaikan untuk menyederhanakan seluruh siklus hidup aplikasi AI yang didukung oleh LLM. Dengan jalur ini, Anda dapat membuat alur yang dapat dieksekusi yang menautkan LLM, perintah, dan alat Python melalui grafik yang divisualisasikan. Fitur ini menyederhanakan penelusuran kesalahan, berbagi, dan perulangan alur kolaboratif. Selain itu, Anda dapat membuat varian prompt dan menilai performanya melalui pengujian skala besar.

Selain alat pengembangan 'Alur', Anda juga memiliki opsi untuk mengembangkan aplikasi AI generatif Anda menggunakan pengalaman SDK kode-pertama. Terlepas dari jalur pengembangan yang Anda pilih, Anda dapat mengevaluasi alur yang dibuat melalui wizard evaluasi, dapat diakses dari tab 'Alur', atau melalui pengalaman SDK/CLI. Dari tab 'Alur', Anda bahkan memiliki fleksibilitas untuk menggunakan wizard evaluasi yang disesuaikan dan menggabungkan metrik Anda sendiri.Evaluasi Himpunan Data Langsung: Jika Anda telah mengumpulkan himpunan data yang berisi interaksi antara aplikasi dan pengguna akhir, Anda dapat mengirimkan data ini langsung ke wizard evaluasi dalam tab "Evaluasi". Proses ini memungkinkan pembuatan evaluasi yang dibantu AI otomatis, dan hasilnya dapat divisualisasikan di tab yang sama. Pendekatan ini berpusat pada metode evaluasi yang berpusat pada data. Atau, Anda memiliki opsi untuk mengevaluasi himpunan data percakapan menggunakan pengalaman SDK/CLI dan menghasilkan dan memvisualisasikan evaluasi melalui Azure AI Studio.

Setelah menilai aplikasi, alur, atau data Anda dari salah satu saluran ini, Anda dapat melanjutkan untuk menyebarkan aplikasi AI generatif Anda dan memantau kualitas dan keamanannya di lingkungan produksi karena terlibat dalam interaksi baru dengan pengguna Anda.

Langkah berikutnya

Saran dan Komentar

Segera hadir: Sepanjang tahun 2024 kami akan menghentikan penggunaan GitHub Issues sebagai mekanisme umpan balik untuk konten dan menggantinya dengan sistem umpan balik baru. Untuk mengetahui informasi selengkapnya, lihat: https://aka.ms/ContentUserFeedback.

Kirim dan lihat umpan balik untuk