Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

BERLAKU UNTUK: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Petunjuk / Saran

Cobalah Data Factory di Microsoft Fabric, solusi analitik all-in-one untuk perusahaan. Microsoft Fabric mencakup semuanya mulai dari pergerakan data hingga ilmu data, analitik real time, kecerdasan bisnis, dan pelaporan. Pelajari cara memulai uji coba baru secara gratis!

Di tutorial ini, Anda menggunakan portal Microsoft Azure untuk membuat alur Azure Data Factory yang menjalankan buku catatan Databricks terhadap kluster pekerjaan Databricks. Tutorial ini juga meneruskan parameter Azure Data Factory ke buku catatan Databricks selama eksekusi.

Anda akan melakukan langkah-langkah berikut dalam tutorial ini:

Membuat pabrik data.

Membuat alur yang menggunakan Databricks Notebook Activity.

Memicu eksekusi alur.

Pantau eksekusi alur.

Jika Anda tidak memiliki langganan Azure, buat akun gratis sebelum Anda memulai.

Catatan

Untuk detail lengkap tentang cara menggunakan Aktivitas Notebook Databricks, termasuk menggunakan pustaka dan meneruskan parameter input dan output, lihat dokumentasi Aktivitas Notebook Databricks.

Prasyarat

- Ruang kerja Azure Databricks. Buat ruang kerja Databricks atau gunakan ruang kerja yang sudah ada. Anda membuat buku catatan Python di ruang kerja Azure Databricks Anda. Kemudian Anda menjalankan buku catatan dan meneruskan parameter ke sana menggunakan Azure Data Factory.

Membuat pabrik data

Luncurkan browser web Microsoft Edge atau Google Chrome. Saat ini, antarmuka pengguna Data Factory hanya didukung di browser web Microsoft Edge dan Google Chrome.

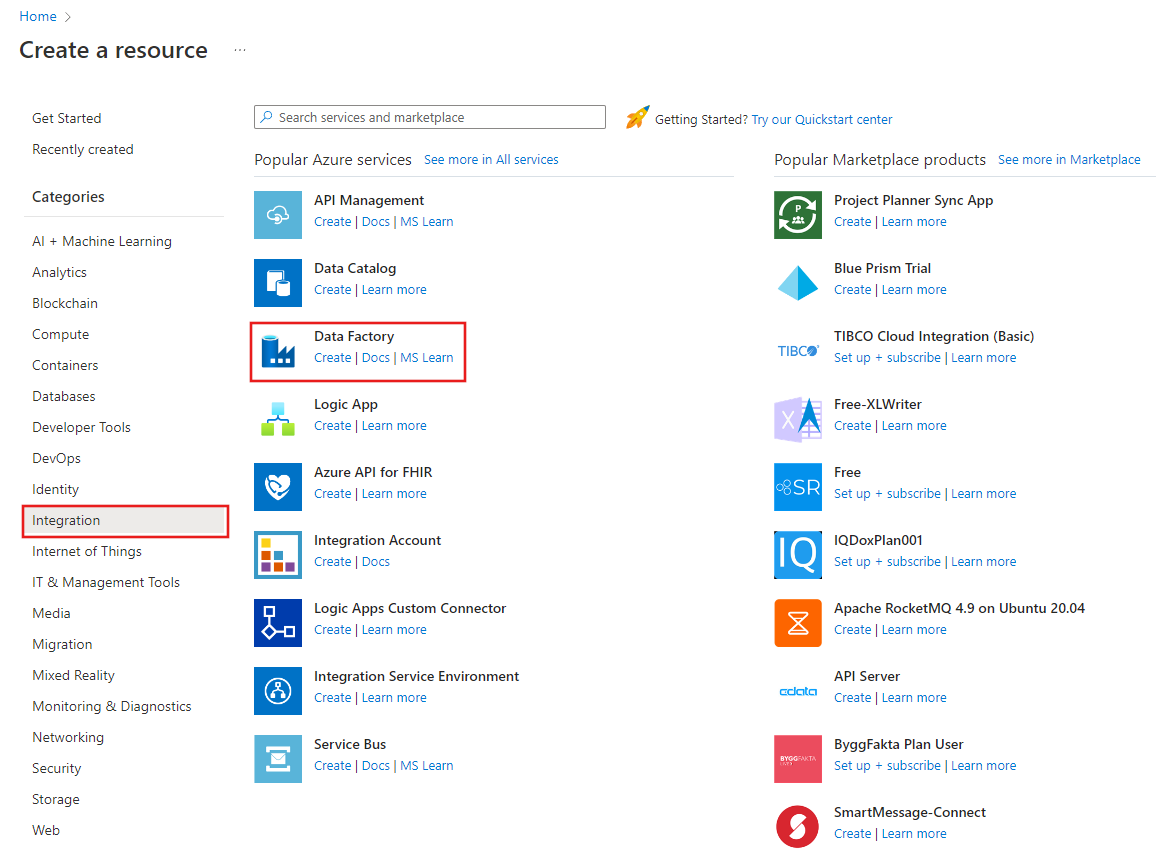

Pilih Buat sumber daya di menu portal Microsoft Azure, lalu pilih>Analytics Data Factory :

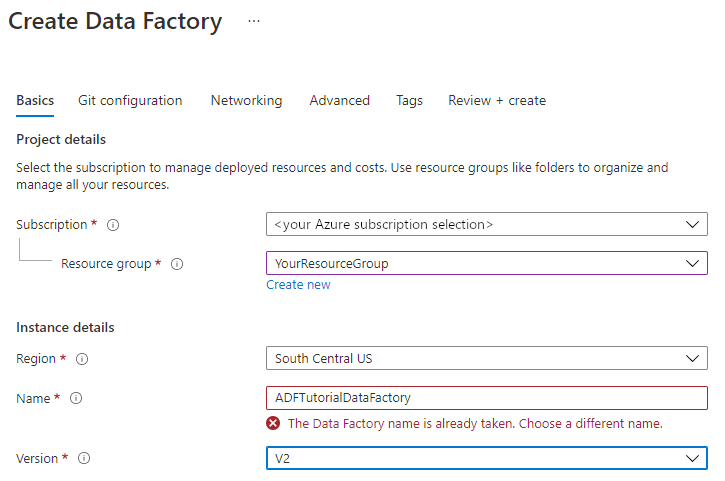

Pada halaman Buat Pabrik Data, di bawah tab Dasar, pilih Langganan Azure tempat Anda ingin membuat pabrik data.

Untuk Grup Sumber Daya, lakukan salah satu langkah berikut:

Pilih grup sumber daya yang ada di menu drop-down.

Pilih Buat baru, dan masukkan nama grup sumber daya baru.

Untuk mempelajari tentang grup sumber daya, lihat Menggunakan grup sumber daya untuk mengelola sumber daya Azure Anda.

Untuk Wilayah, pilih lokasi pabrik data.

Daftar ini hanya menampilkan lokasi yang didukung Data Factory, dan tempat meta data Azure Data Factory Anda akan disimpan. Penyimpanan (seperti Azure Storage dan Azure SQL Database) dan komputasi (seperti Azure HDInsight) data terkait yang digunakan Data Factory dapat berjalan di wilayah lain.

Untuk Nama, masukkan ADFTutorialDataFactory.

Nama pabrik data Azure harus bersifat unik secara global. Jika Anda melihat kesalahan berikut, ubah nama pabrik data (Misalnya, gunakan <yourname>ADFTutorialDataFactory). Untuk penamaan aturan untuk artefak Pabrik Data, lihat artikel Pabrik Data - aturan penamaan.

Untuk Versi, pilih V2.

Pilih Berikutnya: Konfigurasi Git, lalu pilih kotak centang Konfigurasikan Git nanti.

Pilih Tinjau + buat, lalu pilih Buat setelah validasi berhasil.

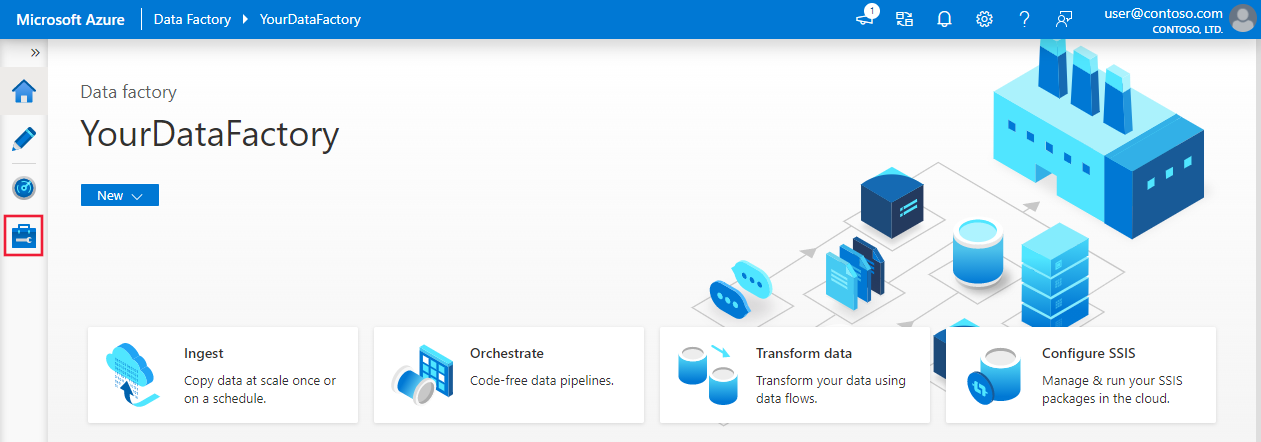

Setelah selesai membuat, pilih Buka sumber daya untuk menavigasi ke halaman Azure Data Factory. Pilih ubin Buka Azure Data Factory Studio untuk memulai aplikasi antarmuka pengguna (UI) Azure Data Factory pada tab browser terpisah.

Membuat layanan tertaut

Di bagian ini, Anda menulis layanan tertaut Databricks. Layanan tertaut ini berisi informasi koneksi ke kluster Databricks:

Membuat layanan tertaut Azure Databricks

Di halaman beranda, beralih ke tab Kelola di panel kiri.

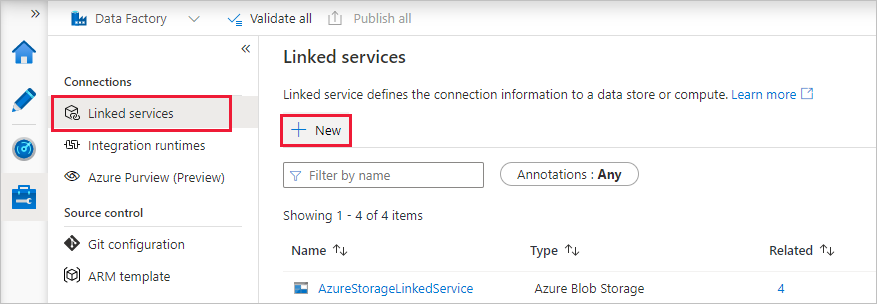

Pilih Layanan tertaut di bagian Koneksi, lalu pilih + Baru.

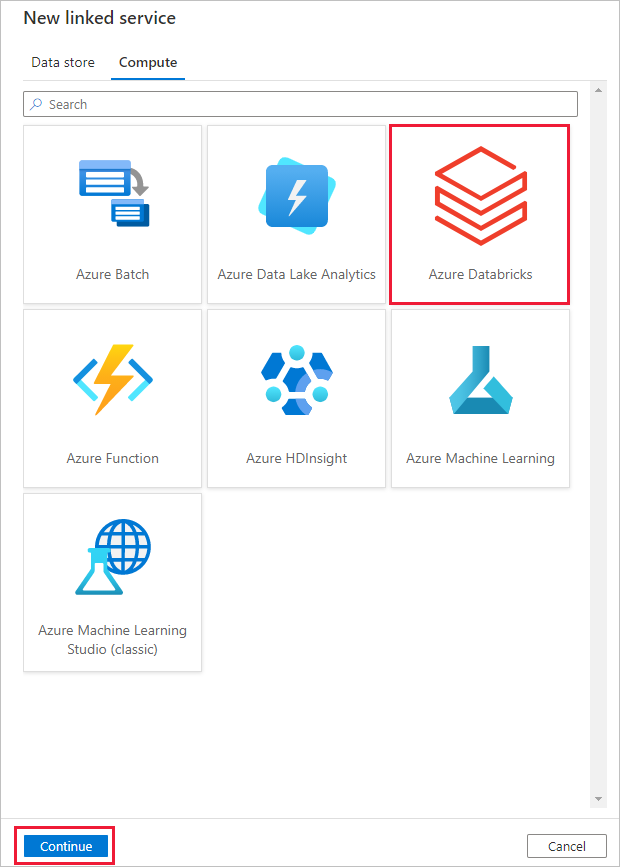

Di jendela Layanan tertaut baru, pilih Komputasi>Azure Databricks, lalu pilih Lanjutkan.

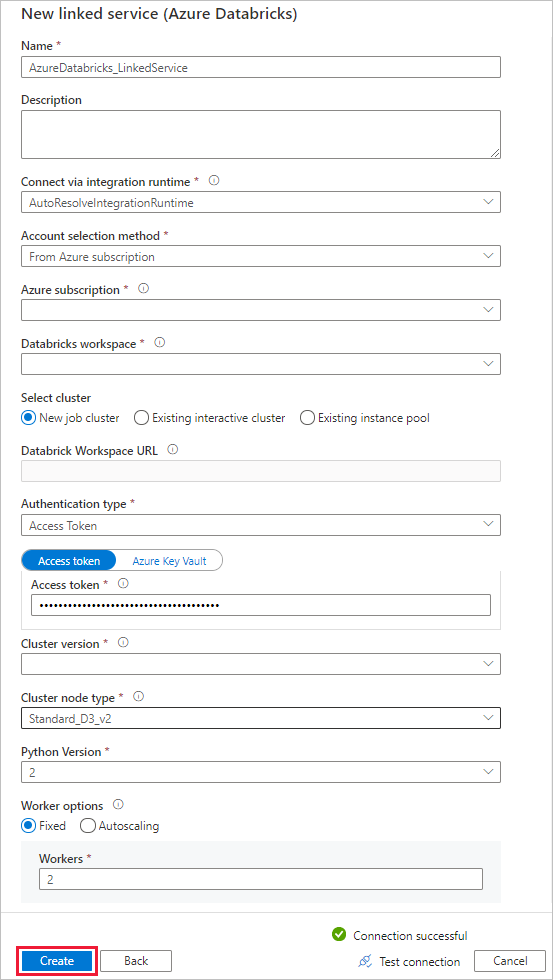

Di jendela Layanan tertaut baru, lakukan langkah-langkah berikut:

Untuk Nama, masukkan AzureDatabricks_LinkedService.

Pilih ruang kerja Databricks yang sesuai tempat Anda akan menjalankan buku catatan.

Untuk Pilih kluster, pilih Kluster pekerjaan baru.

Untuk URL Ruang Kerja Databricks, informasi harus diisi otomatis.

Untuk Jenis autentikasi, jika Anda memilih Token Akses, hasilkan dari tempat kerja Azure Databricks. Anda dapat menemukan langkah-langkahnya di sini. Untuk Identitas layanan terkelola dan Identitas Terkelola yang Ditetapkan Pengguna, berikan peran Kontributor ke kedua identitas di menu Kontrol akses sumber daya Azure Databricks.

Untuk Versi kluster, pilih versi yang ingin Anda gunakan.

Untuk Jenis node kluster, pilih Standar_D3_v2 di bawah kategori Tujuan Umum (HDD) untuk tutorial ini.

Untuk Pekerja, masukkan 2.

Pilih Buat.

Buat alur

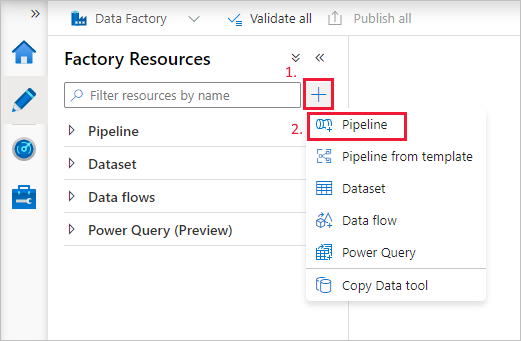

Pilih tombol (plus) +, lalu pilih Alur pada menu.

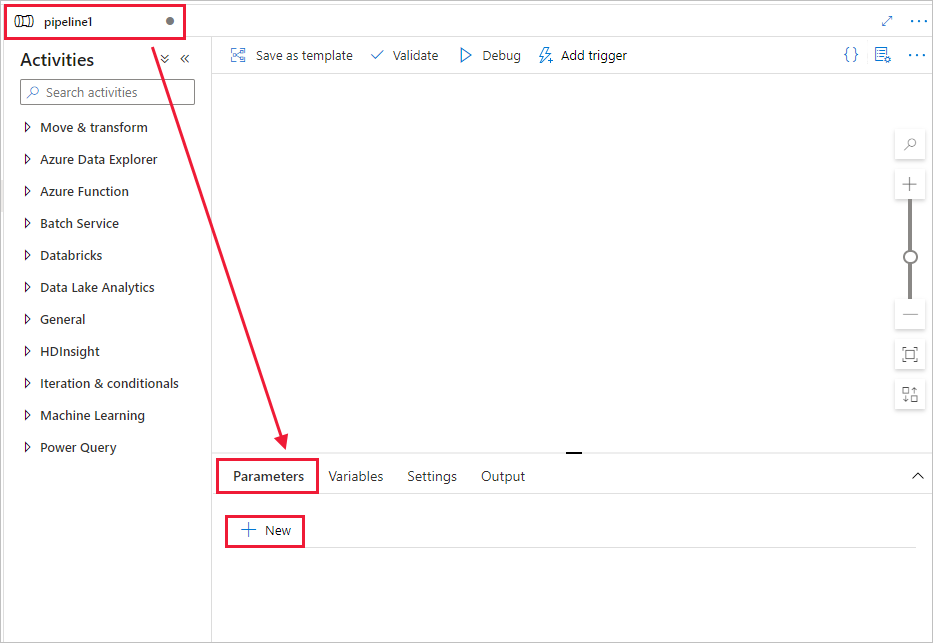

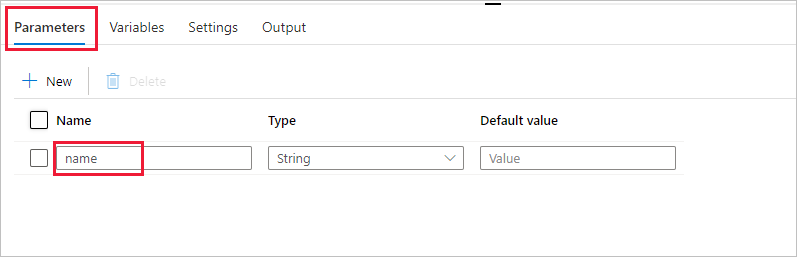

Buat parameter yang akan digunakan di Alur. Kemudian Anda meneruskan parameter ini ke Databricks Notebook Activity. Di alur yang kosong, klik tab Parameter, lalu pilih + Baru dan beri nama 'nama'.

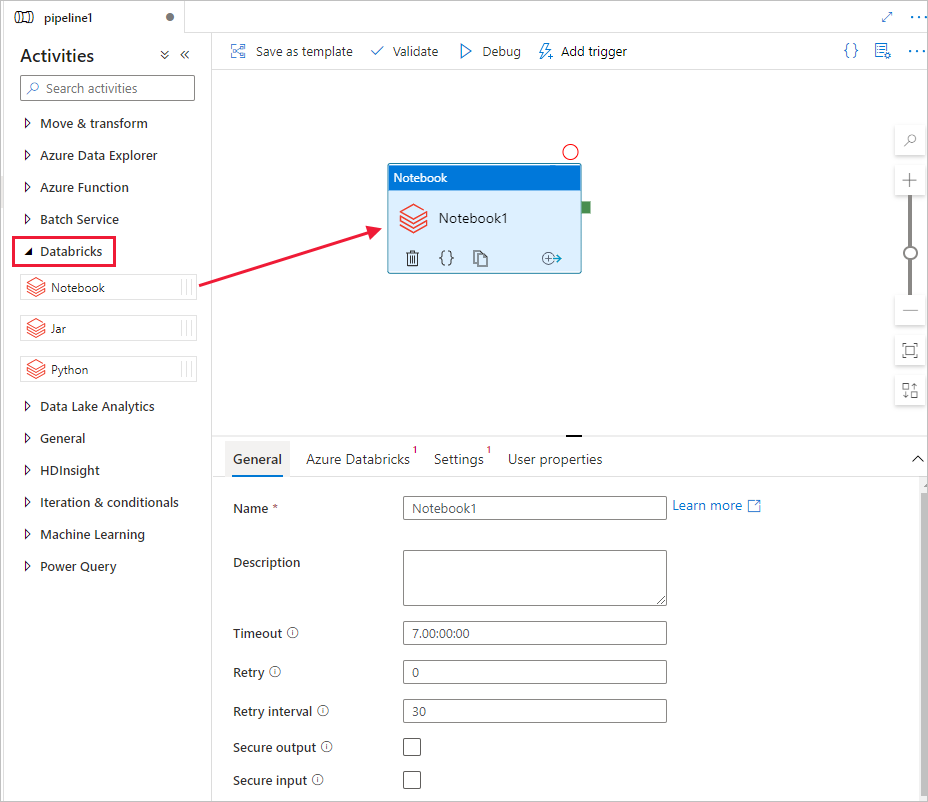

Di kotak alat Aktivitas, luaskan Databricks. Seret aktivitas Buku catatan dari kotak alat Aktivitas ke permukaan perancang alur.

Di properti untuk jendela aktivitas DatabricksNotebook pada bagian bawah, selesaikan langkah-langkah berikut ini:

Beralih ke tab Azure Databricks.

Pilih AzureDatabricks_LinkedService (yang Anda buat di prosedur sebelumnya).

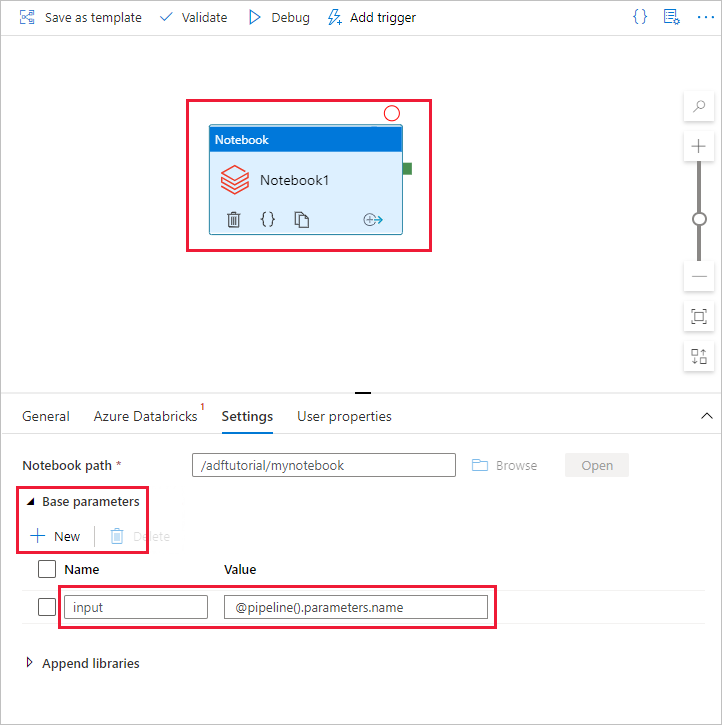

Beralih ke tab Pengaturan.

Telusuri untuk memilih jalur Databricks Notebook. Mari kita membuat buku catatan dan menentukan jalurnya di sini. Anda mendapatkan Jalur Notebook dengan mengikuti beberapa langkah berikutnya.

Luncurkan Ruang Kerja Azure Databricks Anda.

Buat Folder Baru di Tempat Kerja dan beri nama adftutorial.

Buat buku catatan baru, sebut saja mynotebook. Klik kanan Folder adftutorial, dan pilih Buat.

Di buku catatan yang baru dibuat "mynotebook'" tambahkan kode berikut:

# Creating widgets for leveraging parameters, and printing the parameters dbutils.widgets.text("input", "","") y = dbutils.widgets.get("input") print ("Param -\'input':") print (y)Jalur Buku Catatan dalam kasus ini adalah /adftutorial/mynotebook.

Beralih kembali ke alat penyusunan tulisan antarmuka pengguna Data Factory. Buka Tab Pengaturan di bagian aktivitas Notebook1.

sebuah. Tambahkan parameter ke aktivitas Buku Catatan. Anda menggunakan parameter yang sama dengan yang Anda tambahkan sebelumnya ke Alur.

b. Beri nama parameter sebagai input dan berikan nilai sebagai ekspresi @pipeline().parameters.name.

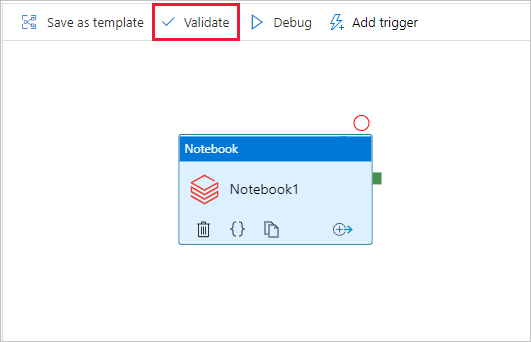

Untuk memvalidasi alur, klik tombol Validasi pada toolbar. Untuk menutup jendela validasi, pilih tombol Tutup.

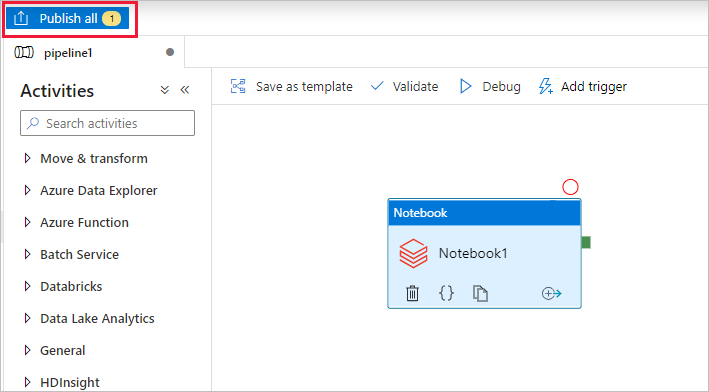

Pilih Terbitkan semua. Antarmuka pengguna Data Factory menerbitkan entitas (layanan dan alur tertaut) ke layanan Azure Data Factory.

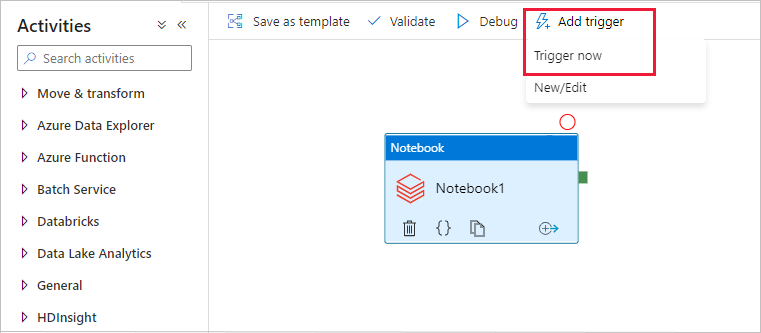

Memicu proses alur

Pilih Tambahkan pemicu pada toolbar, lalu pilih Picu sekarang.

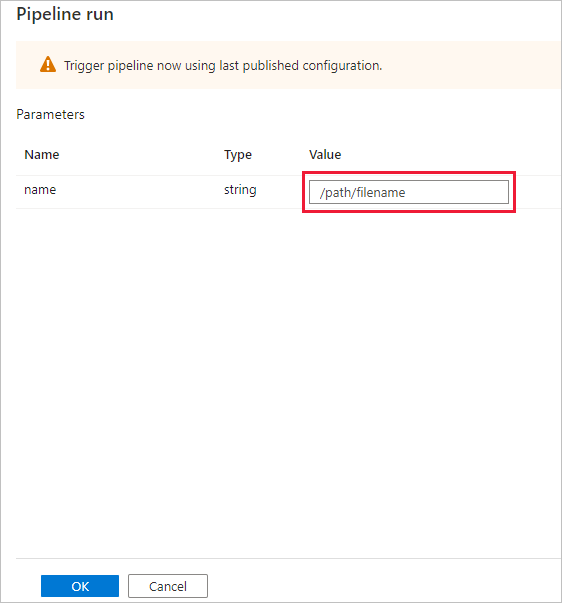

Kotak dialog Eksekusi alur meminta parameter nama. Gunakan /path/filename sebagai parameter di sini. Pilih OK.

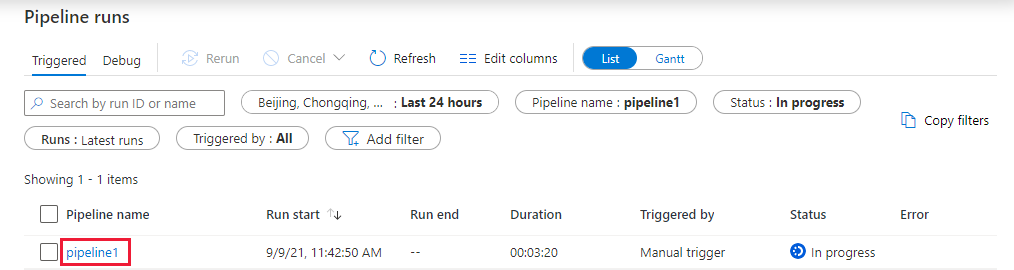

Memantau eksekusi alur

Beralih ke tab Monitor. Pastikan Anda melihat eksekusi alur. Dibutuhkan sekitar 5-8 menit untuk membuat kluster pekerjaan Databricks, tempat buku catatan dieksekusi.

Pilih Refresh secara berkala untuk memeriksa status eksekusi alur.

Untuk melihat eksekusi aktivitas yang terkait dengan eksekusi alur, pilih tautan pipeline1 di kolom Nama alur.

Di halaman Eksekusi aktivitas, pilih Output di kolom Nama aktivitas untuk melihat output setiap aktivitas, dan Anda bisa menemukan tautan menuju log Databricks di panel Output untuk log Spark yang lebih detail.

Untuk kembali ke tampilan alur yang dijalankan, pilih tautan Semua alur yang berjalan di menu remah roti di atas.

Verifikasi output

Anda dapat masuk ke ruang kerja Azure Databricks, buka Eksekusi Pekerjaan dan Anda dapat melihat status Pekerjaan sebagai eksekusi tertunda, berjalan, atau dihentikan.

Anda dapat memilih Nama pekerjaan dan menavigasi untuk melihat detail lebih lanjut. Jika berhasil dijalankan, Anda dapat memvalidasi parameter yang diteruskan dan output buku catatan Python.

Ringkasan

Alur dalam sampel ini memicu aktivitas Databricks Notebook dan meneruskan parameter ke sana. Anda mempelajari cara untuk:

Membuat pabrik data.

Membuat alur yang menggunakan aktivitas Databricks Notebook.

Memicu eksekusi alur.

Pantau eksekusi alur.