Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

Penting

Editor Alur Lakeflow ada di Pratinjau Umum.

Di Azure Databricks, Anda dapat mengontrol alur dan semua kode yang terkait dengannya. Dengan sumber yang mengontrol semua file yang terkait dengan alur Anda, perubahan pada kode transformasi, kode eksplorasi, dan konfigurasi alur Anda semuanya diberi versi di Git dan dapat diuji dalam pengembangan dan disebarkan dengan percaya diri ke produksi.

Alur yang dikontrol sumber menawarkan keuntungan berikut:

- Keterlacakan: Ambil setiap perubahan dalam riwayat Git.

- Pengujian: Memvalidasi perubahan alur di ruang kerja pengembangan sebelum mempromosikan ke ruang kerja produksi bersama. Setiap pengembang memiliki alur pengembangan mereka sendiri di cabang kode mereka sendiri di folder Git dan dalam skema mereka sendiri.

- Kolaborasi: Ketika pengembangan dan pengujian individu selesai, perubahan kode didorong ke alur produksi utama.

- Tata kelola: Selaras dengan CI/CD perusahaan dan standar penyebaran.

Azure Databricks memungkinkan alur dan file sumbernya dikontrol sumber bersama-sama menggunakan Bundel Aset Databricks. Dengan bundel, konfigurasi jalur konveyor dikendalikan oleh kontrol sumber dalam bentuk file konfigurasi YAML bersama file sumber Python atau SQL dari jalur konveyor. Satu bundel mungkin memiliki satu atau banyak alur, serta jenis sumber daya lainnya, seperti pekerjaan.

Halaman ini memperlihatkan cara menyiapkan alur yang dikontrol sumber menggunakan Bundel Aset Databricks. Untuk informasi selengkapnya tentang bundel, lihat Apa itu Bundel Aset Databricks?.

Persyaratan

Untuk membuat alur yang dikontrol sumber, Anda harus sudah memiliki:

- Folder Git yang dibuat di ruang kerja Anda dan dikonfigurasi. Folder Git memungkinkan pengguna individual untuk menulis dan menguji perubahan sebelum menerapkannya ke repositori Git. Lihat Folder Git Azure Databricks.

- Editor Alur Lakeflow diaktifkan. UI yang dijelaskan dalam tutorial ini hanya tersedia dalam pengalaman editor ini. Lihat Mengembangkan dan men-debug alur ETL dengan Editor Alur Lakeflow.

Membuat alur baru dalam bundel

Nota

Databricks merekomendasikan pembuatan alur yang dikontrol sumber dari awal. Atau, Anda dapat menambahkan alur yang ada ke bundel yang sudah dikontrol sumber. Lihat Memigrasikan sumber daya yang ada ke bundel.

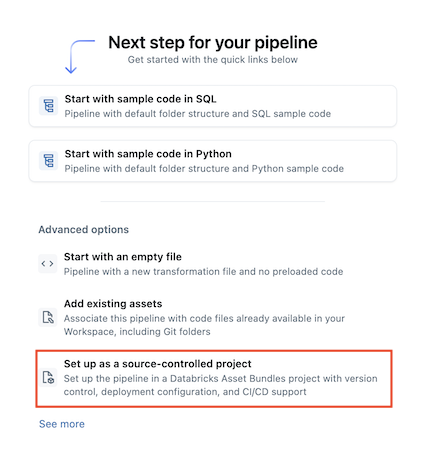

Untuk membuat alur baru yang dikontrol sumber:

Di ruang kerja, buka

Baru>

Alur ETL.

Pilih

Penyiapan sebagai proyek yang dikontrol sumber:

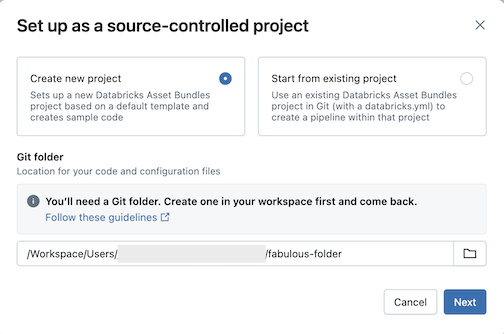

Klik Buat proyek baru, lalu pilih folder Git tempat Anda ingin meletakkan kode dan konfigurasi Anda:

Klik Berikutnya.

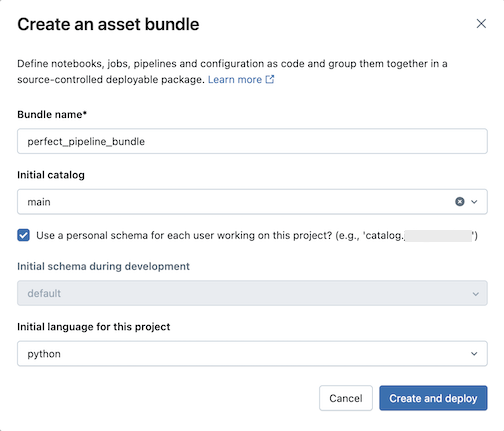

Masukkan yang berikut ini dalam dialog Buat bundel aset :

- Nama bundel: Nama bundel.

- Katalog awal: Nama katalog yang berisi skema yang akan digunakan.

- Gunakan skema pribadi: Biarkan kotak ini dicentang jika Anda ingin mengisolasi pengeditan ke skema pribadi, agar perubahan satu sama lain tidak saling menimpa ketika pengguna di organisasi Anda berkolaborasi pada proyek yang sama dalam pengembangan.

- Bahasa awal: Bahasa awal yang digunakan untuk file alur sampel proyek, baik Python atau SQL.

Klik Buat dan sebarkan. Bundel dengan pipa dibuat di folder Git.

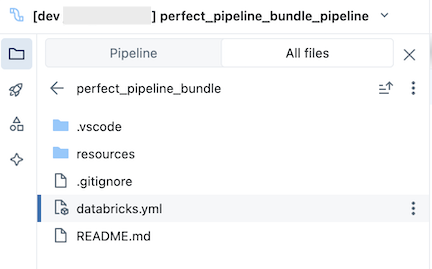

Menjelajahi bundel proses

Selanjutnya, jelajahi bundel pipa yang dibuat.

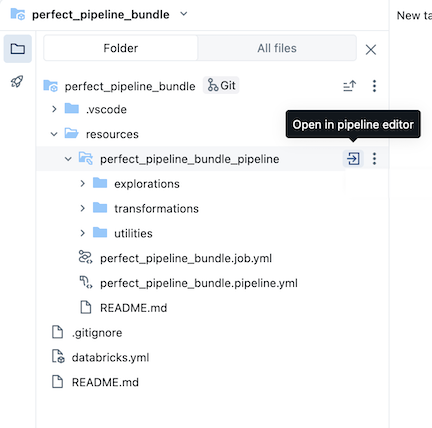

Bundel, yang ada di folder Git, berisi file sistem bundel dan databricks.yml file, yang menentukan variabel, URL dan izin ruang kerja target, dan pengaturan lain untuk bundel. Folder resources bundel adalah tempat di mana definisi untuk sumber daya seperti alur data terkandung.

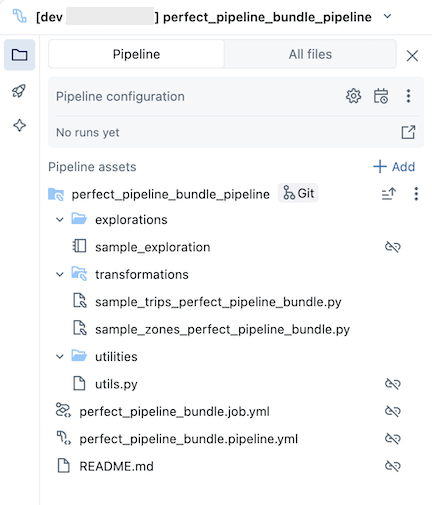

resources Buka folder, lalu klik tombol editor alur untuk melihat alur yang dikontrol sumber:

Contoh bundel alur mencakup file berikut:

Contoh buku catatan eksplorasi

Dua file kode sampel yang melakukan transformasi pada tabel

File kode sampel yang berisi fungsi utilitas

File YAML konfigurasi pekerjaan yang mendefinisikan tugas dalam satu bundel yang menjalankan pipeline

File YAML konfigurasi alur yang menentukan alur

Penting

Anda harus mengedit file ini untuk menyimpan secara permanen setiap perubahan konfigurasi pada pipeline, termasuk perubahan yang dilakukan melalui UI. Jika tidak, perubahan UI akan ditimpa saat bundel dideploy ulang. Misalnya, untuk mengatur katalog default yang berbeda untuk alur pemrosesan, editlah

catalogbidang dalam berkas konfigurasi ini.File README dengan detail tambahan tentang sampel bundel alur dan instruksi tentang cara menjalankan alur

Untuk informasi tentang file pipeline, lihat Browser aset pipeline.

Untuk informasi selengkapnya tentang penulisan dan penyebaran perubahan pada bundel alur, lihat Bundel penulis di ruang kerja dan Menyebarkan bundel dan menjalankan alur kerja dari ruang kerja.

Menjalankan rangkaian proses

Anda dapat menjalankan transformasi individual atau seluruh alur yang dikontrol sumber:

- Untuk menjalankan dan melihat pratinjau sebuah transformasi tunggal dalam pipeline, pilih berkas transformasi di pohon browser ruang kerja untuk membukanya di penyunting berkas. Di bagian atas file di editor, klik tombol Jalankan pemutaran file .

- Untuk menjalankan semua transformasi dalam alur, klik tombol Jalankan alur di kanan atas ruang kerja Databricks.

Untuk informasi selengkapnya tentang menjalankan alur, lihat Menjalankan kode alur.

Memperbarui alur

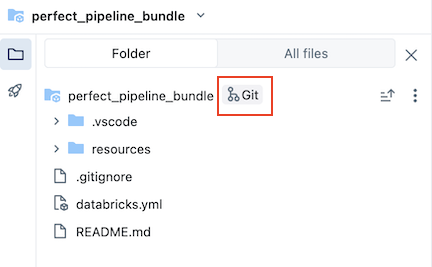

Anda dapat memperbarui artefak dalam alur Anda atau menambahkan eksplorasi dan transformasi tambahan, tetapi kemudian Anda ingin mendorong perubahan tersebut ke GitHub. Klik ikon Git yang terkait dengan bundel alur atau klik menu kebab (ikon tiga titik) untuk folder lalu Git... untuk memilih perubahan mana yang akan didorong. Lihat Menerapkan dan mendorong perubahan.

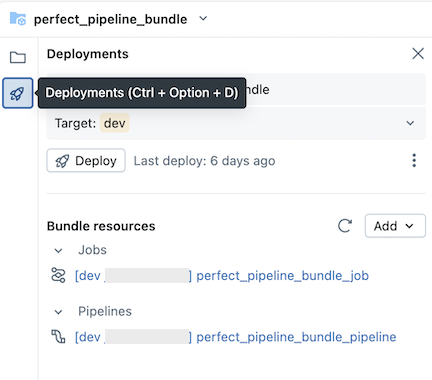

Selain itu, saat Anda memperbarui file konfigurasi alur atau menambahkan atau menghapus file dari bundel, perubahan ini tidak disebarkan ke ruang kerja target hingga Anda secara eksplisit menyebarkan bundel. Lihat Menyebarkan bundel dan menjalankan alur kerja dari ruang kerja.

Nota

Databricks merekomendasikan agar Anda mempertahankan pengaturan default untuk pipeline yang dikontrol sumber. Pengaturan bawaan dikonfigurasi sedemikian rupa sehingga Anda tidak perlu mengedit konfigurasi YAML bundel pipeline ketika file tambahan ditambahkan melalui UI.

Menambahkan alur yang sudah ada ke bundel

Untuk menambahkan alur yang ada ke bundel, pertama-tama buat bundel di ruang kerja, lalu tambahkan definisi YAML alur ke bundel, seperti yang dijelaskan di halaman berikut:

Untuk informasi tentang cara memigrasikan sumber daya ke bundel menggunakan Databricks CLI, lihat Memigrasikan sumber daya yang ada ke bundel.

Sumber daya tambahan

Untuk tutorial tambahan dan materi referensi untuk alur, lihat Alur Deklaratif Lakeflow Spark.