Memigrasikan LLM yang dioptimalkan yang melayani titik akhir ke throughput yang disediakan

Artikel ini menjelaskan cara memigrasikan LLM yang ada yang melayani titik akhir ke pengalaman throughput yang disediakan yang tersedia menggunakan API Model Foundation.

Apa yang berubah?

Throughput yang disediakan memberikan pengalaman yang lebih sederhana untuk meluncurkan LLM yang dioptimalkan yang melayani titik akhir. Databricks telah memodifikasi sistem penyajian model LLM mereka sehingga:

- Rentang peluasan skala dapat dikonfigurasi dalam istilah ASLI LLM, seperti token per detik alih-alih konkurensi.

- Pelanggan tidak perlu lagi memilih jenis beban kerja GPU itu sendiri.

Titik akhir penyajian LLM baru dibuat dengan throughput yang disediakan secara default. Jika Anda ingin terus memilih jenis beban kerja GPU, pengalaman ini hanya didukung menggunakan API.

Memigrasikan LLM yang melayani titik akhir ke throughput yang disediakan

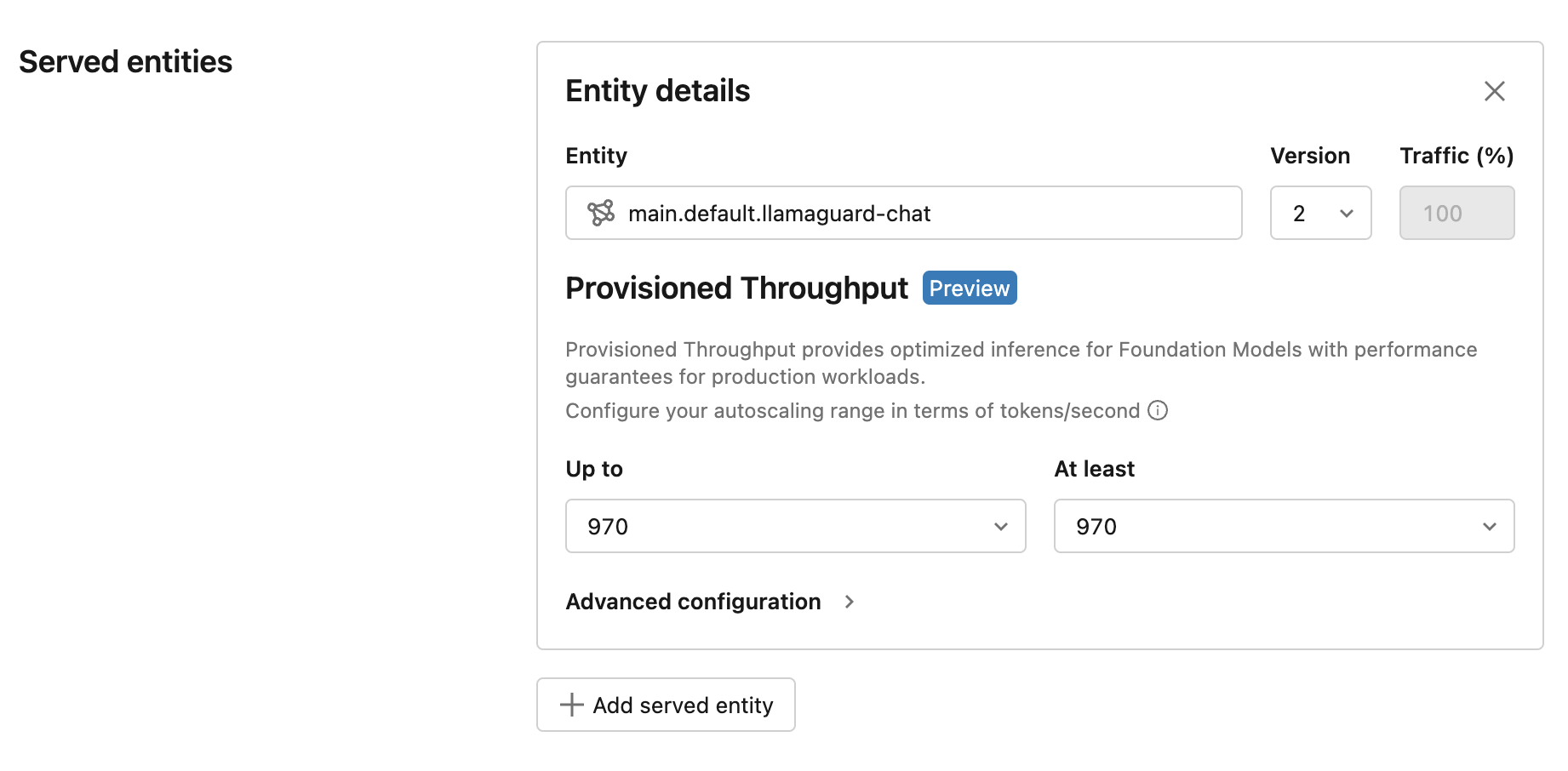

Cara paling sederhana untuk memigrasikan titik akhir yang ada ke throughput yang disediakan adalah dengan memperbarui titik akhir Anda dengan versi model baru. Setelah Anda memilih versi model baru, UI menampilkan pengalaman untuk throughput yang disediakan. UI menunjukkan token per rentang detik berdasarkan tolok ukur Databricks untuk kasus penggunaan umum.

Performa dengan penawaran yang diperbarui ini benar-benar lebih baik karena peningkatan pengoptimalan, dan harga untuk titik akhir Anda tetap tidak berubah. Silakan hubungi untuk model-serving-feedback@databricks.com umpan balik atau kekhawatiran produk.