Azure Event Hubs: Platform streaming data real-time dengan dukungan Apache Kafka asli

Azure Event Hubs adalah layanan streaming data asli di cloud yang dapat mengalirkan jutaan peristiwa per detik, dengan latensi rendah, dari sumber apa pun ke tujuan apa pun. Azure Event Hubs kompatibel dengan Apache Kafka. Ini memungkinkan Anda menjalankan beban kerja Kafka yang ada tanpa perubahan kode apa pun.

Bisnis dapat menggunakan Azure Event Hubs untuk menyerap dan menyimpan data streaming. Dengan menggunakan data streaming, bisnis dapat memperoleh wawasan berharga, mendorong analitik real time, dan menanggapi peristiwa saat terjadi. Mereka dapat menggunakan data ini untuk meningkatkan efisiensi keseluruhan dan pengalaman pelanggan mereka.

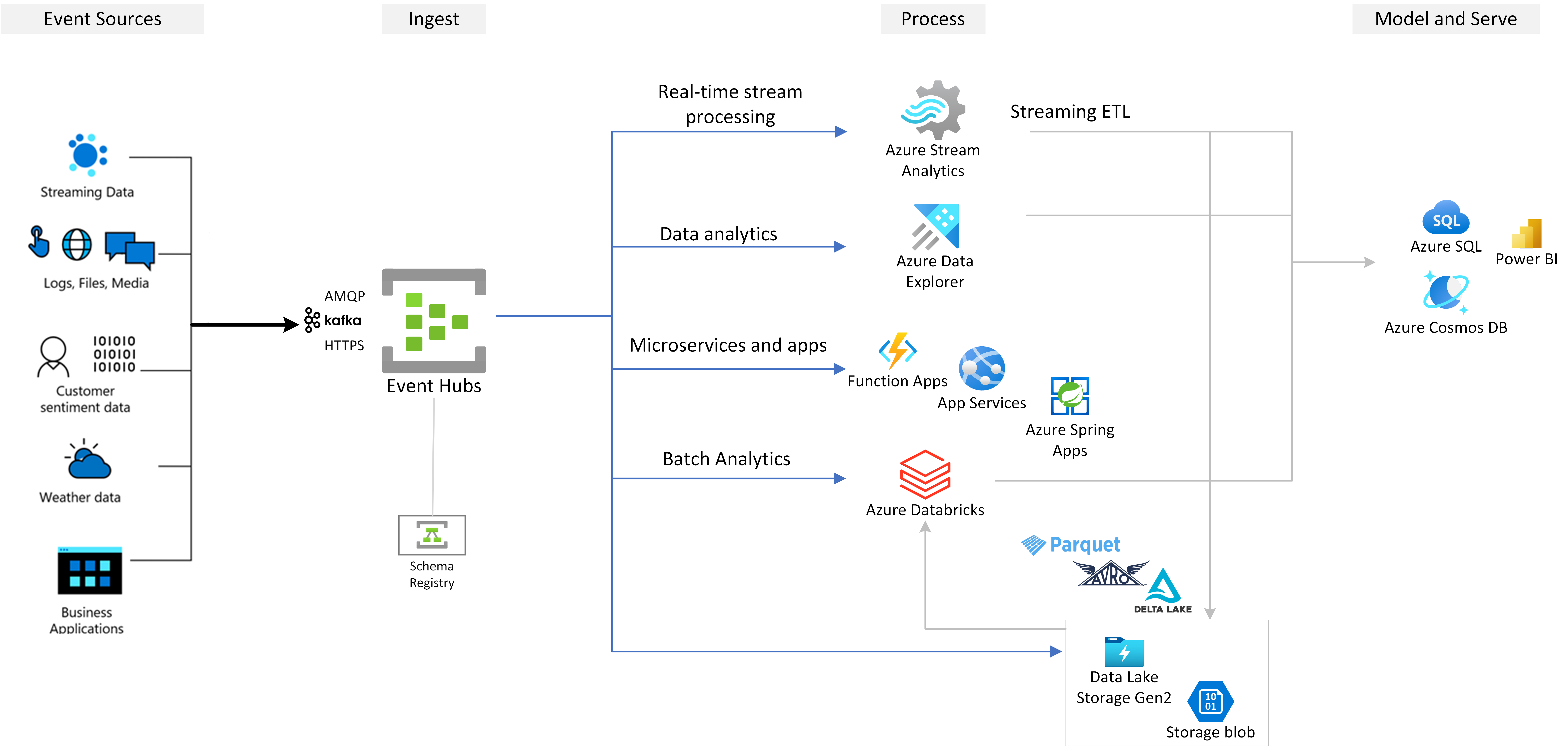

Azure Event Hubs adalah lapisan penyerapan peristiwa pilihan dari solusi streaming peristiwa apa pun yang Anda bangun di atas Azure. Ini terintegrasi dengan layanan data dan analitik di dalam dan di luar Azure untuk membangun alur streaming data lengkap untuk melayani kasus penggunaan berikut:

- Memproses data dari pusat aktivitas Anda dengan menggunakan Azure Stream Analytics untuk menghasilkan wawasan real time.

- Menganalisis dan menjelajahi data streaming dengan Azure Data Explorer.

- Buat aplikasi, fungsi, atau layanan mikro cloud asli Anda sendiri yang berjalan pada data streaming dari Azure Event Hubs.

- Streaming peristiwa dengan validasi skema dengan menggunakan Azure Schema Registry bawaan untuk memastikan kualitas dan kompatibilitas data streaming.

Kemampuan utama

Pelajari tentang kemampuan utama Azure Event Hubs di bagian berikut.

Apache Kafka di Azure Event Hubs

Event Hubs adalah mesin streaming peristiwa multi-protokol yang secara asli mendukung protokol Advanced Message Queuing Protocol (AMQP), Apache Kafka, dan HTTPS. Karena mendukung Apache Kafka, Anda dapat membawa beban kerja Kafka ke Azure Event Hubs tanpa membuat perubahan kode apa pun. Anda tidak perlu menyiapkan, mengonfigurasi, atau mengelola kluster Kafka Anda sendiri atau menggunakan penawaran Kafka-as-a-service yang tidak asli ke Azure.

Azure Event Hubs dibangun sebagai mesin broker asli cloud. Untuk alasan ini, Anda dapat menjalankan beban kerja Kafka dengan performa yang lebih baik, efisiensi biaya yang lebih baik, dan tanpa overhead operasional.

Untuk informasi selengkapnya, lihat Azure Event Hubs untuk Apache Kafka.

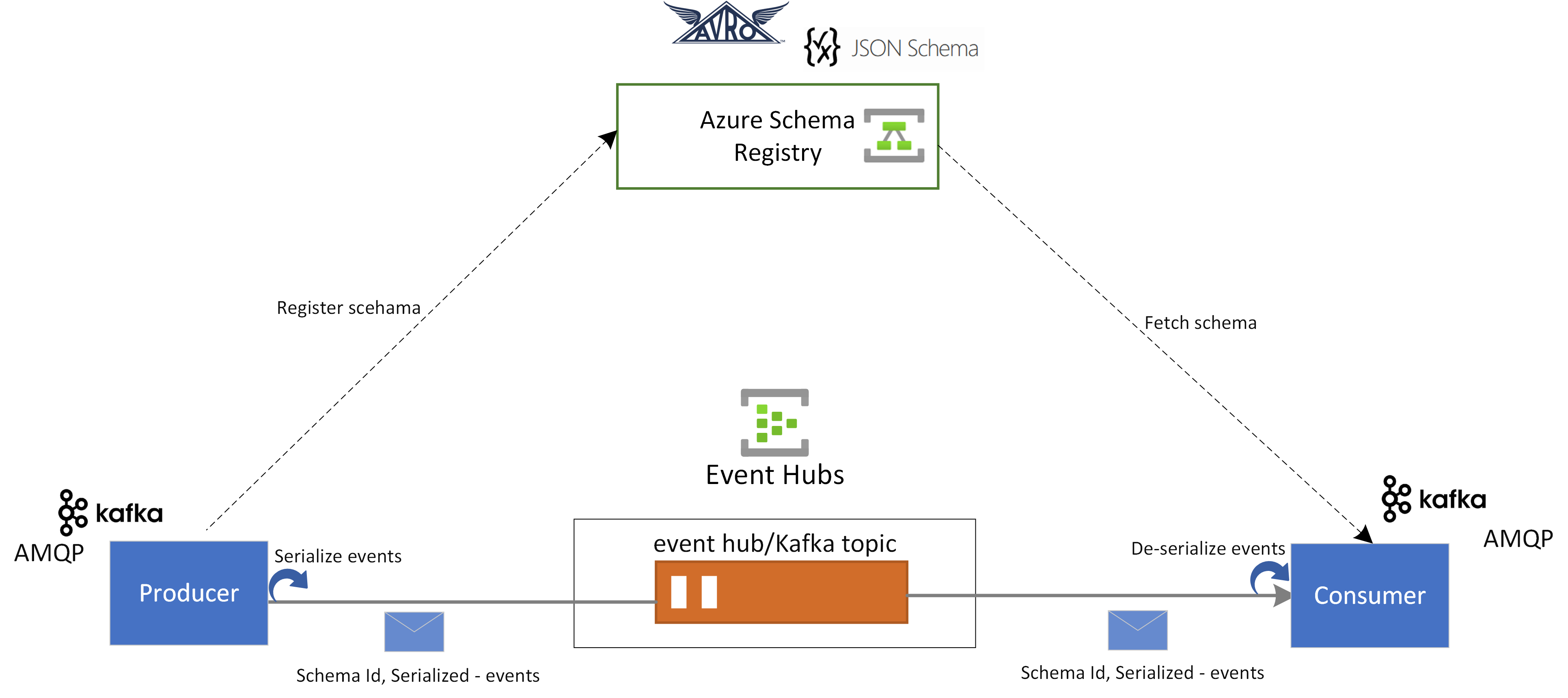

Registri Skema di Azure Event Hubs

Azure Schema Registry di Azure Event Hubs menyediakan repositori terpusat untuk mengelola skema aplikasi streaming peristiwa. Schema Registry hadir gratis dengan setiap namespace Azure Event Hubs. Ini terintegrasi dengan aplikasi Kafka atau aplikasi berbasis Azure Event Hubs SDK Anda.

Registri Skema memastikan kompatibilitas dan konsistensi data di seluruh produsen dan konsumen peristiwa. Ini memungkinkan evolusi skema, validasi, dan tata kelola dan mempromosikan pertukaran data dan interoperabilitas yang efisien.

Registri Skema terintegrasi dengan aplikasi Kafka Anda yang ada dan mendukung beberapa format skema, termasuk skema Avro dan JSON.

Untuk informasi selengkapnya, lihat Azure Schema Registry di Pusat Aktivitas.

Pemrosesan peristiwa streaming secara real time dengan Azure Stream Analytics

Azure Event Hubs terintegrasi dengan Azure Stream Analytics untuk mengaktifkan pemrosesan aliran real time. Dengan editor tanpa kode bawaan, Anda dapat mengembangkan pekerjaan Azure Stream Analytics dengan menggunakan fungsionalitas seret dan letakkan, tanpa menulis kode apa pun.

Atau, pengembang dapat menggunakan bahasa kueri Azure Stream Analytics berbasis SQL untuk melakukan pemrosesan aliran real time dan memanfaatkan berbagai fungsi untuk menganalisis data streaming.

Untuk informasi selengkapnya, lihat artikel di bagian integrasi Azure Stream Analytics dari daftar isi.

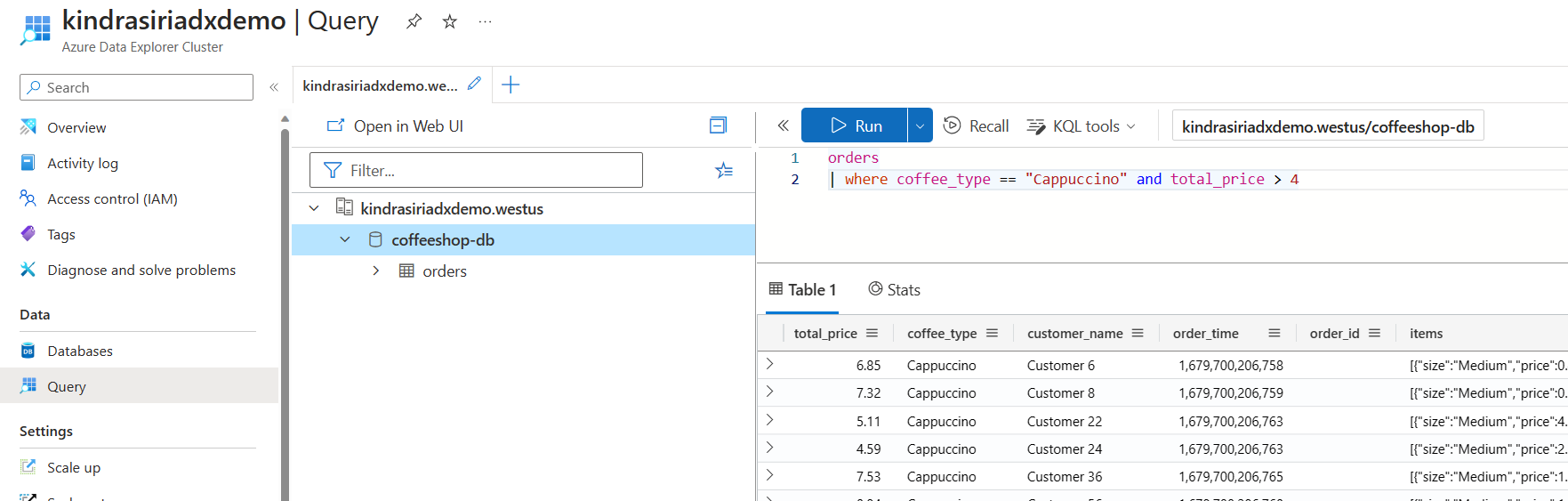

Menjelajahi data streaming dengan Azure Data Explorer

Azure Data Explorer adalah platform yang dikelola sepenuhnya untuk analitik big data yang memberikan performa tinggi dan memungkinkan analisis data dalam volume besar hampir real time. Dengan mengintegrasikan Event Hubs dengan Azure Data Explorer, Anda dapat melakukan analitik hampir real time dan eksplorasi data streaming.

Untuk informasi selengkapnya, lihat Menyerap data dari pusat aktivitas ke Azure Data Explorer.

Fungsi Azure, SDK, dan ekosistem Kafka

Dengan Azure Event Hubs, Anda dapat menyerap, buffer, menyimpan, dan memproses streaming Anda secara real time untuk mendapatkan wawasan yang dapat ditindaklanjuti. Azure Event Hubs menggunakan model konsumen yang dipartisi. Ini memungkinkan beberapa aplikasi untuk memproses aliran secara bersamaan dan memungkinkan Anda mengontrol kecepatan pemrosesan. Azure Event Hubs juga terintegrasi dengan Azure Functions untuk arsitektur tanpa server.

Ekosistem yang luas tersedia untuk protokol AMQP 1.0 standar industri. SDK tersedia dalam bahasa seperti .NET, Java, Python, dan JavaScript, sehingga Anda dapat mulai memproses streaming dari Azure Event Hubs. Semua bahasa klien yang didukung menyediakan integrasi tingkat rendah.

Ekosistem ini juga memungkinkan Anda untuk berintegrasi dengan Azure Functions, Azure Spring Apps, Kafka Connectors, dan platform dan teknologi analitik data lainnya, seperti Apache Spark dan Apache Flink.

Streaming peristiwa yang fleksibel dan hemat biaya

Anda dapat mengalami streaming peristiwa yang fleksibel dan hemat biaya melalui tingkat Standar, Premium, atau Khusus untuk Azure Event Hubs. Opsi ini memenuhi kebutuhan streaming data yang berkisar dari beberapa MB/detik hingga beberapa GB/detik. Anda dapat memilih kecocokan yang sesuai dengan kebutuhan Anda.

Dapat diskalakan

Dengan Azure Event Hubs, Anda dapat memulai dengan aliran data dalam megabyte dan tumbuh menjadi gigabyte atau terabyte. Fitur auto-inflate adalah salah satu opsi yang tersedia untuk menskalakan jumlah unit throughput atau unit pemrosesan untuk memenuhi kebutuhan penggunaan Anda.

Mendukung streaming pesan besar

Dalam sebagian besar skenario streaming, data ditandai dengan ringan, biasanya kurang dari 1 MB, dan memiliki throughput tinggi. Ada juga instans di mana pesan tidak dapat dibagi menjadi segmen yang lebih kecil. Azure Event Hubs dapat mengakomodasi peristiwa hingga 20 MB dengan kluster khusus yang dapat diskalakan mandiri tanpa biaya tambahan. Kemampuan ini memungkinkan Azure Event Hubs untuk menangani berbagai ukuran pesan untuk memastikan operasi bisnis yang tidak terganggu. Untuk informasi selengkapnya, lihat Mengirim dan menerima pesan besar dengan Azure Event Hubs.

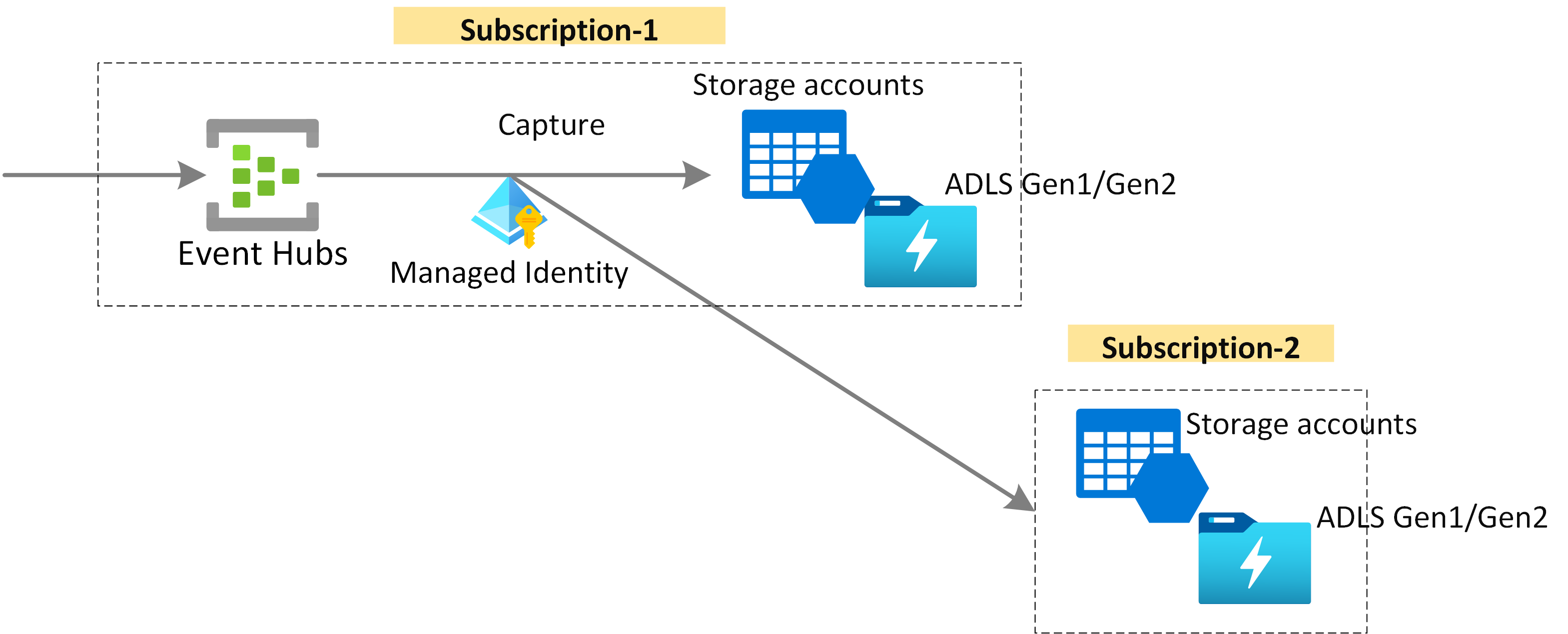

Mengambil data streaming untuk retensi jangka panjang dan analitik batch

Ambil data Anda hampir real time di Azure Blob Storage atau Azure Data Lake Storage untuk retensi jangka panjang atau pemrosesan batch mikro. Anda dapat mencapai perilaku ini pada aliran yang sama dengan yang Anda gunakan untuk mendapatkan analitik real time. Menyiapkan tangkapan data peristiwa itu cepat.

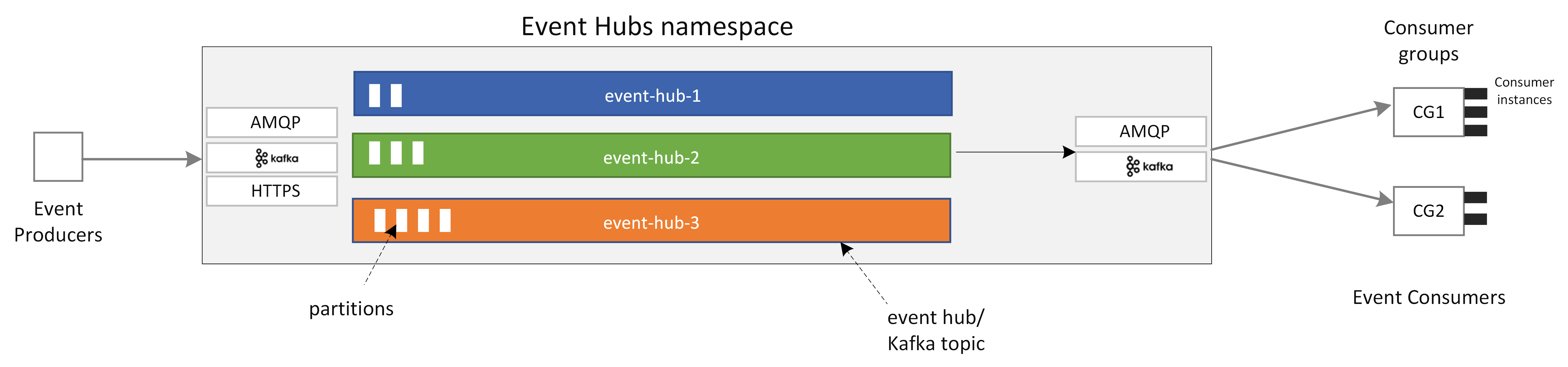

Cara kerjanya

Azure Event Hubs menyediakan platform streaming peristiwa terpadu dengan buffer penyimpanan waktu, memisahkan produsen peristiwa dari konsumen peristiwa. Aplikasi produsen dan konsumen dapat melakukan penyerapan data skala besar melalui beberapa protokol.

Diagram berikut menunjukkan komponen utama arsitektur Azure Event Hubs.

Komponen fungsi utama Azure Event Hubs meliputi:

- Aplikasi produsen: Aplikasi ini dapat menyerap data ke pusat aktivitas dengan menggunakan SDK Azure Event Hubs atau klien produsen Kafka apa pun.

- Namespace: Kontainer manajemen untuk satu atau beberapa hub peristiwa atau topik Kafka. Tugas manajemen seperti mengalokasikan kapasitas streaming, mengonfigurasi keamanan jaringan, dan mengaktifkan pemulihan bencana geografis ditangani di tingkat namespace layanan.

- Topik Azure Event Hubs/Kafka: Di Azure Event Hubs, Anda dapat mengatur peristiwa ke pusat aktivitas atau topik Kafka. Ini adalah log terdistribusi khusus tambahan, yang dapat terdiri dari satu atau beberapa partisi.

- Partisi: Partisi digunakan untuk menskalakan pusat aktivitas. Mereka seperti jalur di jalan bebas hambatan. Jika Anda memerlukan lebih banyak throughput streaming, Anda dapat menambahkan lebih banyak partisi.

- Aplikasi konsumen: Aplikasi ini dapat menggunakan data dengan mencari melalui log peristiwa dan memelihara offset konsumen. Konsumen dapat menjadi klien konsumen Kafka atau klien Event Hubs SDK.

- Grup konsumen: Grup logis instans konsumen ini membaca data dari pusat aktivitas atau topik Kafka. Ini memungkinkan beberapa konsumen untuk membaca data streaming yang sama di pusat aktivitas secara independen dengan kecepatan mereka sendiri dan dengan offset mereka sendiri.

Konten terkait

Untuk mulai menggunakan Azure Event Hubs, lihat mulai cepat berikut ini.

Melakukan streaming data dengan menggunakan Event Hubs SDK (AMQP)

Anda dapat menggunakan salah satu sampel berikut untuk mengalirkan data ke Azure Event Hubs dengan menggunakan SDK.

Melakukan streaming data dengan menggunakan Apache Kafka

Anda dapat menggunakan sampel berikut untuk mengalirkan data dari aplikasi Kafka Anda ke Azure Event Hubs.

Validasi skema dengan Schema Registry

Anda dapat menggunakan Event Hubs Schema Registry untuk melakukan validasi skema untuk aplikasi streaming acara Anda.

Saran dan Komentar

Segera hadir: Sepanjang tahun 2024 kami akan menghentikan penggunaan GitHub Issues sebagai mekanisme umpan balik untuk konten dan menggantinya dengan sistem umpan balik baru. Untuk mengetahui informasi selengkapnya, lihat: https://aka.ms/ContentUserFeedback.

Kirim dan lihat umpan balik untuk