Mulai menggunakan data DICOM dalam beban kerja analitik

Artikel ini menjelaskan cara mulai menggunakan data DICOM® dalam beban kerja analitik dengan Azure Data Factory dan Microsoft Fabric.

Prasyarat

Sebelum Memulai, selesaikan langkah-langkah berikut:

- Buat akun penyimpanan dengan kemampuan Azure Data Lake Storage Gen2 dengan mengaktifkan namespace hierarkis:

- Buat kontainer untuk menyimpan metadata DICOM, misalnya, bernama

dicom.

- Buat kontainer untuk menyimpan metadata DICOM, misalnya, bernama

- Sebarkan instans layanan DICOM.

- (Opsional) Sebarkan layanan DICOM dengan Data Lake Storage untuk mengaktifkan akses langsung ke file DICOM.

- Membuat instans Data Factory :

- Aktifkan identitas terkelola yang ditetapkan sistem.

- Buat lakehouse di Fabric.

- Tambahkan penetapan peran ke identitas terkelola yang ditetapkan sistem Data Factory untuk layanan DICOM dan akun penyimpanan Data Lake Storage Gen2:

- Tambahkan peran Pembaca Data DICOM untuk memberikan izin ke layanan DICOM.

- Tambahkan peran Kontributor Data Blob Penyimpanan untuk memberikan izin ke akun Data Lake Storage Gen2.

Mengonfigurasi alur Data Factory untuk layanan DICOM

Dalam contoh ini, alur Data Factory digunakan untuk menulis atribut DICOM untuk instans, seri, dan studi ke akun penyimpanan dalam format tabel Delta.

Dari portal Azure, buka instans Data Factory dan pilih Luncurkan studio untuk memulai.

Membuat layanan tertaut

Alur Data Factory dibaca dari sumber data dan menulis ke sink data, yang biasanya merupakan layanan Azure lainnya. Koneksi ke layanan lain ini dikelola sebagai layanan tertaut.

Alur dalam contoh ini membaca data dari layanan DICOM dan menulis outputnya ke akun penyimpanan, sehingga layanan tertaut harus dibuat untuk keduanya.

Membuat layanan tertaut untuk layanan DICOM

Di Azure Data Factory Studio, pilih Kelola dari menu di sebelah kiri. Di bawah Koneksi, pilih Layanan tertaut lalu pilih Baru.

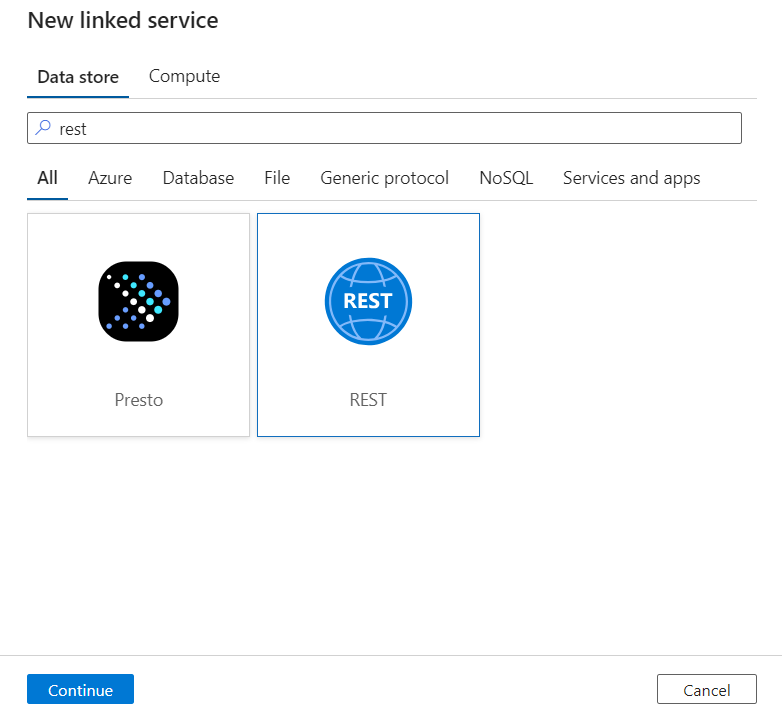

Pada panel Layanan tertaut baru, cari REST. Pilih petak PETA REST lalu pilih Lanjutkan.

Masukkan Nama dan Deskripsi untuk layanan tertaut.

Di bidang URL Dasar, masukkan URL layanan untuk layanan DICOM Anda. Misalnya, layanan DICOM bernama

contosoclinicdicontosohealthruang kerja memiliki URLhttps://contosohealth-contosoclinic.dicom.azurehealthcareapis.comlayanan .Untuk Jenis autentikasi, pilih Identitas Terkelola yang Ditetapkan Sistem.

Untuk sumber daya AAD, masukkan

https://dicom.healthcareapis.azure.com. URL ini sama untuk semua instans layanan DICOM.Setelah Anda mengisi bidang yang diperlukan, pilih Uji koneksi untuk memastikan peran identitas dikonfigurasi dengan benar.

Saat pengujian koneksi berhasil, pilih Buat.

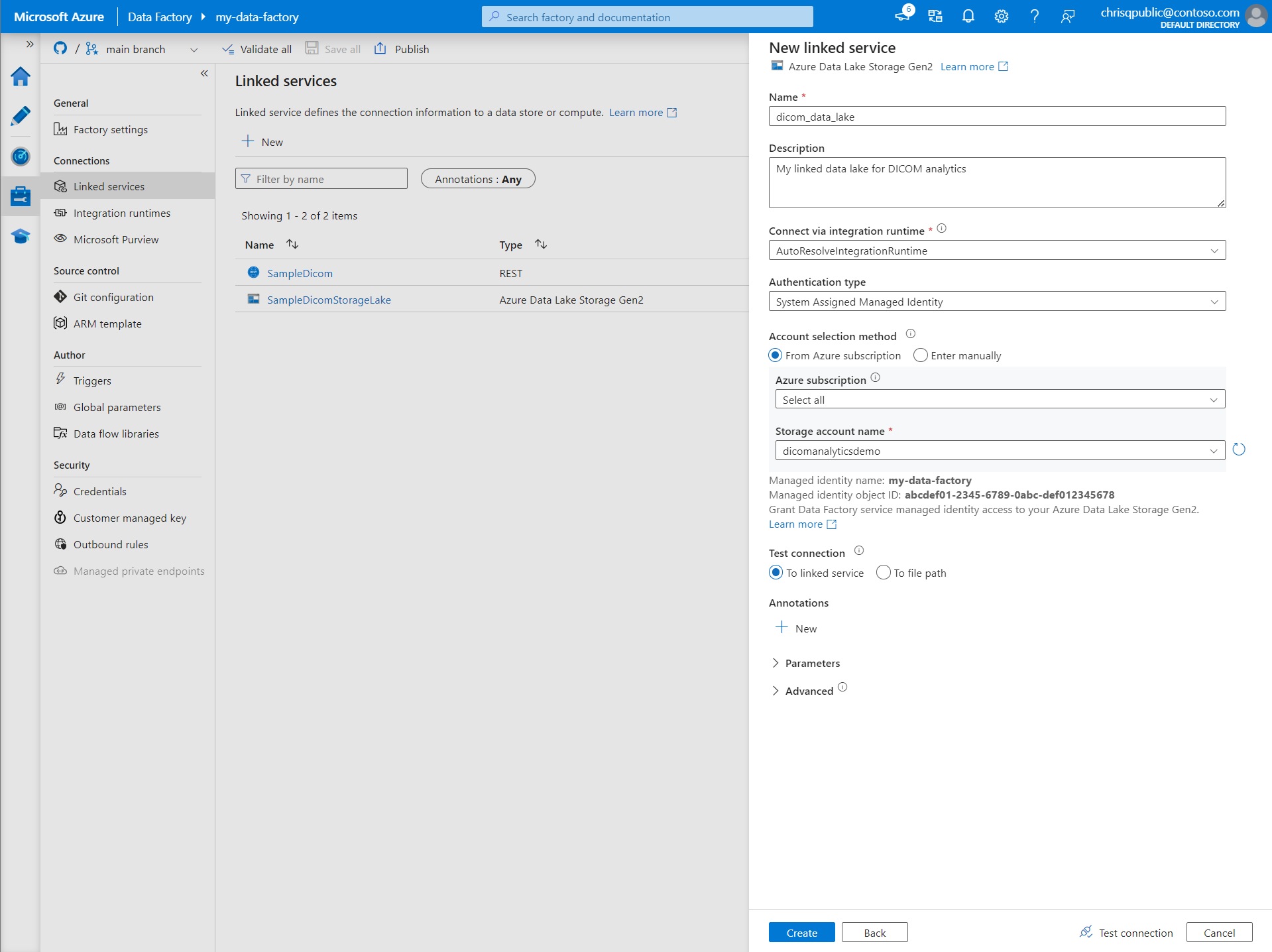

Membuat layanan tertaut untuk Azure Data Lake Storage Gen2

Di Data Factory Studio, pilih Kelola dari menu di sebelah kiri. Di bawah Koneksi, pilih Layanan tertaut lalu pilih Baru.

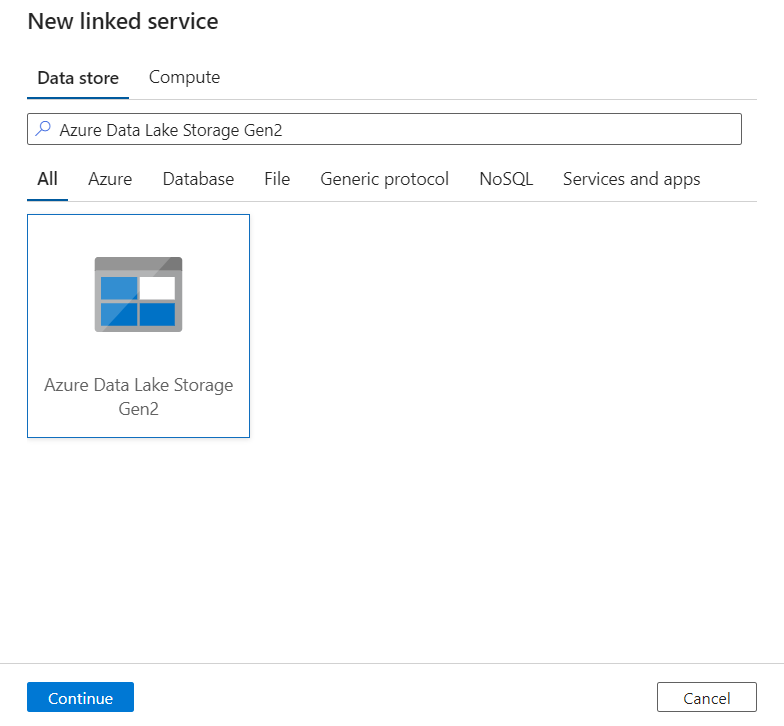

Pada panel Layanan tertaut baru, cari Azure Data Lake Storage Gen2. Pilih petak peta Azure Data Lake Storage Gen2 lalu pilih Lanjutkan.

Masukkan Nama dan Deskripsi untuk layanan tertaut.

Untuk Jenis autentikasi, pilih Identitas Terkelola yang Ditetapkan Sistem.

Masukkan detail akun penyimpanan dengan memasukkan URL ke akun penyimpanan secara manual. Anda juga dapat memilih langganan Azure dan akun penyimpanan dari menu dropdown.

Setelah Anda mengisi bidang yang diperlukan, pilih Uji koneksi untuk memastikan peran identitas dikonfigurasi dengan benar.

Saat pengujian koneksi berhasil, pilih Buat.

Membuat alur untuk data DICOM

Alur Data Factory adalah kumpulan aktivitas yang melakukan tugas, seperti menyalin metadata DICOM ke tabel Delta. Bagian ini merinci pembuatan alur yang secara teratur menyinkronkan data DICOM ke tabel Delta saat data ditambahkan ke, diperbarui, dan dihapus dari layanan DICOM.

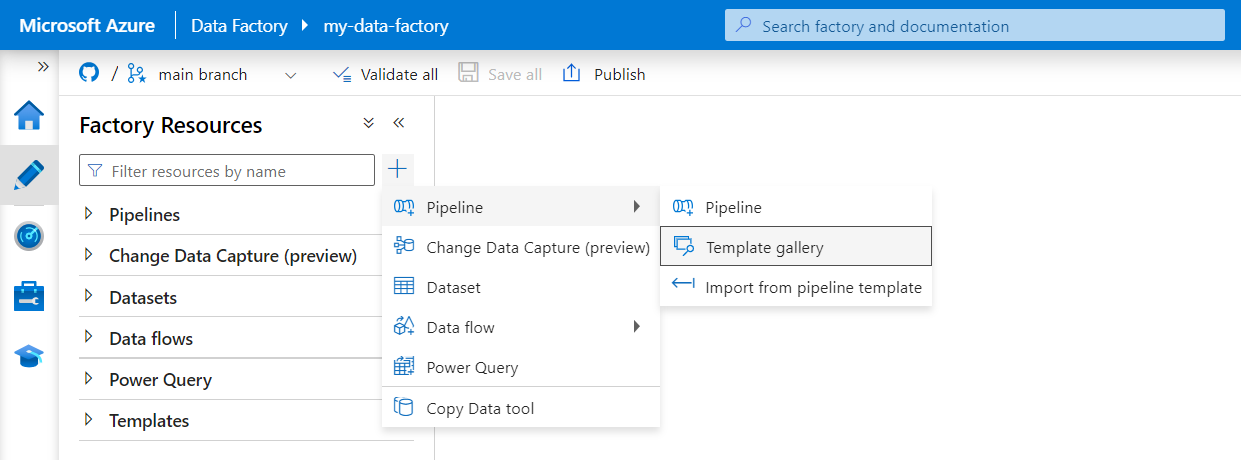

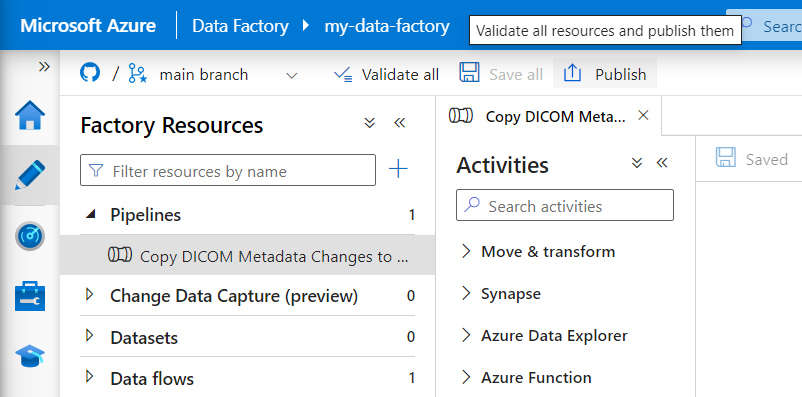

Pilih Penulis dari menu di sebelah kiri. Di panel Sumber Daya Pabrik, pilih tanda plus (+) untuk menambahkan sumber daya baru. Pilih Alur lalu pilih Galeri templat dari menu.

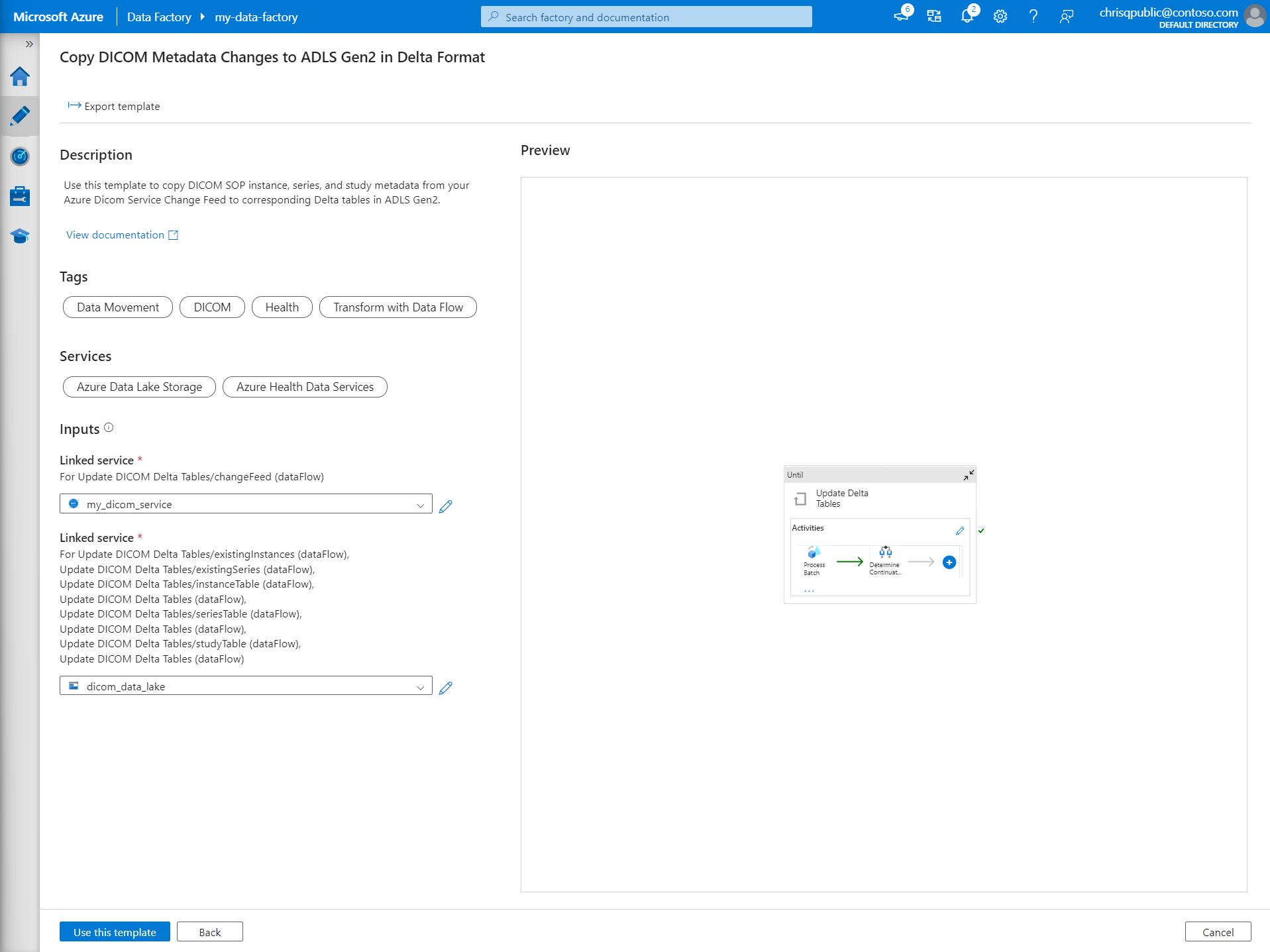

Di galeri Templat, cari DICOM. Pilih petak Salin Perubahan Metadata DICOM ke ADLS Gen2 dalam Format Delta lalu pilih Lanjutkan.

Di bagian Input , pilih layanan tertaut yang sebelumnya dibuat untuk layanan DICOM dan akun Data Lake Storage Gen2.

Pilih Gunakan templat ini untuk membuat alur baru.

Membuat alur untuk data DICOM

Jika Anda membuat layanan DICOM dengan Azure Data Lake Storage, alih-alih menggunakan templat dari galeri templat, Anda perlu menggunakan templat kustom untuk menyertakan parameter baru fileName dalam alur metadata. Untuk mengonfigurasi alur, ikuti langkah-langkah ini.

Unduh templat dari GitHub. File templat adalah folder terkompresi (zip). Anda tidak perlu mengekstrak file karena file sudah diunggah dalam bentuk terkompresi.

Di Azure Data Factory, pilih Penulis dari menu sebelah kiri. Pada panel Sumber Daya Pabrik, pilih tanda plus (+) untuk menambahkan sumber daya baru. Pilih Alur lalu pilih Impor dari templat alur.

Di jendela Buka , pilih templat yang Anda unduh. Pilih Buka.

Di bagian Input , pilih layanan tertaut yang dibuat untuk layanan DICOM dan akun Azure Data Lake Storage Gen2.

Pilih Gunakan templat ini untuk membuat alur baru.

Menjadwalkan alur

Alur dijadwalkan oleh pemicu. Ada berbagai jenis pemicu. Pemicu jadwal memungkinkan alur dipicu untuk berjalan pada waktu tertentu dalam sehari, seperti setiap jam, atau setiap hari pada tengah malam. Pemicu manual memicu alur sesuai permintaan, yang berarti alur berjalan kapan pun Anda inginkan.

Dalam contoh ini, pemicu jendela tumbling digunakan untuk menjalankan alur secara berkala mengingat titik awal dan interval waktu reguler. Untuk informasi selengkapnya tentang pemicu, lihat Eksekusi dan pemicu alur di Azure Data Factory atau Azure Synapse Analytics.

Membuat pemicu jendela tumbling baru

Pilih Penulis dari menu di sebelah kiri. Pilih alur untuk layanan DICOM dan pilih Tambahkan pemicu dan Baru/Edit dari bilah menu.

Pada panel Tambahkan pemicu , pilih menu dropdown Pilih pemicu lalu pilih Baru.

Masukkan Nama dan Deskripsi untuk pemicu.

Pilih jendela Tumbling sebagai Jenis.

Untuk mengonfigurasi alur yang berjalan per jam, atur Pengulangan ke 1 Jam.

Perluas bagian Tingkat Lanjut dan masukkan Penundaan 15 menit. Pengaturan ini memungkinkan operasi yang tertunda pada akhir jam selesai sebelum diproses.

Atur Konkurensi maksimum ke 1 untuk memastikan konsistensi di seluruh tabel.

Pilih OK untuk terus mengonfigurasi parameter eksekusi pemicu.

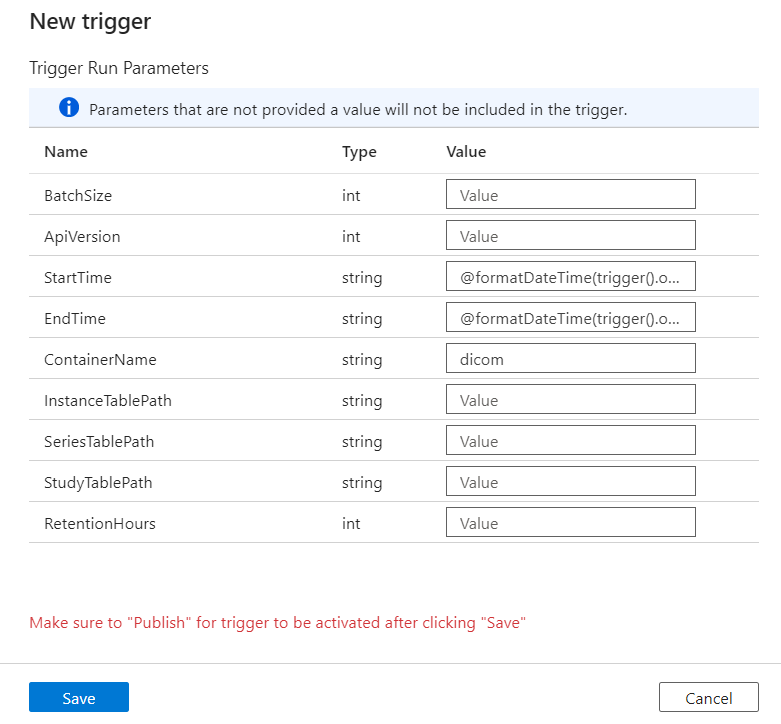

Mengonfigurasi parameter eksekusi pemicu

Pemicu menentukan kapan alur berjalan. Mereka juga menyertakan parameter yang diteruskan ke eksekusi alur. Templat Salin Perubahan Metadata DICOM ke Delta menentukan parameter yang dijelaskan dalam tabel berikut. Jika tidak ada nilai yang disediakan selama konfigurasi, nilai default yang tercantum digunakan untuk setiap parameter.

| Nama Parameter | Deskripsi | Nilai default |

|---|---|---|

| BatchSize | Jumlah maksimum perubahan yang diambil pada satu waktu dari umpan perubahan (maksimum 200) | 200 |

| ApiVersion | Versi API untuk layanan Azure DICOM (minimum 2) | 2 |

| StartTime | Waktu mulai inklusif untuk perubahan DICOM | 0001-01-01T00:00:00Z |

| EndTime | Waktu akhir eksklusif untuk perubahan DICOM | 9999-12-31T23:59:59Z |

| ContainerName | Nama kontainer untuk tabel Delta yang dihasilkan | dicom |

| InstanceTablePath | Jalur yang berisi tabel Delta untuk instans SOP DICOM dalam kontainer | instance |

| SeriesTablePath | Jalur yang berisi tabel Delta untuk seri DICOM dalam kontainer | series |

| StudyTablePath | Jalur yang berisi tabel Delta untuk studi DICOM dalam kontainer | study |

| RetentionHours | Retensi maksimum dalam jam untuk data dalam tabel Delta | 720 |

Pada panel Parameter Eksekusi Pemicu, masukkan nilai ContainerName yang cocok dengan nama kontainer penyimpanan yang dibuat dalam prasyarat.

Untuk StartTime, gunakan variabel

@formatDateTime(trigger().outputs.windowStartTime)sistem .Untuk EndTime, gunakan variabel

@formatDateTime(trigger().outputs.windowEndTime)sistem .Catatan

Hanya pemicu jendela tumbling yang mendukung variabel sistem:

@trigger().outputs.windowStartTimedan@trigger().outputs.windowEndTime.

Pemicu jadwal menggunakan variabel sistem yang berbeda:

@trigger().scheduledTimedan@trigger().startTime.

Pelajari selengkapnya tentang jenis pemicu.

Pilih Simpan untuk membuat pemicu baru. Pilih Terbitkan untuk memulai pemicu Anda yang berjalan pada jadwal yang ditentukan.

Setelah pemicu diterbitkan, pemicu dapat dipicu secara manual dengan menggunakan opsi Picu sekarang . Jika waktu mulai ditetapkan untuk nilai di masa lalu, alur akan segera dimulai.

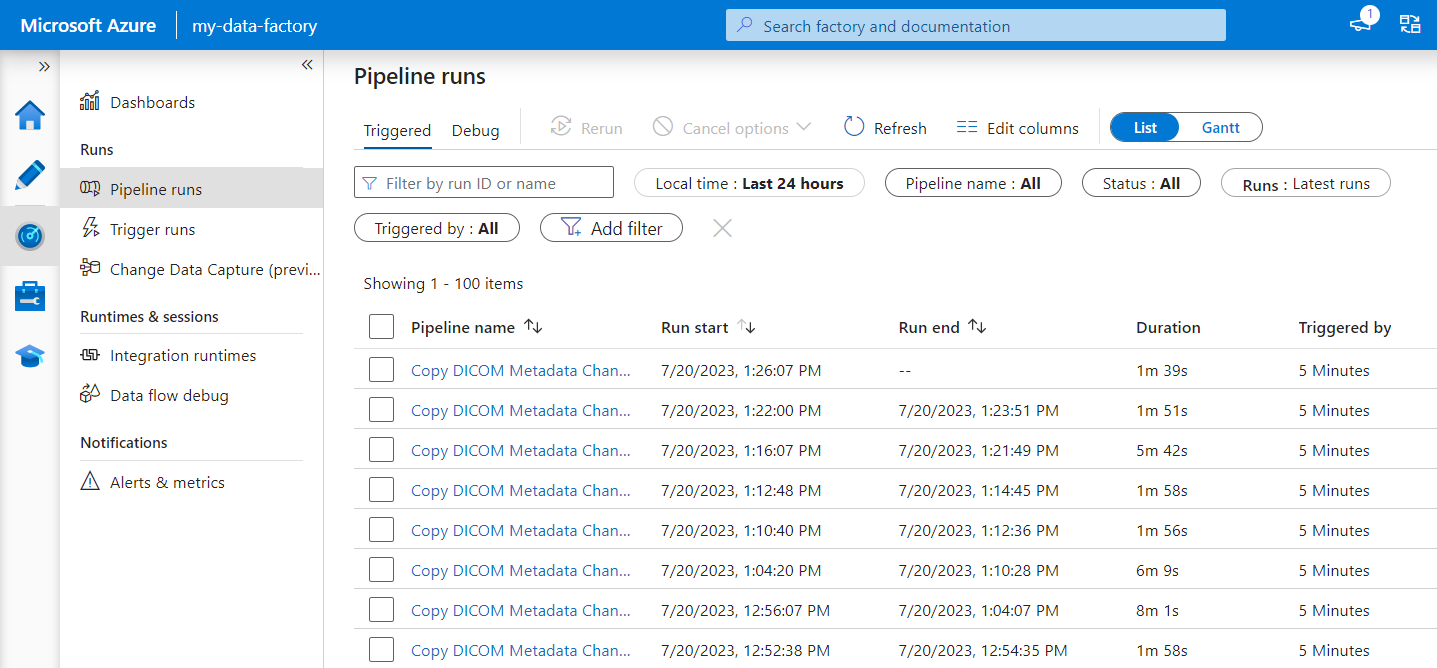

Memantau eksekusi alur

Anda dapat memantau eksekusi yang dipicu dan eksekusi alur terkait pada tab Monitor . Di sini, Anda dapat menelusuri kapan setiap alur berjalan dan berapa lama waktu yang dibutuhkan untuk berjalan. Anda juga dapat berpotensi men-debug masalah apa pun yang muncul.

Microsoft Fabric

Fabric adalah solusi analitik all-in-one yang berada di atas Microsoft OneLake. Dengan penggunaan Fabric lakehouse, Anda dapat mengelola, menyusun, dan menganalisis data di OneLake dalam satu lokasi. Setiap data di luar OneLake, yang ditulis ke Data Lake Storage Gen2, dapat dihubungkan ke OneLake menggunakan pintasan untuk memanfaatkan rangkaian alat Fabric.

Membuat pintasan ke tabel metadata

Pergi ke lakehouse yang dibuat dalam prasyarat. Di tampilan Explorer, pilih menu elipsis (...) di samping folder Tabel.

Pilih Pintasan baru untuk membuat pintasan baru ke akun penyimpanan yang berisi data analitik DICOM.

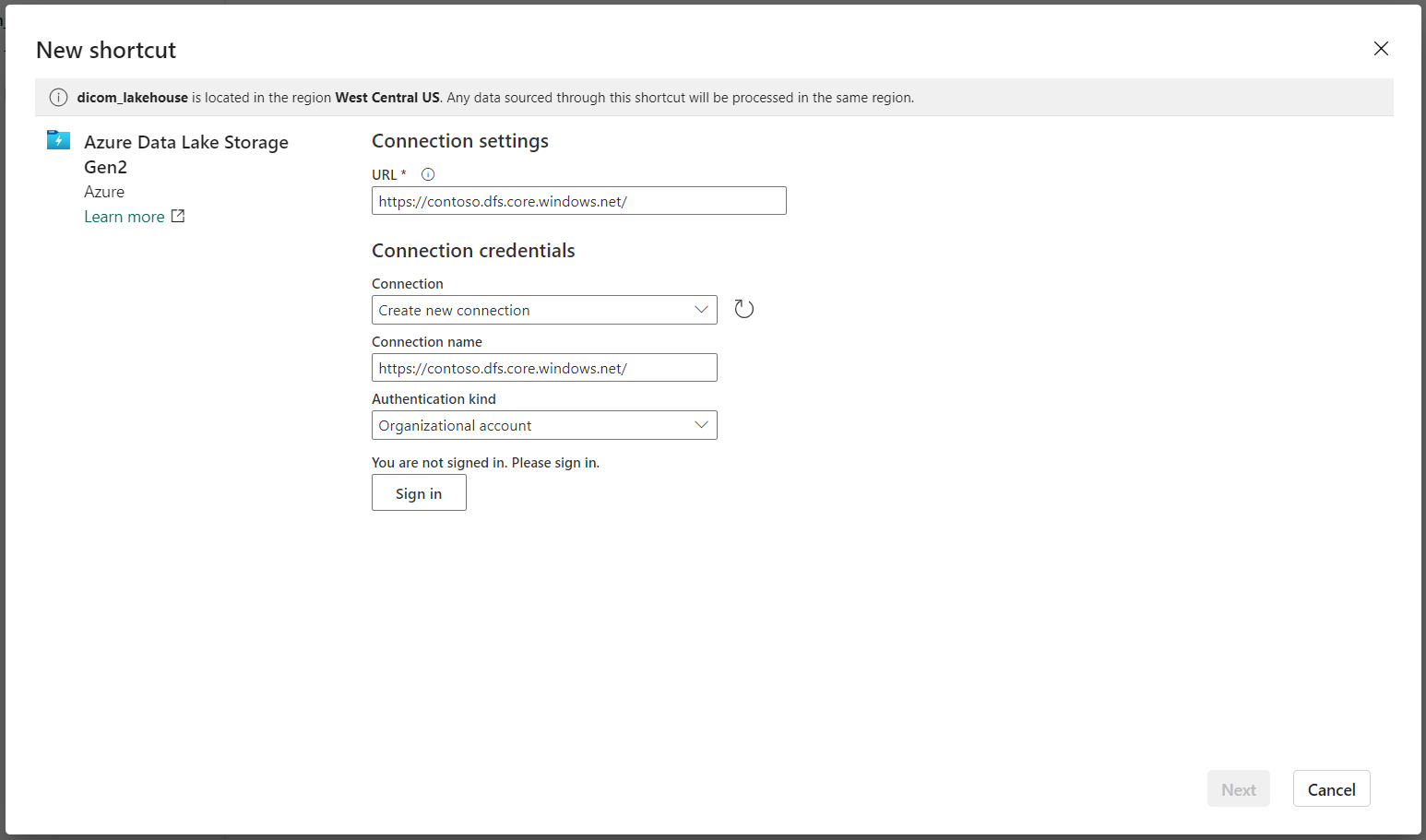

Pilih Azure Data Lake Storage Gen2 sebagai sumber untuk pintasan.

Di bawah Pengaturan koneksi, masukkan URL yang Anda gunakan di bagian Layanan tertaut.

Pilih koneksi yang sudah ada atau buat koneksi baru dengan memilih jenis Autentikasi yang ingin Anda gunakan.

Catatan

Ada beberapa opsi untuk mengautentikasi antara Data Lake Storage Gen2 dan Fabric. Anda dapat menggunakan akun organisasi atau perwakilan layanan. Kami tidak merekomendasikan penggunaan kunci akun atau token tanda tangan akses bersama.

Pilih Selanjutnya.

Masukkan Nama Pintasan yang mewakili data yang dibuat oleh alur Data Factory. Misalnya, untuk

instancetabel Delta, nama pintasan mungkin harus berupa instans.Masukkan Sub Path yang cocok dengan

ContainerNameparameter dari konfigurasi parameter eksekusi dan nama tabel untuk pintasan. Misalnya, gunakan/dicom/instanceuntuk tabel Delta dengan jalurinstancedalamdicomkontainer.Pilih Buat untuk membuat pintasan.

Ulangi langkah 2 hingga 9 untuk menambahkan pintasan yang tersisa ke tabel Delta lainnya di akun penyimpanan (misalnya,

seriesdanstudy).

Setelah Anda membuat pintasan, perluas tabel untuk memperlihatkan nama dan jenis kolom.

Membuat pintasan ke file

Jika Anda menggunakan layanan DICOM dengan Data Lake Storage, Anda juga dapat membuat pintasan ke data file DICOM yang disimpan di data lake.

Pergi ke lakehouse yang dibuat dalam prasyarat. Di tampilan Explorer, pilih menu elipsis (...) di samping folder File.

Pilih Pintasan baru untuk membuat pintasan baru ke akun penyimpanan yang berisi data DICOM.

Pilih Azure Data Lake Storage Gen2 sebagai sumber untuk pintasan.

Di bawah Pengaturan koneksi, masukkan URL yang Anda gunakan di bagian Layanan tertaut.

Pilih koneksi yang sudah ada atau buat koneksi baru dengan memilih jenis Autentikasi yang ingin Anda gunakan.

Pilih Selanjutnya.

Masukkan Nama Pintasan yang menjelaskan data DICOM. Misalnya, contoso-dicom-files.

Masukkan Sub Path yang cocok dengan nama kontainer penyimpanan dan folder yang digunakan oleh layanan DICOM. Misalnya, jika Anda ingin menautkan ke folder akar, Sub Path adalah /dicom/AHDS. Folder akar selalu

AHDS, tetapi Anda dapat secara opsional menautkan ke folder anak untuk ruang kerja tertentu atau instans layanan DICOM.Pilih Buat untuk membuat pintasan.

Menjalankan notebook

Setelah tabel dibuat di lakehouse, Anda dapat mengkuerinya dari notebook Fabric. Anda dapat membuat buku catatan langsung dari lakehouse dengan memilih Buka Notebook dari bilah menu.

Pada halaman buku catatan, konten lakehouse dapat dilihat di sisi kiri, termasuk tabel yang baru ditambahkan. Di bagian atas halaman, pilih bahasa untuk buku catatan. Bahasa ini juga dapat dikonfigurasi untuk masing-masing sel. Contoh berikut menggunakan Spark SQL.

Mengkueri tabel dengan menggunakan Spark SQL

Di editor sel, masukkan kueri Spark SQL seperti SELECT pernyataan.

SELECT * from instance

Kueri ini memilih semua konten dari instance tabel. Saat Anda siap, pilih Jalankan sel untuk menjalankan kueri.

Setelah beberapa detik, hasil kueri muncul dalam tabel di bawah sel seperti contoh berikut yang diperlihatkan. Waktu mungkin lebih lama jika kueri Spark ini adalah yang pertama dalam sesi karena konteks Spark perlu diinisialisasi.

Mengakses data file DICOM di buku catatan

Jika Anda menggunakan templat untuk membuat alur dan membuat pintasan ke data file DICOM, Anda dapat menggunakan filePath kolom dalam instance tabel untuk menghubungkan metadata instans ke data file.

SELECT sopInstanceUid, filePath from instance

Ringkasan

Di artikel ini, Anda telah mempelajari cara:

- Gunakan templat Data Factory untuk membuat alur dari layanan DICOM ke akun Data Lake Storage Gen2.

- Konfigurasikan pemicu untuk mengekstrak metadata DICOM pada jadwal per jam.

- Gunakan pintasan untuk menyambungkan data DICOM di akun penyimpanan ke Fabric lakehouse.

- Gunakan buku catatan untuk mengkueri data DICOM di lakehouse.

Langkah berikutnya

Catatan

DICOM® adalah merek dagang terdaftar dari Asosiasi Produsen Listrik Nasional untuk publikasi Standar yang berkaitan dengan komunikasi digital informasi medis.