Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

Dalam tutorial ini, Anda mengisi Dasbor Real-Time untuk menangkap wawasan dari data AGEN OPC yang Anda kirim ke Azure Event Hubs di tutorial sebelumnya. Dengan menggunakan Microsoft Fabric Real-Time Intelligence, Anda membawa data Anda dari Event Hubs ke Microsoft Fabric, dan memetakannya ke dalam database KQL yang dapat menjadi sumber untuk Dasbor Real-Time. Kemudian, Anda membuat dasbor untuk menampilkan data tersebut dalam petak peta visual yang menangkap wawasan dan menampilkan nilai dari waktu ke waktu.

Operasi ini adalah langkah terakhir dalam sampel pengalaman tutorial end-to-end, yang berasal dari penyebaran Operasi Azure IoT di tepi melalui mendapatkan wawasan dari data perangkat tersebut di cloud.

Prasyarat

Sebelum memulai tutorial ini, Anda harus menyelesaikan Tutorial: Mengirim pesan dari aset ke cloud menggunakan aliran data

Anda juga memerlukan langganan Microsoft Fabric. Di langganan, Anda memerlukan akses ke ruang kerja dengan izin Kontributor atau di atasnya.

Selain itu, penyewa Fabric Anda harus mengizinkan pembuatan Dasbor Real-Time. Ini adalah pengaturan yang dapat diaktifkan oleh administrator penyewa Anda. Untuk informasi selengkapnya, lihat Mengaktifkan pengaturan penyewa di portal admin.

Masalah apa yang akan kita pecahkan?

Setelah data OPC UA Anda tiba di cloud, Anda akan memiliki banyak informasi yang tersedia untuk dianalisis. Anda mungkin ingin mengatur data tersebut dan membuat laporan yang berisi grafik dan visualisasi untuk mendapatkan wawasan dari data. Langkah-langkah dalam tutorial ini menggambarkan bagaimana Anda dapat menghubungkan data tersebut ke Real-Time Intelligence dan membangun Dasbor Real-Time.

Menyerap data ke dalam Kecerdasan Real-Time

Di bagian ini, Anda menyiapkan eventstream Microsoft Fabric untuk menghubungkan hub peristiwa Anda ke database KQL di Real-Time Intelligence. Proses ini termasuk menyiapkan pemetaan data untuk mengubah data payload dari format JSON-nya menjadi kolom di KQL.

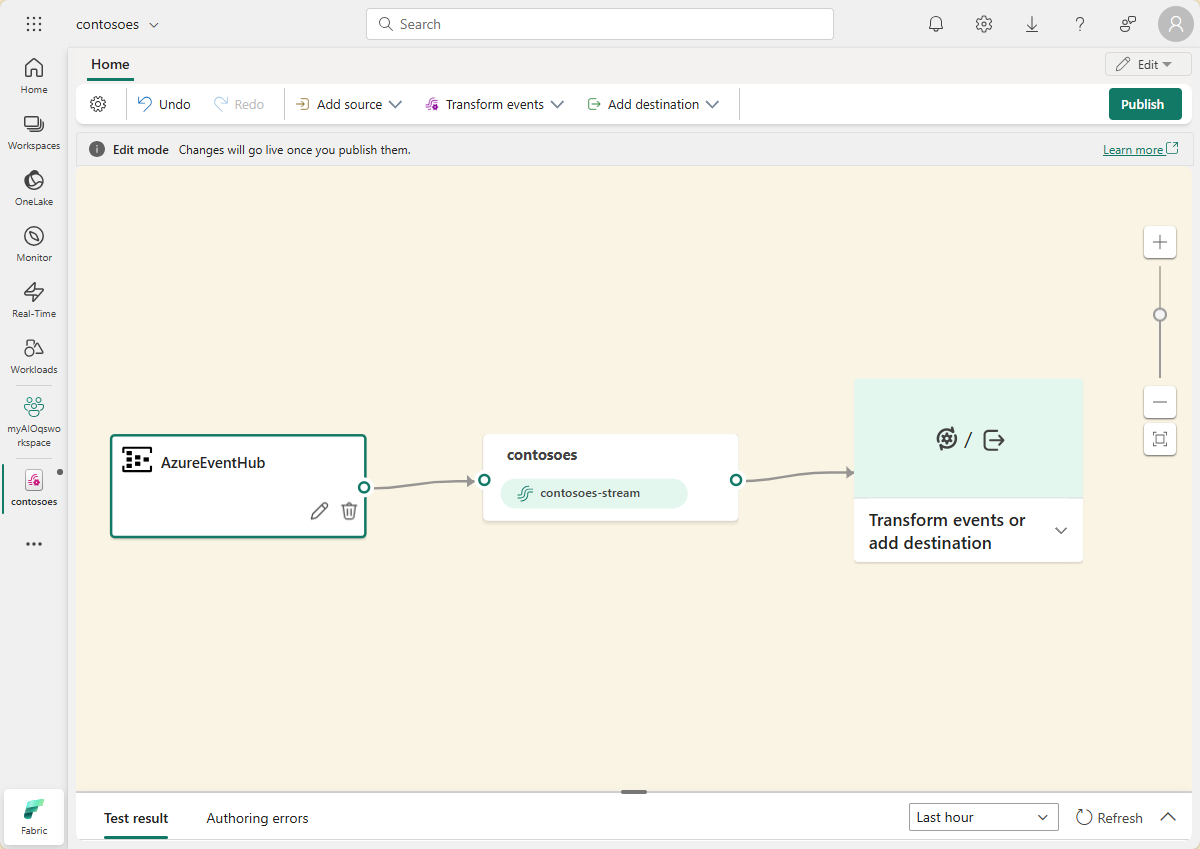

Membuat eventstream

Di bagian ini, Anda membuat eventstream yang akan digunakan untuk membawa data Anda dari Event Hubs ke Microsoft Fabric Real-Time Intelligence, dan akhirnya ke dalam database KQL.

Mulailah dengan menavigasi ke pengalaman Real-Time Intelligence di Microsoft Fabric dan membuka ruang kerja Fabric Anda.

Ikuti langkah-langkah dalam Membuat eventstream di Microsoft Fabric untuk membuat sumber daya eventstream baru di ruang kerja Anda.

Setelah eventstream dibuat, Anda akan melihat editor utama tempat Anda dapat mulai membangun eventstream.

Menambahkan pusat aktivitas sebagai sumber

Selanjutnya, tambahkan pusat aktivitas Anda dari tutorial sebelumnya sebagai sumber data untuk eventstream.

Ikuti langkah-langkah di Menambahkan sumber Azure Event Hubs ke eventstream untuk menambahkan sumber peristiwa. Ingatlah catatan berikut:

- Anda akan membuat koneksi cloud baru dengan autentikasi Kunci Akses Bersama.

- Pastikan autentikasi lokal diaktifkan di pusat aktivitas Anda. Anda dapat mengatur ini dari halaman Gambaran Umum di portal Azure.

- Untuk Grup konsumen, gunakan pilihan default ($Default).

- Untuk Format data, pilih Json (mungkin sudah dipilih secara default).

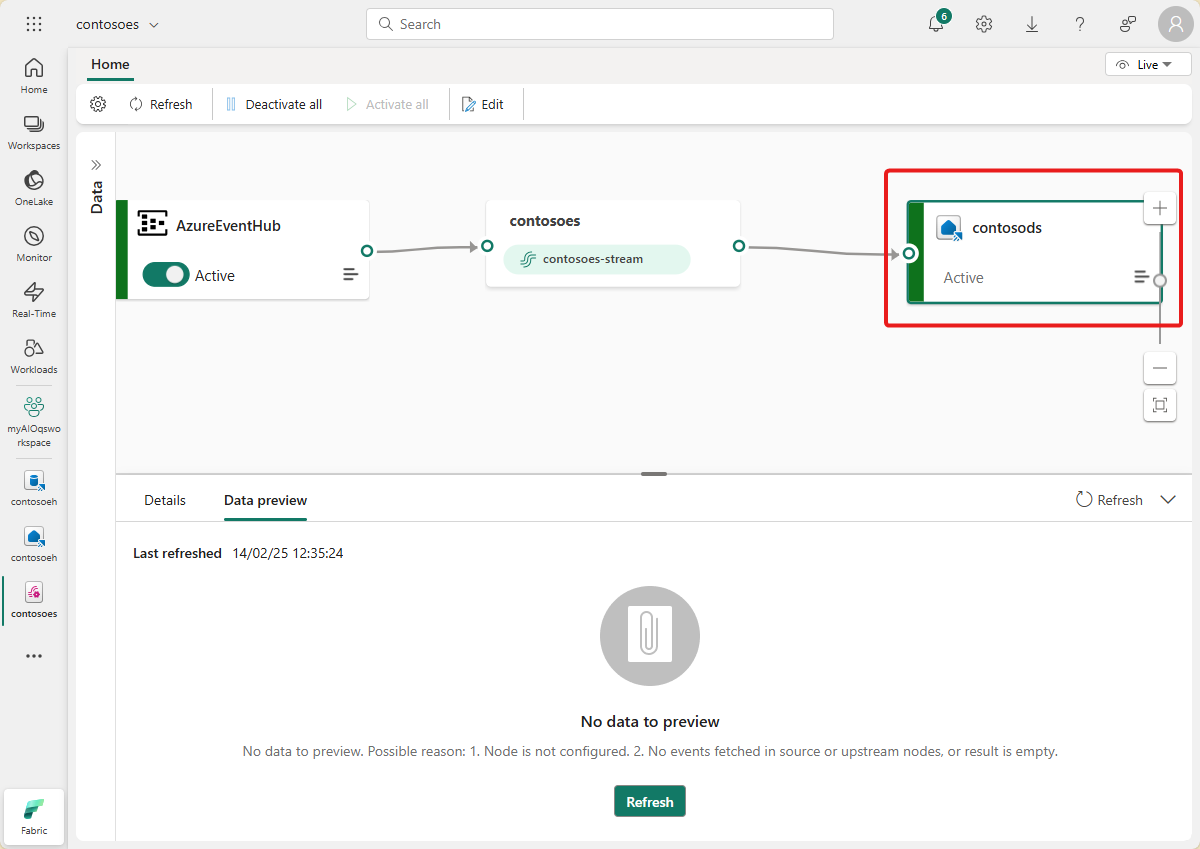

Setelah menyelesaikan alur ini, hub peristiwa Azure terlihat di tampilan langsung eventstream sebagai sumber.

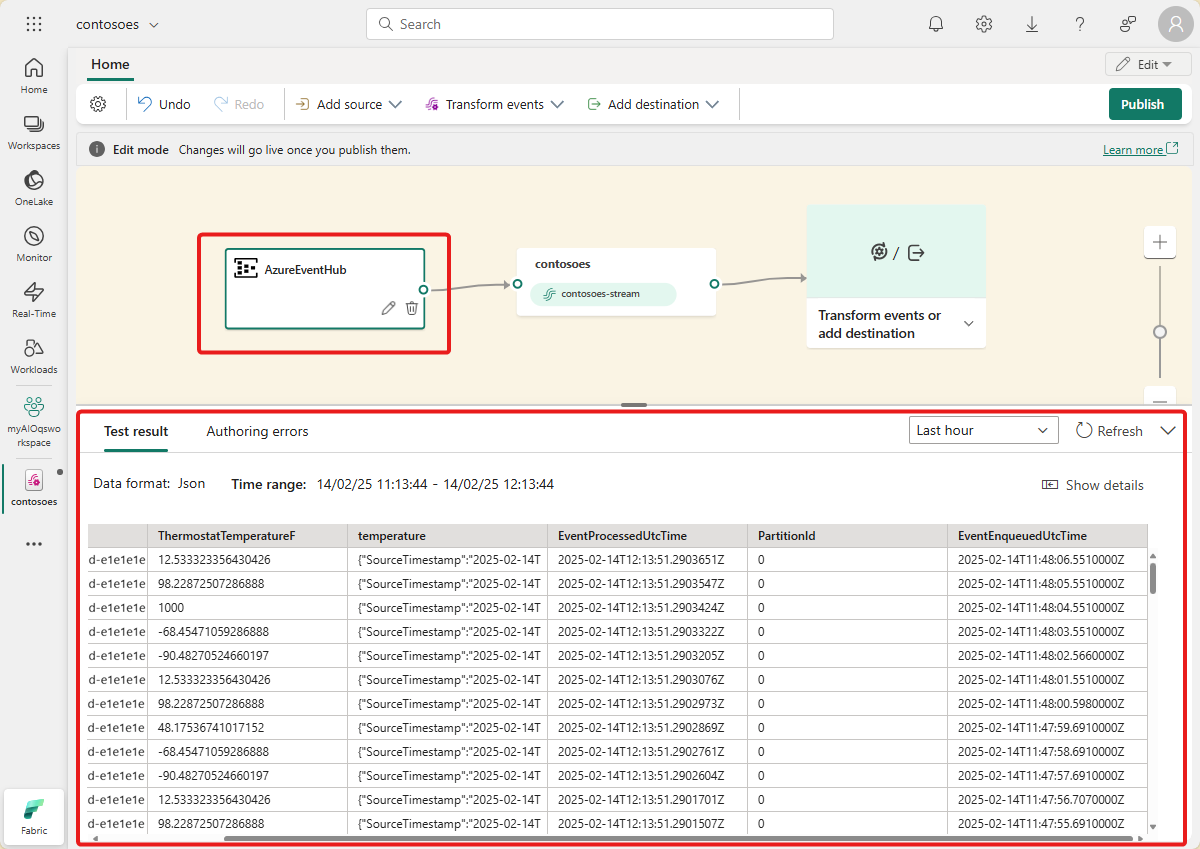

Memverifikasi aliran data

Ikuti langkah-langkah ini untuk memeriksa pekerjaan Anda sejauh ini, dan pastikan data mengalir ke eventstream.

Mulai kluster tempat Anda menyebarkan Operasi Azure IoT dalam tutorial sebelumnya. Simulator OPC PLC yang Anda sebarkan dengan instans Azure IoT Operations Anda harus mulai menjalankan dan mengirim data ke broker MQTT. Anda dapat memverifikasi bagian alur ini menggunakan mqttui seperti yang dijelaskan dalam Memverifikasi bahwa data mengalir.

Tunggu beberapa menit hingga data disebarluaskan. Kemudian, dalam tampilan langsung eventstream, pilih sumber AzureEventHub dan refresh Pratinjau data. Anda akan melihat data JSON dari simulator mulai muncul dalam tabel.

Petunjuk / Saran

Jika data belum tiba di eventstream, Anda mungkin ingin memeriksa aktivitas hub peristiwa untuk memverifikasi bahwa data tersebut menerima pesan. Ini akan membantu Anda mengisolasi bagian alur mana yang akan di-debug.

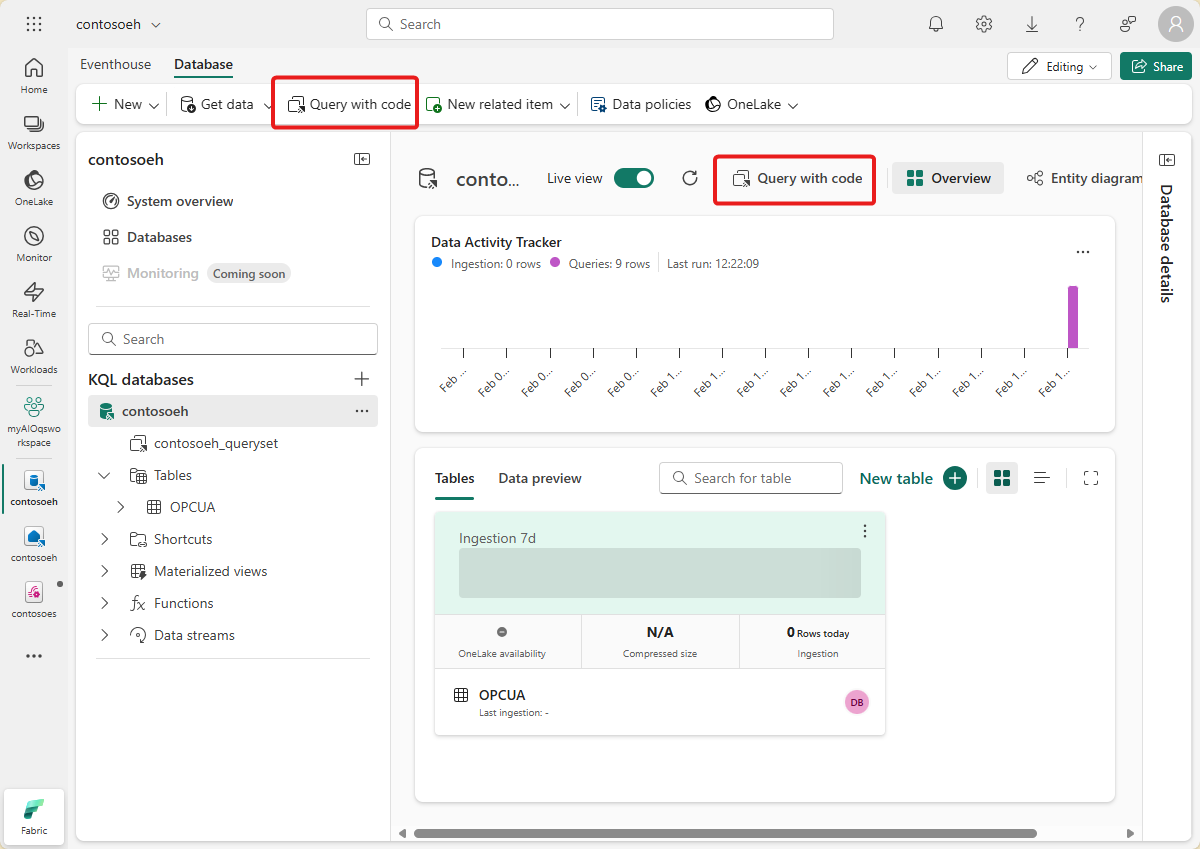

Menyiapkan sumber daya KQL

Di bagian ini, Anda membuat database KQL di ruang kerja Microsoft Fabric untuk digunakan sebagai tujuan data Anda.

Ikuti langkah-langkah dalam Membuat Eventhouse untuk membuat Eventhouse Inteligensi Real Time dengan database KQL anak. Anda hanya perlu menyelesaikan bagian berjudul Buat Eventhouse.

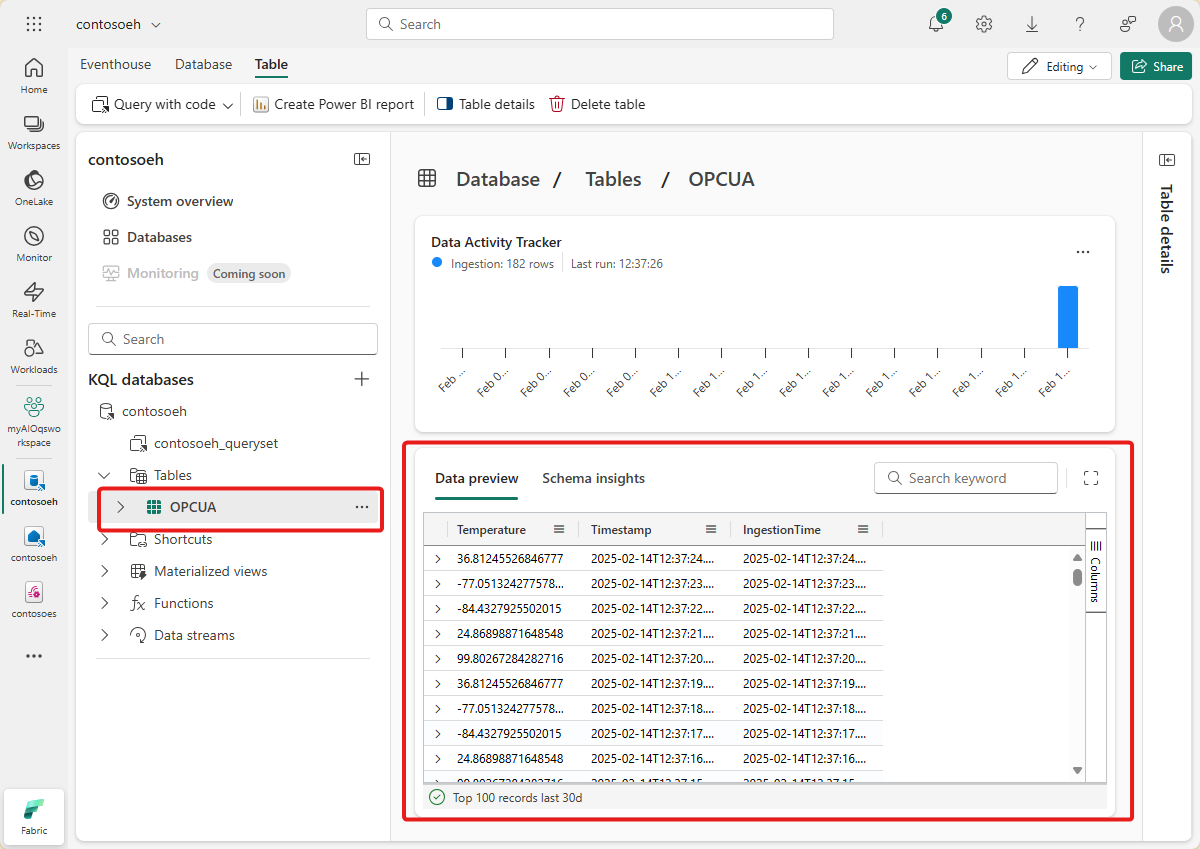

Selanjutnya, buat tabel di database Anda. Sebut saja OPCUA dan gunakan kolom berikut.

Nama kolom Jenis Data AssetId benang Suhu desimal Tanda Waktu Tanggal dan waktu Setelah tabel OPCUA dibuat, pilih database Anda dan gunakan tombol Kueri dengan kode untuk membuka jendela kueri.

Hapus kode yang sudah ada dan jalankan kueri KQL berikut untuk membuat pemetaan data untuk tabel Anda. Pemetaan data akan disebut opcua_mapping.

.create table ['OPCUA'] ingestion json mapping 'opcua_mapping' '[{"column":"AssetId", "Properties":{"Path":"$[\'AssetId\']"}},{"column":"Temperature", "Properties":{"Path":"$[\'ThermostatTemperatureF\']"}},{"column":"Timestamp", "Properties":{"Path":"$[\'EventProcessedUtcTime\']"}}]'

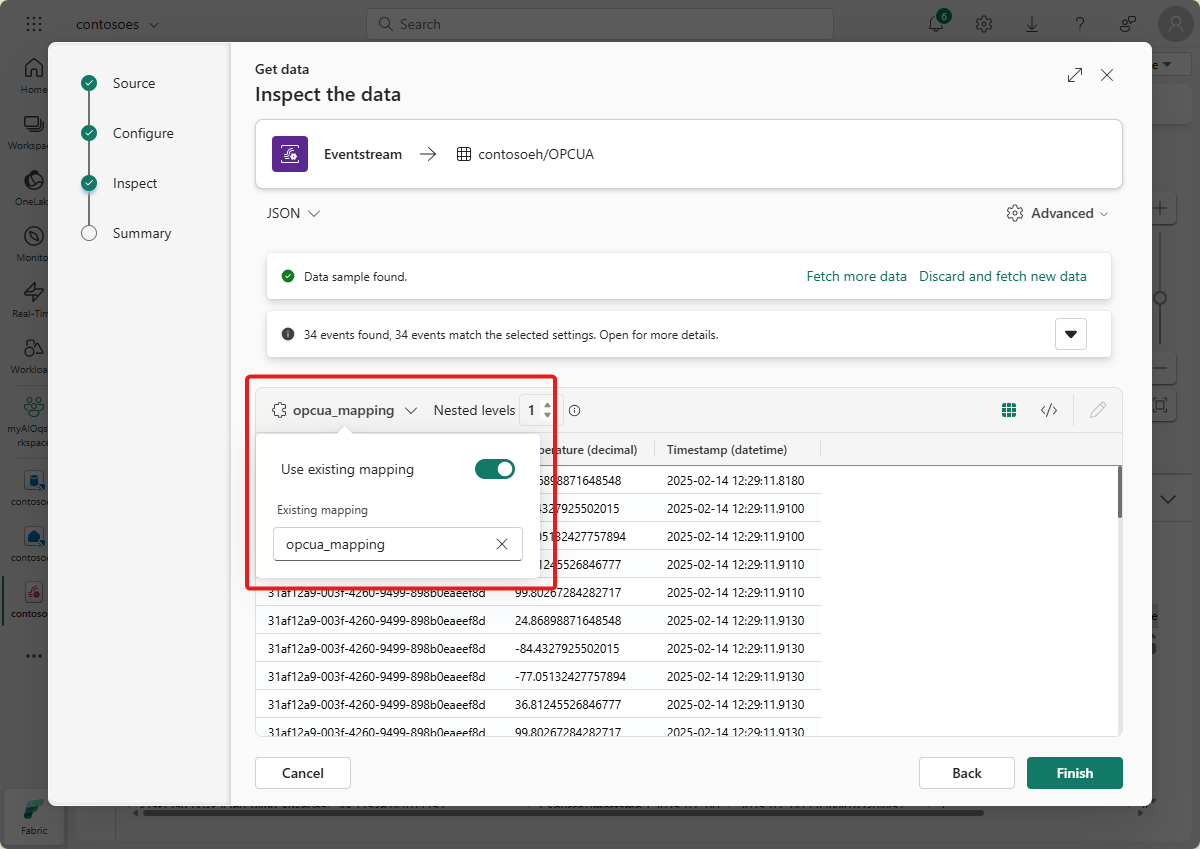

Menambahkan tabel data sebagai tujuan

Selanjutnya, kembali ke tampilan eventstream, tempat Anda dapat menambahkan tabel KQL baru sebagai tujuan eventstream.

Ikuti langkah-langkah dalam Menambahkan tujuan KQL Database ke eventstream untuk menambahkan tujuan. Ingatlah catatan berikut:

Gunakan mode penyerapan langsung.

Pada langkah Konfigurasi, pilih tabel OPCUA yang Anda buat sebelumnya.

Pada langkah Inspeksi, pilih opcua_mapping, pilih Pemetaan yang sudah ada, dan pilih opcua_mapping.

Petunjuk / Saran

Jika tidak ada pemetaan yang ditemukan, coba refresh editor eventstream dan mulai ulang langkah-langkah untuk menambahkan tujuan. Atau, Anda dapat memulai proses konfigurasi yang sama ini dari tabel KQL alih-alih dari eventstream, seperti yang dijelaskan dalam Mendapatkan data dari Eventstream.

Setelah menyelesaikan alur ini, tabel KQL terlihat di tampilan langsung eventstream sebagai tujuan.

Tunggu beberapa menit hingga data disebarluaskan dan status tujuan berubah menjadi Aktif

Jika mau, Anda juga bisa menampilkan dan mengkueri data ini di database KQL Anda secara langsung.

Membuat Dasbor Real-Time

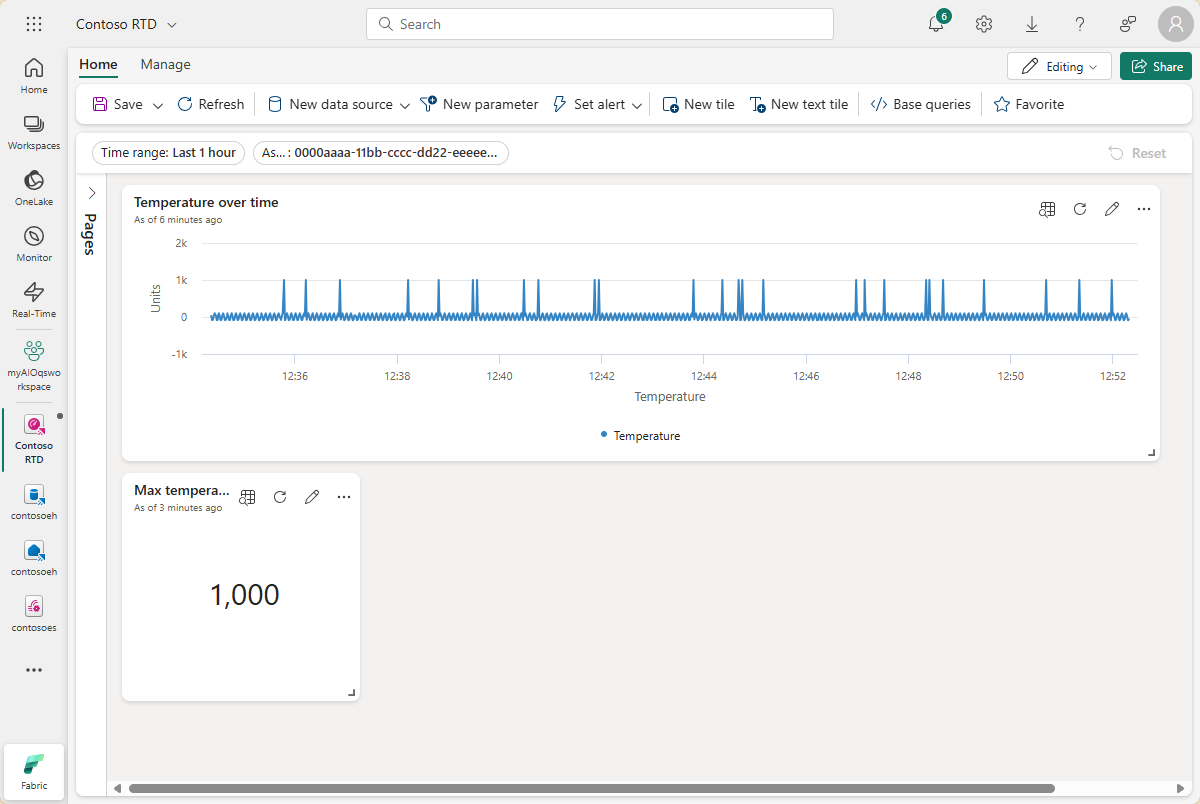

Di bagian ini, Anda akan membuat Dasbor Real-Time baru untuk memvisualisasikan data tutorial Anda. Dasbor akan memungkinkan pemfilteran berdasarkan ID aset dan tanda waktu, dan akan menampilkan ringkasan visual data suhu dan kelembaban.

Catatan

Anda hanya dapat membuat Dasbor Real-Time jika admin penyewa Anda telah mengaktifkan pembuatan Dasbor Real-Time di penyewa Fabric Anda. Untuk informasi selengkapnya, lihat Mengaktifkan pengaturan penyewa di portal admin.

Membuat dasbor dan menyambungkan sumber data

Ikuti langkah-langkah di bagian Buat dasbor baru untuk membuat Dasbor Real-Time baru dari kemampuan Real-Time Intelligence.

Kemudian, ikuti langkah-langkah di bagian Tambahkan sumber data untuk menambahkan database Anda sebagai sumber data. Ingatlah hal-hal berikut:

- Di panel Sumber data , database Anda akan berada di bawah Eventhouse/KQL Database.

Konfigurasikan parameter

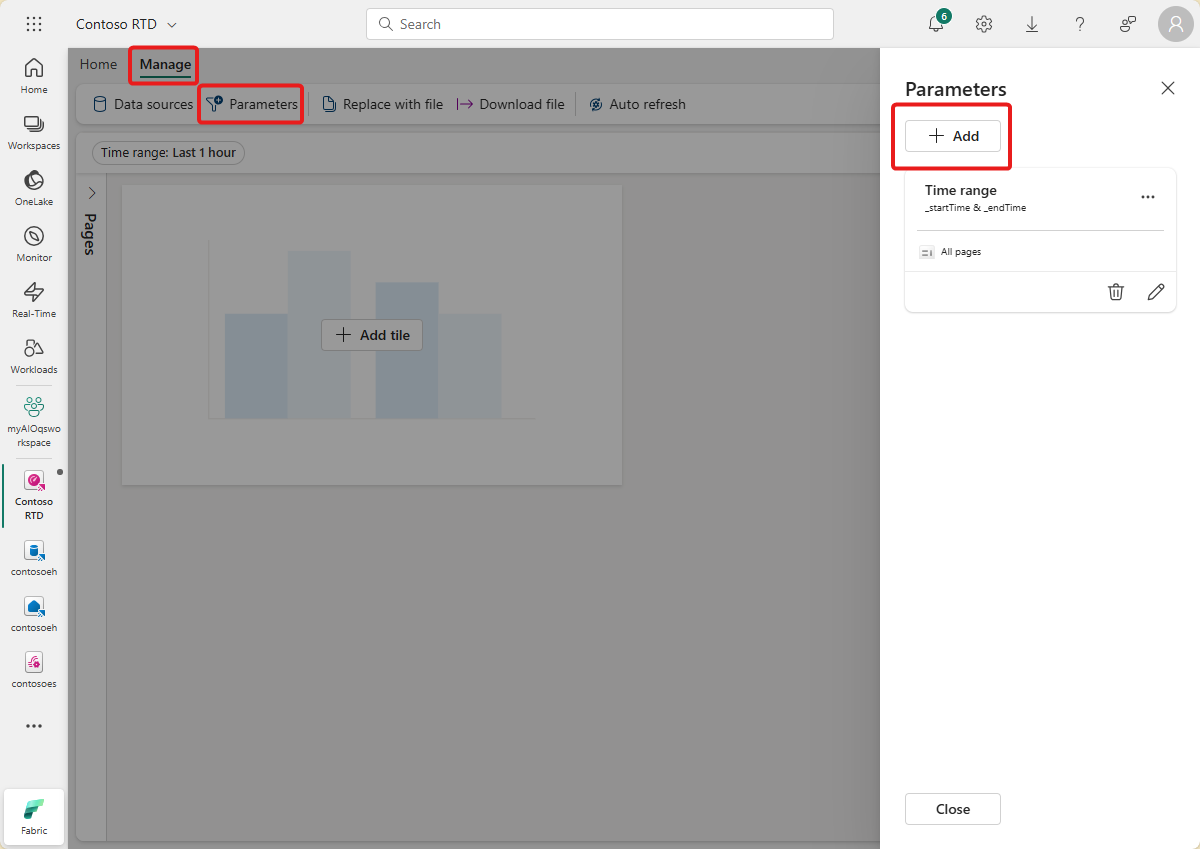

Selanjutnya, konfigurasikan beberapa parameter untuk dasbor Anda sehingga visual dapat difilter berdasarkan ID aset dan tanda waktu. Dasbor dilengkapi dengan parameter default untuk memfilter menurut rentang waktu, sehingga Anda hanya perlu membuat yang dapat memfilter menurut ID aset.

Beralih ke tab Kelola , dan pilih Parameter. Pilih + Tambahkan untuk menambahkan parameter baru.

Buat parameter baru dengan karakteristik berikut:

- Label: Aset

- Jenis parameter: Pilihan tunggal (sudah dipilih secara default)

- Nama variabel: _asset

- Jenis data: string (sudah dipilih secara default)

-

Sumber: Kueri

Sumber data: Database Anda (sudah dipilih secara default)

Pilih Edit kueri dan tambahkan kueri KQL berikut.

OPCUA | summarize by AssetId

- Kolom nilai: AssetId

- Nilai default: Pilih nilai kueri pertama

Pilih Selesai untuk menyimpan parameter Anda.

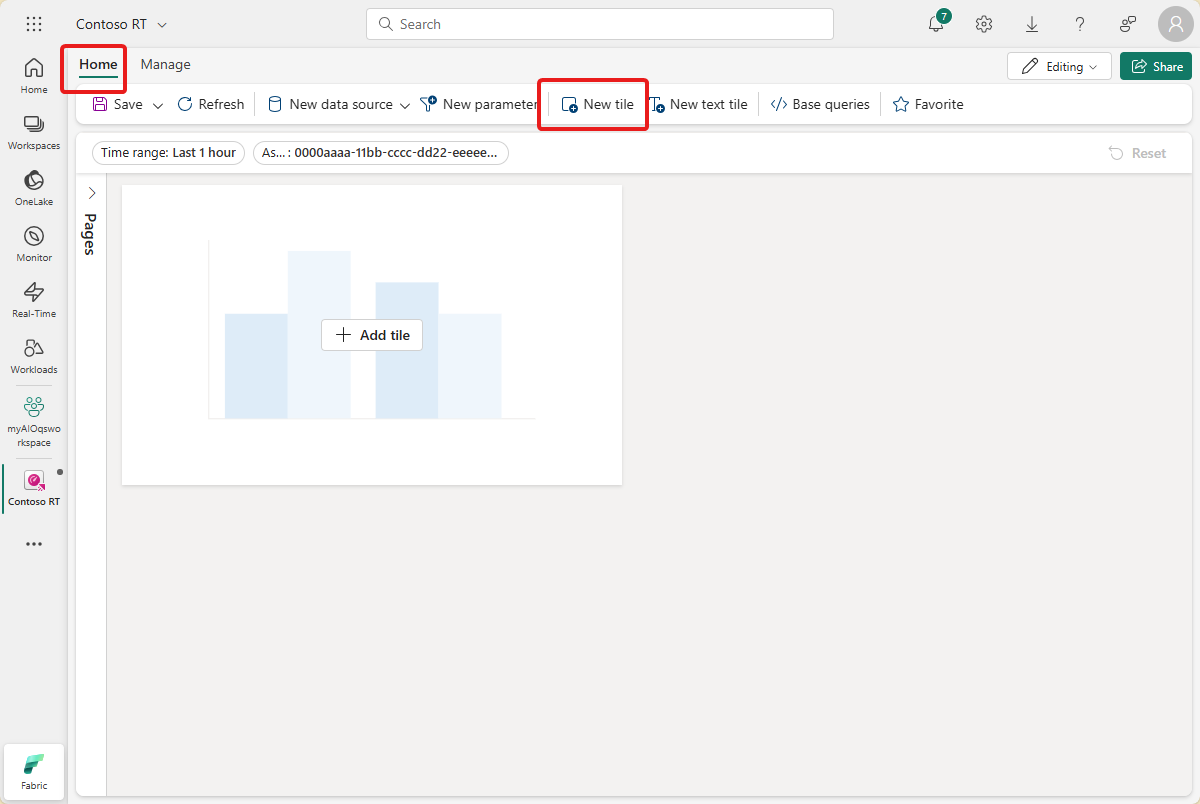

Membuat petak peta bagan garis

Selanjutnya, tambahkan petak ke dasbor Anda untuk menampilkan bagan garis suhu dan kelembaban dari waktu ke waktu untuk aset dan rentang waktu yang dipilih.

Pilih + Tambahkan petak peta atau Petak peta baru untuk menambahkan petak peta baru.

Masukkan kueri KQL berikut untuk petak peta. Kueri ini menerapkan parameter filter dari pemilih dasbor untuk rentang waktu dan aset, dan menarik rekaman yang dihasilkan dengan tanda waktu, suhu, dan kelembabannya.

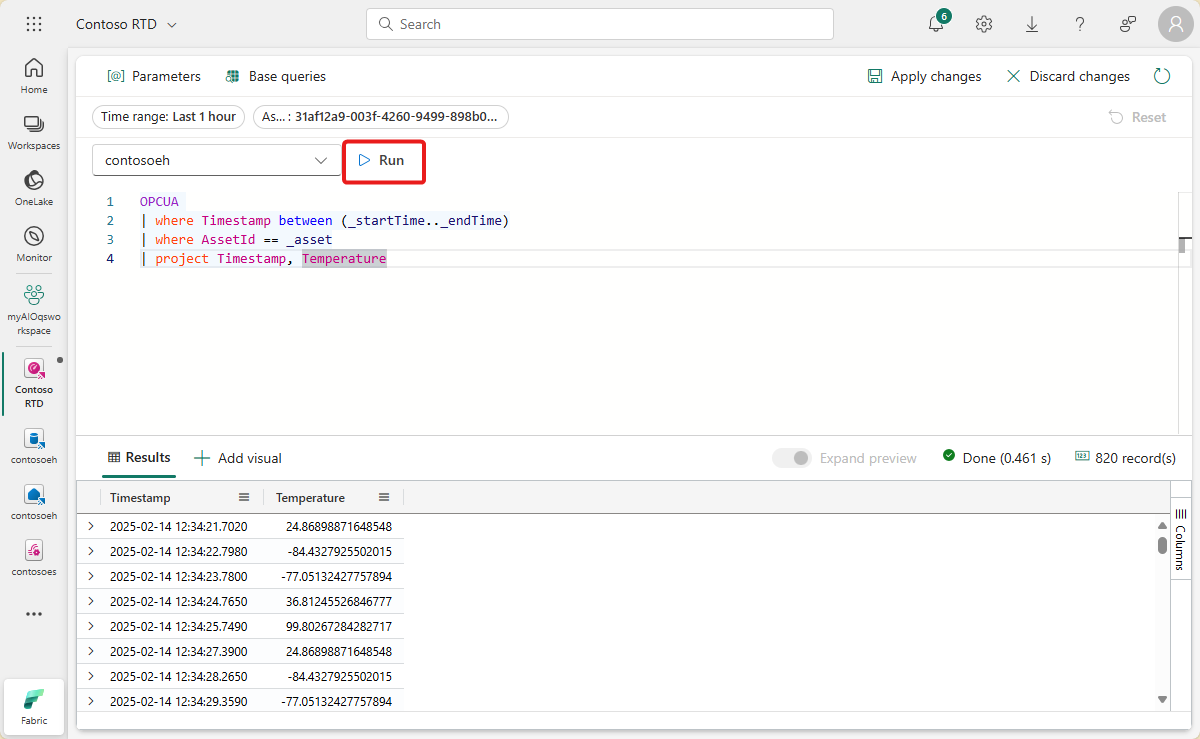

OPCUA | where Timestamp between (_startTime.._endTime) | where AssetId == _asset | project Timestamp, TemperatureJalankan kueri untuk memverifikasi bahwa data dapat ditemukan.

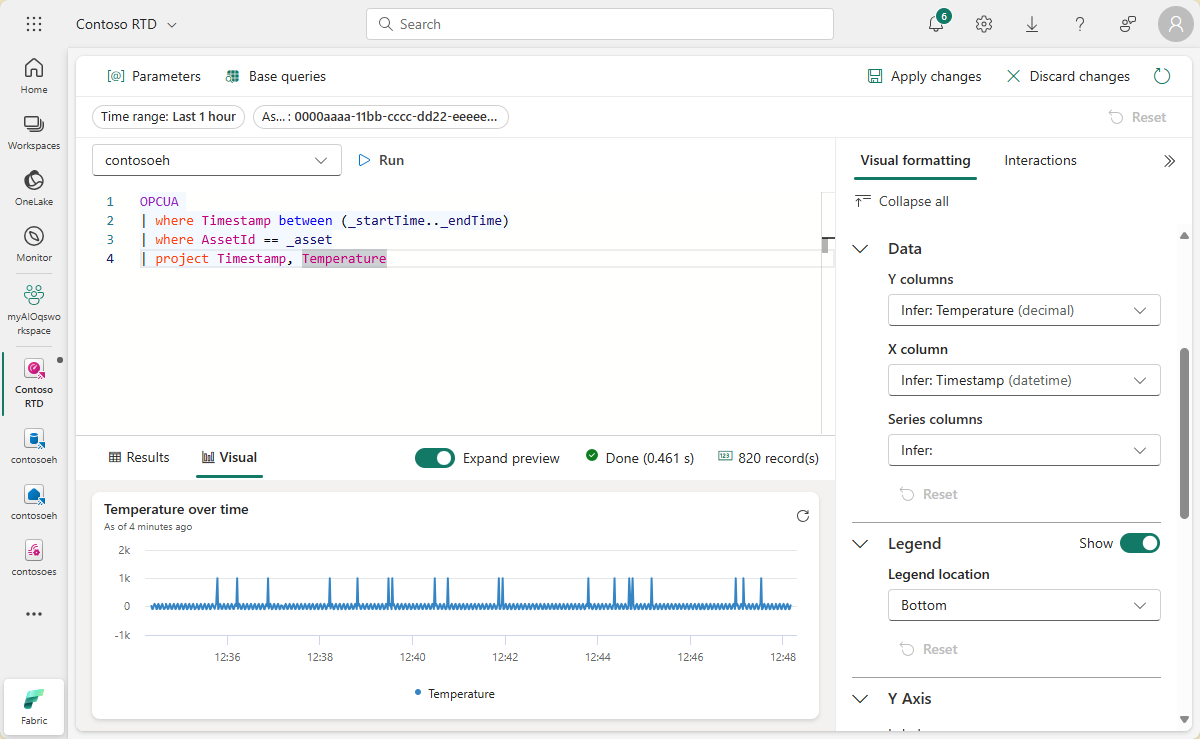

Pilih + Tambahkan visual di samping hasil kueri untuk menambahkan visual untuk data ini. Buat visual dengan karakteristik berikut:

- Nama petak peta: Suhu dari waktu ke waktu

- Jenis visual: Bagan garis

-

Data:

- Kolom Y: Suhu (desimal) (sudah disimpulkan secara default)

- Kolom X: Tanda waktu (tanggalwaktu) (sudah disimpulkan secara default)

-

Sumbu Y:

- Label: Unit

-

Sumbu X:

- Label: Tanda waktu

Pilih Terapkan perubahan untuk membuat petak peta.

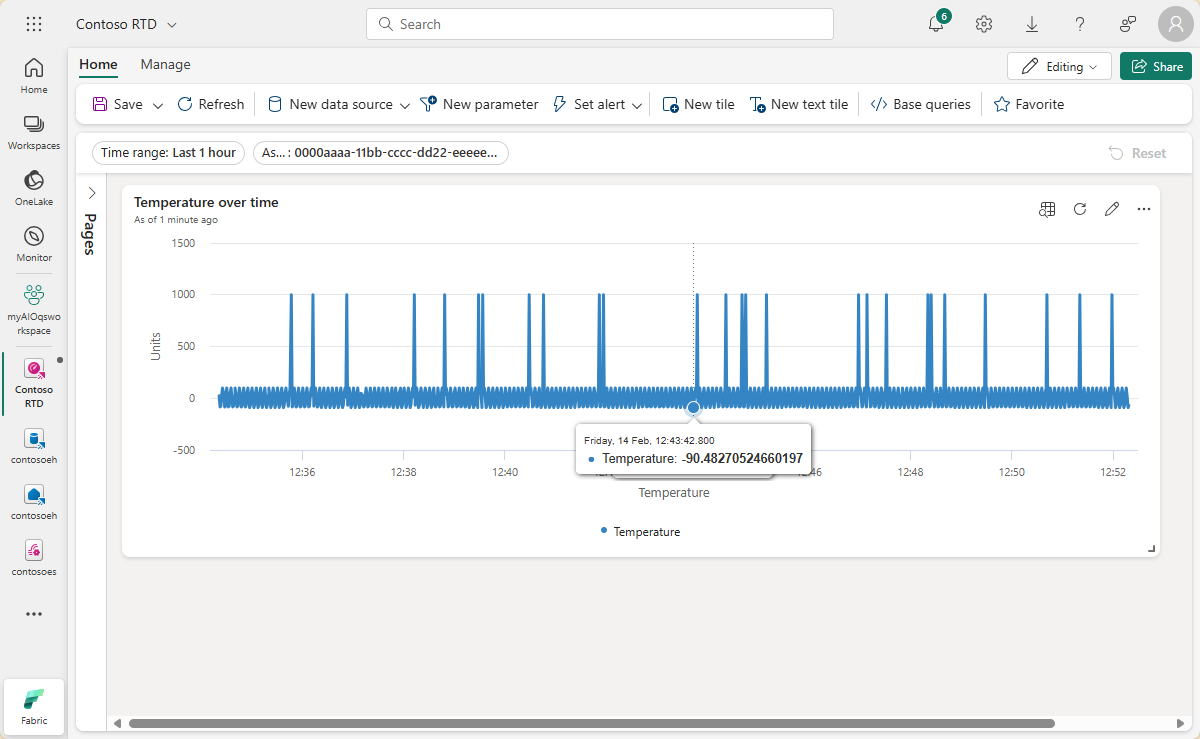

Lihat petak peta yang sudah selesai di dasbor Anda.

Membuat petak peta nilai maks

Selanjutnya, buat beberapa petak peta untuk menampilkan nilai maksimum suhu dan kelembaban.

Pilih Petak peta baru untuk membuat petak peta baru.

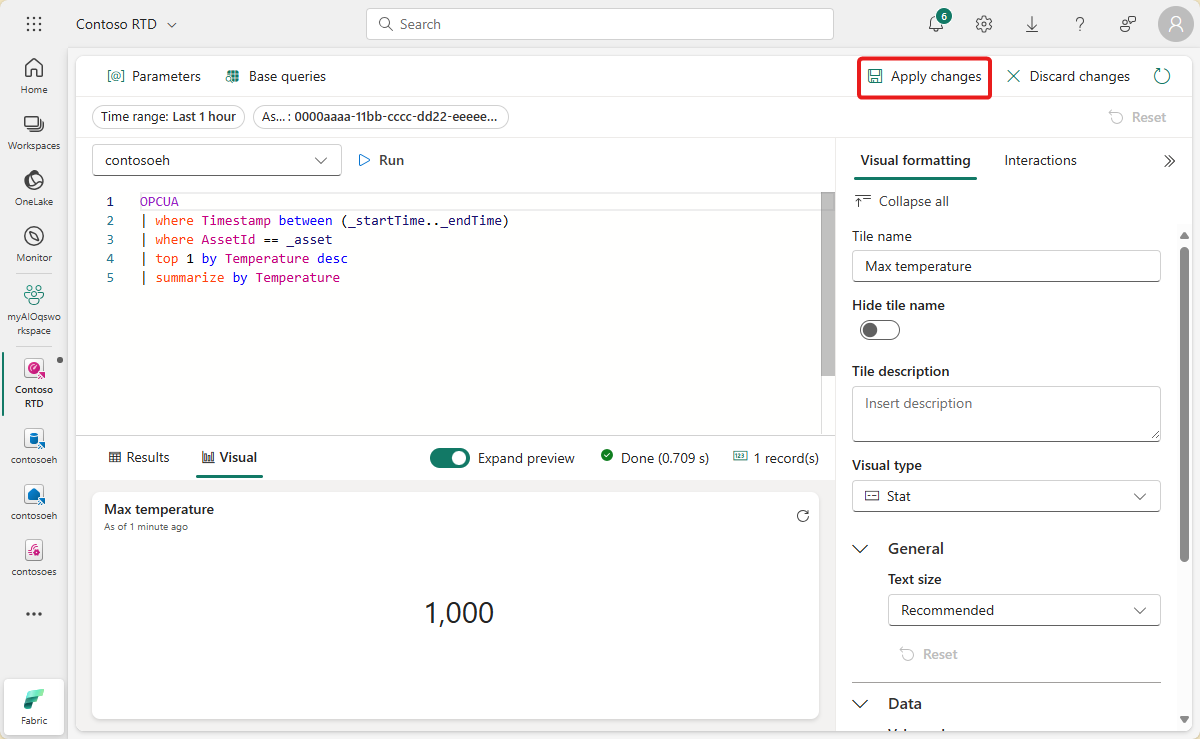

Masukkan kueri KQL berikut untuk petak peta. Kueri ini menerapkan parameter filter dari pemilih dasbor untuk rentang waktu dan aset, dan mengambil nilai suhu tertinggi dari rekaman yang dihasilkan.

OPCUA | where Timestamp between (_startTime.._endTime) | where AssetId == _asset | top 1 by Temperature desc | summarize by TemperatureJalankan kueri untuk memverifikasi bahwa suhu maksimum dapat ditemukan.

Pilih + Tambahkan visual untuk menambahkan visual untuk data ini. Buat visual dengan karakteristik berikut:

- Nama petak peta: Suhu maks

- Jenis visual: Stat

-

Data:

- Kolom nilai: Suhu (desimal) (sudah disimpulkan secara default)

Pilih Terapkan perubahan untuk membuat petak peta.

Lihat petak peta yang sudah selesai di dasbor Anda (Anda mungkin ingin mengubah ukuran petak sehingga teks lengkap terlihat).

Simpan dasbor anda yang sudah selesai.

Sekarang Anda memiliki dasbor yang menampilkan berbagai jenis visual untuk data aset dalam tutorial ini. Dari sini, Anda dapat bereksperimen dengan filter dan menambahkan jenis petak peta lainnya untuk melihat bagaimana dasbor dapat memungkinkan Anda melakukan lebih banyak hal dengan data Anda.

Bagaimana kita memecahkan masalah?

Dalam tutorial ini, Anda menggunakan eventstream untuk menyerap data Event Hubs Anda ke dalam database KQL di Microsoft Fabric Real-Time Intelligence. Kemudian, Anda membuat Dasbor Real-Time yang didukung oleh data tersebut, yang secara visual melacak perubahan nilai dari waktu ke waktu. Dengan menghubungkan data tepi dari berbagai sumber bersama-sama di Microsoft Fabric, Anda dapat membuat laporan dengan visualisasi dan fitur interaktif yang menawarkan wawasan yang lebih mendalam tentang kesehatan aset, pemanfaatan, dan tren operasional. Hal ini dapat memberdayakan Anda untuk meningkatkan produktivitas, meningkatkan performa aset, dan mendorong pengambilan keputusan berdasarkan informasi untuk hasil bisnis yang lebih baik.

Ini menyelesaikan langkah terakhir dalam alur tutorial untuk menggunakan Operasi Azure IoT untuk mengelola data perangkat dari penyebaran melalui analisis di cloud.

Membersihkan sumber daya

Jika Anda melanjutkan ke tutorial berikutnya, simpan semua sumber daya Anda.

Jika Anda ingin menghapus penyebaran Operasi Azure IoT tetapi mempertahankan kluster Anda, gunakan perintah az iot ops delete :

az iot ops delete --cluster $CLUSTER_NAME --resource-group $RESOURCE_GROUP

Jika Anda ingin menghapus semua sumber daya yang Anda buat untuk mulai cepat ini, hapus kluster Kubernetes tempat Anda menyebarkan Operasi Azure IoT lalu hapus grup sumber daya Azure yang berisi kluster.

Jika Anda menggunakan Codespace untuk mulai cepat ini, hapus Codespace Anda dari GitHub.

Catatan

Grup sumber daya berisi namespace layanan Azure Event Hubs yang Anda buat dalam tutorial ini.

Anda juga dapat menghapus ruang kerja Microsoft Fabric dan/atau semua sumber daya di dalamnya yang terkait dengan tutorial ini, termasuk eventstream, Eventhouse, dan Real-Time Dashboard.