Cara menyebarkan model Meta Llama 3.1 dengan Azure Pembelajaran Mesin studio

Dalam artikel ini, Anda mempelajari tentang keluarga model Meta Llama (LLM). Anda juga mempelajari cara menggunakan studio Azure Pembelajaran Mesin untuk menyebarkan model dari set ini baik ke API tanpa server dengan penagihan bayar sesuai pemakaian atau ke komputasi terkelola.

Penting

Baca selengkapnya tentang pengumuman Instruksi Meta Llama 3.1 405B dan model Llama 3.1 lainnya yang tersedia sekarang di Azure AI Model Catalog: Blog Komunitas Teknologi Microsoft dan dari Blog Pengumuman Meta.

Sekarang tersedia di Azure Pembelajaran Mesin studio Models-as-a-Service:

Meta-Llama-3.1-405B-InstructMeta-Llama-3.1-70B-InstructMeta-Llama-3.1-8B-Instruct

Keluarga Meta Llama 3.1 dari model bahasa besar multibahasa (LLM) adalah kumpulan model generatif yang telah dilatih dan disetel dalam ukuran 8B, 70B, dan 405B (teks masuk/teks keluar). Semua model mendukung panjang konteks panjang (128k) dan dioptimalkan untuk inferensi dengan dukungan untuk perhatian kueri yang dikelompokkan (GQA). Model teks yang disetel instruksi Llama 3.1 (8B, 70B, 405B) dioptimalkan untuk kasus penggunaan dialog multibahasa dan mengungguli banyak model obrolan sumber terbuka yang tersedia pada tolok ukur industri umum.

Lihat sampel GitHub berikut untuk menjelajahi integrasi dengan LangChain, LiteLLM, OpenAI, dan Azure API.

Penting

Fitur ini masih dalam pratinjau umum. Versi pratinjau ini disediakan tanpa perjanjian tingkat layanan, dan tidak disarankan untuk beban kerja produksi. Fitur tertentu mungkin tidak didukung atau mungkin memiliki kemampuan terbatas.

Untuk mengetahui informasi selengkapnya, lihat Ketentuan Penggunaan Tambahan untuk Pratinjau Microsoft Azure.

Menyebarkan Meta Llama 3.1 405B Instruksikan sebagai API tanpa server

Model Meta Llama 3.1 - seperti Meta Llama 3.1 405B Instruct - dapat disebarkan sebagai API tanpa server dengan bayar sesuai penggunaan, menyediakan cara untuk menggunakannya sebagai API tanpa menghostingnya di langganan Anda sambil menjaga keamanan perusahaan dan organisasi kepatuhan membutuhkan. Opsi penyebaran ini tidak memerlukan kuota dari langganan Anda. Model Meta Llama 3.1 disebarkan sebagai API tanpa server dengan penagihan bayar sesuai pemakaian melalui Microsoft Marketplace Azure, dan mereka mungkin menambahkan lebih banyak ketentuan penggunaan dan harga.

penawaran model Marketplace Azure

Model berikut tersedia di Marketplace Azure untuk Llama 3.1 dan Llama 3 saat disebarkan sebagai layanan dengan bayar sesuai penggunaan:

- Meta-Llama-3.1-405B-Instruct (pratinjau)

- Meta-Llama-3.1-70B-Instruct (pratinjau)

- Meta Llama-3.1-8B-Instruct (pratinjau)

- Meta-Llama-3-70B-Instruct (pratinjau)

- Meta-Llama-3-8B-Instruct (pratinjau)

Jika Anda perlu menyebarkan model yang berbeda, sebarkan ke komputasi terkelola sebagai gantinya.

Prasyarat

Langganan Azure dengan metode pembayaran yang valid. Langganan Azure gratis atau uji coba tidak akan berfungsi. Jika Anda tidak memiliki langganan Azure, buat akun Azure berbayar untuk memulai.

Ruang kerja Azure Pembelajaran Mesin dan instans komputasi. Jika Anda tidak memilikinya, gunakan langkah-langkah dalam artikel Mulai Cepat: Membuat sumber daya ruang kerja untuk membuatnya. Penawaran penyebaran model API tanpa server untuk Meta Llama 3.1 dan Llama 3 hanya tersedia dengan hub yang dibuat di wilayah ini:

- AS Timur

- AS Timur 2

- US Tengah Utara

- US Tengah Selatan

- AS Barat

- AS Barat 3

- Swedia Tengah

Untuk daftar wilayah yang tersedia untuk setiap model yang mendukung penyebaran titik akhir API tanpa server, lihat Ketersediaan wilayah untuk model di titik akhir API tanpa server.

Kontrol akses berbasis peran Azure (Azure RBAC) digunakan untuk memberikan akses ke operasi di Azure Machine Learning. Untuk melakukan langkah-langkah dalam artikel ini, akun pengguna Anda harus diberi peran pemilik atau kontributor untuk langganan Azure. Atau, akun Anda dapat diberi peran kustom yang memiliki izin berikut:

Pada langganan Azure—untuk berlangganan ruang kerja ke penawaran Marketplace Azure, sekali untuk setiap ruang kerja, per penawaran:

Microsoft.MarketplaceOrdering/agreements/offers/plans/readMicrosoft.MarketplaceOrdering/agreements/offers/plans/sign/actionMicrosoft.MarketplaceOrdering/offerTypes/publishers/offers/plans/agreements/readMicrosoft.Marketplace/offerTypes/publishers/offers/plans/agreements/readMicrosoft.SaaS/register/action

Pada grup sumber daya—untuk membuat dan menggunakan sumber daya SaaS:

Microsoft.SaaS/resources/readMicrosoft.SaaS/resources/write

Di ruang kerja—untuk menyebarkan titik akhir (peran ilmuwan data Azure Pembelajaran Mesin sudah berisi izin ini):

Microsoft.MachineLearningServices/workspaces/marketplaceModelSubscriptions/*Microsoft.MachineLearningServices/workspaces/serverlessEndpoints/*

Untuk informasi selengkapnya tentang izin, lihat Mengelola akses ke ruang kerja Azure Pembelajaran Mesin.

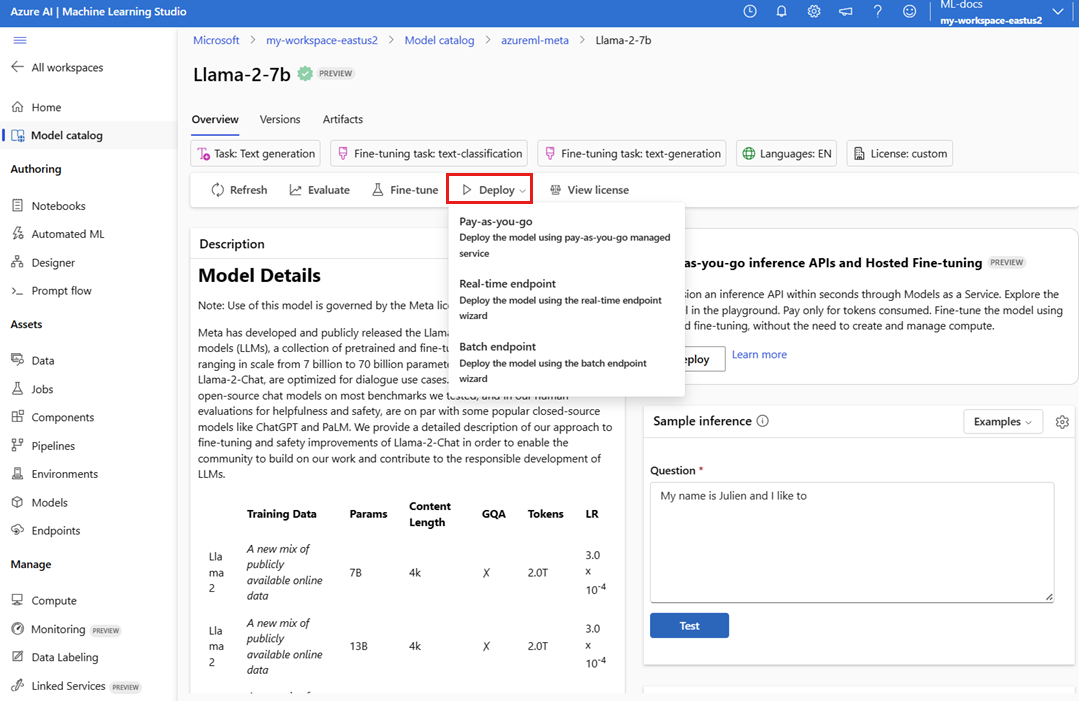

Buat slot penyebaran baru

Untuk membuat penyebaran:

Buka studio Azure Pembelajaran Mesin.

Pilih ruang kerja tempat Anda ingin menyebarkan model Anda. Untuk menggunakan penawaran penyebaran model prabayar, ruang kerja Anda harus termasuk dalam salah satu wilayah yang tersedia yang tercantum dalam prasyarat artikel ini.

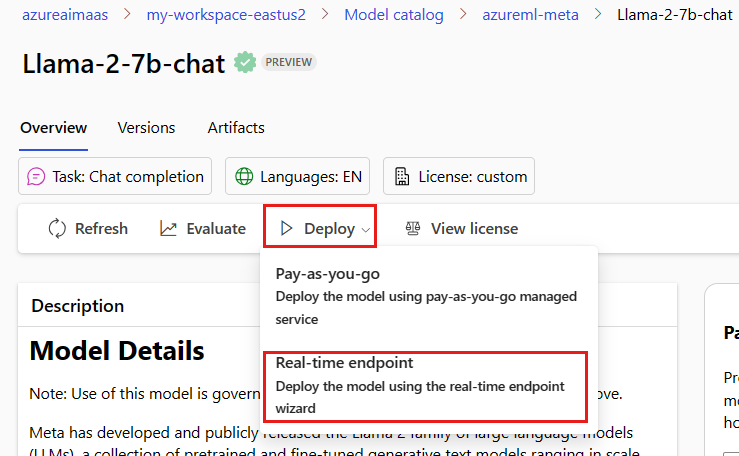

Pilih

Meta-Llama-3.1-405B-Instructuntuk menyebarkan dari katalog model.Atau, Anda dapat memulai penyebaran dengan masuk ke ruang kerja Anda dan memilih Titik>Akhir Titik>akhir Tanpa Server Buat.

Pada halaman Detail untuk

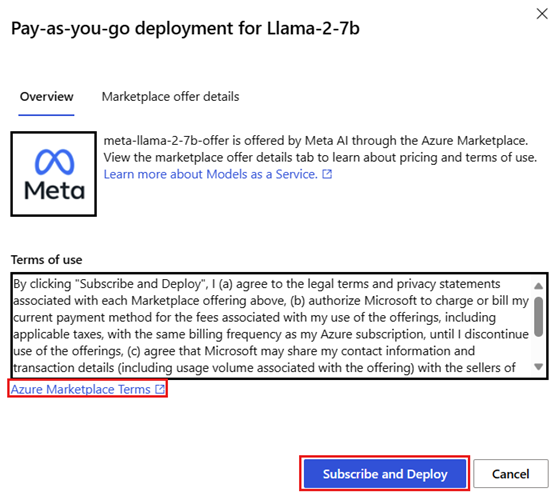

Meta-Llama-3.1-405B-Instruct, pilih Sebarkan lalu pilih API Tanpa Server dengan Azure AI Content Safety.Pada wizard penyebaran, pilih tautan untuk Marketplace Azure Ketentuan untuk mempelajari selengkapnya tentang ketentuan penggunaan. Anda juga dapat memilih tab detail penawaran Marketplace untuk mempelajari tentang harga untuk model yang dipilih.

Jika ini adalah pertama kalinya Anda menyebarkan model di ruang kerja, Anda harus berlangganan ruang kerja Anda untuk penawaran tertentu (misalnya,

Meta-Llama-3.1-405B-Instruct) dari Marketplace Azure. Langkah ini mengharuskan akun Anda memiliki izin langganan Azure dan izin grup sumber daya yang tercantum dalam prasyarat. Setiap ruang kerja memiliki langganannya sendiri ke penawaran Marketplace Azure tertentu, yang memungkinkan Anda mengontrol dan memantau pengeluaran. Pilih Berlangganan dan Sebarkan.Catatan

Berlangganan ruang kerja ke penawaran Marketplace Azure tertentu (dalam hal ini, Llama-3-70B) mengharuskan akun Anda memiliki akses Kontributor atau Pemilik di tingkat langganan tempat proyek dibuat. Atau, akun pengguna Anda dapat diberi peran kustom yang memiliki izin langganan Azure dan izin grup sumber daya yang tercantum dalam prasyarat.

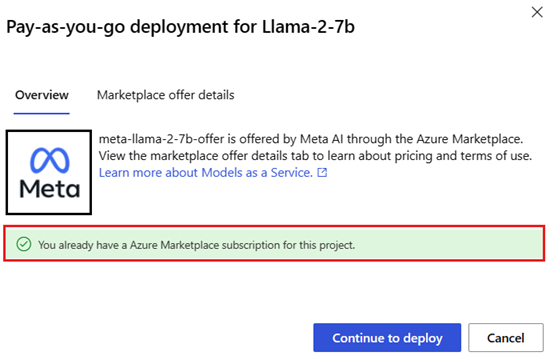

Setelah Anda mendaftarkan ruang kerja untuk penawaran Marketplace Azure tertentu, penyebaran berikutnya dari penawaran yang sama di ruang kerja yang sama tidak memerlukan berlangganan lagi. Oleh karena itu, Anda tidak perlu memiliki izin tingkat langganan untuk penyebaran berikutnya. Jika skenario ini berlaku untuk Anda, pilih Lanjutkan untuk menyebarkan.

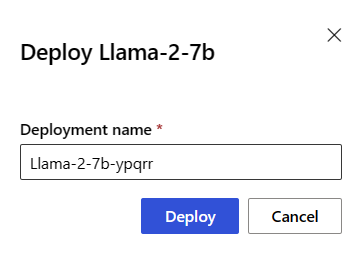

Beri nama penyebaran. Nama ini menjadi bagian dari URL API penyebaran. URL ini harus unik di setiap wilayah Azure.

Pilih Sebarkan. Tunggu hingga penyebaran selesai dan Anda diarahkan ke halaman titik akhir tanpa server.

Pilih titik akhir untuk membuka halaman Detailnya.

Pilih tab Uji untuk mulai berinteraksi dengan model.

Anda juga dapat mencatat URL Target dan Kunci Rahasia untuk memanggil penyebaran dan menghasilkan penyelesaian.

Anda selalu dapat menemukan detail titik akhir, URL, dan kunci akses dengan menavigasi ke titik akhir Tanpa Server Titik>Akhir Ruang>Kerja.

Untuk mempelajari tentang penagihan untuk model Meta Llama yang disebarkan sebagai API tanpa server, lihat Pertimbangan biaya dan kuota untuk model Meta Llama yang disebarkan sebagai API tanpa server.

Mengonsumsi model Meta Llama sebagai layanan

Model yang disebarkan sebagai layanan dapat dikonsumsi menggunakan obrolan atau API penyelesaian, tergantung pada jenis model yang Anda sebarkan.

Di ruang kerja, pilih Titik>Akhir Titik akhir Tanpa Server.

Temukan dan pilih penyebaran yang

Meta-Llama-3.1-405B-InstructAnda buat.Salin URL Target dan nilai Token kunci.

Buat permintaan API berdasarkan jenis model yang Anda sebarkan.

- Untuk model penyelesaian, seperti

Llama-3-8B, gunakan<target_url>/v1/completionsAPI. - Untuk model obrolan, seperti

Meta-Llama-3.1-405B-Instruct, gunakan/chat/completionsAPI.

Untuk informasi selengkapnya tentang menggunakan API, lihat bagian referensi .

- Untuk model penyelesaian, seperti

Referensi untuk model Meta Llama 3.1 menyebarkan API tanpa server

Model Llama menerima API Inferensi Model Azure AI pada rute /chat/completions atau LLAMA Chat API di /v1/chat/completions. Dengan cara yang sama, penyelesaian teks dapat dihasilkan menggunakan Azure AI Model Inference API pada rute /completions atau API Penyelesaian Llama pada /v1/completions

Skema Azure AI Model Inference API dapat ditemukan dalam referensi untuk artikel Penyelesaian Obrolan dan spesifikasi OpenAPI dapat diperoleh dari titik akhir itu sendiri.

API Penyelesaian

Gunakan metode POST untuk mengirim permintaan ke /v1/completions rute:

Permintaan

POST /v1/completions HTTP/1.1

Host: <DEPLOYMENT_URI>

Authorization: Bearer <TOKEN>

Content-type: application/json

Mengajukan permintaan skema

Payload adalah string berformat JSON yang berisi parameter berikut:

| Tombol | Jenis | Default | Deskripsi |

|---|---|---|---|

prompt |

string |

Tidak ada default. Nilai ini harus ditentukan. | Perintah untuk mengirim ke model. |

stream |

boolean |

False |

Streaming memungkinkan token yang dihasilkan dikirim sebagai peristiwa yang dikirim server khusus data setiap kali tersedia. |

max_tokens |

integer |

16 |

Jumlah maksimum token yang akan dihasilkan dalam penyelesaian. Jumlah token prompt Anda ditambah max_tokens tidak dapat melebihi panjang konteks model. |

top_p |

float |

1 |

Alternatif untuk pengambilan sampel dengan suhu, yang disebut pengambilan sampel nukleus, di mana model mempertimbangkan hasil token dengan top_p massa probabilitas. Jadi 0,1 berarti hanya token yang terdiri dari 10% massa peluang teratas yang dipertimbangkan. Kami umumnya merekomendasikan perubahan top_p atau temperature, tetapi tidak keduanya. |

temperature |

float |

1 |

Suhu pengambilan sampel yang akan digunakan, antara 0 dan 2. Nilai yang lebih tinggi berarti sampel model lebih luas distribusi token. Nol berarti pengambilan sampel serakah. Sebaiknya ubah ini atau top_p, tetapi tidak keduanya. |

n |

integer |

1 |

Berapa banyak penyelesaian yang dihasilkan untuk setiap perintah. Catatan: Karena parameter ini menghasilkan banyak penyelesaian, parameter ini dapat dengan cepat menggunakan kuota token Anda. |

stop |

array |

null |

String atau daftar string yang berisi kata di mana API berhenti menghasilkan token lebih lanjut. Teks yang dikembalikan tidak akan berisi urutan berhenti. |

best_of |

integer |

1 |

best_of Menghasilkan sisi server penyelesaian dan mengembalikan "terbaik" (yang dengan probabilitas log terendah per token). Hasil tidak dapat dialirkan. Ketika digunakan dengan n, best_of mengontrol jumlah penyelesaian kandidat dan n menentukan berapa banyak yang akan dikembalikan—best_of harus lebih besar dari n. Catatan: Karena parameter ini menghasilkan banyak penyelesaian, parameter ini dapat dengan cepat menggunakan kuota token Anda. |

logprobs |

integer |

null |

Angka yang menunjukkan untuk menyertakan probabilitas log pada logprobs token yang paling mungkin dan token yang dipilih. Misalnya, jika logprobs adalah 10, API mengembalikan daftar 10 token yang paling mungkin. API selalu mengembalikan logprob token sampel, sehingga mungkin ada hingga logprobs+1 elemen dalam respons. |

presence_penalty |

float |

null |

Angka antara -2,0 dan 2,0. Nilai positif mengkhususkan token baru berdasarkan apakah token tersebut muncul dalam teks sejauh ini, meningkatkan kemungkinan model untuk berbicara tentang topik baru. |

ignore_eos |

boolean |

True |

Apakah akan mengabaikan token EOS dan terus menghasilkan token setelah token EOS dihasilkan. |

use_beam_search |

boolean |

False |

Apakah akan menggunakan pencarian sinar alih-alih pengambilan sampel. Dalam kasus seperti itu, best_of harus lebih besar dari 1 dan temperature harus 0. |

stop_token_ids |

array |

null |

Daftar ID untuk token yang, saat dibuat, menghentikan pembuatan token lebih lanjut. Output yang dikembalikan berisi token berhenti kecuali token berhenti adalah token khusus. |

skip_special_tokens |

boolean |

null |

Apakah akan melewati token khusus dalam output. |

Contoh

Isi

{

"prompt": "What's the distance to the moon?",

"temperature": 0.8,

"max_tokens": 512,

}

Skema respons

Payload respons adalah kamus dengan bidang berikut.

| Tombol | Tipe | Deskripsi |

|---|---|---|

id |

string |

Pengidentifikasi unik untuk penyelesaian. |

choices |

array |

Daftar pilihan penyelesaian model yang dihasilkan untuk perintah input. |

created |

integer |

Tanda waktu Unix (dalam detik) saat penyelesaian dibuat. |

model |

string |

model_id digunakan untuk penyelesaian. |

object |

string |

Jenis objek, yang selalu text_completion. |

usage |

object |

Statistik penggunaan untuk permintaan penyelesaian. |

Tip

Dalam mode streaming, untuk setiap potongan respons, finish_reason selalu null, kecuali dari yang terakhir yang dihentikan oleh payload [DONE].

Objek choices adalah kamus dengan bidang berikut.

| Tombol | Tipe | Deskripsi |

|---|---|---|

index |

integer |

Indeks pilihan. Ketika best_of> 1, indeks dalam array ini mungkin tidak berurutan dan mungkin tidak 0 hingga n-1. |

text |

string |

Hasil penyelesaian. |

finish_reason |

string |

Alasan model berhenti menghasilkan token: - stop: model mencapai titik berhenti alami, atau urutan berhenti yang disediakan. - length: jika jumlah maksimum token telah tercapai. - content_filter: Ketika RAI memoderasi dan CMP memaksa moderasi. - content_filter_error: kesalahan selama moderasi dan tidak dapat membuat keputusan tentang respons. - null: Respons API masih berlangsung atau tidak lengkap. |

logprobs |

object |

Probabilitas log dari token yang dihasilkan dalam teks output. |

Objek usage adalah kamus dengan bidang berikut.

| Tombol | Tipe | Nilai |

|---|---|---|

prompt_tokens |

integer |

Jumlah token dalam perintah. |

completion_tokens |

integer |

Jumlah token yang dihasilkan dalam penyelesaian. |

total_tokens |

integer |

Total token. |

Objek logprobs adalah kamus dengan bidang berikut:

| Tombol | Tipe | Nilai |

|---|---|---|

text_offsets |

array dari integers |

Posisi atau indeks setiap token dalam output penyelesaian. |

token_logprobs |

array dari float |

Dipilih logprobs dari kamus dalam top_logprobs array. |

tokens |

array dari string |

Token yang dipilih. |

top_logprobs |

array dari dictionary |

Array kamus. Di setiap kamus, kuncinya adalah token dan nilainya adalah prob. |

Contoh

{

"id": "12345678-1234-1234-1234-abcdefghijkl",

"object": "text_completion",

"created": 217877,

"choices": [

{

"index": 0,

"text": "The Moon is an average of 238,855 miles away from Earth, which is about 30 Earths away.",

"logprobs": null,

"finish_reason": "stop"

}

],

"usage": {

"prompt_tokens": 7,

"total_tokens": 23,

"completion_tokens": 16

}

}

API Obrolan

Gunakan metode POST untuk mengirim permintaan ke /v1/chat/completions rute:

Permintaan

POST /v1/chat/completions HTTP/1.1

Host: <DEPLOYMENT_URI>

Authorization: Bearer <TOKEN>

Content-type: application/json

Mengajukan permintaan skema

Payload adalah string berformat JSON yang berisi parameter berikut:

| Tombol | Jenis | Default | Deskripsi |

|---|---|---|---|

messages |

string |

Tidak ada default. Nilai ini harus ditentukan. | Pesan atau riwayat pesan yang akan digunakan untuk meminta model. |

stream |

boolean |

False |

Streaming memungkinkan token yang dihasilkan dikirim sebagai peristiwa yang dikirim server khusus data setiap kali tersedia. |

max_tokens |

integer |

16 |

Jumlah maksimum token yang akan dihasilkan dalam penyelesaian. Jumlah token prompt Anda ditambah max_tokens tidak dapat melebihi panjang konteks model. |

top_p |

float |

1 |

Alternatif untuk pengambilan sampel dengan suhu, yang disebut pengambilan sampel nukleus, di mana model mempertimbangkan hasil token dengan top_p massa probabilitas. Jadi 0,1 berarti hanya token yang terdiri dari 10% massa peluang teratas yang dipertimbangkan. Kami umumnya merekomendasikan perubahan top_p atau temperature, tetapi tidak keduanya. |

temperature |

float |

1 |

Suhu pengambilan sampel yang akan digunakan, antara 0 dan 2. Nilai yang lebih tinggi berarti sampel model lebih luas distribusi token. Nol berarti pengambilan sampel serakah. Sebaiknya ubah ini atau top_p, tetapi tidak keduanya. |

n |

integer |

1 |

Berapa banyak penyelesaian yang dihasilkan untuk setiap perintah. Catatan: Karena parameter ini menghasilkan banyak penyelesaian, parameter ini dapat dengan cepat menggunakan kuota token Anda. |

stop |

array |

null |

String atau daftar string yang berisi kata di mana API berhenti menghasilkan token lebih lanjut. Teks yang dikembalikan tidak akan berisi urutan berhenti. |

best_of |

integer |

1 |

best_of Menghasilkan sisi server penyelesaian dan mengembalikan "terbaik" (yang dengan probabilitas log terendah per token). Hasil tidak dapat dialirkan. Ketika digunakan dengan n, best_of mengontrol jumlah penyelesaian kandidat dan n menentukan berapa banyak yang akan dikembalikan—best_of harus lebih besar dari n. Catatan: Karena parameter ini menghasilkan banyak penyelesaian, parameter ini dapat dengan cepat menggunakan kuota token Anda. |

logprobs |

integer |

null |

Angka yang menunjukkan untuk menyertakan probabilitas log pada logprobs token yang paling mungkin dan token yang dipilih. Misalnya, jika logprobs adalah 10, API mengembalikan daftar 10 token yang paling mungkin. API akan selalu mengembalikan logprob token sampel, sehingga mungkin ada hingga logprobs+1 elemen dalam respons. |

presence_penalty |

float |

null |

Angka antara -2,0 dan 2,0. Nilai positif mengkhususkan token baru berdasarkan apakah token tersebut muncul dalam teks sejauh ini, meningkatkan kemungkinan model untuk berbicara tentang topik baru. |

ignore_eos |

boolean |

True |

Apakah akan mengabaikan token EOS dan terus menghasilkan token setelah token EOS dihasilkan. |

use_beam_search |

boolean |

False |

Apakah akan menggunakan pencarian sinar alih-alih pengambilan sampel. Dalam kasus seperti itu, best_of harus lebih besar dari 1 dan temperature harus 0. |

stop_token_ids |

array |

null |

Daftar ID untuk token yang, saat dibuat, menghentikan pembuatan token lebih lanjut. Output yang dikembalikan berisi token berhenti kecuali token berhenti adalah token khusus. |

skip_special_tokens |

boolean |

null |

Apakah akan melewati token khusus dalam output. |

Objek messages memiliki bidang berikut:

| Tombol | Tipe | Nilai |

|---|---|---|

content |

string |

Isi pesan. Konten diperlukan untuk semua pesan. |

role |

string |

Peran penulis pesan. Salah satu dari system, user, atau assistant. |

Contoh

Isi

{

"messages":

[

{

"role": "system",

"content": "You are a helpful assistant that translates English to Italian."},

{

"role": "user",

"content": "Translate the following sentence from English to Italian: I love programming."

}

],

"temperature": 0.8,

"max_tokens": 512,

}

Skema respons

Payload respons adalah kamus dengan bidang berikut.

| Tombol | Tipe | Deskripsi |

|---|---|---|

id |

string |

Pengidentifikasi unik untuk penyelesaian. |

choices |

array |

Daftar pilihan penyelesaian model yang dihasilkan untuk pesan input. |

created |

integer |

Tanda waktu Unix (dalam detik) saat penyelesaian dibuat. |

model |

string |

model_id digunakan untuk penyelesaian. |

object |

string |

Jenis objek, yang selalu chat.completion. |

usage |

object |

Statistik penggunaan untuk permintaan penyelesaian. |

Tip

Dalam mode streaming, untuk setiap potongan respons, finish_reason selalu null, kecuali dari yang terakhir yang dihentikan oleh payload [DONE]. Di setiap choices objek, kunci untuk messages diubah oleh delta.

Objek choices adalah kamus dengan bidang berikut.

| Tombol | Tipe | Deskripsi |

|---|---|---|

index |

integer |

Indeks pilihan. Ketika best_of> 1, indeks dalam array ini mungkin tidak berurutan dan mungkin bukan 0 ke n-1. |

messages atau delta |

string |

Penyelesaian obrolan menghasilkan messages objek. Saat mode streaming digunakan, delta kunci digunakan. |

finish_reason |

string |

Alasan model berhenti menghasilkan token: - stop: model mencapai titik berhenti alami atau urutan berhenti yang disediakan. - length: jika jumlah maksimum token telah tercapai. - content_filter: Ketika RAI memoderasi dan CMP memaksa moderasi - content_filter_error: kesalahan selama moderasi dan tidak dapat membuat keputusan tentang respons - null: Respons API masih berlangsung atau tidak lengkap. |

logprobs |

object |

Probabilitas log dari token yang dihasilkan dalam teks output. |

Objek usage adalah kamus dengan bidang berikut.

| Tombol | Tipe | Nilai |

|---|---|---|

prompt_tokens |

integer |

Jumlah token dalam perintah. |

completion_tokens |

integer |

Jumlah token yang dihasilkan dalam penyelesaian. |

total_tokens |

integer |

Total token. |

Objek logprobs adalah kamus dengan bidang berikut:

| Tombol | Tipe | Nilai |

|---|---|---|

text_offsets |

array dari integers |

Posisi atau indeks setiap token dalam output penyelesaian. |

token_logprobs |

array dari float |

Dipilih logprobs dari kamus dalam top_logprobs array. |

tokens |

array dari string |

Token yang dipilih. |

top_logprobs |

array dari dictionary |

Array kamus. Di setiap kamus, kuncinya adalah token dan nilainya adalah prob. |

Contoh

Berikut adalah contoh respons:

{

"id": "12345678-1234-1234-1234-abcdefghijkl",

"object": "chat.completion",

"created": 2012359,

"model": "",

"choices": [

{

"index": 0,

"finish_reason": "stop",

"message": {

"role": "assistant",

"content": "Sure, I\'d be happy to help! The translation of ""I love programming"" from English to Italian is:\n\n""Amo la programmazione.""\n\nHere\'s a breakdown of the translation:\n\n* ""I love"" in English becomes ""Amo"" in Italian.\n* ""programming"" in English becomes ""la programmazione"" in Italian.\n\nI hope that helps! Let me know if you have any other sentences you\'d like me to translate."

}

}

],

"usage": {

"prompt_tokens": 10,

"total_tokens": 40,

"completion_tokens": 30

}

}

Menyebarkan model Meta Llama ke komputasi terkelola

Selain menyebarkan dengan layanan terkelola prabayar, Anda juga dapat menyebarkan model Meta Llama 3.1 ke komputasi terkelola di studio Azure Pembelajaran Mesin. Saat disebarkan ke komputasi terkelola, Anda dapat memilih semua detail tentang infrastruktur yang menjalankan model, termasuk komputer virtual yang akan digunakan dan jumlah instans untuk menangani beban yang Anda harapkan. Model yang disebarkan ke komputasi terkelola menggunakan kuota dari langganan Anda. Model berikut dari gelombang rilis 3.1 tersedia pada komputasi terkelola:

Meta-Llama-3.1-8B-Instruct(FT didukung)Meta-Llama-3.1-70B-Instruct(FT didukung)Meta-Llama-3.1-8B(FT didukung)Meta-Llama-3.1-70B(FT didukung)Llama Guard 3 8BPrompt Guard

Buat slot penyebaran baru

Ikuti langkah-langkah ini untuk menyebarkan model seperti Meta-Llama-3.1-70B-Instruct ke komputasi terkelola di studio Azure Pembelajaran Mesin.

Pilih ruang kerja tempat Anda ingin menyebarkan model.

Pilih model yang ingin Anda sebarkan dari katalog model studio.

Atau, Anda dapat memulai penyebaran dengan masuk ke ruang kerja Anda dan memilih Titik>Akhir Buat Komputasi>Terkelola.

Pada halaman gambaran umum model, pilih Sebarkan lalu Komputasi Terkelola tanpa Keamanan Konten Azure AI.

Pada halaman Sebarkan dengan Azure AI Content Safety (pratinjau) , pilih Lewati Azure AI Content Safety sehingga Anda dapat terus menyebarkan model menggunakan UI.

Tip

Secara umum, kami sarankan Anda memilih Aktifkan Azure AI Content Safety (Disarankan) untuk penyebaran model Meta Llama. Opsi penyebaran ini saat ini hanya didukung menggunakan Python SDK dan itu terjadi di buku catatan.

Pilih Lanjutkan.

Tip

Jika Anda tidak memiliki cukup kuota yang tersedia di proyek yang dipilih, Anda dapat menggunakan opsi yang ingin saya gunakan kuota bersama dan saya mengakui bahwa titik akhir ini akan dihapus dalam 168 jam.

Pilih Komputer virtual dan jumlah Instans yang ingin Anda tetapkan ke penyebaran.

Pilih jika Anda ingin membuat penyebaran ini sebagai bagian dari titik akhir baru atau yang sudah ada. Titik akhir dapat menghosting beberapa penyebaran sambil menjaga konfigurasi sumber daya tetap eksklusif untuk masing-masing penyebaran. Penyebaran di bawah titik akhir yang sama berbagi URI titik akhir dan kunci aksesnya.

Tunjukkan apakah Anda ingin mengaktifkan Pengumpulan data inferensi (pratinjau).

Tunjukkan apakah Anda ingin mengaktifkan Model Paket (pratinjau).

Pilih Sebarkan. Setelah beberapa saat, halaman Detail titik akhir terbuka.

Tunggu hingga pembuatan dan penyebaran titik akhir selesai. Langkah ini bisa memakan waktu beberapa menit.

Pilih halaman Konsumsi titik akhir untuk mendapatkan sampel kode yang dapat Anda gunakan untuk menggunakan model yang disebarkan di aplikasi Anda.

Untuk informasi selengkapnya tentang cara menyebarkan model ke komputasi terkelola menggunakan studio, lihat Menyebarkan model fondasi ke titik akhir untuk inferensi.

Mengonsumsi model Meta Llama yang disebarkan ke komputasi terkelola

Untuk referensi tentang cara memanggil model Meta Llama 3 yang disebarkan ke komputasi terkelola, lihat kartu model di katalog model studio Azure Pembelajaran Mesin. Setiap kartu model memiliki halaman gambaran umum yang menyertakan deskripsi model, sampel untuk inferensi berbasis kode, penyempurnaan, dan evaluasi model.

Contoh inferensi tambahan

| Paket | Contoh Buku Catatan |

|---|---|

| CLI menggunakan permintaan web CURL dan Python | webrequests.ipynb |

| OpenAI SDK (eksperimental) | openaisdk.ipynb |

| LangChain | langchain.ipynb |

| LiteLLM SDK | litellm.ipynb |

Biaya dan kuota

Pertimbangan biaya dan kuota untuk model Meta Llama 3.1 yang disebarkan sebagai API tanpa server

Model Meta Llama 3.1 yang disebarkan sebagai API tanpa server ditawarkan oleh Meta melalui Marketplace Azure dan terintegrasi dengan studio Azure Pembelajaran Mesin untuk digunakan. Anda dapat menemukan harga Marketplace Azure saat menyebarkan atau menyempurnakan model.

Setiap kali ruang kerja berlangganan penawaran model tertentu dari Marketplace Azure, sumber daya baru dibuat untuk melacak biaya yang terkait dengan konsumsinya. Sumber daya yang sama digunakan untuk melacak biaya yang terkait dengan inferensi dan penyempurnaan; namun, beberapa meter tersedia untuk melacak setiap skenario secara independen.

Untuk informasi selengkapnya tentang cara melacak biaya, lihat Memantau biaya untuk model yang ditawarkan melalui Marketplace Azure.

Kuota dikelola per penyebaran. Setiap penyebaran memiliki batas tarif 400.000 token per menit dan 1.000 permintaan API per menit. Namun, saat ini kami membatasi satu penyebaran per model per proyek. Hubungi Dukungan Microsoft Azure jika batas tarif saat ini tidak cukup untuk skenario Anda.

Pertimbangan biaya dan kuota untuk model Meta Llama 3.1 yang disebarkan komputasi terkelola

Untuk penyebaran dan inferensi model Meta Llama 3.1 dengan komputasi terkelola, Anda menggunakan kuota inti komputer virtual (VM) yang ditetapkan ke langganan Anda berdasarkan per wilayah. Saat mendaftar ke Azure AI Studio, Anda menerima kuota VM default untuk beberapa keluarga VM yang tersedia di wilayah tersebut. Anda dapat terus membuat penyebaran hingga mencapai batas kuota Anda. Setelah mencapai batas ini, Anda dapat meminta penambahan kuota.

Pemfilteran konten

Model yang disebarkan sebagai API tanpa server dilindungi oleh keamanan konten Azure AI. Saat disebarkan ke komputasi terkelola, Anda dapat menolak kemampuan ini. Dengan keamanan konten Azure AI diaktifkan, perintah dan penyelesaian melewati ansambel model klasifikasi yang bertujuan mendeteksi dan mencegah output konten berbahaya. Sistem pemfilteran konten mendeteksi dan mengambil tindakan pada kategori tertentu dari konten yang berpotensi berbahaya dalam perintah input dan penyelesaian output. Pelajari selengkapnya tentang Azure AI Content Safety.

Konten terkait

Saran dan Komentar

Segera hadir: Sepanjang tahun 2024 kami akan menghentikan penggunaan GitHub Issues sebagai mekanisme umpan balik untuk konten dan menggantinya dengan sistem umpan balik baru. Untuk mengetahui informasi selengkapnya, lihat: https://aka.ms/ContentUserFeedback.

Kirim dan lihat umpan balik untuk