Memfilter dan menyerap untuk Azure Data Lake Storage Gen2 menggunakan editor tanpa kode Azure Stream Analytics

Artikel ini menjelaskan cara menggunakan editor tanpa kode untuk membuat pekerjaan Azure Stream Analytics dengan mudah. Ini terus membaca dari Azure Event Hubs Anda, memfilter data masuk, lalu menulis hasilnya terus menerus ke Azure Data Lake Storage Gen2.

Prasyarat

- Sumber daya Azure Event Hubs Anda harus dapat diakses publik dan tidak berada di belakang firewall atau diamankan di Azure Virtual Network

- Data di Azure Event Hubs Anda harus diserialisasikan dalam format JSON, CSV, atau Avro.

Mengembangkan pekerjaan Azure Stream Analytics untuk memfilter dan menyerap data secara real-time

Di portal Azure, temukan dan pilih instans Azure Event Hubs.

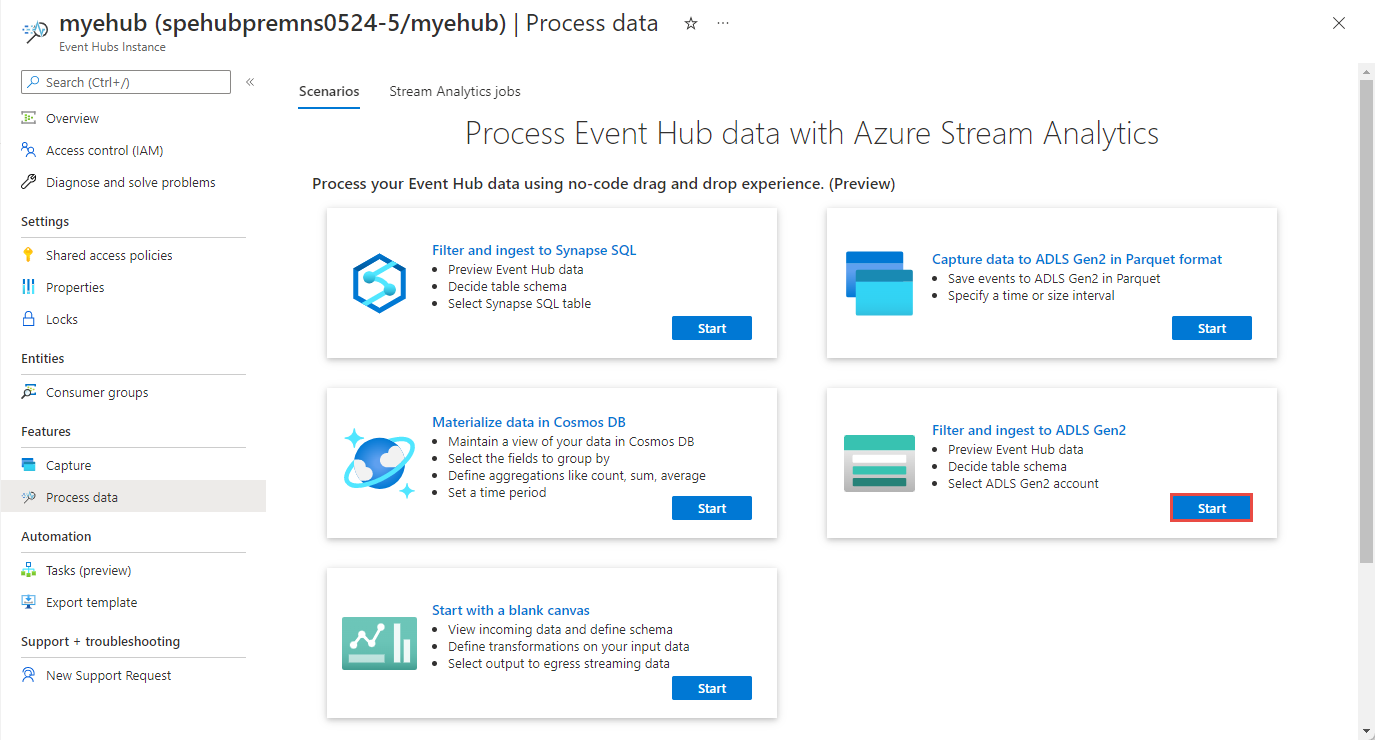

Pilih Fitur>Data Proses, lalu pilih Mulai pada kartu Filter dan serap ke ADLS Gen2.

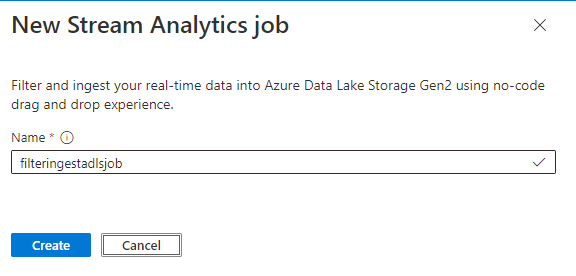

Masukkan nama untuk pekerjaan Azure Stream Analytics, lalu pilih Buat.

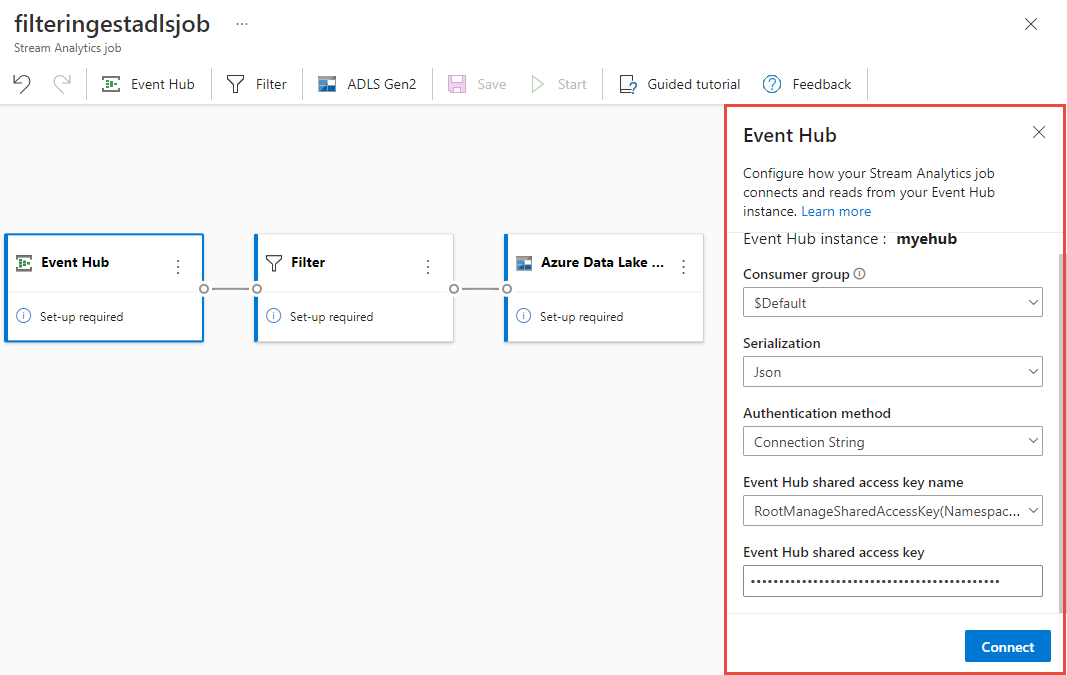

Tentukan Jenis serialisasi data Anda di jendela Azure Event Hubs dan Metode autentikasi yang akan digunakan pekerjaan untuk menyambungkan ke Azure Event Hubs. Kemudian pilih Sambungkan.

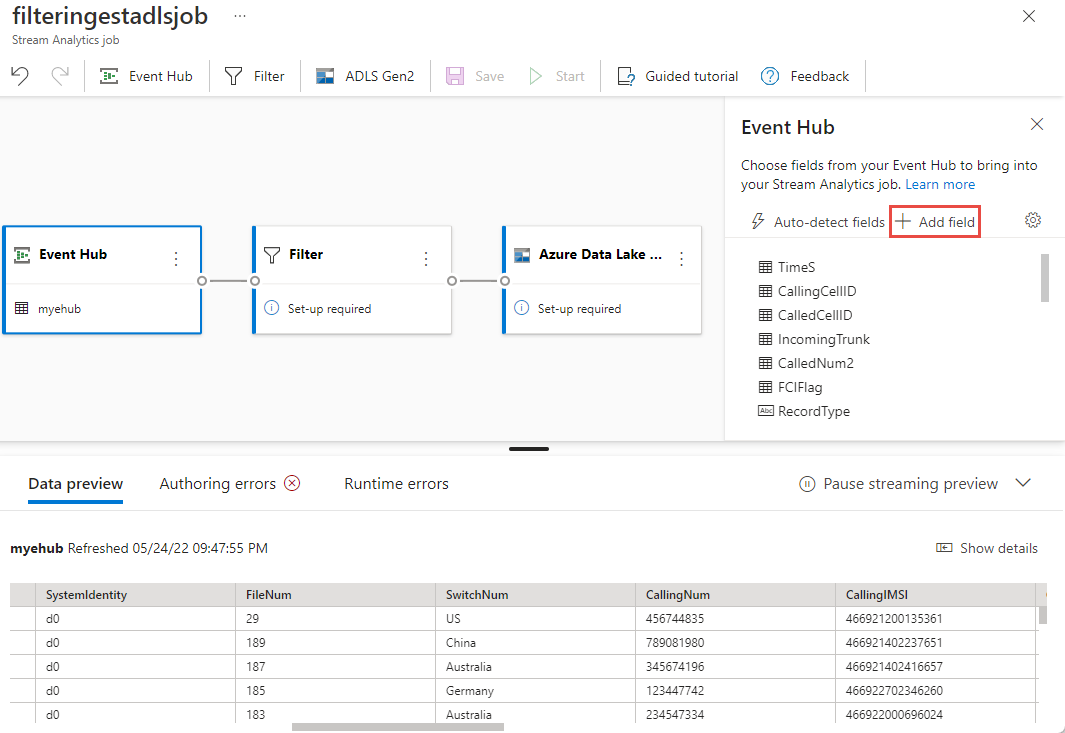

Jika koneksi berhasil dibuat dan Anda memiliki aliran data yang mengalir ke instans Azure Event Hubs, Anda akan segera melihat dua hal:

- Bidang yang ada dalam data input. Anda dapat memilih Tambahkan bidang atau pilih simbol tiga titik di samping bidang untuk menghapus, mengganti nama, atau mengubah jenisnya.

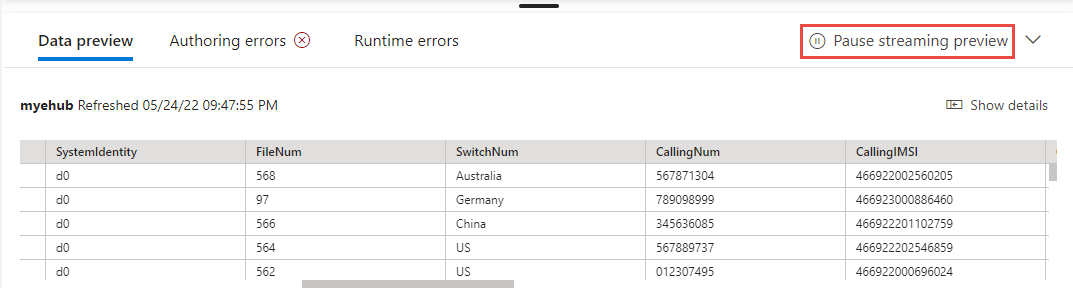

- Sampel langsung data masuk dalam tabel Pratinjau data di bawah tampilan diagram. Ini secara otomatis di-refresh secara berkala. Anda dapat memilih Jeda pratinjau streaming untuk melihat tampilan statis data masukan sampel.

- Bidang yang ada dalam data input. Anda dapat memilih Tambahkan bidang atau pilih simbol tiga titik di samping bidang untuk menghapus, mengganti nama, atau mengubah jenisnya.

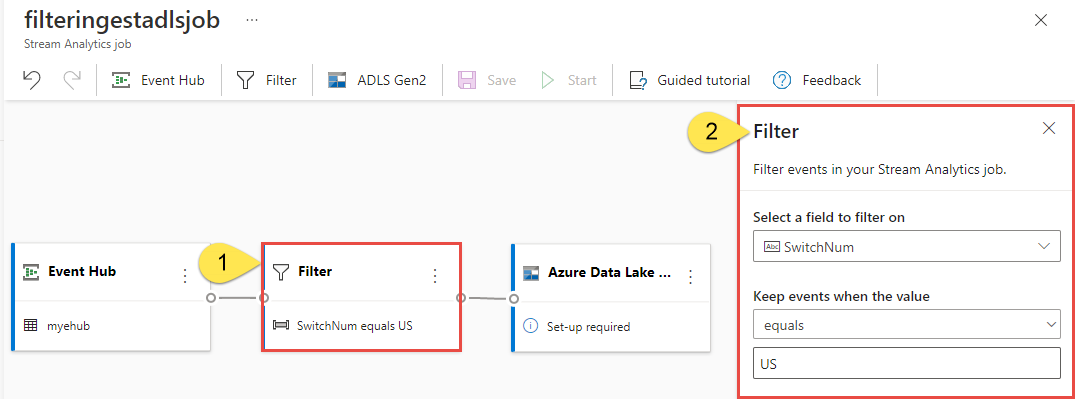

Pilih petak peta Filter. Di area Filter, pilih bidang untuk memfilter data masuk dengan kondisi.

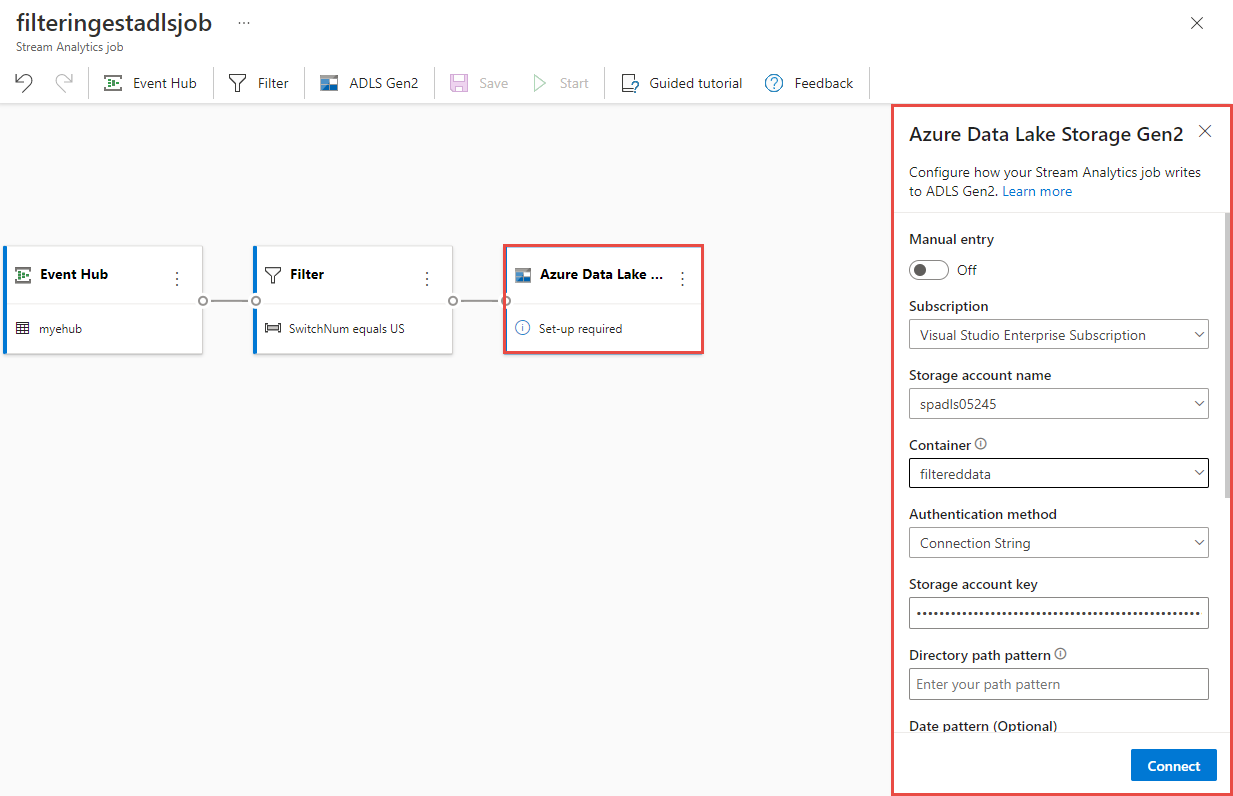

Pilih petak peta Azure Data Lake Storage Gen2. Pilih akun Azure Data Lake Gen2 untuk mengirim data yang difilter:

- Pilih langganan, nama akun penyimpanan, dan kontainer dari menu drop-down.

- Setelah langganan dipilih, metode autentikasi dan kunci akun penyimpanan harus diisi secara otomatis. Pilih Sambungkan.

Untuk informasi selengkapnya tentang bidang dan untuk melihat contoh pola jalur, lihat Penyimpanan blob dan output Azure Data Lake Gen2 dari Azure Stream Analytics.

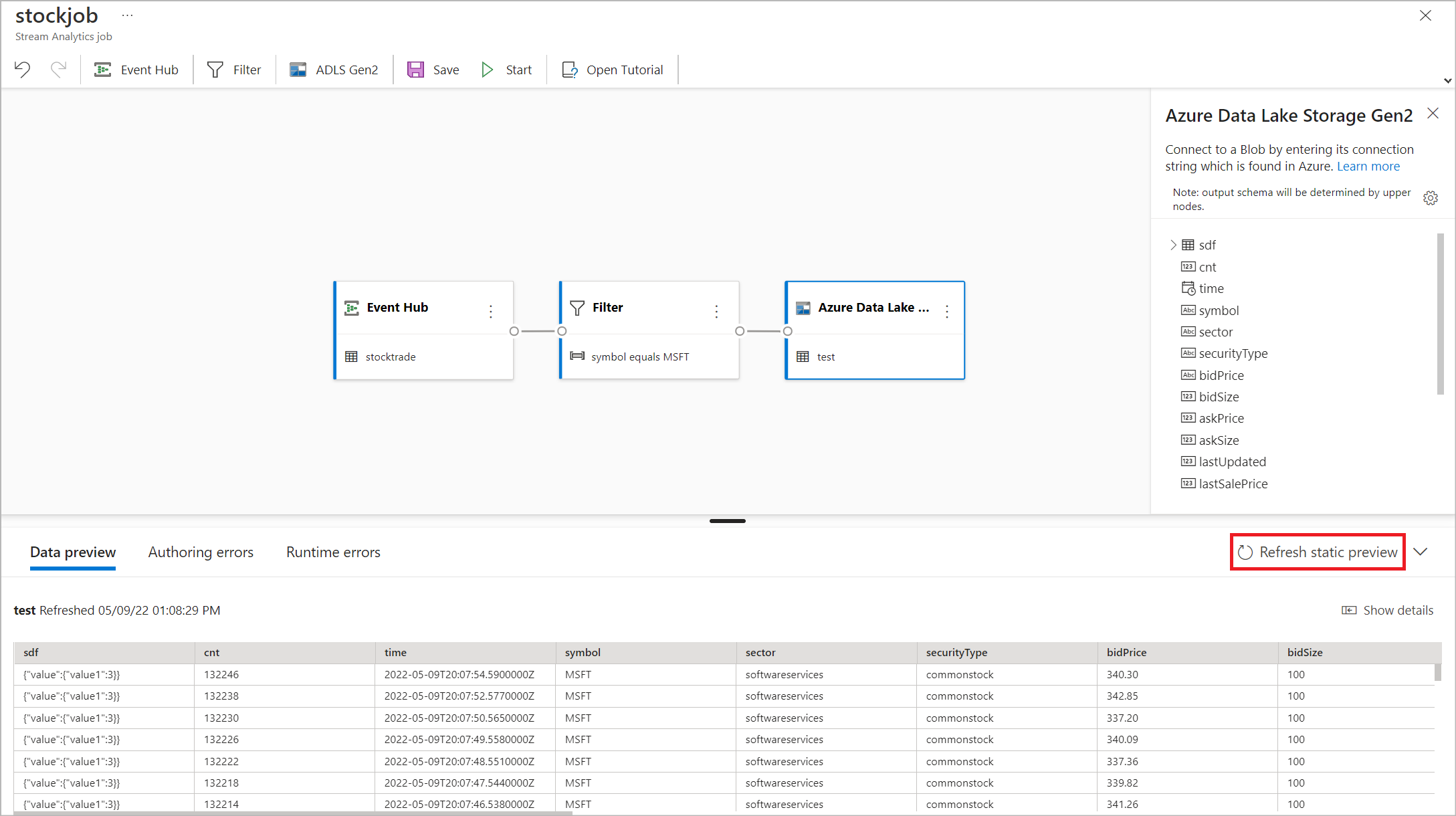

Secara opsional, pilih Dapatkan pratinjau statis/Refresh pratinjau statis untuk melihat pratinjau data yang akan diserap dari Azure Data Lake Storage Gen2.

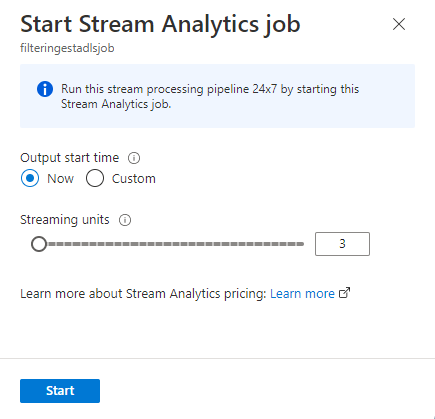

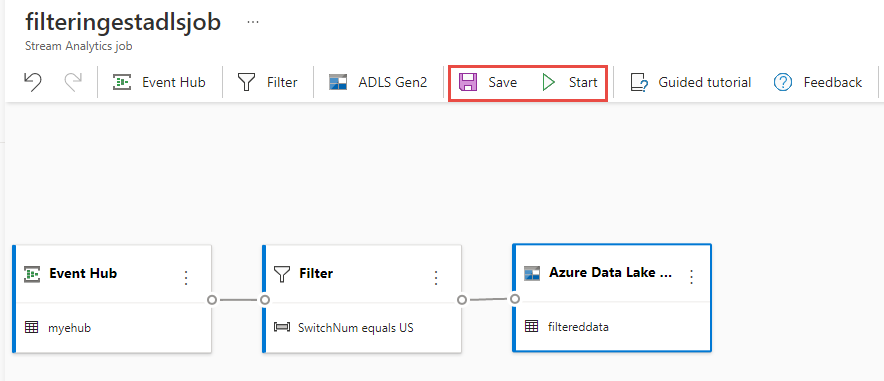

Pilih Simpan lalu pilih Mulai pekerjaan Azure Stream Analytics.

Untuk memulai pekerjaan, tentukan jumlah Unit Streaming (SU) yang dijalankan pekerjaan. SU mewakili jumlah komputasi dan memori yang dialokasikan untuk pekerjaan tersebut. Kami menyarankan agar Anda memulai dengan tiga dan kemudian menyesuaikan sesuai kebutuhan.

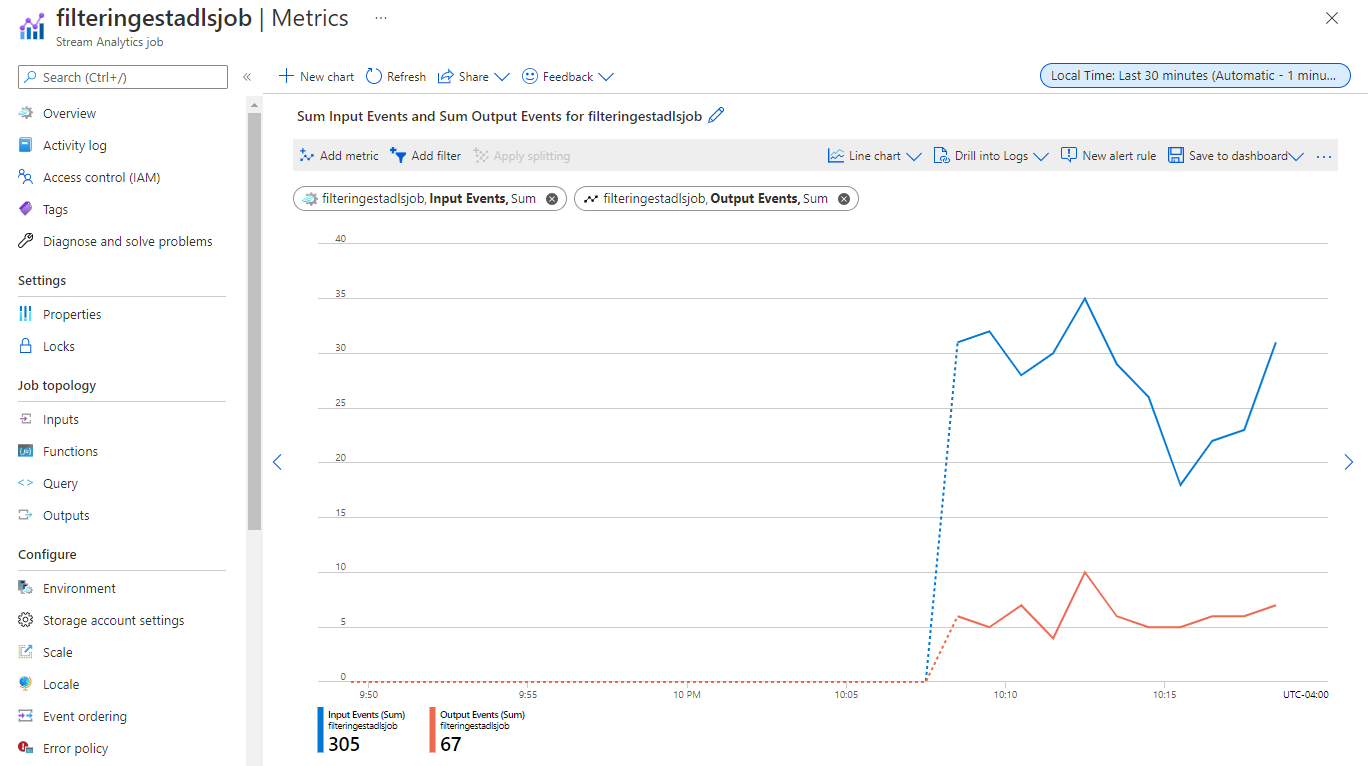

Setelah Anda memilih Mulai, pekerjaan mulai berjalan dalam dua menit dan metrik akan terbuka di bagian tab di bawah ini.

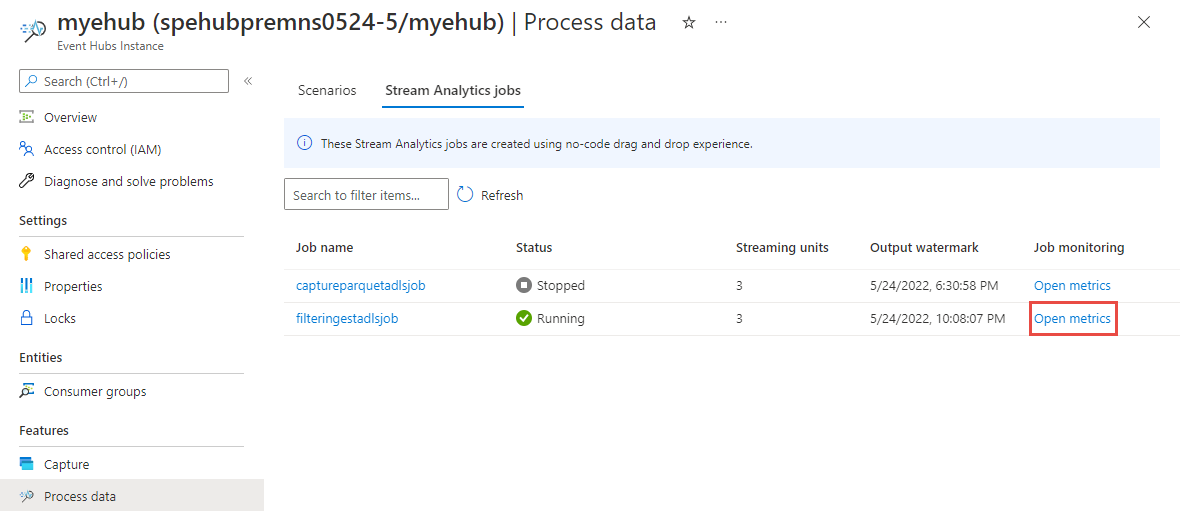

Anda dapat melihat pekerjaan pada bawah bagian Data Proses di tab pekerjaan Azure Stream Analytics. Pilih Refresh hingga Anda melihat status pekerjaan Berjalan. Pilih Buka metrik untuk memantaunya atau menghentikan dan memulai ulang, sesuai kebutuhan.

Berikut ini adalah contoh halaman Metrik:

Memverifikasi data pada Data Lake Storage

Anda akan melihat file yang dibuat pada kontainer yang Anda tentukan.

Unduh serta buka file untuk mengonfirmasi bahwa Anda hanya melihat data yang difilter. Dalam contoh berikut ini, Anda akan melihat data dengan SwitchNum diatur ke AS.

{"RecordType":"MO","SystemIdentity":"d0","FileNum":"548","SwitchNum":"US","CallingNum":"345697969","CallingIMSI":"466921402416657","CalledNum":"012332886","CalledIMSI":"466923101048691","DateS":"20220524","TimeType":0,"CallPeriod":0,"ServiceType":"S","Transfer":0,"OutgoingTrunk":"419","MSRN":"1416960750071","callrecTime":"2022-05-25T02:07:10Z","EventProcessedUtcTime":"2022-05-25T02:07:50.5478116Z","PartitionId":0,"EventEnqueuedUtcTime":"2022-05-25T02:07:09.5140000Z", "TimeS":null,"CallingCellID":null,"CalledCellID":null,"IncomingTrunk":null,"CalledNum2":null,"FCIFlag":null} {"RecordType":"MO","SystemIdentity":"d0","FileNum":"552","SwitchNum":"US","CallingNum":"012351287","CallingIMSI":"262021390056324","CalledNum":"012301973","CalledIMSI":"466922202613463","DateS":"20220524","TimeType":3,"CallPeriod":0,"ServiceType":"V","Transfer":0,"OutgoingTrunk":"442","MSRN":"886932428242","callrecTime":"2022-05-25T02:07:13Z","EventProcessedUtcTime":"2022-05-25T02:07:50.5478116Z","PartitionId":0,"EventEnqueuedUtcTime":"2022-05-25T02:07:12.7350000Z", "TimeS":null,"CallingCellID":null,"CalledCellID":null,"IncomingTrunk":null,"CalledNum2":null,"FCIFlag":null} {"RecordType":"MO","SystemIdentity":"d0","FileNum":"559","SwitchNum":"US","CallingNum":"456757102","CallingIMSI":"466920401237309","CalledNum":"345617823","CalledIMSI":"466923000886460","DateS":"20220524","TimeType":1,"CallPeriod":696,"ServiceType":"V","Transfer":1,"OutgoingTrunk":"419","MSRN":"886932429155","callrecTime":"2022-05-25T02:07:22Z","EventProcessedUtcTime":"2022-05-25T02:07:50.5478116Z","PartitionId":0,"EventEnqueuedUtcTime":"2022-05-25T02:07:21.9190000Z", "TimeS":null,"CallingCellID":null,"CalledCellID":null,"IncomingTrunk":null,"CalledNum2":null,"FCIFlag":null}

Pertimbangan saat menggunakan fitur Replikasi Geografis Azure Event Hubs

Azure Event Hubs baru-baru ini meluncurkan fitur Geo-Replikasi di pratinjau publik. Fitur ini berbeda dari fitur Pemulihan Bencana Geografis Azure Event Hubs.

Ketika jenis failover Dipaksa dan konsistensi replikasi asinkron, pekerjaan Azure Stream Analytics tidak menjamin output sekali ke output Azure Event Hubs.

Azure Stream Analytics, sebagai produsen dengan output pusat aktivitas, mungkin mengamati keterlambatan marka air pada pekerjaan selama durasi failover dan selama pembatasan oleh Azure Event Hubs jika lag replikasi antara primer dan sekunder mencapai lag maksimum yang dikonfigurasi.

Azure Stream Analytics, sebagai konsumen dengan Event Hubs sebagai Input, mungkin mengamati keterlambatan marka air pada pekerjaan selama durasi failover dan mungkin melewati data atau menemukan data duplikat setelah failover selesai.

Karena peringatan ini, kami sarankan Anda memulai ulang pekerjaan Azure Stream Analytics dengan waktu mulai yang sesuai tepat setelah failover Azure Event Hubs selesai. Selain itu, karena fitur Replikasi Geografis Azure Event Hubs ada di pratinjau publik, kami tidak menyarankan penggunaan pola ini untuk pekerjaan Azure Stream Analytics produksi pada saat ini. Perilaku Azure Stream Analytics saat ini akan meningkat sebelum fitur Replikasi Geografis Azure Event Hubs tersedia secara umum dan dapat digunakan dalam pekerjaan produksi Azure Stream Analytics.

Langkah berikutnya

Pelajari selengkapnya tentang Azure Stream Analytics dan cara memantau pekerjaan yang telah Anda buat.