Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

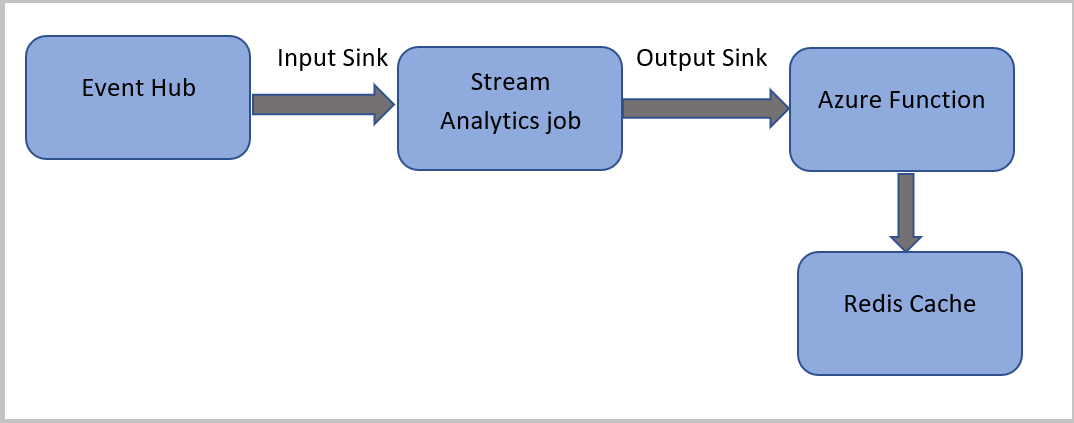

Dalam tutorial ini, Anda membuat pekerjaan Azure Stream Analytics yang membaca peristiwa dari Azure Event Hubs, menjalankan kueri pada data peristiwa, lalu memanggil fungsi Azure, yang menulis ke instans Azure Cache for Redis.

Catatan

- Anda dapat menjalankan Azure Functions dari Azure Stream Analytics dengan mengonfigurasi Functions sebagai salah satu sink (output) ke pekerjaan Azure Stream Analytics. Functions adalah pengalaman komputasi sesuai permintaan berbasis peristiwa yang memungkinkan Anda menerapkan kode yang dipicu oleh peristiwa yang terjadi di Azure atau layanan pihak ketiga. Kemampuan Functions dalam merespons pemicu ini menjadikannya output alami untuk tugas Azure Stream Analytics.

- Azure Stream Analytics menggunakan Functions melalui pemicu HTTP. Adapter output Functions memungkinkan pengguna menghubungkan Functions ke Azure Stream Analytics, sehingga peristiwa dapat dipicu berdasarkan kueri Azure Stream Analytics.

- Koneksi ke Azure Functions di dalam jaringan virtual (VNet) dari tugas Azure Stream Analytics yang berjalan di kluster multi-penyewa tidak didukung.

Dalam tutorial ini, Anda akan mempelajari cara:

- Membuat instans Azure Event Hubs

- Membuat instans Azure Cache for Redis

- Buat Fungsi Azure

- Membuat pekerjaan Azure Stream Analytics

- Mengonfigurasi event hub sebagai input dan fungsi sebagai output

- Menjalankan pekerjaan Analisis Aliran

- Memeriksa hasil Azure Cache for Redis

Jika Anda tidak memiliki langganan Azure, buat akun gratis sebelum memulai.

Prasyarat

Sebelum memulai, pastikan Anda telah menyelesaikan langkah-langkah berikut:

- Jika Anda tidak memiliki langganan Azure, buat akun gratis.

- Unduh aplikasi generator peristiwa panggilan telepon, TelcoGenerator.zip dari Microsoft Download Center atau dapatkan kode sumber dari GitHub.

Masuk ke Azure

Masuk ke portal Azure.

Membuat pusat aktivitas

Anda perlu mengirim beberapa data sampel ke pusat aktivitas sebelum Azure Stream Analytics dapat menganalisis aliran data panggilan penipuan. Dalam tutorial ini, Anda mengirim data ke Azure dengan menggunakan Azure Event Hubs.

Gunakan langkah berikut untuk membuat pusat aktivitas dan mengirim data panggilan ke pusat aktivitas tersebut:

Masuk ke portal Azure.

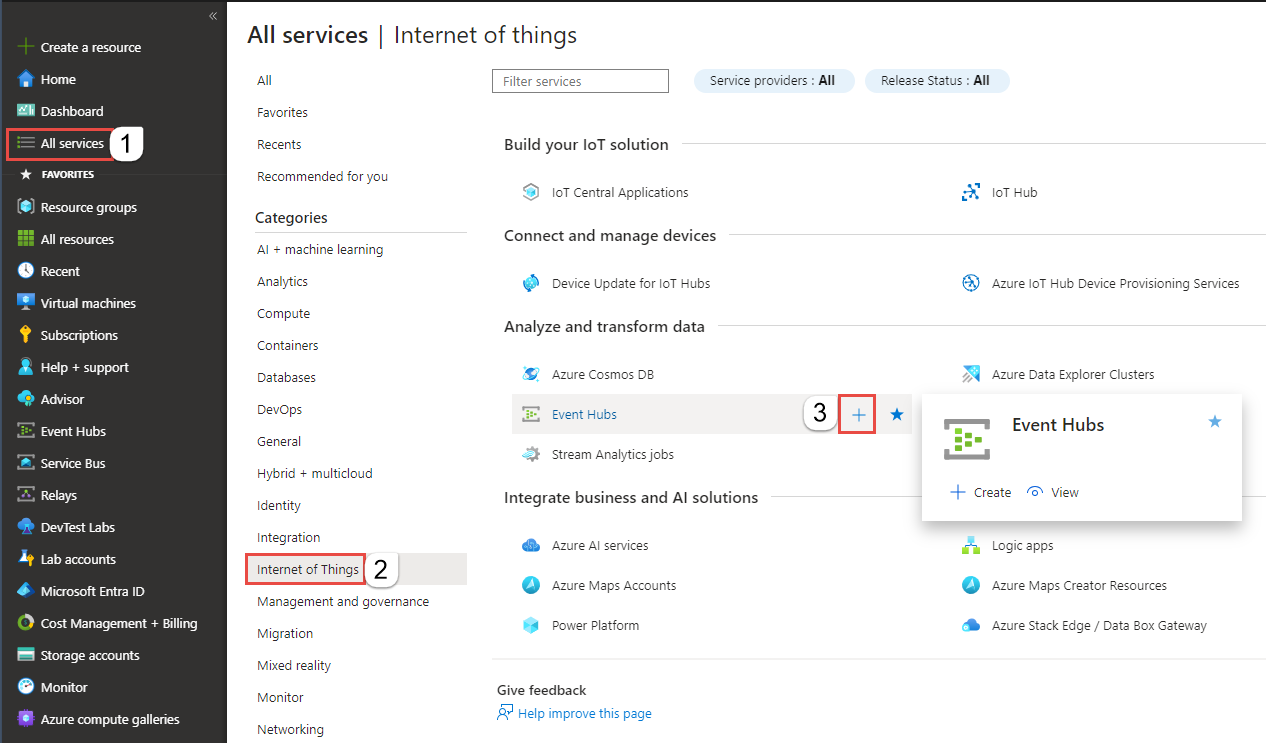

Pilih Semua layanan di menu sebelah kiri, pilih Internet of things, arahkan mouse ke Azure Event Hubs, lalu pilih tombol + (Tambahkan).

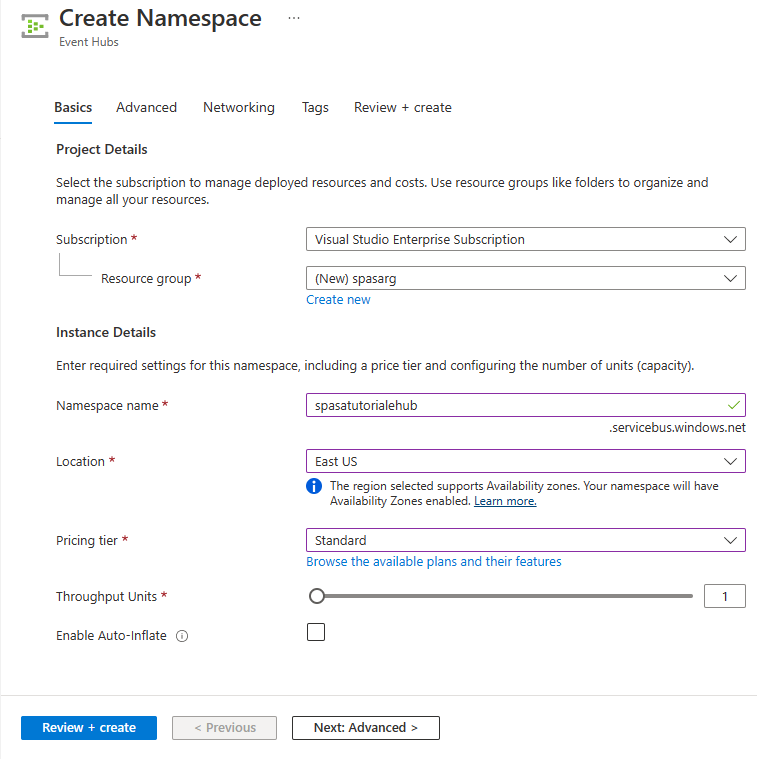

Pada halaman Buat Namespace , ikuti langkah-langkah berikut ini:

Pilih langganan Azure tempat Anda ingin membuat pusat aktivitas.

Untuk Grup sumber daya, pilih Buat baru dan masukkan nama untuk grup sumber daya. Namespace layanan Azure Event Hubs dibuat dalam grup sumber daya ini.

Untuk nama Namespace, masukkan nama unik untuk namespace Layanan Pusat Aktivitas.

Untuk Lokasi, pilih wilayah tempat Anda ingin membuat namespace layanan.

Untuk Tingkat harga, pilih Standar.

Pilih Tinjau + buat di bagian bawah halaman.

Pada halaman Tinjau + buat wizard pembuatan namespace, pilih Buat di bagian bawah halaman setelah meninjau semua pengaturan.

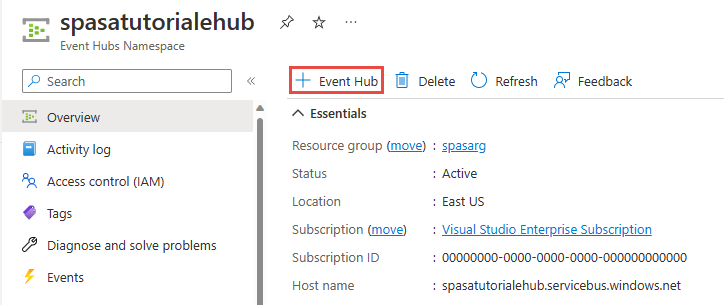

Setelah namespace layanan berhasil disebarkan, pilih Buka sumber daya untuk menavigasi ke halaman Event Hubs Namespace.

Pada halaman Event Hubs Namespace, pilih +Azure Event Hub di bilah perintah.

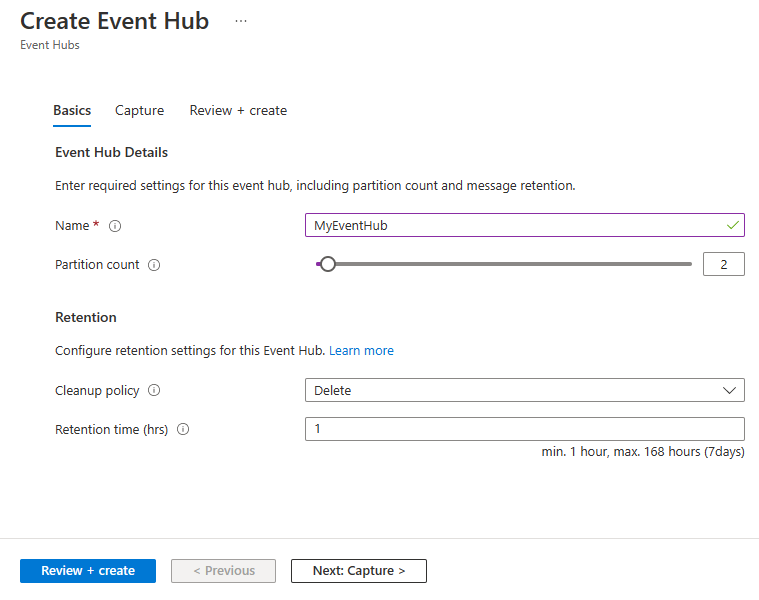

Pada halaman Buat Azure Event Hub, masukkan Nama untuk pusat aktivitas. Atur Jumlah Partisi ke 2. Gunakan opsi default di pengaturan yang tersisa dan pilih Tinjau + buat.

Pada halaman Tinjau + buat, pilih Buat di bagian bawah halaman. Kemudian tunggu penyebaran berhasil.

Berikan akses ke event hub dan dapatkan string koneksi

Sebelum aplikasi dapat mengirim data ke Azure Event Hubs, event hub harus memiliki kebijakan yang mengizinkan akses. Kebijakan akses menghasilkan string koneksi yang menyertakan informasi otorisasi.

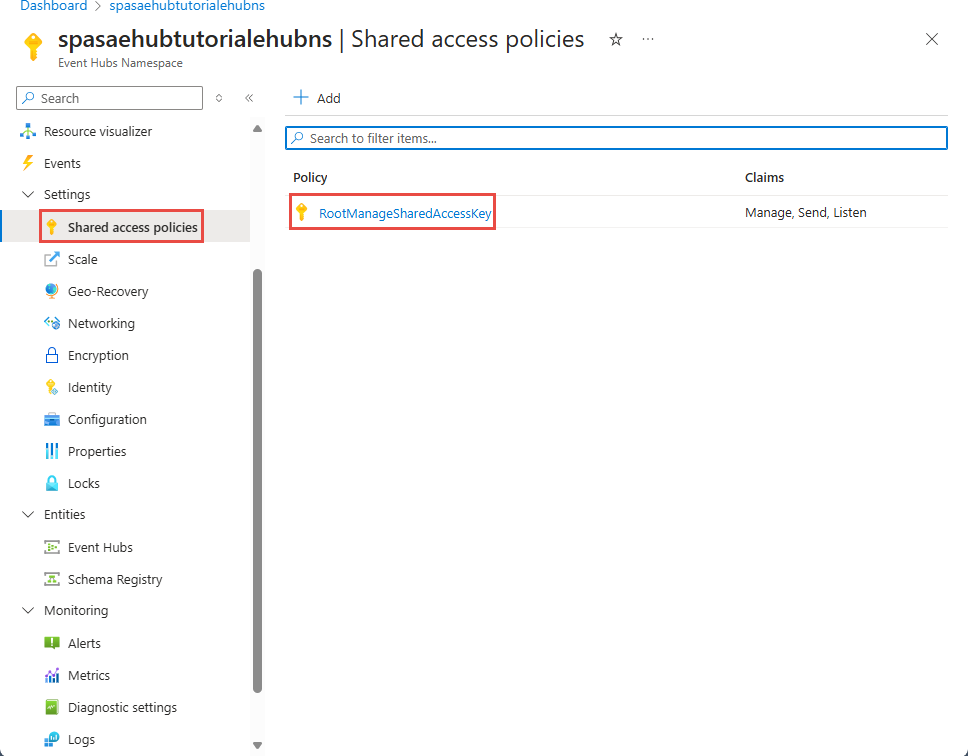

Pada halaman Namespace Layanan Pusat Aktivitas, pilih Kebijakan akses bersama di menu sebelah kiri.

Pilih RootManageSharedAccessKey dari daftar kebijakan.

Kemudian, pilih tombol salin di samping String koneksi - kunci utama.

Tempelkan string koneksi ke editor teks. Anda memerlukan string koneksi ini di bagian berikutnya.

String koneksi terlihat sebagai berikut:

Endpoint=sb://<Your event hub namespace>.servicebus.windows.net/;SharedAccessKeyName=<Your shared access policy name>;SharedAccessKey=<generated key>Perhatikan bahwa string koneksi berisi beberapa pasangan kunci-nilai yang dipisahkan dengan titik koma: Titik Akhir, SharedAccessKeyName, dan SharedAccessKey.

Mulai aplikasi generator peristiwa

Sebelum memulai aplikasi TelcoGenerator, Anda harus mengonfigurasinya untuk mengirim data ke Azure Event Hubs yang Anda buat sebelumnya.

Ekstrak isi file TelcoGenerator.zip ini.

Buka file

TelcoGenerator\TelcoGenerator\telcodatagen.exe.configdi editor teks pilihan Anda. Ada lebih dari satu file.config, jadi pastikan Anda membuka yang benar.Perbarui elemen

<appSettings>dalam file konfigurasi dengan detail berikut:- Atur nilai kunci EventHubName ke nilai EntityPath di akhir string koneksi.

- Atur nilai kunci Microsoft.ServiceBus.ConnectionString ke string koneksi ke namespace. Jika Anda menggunakan string koneksi ke pusat aktivitas, bukan namespace layanan, hapus

EntityPathnilai (;EntityPath=myeventhub) di akhir. Jangan lupa untuk menghapus titik koma yang mendahului nilai EntityPath.

Simpan file.

Selanjutnya buka jendela perintah dan ubah ke folder tempat Anda membuka mengekstrak file aplikasi TelcoGenerator. Masukkan perintah berikut:

.\telcodatagen.exe 1000 0.2 2Perintah ini mengambil parameter berikut:

- Jumlah catatan data panggilan per jam.

- Persentase probabilitas penipuan, yaitu seberapa sering aplikasi harus mensimulasikan panggilan penipuan. Nilai 0,2 berarti bahwa sekitar 20% dari rekaman panggilan terlihat curang.

- Durasi dalam jam, yaitu jumlah jam aplikasi harus berjalan. Anda juga dapat menghentikan aplikasi kapan saja dengan mengakhiri proses (Ctrl+C) di baris perintah.

Setelah beberapa detik, aplikasi mulai menampilkan catatan panggilan telepon di layar saat aplikasi mengirimkannya ke event hub. Data panggilan telepon berisi bidang berikut ini:

Rekaman Definisi CallrecTime Tanda waktu untuk waktu mulai panggilan. SwitchNum Pengalih telepon yang digunakan untuk menyambungkan panggilan. Untuk contoh ini, pengalih adalah string yang mewakili negara/wilayah asal (AS, Tiongkok, Inggris, Jerman, atau Australia). CallingNum Nomor telepon penelepon. CallingIMSI Identitas Pelanggan Seluler Internasional (IMSI). Ini adalah pengidentifikasi unik penelepon. CalledNum Nomor telepon penerima panggilan. CalledIMSI Identitas Pelanggan Seluler Internasional (IMSI). Ini adalah pengidentifikasi unik penerima panggilan.

Membuat pekerjaan Azure Stream Analytics

Setelah memiliki streaming peristiwa panggilan, Anda dapat membuat pekerjaan Azure Stream Analytics yang membaca data dari event hub.

- Untuk membuat pekerjaan Stream Analytics, buka portal Azure.

- Pilih Buat sumber daya dan cari pekerjaan Azure Stream Analytics. Pilih petak pekerjaan Azure Stream Analytics dan pilih Buat.

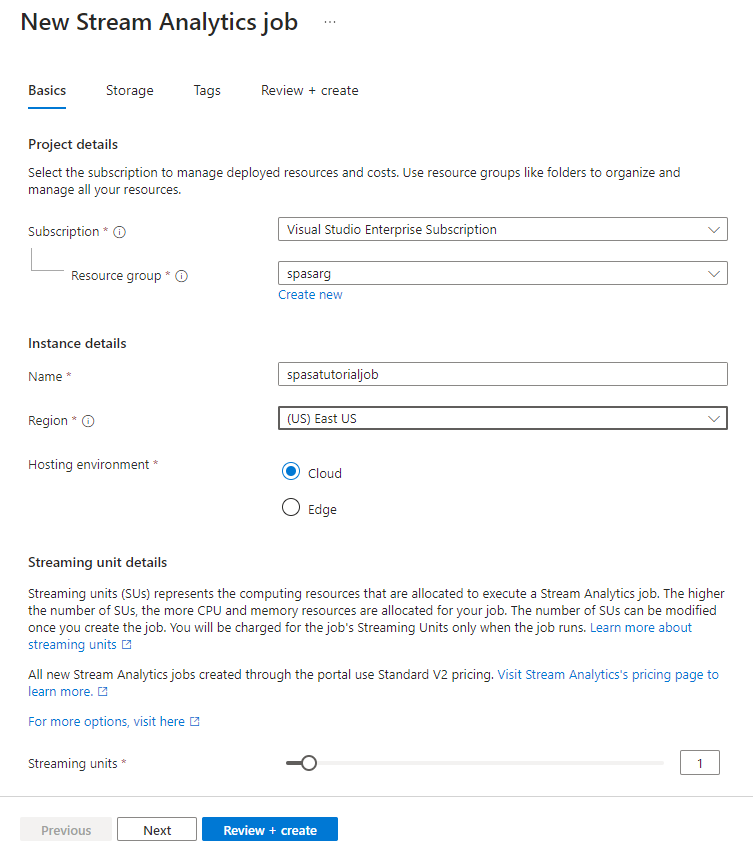

- Pada halaman pekerjaan Analisis Aliran Baru, ikuti langkah-langkah berikut:

Untuk Langganan, pilih langganan yang berisi namespace layanan Azure Event Hubs.

Untuk Grup sumber daya, pilih grup sumber daya yang Anda buat sebelumnya.

Di bagian Detail instans, Untuk Nama, masukkan nama unik untuk pekerjaan Azure Stream Analytics.

Untuk Wilayah, pilih wilayah tempat Anda ingin membuat pekerjaan Azure Stream Analytics. Kami menyarankan agar Anda menempatkan pekerjaan dan pusat aktivitas di wilayah yang sama untuk performa terbaik dan agar Anda tidak membayar untuk mentransfer data antar wilayah.

Untuk Lingkungan hosting< pilih Cloud jika belum dipilih. Pekerjaan Azure Stream Analytics dapat disebarkan ke cloud atau edge. Cloud memungkinkan Anda untuk menyebarkan ke Azure Cloud, dan Edge memungkinkan Anda untuk menyebarkan ke perangkat IoT Edge.

Untuk Unit streaming, pilih 1. Unit streaming mewakili sumber daya komputasi yang diperlukan untuk menjalankan pekerjaan. Secara default, nilai ini diatur ke 1. Untuk mempelajari tentang penskalaan unit streaming, lihat artikel memahami dan menyesuaikan unit streaming.

Pilih Tinjau + buat di bagian bawah halaman.

- Pada halaman Tinjau + buat , tinjau pengaturan, lalu pilih Buat untuk membuat pekerjaan Azure Stream Analytics.

- Setelah pekerjaan disebarkan, pilih Buka sumber daya untuk menavigasi ke halaman pekerjaan Azure Stream Analytics.

Mengonfigurasi input pekerjaan

Langkah selanjutnya adalah menentukan sumber input untuk pekerjaan membaca data menggunakan event hub yang Anda buat di bagian sebelumnya.

Pada halaman pekerjaan Azure Stream Analytics, di bagian Topologi Pekerjaan di menu sebelah kiri, pilih Input.

Pada halaman Input , pilih + Tambahkan input dan Event hub.

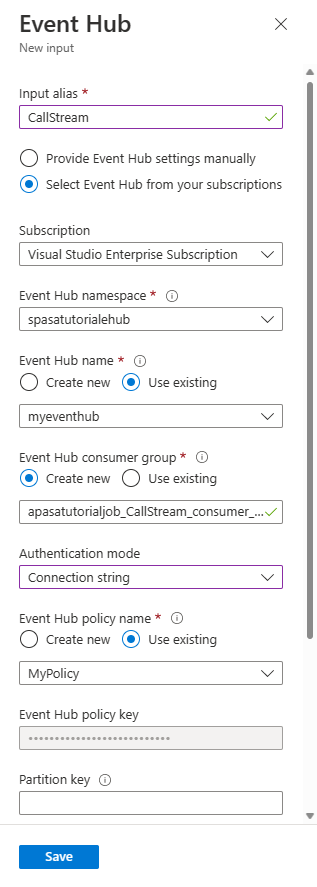

Pada halaman Pusat aktivitas , ikuti langkah-langkah berikut:

Untuk Alias input, masukkan CallStream. Alias input adalah nama yang mudah diingat untuk mengidentifikasi input Anda. Alias input hanya dapat berisi karakter alfanumerik dan tanda hubung, dan panjangnya harus 3-63 karakter.

Untuk Langganan, pilih langganan Azure tempat Anda membuat hub peristiwa. Event hub dapat berada di langganan yang sama atau yang berbeda dengan pekerjaan Azure Stream Analytics.

Untuk namespace layanan Azure Event Hubs, pilih namespace layanan Azure Event Hubs yang Anda buat di bagian sebelumnya. Semua namespace yang tersedia di langganan Anda saat ini tercantum di menu dropdown.

Untuk Nama hub peristiwa, pilih pusat aktivitas yang Anda buat di bagian sebelumnya. Semua hub peristiwa yang tersedia di namespace yang dipilih tercantum di menu dropdown.

Untuk Grup konsumen pusat aktivitas, pertahankan opsi Buat baru yang dipilih sehingga grup konsumen baru dibuat di hub peristiwa. Kami sarankan Anda menggunakan grup konsumen yang berbeda untuk setiap pekerjaan Azure Stream Analytics. Jika tidak ada grup konsumen yang ditentukan, pekerjaan Azure Stream Analytics

$Defaultmenggunakan grup konsumen. Saat pekerjaan memuat swa-gabung atau memiliki beberapa input, beberapa input mungkin dibaca oleh lebih dari satu pembaca. Situasi ini berdampak pada jumlah pembaca dalam satu grup konsumen.Untuk Mode autentikasi, pilih String koneksi. Lebih mudah untuk menguji tutorial dengan opsi ini.

Untuk Nama kebijakan pusat aktivitas, pilih Gunakan yang sudah ada, lalu pilih kebijakan yang Anda buat sebelumnya.

Pilih Simpan di bagian bawah halaman.

Membuat instans Azure Cache for Redis

Buat cache di Azure Cache for Redis dengan menggunakan langkah-langkah yang dijelaskan dalam Membuat instans Azure Cache for Redis.

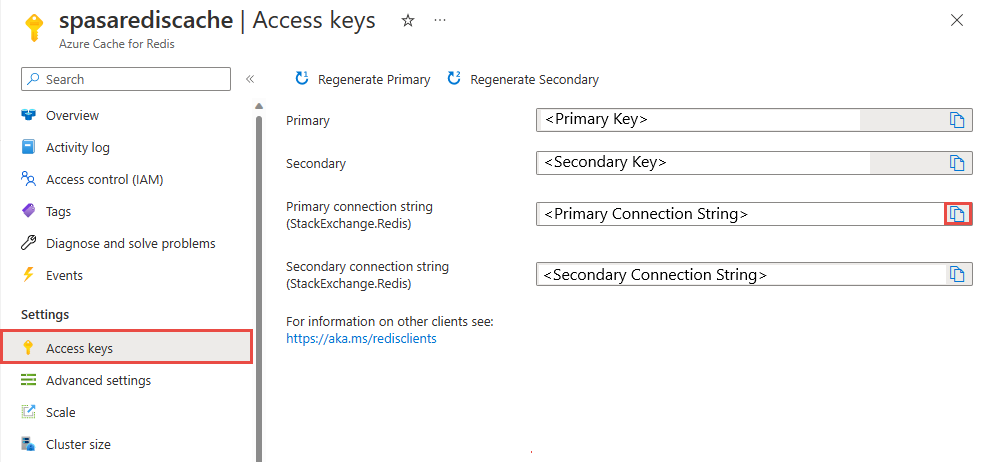

Setelah Anda membuat singgahan, di bagian Pengaturan, pilih Kunci Akses. Catat String koneksi primer.

Membuat fungsi di Azure Functions yang dapat menulis data ke Azure Cache for Redis

Lihat bagian Membuat aplikasi fungsi di dokumentasi Functions. Sampel ini dibangun di:

Buat aplikasi fungsi HttpTrigger default di Visual Studio Code dengan mengikuti tutorial ini. Informasi berikut digunakan: bahasa:

C#, runtime:.NET 6(di bawah fungsi v4), templat:HTTP trigger.Instal pustaka klien Redis dengan menjalankan perintah berikut di terminal yang terletak di folder proyek:

dotnet add package StackExchange.Redis --version 2.2.88Tambahkan item

RedisConnectionStringdanRedisDatabaseIndexdi bagianValuesdarilocal.settings.jsonAnda, dengan mengisi string koneksi dari server tujuan:{ "IsEncrypted": false, "Values": { "AzureWebJobsStorage": "", "FUNCTIONS_WORKER_RUNTIME": "dotnet", "RedisConnectionString": "Your Redis Connection String", "RedisDatabaseIndex":"0" } }Redis Database Index adalah angka dari 0 hingga 15 yang mengidentifikasi database pada instans.

Ganti seluruh fungsi (file .cs dalam proyek) dengan cuplikan kode berikut. Perbarui namespace layanan, nama kelas, dan nama fungsi Anda sendiri:

using System; using System.IO; using System.Threading.Tasks; using Microsoft.AspNetCore.Mvc; using Microsoft.Azure.WebJobs; using Microsoft.Azure.WebJobs.Extensions.Http; using Microsoft.AspNetCore.Http; using Microsoft.Extensions.Logging; using Newtonsoft.Json; using StackExchange.Redis; namespace Company.Function { public static class HttpTrigger1{ [FunctionName("HttpTrigger1")] public static async Task<IActionResult> Run( [HttpTrigger(AuthorizationLevel.Function, "get","post", Route = null)] HttpRequest req, ILogger log) { // Extract the body from the request string requestBody = await new StreamReader(req.Body).ReadToEndAsync(); if (string.IsNullOrEmpty(requestBody)) {return new StatusCodeResult(204);} // 204, ASA connectivity check dynamic data = JsonConvert.DeserializeObject(requestBody); // Reject if too large, as per the doc if (data.ToString().Length > 262144) {return new StatusCodeResult(413);} //HttpStatusCode.RequestEntityTooLarge string RedisConnectionString = Environment.GetEnvironmentVariable("RedisConnectionString"); int RedisDatabaseIndex = int.Parse(Environment.GetEnvironmentVariable("RedisDatabaseIndex")); using (var connection = ConnectionMultiplexer.Connect(RedisConnectionString)) { // Connection refers to a property that returns a ConnectionMultiplexer IDatabase db = connection.GetDatabase(RedisDatabaseIndex); // Parse items and send to binding for (var i = 0; i < data.Count; i++) { string key = data[i].Time + " - " + data[i].CallingNum1; db.StringSet(key, data[i].ToString()); log.LogInformation($"Object put in database. Key is {key} and value is {data[i].ToString()}"); // Simple get of data types from the cache string value = db.StringGet(key); log.LogInformation($"Database got: {key} => {value}"); } } return new OkResult(); // 200 } } }Saat Azure Stream Analytics menerima pengecualian "Entitas Permintaan HTTP Terlalu Besar" dari fungsi, ini mengurangi ukuran kumpulan yang dikirim ke fungsi. Kode berikut memastikan bahwa Azure Stream Analytics tidak mengirimkan batch yang terlalu besar. Pastikan bahwa nilai jumlah dan ukuran batch maksimum yang digunakan dalam fungsi konsisten dengan nilai yang dimasukkan di portal Azure Stream Analytics.

Fungsi tersebut sekarang dapat diterbitkan ke Azure.

Buka fungsi pada portal Azure, dan atur pengaturan aplikasi untuk

RedisConnectionStringdanRedisDatabaseIndex.

Memperbarui tugas Azure Stream Analytics dengan fungsi sebagai output

Buka tugas Azure Stream Analytics di portal Azure.

Telusuri ke fungsi Anda, dan pilih Ringkasan>Output>Tambahkan. Untuk menambahkan output baru, pilih Fungsi Azure untuk opsi sink. Adapter output Functions memiliki properti berikut:

Nama properti Deskripsi Alias output Nama yang mudah diingat yang Anda gunakan dalam kueri tugas untuk mereferensikan output. Opsi impor Anda dapat menggunakan fungsi dari langganan saat ini, atau menyediakan pengaturan secara manual jika fungsi tersebut ada di langganan lain. Aplikasi Fungsi Nama aplikasi Functions. Fungsi Nama fungsi di aplikasi Functions Anda (nama fungsi run.csx Anda). Ukuran Batch Maksimum Mengatur ukuran maksimum setiap batch output, yang dikirim ke fungsi dalam byte. Secara default, nilai ini diatur ke 262.144 byte (256 KB). Jumlah Batch Maksimum Menentukan jumlah maksimum peristiwa di setiap batch yang dikirim ke fungsi. Nilai default adalah 100. Properti ini bersifat opsional. Tombol Memungkinkan Anda menggunakan fungsi dari langganan lain. Masukkan nilai kunci untuk mengakses fungsi Anda. Properti ini bersifat opsional. Masukkan nama alias output. Dalam tutorial ini, ini diberi nama saop1, tetapi Anda dapat menggunakan nama apa pun pilihan Anda. Isi detail lainnya.

Buka tugas Azure Stream Analytics Anda, lalu perbarui kueri ke berikut ini.

Penting

Contoh skrip berikut mengasumsikan bahwa Anda menggunakan CallStream untuk nama input dan saop1 untuk nama output. Jika Anda menggunakan nama yang berbeda, JANGAN lupa untuk memperbarui kueri.

SELECT System.Timestamp as Time, CS1.CallingIMSI, CS1.CallingNum as CallingNum1, CS2.CallingNum as CallingNum2, CS1.SwitchNum as Switch1, CS2.SwitchNum as Switch2 INTO saop1 FROM CallStream CS1 TIMESTAMP BY CallRecTime JOIN CallStream CS2 TIMESTAMP BY CallRecTime ON CS1.CallingIMSI = CS2.CallingIMSI AND DATEDIFF(ss, CS1, CS2) BETWEEN 1 AND 5 WHERE CS1.SwitchNum != CS2.SwitchNumMulai aplikasi telcodatagen.exe dengan menjalankan perintah berikut ini di baris perintah. Perintah ini menggunakan format

telcodatagen.exe [#NumCDRsPerHour] [SIM Card Fraud Probability] [#DurationHours].telcodatagen.exe 1000 0.2 2Mulai tugas Azure Stream Analytics.

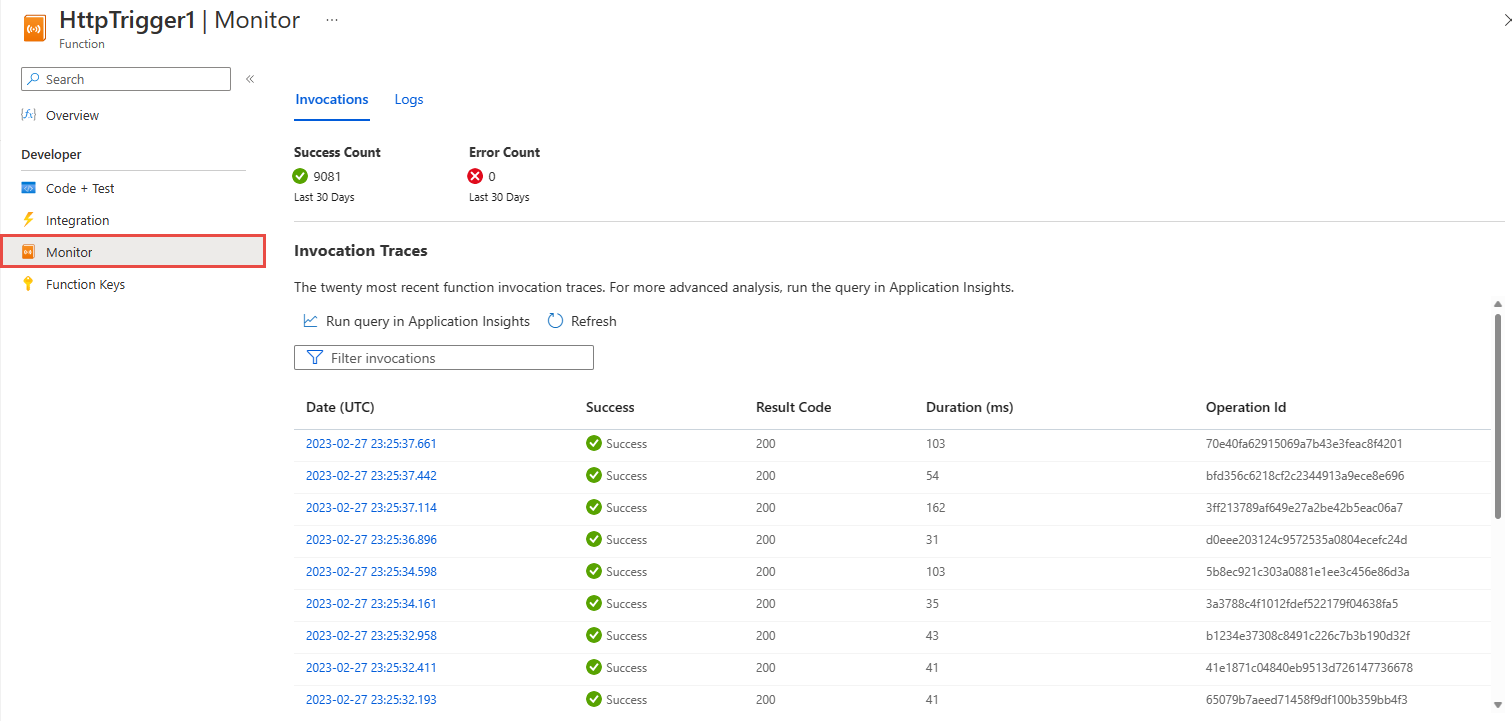

Pada halaman Monitor untuk fungsi Azure Anda, Anda melihat bahwa fungsi dipanggil.

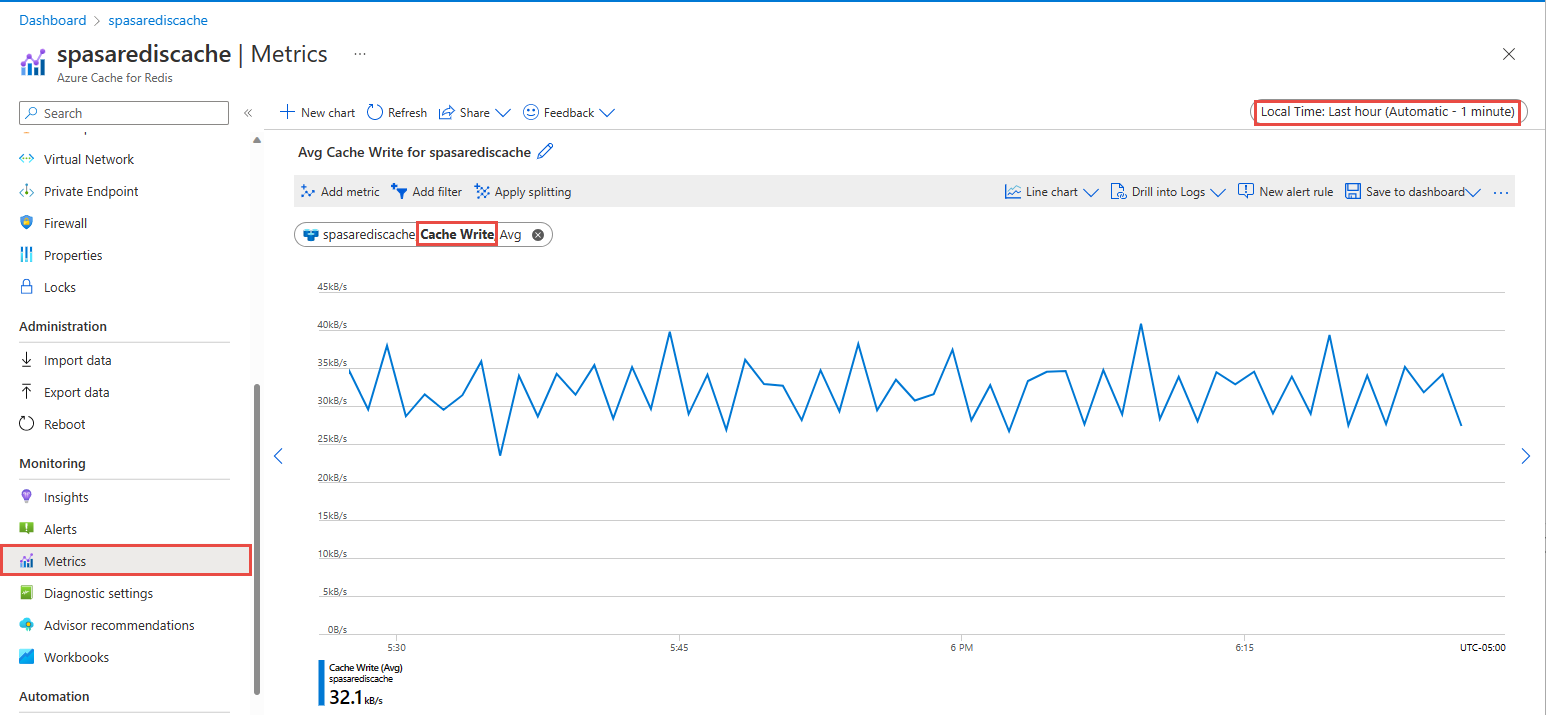

Pada halaman Azure Cache for Redis cache Anda, pilih Metrik di menu sebelah kiri, tambahkan metrik Cache Write, dan atur durasi ke jam terakhir. Anda melihat bagan yang mirip dengan gambar berikut.

Memeriksa hasil Azure Cache for Redis

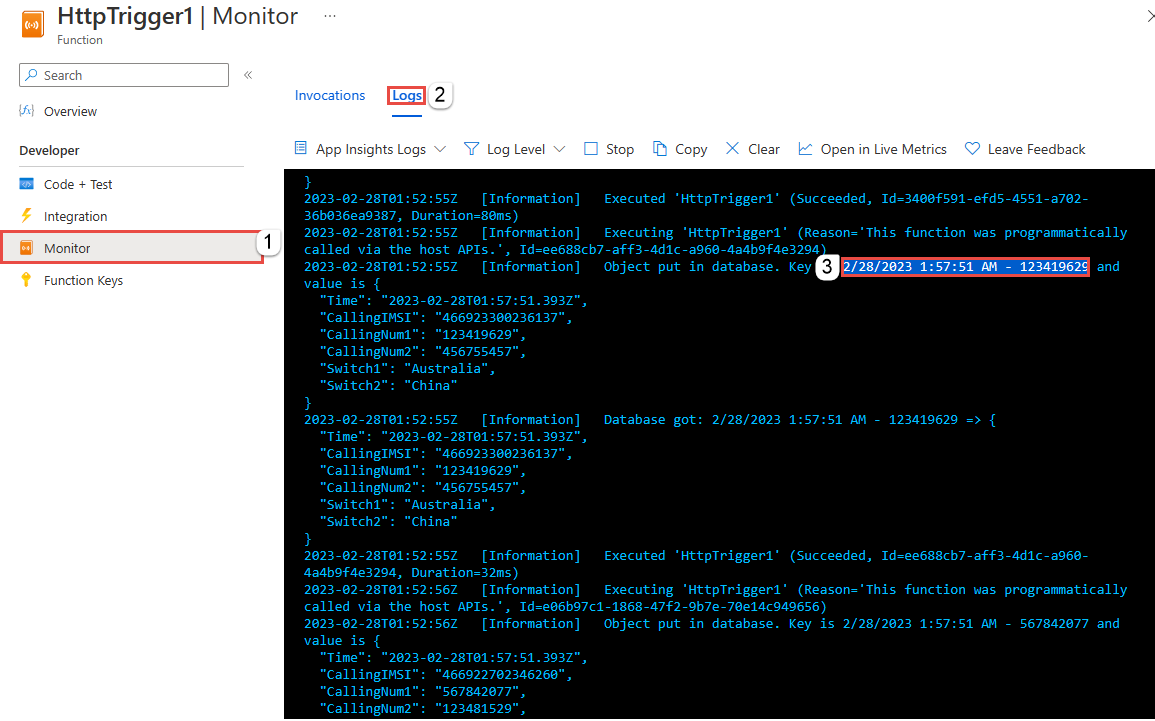

Mendapatkan kunci dari log Azure Functions

Pertama, dapatkan kunci untuk rekaman yang disisipkan ke Azure Cache for Redis. Dalam kode, kunci dihitung dalam fungsi Azure seperti yang ditunjukkan dalam cuplikan kode berikut:

string key = data[i].Time + " - " + data[i].CallingNum1;

db.StringSet(key, data[i].ToString());

log.LogInformation($"Object put in database. Key is {key} and value is {data[i].ToString()}");

Telusuri ke portal Azure, dan temukan aplikasi Azure Functions Anda.

Pilih Functions di menu sebelah kiri.

Pilih HTTPTrigger1 dari daftar fungsi.

Pilih Pantau di menu sebelah kiri.

Beralih ke tab Log .

Catat kunci dari pesan informasi seperti yang ditunjukkan pada cuplikan layar berikut. Anda menggunakan kunci ini untuk menemukan nilai di Azure Cache for Redis.

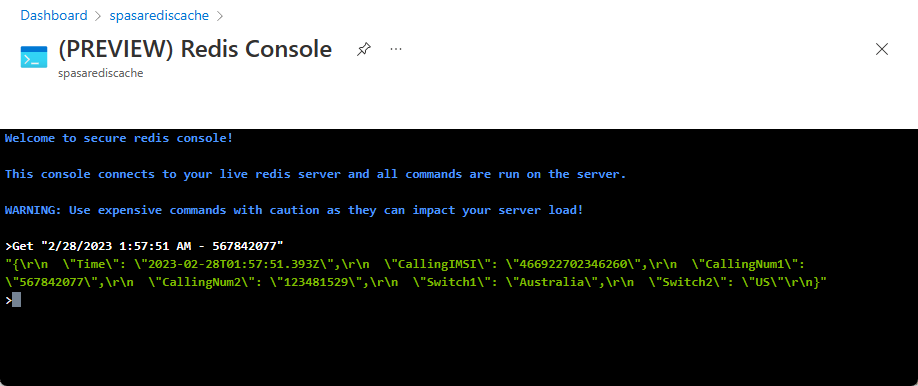

Gunakan kunci untuk menemukan rekaman di Azure Cache for Redis

Telusuri di portal Azure, lalu cari Azure Cache for Redis. Pilih Konsol.

Gunakan perintah Azure Cache for Redis untuk memverifikasi bahwa data Anda berada di Azure Cache for Redis. (Perintah mengambil format Dapatkan {key}.) Gunakan kunci yang Anda salin dari log Monitor untuk fungsi Azure (di bagian sebelumnya).

Dapatkan "KEY-FROM-THE-PREVIOUS-SECTION"

Perintah ini akan mencetak nilai kunci yang ditentukan:

Penanganan kesalahan dan percobaan ulang

Jika pengiriman peristiwa ke Azure Functions gagal, Azure Stream Analytics akan mencoba kembali sebagian besar operasi. Semua pengecualian http dicoba kembali hingga berhasil kecuali untuk kesalahan http 413 (entitas terlalu besar). Kesalahan entitas terlalu besar dianggap sebagai kesalahan data yang tunduk pada kebijakan coba lagi atau hilangkan.

Catatan

Batas waktu permintaan HTTP dari Azure Stream Analytics ke Azure Functions diatur ke 100 detik. Jika aplikasi Azure Functions Anda membutuhkan waktu lebih dari 100 detik untuk memproses batch, Kesalahan Azure Stream Analytics keluar dan akan mencoba kembali untuk batch.

Mencoba kembali untuk batas waktu dapat mengakibatkan peristiwa duplikat yang ditulis ke sink output. Saat Azure Stream Analytics mencoba lagi batch yang gagal, semua peristiwa dalam batch akan dicoba lagi. Misalnya, pertimbangkan batch 20 peristiwa yang dikirim ke Azure Functions dari Azure Stream Analytics. Misalnya, Azure Functions membutuhkan waktu 100 detik untuk memproses 10 peristiwa pertama dalam batch tersebut. Setelah 100 detik, Azure Stream Analytics menangguhkan permintaan karena belum menerima respons positif dari Azure Functions, dan permintaan lain dikirim untuk batch yang sama. 10 peristiwa pertama dalam batch diproses lagi oleh Azure Functions, yang menyebabkan duplikat.

Masalah umum

Di portal Azure, saat Anda mencoba mengatur ulang nilai Ukuran Batch Maksimum/Jumlah Batch Maksimum ke kosong (default), nilai akan berubah kembali menjadi nilai yang dimasukkan sebelumnya saat disimpan. Dalam kasus ini, masukkan nilai default untuk bidang ini secara manual.

Penggunaan perutean HTTP Azure Functions saat ini tidak didukung oleh Azure Stream Analytics.

Dukungan untuk menyambungkan ke Azure Functions yang dihosting di jaringan virtual tidak diaktifkan.

Membersihkan sumber daya

Jika tidak diperlukan lagi, hapus grup sumber daya, pekerjaan streaming, dan semua sumber daya terkait. Menghapus pekerjaan menghindari tagihan unit streaming yang digunakan oleh pekerjaan. Jika Anda ingin menggunakan pekerjaan di masa depan, Anda dapat menghentikannya dan memulainya kembali nanti ketika Anda membutuhkannya. Jika Anda ingin berhenti menggunakan pekerjaan ini, hapus semua sumber daya yang dibuat dalam mulai cepat ini dengan menggunakan langkah-langkah berikut:

- Dari menu sebelah kiri di portal Azure, pilih Grup sumber daya kemudian pilih nama sumber daya yang Anda buat.

- Pada halaman grup sumber daya, pilih Hapus, ketik nama sumber daya untuk dihapus dalam kotak teks, kemudian pilih Hapus.

Langkah berikutnya

Dalam tutorial ini, Anda telah membuat pekerjaan Azure Stream Analytics sederhana yang menjalankan Azure Function. Untuk mempelajari selengkapnya tentang pekerjaan Azure Stream Analytics, lanjutkan ke tutorial berikutnya: