Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

Nota

Fabric Runtime 2.0 saat ini dalam tahap pratinjau eksperimental. Untuk informasi selengkapnya, lihat batasan dan catatan.

Fabric Runtime memberikan integrasi yang mulus dalam ekosistem Microsoft Fabric, menawarkan lingkungan yang kuat untuk proyek rekayasa data dan ilmu data yang didukung oleh Apache Spark.

Artikel ini memperkenalkan Fabric Runtime 2.0 Experimental (Pratinjau), runtime terbaru yang dirancang untuk komputasi big data di Microsoft Fabric. Ini menyoroti fitur dan komponen utama yang membuat rilis ini menjadi langkah maju yang signifikan untuk analitik yang dapat diskalakan dan beban kerja tingkat lanjut.

Fabric Runtime 2.0 menggabungkan komponen dan peningkatan berikut yang dirancang untuk meningkatkan kemampuan pemrosesan data Anda:

- Apache Spark 4.0

- Sistem Operasi: Azure Linux 3.0 (Mariner 3.0)

- Java: 21

- Scala: 2.13

- Python: 3.12

- Danau Delta: 4.0

Mengaktifkan Runtime 2.0

Anda dapat mengaktifkan Runtime 2.0 di tingkat ruang kerja atau tingkat item lingkungan. Gunakan pengaturan ruang kerja untuk menerapkan Runtime 2.0 sebagai default untuk semua beban kerja Spark di ruang kerja Anda. Atau, buat item Lingkungan dengan Runtime 2.0 untuk digunakan dengan notebook tertentu atau definisi pekerjaan Spark, yang mengambil alih default ruang kerja.

Mengaktifkan Runtime 2.0 di pengaturan Ruang Kerja

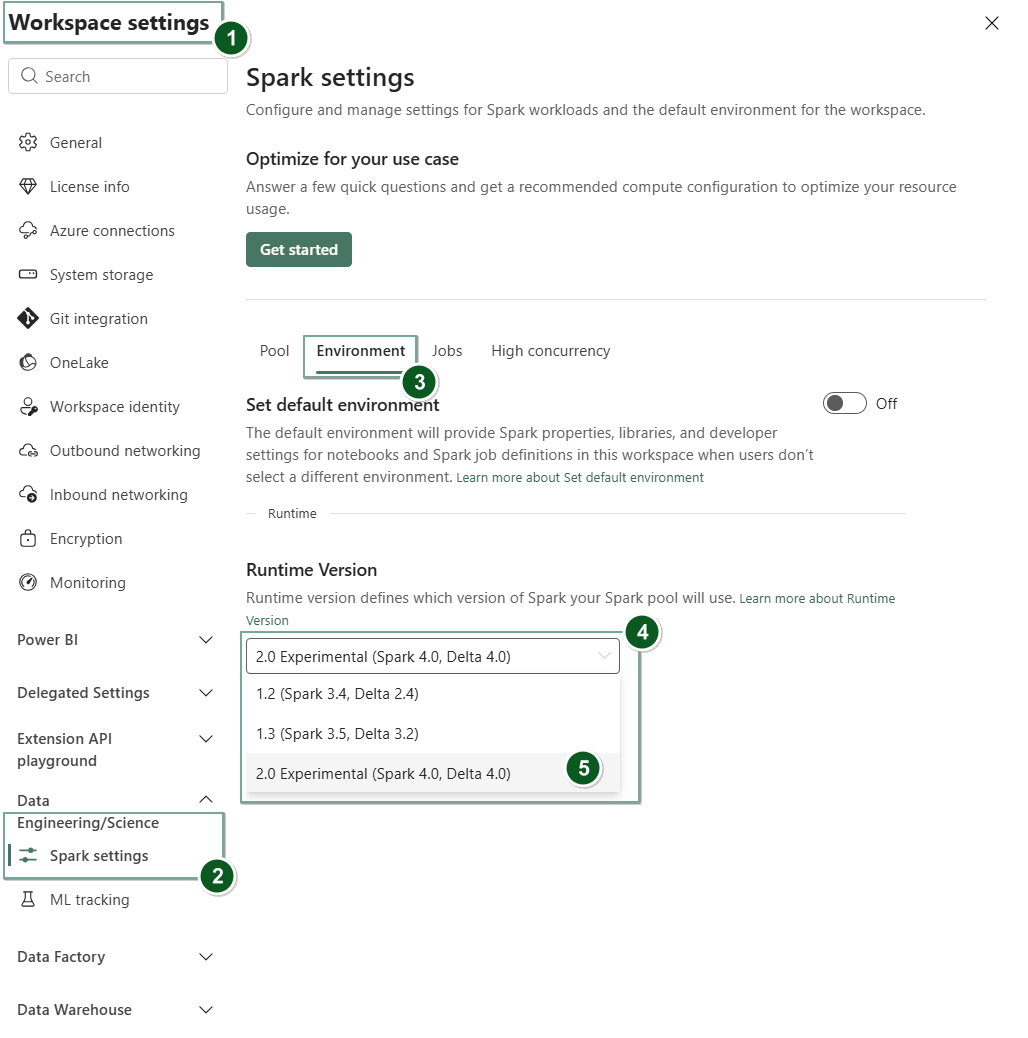

Untuk mengatur Runtime 2.0 sebagai default untuk seluruh ruang kerja Anda:

Navigasi ke tab Pengaturan ruang kerja dalam ruang kerja Fabric Anda.

Buka tab Rekayasa Data/Sains dan pilih Pengaturan Spark.

Pilih tabLingkungan.

Di bawah menu dropdown Versi runtime , pilih 2.0 Eksperimental (Spark 4.0, Delta 4.0) dan simpan perubahan Anda. Tindakan ini menetapkan Runtime 2.0 sebagai runtime default untuk ruang kerja Anda.

Mengaktifkan Runtime 2.0 dalam item Lingkungan

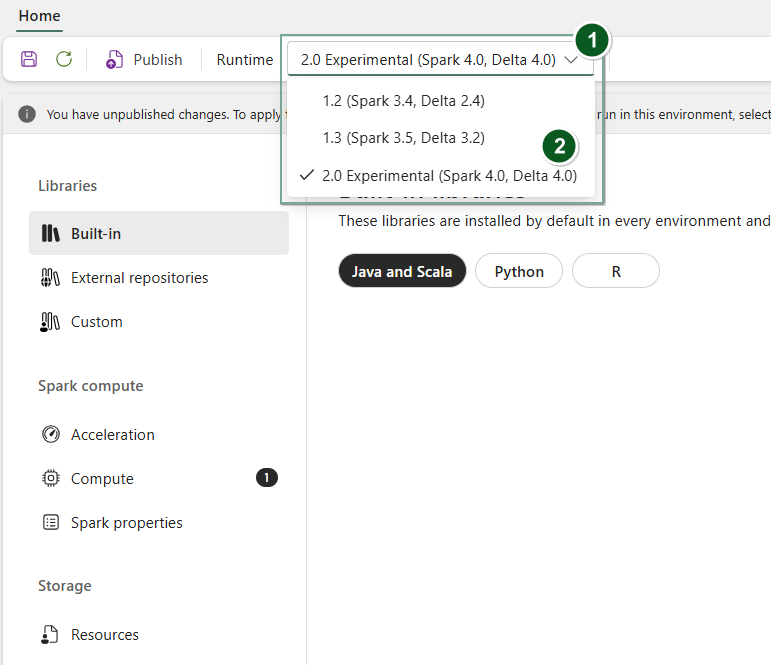

Untuk menggunakan Runtime 2.0 dengan notebook tertentu atau definisi kerja Spark:

Buat item Lingkungan baru atau buka yang sudah ada.

Pada bagian dropdown Runtime, pilih 2.0 Eksperimental (Spark 4.0, Delta 4.0),

SavedanPublishperubahan Anda.Penting

Dibutuhkan waktu sekitar 2-5 menit agar sesi Spark 2.0 dimulai, karena kumpulan pemula bukan bagian dari rilis eksperimental awal.

Selanjutnya, Anda dapat menggunakan item Lingkungan ini dengan

NotebookatauSpark Job Definition.

Anda sekarang dapat mulai bereksperimen dengan peningkatan dan fungsionalitas terbaru yang diperkenalkan dalam Fabric Runtime 2.0 (Spark 4.0 dan Delta Lake 4.0).

Pratinjau Umum Eksperimental

Tahap pratinjau eksperimental runtime 2.0 Fabric memberi Anda akses awal ke fitur dan API baru dari Spark 4.0 dan Delta Lake 4.0. Pratinjau ini memungkinkan Anda menggunakan penyempurnaan berbasis Spark terbaru segera, memastikan kesiapan dan transisi yang lancar untuk perubahan di masa mendatang seperti versi Java, Scala, dan Python yang lebih baru.

Petunjuk / Saran

Untuk informasi terbaru, daftar perubahan terperinci, dan catatan rilis tertentu untuk runtime Fabric, periksa dan berlangganan Rilis dan Pembaruan Runtime Spark.

Batasan dan Catatan

Fabric Runtime 2.0 saat ini berada dalam tahap pratinjau publik eksperimental, yang dirancang bagi pengguna untuk menjelajahi dan bereksperimen dengan fitur dan API terbaru dari Spark dan Delta Lake di lingkungan pengembangan atau pengujian. Meskipun versi ini menawarkan akses ke fungsionalitas inti, ada batasan tertentu:

Anda dapat menggunakan sesi Spark 4.0, menulis kode di notebook, menjadwalkan definisi kerja Spark, dan menggunakan dengan PySpark, Scala, dan Spark SQL. Namun, bahasa R tidak didukung dalam rilis awal ini.

Anda dapat menginstal pustaka langsung dalam kode Anda dengan pip dan conda. Anda dapat mengatur pengaturan Spark melalui opsi %%configure di notebook dan Definisi Pekerjaan Spark (SJD).

Anda dapat membaca dan menulis ke Lakehouse dengan Delta Lake 4.0, tetapi beberapa fitur canggih seperti urutan V, penulisan Parquet asli, kompaksi otomatis, pengoptimalan penulisan, penggabungan acak rendah, penggabungan, evolusi skema, dan perjalanan waktu tidak termasuk dalam rilis awal ini.

Spark Advisor saat ini tidak tersedia. Namun, alat pemantauan seperti Spark UI dan log didukung dalam rilis awal ini.

Fitur seperti integrasi Data Science termasuk Copilot dan konektor termasuk Kusto, SQL Analytics, Cosmos DB, dan MySQL Java Connector saat ini tidak didukung dalam rilis awal ini. Pustaka Data Science tidak didukung di lingkungan PySpark. PySpark hanya berfungsi dengan pengaturan dasar Conda, yang mencakup hanya PySpark tanpa pustaka tambahan.

Integrasi dengan item lingkungan dan Visual Studio Code tidak didukung dalam rilis awal ini.

Ini tidak mendukung membaca dan menulis data ke akun Azure Storage Tujuan Umum v2 (GPv2) dengan protokol WASB atau ABFS.

Nota

Bagikan umpan balik Anda tentang Fabric Runtime di platform Ideas. Pastikan untuk menyebutkan versi dan tahap rilis yang Anda maksud. Kami menghargai umpan balik komunitas dan memprioritaskan peningkatan berdasarkan suara, memastikan kami memenuhi kebutuhan pengguna.

Sorotan utama

Apache Spark 4.0

Apache Spark 4.0 menandai tonggak penting sebagai rilis perdana dalam seri 4.x, mewujudkan upaya kolektif komunitas sumber terbuka yang semarak.

Dalam versi ini, Spark SQL secara signifikan diperkaya dengan fitur baru yang kuat yang dirancang untuk meningkatkan ekspresif dan fleksibilitas untuk beban kerja SQL, seperti dukungan jenis data VARIAN, fungsi yang ditentukan pengguna SQL, variabel sesi, sintaks pipa, dan kolase string. PySpark melihat dedikasi berkelanjutan terhadap cakupan fungsional dan pengalaman pengembang secara keseluruhan, menghadirkan API plotting asli, API Sumber Data Python baru, dukungan untuk UDTF Python, dan profilering terpadu untuk UDF PySpark, serta banyak peningkatan lainnya. Streaming Terstruktur berevolusi dengan penambahan utama yang memberikan kontrol dan kemudahan penelusuran kesalahan yang lebih besar, terutama pengenalan Api Status Arbitrer v2 untuk manajemen status yang lebih fleksibel dan Sumber Data Status untuk penelusuran kesalahan yang lebih mudah.

Anda dapat memeriksa daftar lengkap dan perubahan terperinci di sini: https://spark.apache.org/releases/spark-release-4-0-0.html.

Nota

Di Spark 4.0, SparkR tidak digunakan lagi dan mungkin dihapus dalam versi mendatang.

Danau Delta 4.0

Delta Lake 4.0 menandai komitmen kolektif untuk membuat Delta Lake dapat dioperasikan di seluruh format, lebih mudah dikerjakan, dan lebih berkinerja. Delta 4.0 adalah rilis tonggak pencapaian yang dikemas dengan fitur baru yang kuat, pengoptimalan performa, dan peningkatan dasar untuk masa depan data lakehouse terbuka.

Anda dapat memeriksa daftar lengkap dan perubahan terperinci yang diperkenalkan dengan Delta Lake 3.3 dan 4.0 di sini: https://github.com/delta-io/delta/releases/tag/v3.3.0. https://github.com/delta-io/delta/releases/tag/v4.0.0.

Penting

Fitur khusus Delta Lake 4.0 bersifat eksperimental dan hanya berfungsi pada pengalaman Spark, seperti Notebook dan Definisi Pekerjaan Spark. Jika Anda perlu menggunakan tabel Delta Lake yang sama di beberapa beban kerja Microsoft Fabric, jangan aktifkan fitur tersebut. Untuk mempelajari selengkapnya tentang versi dan fitur protokol mana yang kompatibel di semua pengalaman Microsoft Fabric, baca interoperabilitas format tabel Delta Lake.

Konten terkait

- Apache Spark Runtimes in Fabric - Gambaran Umum, Penerapan Versi, dan Dukungan Beberapa Runtime

- Panduan migrasi Spark Core

- Panduan migrasi SQL, Himpunan Data, dan DataFrame

- Panduan migrasi Streaming Terstruktur

- Panduan migrasi MLlib (Pembelajaran Mesin)

- Panduan migrasi PySpark (Python on Spark)

- Panduan migrasi SparkR (R on Spark)