Skenario harga menggunakan Dataflow Gen2 untuk memuat 2 GB data Parquet ke tabel Lakehouse

Dalam skenario ini, Dataflow Gen2 digunakan untuk memuat 2 GB data Parquet yang disimpan di Azure Data Lake Storage (ADLS) Gen2 ke tabel Lakehouse di Microsoft Fabric. Kami menggunakan data sampel hijau Taksi NYC untuk data Parquet.

Harga yang digunakan dalam contoh berikut bersifat hipotetis dan tidak berniat untuk menyiratkan harga aktual yang tepat. Ini hanya untuk menunjukkan bagaimana Anda dapat memperkirakan, merencanakan, dan mengelola biaya untuk proyek Data Factory di Microsoft Fabric. Selain itu, karena kapasitas Fabric dihargai secara unik di seluruh wilayah, kami menggunakan harga bayar sesuai pemakaian untuk kapasitas Fabric di US Barat 2 (wilayah Azure biasa), sebesar $ 0,18 per CU per jam. Lihat di sini ke Microsoft Fabric - Harga untuk menjelajahi opsi harga kapasitas Fabric lainnya.

Konfigurasi

Untuk mencapai skenario ini, Anda perlu membuat aliran data dengan langkah-langkah berikut:

- Inisialisasi Aliran Data: Dapatkan data file Parquet 2 GB dari akun penyimpanan ADLS Gen2.

- Mengonfigurasi Power Query:

- Navigasi ke Power Query.

- Pastikan opsi untuk penahapan kueri diaktifkan.

- Lanjutkan untuk menggabungkan file Parquet.

- Transformasi Data:

- Promosikan header untuk kejelasan.

- Hapus kolom yang tidak perlu.

- Sesuaikan jenis data kolom sesuai kebutuhan.

- Tentukan Tujuan Data Output:

- Konfigurasikan Lakehouse sebagai tujuan output data.

- Dalam contoh ini, Lakehouse dalam Fabric dibuat dan digunakan.

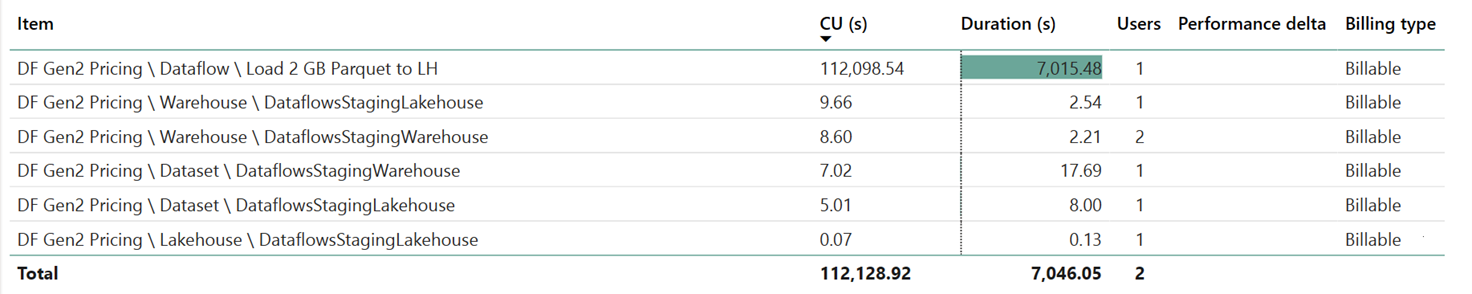

Estimasi biaya menggunakan Aplikasi Metrik Fabric

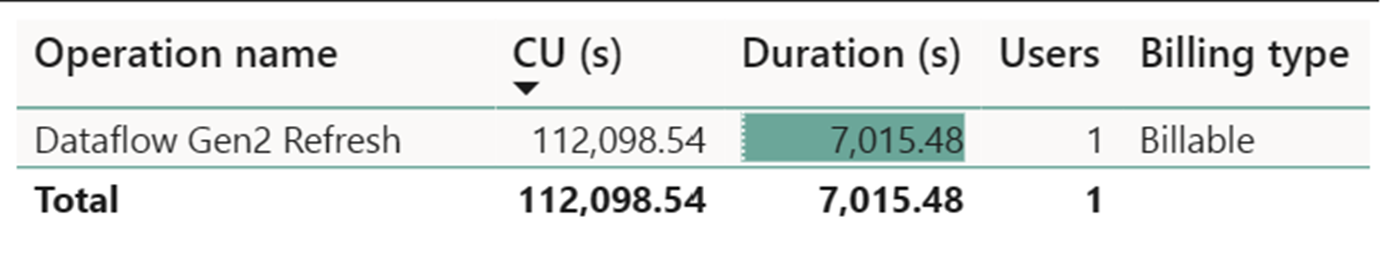

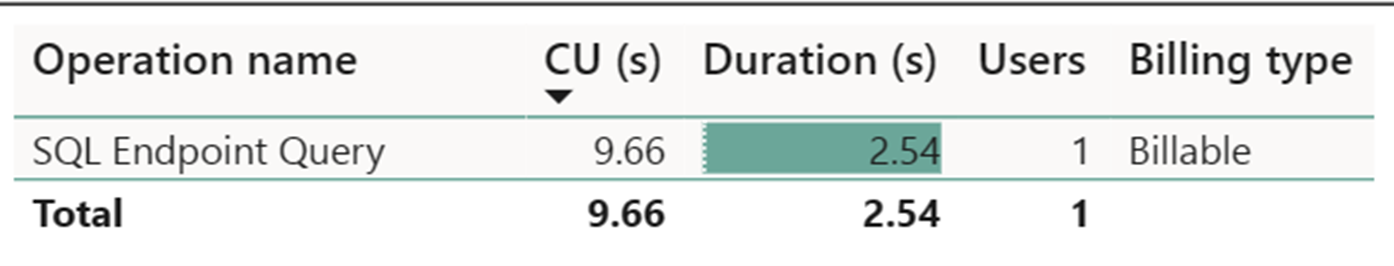

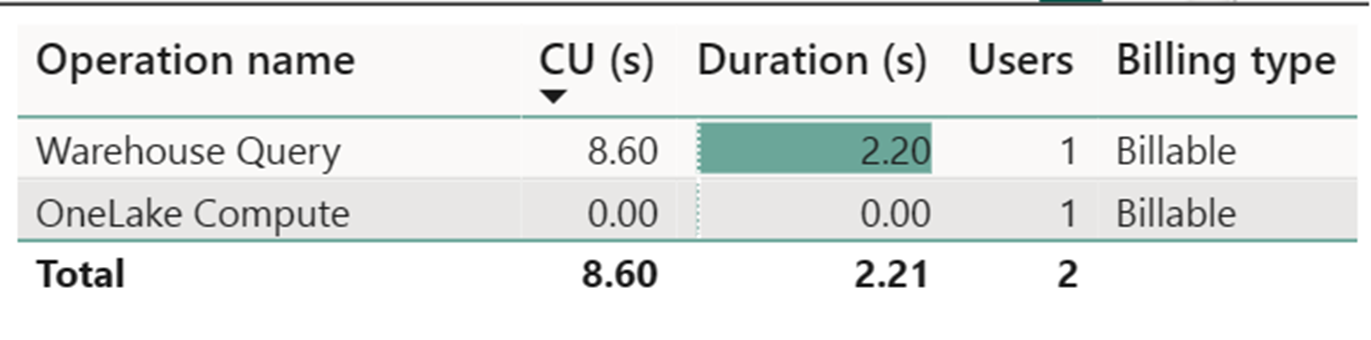

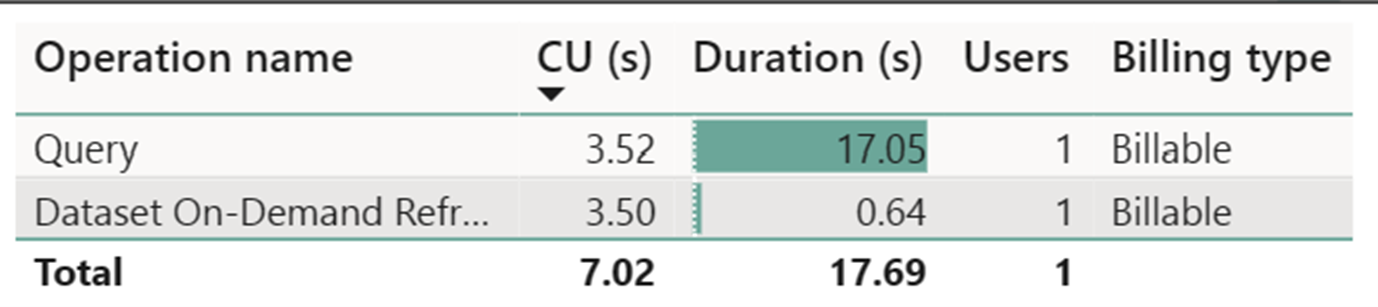

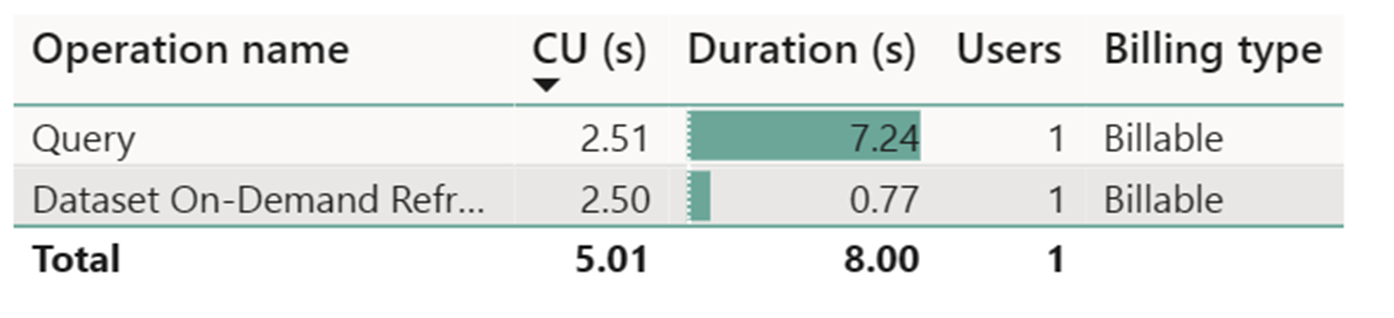

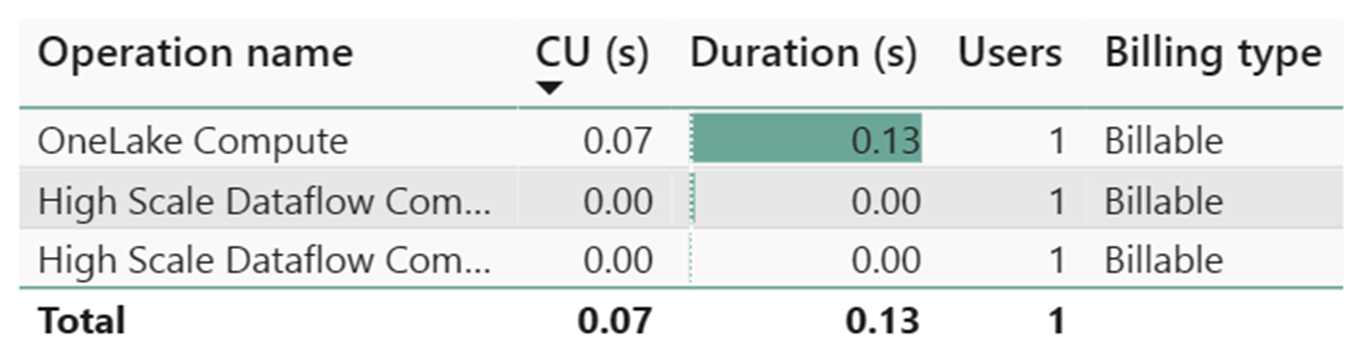

Pengukuran Komputasi Aliran Data Skala Tinggi merekam aktivitas yang dapat diabaikan. Pengukur Komputasi Standar untuk operasi refresh Dataflow Gen2 mengonsumsi 112.098.540 Unit Komputasi (CUs). Penting untuk dipertimbangkan bahwa operasi lain, termasuk Kueri Gudang, Kueri Titik Akhir SQL, dan Refresh Sesuai Permintaan Himpunan Data, merupakan aspek terperinci dari implementasi Dataflow Gen2 yang saat ini transparan dan diperlukan untuk operasi masing-masing. Namun, operasi ini akan disembubungkan dalam pembaruan di masa mendatang dan harus diabaikan saat memperkirakan biaya untuk Dataflow Gen2.

Catatan

Meskipun dilaporkan sebagai metrik, durasi aktual eksekusi tidak relevan saat menghitung jam CU yang efektif dengan Aplikasi Metrik Fabric sejak metrik detik CU, itu juga melaporkan durasinya.

| Metric | Komputasi Standar | Komputasi Skala Tinggi |

|---|---|---|

| Total detik CU | 112,098,54 CU detik | 0 DETIK CU |

| Jam CU efektif ditagih | 112.098,54 / (60*60) = 31,14 jam CU | 0 / (60*60) = 0 jam CU |

Total biaya eksekusi pada $0,18/JAM CU = (31,14 JAM CU) * ($0,18/jam CU) ~= $5,60