Log Delta Lake di Gudang di Microsoft Fabric

Berlaku untuk:✅ Gudang di Microsoft Fabric

Gudang di Microsoft Fabric dibangun dengan format file terbuka. Tabel pengguna disimpan dalam format file parket, dan log Delta Lake diterbitkan untuk semua tabel pengguna.

Log Delta Lake membuka akses langsung ke tabel pengguna gudang untuk mesin apa pun yang dapat membaca tabel Delta Lake. Akses ini terbatas pada baca-saja untuk memastikan data pengguna mempertahankan kepatuhan transaksi ACID. Semua sisipan, pembaruan, dan penghapusan ke data dalam tabel harus dijalankan melalui Gudang. Setelah transaksi dilakukan, proses latar belakang sistem dimulai untuk menerbitkan log Delta Lake yang diperbarui untuk tabel yang terpengaruh.

Cara mendapatkan jalur OneLake

Langkah-langkah berikut merinci cara mendapatkan jalur OneLake dari tabel di gudang:

Buka Gudang di ruang kerja Microsoft Fabric Anda.

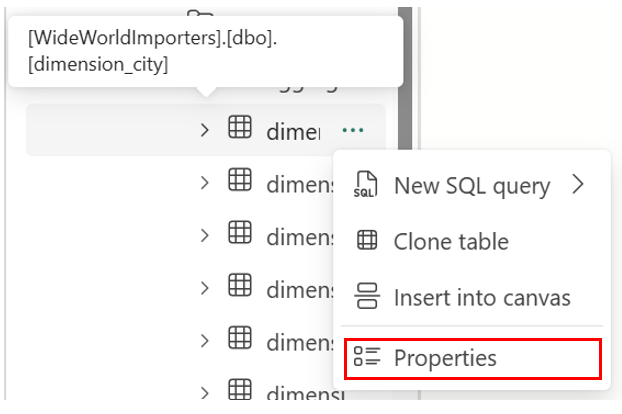

Di Object Explorer, Anda menemukan opsi lainnya (...) pada tabel yang dipilih di folder Tabel. Pilih menu Properti.

Pada pilihan, panel Properti memperlihatkan informasi berikut ini:

- Nama

- Format

- Jenis

- URL

- Jalur relatif

- Jalur ABFS

Cara mendapatkan jalur log Delta Lake

Anda dapat menemukan log Delta Lake melalui metode berikut:

Log Delta Lake dapat dikueri melalui pintasan yang dibuat di lakehouse. Anda dapat melihat file menggunakan Microsoft Fabric Spark Notebook atau penjelajah Lakehouse di Synapse Rekayasa Data di portal Microsoft Fabric.

Log Delta Lake dapat ditemukan melalui Azure Storage Explorer, melalui koneksi Spark seperti mode Power BI Direct Lake, atau menggunakan layanan lain yang dapat membaca tabel delta.

Log Delta Lake dapat ditemukan di

_delta_logfolder setiap tabel melalui OneLake Explorer di Windows, seperti yang ditunjukkan pada cuplikan layar berikut.

Menjeda penerbitan log Delta Lake

Penerbitan log Delta Lake dapat dijeda dan dilanjutkan jika diperlukan. Saat penerbitan dijeda, mesin Microsoft Fabric yang membaca tabel di luar Gudang melihat data seperti sebelum jeda. Ini memastikan bahwa laporan tetap stabil dan konsisten, mencerminkan data dari semua tabel seperti yang ada sebelum perubahan apa pun dilakukan pada tabel. Setelah pembaruan data selesai, Anda dapat melanjutkan penerbitan Delta Lake Log untuk membuat semua perubahan data terbaru terlihat oleh mesin analitik lainnya. Kasus penggunaan lain untuk menjeda penerbitan log Delta Lake adalah ketika pengguna tidak memerlukan interoperabilitas dengan mesin komputasi lain di Microsoft Fabric, karena dapat membantu menghemat biaya komputasi.

Sintaks untuk menjeda dan melanjutkan penerbitan log Delta Lake adalah sebagai berikut:

ALTER DATABASE CURRENT SET DATA_LAKE_LOG_PUBLISHING = PAUSED | AUTO

Contoh: menjeda dan melanjutkan penerbitan log Delta Lake

Untuk menjeda penerbitan log Delta Lake, gunakan cuplikan kode berikut:

ALTER DATABASE CURRENT SET DATA_LAKE_LOG_PUBLISHING = PAUSED

Kueri ke tabel gudang pada gudang saat ini dari mesin Microsoft Fabric lainnya (misalnya, kueri dari Lakehouse) sekarang menampilkan versi data seperti sebelum menjeda penerbitan log Delta Lake. Kueri gudang masih menampilkan versi data terbaru.

Untuk melanjutkan penerbitan log Delta Lake, gunakan cuplikan kode berikut:

ALTER DATABASE CURRENT SET DATA_LAKE_LOG_PUBLISHING = AUTO

Ketika status diubah kembali ke AUTO, mesin Fabric Warehouse menerbitkan log dari semua perubahan terbaru yang dilakukan pada tabel di gudang, memungkinkan mesin analitik lain di Microsoft Fabric untuk membaca versi data terbaru.

Memeriksa status penerbitan log Delta Lake

Untuk memeriksa status penerbitan log Delta Lake saat ini di semua gudang untuk ruang kerja saat ini, gunakan cuplikan kode berikut:

SELECT [name], [DATA_LAKE_LOG_PUBLISHING_DESC] FROM sys.databases

Batasan

- Nama Tabel hanya dapat digunakan oleh Spark dan sistem lain jika hanya berisi karakter ini: A-Z a-z 0-9 dan garis bawah.

- Nama Kolom yang akan digunakan oleh Spark dan sistem lain tidak boleh berisi:

- Ruang

- Tab

- pengembalian pengangkutan

- [

- ,

- ;

- {

- }

- (

- )

- =

- ]