Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

Peraturan dan standar AI muncul di seluruh wilayah dan industri, menyediakan kerangka kerja yang kuat bagi organisasi untuk menilai, menerapkan, dan menguji kontrol mereka untuk mengembangkan dan menggunakan AI yang dapat dipercaya. Artikel ini membantu tim risiko dan kepatuhan mempersiapkan upaya kepatuhan. Ini menjelaskan cara:

- Menilai dan memperkuat kesiapan kepatuhan Anda terhadap peraturan.

- Terapkan kontrol untuk mengatur penggunaan aplikasi dan data AI.

Ini adalah artikel keempat dalam sebuah seri. Jika Anda belum menyelesaikan tugas di Menyiapkan keamanan AI, Temukan aplikasi dan data AI, danLindungi aplikasi dan data AI, mulailah dengan artikel ini untuk menyiapkan lingkungan Anda dengan kemampuan yang ditentukan dalam artikel ini.

Gunakan artikel ini bersama dengan sumber daya ini:

- Skenario bisnis kerangka kerja adopsi Zero Trust—Memenuhi persyaratan peraturan dan kepatuhan dengan Zero Trust

- Cloud Adoption Framework (CAF) untuk AI—Proses untuk mengelola AI

Apa pertimbangan baru untuk mengatur aplikasi dan data AI?

Sama seperti AI memperkenalkan permukaan serangan baru yang mengubah lanskap risiko, AI juga memperkenalkan metode pemrosesan baru dan menggunakan data yang memengaruhi kepatuhan terhadap peraturan. Karakteristik baru AI ini memengaruhi peraturan yang ada, seperti peraturan privasi, dan peraturan baru yang ditargetkan khusus untuk penggunaan AI.

Ilustrasi berikut menyoroti peraturan AI yang muncul, termasuk Kecerdasan Buatan dan Undang-Undang Data (AIDA) di Amerika Utara, Undang-Undang AI Eropa, Rencana Tindakan AI di Australia, dan standar global yang diproduksi oleh ISO.

Secara luas, mengatur AI untuk kepatuhan terhadap peraturan meliputi:

- Mencatat dan mempertahankan interaksi AI.

- Mendeteksi potensi penggunaan yang tidak sesuai.

- Menggunakan alat, seperti eDiscovery pada interaksi AI, jika diperlukan.

Ini membantu organisasi memenuhi persyaratan kepatuhan mereka dan menanggapi potensi litigasi secara efektif.

Untuk organisasi yang membangun AI, tim risiko dan kepatuhan perlu memungkinkan tim pengembangan untuk mendokumentasikan detail proyek mereka, seperti nama model, versi, tujuan sistem AI, dan metrik evaluasi mereka untuk mengatasi risiko kualitas, keselamatan, dan keamanan. Upaya ini dapat membantu tim risiko dan kepatuhan memiliki format informasi standar untuk mempersiapkan audit dan menanggapi permintaan peraturan.

Praktik terbaik lainnya adalah menggunakan penilaian dampak privasi, kontrol yang telah diterapkan banyak perusahaan untuk peraturan seperti GDPR, untuk memastikan aplikasi AI memiliki semua penilaian dan kontrol untuk melindungi privasi. Microsoft menyediakan kemampuan seperti Penilaian Privasi Priva yang dapat dengan mudah diintegrasikan ke dalam siklus hidup pengembangan AI Anda untuk memastikan pengembang tetap mengutamakan privasi.

Terakhir, untuk membangun aplikasi AI yang bertanggung jawab dan mematuhi persyaratan peraturan baru, organisasi perlu membuat pagar pembatas untuk mendeteksi dan memblokir konten berbahaya, seperti konten kekerasan, kebencian, seksual, dan bahaya diri. Selain itu, Anda ingin aplikasi AI menghasilkan konten yang andal. Pagar pembatas harus membantu mendeteksi dan memperbaiki informasi yang salah untuk mengurangi risiko keputusan yang salah berdasarkan output yang tidak di-ground. Mereka juga harus mengidentifikasi konten yang melanggar hak cipta. Pagar pembatas ini dapat membantu organisasi membangun aplikasi AI yang bertanggung jawab dan dapat dipercaya.

Kemampuan untuk mengatur aplikasi dan data AI

Microsoft menyertakan kemampuan untuk membantu organisasi menghubungkan titik-titik antara standar peraturan dan solusi teknologi.

Langkah-langkah berikut menjelaskan ilustrasi dan juga menelusuri langkah-langkah penerapan kemampuan ini.

| Langkah | Tugas | Ruang Lingkup |

|---|---|---|

| 1 | Membangun dan mengelola penilaian di Microsoft Purview Compliance Manager | Seluruh perusahaan |

| 2 | Menggunakan Aplikasi Defender for Cloud untuk mengelola aplikasi AI berdasarkan risiko kepatuhan | Aplikasi SaaS AI |

| 3 | Gunakan Cloud Security Posture Management (CSPM) untuk beban kerja AI untuk menemukan dan mengelola aplikasi yang dibuat khusus berdasarkan risiko kepatuhan | Aplikasi AI yang dibangun secara khusus berbasis Azure AI |

| 4 | Mengonfigurasi Kepatuhan Komunikasi Purview untuk meminimalkan risiko komunikasi dengan membantu Anda mendeteksi, menangkap, dan bertindak atas pesan yang berpotensi tidak pantas di organisasi Anda | Aplikasi dan layanan Microsoft 365 Aplikasi AI yang terhubung oleh konektor Microsoft Entra atau Microsoft Purview Data Map Layanan Azure AI |

| 5 | Konfigurasikan Manajemen Siklus Hidup Data Purview untuk menyimpan konten yang perlu Anda simpan, dan hapus konten yang tidak Anda simpan. | Kebijakan retensi untuk aplikasi AI mencakup permintaan dan respons pengguna untuk Microsoft 365 Copilot dan Copilot Studio, serta permintaan dan respons pengguna untuk copilot Microsoft lainnya dan aplikasi AI generatif saat mereka memiliki kebijakan pengumpulan dengan pengaturan untuk menangkap konten. Pesan-pesan ini kemudian dapat dipertahankan dan dihapus karena alasan kepatuhan. Untuk mengintegrasikan aplikasi AI yang dikembangkan di penyedia cloud lain, gunakan Purview SDK. |

| 6 | Gunakan eDiscovery bersama dengan log audit untuk Microsoft 365 Copilot untuk penyelidikan, sesuai kebutuhan | Log audit dibuat secara otomatis saat pengguna berinteraksi dengan Copilot atau Aplikasi AI. Untuk mengintegrasikan aplikasi AI yang dikembangkan di penyedia cloud lain, gunakan Purview SDK. |

| 7 | Gunakan Penilaian Privasi Priva untuk memulai penilaian dampak privasi untuk aplikasi AI yang Anda buat | Aplikasi apa pun, lokasi mana pun |

| 8 | Menggunakan laporan AI di AI Foundry untuk mendokumenkan detail proyek AI untuk aplikasi yang Anda kembangkan | Aplikasi AI di Azure |

| 9 | Terapkan Azure AI Content Safety untuk memblokir konten berbahaya, serta mendeteksi dan memperbaiki respons tak berdasar. | Aplikasi AI di Azure |

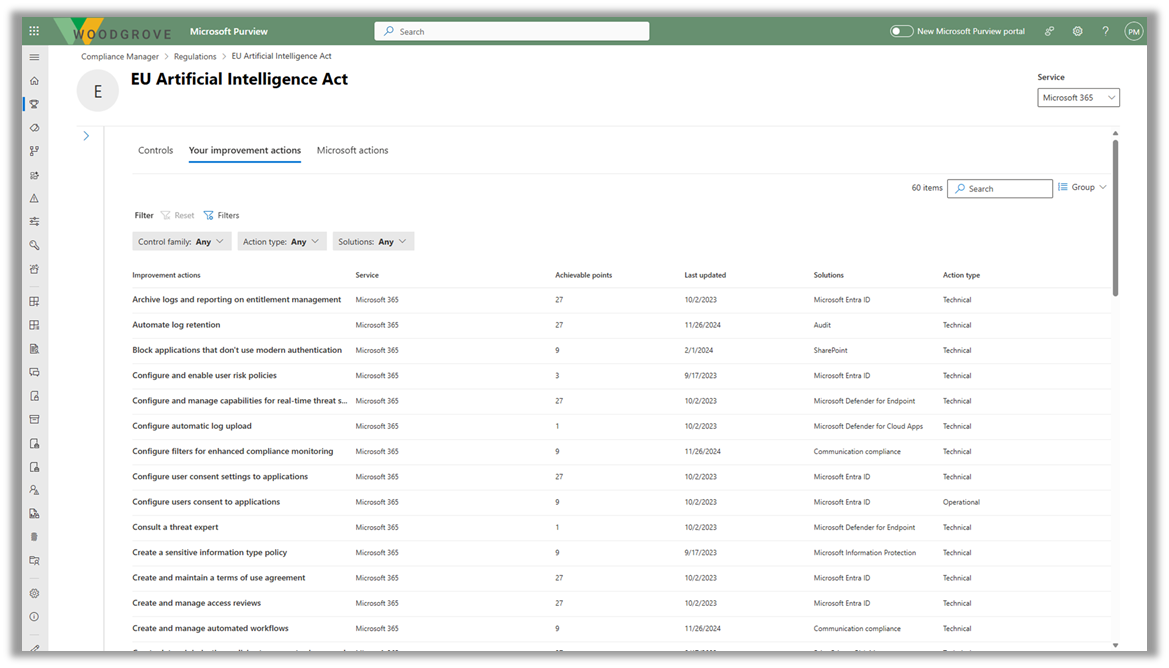

Langkah 1—Membangun dan mengelola penilaian di Microsoft Purview Compliance Manager

Microsoft Purview Compliance Manager adalah solusi yang membantu Anda menilai dan mengelola kepatuhan secara otomatis di seluruh lingkungan multicloud Anda. Pengelola Kepatuhan dapat membantu Anda sepanjang perjalanan kepatuhan Anda, mulai dari mengambil inventaris risiko perlindungan data, hingga mengelola kompleksitas penerapan kontrol, tetap mengikuti perkembangan terkait peraturan dan sertifikasi, serta melapor kepada auditor.

Saat ini Compliance Manager menyertakan templat peraturan untuk peraturan terkait AI berikut:

- Undang-Undang Kecerdasan Buatan Uni Eropa

- ISO/IEC 23894:2023

- ISO/IEC 42001:2023

- NIST AI Risk Management Framework (RMF) 1.0

Gunakan sumber daya berikut untuk mulai menggunakan Compliance Manager.

| Tugas | Sumber daya yang disarankan |

|---|---|

| Pelajari dan mulai |

Manajer Kepatuhan Microsoft Purview Mulai menggunakan Microsoft Purview Compliance Manager Membangun dan mengelola penilaian di Microsoft Purview Compliance Manager |

| Lihat apakah Manajer Kepatuhan menyertakan templat untuk peraturan | Daftar peraturan |

| Membangun penilaian kustom | Membangun penilaian kustom (pratinjau) di Microsoft Purview Compliance Manager |

Langkah 2—Gunakan Defender untuk Aplikasi Cloud

Gunakan Aplikasi Defender for Cloud untuk mengelola aplikasi AI berdasarkan risiko kepatuhan. Artikel sebelumnya dalam seri ini menjelaskan cara menggunakan Defender for Cloud Apps untuk menemukan, mengelola, dan melindungi penggunaan aplikasi AI. Kepatuhan terhadap peraturan memperkenalkan kriteria tambahan untuk triaging dan menilai risiko aplikasi ini.

Setelah membangun satu atau beberapa penilaian untuk peraturan tertentu di Purview Compliance Manager, bekerja sama dengan tim Defender for Cloud Apps Anda untuk mengintegrasikan kewajiban kepatuhan Anda ke dalam kriteria untuk menilai risiko aplikasi AI, memberi sanksi atau memblokir aplikasi ini, dan menerapkan kebijakan sesi untuk mengontrol bagaimana aplikasi ini dapat diakses (misalnya, hanya dengan perangkat yang sesuai).

Lihat artikel sebelumnya dalam seri ini untuk memulai dan menggunakan Defender for Cloud Apps.

| Tugas | Sumber daya yang disarankan |

|---|---|

| Menemukan, memberi sanksi, dan memblokir aplikasi AI dengan Pertahanan Microsoft untuk Aplikasi Cloud | Lihat Langkah 3 di Menemukan aplikasi dan data AI |

| Menggunakan Defender for Cloud Apps untuk melakukan triase dan melindungi penggunaan aplikasi AI | Lihat Mendapatkan manfaat maksimal dari perlindungan ancaman untuk AI di Melindungi aplikasi dan data AI |

Langkah 3—Gunakan Cloud Security Posture Management (CSPM) untuk beban kerja AI

Gunakan paket Defender Cloud Security Posture Management (CSPM) di Microsoft Defender for Cloud untuk menemukan dan mengelola aplikasi yang dibuat khusus berdasarkan risiko kepatuhan. Sama seperti Defender untuk Aplikasi Cloud, kepatuhan terhadap peraturan memperkenalkan kriteria tambahan untuk melakukan triaging dan menilai risiko aplikasi bawaan kustom Anda dengan CSPM untuk AI.

Bekerja sama dengan tim Defender for Cloud Anda untuk mengintegrasikan kewajiban kepatuhan Anda ke dalam kriteria untuk menilai risiko dan mengatur aplikasi yang dibuat khusus.

Lihat artikel sebelumnya dalam seri ini untuk memulai dan menggunakan Defender for Cloud.

| Tugas | Sumber daya yang disarankan |

|---|---|

| Temukan beban kerja AI yang disebarkan di lingkungan Anda dan dapatkan wawasan keamanan dengan Microsoft Defender for Cloud | Lihat Langkah 4 di Menemukan aplikasi dan data AI] |

| Menerapkan perlindungan AI di Defender for Cloud | Lihat Langkah 2 tentang Memaksimalkan perlindungan ancaman untuk AI di bagian Melindungi aplikasi dan data AI |

Langkah 4—Mengonfigurasi Kepatuhan Komunikasi Purview

Konfigurasikan Kepatuhan Komunikasi Purview untuk meminimalkan risiko komunikasi dengan membantu Anda mendeteksi, menangkap, dan bertindak atas pesan yang berpotensi tidak pantas di organisasi Anda. Untuk AI Generatif, Anda dapat menggunakan kebijakan kepatuhan komunikasi untuk menganalisis interaksi (perintah dan respons) yang dimasukkan ke dalam aplikasi AI generatif untuk membantu mendeteksi interaksi yang tidak pantas atau berisiko atau berbagi informasi rahasia. Cakupan didukung untuk Microsoft 365 Copilot, Copilot yang dibuat menggunakan Microsoft Copilot Studio, aplikasi AI yang terhubung melalui konektor Microsoft Entra atau Microsoft Purview Data Map, serta lainnya.

Gunakan sumber daya berikut untuk memulai.

| Tugas | Sumber daya yang disarankan |

|---|---|

| Pelajari dan mulai sekarang |

Pelajari tentang kepatuhan komunikasi Rencana kepatuhan komunikasi Memulai dengan kepatuhan komunikasi |

| Mengonfigurasi kebijakan |

Mengonfigurasi kebijakan kepatuhan komunikasi untuk mendeteksi interaksi AI generatif Membuat dan mengelola kebijakan kepatuhan komunikasi |

Langkah 5—Mengonfigurasi Manajemen Siklus Hidup Data Purview

Manajemen Siklus Hidup Data Microsoft Purview memberi Anda alat dan kemampuan untuk menyimpan konten yang perlu Anda simpan, dan menghapus konten yang tidak Anda simpan. Secara proaktif menghapus konten yang tidak lagi diwajibkan untuk disimpan membantu mengurangi risiko pemaparan data yang berlebihan dalam alat AI. Fitur utama meliputi:

- Kebijakan retensi dan label retensi

- Pengarsipan kotak surat dan kotak surat tidak aktif—Kotak surat pengguna menyertakan folder tersembunyi dengan perintah dan respons Copilot

Gunakan sumber daya berikut untuk memulai.

| Tugas | Sumber daya yang disarankan |

|---|---|

| Pelajari dan mulai |

Pelajari tentang Manajemen Siklus Hidup Data Microsoft Purview Mulai menggunakan manajemen siklus hidup data |

| Pelajari tentang retensi untuk aplikasi Copilot & AI | Pelajari cara kerja retensi dengan aplikasi AI |

| Untuk aplikasi AI yang dikembangkan di penyedia cloud lain, integrasikan dengan Purview SDK | Pelajari tentang Microsoft Purview SDK |

Langkah 6—Gunakan eDiscovery bersama dengan log audit untuk Microsoft 365 Copilot

Gunakan Microsoft Purview eDiscovery untuk mencari kata kunci dalam permintaan dan respons Copilot yang mungkin tidak pantas. Anda juga dapat menyertakan info ini dalam kasus eDiscovery untuk meninjau, mengekspor, atau menangguhkan data ini untuk penyelidikan hukum yang sedang berlangsung.

Gunakan log audit Microsoft Purview untuk mengidentifikasi bagaimana, kapan, dan di mana interaksi Copilot terjadi dan item mana yang diakses, termasuk label sensitivitas apa pun pada item tersebut.

| Tugas | Sumber daya yang disarankan |

|---|---|

| Pelajari di mana data penggunaan Copilot disimpan dan bagaimana Anda dapat mengauditnya | Arsitektur perlindungan data dan audit Microsoft 365 Copilot |

| Mulai menggunakan eDiscovery | Pelajari tentang solusi eDiscovery |

| Pelajari tentang log audit Purview | Pelajari tentang solusi audit di Microsoft Purview |

| Pelajari tentang log audit untuk aplikasi AI | Pelajari aktivitas admin dan pengguna mana yang dicatat untuk aplikasi AI |

| Untuk aplikasi AI yang dikembangkan di penyedia cloud lain, integrasikan dengan Purview SDK | Pelajari tentang Microsoft Purview SDK |

Langkah 7—Gunakan Penilaian Privasi Priva

Gunakan Penilaian Privasi Priva (pratinjau) untuk memulai penilaian dampak privasi untuk aplikasi AI yang Anda buat. Ini membantu memastikan aplikasi AI dibangun dengan cara yang menghormati privasi. Penilaian Privasi mengotomatiskan penemuan, dokumentasi, dan evaluasi penggunaan data pribadi di seluruh data estate Anda.

Gunakan sumber daya berikut untuk memulai Penilaian Privasi Priva dan untuk memulai penilaian dampak privasi.

| Tugas | Sumber daya yang disarankan |

|---|---|

| Pelajari dan mulai |

Pelajari tentang penilaian privasi Mulai dengan penilaian privasi |

| Membuat penilaian | Membuat dan mengelola penilaian privasi |

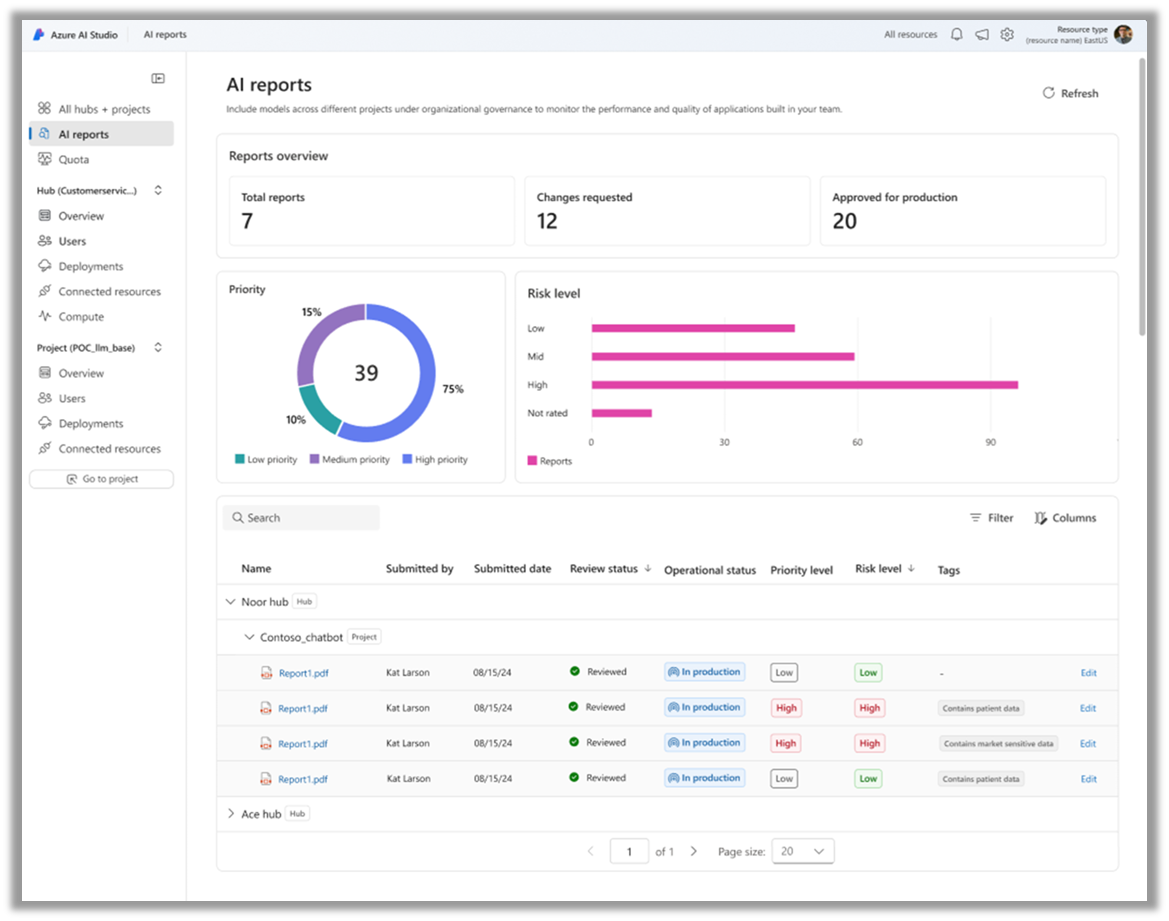

Langkah 8—Gunakan laporan AI di AI Foundry

Laporan AI di Azure AI Foundry dapat membantu pengembang mendokumenkan detail proyek mereka. Pengembang dapat membuat laporan yang menunjukkan semua detail proyek AI, seperti kartu model, versi model, konfigurasi filter keamanan konten, dan metrik evaluasi. Laporan ini dapat diekspor dalam format PDF atau SPDX, membantu tim pengembangan menunjukkan kesiapan produksi dalam alur kerja tata kelola, risiko, dan kepatuhan (GRC) dan memfasilitasi audit aplikasi yang lebih mudah dan berkelanjutan dalam produksi.

Gunakan sumber daya berikut untuk memulai.

| Tugas | Sumber daya yang disarankan |

|---|---|

| Baca tentang Laporan AI di AI Foundry (blog) | Laporan AI: Meningkatkan tata kelola AI dan GenAIOps dengan dokumentasi yang konsisten |

| Pelajari tentang dan mulai menggunakan AI Foundry | Apa itu Azure AI Foundry? |

Langkah 9—Menerapkan Keamanan Konten Azure AI

Azure AI Content Safety adalah layanan AI yang mendeteksi konten yang dihasilkan pengguna dan buatan AI yang berbahaya dalam aplikasi dan layanan. Azure AI Content Safety menyertakan API teks dan gambar yang memungkinkan Anda mendeteksi materi yang berbahaya. Content Safety Studio interaktif memungkinkan Anda untuk melihat, menjelajahi, dan mencoba kode sampel untuk mendeteksi konten berbahaya di berbagai modalitas.

Gunakan sumber daya berikut untuk memulai.

| Tugas | Sumber daya yang disarankan |

|---|---|

| Pelajari dan mulai | Apa itu Azure AI Content Safety? - Layanan Azure AI | Microsoft Learn Menggunakan Keamanan Konten di portal Azure AI Foundry |

Langkah selanjutnya untuk mengamankan AI

Lanjutkan untuk membuat kemajuan pada keamanan end-to-end dengan sumber daya Zero Trust: