Memperkenalkan kumpulan penyimpanan di SQL Server Kluster Big Data

Berlaku untuk: SQL Server 2019 (15.x)

Artikel ini menjelaskan peran kumpulan penyimpanan SQL Server dalam kluster big data SQL Server. Bagian berikut menjelaskan arsitektur dan fungsionalitas kumpulan penyimpanan.

Penting

Add-on Kluster Big Data Microsoft SQL Server 2019 akan dihentikan. Dukungan untuk SQL Server 2019 Kluster Big Data akan berakhir pada 28 Februari 2025. Semua pengguna SQL Server 2019 yang ada dengan Jaminan Perangkat Lunak akan didukung sepenuhnya pada platform dan perangkat lunak akan terus dipertahankan melalui pembaruan kumulatif SQL Server hingga saat itu. Untuk informasi selengkapnya, lihat posting blog pengumuman dan Opsi big data di platform Microsoft SQL Server.

Arsitektur kumpulan penyimpanan

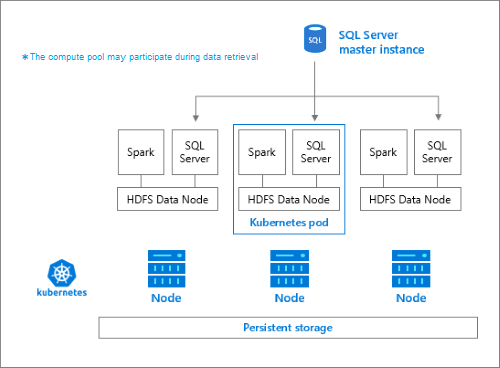

Kumpulan penyimpanan adalah kluster HDFS (Hadoop) lokal dalam kluster big data SQL Server. Ini menyediakan penyimpanan persisten untuk data yang tidak terstruktur dan semi terstruktur. File data, seperti Parquet atau teks yang dibatasi, dapat disimpan di kumpulan penyimpanan. Untuk mempertahankan penyimpanan setiap pod di kumpulan memiliki volume persisten yang melekat padanya. File kumpulan penyimpanan dapat diakses melalui PolyBase melalui SQL Server atau langsung menggunakan Apache Knox Gateway.

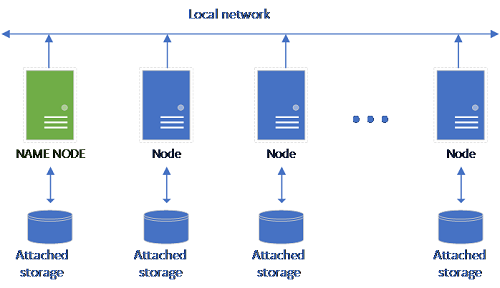

Pengaturan HDFS klasik terdiri dari satu set komputer perangkat keras komoditas dengan penyimpanan terpasang. Data tersebar di blok di seluruh simpul untuk toleransi kesalahan dan memanfaatkan pemrosesan paralel. Salah satu simpul dalam kluster berfungsi sebagai node nama dan berisi informasi metadata tentang file yang terletak di simpul data.

Kumpulan penyimpanan terdiri dari simpul penyimpanan yang merupakan anggota kluster HDFS. Ini menjalankan satu atau beberapa pod Kubernetes dengan setiap pod yang menghosting kontainer berikut:

- Kontainer Hadoop yang ditautkan ke volume persisten (penyimpanan). Semua kontainer jenis ini bersama-sama membentuk kluster Hadoop. Dalam kontainer Hadoop adalah proses manajer simpul YARN yang dapat membuat proses pekerja Apache Spark sesuai permintaan. Simpul kepala Spark menghosting metastore apache hive, riwayat spark, dan kontainer riwayat pekerjaan YARN.

- Instans SQL Server untuk membaca data dari HDFS menggunakan teknologi OpenRowSet.

collectduntuk mengumpulkan data metrik.fluentbituntuk mengumpulkan data log.

Tanggung jawab

Simpul penyimpanan bertanggung jawab untuk:

- Penyerapan data melalui Apache Spark.

- Penyimpanan data dalam HDFS (Parquet dan format teks yang dibatasi). HDFS juga menyediakan persistensi data, karena data HDFS tersebar di semua simpul penyimpanan di SQL BDC.

- Akses data melalui titik akhir HDFS dan SQL Server.

Mengakses data

Metode utama untuk mengakses data di kumpulan penyimpanan adalah:

- Pekerjaan Spark.

- Pemanfaatan tabel eksternal SQL Server untuk memungkinkan kueri data menggunakan simpul komputasi PolyBase dan instans SQL Server yang berjalan di simpul HDFS.

Anda juga dapat berinteraksi dengan HDFS menggunakan:

- Azure Data Studio.

- Azure Data CLI (

azdata). - kubectl untuk mengeluarkan perintah ke kontainer Hadoop.

- Gateway http HDFS.

Langkah berikutnya

Untuk mempelajari selengkapnya tentang Kluster Big Data SQL Server, lihat sumber daya berikut ini: