Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

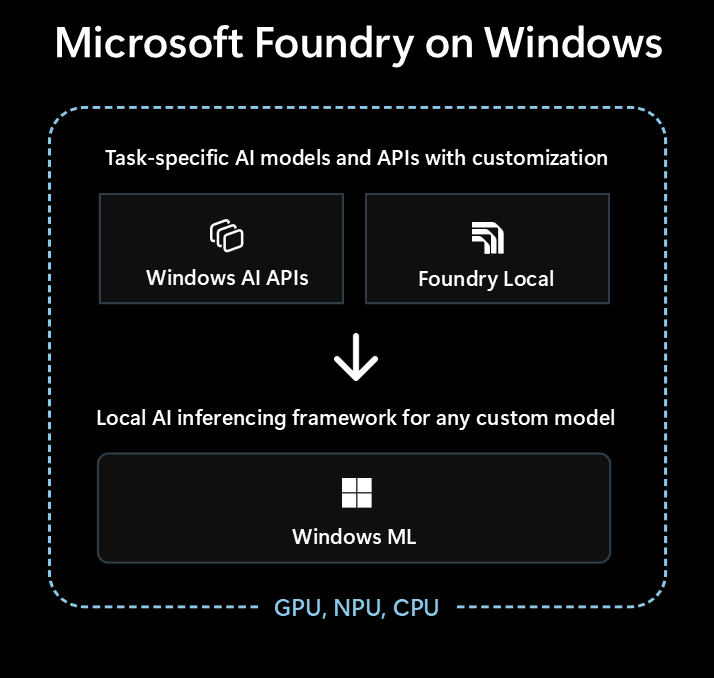

Microsoft Foundry on Windows adalah solusi utama bagi pengembang yang ingin mengintegrasikan kemampuan AI lokal ke dalam aplikasi Windows mereka.

Microsoft Foundry on Windows memberikan kepada pengembang...

- Model dan API AI yang siap digunakan melalui Windows AI APIs dan Foundry Local

- Kerangka kerja inferensi AI untuk menjalankan model apa pun secara lokal melalui Windows ML

Terlepas dari apakah Anda baru menggunakan AI, atau pakar Pembelajaran Mesin (ML) berpengalaman, Microsoft Foundry on Windows memiliki sesuatu untuk Anda.

Model dan API AI siap pakai

Aplikasi Anda dapat dengan mudah menggunakan model dan API AI lokal berikut dalam waktu kurang dari satu jam. Distribusi dan waktu proses file model ditangani oleh Microsoft, dan model dibagikan ke seluruh aplikasi. Menggunakan model dan API ini hanya mengambil beberapa baris kode, tidak ada keahlian ML yang diperlukan.

| Jenis model atau API | Apa itu | Opsi dan perangkat yang didukung |

|---|---|---|

| Model Bahasa Besar (LLM) | Model teks generatif | Phi Silica melalui AI APIs (mendukung penyempurnaan) atau 20+ model OSS LLM melalui Foundry Local Lihat LLM lokal untuk mempelajari selengkapnya. |

| Deskripsi Gambar | Mendapatkan deskripsi teks bahasa alami dari gambar | Deskripsi Gambar melalui AI APIs (Copilot+ PC) |

| Ekstraktor Latar Depan Gambar | Segmentasi latar depan gambar | Ekstraktor Latar Depan Gambar melalui AI APIs (Copilot+ PC) |

| Pembuatan Gambar | Membuat gambar dari teks | Pembuatan Gambar melalui AI APIs (Copilot+ PC) |

| Hapus Objek Gambar | Menghapus objek dari gambar | Hapus Objek Gambar melalui AI APIs (PC dengan Copilot+) |

| Ekstraktor Objek Gambar | Segmentasikan objek tertentu dalam gambar | Ekstraktor Objek Gambar melalui AI APIs (Copilot+ PC) |

| Super Resolusi Gambar | Meningkatkan resolusi gambar | Resolusi Super Gambar melalui AI APIs (Copilot+ PC) |

| Pencarian Semantik | Mencari teks dan gambar secara semantik | Pencarian Konten Aplikasi melalui AI APIs (Copilot+ PC) |

| Pengenalan Ucapan | Mengonversi ucapan menjadi teks | Berbisik melalui Foundry Local atau Pengenalan Ucapan melalui Windows SDK Lihat Pengenalan Ucapan untuk mempelajari selengkapnya. |

| Pengenalan Teks (OCR) | Mengenali teks dari gambar | OCR melalui AI APIs (Copilot+ PC) |

| Resolusi Super Video (VSR) | Meningkatkan resolusi video | Resolusi Super Video melalui AI APIs (Copilot+ PC) |

Menggunakan model lain dengan Windows ML

Anda dapat menggunakan berbagai model dari Hugging Face atau sumber lain, atau bahkan melatih model Anda sendiri, dan menjalankannya secara lokal pada PC Windows 10 dan yang lebih baru menggunakan Windows ML(kompatibilitas dan performa model akan bervariasi berdasarkan perangkat keras perangkat).

Lihat menemukan atau melatih model untuk digunakan dengan Windows ML pelajari lebih lanjut.

Opsi mana yang harus dipilih lebih dulu

Ikuti pohon keputusan ini untuk memilih pendekatan terbaik untuk aplikasi dan skenario Anda:

Periksa apakah Windows AI APIs bawaan mencakup skenario Anda dan Anda menargetkan PC Copilot+. Ini adalah jalur tercepat ke pasar dengan upaya pengembangan minimal.

Jika Windows AI APIs tidak memiliki apa yang Anda butuhkan, atau Anda perlu mendukung Windows 10 dan yang lebih baru, pertimbangkan Foundry Local untuk LLM atau skenario suara ke teks.

Jika Anda memerlukan model kustom, ingin memanfaatkan model yang ada dari Hugging Face atau sumber lain, atau memiliki persyaratan model tertentu yang tidak tercakup oleh opsi di atas, Windows ML memberi Anda fleksibilitas untuk menemukan atau melatih model Anda sendiri (dan mendukung Windows 10 dan yang lebih baru).

Aplikasi Anda juga dapat menggunakan kombinasi ketiga teknologi ini.

Teknologi yang tersedia untuk AI lokal

Teknologi berikut tersedia dalam Microsoft Foundry on Windows:

| Windows AI APIs | Foundry Local | Windows ML | |

|---|---|---|---|

| Apa itu | Model dan API AI siap pakai di berbagai jenis tugas, yang dioptimalkan untuk PC Copilot+ | LLM siap pakai dan model suara ke teks | ONNX Runtime kerangka kerja untuk menjalankan model yang Anda temukan atau latih |

| Perangkat yang didukung | Copilot+ PC | PC Windows 10 dan versi yang lebih baru serta lintas platform (Performa bervariasi berdasarkan perangkat keras yang tersedia, tidak semua model tersedia) |

Pc Windows 10 dan yang lebih baru, dan lintas platform melalui sumber terbuka ONNX Runtime (Performa bervariasi berdasarkan perangkat keras yang tersedia) |

| Jenis model dan API tersedia |

LLM Deskripsi Gambar Ekstraktor Latar Depan Gambar Pembuatan Gambar Hapus Objek Gambar Ekstraktor Objek Gambar Super Resolusi Gambar Pencarian Semantik Pengenalan Teks (OCR) Resolusi Super Video |

LLM (banyak) suara ke teks Telusuri 20+ model yang tersedia |

Menemukan atau melatih model Anda sendiri |

| Distribusi model | Dihosting oleh Microsoft, diperoleh saat runtime, dan dibagikan di seluruh aplikasi | Dihosting oleh Microsoft, diperoleh saat runtime, dan dibagikan di seluruh aplikasi | Distribusi yang ditangani oleh aplikasi Anda (pustaka aplikasi dapat berbagi model di seluruh aplikasi) |

| Pelajari lebih lanjut | AI APIs Membaca dokumen | Foundry Local Membaca dokumen | Windows ML Membaca dokumen |

Microsoft Foundry on Windows juga termasuk alat pengembang seperti AI Toolkit untuk Visual Studio Code dan AI Dev Gallery yang akan membantu Anda berhasil membangun kemampuan AI.

AI Toolkit untuk Visual Studio Code adalah Ekstensi Visual Studio Code yang memungkinkan Anda mengunduh dan menjalankan model AI secara lokal, termasuk akses ke akselerasi perangkat keras untuk performa dan skala yang lebih baik melalui DirectML. AI Toolkit dapat juga membantu Anda dengan:

- Menguji model di taman bermain intuitif atau di aplikasi Anda dengan REST API.

- Menyempurnakan model AI Anda, baik secara lokal maupun di cloud (pada komputer virtual) untuk membuat keterampilan baru, meningkatkan keandalan respons, mengatur nada dan format respons.

- Menyempurnakan model bahasa kecil (SLM) populer, seperti Phi-3 dan Mistral.

- Sebarkan fitur AI Anda baik ke cloud atau dengan aplikasi yang berjalan di perangkat.

- Manfaatkan akselerasi perangkat keras untuk performa yang lebih baik dengan fitur AI menggunakan DirectML. DirectML adalah API tingkat rendah yang memungkinkan perangkat keras perangkat Windows Anda mempercepat performa model ML menggunakan GPU perangkat atau NPU. Memasangkan DirectML dengan ONNX Runtime biasanya merupakan cara paling mudah bagi pengembang untuk membawa AI yang dipercepat perangkat keras kepada pengguna mereka dalam skala besar. Pelajari lebih lanjut: Gambaran Umum DirectML.

- Mengukur dan memvalidasi model untuk digunakan pada NPU dengan menggunakan kemampuan konversi model

Ide untuk memanfaatkan AI lokal

Beberapa cara agar aplikasi Windows dapat memanfaatkan AI lokal untuk meningkatkan fungsionalitas dan pengalaman penggunanya meliputi:

- Aplikasi dapat menggunakan model AI LLM Generatif untuk memahami topik kompleks untuk meringkas, menulis ulang, melaporkan, atau memperluas.

- Aplikasi dapat menggunakan model LLM untuk mengubah konten bentuk bebas menjadi format terstruktur yang dapat dipahami aplikasi Anda.

- Aplikasi dapat menggunakan model Pencarian Semantik yang memungkinkan pengguna mencari konten dengan makna dan menemukan konten terkait dengan cepat.

- Aplikasi dapat menggunakan model pemrosesan bahasa alami untuk alasan persyaratan bahasa alami yang kompleks, dan merencanakan dan menjalankan tindakan untuk mencapai permintaan pengguna.

- Aplikasi dapat menggunakan model manipulasi gambar untuk memodifikasi gambar, menghapus, atau menambahkan subjek, skala besar, atau menghasilkan konten baru secara cerdas.

- Aplikasi dapat menggunakan model diagnostik prediktif untuk membantu mengidentifikasi dan memprediksi masalah serta membantu memandu pengguna atau melakukannya untuk mereka.

Menggunakan Model AI Cloud

Jika menggunakan fitur AI lokal bukan jalur yang tepat untuk Anda, menggunakan model dan sumber daya Cloud AI dapat menjadi solusi.

Menggunakan praktik AI yang Bertanggung Jawab

Setiap kali Anda menggabungkan fitur AI di aplikasi Windows Anda , sebaiknya ikuti panduan Mengembangkan Aplikasi dan Fitur AI Generatif yang Bertanggung Jawab pada Windows .