Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

SI APPLICA A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Suggerimento

Provare Data Factory in Microsoft Fabric, una soluzione di analisi all-in-one per le aziende. Microsoft Fabric copre tutto, dallo spostamento dati al data science, all'analisi in tempo reale, alla business intelligence e alla creazione di report. Vedere le informazioni su come iniziare una nuova prova gratuita.

Benvenuti in Azure Data Factory Questo articolo illustra come creare la prima data factory e la pipeline entro cinque minuti.

Il modello di Azure Resource Manager in questo articolo crea e configura tutti gli elementi necessari. È quindi possibile passare alla data factory demo e attivare la pipeline, che sposta alcuni dati di esempio da una cartella di Archiviazione BLOB di Azure a un'altra.

Prerequisiti

Se non si ha una sottoscrizione di Azure, creare un account gratuito prima di iniziare.

Riepilogo video

Il video seguente fornisce una panoramica dell'esempio in questo articolo.

Passaggio 1: Usare la demo per creare risorse

In questo scenario dimostrativo, si usa l'attività di copia nella data factory per copiare un BLOB denominato moviesDB2.csv da una cartella di input nell'Archiviazione BLOB di Azure a una cartella di output. In uno scenario reale, questa operazione di copia potrebbe avvenire tra una delle numerose origini dati supportate e i sink disponibili nel servizio. Potrebbe anche comportare trasformazioni nei dati.

Selezionare il pulsante seguente.

Selezionando il pulsante vengono create le risorse di Azure seguenti:

- Un account di Azure Data Factory

- Una data factory contenente una pipeline con un'attività di copia

- Un account di Archiviazione BLOB di Azure con moviesDB2.csv caricato in una cartella di input come origine

- Un servizio collegato per collegare la data factory a Blob Storage

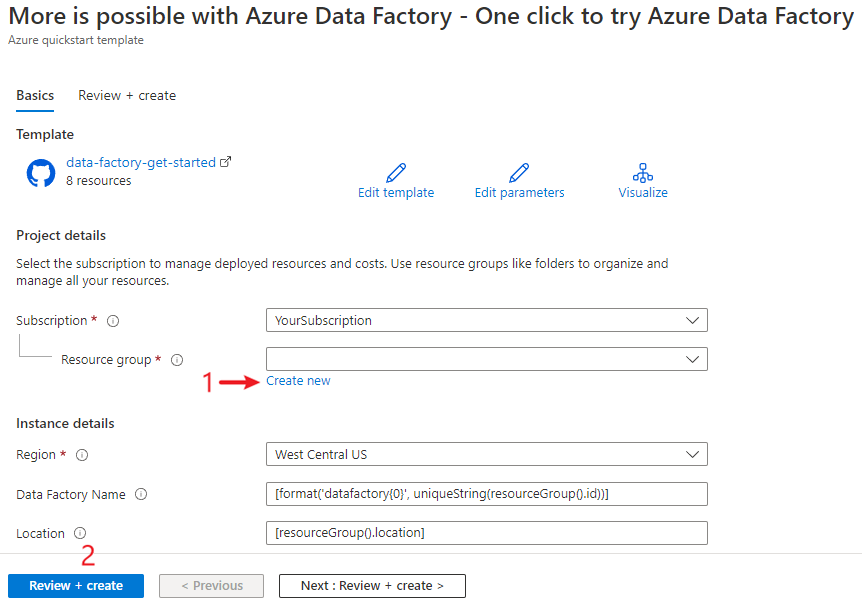

Si viene indirizzati alla pagina di configurazione per distribuire il modello. In questa pagina:

In Gruppo di risorse selezionare Crea nuovo per creare un gruppo di risorse. È possibile lasciare tutti gli altri valori con i valori predefiniti.

Selezionare Rivedi e crea e quindi crea per distribuire le risorse.

Note

L'utente che distribuisce il modello deve assegnare un ruolo a un'identità gestita. Questo passaggio richiede autorizzazioni che possono essere concesse tramite il ruolo Proprietario, Amministratore accesso utenti o Operatore identità gestita.

Tutte le risorse di questa demo vengono create nel nuovo gruppo di risorse, in modo da poterle pulire facilmente in un secondo momento.

Passaggio 2: Esaminare le risorse distribuite

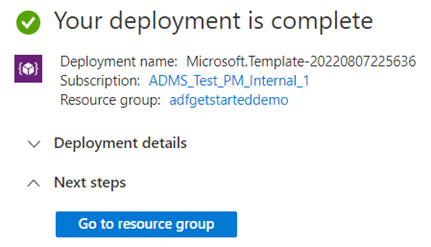

Nel messaggio che mostra il completamento della distribuzione, selezionare Vai al gruppo di risorse.

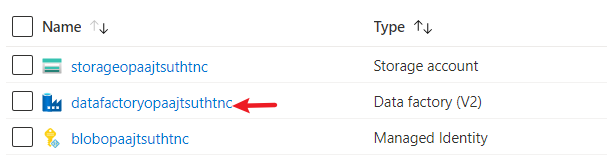

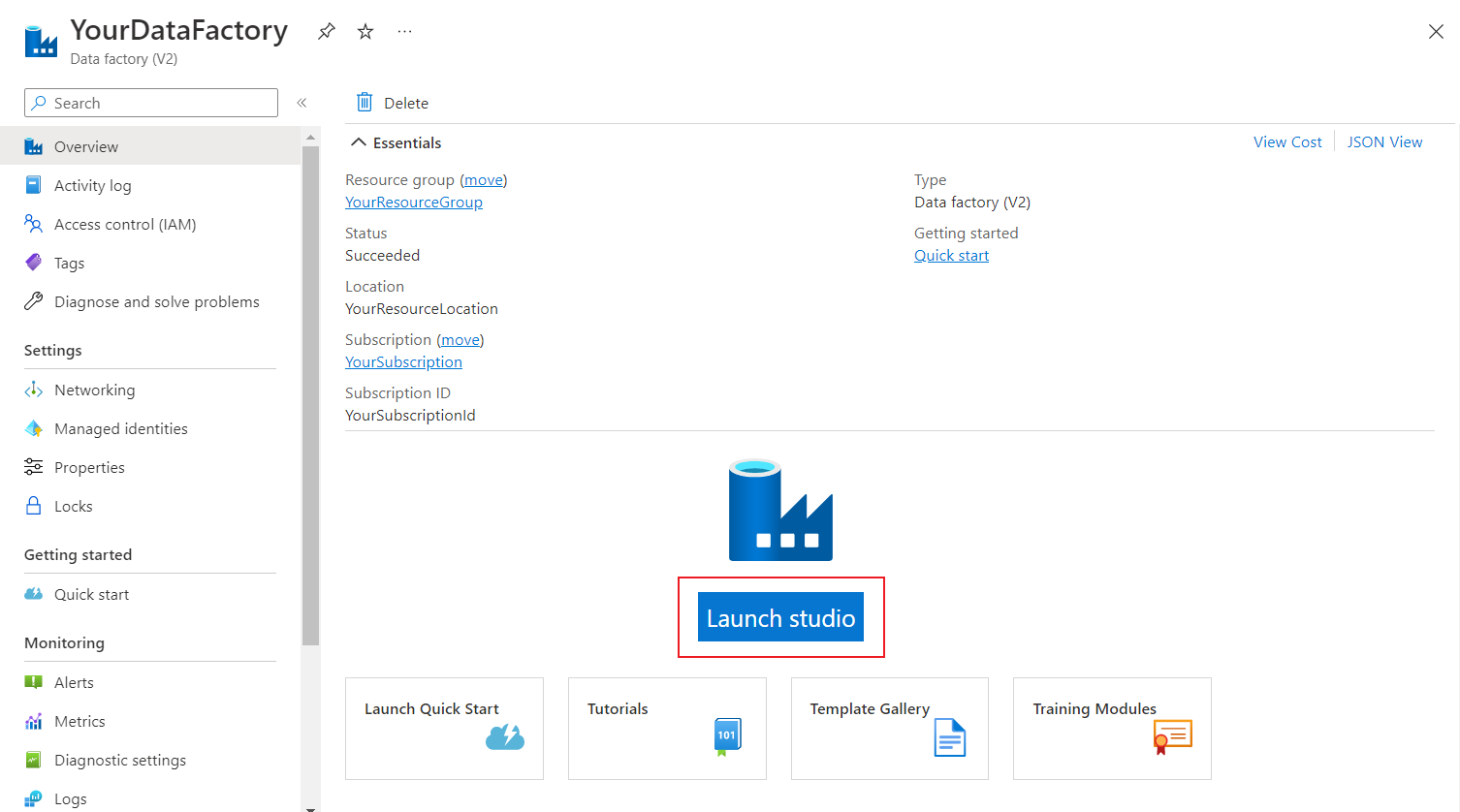

Il gruppo di risorse include la nuova data factory, l'account di Archiviazione BLOB e l'identità gestita creata dalla distribuzione. Selezionare la data factory nel gruppo di risorse per visualizzarla.

Selezionare il pulsante Avvia studio .

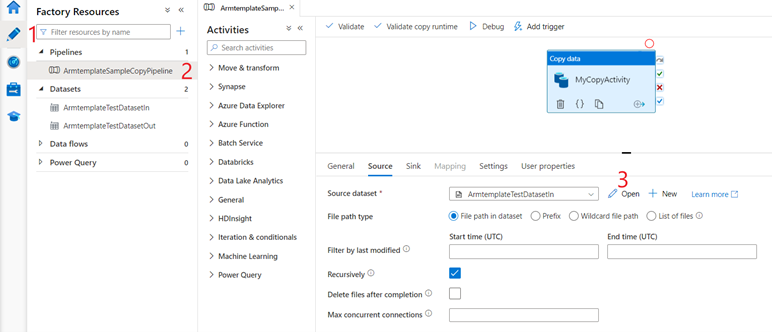

In Azure Data Factory Studio:

- Selezionare la scheda Autore

.

. - Selezionare la pipeline creata dal modello.

- Controllare i dati di origine selezionando Apri.

- Selezionare la scheda Autore

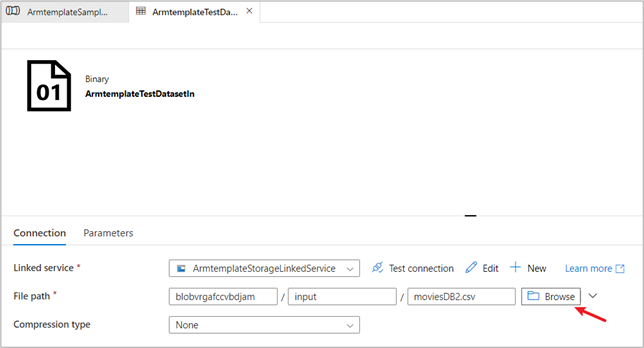

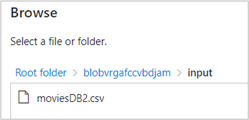

Nel set di dati di origine selezionare Sfoglia per visualizzare il file di input creato per la demo.

Si noti il file moviesDB2.csv, già caricato nella cartella di input.

Passaggio 3: Attivare la pipeline demo per l'esecuzione

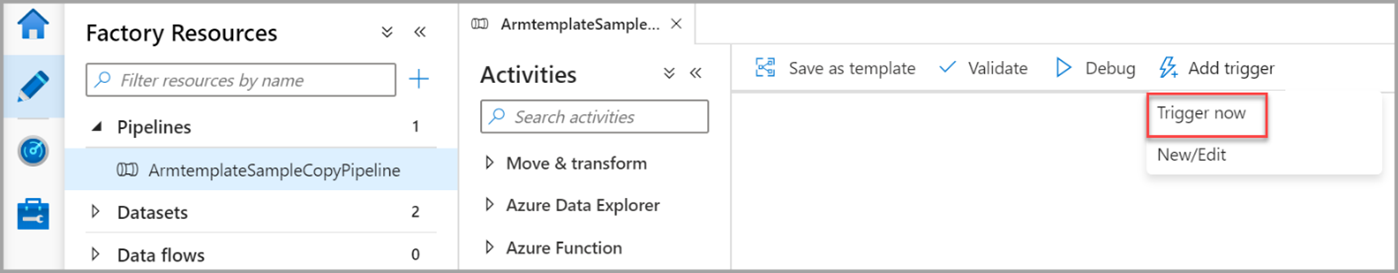

Selezionare Aggiungi trigger e quindi Attiva ora.

Nel riquadro destro, in Esecuzione pipeline, selezionare OK.

Monitorare la pipeline

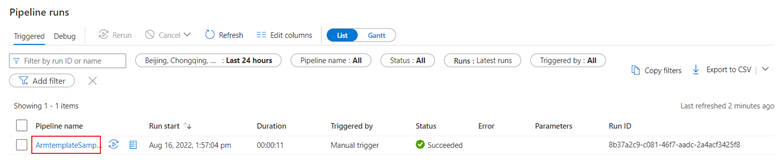

Selezionare la scheda Monitoraggio

. Questa scheda offre una panoramica delle esecuzioni della pipeline, compresi l’ora di inizio e lo stato.

. Questa scheda offre una panoramica delle esecuzioni della pipeline, compresi l’ora di inizio e lo stato.

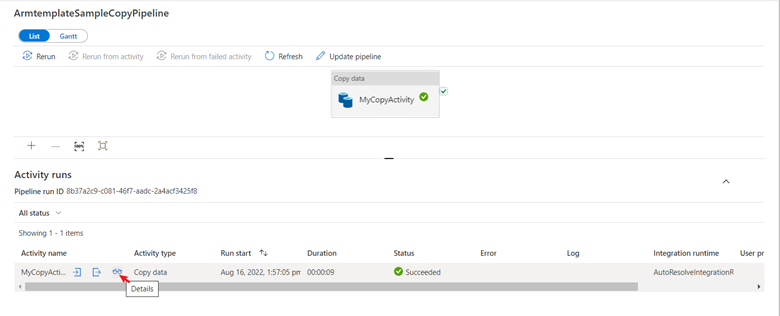

In questo avvio rapido la pipeline ha un solo tipo di attività: Copia dati. Selezionare il nome della pipeline per visualizzare i dettagli dei risultati dell'esecuzione dell'attività di copia.

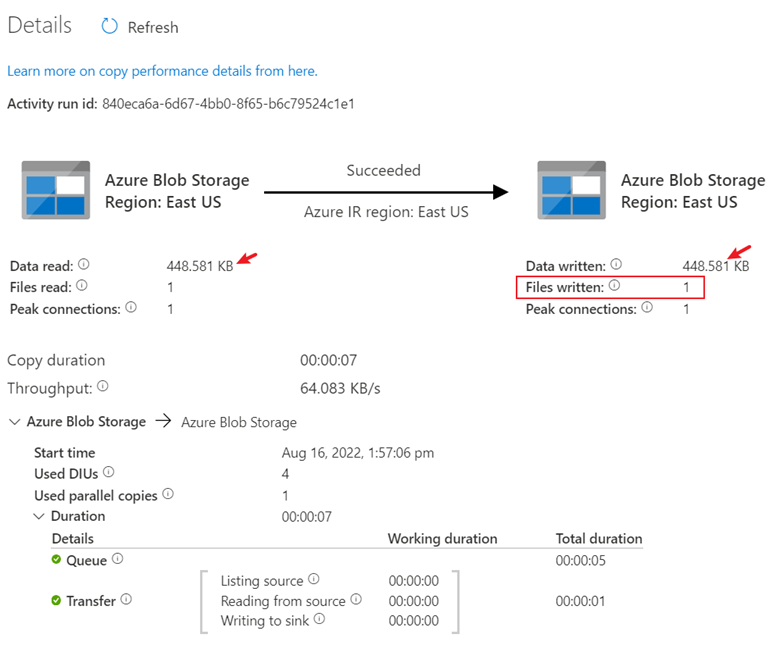

Selezionare l'icona Dettagli per visualizzare il processo di copia dettagliato. Nei risultati, le dimensioni di lettura e scrittura deidati sono uguali e un file è stato letto e scritto. Queste informazioni dimostrano che tutti i dati sono stati copiati correttamente nella destinazione.

Pulire le risorse

È possibile pulire tutte le risorse create in questo articolo in uno dei due modi seguenti:

È possibile eliminare l’intero gruppo di risorse di Azure, che include tutte le risorse create al suo interno.

Se si desidera mantenere intatte alcune risorse, passare al gruppo di risorse ed eliminare solo le risorse specifiche da rimuovere.

Ad esempio, se si usa questo modello per creare una data factory da usare in un'altra esercitazione, è possibile eliminare le altre risorse ma mantenere solo la data factory.

Contenuti correlati

In questo articolo è stata creata una data factory contenente una pipeline con un'attività di copia. Per altre informazioni su Azure Data Factory, continuare con il modulo di training e l'articolo seguente: