Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Importante

Questa funzionalità è in versione beta. Gli amministratori dell'account possono controllare l'accesso a questa funzionalità dalla pagina Anteprime .

Che cos'è gateway di intelligenza artificiale (beta)?

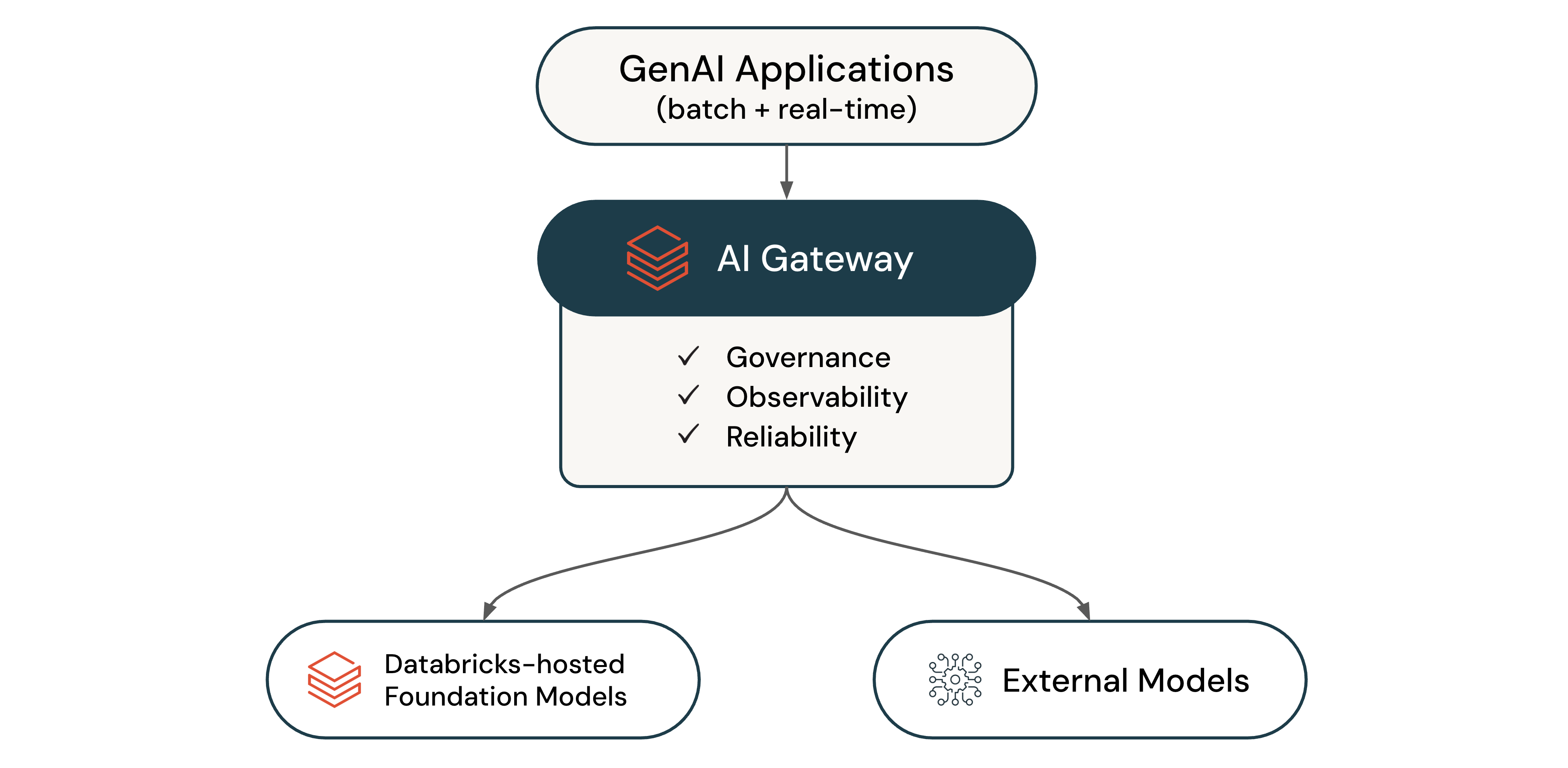

Il gateway di intelligenza artificiale (Beta) è il piano di controllo aziendale per la governance degli endpoint LLM e degli agenti di codifica. Usarlo per analizzare l'utilizzo, configurare le autorizzazioni e gestire la capacità tra i provider.

Con il gateway di intelligenza artificiale è possibile:

- Analizza il modo in cui gli agenti di codifica e LLM vengono usati nella vostra organizzazione

- Gestire l'accesso ai modelli ospitati e esterni di Azure Databricks

- Accedi il traffico LLM tra tutti gli endpoint su Unity Catalog

- Monitorare l'integrità degli endpoint e la disponibilità del fornitore

- Applicare i limiti di frequenza

- Instradare il traffico in modo intelligente tra provider per l'affidabilità e il bilanciamento del carico

- Cambiare provider e modelli senza modifiche al codice

Funzionalità supportate

La tabella seguente definisce le funzionalità del gateway di intelligenza artificiale disponibili:

| Caratteristica / Funzionalità | Descrzione |

|---|---|

| Permissions | Controllare chi può accedere agli endpoint. |

| Rilevamento dell'utilizzo | Monitorare l'utilizzo e i costi usando le tabelle di sistema. |

| tabelle di inferenza | Monitorare e controllare le richieste e le risposte nelle tabelle Delta del catalogo Unity. |

| Metriche operative | Monitorare l'utilizzo in tempo reale. |

| Limitazioni di velocità | Applicare limiti di consumo a livello di endpoint, utente o gruppo. |

| Fallbacks | Aumentare l'affidabilità eseguendo il routing a più provider in caso di errori. |

Annotazioni

Le funzionalità del gateway di intelligenza artificiale non comportano addebiti durante la versione beta.

Usare il gateway di intelligenza artificiale

Azure Databricks fornisce endpoint di AI Gateway per i popolari modelli linguistici di grandi dimensioni (LLMs). È possibile creare nuovi endpoint per gestire gli agenti di codifica e altre applicazioni.

Per iniziare, vedere Configurare gli endpoint del gateway di intelligenza artificiale. Per eseguire query sugli endpoint, vedere Eseguire query sugli endpoint del gateway di intelligenza artificiale. Per integrare agenti di codifica come Cursor, Gemini CLI, Codex CLI e Claude Code, vedere Integrazione con agenti di codifica.

Avvio rapido delle query

L'esempio seguente illustra come eseguire query su un endpoint del gateway di intelligenza artificiale usando Python e il client OpenAI:

from openai import OpenAI

import os

# To get a Databricks token, see https://docs.databricks.com/dev-tools/auth/pat

DATABRICKS_TOKEN = os.environ.get('DATABRICKS_TOKEN')

client = OpenAI(

api_key=DATABRICKS_TOKEN,

base_url="https://<ai-gateway-url>/mlflow/v1"

)

chat_completion = client.chat.completions.create(

messages=[

{"role": "user", "content": "Hello!"},

{"role": "assistant", "content": "Hello! How can I assist you today?"},

{"role": "user", "content": "What is Databricks?"},

],

model="databricks-gpt-5-2",

max_tokens=256

)

print(chat_completion.choices[0].message.content)

Sostituire <ai-gateway-url> con l'URL dell'endpoint del gateway di intelligenza artificiale.

Passaggi successivi

- Configurare gli endpoint del gateway di intelligenza artificiale

- Eseguire query sugli endpoint del gateway di intelligenza artificiale

- Integrazione con agenti di codifica

- Monitorare l'utilizzo per gli endpoint del gateway di intelligenza artificiale

- Monitorare i modelli usando le tabelle di inferenza