Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Questo articolo illustra come iniziare a usare il servizio Azure OpenAI in IntelliJ IDEA. Illustra come usare modelli di chat come GPT-3.5-Turbo e GPT-4 per testare ed sperimentare parametri e origini dati diversi.

Prerequisiti

Un Kit di Sviluppo Java (JDK) supportato. Per altre informazioni sui JDK disponibili per lo sviluppo in Azure, vedere supporto Java in Azure e Azure Stack.

IntelliJ IDEA, Ultimate o Community Edition.

Azure Toolkit for IntelliJ. Per ulteriori informazioni, vedere Installa Azure Toolkit per IntelliJ. È anche necessario accedere all'account Azure per Azure Toolkit for IntelliJ. Per ulteriori informazioni, vedere le istruzioni per l'accesso per Azure Toolkit for IntelliJ (e).

Una sottoscrizione di Azure: crearne una gratuitamente.

Accesso concesso ad Azure OpenAI nella sottoscrizione di Azure desiderata.

Attualmente, l'accesso a questo servizio viene concesso solo su richiesta. È possibile richiedere l'accesso ad Azure OpenAI completando il modulo in Richiedi accesso al servizio OpenAI di Azure.

Una risorsa del servizio OpenAI di Azure con i modelli distribuiti

gpt-35-turboogpt-4. Per altre informazioni sulla distribuzione del modello, vedere Creare e distribuire una risorsa del Servizio OpenAI di Azure.

Installare e accedere

La procedura seguente illustra il processo di accesso di Azure nell'ambiente di sviluppo IntelliJ:

Se il plug-in non è installato, vedere Azure Toolkit for IntelliJ.

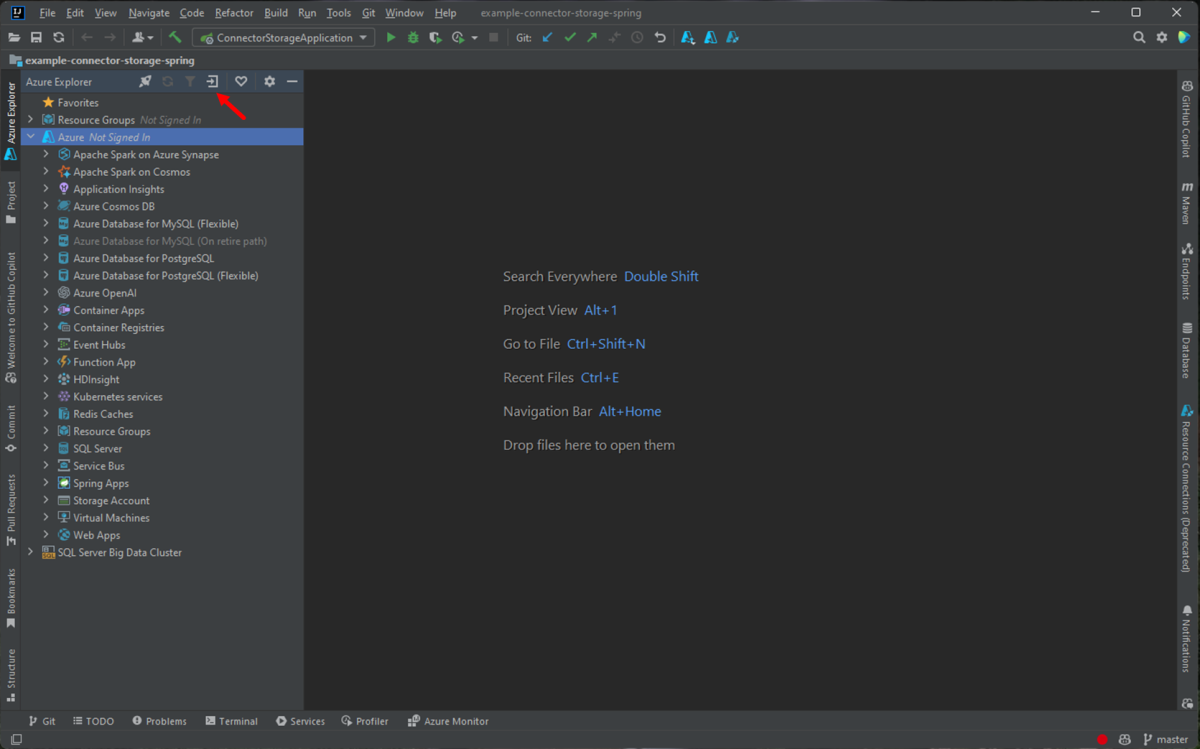

Per accedere all'account Azure, passare alla barra laterale di Azure Explorer a sinistra e quindi selezionare l'icona Di accesso ad Azure . In alternativa, è possibile passare a Strumenti, espandere Azure e quindi selezionare Accesso ad Azure.

Nella finestra Accesso ad Azure, selezionare OAuth 2.0 e quindi selezionare Accedi. Per altre opzioni di accesso, vedere Istruzioni di accesso per Azure Toolkit for IntelliJ.

Nel browser accedere con l'account che ha accesso alla risorsa OpenAI e quindi tornare a IntelliJ. Nella finestra di dialogo Seleziona sottoscrizioni selezionare la sottoscrizione da usare e quindi selezionare Seleziona.

Creare e distribuire una risorsa del Servizio OpenAI di Azure

Dopo il flusso di lavoro di accesso, fare clic con il pulsante destro del mouse sull'elemento Azure OpenAI in Azure Explorer e scegliere Crea servizio OpenAI di Azure.

Nella finestra di dialogo Crea servizio OpenAI di Azure specificare le informazioni seguenti e quindi selezionare OK:

- Nome: nome descrittivo per la risorsa del servizio Azure OpenAI, ad esempio MyOpenAIResource. Questo nome è anche il nome di dominio personalizzato nell'endpoint. Il nome della risorsa può includere solo caratteri alfanumerici e trattini e non può iniziare o terminare con un trattino.

- Area: la posizione dell'istanza. Alcuni modelli sono disponibili solo in aree specifiche. Per maggiori informazioni, vedere Modelli di servizio OpenAI di Azure..

- Sku: le risorse OpenAI standard di Azure vengono fatturate in base all'utilizzo dei token. Per altre informazioni, vedere Prezzi del servizio Azure OpenAI.

Prima di poter usare i completamenti della chat, è necessario implementare un modello. Fare clic con il pulsante destro del mouse sull'istanza di Azure OpenAI e scegliere Crea nuova distribuzione. Nella finestra di dialogo popup Crea distribuzione OpenAI di Azure specificare le informazioni seguenti e quindi selezionare OK:

- Nome della distribuzione: scegliere attentamente un nome. Il nome di distribuzione viene usato nel codice per chiamare il modello tramite le librerie client e le API REST.

- Modello: selezionare un modello. La disponibilità del modello varia in base all'area geografica. Per un elenco dei modelli disponibili per area, vedere la sezione Tabella di riepilogo dei modelli e disponibilità dell'area dei modelli di servizio OpenAI di Azure.

Il toolkit visualizza un messaggio di stato quando la distribuzione è completa e pronta per l'uso.

Interagire con Azure OpenAI usando prompt e impostazioni

Fare clic con il pulsante destro del mouse sulla risorsa OpenAI di Azure e quindi scegliere Apri in AI Playground.

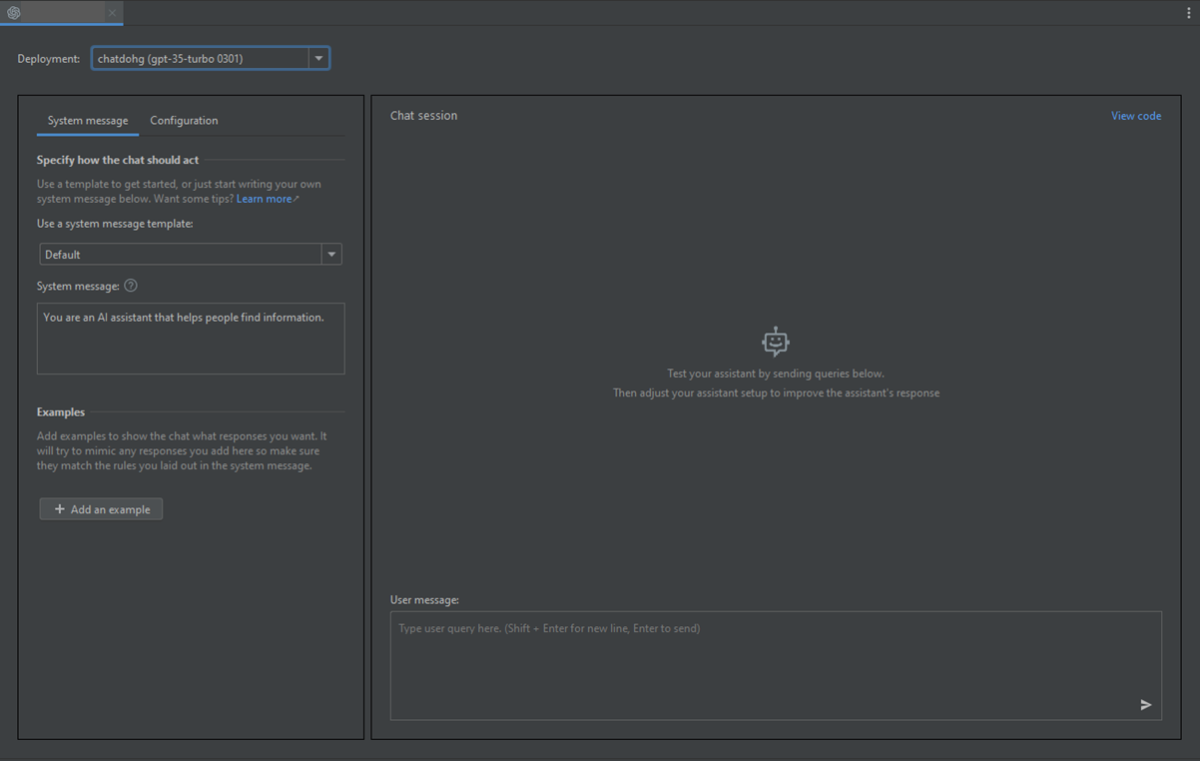

È possibile iniziare a esplorare le funzionalità OpenAI tramite il playground chat di Azure OpenAI Studio in IntelliJ IDEA.

Per attivare il completamento, è possibile immettere un testo come richiesta. Il modello genera il completamento e tenta di corrispondere al contesto o al modello.

Per avviare una sessione di chat, seguire questa procedura:

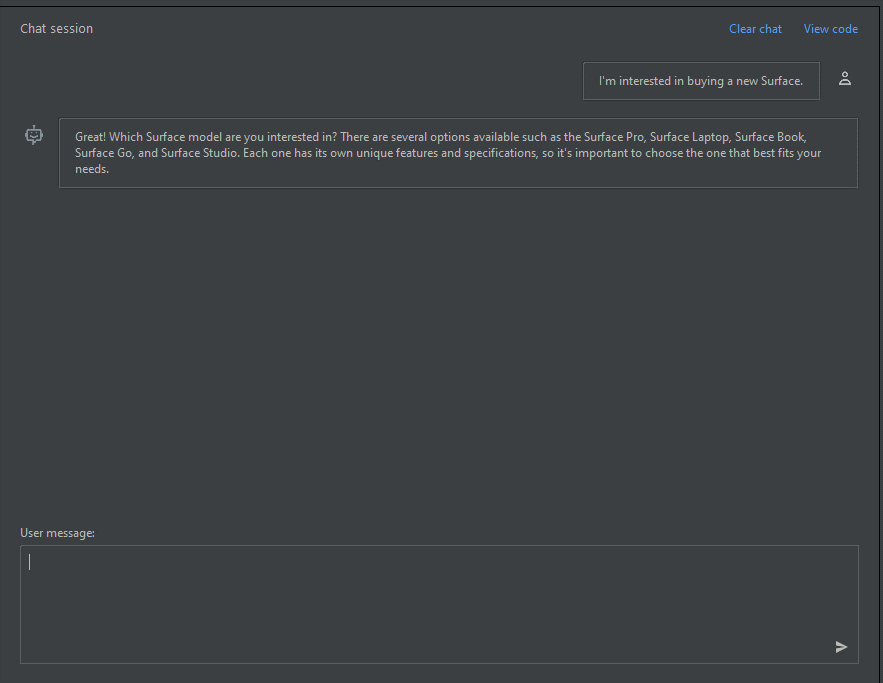

Nel riquadro della sessione di chat puoi iniziare con una semplice richiesta come questa: "Sono interessato a acquistare un nuovo Surface". Dopo aver digitato il prompt, selezionare Invia. Si riceve una risposta simile all'esempio seguente:

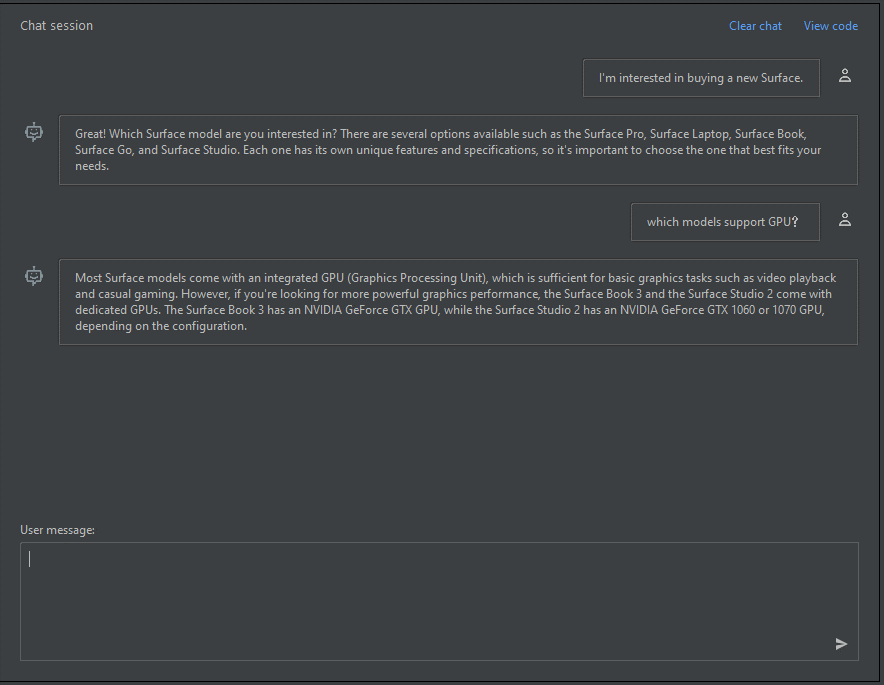

Great! Which Surface model are you interested in? There are several options available such as the Surface Pro, Surface Laptop, Surface Book, Surface Go, and Surface Studio. Each one has its own unique features and specifications, so it's important to choose the one that best fits your needs.Immettere una domanda di completamento, ad esempio: "Quali modelli supportano GPU?" e selezionare Invia. Si riceve una risposta simile all'esempio seguente:

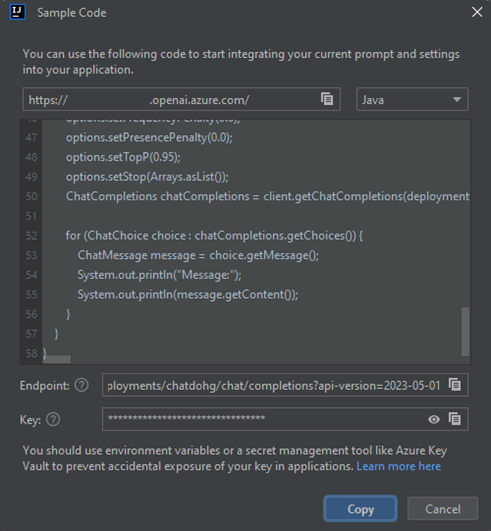

Most Surface models come with an integrated GPU (Graphics Processing Unit), which is sufficient for basic graphics tasks such as video playback and casual gaming. However, if you're looking for more powerful graphics performance, the Surface Book 3 and the Surface Studio 2 come with dedicated GPUs. The Surface Book 3 has an NVIDIA GeForce GTX GPU, while the Surface Studio 2 has an NVIDIA GeForce GTX 1060 or 1070 GPU, depending on the configuration.Ora che si ha una conversazione di base, selezionare Visualizza codice dal riquadro e si dispone di una riproduzione del codice dietro l'intera conversazione fino a questo momento. È possibile visualizzare gli esempi di codice basati su Java SDK, curl e JSON che corrispondono alla sessione e alle impostazioni della chat, come illustrato nello screenshot seguente:

È quindi possibile selezionare Copia per prendere questo codice e scrivere un'applicazione per eseguire la stessa attività che stai attualmente svolgendo con il playground.

Impostazioni

È possibile selezionare la scheda Configurazione per impostare i parametri seguenti:

| Nome | Descrizione |

|---|---|

| Risposta massima | Imposta un limite per il numero di token che il modello può generare. I token totali (richiesta e risposta) che è possibile inviare dipendono dal modello distribuito: • gpt-35-turbo-1106 / 0125 – fino a 16 385 token • gpt-35-turbo-16k-0613 – fino a 16 385 token • gpt-4-turbo-2024-04-09 – fino a 128 000 token • gpt-4o-2024-05-13 – fino a 128 000 token Per l'elenco completo up-to-date dei limiti, vedere Tabella di riepilogo dei modelli e disponibilità dell'area. Verifica sempre che la somma dello spunto e del completamento previsto si adatti alla finestra di contesto del modello. |

| Temperatura | Controlla la casualità. Abbassando la temperatura, il modello produce risposte più ripetitive e deterministiche. Aumentando la temperatura, vengono generate risposte più impreviste o creative. Prova a regolare la temperatura o le probabilità principali, ma non entrambe. |

| Probabilità principali | Analogamente alla temperatura, controlla la casualità, ma usa un metodo diverso. Abbassare il valore delle probabilità principali restringe la selezione dei token del modello ai token più probabili. L'aumento del valore consente al modello di scegliere tra token con probabilità elevata e bassa. Prova a regolare la temperatura o le probabilità principali, ma non entrambe. |

| Sequenze di interruzione | Fa sì che il modello termini la sua risposta in un punto desiderato. La risposta del modello termina prima della sequenza specificata, quindi non contiene il testo della sequenza di interruzione. Per GPT-35-Turbo, l'uso di <|im_end|> garantisce che la risposta del modello non generi una query utente di follow-up. È possibile includere fino a quattro sequenze di interruzione. |

| Penalità di frequenza | Riduce la probabilità di ripetere un token in modo proporzionale in base alla frequenza con cui appare nel testo finora. Questa azione riduce la probabilità di ripetere esattamente lo stesso testo in una risposta. |

| Penalità di presenza | Riduce la possibilità di ripetere tutti i token visualizzati nel testo fino a questo momento. Ciò aumenta la probabilità di introdurre nuovi argomenti in una risposta. |

Pulire le risorse

Dopo aver completato il test del playground della chat, se si vuole pulire e rimuovere una risorsa OpenAI, è possibile eliminare la risorsa o il gruppo di risorse. L'eliminazione del gruppo di risorse elimina anche tutte le altre risorse associate. Per pulire le risorse, seguire questa procedura:

Per eliminare le risorse OpenAI di Azure, passare alla barra laterale di Azure Explorer a sinistra e individuare l'elemento Azure OpenAI .

Fare clic con il pulsante destro del mouse sul servizio Azure OpenAI che si vuole eliminare e quindi scegliere Elimina.

Per eliminare il gruppo di risorse, visitare il portale di Azure ed eliminare manualmente le risorse nella sottoscrizione.

Passaggi successivi

Per altre informazioni, vedere Informazioni su come usare i modelli GPT-35-Turbo e GPT-4.

Per altri esempi, controllare il repository GitHub degli esempi di Azure OpenAI.