Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Questo articolo illustra come tenere traccia ed eseguire il debug di processi Apache Spark in esecuzione nei cluster HDInsight. Eseguire il debug usando l'interfaccia utente yarn di Apache Hadoop, l'interfaccia utente di Spark e il server cronologia Spark. Si avvia un job Spark usando un notebook disponibile con il cluster Spark, Machine Learning: Analisi predittiva sui dati di ispezione degli alimenti usando MLLib. Usare la procedura seguente per tenere traccia di un'applicazione inviata usando anche qualsiasi altro approccio, ad esempio spark-submit.

Se non si ha una sottoscrizione di Azure, creare un account gratuito prima di iniziare.

Prerequisiti

Un cluster di Apache Spark su HDInsight. Per istruzioni, vedere Creare cluster Apache Spark in Azure HDInsight.

Si sarà già avviato il notebook Machine Learning: analisi predittiva dei dati del controllo degli alimenti tramite MLlib. Per istruzioni su come eseguire questo notebook, seguire il collegamento.

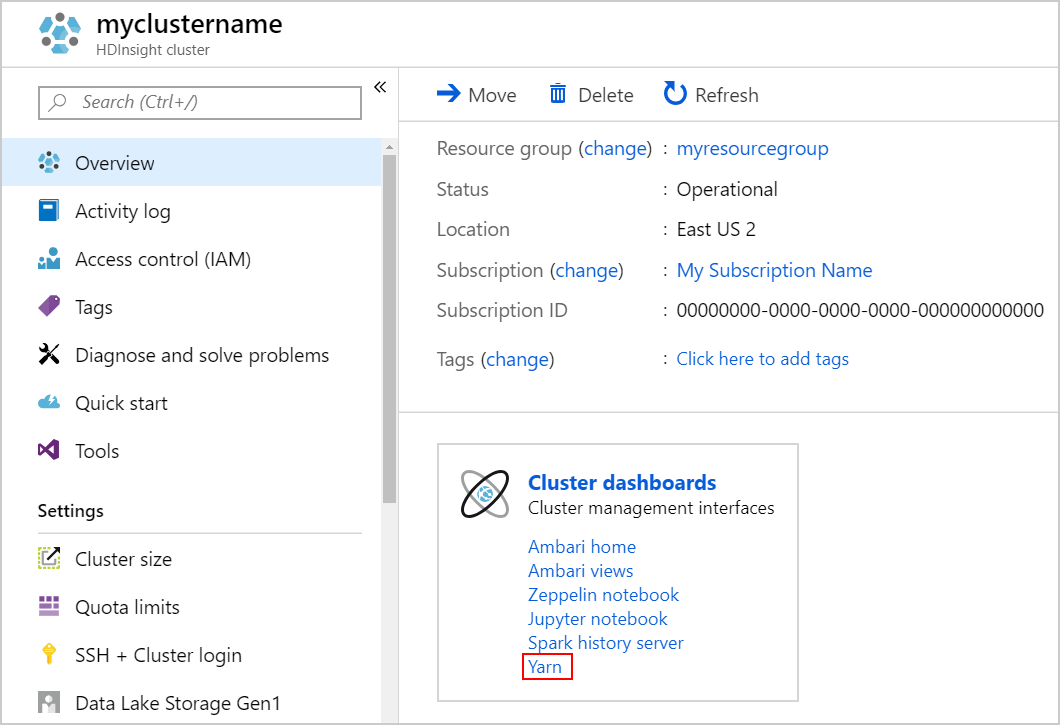

Tenere traccia di un'applicazione nell'interfaccia utente yarn

Avviare l'interfaccia utente YARN. Selezionare Yarn sotto Cluster dashboards.

Suggerimento

In alternativa, è anche possibile avviare l'interfaccia utente YARN dall'interfaccia utente di Ambari. Per avviare l'interfaccia utente di Ambari, selezionare Home page di Ambari in Dashboard del cluster. Dall'interfaccia utente di Ambari, passare a Rapidi Collegamenti>YARN> al Resource Manager attivo >all'interfaccia utente di Resource Manager.

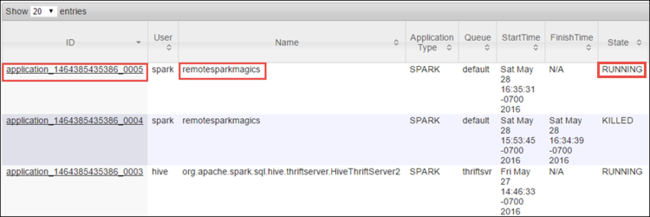

Poiché è stato avviato il processo Spark con Jupyter Notebooks, l'applicazione ha il nome remotesparkmagics (il nome per tutte le applicazioni avviate dai notebook). Selezionare l'ID applicazione associato al nome dell'applicazione per ottenere ulteriori informazioni sull'attività. Questa azione avvia la visualizzazione dell'applicazione.

Per tali applicazioni avviate dai notebook di Jupyter, lo stato è sempre IN ESECUZIONE fino a quando non si esce dal notebook.

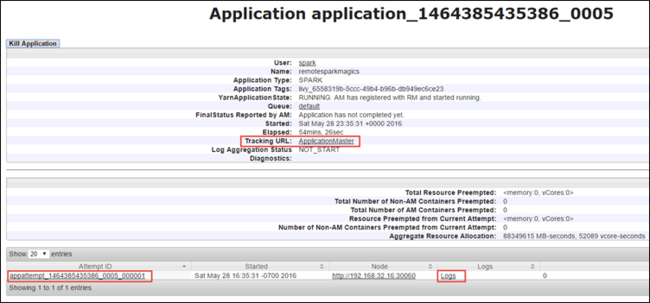

Dalla visualizzazione dell'applicazione è possibile eseguire il drill-down per individuare i contenitori associati all'applicazione e i log (stdout/stderr). È anche possibile avviare l'interfaccia utente di Spark facendo clic sul collegamento corrispondente all'URL di rilevamento, come illustrato di seguito.

Tenere traccia di un'applicazione nell'interfaccia utente di Spark

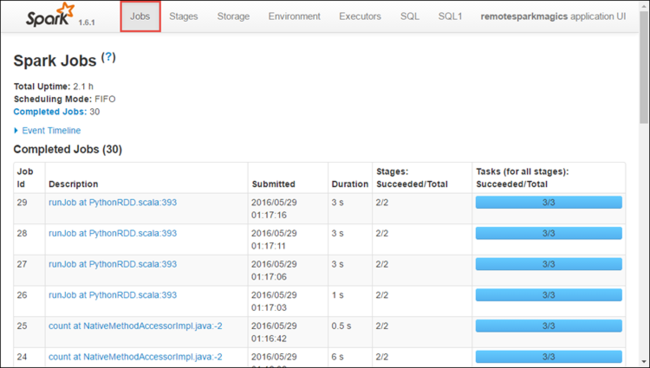

Nell'interfaccia utente di Spark è possibile eseguire il drill-down dei processi Spark generati dall'applicazione avviata in precedenza.

Per avviare l'interfaccia utente di Spark, dalla visualizzazione dell'applicazione selezionare il collegamento accanto all'URL di rilevamento, come mostrato nella schermata sopra. È possibile visualizzare tutti i processi Spark avviati dall'applicazione in esecuzione in Jupyter Notebook.

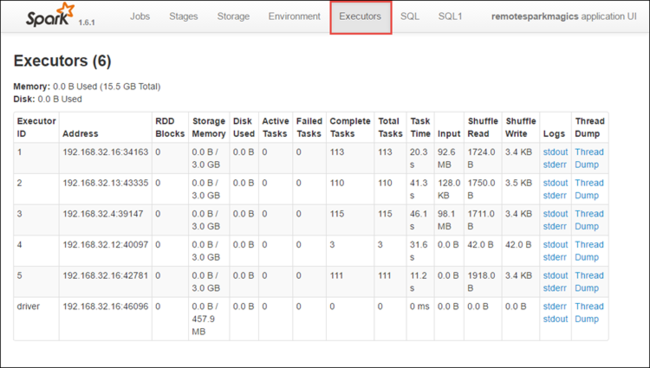

Selezionare la scheda Executors per visualizzare le informazioni di elaborazione e archiviazione per ogni executor. È anche possibile recuperare lo stack di chiamate selezionando il collegamento Thread Dump .You can also retrieve the call stack by select the Thread Dump link.

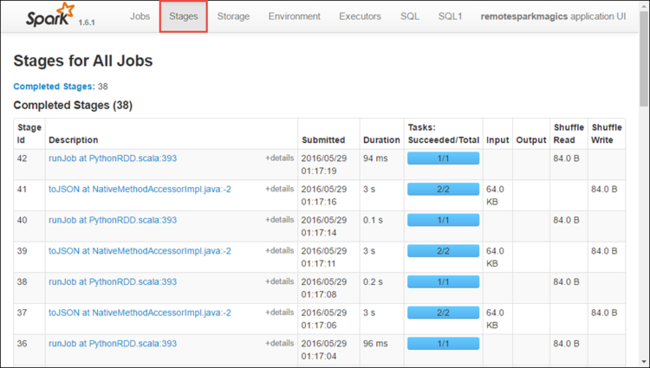

Selezionare la scheda Fasi per visualizzare le fasi associate all'applicazione.

Ogni fase può avere più attività per le quali è possibile visualizzare le statistiche di esecuzione, come illustrato di seguito.

Dettagli della scheda stage del server di cronologia Spark.

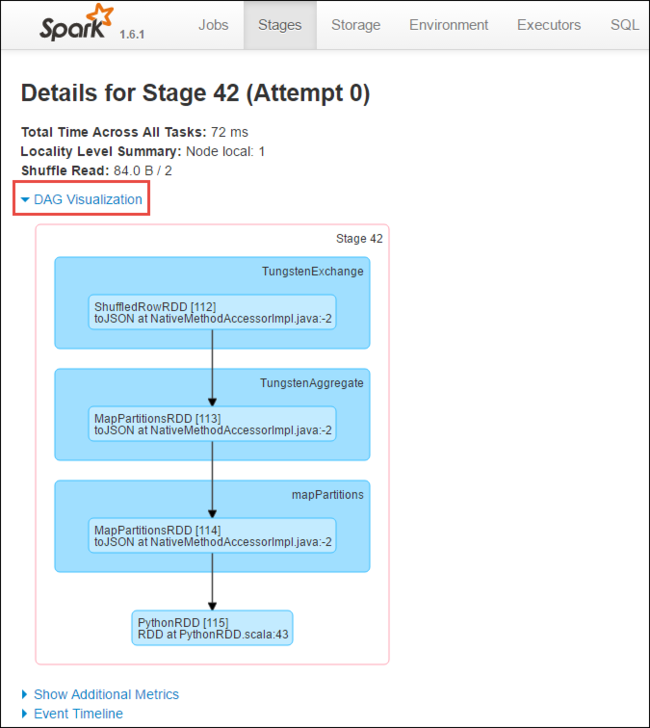

Dalla pagina dei dettagli della fase è possibile avviare la visualizzazione DAG. Espandere il collegamento Visualizzazione DAG nella parte superiore della pagina, come illustrato di seguito.

DAG o Direct Aclyic Graph rappresenta le diverse fasi dell'applicazione. Ogni casella blu nel grafico rappresenta un'operazione Spark richiamata dall'applicazione.

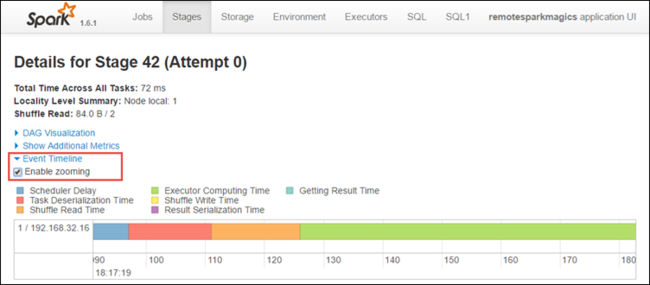

Dalla pagina dei dettagli della fase è anche possibile avviare la visualizzazione sequenza temporale dell'applicazione. Espandere il collegamento Sequenza temporale eventi nella parte superiore della pagina, come illustrato di seguito.

Questa immagine visualizza gli eventi Spark sotto forma di sequenza temporale. La visualizzazione sequenza temporale è disponibile a tre livelli, tra processi, all'interno di un processo e all'interno di una fase. L'immagine sopra mostra la vista sequenza temporale per una determinata fase.

Suggerimento

Se si seleziona la casella di controllo Abilita zoom , è possibile scorrere verso sinistra e destra nella visualizzazione sequenza temporale.

Altre schede nell'interfaccia utente di Spark forniscono anche informazioni utili sull'istanza di Spark.

- Scheda Archiviazione: se l'applicazione crea un set di dati RDD, è possibile trovare informazioni nella scheda Archiviazione.

- Scheda Ambiente: questa scheda fornisce informazioni utili sull'istanza di Spark, ad esempio:

- Versione di Scala

- Directory dei log eventi associata al cluster

- Numero di core executor per l'applicazione

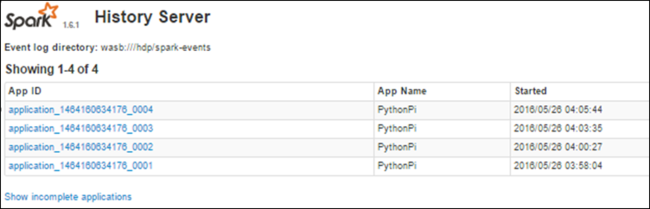

Trovare informazioni sui processi completati usando il server cronologia Spark

Al termine di un processo, le informazioni sul processo vengono mantenute nel server cronologia Spark.

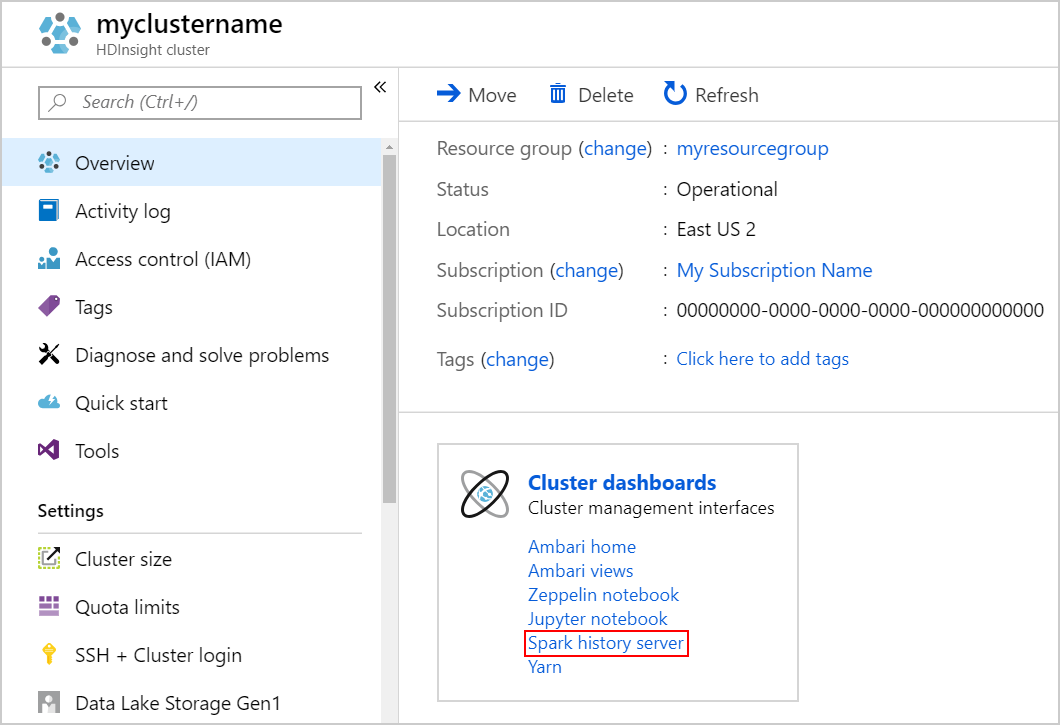

Per avviare il server della cronologia di Spark, nella pagina Panoramica, selezionare Server della cronologia di Spark nella dashboard del cluster.

Suggerimento

In alternativa, è anche possibile avviare l'interfaccia utente del server cronologia Spark dall'interfaccia utente di Ambari. Per avviare l'interfaccia utente di Ambari, nel pannello Panoramica selezionare home di Ambari sotto cluster dashboards. Dall'interfaccia utente di Ambari, naviga su Spark2>Quick Links>Spark2 History Server UI.

Vengono visualizzate tutte le applicazioni completate. Seleziona l'ID di un'applicazione per approfondire e ottenere ulteriori informazioni.