Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Ricerca di intelligenza artificiale di Azure può estrarre e indicizzare testo e immagini da documenti PDF archiviati in Archiviazione BLOB di Azure. Questa esercitazione illustra come creare una pipeline di indicizzazione multilingue descrivendo il contenuto visivo nel linguaggio naturale e incorporandolo insieme al testo del documento.

Dal documento di origine ogni immagine viene passata alla competenza Prompt GenAI (anteprima) per generare una descrizione testuale concisa. Queste descrizioni, insieme al testo originale del documento, vengono quindi incorporate in rappresentazioni vettoriali usando il modello text-embedding-3-large di Azure OpenAI. Il risultato è un singolo indice contenente contenuto ricercabile semanticamente da entrambe le modalità: testo e immagini verbalizzate.

In questa esercitazione si userà:

Documento PDF a 36 pagine che combina contenuti visivi avanzati, ad esempio grafici, infografici e pagine analizzate, con testo tradizionale.

Competenza Estrazione documenti per estrarre immagini e testo normalizzati.

Competenza Prompt GenAI (anteprima) per generare didascalie delle immagini, che sono descrizioni basate su testo del contenuto visivo, per la ricerca e l'ancoraggio.

Indice di ricerca configurato per archiviare incorporamenti di testo e immagini e supporto per la ricerca di somiglianza basata su vettori.

Questa esercitazione illustra un approccio a costi inferiori per l'indicizzazione di contenuto multimodale usando la funzione di Estrazione documenti e la didascalia delle immagini. Consente l'estrazione e la ricerca su testo e immagini da documenti in Archiviazione BLOB di Azure. Tuttavia, non include metadati di posizione per il testo, ad esempio numeri di pagina o aree di delimitazione.

Per una soluzione più completa che includa il layout di testo strutturato e i metadati spaziali, vedere Indicizzazione di BLOB con testo e immagini per scenari RAG multimodali attraverso la verbalizzazione delle immagini e l'abilità di Layout del documento.

Annotazioni

L'impostazione imageAction su generateNormalizedImages è necessaria per questa esercitazione e comporta un addebito aggiuntivo per l'estrazione di immagini in base ai prezzi di Ricerca di intelligenza artificiale di Azure.

Usando un client REST e le API REST di ricerca , è possibile:

- Configurare dati di esempio e configurare un'origine dati

azureblob - Creare un indice con supporto per incorporamenti di testo e immagini

- Definire un set di competenze con estrazione, didascalia e passaggi di incorporamento

- Creare ed eseguire un indicizzatore per elaborare e indicizzare il contenuto

- Eseguire una ricerca nell'indice che appena creato

Prerequisiti

Un account Azure con una sottoscrizione attiva. Creare un account gratuito.

Ricerca di intelligenza artificiale di Azure, piano tariffario Basic o superiore, con un'identità gestita. Creare un servizio o trovare un servizio esistente nella sottoscrizione corrente.

Visual Studio Code con un client REST.

Scarica i file

Scaricare il pdf di esempio seguente:

Caricare i dati di esempio in Archiviazione di Azure

In Azure Storage, creare un nuovo contenitore denominato doc-extraction-image-verbalization-container.

Per le connessioni effettuate usando un'identità gestita assegnata dal sistema. Specificare una stringa di connessione che contiene un ResourceId, senza chiave o password dell'account. ResourceId deve includere l'ID sottoscrizione dell'account di archiviazione, il gruppo di risorse dell'account di archiviazione e il nome dell'account di archiviazione. La stringa di connessione è simile all'esempio seguente:

"credentials" : { "connectionString" : "ResourceId=/subscriptions/00000000-0000-0000-0000-00000000/resourceGroups/MY-DEMO-RESOURCE-GROUP/providers/Microsoft.Storage/storageAccounts/MY-DEMO-STORAGE-ACCOUNT/;" }Per le connessioni effettuate usando un'identità gestita assegnata dall'utente. Specificare una stringa di connessione che contiene un ResourceId, senza chiave o password dell'account. ResourceId deve includere l'ID sottoscrizione dell'account di archiviazione, il gruppo di risorse dell'account di archiviazione e il nome dell'account di archiviazione. Specificare un'identità usando la sintassi illustrata nell'esempio seguente. Impostare userAssignedIdentity sull'identità gestita assegnata dall'utente La stringa di connessione è simile all'esempio seguente:

"credentials" : { "connectionString" : "ResourceId=/subscriptions/00000000-0000-0000-0000-00000000/resourceGroups/MY-DEMO-RESOURCE-GROUP/providers/Microsoft.Storage/storageAccounts/MY-DEMO-STORAGE-ACCOUNT/;" }, "identity" : { "@odata.type": "#Microsoft.Azure.Search.DataUserAssignedIdentity", "userAssignedIdentity" : "/subscriptions/00000000-0000-0000-0000-00000000/resourcegroups/MY-DEMO-RESOURCE-GROUP/providers/Microsoft.ManagedIdentity/userAssignedIdentities/MY-DEMO-USER-MANAGED-IDENTITY" }

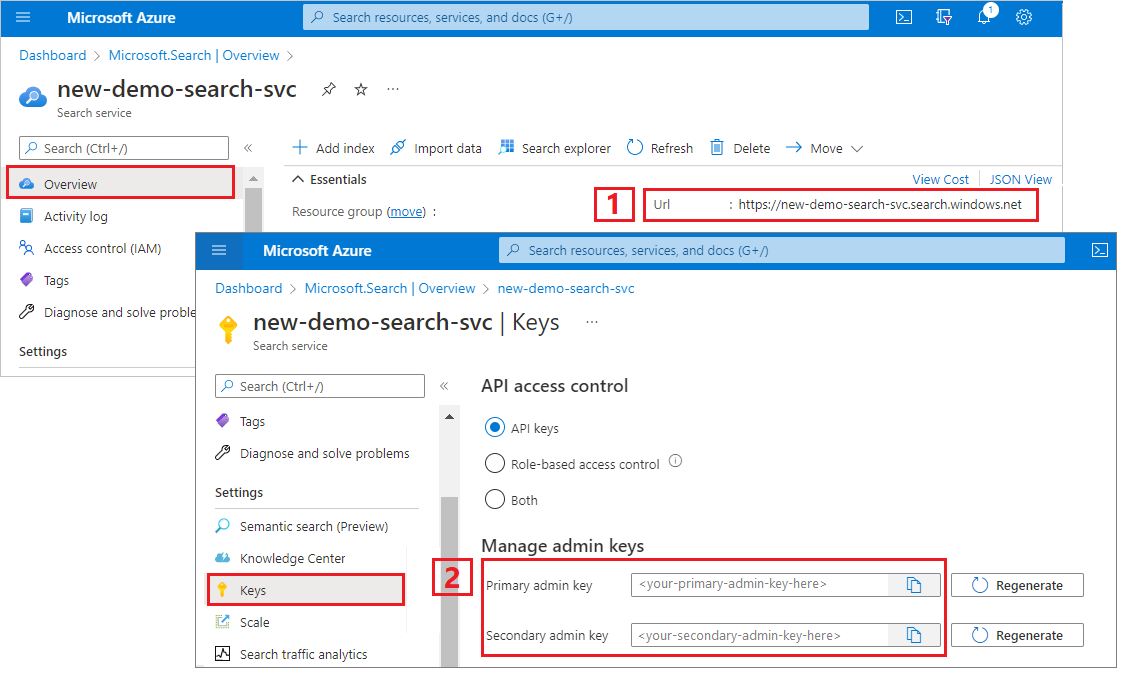

Copiare l'URL del servizio di ricerca e la chiave API

Per questa esercitazione, le connessioni ad Azure AI Search richiedono un endpoint e una chiave API. È possibile ottenere questi valori dal portale di Azure. Per metodi di connessione alternativi, vedere Identità gestite.

Accedere al portale di Azure, passare alla pagina Panoramica del servizio di ricerca e quindi copiare l'URL. Un endpoint di esempio potrebbe essere simile a

https://mydemo.search.windows.net.In Impostazioni>Chiavi, copiare una chiave amministratore. Le chiavi amministratore vengono usate per aggiungere, modificare ed eliminare oggetti. Sono disponibili due chiavi amministratore intercambiabili. Copiarne una.

Configurare il file REST

Avviare Visual Studio Code e creare un nuovo file.

Specificare i valori per le variabili usate nella richiesta.

@baseUrl = PUT-YOUR-SEARCH-SERVICE-ENDPOINT-HERE @apiKey = PUT-YOUR-ADMIN-API-KEY-HERE @storageConnection = PUT-YOUR-STORAGE-CONNECTION-STRING-HERE @openAIResourceUri = PUT-YOUR-OPENAI-URI-HERE @openAIKey = PUT-YOUR-OPENAI-KEY-HERE @chatCompletionResourceUri = PUT-YOUR-CHAT-COMPLETION-URI-HERE @chatCompletionKey = PUT-YOUR-CHAT-COMPLETION-KEY-HERE @imageProjectionContainer=PUT-YOUR-IMAGE-PROJECTION-CONTAINER-HERESalvare il file usando un'estensione

.resto.http.

Per informazioni sul client REST, vedere Guida introduttiva: Ricerca di parole chiave con REST.

Creare un'origine dati

Creare un'origine dati (REST) crea una connessione all'origine dati che specifica i dati da indicizzare.

### Create a data source

POST {{baseUrl}}/datasources?api-version=2025-05-01-preview HTTP/1.1

Content-Type: application/json

api-key: {{apiKey}}

{

"name": "doc-extraction-image-verbalization-ds",

"description": null,

"type": "azureblob",

"subtype": null,

"credentials": {

"connectionString": "{{storageConnection}}"

},

"container": {

"name": "doc-extraction-image-verbalization-container",

"query": null

},

"dataChangeDetectionPolicy": null,

"dataDeletionDetectionPolicy": null,

"encryptionKey": null,

"identity": null

}

Inviare la richiesta. La risposta dovrebbe essere simile alla seguente:

HTTP/1.1 201 Created

Transfer-Encoding: chunked

Content-Type: application/json; odata.metadata=minimal; odata.streaming=true; charset=utf-8

Location: https://<YOUR-SEARCH-SERVICE-NAME>.search.windows-int.net:443/datasources('doc-extraction-image-verbalization-ds')?api-version=2025-05-01-preview -Preview

Server: Microsoft-IIS/10.0

Strict-Transport-Security: max-age=2592000, max-age=15724800; includeSubDomains

Preference-Applied: odata.include-annotations="*"

OData-Version: 4.0

request-id: 4eb8bcc3-27b5-44af-834e-295ed078e8ed

elapsed-time: 346

Date: Sat, 26 Apr 2025 21:25:24 GMT

Connection: close

{

"name": "doc-extraction-image-verbalization-ds",

"description": "A test datasource",

"type": "azureblob",

"subtype": null,

"indexerPermissionOptions": [],

"credentials": {

"connectionString": null

},

"container": {

"name": "doc-extraction-multimodality-container",

"query": null

},

"dataChangeDetectionPolicy": null,

"dataDeletionDetectionPolicy": null,

"encryptionKey": null,

"identity": null

}

Creare un indice

Creare un indice (REST) crea un indice di ricerca nel servizio di ricerca. Un indice specifica tutti i parametri e i relativi attributi.

Per i JSON annidati, i campi dell'indice devono essere identici ai campi di origine. Attualmente, la ricerca AI di Azure non supporta i mapping dei campi in JSON annidato, quindi i nomi dei campi e i tipi di dati devono corrispondere esattamente. L'indice seguente è allineato agli elementi JSON nel contenuto non elaborato.

### Create an index

POST {{baseUrl}}/indexes?api-version=2025-05-01-preview HTTP/1.1

Content-Type: application/json

api-key: {{apiKey}}

{

"name": "doc-extraction-image-verbalization-index",

"fields": [

{

"name": "content_id",

"type": "Edm.String",

"retrievable": true,

"key": true,

"analyzer": "keyword"

},

{

"name": "text_document_id",

"type": "Edm.String",

"searchable": false,

"filterable": true,

"retrievable": true,

"stored": true,

"sortable": false,

"facetable": false

},

{

"name": "document_title",

"type": "Edm.String",

"searchable": true

},

{

"name": "image_document_id",

"type": "Edm.String",

"filterable": true,

"retrievable": true

},

{

"name": "content_text",

"type": "Edm.String",

"searchable": true,

"retrievable": true

},

{

"name": "content_embedding",

"type": "Collection(Edm.Single)",

"dimensions": 3072,

"searchable": true,

"retrievable": true,

"vectorSearchProfile": "hnsw"

},

{

"name": "content_path",

"type": "Edm.String",

"searchable": false,

"retrievable": true

},

{

"name": "offset",

"type": "Edm.String",

"searchable": false,

"retrievable": true

},

{

"name": "location_metadata",

"type": "Edm.ComplexType",

"fields": [

{

"name": "page_number",

"type": "Edm.Int32",

"searchable": false,

"retrievable": true

},

{

"name": "bounding_polygons",

"type": "Edm.String",

"searchable": false,

"retrievable": true,

"filterable": false,

"sortable": false,

"facetable": false

}

]

}

],

"vectorSearch": {

"profiles": [

{

"name": "hnsw",

"algorithm": "defaulthnsw",

"vectorizer": "{{vectorizer}}"

}

],

"algorithms": [

{

"name": "defaulthnsw",

"kind": "hnsw",

"hnswParameters": {

"m": 4,

"efConstruction": 400,

"metric": "cosine"

}

}

],

"vectorizers": [

{

"name": "{{vectorizer}}",

"kind": "azureOpenAI",

"azureOpenAIParameters": {

"resourceUri": "{{openAIResourceUri}}",

"deploymentId": "text-embedding-3-large",

"apiKey": "{{openAIKey}}",

"modelName": "text-embedding-3-large"

}

}

]

},

"semantic": {

"defaultConfiguration": "semanticconfig",

"configurations": [

{

"name": "semanticconfig",

"prioritizedFields": {

"titleField": {

"fieldName": "document_title"

},

"prioritizedContentFields": [

],

"prioritizedKeywordsFields": []

}

}

]

}

}

Punti chiave:

Gli incorporamenti di testo e immagine vengono archiviati nel

content_embeddingcampo e devono essere configurati con dimensioni appropriate (ad esempio, 3072) e un profilo di ricerca vettoriale.location_metadataacquisisce i metadati del poligono di delimitazione e del numero di pagina per ogni immagine normalizzata, consentendo di effettuare ricerche spaziali precise o sovrimpressioni dell'interfaccia utente.location_metadataesiste solo per le immagini in questo scenario. Se vuoi acquisire anche i metadati di posizione per il testo, prendi in considerazione l'uso della funzionalità di Layout documento. Un'esercitazione approfondita è disponibile in fondo alla pagina.Per altre informazioni sulla ricerca vettoriale, vedere Vettori in Ricerca di intelligenza artificiale di Azure.

Per altre informazioni sulla classificazione semantica, vedere Classificazione semantica in Ricerca di intelligenza artificiale di Azure

Creare un set di competenze

Creare un set di competenze (REST) crea un indice di ricerca nel servizio di ricerca. Un indice specifica tutti i parametri e i relativi attributi.

### Create a skillset

POST {{baseUrl}}/skillsets?api-version=2025-05-01-preview HTTP/1.1

Content-Type: application/json

api-key: {{apiKey}}

{

"name": "doc-extraction-image-verbalization-skillset",

"description": "A test skillset",

"skills": [

{

"@odata.type": "#Microsoft.Skills.Util.DocumentExtractionSkill",

"name": "document-extraction-skill",

"description": "Document extraction skill to exract text and images from documents",

"parsingMode": "default",

"dataToExtract": "contentAndMetadata",

"configuration": {

"imageAction": "generateNormalizedImages",

"normalizedImageMaxWidth": 2000,

"normalizedImageMaxHeight": 2000

},

"context": "/document",

"inputs": [

{

"name": "file_data",

"source": "/document/file_data"

}

],

"outputs": [

{

"name": "content",

"targetName": "extracted_content"

},

{

"name": "normalized_images",

"targetName": "normalized_images"

}

]

},

{

"@odata.type": "#Microsoft.Skills.Text.SplitSkill",

"name": "split-skill",

"description": "Split skill to chunk documents",

"context": "/document",

"defaultLanguageCode": "en",

"textSplitMode": "pages",

"maximumPageLength": 2000,

"pageOverlapLength": 200,

"unit": "characters",

"inputs": [

{

"name": "text",

"source": "/document/extracted_content",

"inputs": []

}

],

"outputs": [

{

"name": "textItems",

"targetName": "pages"

}

]

},

{

"@odata.type": "#Microsoft.Skills.Text.AzureOpenAIEmbeddingSkill",

"name": "text-embedding-skill",

"description": "Embedding skill for text",

"context": "/document/pages/*",

"inputs": [

{

"name": "text",

"source": "/document/pages/*"

}

],

"outputs": [

{

"name": "embedding",

"targetName": "text_vector"

}

],

"resourceUri": "{{openAIResourceUri}}",

"deploymentId": "text-embedding-3-large",

"apiKey": "{{openAIKey}}",

"dimensions": 3072,

"modelName": "text-embedding-3-large"

},

{

"@odata.type": "#Microsoft.Skills.Custom.ChatCompletionSkill",

"name": "genAI-prompt-skill",

"description": "GenAI Prompt skill for image verbalization",

"uri": "{{chatCompletionResourceUri}}",

"timeout": "PT1M",

"apiKey": "{{chatCompletionKey}}",

"context": "/document/normalized_images/*",

"inputs": [

{

"name": "systemMessage",

"source": "='You are tasked with generating concise, accurate descriptions of images, figures, diagrams, or charts in documents. The goal is to capture the key information and meaning conveyed by the image without including extraneous details like style, colors, visual aesthetics, or size.\n\nInstructions:\nContent Focus: Describe the core content and relationships depicted in the image.\n\nFor diagrams, specify the main elements and how they are connected or interact.\nFor charts, highlight key data points, trends, comparisons, or conclusions.\nFor figures or technical illustrations, identify the components and their significance.\nClarity & Precision: Use concise language to ensure clarity and technical accuracy. Avoid subjective or interpretive statements.\n\nAvoid Visual Descriptors: Exclude details about:\n\nColors, shading, and visual styles.\nImage size, layout, or decorative elements.\nFonts, borders, and stylistic embellishments.\nContext: If relevant, relate the image to the broader content of the technical document or the topic it supports.\n\nExample Descriptions:\nDiagram: \"A flowchart showing the four stages of a machine learning pipeline: data collection, preprocessing, model training, and evaluation, with arrows indicating the sequential flow of tasks.\"\n\nChart: \"A bar chart comparing the performance of four algorithms on three datasets, showing that Algorithm A consistently outperforms the others on Dataset 1.\"\n\nFigure: \"A labeled diagram illustrating the components of a transformer model, including the encoder, decoder, self-attention mechanism, and feedforward layers.\"'"

},

{

"name": "userMessage",

"source": "='Please describe this image.'"

},

{

"name": "image",

"source": "/document/normalized_images/*/data"

}

],

"outputs": [

{

"name": "response",

"targetName": "verbalizedImage"

}

]

},

{

"@odata.type": "#Microsoft.Skills.Text.AzureOpenAIEmbeddingSkill",

"name": "verblized-image-embedding-skill",

"description": "Embedding skill for verbalized images",

"context": "/document/normalized_images/*",

"inputs": [

{

"name": "text",

"source": "/document/normalized_images/*/verbalizedImage",

"inputs": []

}

],

"outputs": [

{

"name": "embedding",

"targetName": "verbalizedImage_vector"

}

],

"resourceUri": "{{openAIResourceUri}}",

"deploymentId": "text-embedding-3-large",

"apiKey": "{{openAIKey}}",

"dimensions": 3072,

"modelName": "text-embedding-3-large"

},

{

"@odata.type": "#Microsoft.Skills.Util.ShaperSkill",

"name": "shaper-skill",

"description": "Shaper skill to reshape the data to fit the index schema"

"context": "/document/normalized_images/*",

"inputs": [

{

"name": "normalized_images",

"source": "/document/normalized_images/*",

"inputs": []

},

{

"name": "imagePath",

"source": "='{{imageProjectionContainer}}/'+$(/document/normalized_images/*/imagePath)",

"inputs": []

},

{

"name": "location_metadata",

"sourceContext": "/document/normalized_images/*",

"inputs": [

{

"name": "page_number",

"source": "/document/normalized_images/*/pageNumber"

},

{

"name": "bounding_polygons",

"source": "/document/normalized_images/*/boundingPolygon"

}

]

}

],

"outputs": [

{

"name": "output",

"targetName": "new_normalized_images"

}

]

}

],

"indexProjections": {

"selectors": [

{

"targetIndexName": "{{index}}",

"parentKeyFieldName": "text_document_id",

"sourceContext": "/document/pages/*",

"mappings": [

{

"name": "content_embedding",

"source": "/document/pages/*/text_vector"

},

{

"name": "content_text",

"source": "/document/pages/*"

},

{

"name": "document_title",

"source": "/document/document_title"

}

]

},

{

"targetIndexName": "{{index}}",

"parentKeyFieldName": "image_document_id",

"sourceContext": "/document/normalized_images/*",

"mappings": [

{

"name": "content_text",

"source": "/document/normalized_images/*/verbalizedImage"

},

{

"name": "content_embedding",

"source": "/document/normalized_images/*/verbalizedImage_vector"

},

{

"name": "content_path",

"source": "/document/normalized_images/*/new_normalized_images/imagePath"

},

{

"name": "document_title",

"source": "/document/document_title"

},

{

"name": "locationMetadata",

"source": "/document/normalized_images/*/new_normalized_images/location_metadata"

}

]

}

],

"parameters": {

"projectionMode": "skipIndexingParentDocuments"

}

},

"knowledgeStore": {

"storageConnectionString": "{{storageConnection}}",

"projections": [

{

"files": [

{

"storageContainer": "{{imageProjectionContainer}}",

"source": "/document/normalized_images/*"

}

]

}

]

}

}

Questo set di competenze estrae testo e immagini, vettorizza e forma i metadati dell'immagine per la proiezione nell'indice.

Punti chiave:

Il

content_textcampo viene popolato in due modi:Dal testo estratto del documento utilizzando la funzionalità Estrazione documenti e suddiviso utilizzando la funzionalità Suddivisione testo

Dal contenuto dell'immagine usando la competenza Prompt GenAI, che genera didascalie descrittive per ogni immagine normalizzata

Il

content_embeddingcampo contiene incorporazioni di 3072 dimensioni sia per il testo della pagina che per le descrizioni verbali delle immagini. Questi vengono generati usando il modello text-embedding-3-large di Azure OpenAI.content_pathcontiene il percorso relativo del file di immagine all'interno del contenitore di proiezione di immagini designato. Questo campo viene generato solo per le immagini estratte dai PDF quandoimageActionè impostato sugenerateNormalizedImagese può essere mappato dal documento arricchito dal campo di origine/document/normalized_images/*/imagePath.

Creare ed eseguire un indicizzatore

Creare un indicizzatore crea un indicizzatore nel servizio di ricerca. Un indicizzatore si connette all'origine dati, carica i dati, esegue un set di competenze e indicizza i dati arricchiti.

### Create and run an indexer

POST {{baseUrl}}/indexers?api-version=2025-05-01-preview HTTP/1.1

Content-Type: application/json

api-key: {{apiKey}}

{

"dataSourceName": "doc-extraction-image-verbalization-ds",

"targetIndexName": "doc-extraction-image-verbalization-index",

"skillsetName": "doc-extraction-image-verbalization-skillset",

"parameters": {

"maxFailedItems": -1,

"maxFailedItemsPerBatch": 0,

"batchSize": 1,

"configuration": {

"allowSkillsetToReadFileData": true

}

},

"fieldMappings": [

{

"sourceFieldName": "metadata_storage_name",

"targetFieldName": "document_title"

}

],

"outputFieldMappings": []

}

Esegui le query

È possibile iniziare a eseguire ricerche subito dopo aver caricato il primo documento.

### Query the index

POST {{baseUrl}}/indexes/doc-extraction-image-verbalization-index/docs/search?api-version=2025-05-01-preview HTTP/1.1

Content-Type: application/json

api-key: {{apiKey}}

{

"search": "*",

"count": true

}

Inviare la richiesta. Si tratta di una query di ricerca full-text non specificata che restituisce tutti i campi contrassegnati come recuperabili nell'indice, insieme a un conteggio dei documenti. La risposta dovrebbe essere simile alla seguente:

HTTP/1.1 200 OK

Transfer-Encoding: chunked

Content-Type: application/json; odata.metadata=minimal; odata.streaming=true; charset=utf-8

Content-Encoding: gzip

Vary: Accept-Encoding

Server: Microsoft-IIS/10.0

Strict-Transport-Security: max-age=2592000, max-age=15724800; includeSubDomains

Preference-Applied: odata.include-annotations="*"

OData-Version: 4.0

request-id: 712ca003-9493-40f8-a15e-cf719734a805

elapsed-time: 198

Date: Wed, 30 Apr 2025 23:20:53 GMT

Connection: close

{

"@odata.count": 100,

"@search.nextPageParameters": {

"search": "*",

"count": true,

"skip": 50

},

"value": [

],

"@odata.nextLink": "https://<YOUR-SEARCH-SERVICE-NAME>.search.windows.net/indexes/doc-extraction-image-verbalization-index/docs/search?api-version=2025-05-01-preview "

}

Nella risposta vengono restituiti 100 documenti.

Per quanto riguarda i filtri, è anche possibile usare gli operatori logici (and, or e not) e gli operatori di confronto (eq, ne, gt, lt, ge e le). Per i confronti tra stringhe viene fatta distinzione tra maiuscole e minuscole. Per altre informazioni ed esempi, vedere Esempi di query di ricerca semplici.

Annotazioni

Il $filter parametro funziona solo sui campi contrassegnati come filtrabili durante la creazione dell'indice.

Ecco alcuni esempi di altre query:

### Query for only images

POST {{baseUrl}}/indexes/doc-extraction-image-verbalization-index/docs/search?api-version=2025-05-01-preview HTTP/1.1

Content-Type: application/json

api-key: {{apiKey}}

{

"search": "*",

"count": true,

"filter": "image_document_id ne null"

}

### Query for text or images with content related to energy, returning the id, parent document, and text (extracted text for text chunks and verbalized image text for images), and the content path where the image is saved in the knowledge store (only populated for images)

POST {{baseUrl}}/indexes/doc-extraction-image-verbalization-index/docs/search?api-version=2025-05-01-preview HTTP/1.1

Content-Type: application/json

api-key: {{apiKey}}

{

"search": "energy",

"count": true,

"select": "content_id, document_title, content_text, content_path"

}

Reimpostare ed eseguire di nuovo

Gli indicizzatori possono essere reimpostati per cancellare il marcatore critico, che consente una riesecuzione completa. Le richieste POST seguenti sono per il reset, seguite dal riavvio.

### Reset the indexer

POST {{baseUrl}}/indexers/doc-extraction-image-verbalization-indexer/reset?api-version=2025-05-01-preview HTTP/1.1

api-key: {{apiKey}}

### Run the indexer

POST {{baseUrl}}/indexers/doc-extraction-image-verbalization-indexer/run?api-version=2025-05-01-preview HTTP/1.1

api-key: {{apiKey}}

### Check indexer status

GET {{baseUrl}}/indexers/doc-extraction-image-verbalization-indexer/status?api-version=2025-05-01-preview HTTP/1.1

api-key: {{apiKey}}

Pulire le risorse

Quando si lavora nel proprio abbonamento, alla fine di un progetto è opportuno rimuovere le risorse che non sono più necessarie. Le risorse lasciate in funzione possono costarti denaro. È possibile eliminare risorse singole oppure gruppi di risorse per eliminare l'intero set di risorse.

È possibile usare il portale di Azure per eliminare indici, indicizzatori e origini dati.

Vedere anche

Ora che hai familiarità con un'implementazione di esempio di uno scenario di indicizzazione multimodale, scopri: