Avvio rapido: Creare un nuovo pool di Apache Spark serverless usando il portale di Azure

Azure Synapse Analytics offre vari motori di analisi che consentono di inserire, trasformare, modellare, analizzare e distribuire i dati. Un pool di Apache Spark offre funzionalità di calcolo open source per i Big Data. Dopo aver creato un pool di Apache Spark nell'area di lavoro synapse, è possibile caricare, modellare, elaborare e distribuire i dati per ottenere informazioni analitiche più rapide.

Questa guida di avvio rapido illustra come usare il portale di Azure per creare un pool di Apache Spark in un'area di lavoro Synapse.

Importante

La fatturazione delle istanze di Spark viene calcolata con ripartizione proporzionale al minuto, indipendentemente dal fatto che siano in uso o meno. Assicurarsi di arrestare l'istanza di Spark dopo averla usata oppure impostare un timeout breve. Per altre informazioni, vedere la sezione Pulire le risorse di questo articolo.

Se non si ha una sottoscrizione di Azure, creare un account gratuito prima di iniziare.

Prerequisiti

- È necessaria una sottoscrizione di Azure. Se necessario, creare un account Azure gratuito

- Si userà l'area di lavoro di Synapse.

Accedere al portale di Azure

Accedere al portale di Azure

Accedere all'area di lavoro di Synapse

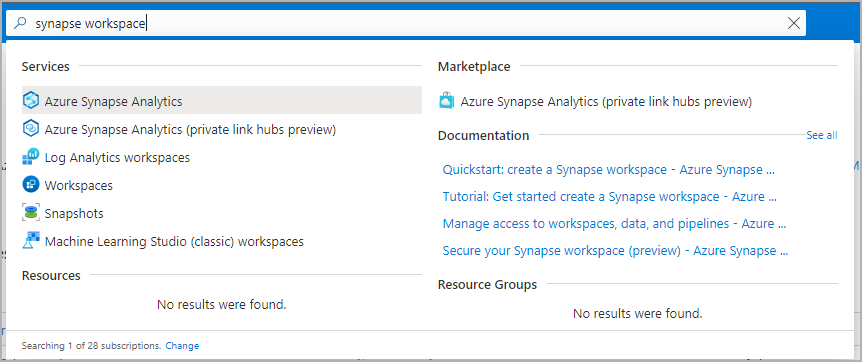

Passare all'area di lavoro di Synapse in cui verrà creato il pool di Apache Spark digitando il nome del servizio (o direttamente il nome della risorsa) nella barra di ricerca.

Dall'elenco delle aree di lavoro, digitare il nome (o parte del nome) dell'area di lavoro da aprire. Per questo esempio viene usata un'area di lavoro denominata contosoanalytics.

Creare un nuovo pool di Apache Spark

Importante

Il runtime di Azure Synapse per Apache Spark 2.4 è stato deprecato e ufficialmente non è supportato a partire da settembre 2023. Dato che Spark 3.1 e Spark 3.2 sono annunciati anche end-of support, si consiglia ai clienti di eseguire la migrazione a Spark 3.3.

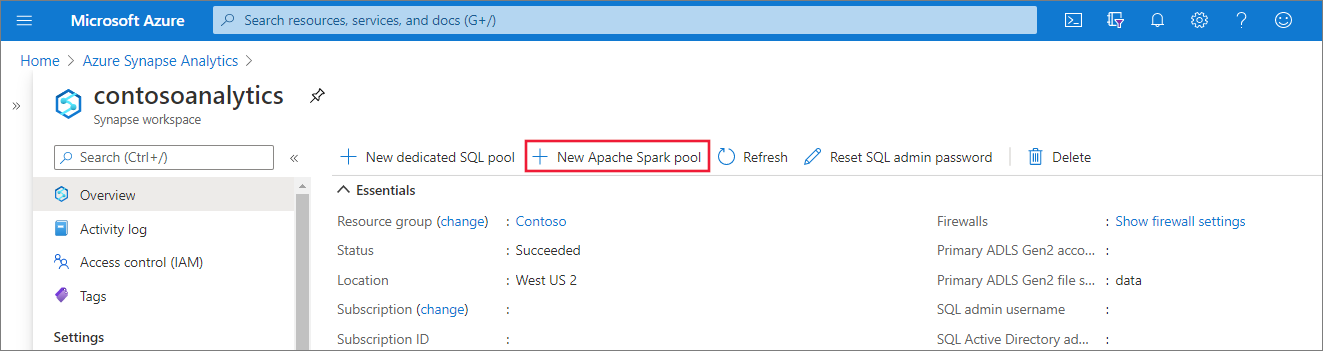

Nell'area di lavoro Synapse in cui creare il pool di Apache Spark selezionare Nuovo pool di Apache Spark.

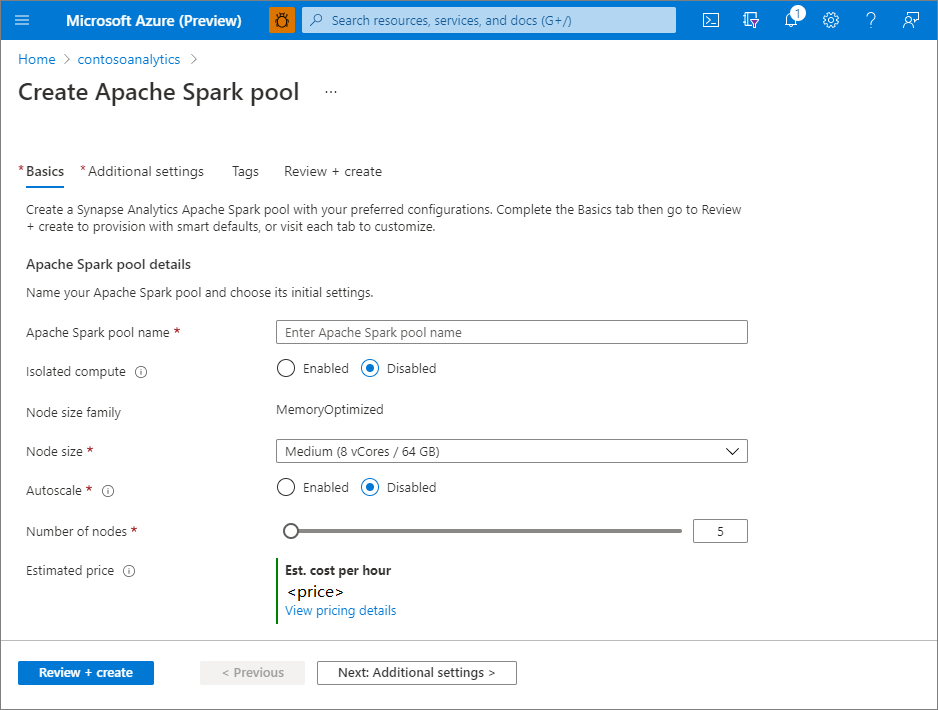

Immettere i dettagli seguenti nella scheda Informazioni di base:

Impostazione Valore suggerito Descrizione Nome del pool di Apache Spark Un nome di pool valido, ad esempio contososparkSi tratta del nome che avrà il pool di Apache Spark. Dimensioni nodo Piccole (4 vCPU/32 GB) Per questa guida di avvio rapido, impostare questa opzione sulle dimensioni minime per ridurre i costi Autoscale Disabled La scalabilità automatica non è necessaria per questo argomento di avvio rapido Numero di nodi 5 Usare dimensioni ridotte per limitare i costi per questo argomento di avvio rapido Importante

Esistono limitazioni specifiche per i nomi che possono essere usati dai pool di Apache Spark. I nomi possono contenere solo lettere o numeri, devono essere costituiti da un massimo di 15 caratteri, devono iniziare con una lettera, non possono contenere parole riservate e devono essere univoci nell'area di lavoro.

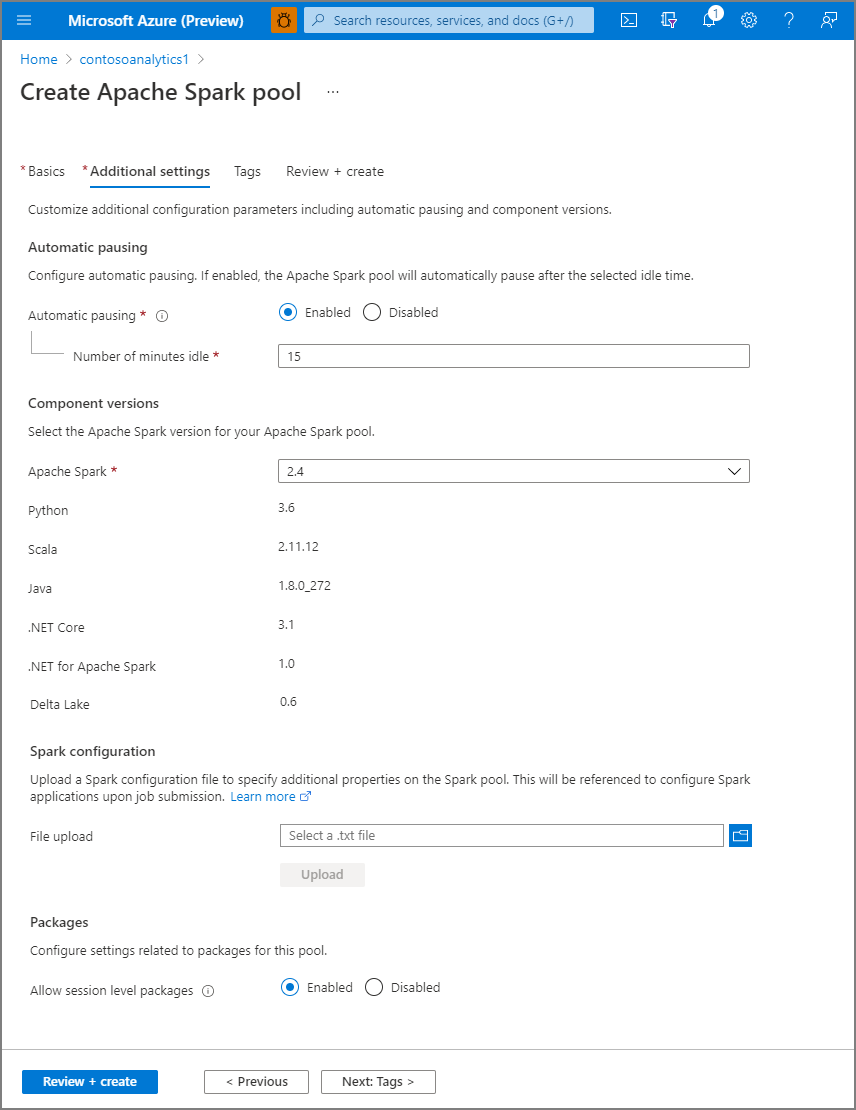

Selezionare Avanti: Impostazioni aggiuntive ed esaminare le impostazioni predefinite. Non modificare le impostazioni predefinite.

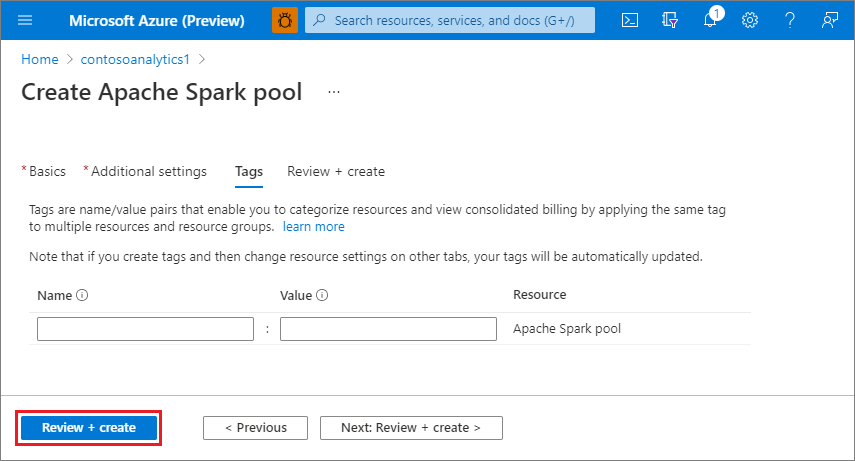

Selezionare Avanti: tag. Prendere in considerazione l'uso dei tag di Azure. Ad esempio, il tag "Owner" o "CreatedBy" per identificare chi ha creato la risorsa e il tag "Environment" per identificare se questa risorsa si trova in Production, Development e così via. Per altre informazioni, vedere Sviluppare la strategia di denominazione e assegnazione di tag per le risorse di Azure.

Selezionare Rivedi e crea.

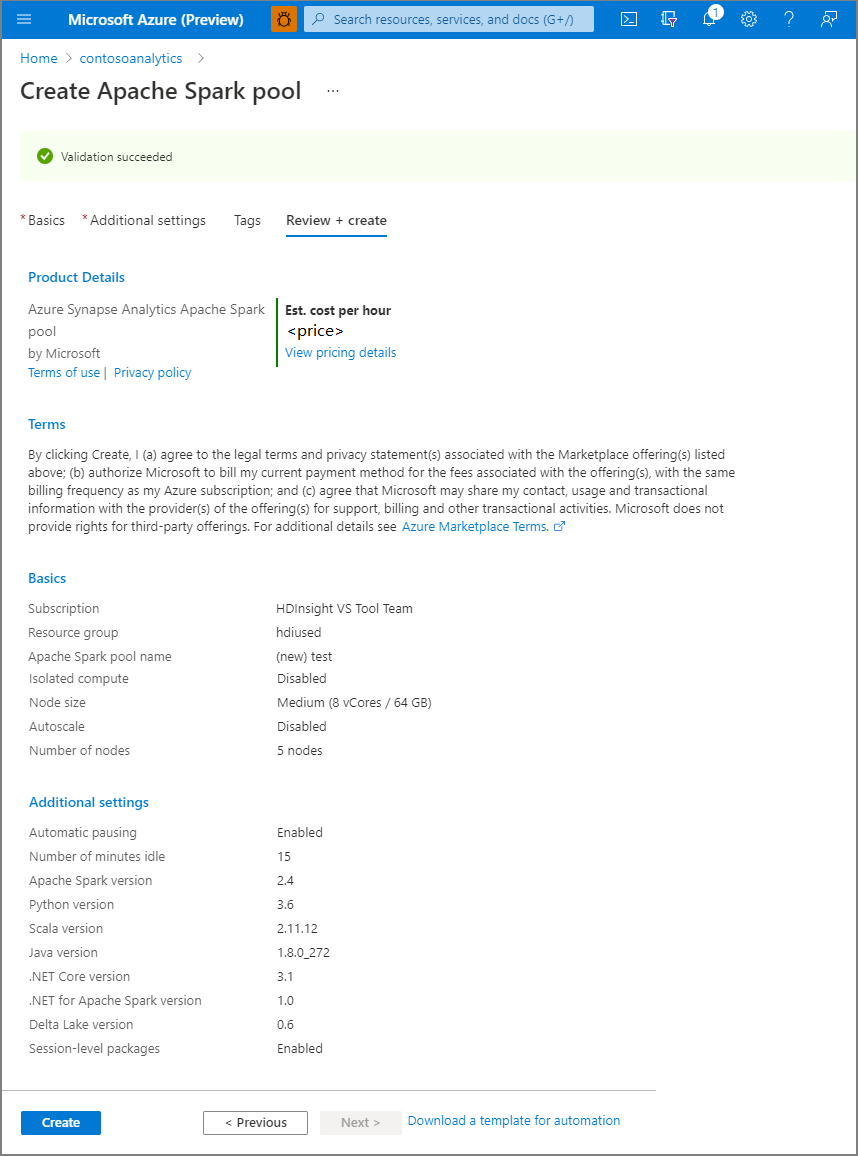

Verificare che i dettagli siano corretti in base a quanto specificato in precedenza, quindi selezionare Crea.

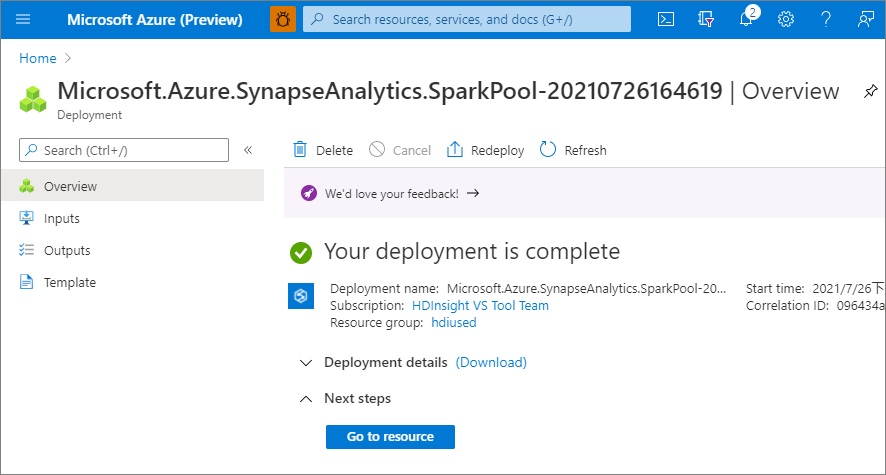

A questo punto, verrà avviato il flusso di provisioning delle risorse e verrà indicato quando è completato.

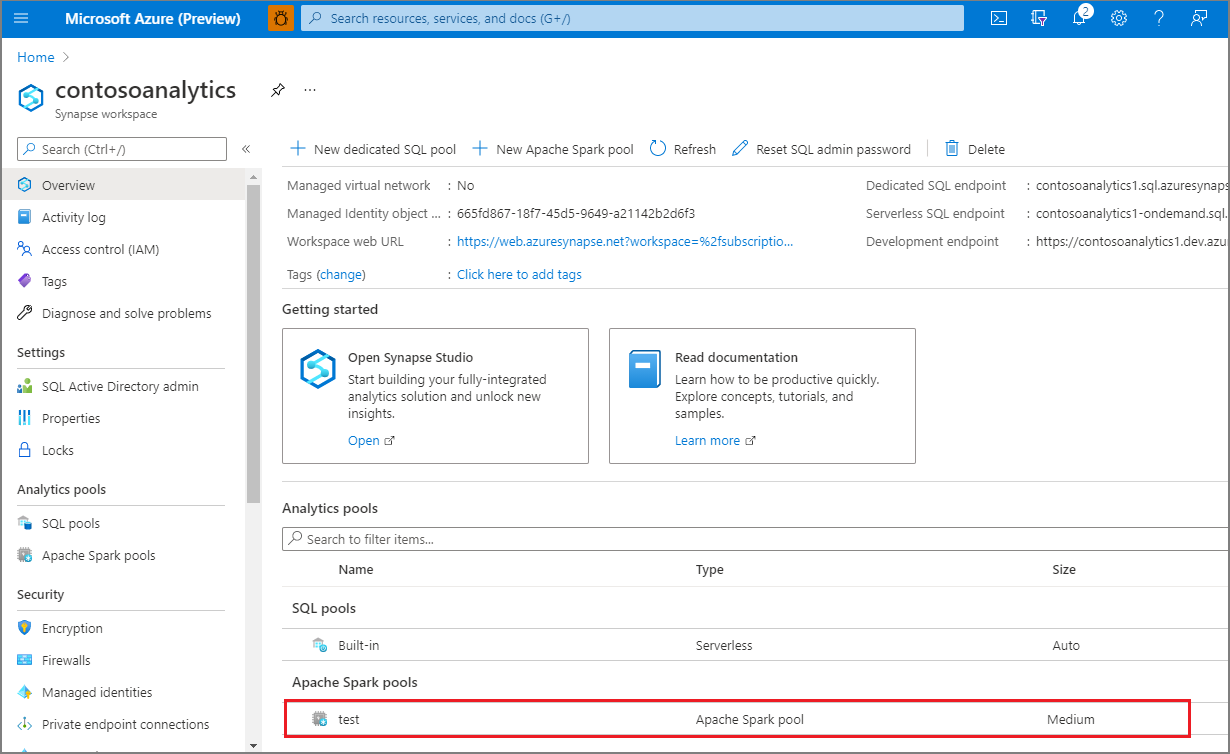

Al termine del provisioning, tornando nell'area di lavoro viene visualizzata una nuova voce per il pool di Apache Spark appena creato.

A questo punto, non sono in esecuzione risorse, non sono presenti addebiti per Spark e sono stati creati i metadati sulle istanze di Spark da creare.

Pulire le risorse

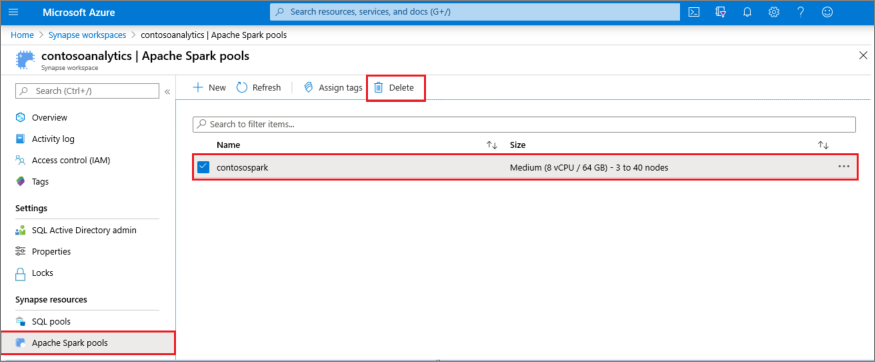

I passaggi seguenti eliminano il pool di Apache Spark dall'area di lavoro.

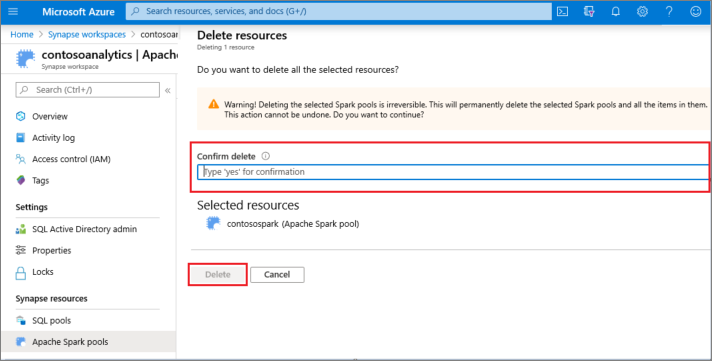

Avviso

Con l'eliminazione di un pool di Apache Spark, viene rimosso anche il motore di analisi dall'area di lavoro. Non sarà più possibile connettersi al pool di Apache Spark e tutte le query, le pipeline e i notebook che lo usano non funzioneranno più.

Per eliminare il pool di Apache Spark, seguire questa procedura:

- Passare al riquadro Pool di Apache Spark nell'area di lavoro.

- Selezionare il pool di Apache Spark da eliminare (in questo caso, contosospark).

- Selezionare Elimina.

- Confermare l'eliminazione e selezionare Il pulsante Elimina .

- Quando il processo viene completato, il pool di Apache Spark non sarà più elencato nelle risorse dell'area di lavoro.