Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

In questa esercitazione si inseriscono altre tabelle dimensionali e dei fatti da Wide World Importers (WWI) nel lakehouse.

Prerequisiti

- Se non si dispone di un lakehouse, è necessario creare un lakehouse.

Inserire i dati

In questa sezione si usa l'attività Copia dati della pipeline di Data Factory per inserire dati di esempio da un account di archiviazione di Azure nella sezione File del lakehouse creato in precedenza.

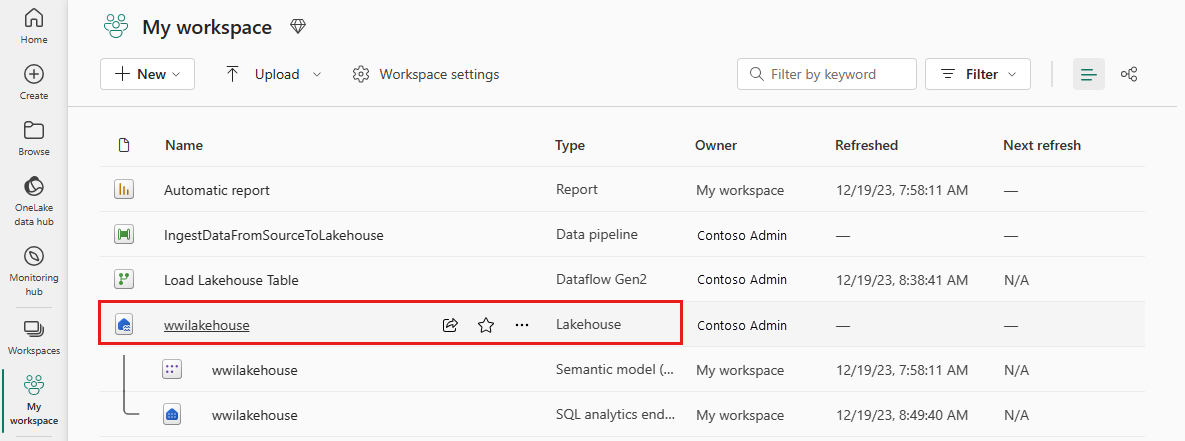

Selezionare Aree di lavoro nel riquadro di spostamento sinistro e quindi selezionare la nuova area di lavoro dal menu Aree di lavoro. Appare la visualizzazione degli elementi dell'area di lavoro.

Nell'opzione Nuovo elemento nella barra multifunzione dell'area di lavoro seleziona Data pipeline.

Nella finestra di dialogo Nuova pipeline, specificare il nome IngestDataFromSourceToLakehouse e selezionare Crea. Viene creata e aperta una nuova pipeline di Azure Data Factory.

Quindi, configura una connessione HTTP per importare i dati di esempio World Wide Importers nel Lakehouse. Nell'elenco Nuove origini, selezionare Visualizza altro, cercare Http e selezionarlo.

Nella finestra Connetti all'origine dati, immettere i dettagli della tabella seguente e selezionare Avanti.

Proprietà valore URL https://assetsprod.microsoft.com/en-us/wwi-sample-dataset.zipConnessione Creare una nuova connessione Nome connessione wwisampledata Gateway di dati None Tipo di autenticazione Anonimo

Nel passaggio successivo, abilitare la Copia binaria e scegliere ZipDeflate (.zip) come Tipo di compressione, perché l'origine è un file .zip. Mantenere gli altri campi con i valori predefiniti e selezionare Avanti.

Nella finestra Connetti alla destinazione dati specificare cartella radice come File e selezionare Avanti. I dati verranno scritti nella sezione File della casa sul lago.

Selezionare Avanti, il formato del file di destinazione viene impostato automaticamente su Binary. Selezionare quindi Salva+Esegui. È possibile pianificare pipeline per aggiornare i dati periodicamente. In questa esercitazione, la pipeline viene eseguita solo una volta. Il completamento del processo di copia dei dati richiede circa 10-15 minuti.

È possibile monitorare l'esecuzione e l'attività della pipeline nella scheda Output. È anche possibile visualizzare informazioni dettagliate sul trasferimento dei dati selezionando l'icona a forma di occhiali accanto al nome della pipeline, visualizzata quando si passa il puntatore del mouse sul nome.

Una volta completata correttamente l'esecuzione della pipeline, passare al lakehouse (wwilakehouse) e aprire Esplora per visualizzare i dati importati.

Assicurarsi che la cartella WideWorldImportersDW sia presente nella vista Esplora e che contenga i dati per tutte le tabelle.

I dati vengono creati nella sezione File dell'Esploratore Lakehouse. Una nuova cartella con GUID contiene tutti i dati necessari. Rinominare il GUID in wwi-raw-data

Per caricare dati incrementali in un lakehouse, vedere Caricare dati in modo incrementale da un data warehouse in un lakehouse.