Guida introduttiva: Spostare e trasformare i dati con flussi di dati e pipeline di dati

In questa esercitazione viene illustrato come l'esperienza del flusso di dati e della pipeline di dati può creare una soluzione data factory potente e completa.

Prerequisiti

Per iniziare, è necessario disporre dei prerequisiti seguenti:

- Un account tenant con una sottoscrizione attiva. Crea un account gratuito.

- Assicurarsi di avere un'area di lavoro abilitata per Microsoft Fabric: creare un'area di lavoro che non sia l'area di lavoro personale predefinita.

- Un database SQL di Azure con dati di tabella.

- Un account di Archiviazione BLOB.

Flussi di dati confrontati con le pipeline

I flussi di dati Gen2 consentono di sfruttare un'interfaccia a basso codice e 300+ dati e trasformazioni basate su intelligenza artificiale per pulire, preparare e trasformare facilmente i dati con maggiore flessibilità rispetto a qualsiasi altro strumento. Le pipeline di dati consentono funzionalità avanzate di orchestrazione dei dati predefinite per comporre flussi di lavoro di dati flessibili che soddisfano le esigenze aziendali. In una pipeline è possibile creare raggruppamenti logici di attività che eseguono un'attività, che possono includere la chiamata di un flusso di dati per pulire e preparare i dati. Anche se esistono alcune funzionalità che si sovrappongono tra i due, la scelta di quale usare per uno scenario specifico dipende dal fatto che sia necessaria la ricchezza completa delle pipeline o che sia possibile usare le funzionalità più semplici ma più limitate dei flussi di dati. Per altri dettagli, vedere la Guida alle decisioni sull'infrastruttura

Trasformare i dati con flussi di dati

Seguire questa procedura per configurare il flusso di dati.

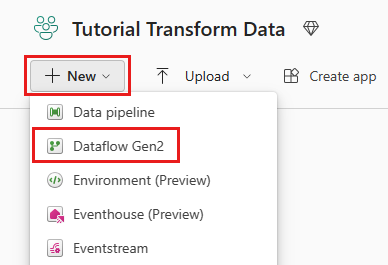

Passaggio 1: Creare un flusso di dati

Scegliere l'area di lavoro abilitata per Fabric e quindi selezionare Nuovo. Selezionare quindi Flusso di dati Gen2.

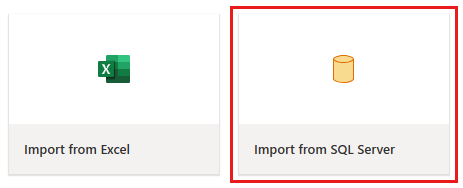

Verrà visualizzata la finestra dell'editor del flusso di dati. Selezionare la scheda Importa da SQL Server .

Passaggio 2: Recuperare i dati

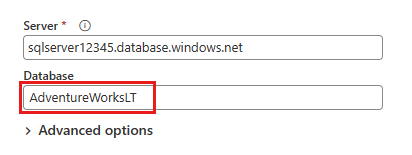

Nella finestra di dialogo Connessione all'origine dati presentata successivamente immettere i dettagli per connettersi al database SQL di Azure e quindi selezionare Avanti. Per questo esempio si usa il database di esempio AdventureWorksLT configurato quando si configura il database SQL di Azure nei prerequisiti.

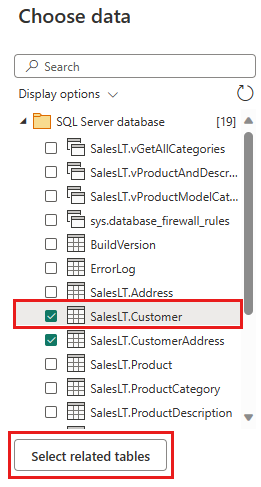

Selezionare i dati da trasformare e quindi selezionare Crea. Per questa guida introduttiva, selezionare SalesLT.Customer dai dati di esempio AdventureWorksLT forniti per il database SQL di Azure e quindi il pulsante Seleziona tabelle correlate per includere automaticamente due altre tabelle correlate.

Passaggio 3: Trasformare i dati

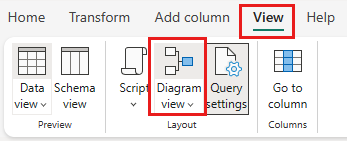

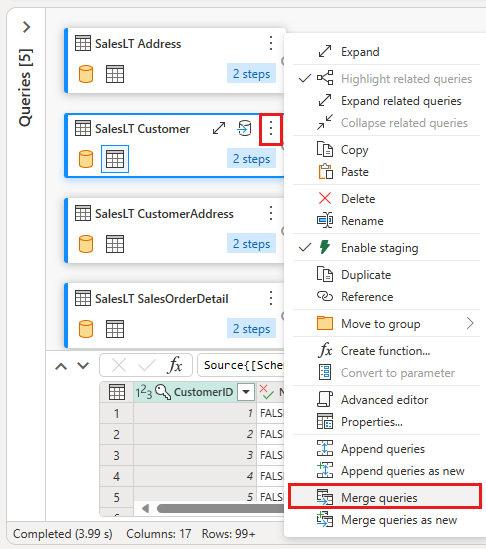

Se non è selezionata, selezionare il pulsante Visualizzazione diagramma nella barra di stato nella parte inferiore della pagina oppure selezionare Visualizzazione diagramma nel menu Visualizza nella parte superiore dell'editor di Power Query. Una di queste opzioni può attivare o disattivare la visualizzazione diagramma.

Fare clic con il pulsante destro del mouse sulla query SalesLT Customer oppure selezionare i puntini di sospensione verticali a destra della query, quindi selezionare Unisci query.

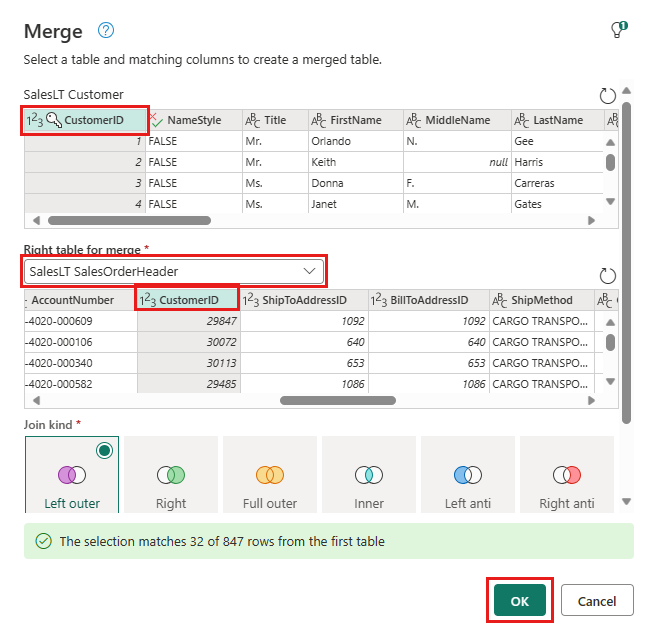

Configurare l'unione selezionando la tabella SalesLTOrderHeader come tabella corretta per l'unione, la colonna CustomerID di ogni tabella come colonna join e Left outer come tipo di join. Selezionare quindi OK per aggiungere la query di merge.

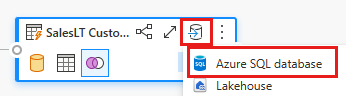

Selezionare il pulsante Aggiungi destinazione dati, simile a un simbolo di database con una freccia sopra di essa, dalla nuova query di unione appena creata. Selezionare quindi database SQL di Azure come tipo di destinazione.

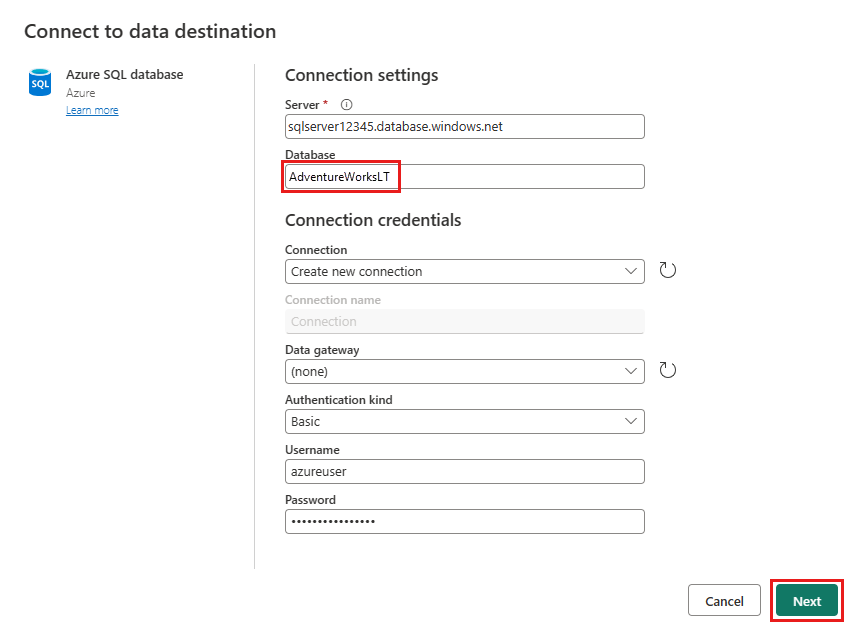

Specificare i dettagli per la connessione al database SQL di Azure in cui pubblicare la query di merge. In questo esempio è possibile usare anche il database AdventureWorksLT usato come origine dati per la destinazione.

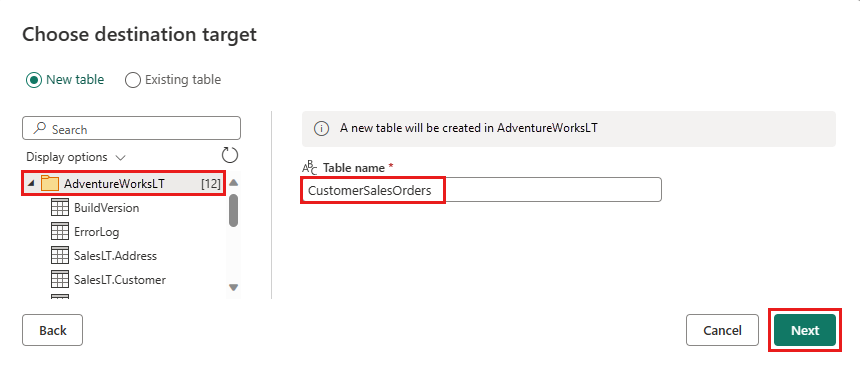

Scegliere un database per archiviare i dati e specificare un nome di tabella, quindi selezionare Avanti.

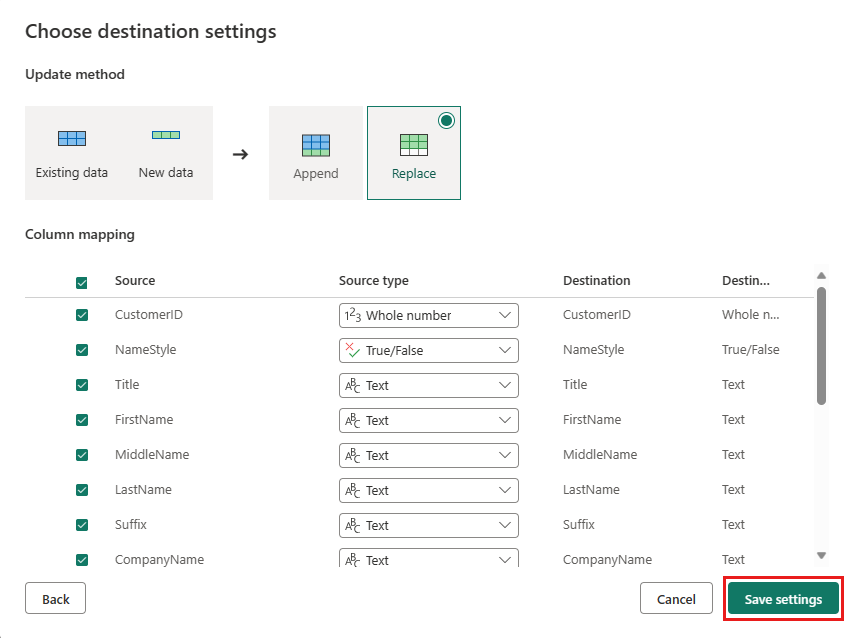

È possibile lasciare le impostazioni predefinite nella finestra di dialogo Scegli impostazioni di destinazione e selezionare Salva impostazioni senza apportare modifiche qui.

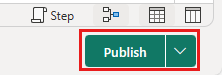

Selezionare Pubblica di nuovo nella pagina dell'editor del flusso di dati per pubblicare il flusso di dati.

Spostare dati con pipeline di dati

Dopo aver creato un dataflow Gen2, è possibile usarlo in una pipeline. In questo esempio si copiano i dati generati dal flusso di dati in formato testo in un account Archiviazione BLOB di Azure.

Passaggio 1: Creare una nuova pipeline di dati

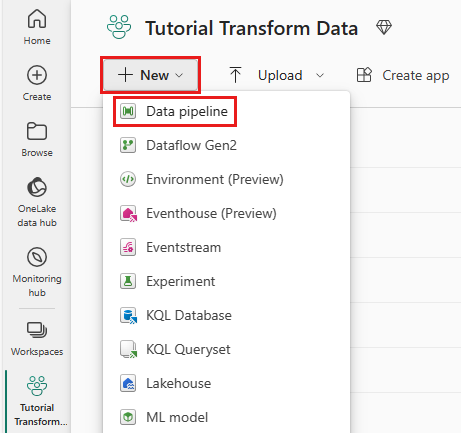

Nell'area di lavoro selezionare Nuovo e quindi selezionare Pipeline di dati.

Assegnare alla pipeline un nome e quindi selezionare Crea.

Passaggio 2: Configurare il flusso di dati

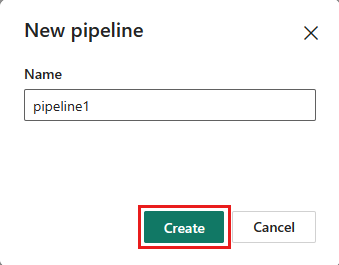

Aggiungere una nuova attività del flusso di dati alla pipeline di dati selezionando Flusso di dati nella scheda Attività .

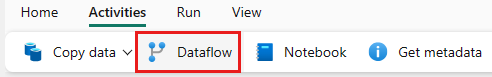

Selezionare il flusso di dati nell'area di disegno della pipeline e quindi la scheda Impostazioni. Scegliere il flusso di dati creato in precedenza dall'elenco a discesa.

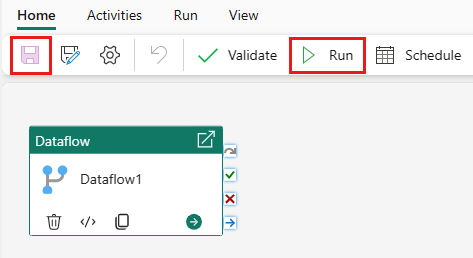

Selezionare Salva e quindi Esegui per eseguire il flusso di dati per popolare inizialmente la tabella di query unita progettata nel passaggio precedente.

Passaggio 3: Usare l'assistente copia per aggiungere un'attività di copia

Selezionare Copia dati nell'area di disegno per aprire lo strumento Copia assistente per iniziare. In alternativa, selezionare Usa assistente copia dall'elenco a discesa Copia dati nella scheda Attività della barra multifunzione.

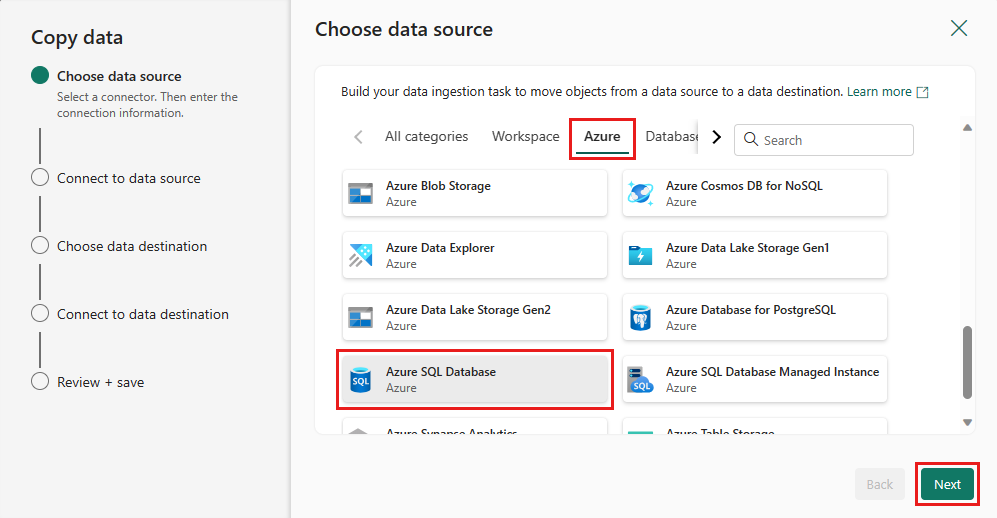

Scegliere l'origine dati selezionando un tipo di origine dati. In questa esercitazione si userà il database SQL di Azure usato in precedenza quando è stato creato il flusso di dati per generare una nuova query di merge. Scorrere verso il basso sotto le offerte di dati di esempio e selezionare la scheda Azure e quindi database SQL di Azure. Selezionare Avanti per continuare.

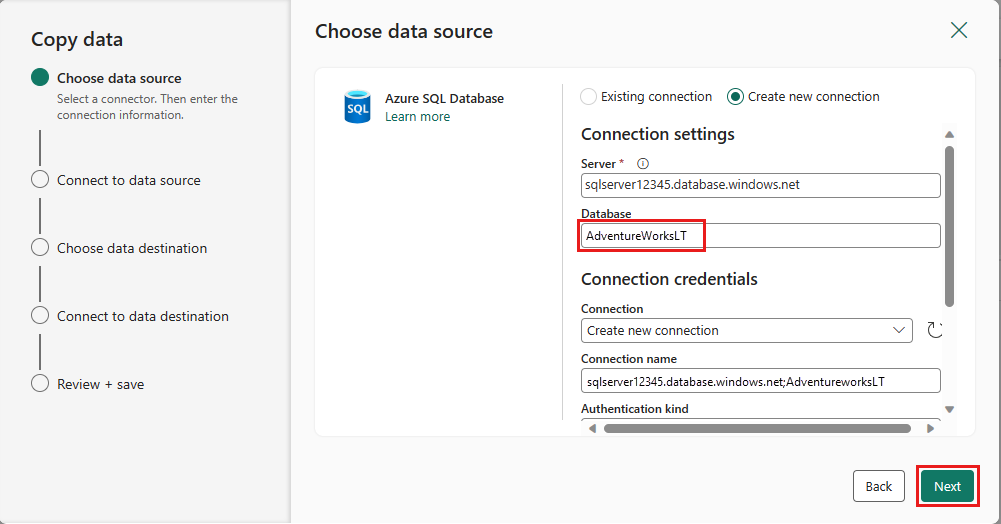

Creare una connessione all'origine dati selezionando Crea nuova connessione. Immettere le informazioni di connessione necessarie nel pannello e immettere AdventureWorksLT per il database, in cui è stata generata la query di merge nel flusso di dati. Quindi seleziona Avanti.

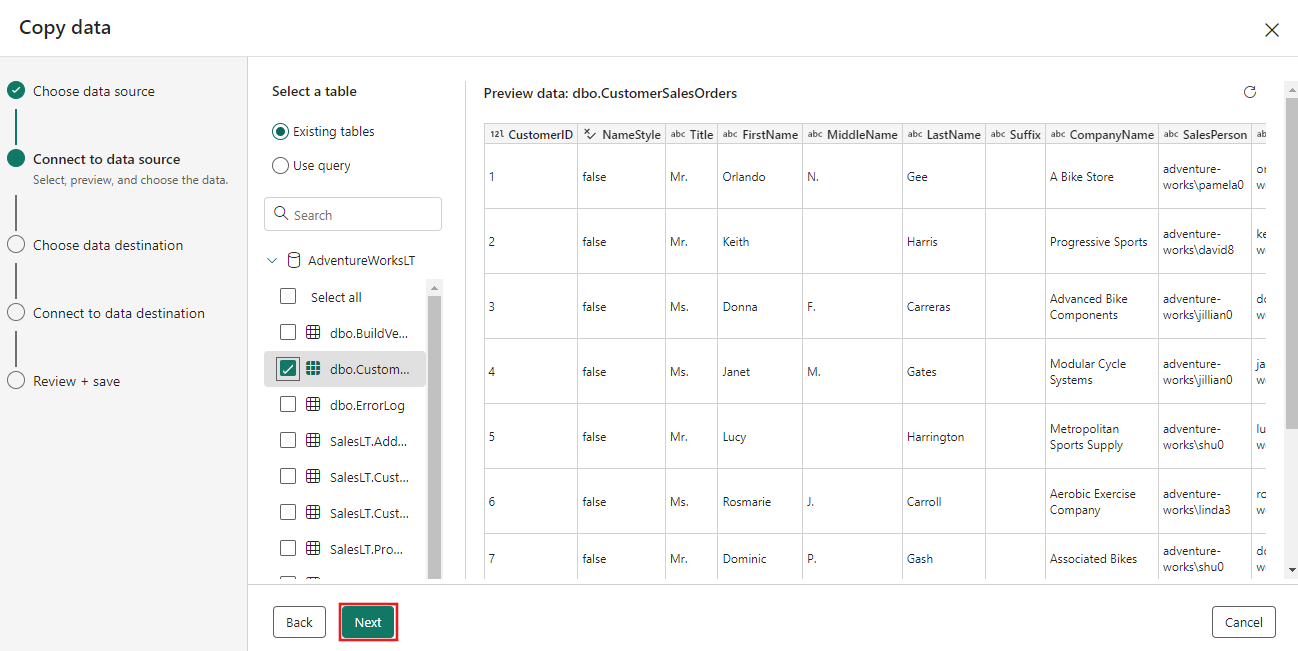

Selezionare la tabella generata nel passaggio del flusso di dati precedente e quindi selezionare Avanti.

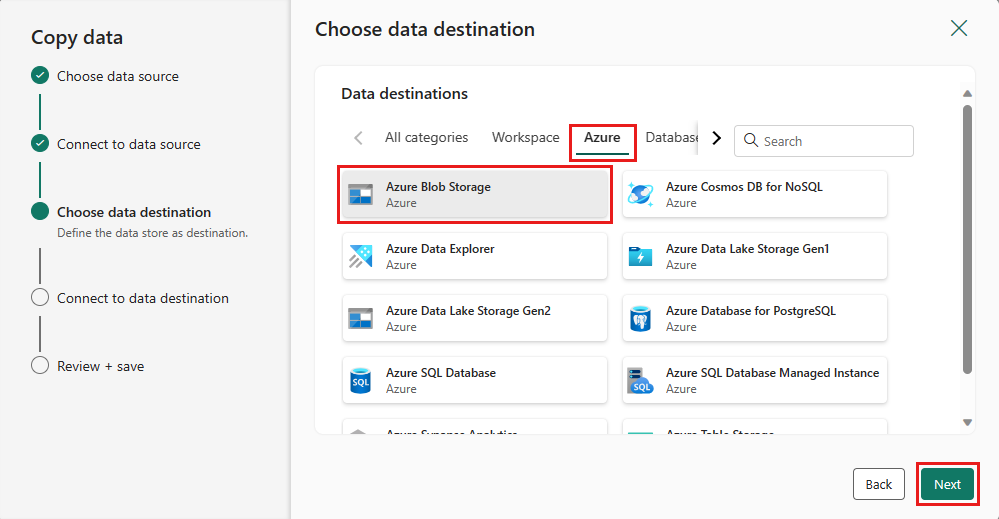

Per la destinazione scegliere Archiviazione BLOB di Azure e quindi selezionare Avanti.

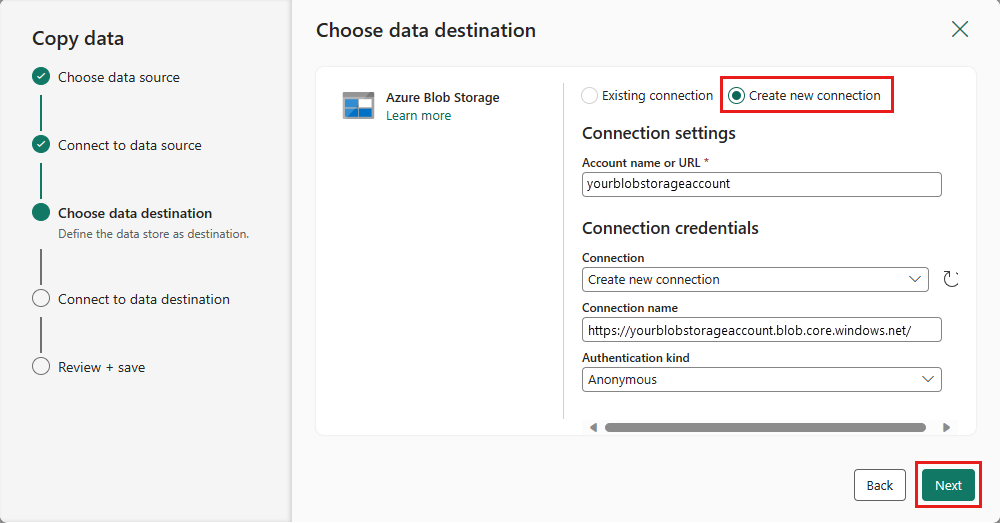

Creare una connessione alla destinazione selezionando Crea nuova connessione. Specificare i dettagli per la connessione e quindi selezionare Avanti.

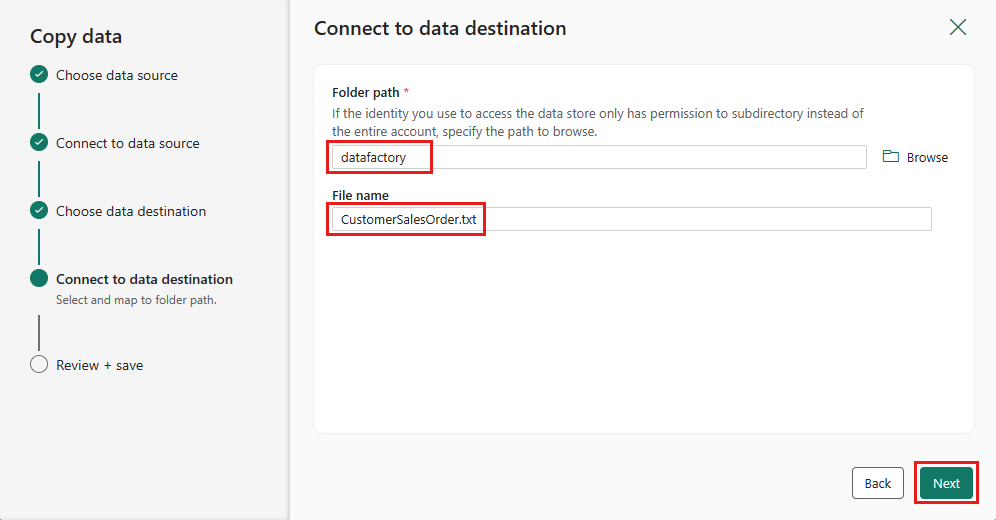

Selezionare il percorso della cartella e specificare un nome file, quindi selezionare Avanti.

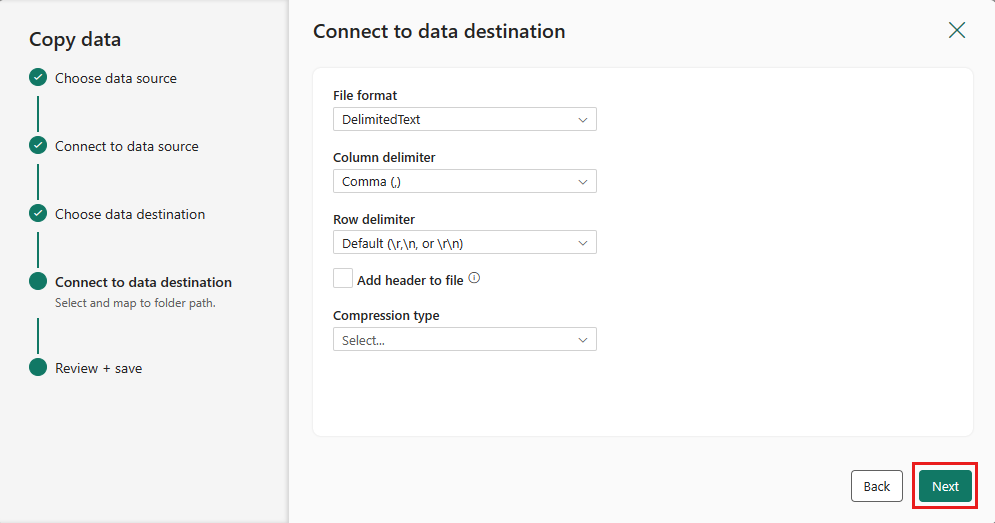

Selezionare di nuovo Avanti per accettare il formato di file predefinito, il delimitatore di colonna, il delimitatore di riga e il tipo di compressione, includendo facoltativamente un'intestazione.

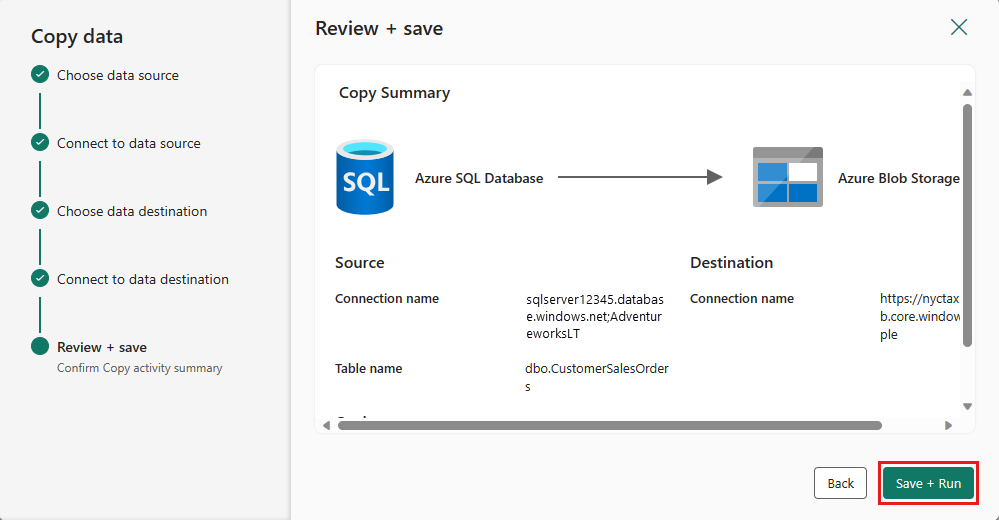

Finalizzare le impostazioni. Esaminare quindi e selezionare Salva + Esegui per completare il processo.

Passaggio 5: Progettare la pipeline di dati e salvare per l'esecuzione e il caricamento dei dati

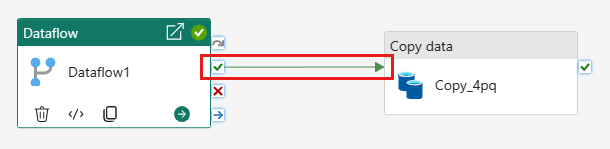

Per eseguire l'attività Copy dopo l'attività Flusso di dati, trascinare da Succeeded nell'attività Flusso di dati all'attività Copia. L'attività Copy viene eseguita solo dopo che l'attività Flusso di dati ha avuto esito positivo.

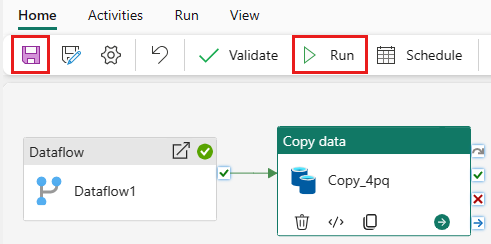

Selezionare Salva per salvare la pipeline di dati. Selezionare quindi Esegui per eseguire la pipeline di dati e caricare i dati.

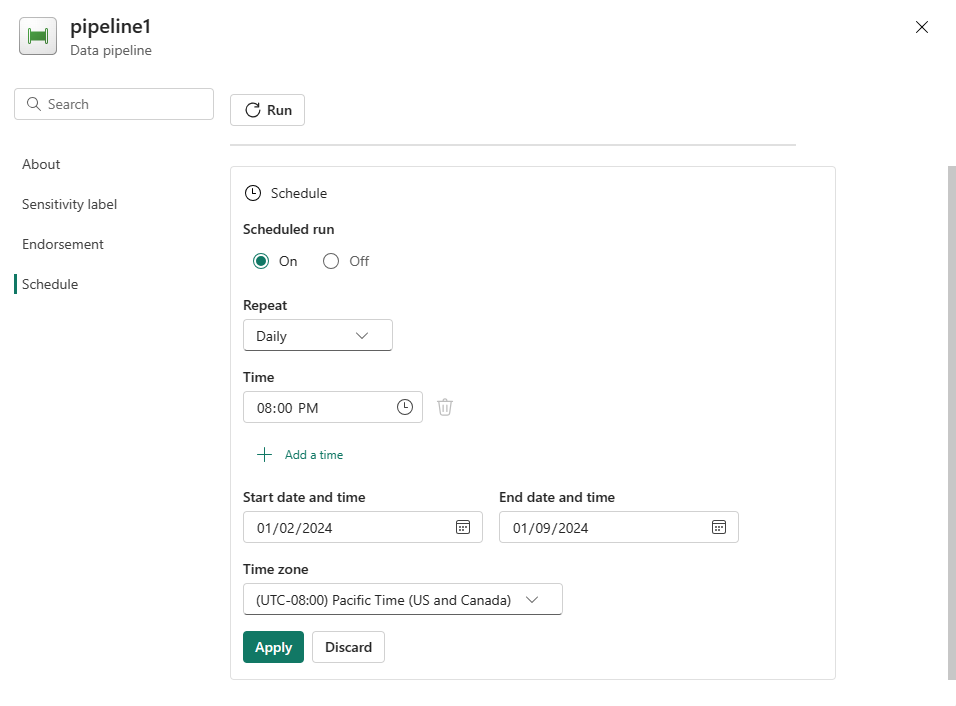

Pianificare l'esecuzione della pipeline

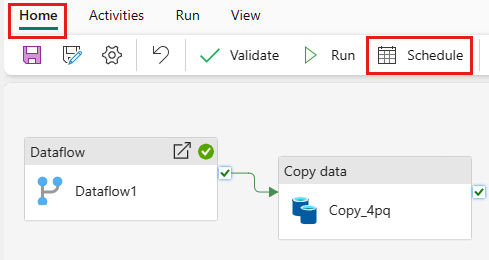

Dopo aver completato lo sviluppo e il test della pipeline, è possibile pianificarlo per l'esecuzione automatica.

Nella scheda Home della finestra dell'editor della pipeline selezionare Pianifica.

Configurare la pianificazione in base alle esigenze. L'esempio seguente pianifica l'esecuzione giornaliera della pipeline alle 18:00 fino alla fine dell'anno.

Contenuto correlato

Questo esempio illustra come creare e configurare un flusso di dati Gen2 per creare una query di merge e archiviarla in un database SQL di Azure, quindi copiare i dati dal database in un file di testo in Archiviazione BLOB di Azure. Contenuto del modulo:

- Creare un flusso di dati.

- Trasformare i dati con il flusso di dati.

- Creare una pipeline di dati usando il flusso di dati.

- Ordinare l'esecuzione dei passaggi nella pipeline.

- Copiare dati con l'Assistente copia.

- Eseguire e pianificare la pipeline di dati.

Passare quindi a altre informazioni sul monitoraggio delle esecuzioni della pipeline.

Commenti e suggerimenti

Presto disponibile: nel corso del 2024 verranno dismessi i problemi di GitHub come meccanismo di feedback per il contenuto e verranno sostituiti con un nuovo sistema di feedback. Per altre informazioni, vedere: https://aka.ms/ContentUserFeedback.

Invia e visualizza il feedback per