Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Queste esercitazioni presentano uno scenario end-to-end completo nell'esperienza di data science di Fabric. Coprono ogni fase, da

- Inserimento dati

- Pulizia dei dati

- Preparazione dei dati

a

- Training del modello di Machine Learning

- Generazione di informazioni dettagliate

e quindi coprire il consumo di tali informazioni dettagliate con gli strumenti di visualizzazione, ad esempio Power BI.

Le persone nuove a Microsoft Fabric devono visitare Che cos'è Microsoft Fabric?.

Introduzione

Un ciclo di vita di un progetto di data science include in genere questi passaggi:

- Comprendere le regole aziendali

- Acquisire i dati

- Esplorare, pulire, preparare e visualizzare i dati

- Addestrare il modello e monitorare l'esperimento

- Assegnare un punteggio al modello e generare informazioni dettagliate

I passaggi spesso procedono in modo iterativo. Gli obiettivi e i criteri di successo di ogni fase dipendono dalla collaborazione, dalla condivisione dei dati e dalla documentazione. L'esperienza di data science di Fabric include più funzionalità predefinite che consentono una collaborazione trasparente, l'acquisizione dei dati, la condivisione e l'utilizzo.

Queste esercitazioni ti pongono nel ruolo di un data scientist che deve esplorare, pulire e trasformare un set di dati che contiene lo stato di abbandono di 10.000 clienti bancari. Si creerà quindi un modello di Machine Learning per stimare quali clienti bancari lasceranno probabilmente.

Nelle esercitazioni si eseguono le attività seguenti:

- Usare i notebook di Fabric per scenari di data science

- Usare Apache Spark per inserire dati in un Fabric lakehouse

- Caricare i dati esistenti dalle tabelle delta lakehouse

- Usare gli strumenti basati su Apache Spark e Python per pulire e trasformare i dati

- Creare esperimenti ed esecuzioni per eseguire il training di modelli di Machine Learning diversi

- Usare MLflow e l'interfaccia utente di Fabric per registrare e tenere traccia dei modelli sottoposti a training

- Eseguire l'assegnazione dei punteggi su larga scala e salvare stime e risultati di inferenza nel lakehouse

- Usare DirectLake per visualizzare le stime in Power BI

Architettura

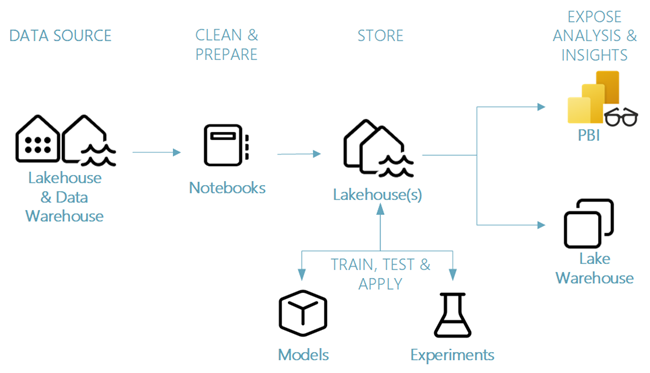

Questa serie di esercitazioni illustra uno scenario di data science end-to-end semplificato che include:

- Inserimento di dati da un'origine dati esterna.

- Esplorazione e pulizia dei dati.

- Training e registrazione dei modelli di Machine Learning.

- Assegnazione di punteggi e salvataggio delle stime in batch.

- Visualizzazione dei risultati della stima in Power BI.

Componenti diversi dello scenario di data science

Origini dati : per inserire dati con Fabric, è possibile connettersi facilmente e rapidamente a Servizi dati di Azure, ad altre piattaforme cloud e alle risorse dati locali. Con i notebook di Fabric è possibile inserire dati da queste risorse:

- Lakehouse incorporati

- Magazzini di Dati

- Modelli semantici

- Varie origini dati di Apache Spark

- Varie origini dati che supportano Python

Questa serie di tutorial è incentrata sull'ingestione e il caricamento dei dati da un lakehouse.

Esplorare, pulire e preparare : l'esperienza di data science di Fabric supporta la pulizia dei dati, la trasformazione, l'esplorazione e la definizione delle funzionalità. Usa esperienze Spark predefinite e strumenti basati su Python, ad esempio Data Wrangler e SemPy Library. Questa esercitazione illustra l'esplorazione dei dati con la seaborn libreria Python e la pulizia e la preparazione dei dati con Apache Spark.

Modelli e esperimenti : con Fabric è possibile eseguire il training, valutare e assegnare punteggi ai modelli di Machine Learning con esperimenti predefiniti. Per registrare e distribuire i modelli e tenere traccia degli esperimenti, MLflow offre una perfetta integrazione con Fabric come modo per modellare gli elementi. Per creare e condividere informazioni dettagliate aziendali, Fabric offre altre funzionalità per la stima del modello su larga scala (PREDICT), per creare e condividere informazioni aziendali dettagliate.

Archiviazione - Fabric standardizza su Delta Lake, il che significa che tutti i motori Fabric possono interagire con lo stesso set di dati archiviato in un lakehouse. Con tale livello di archiviazione, è possibile archiviare dati strutturati e non strutturati che supportano sia l'archiviazione basata su file che il formato tabulare. È possibile accedere facilmente ai set di dati e ai file archiviati tramite tutti gli elementi dell'esperienza Fabric, come notebook e pipeline.

Esporre analisi e informazioni dettagliate : Power BI, uno strumento di business intelligence leader del settore, può usare i dati lakehouse per la generazione di report e visualizzazioni. Nelle risorse del notebook, librerie di visualizzazioni native Python o Spark

matplotlibseabornplotly- E così via.

può visualizzare i dati salvati in un lakehouse. La libreria SemPy supporta anche la visualizzazione dei dati. Questa libreria supporta visualizzazioni ricche e specifiche per attività integrate

- Modello di dati semantico

- Dipendenze e violazioni

- Casi d'uso di classificazione e regressione