Eventi

29 apr, 14 - 30 apr, 19

Join the ultimate Windows Server virtual event April 29-30 for deep-dive technical sessions and live Q&A with Microsoft engineers.

Sign up nowQuesto browser non è più supportato.

Esegui l'aggiornamento a Microsoft Edge per sfruttare i vantaggi di funzionalità più recenti, aggiornamenti della sicurezza e supporto tecnico.

Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Questo articolo descrive i requisiti hardware minimi per Spazi di archiviazione diretta. Per i requisiti hardware su Azure Locale, il nostro sistema operativo progettato per le distribuzioni iperconvergenti con una connessione al cloud, vedere Prima di distribuire Azure Locale: determinare i requisiti hardware.

Per la produzione, Microsoft consiglia di acquistare una soluzione hardware/software convalidata dai partner, che includono strumenti e procedure di distribuzione. Queste soluzioni sono progettate, assemblate e convalidate in base all'architettura di riferimento per garantire la compatibilità e l'affidabilità, in modo da essere operativi rapidamente. Per le soluzioni hardware, visitare il sito Web soluzioni locali di Azure.

Suggerimento

Si vuole valutare Spazi di archiviazione diretta ma non si dispone di hardware? Usare macchine virtuali Hyper-V o Azure come descritto in Uso di Spazi di archiviazione diretta nei cluster di macchine virtuali guest.

Importante

Negli scenari in cui vengono implementati i nodi del cluster, schede di interfaccia di rete, driver e firmware devono essere una corrispondenza esatta per il corretto funzionamento del raggruppamento SET.

I sistemi, i componenti, i dispositivi e i driver devono essere certificati per il sistema operativo usato nel Catalogo di Windows Server. Inoltre, è consigliabile che i server e le schede di rete abbiano le qualifiche aggiuntive SDDC (Software-Defined Data Center) Standard e/o Software-Defined Data Center (SDDC) Premium, come illustrato di seguito. Sono presenti più di 1.000 componenti con le domande frequenti su SDDC.

Il cluster completamente configurato (server, rete e archiviazione) deve superare tutti i test di convalida del cluster in Base alla procedura guidata in Gestione cluster di failover o con il Test-Clustercmdlet in PowerShell.

Inoltre, si applicano i requisiti seguenti:

Spazi di archiviazione diretta richiede una connessione di rete a bassa latenza e larghezza di banda elevata affidabile tra ogni nodo.

Interconnessione minima per un nodo su scala ridotta 2-3

Interconnessione consigliata per prestazioni elevate, su larga scala o distribuzioni di 4+

Interconnessioni di nodi commutati o commutatori

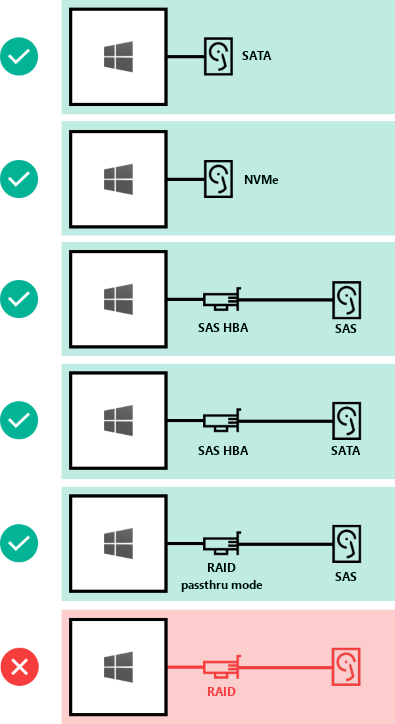

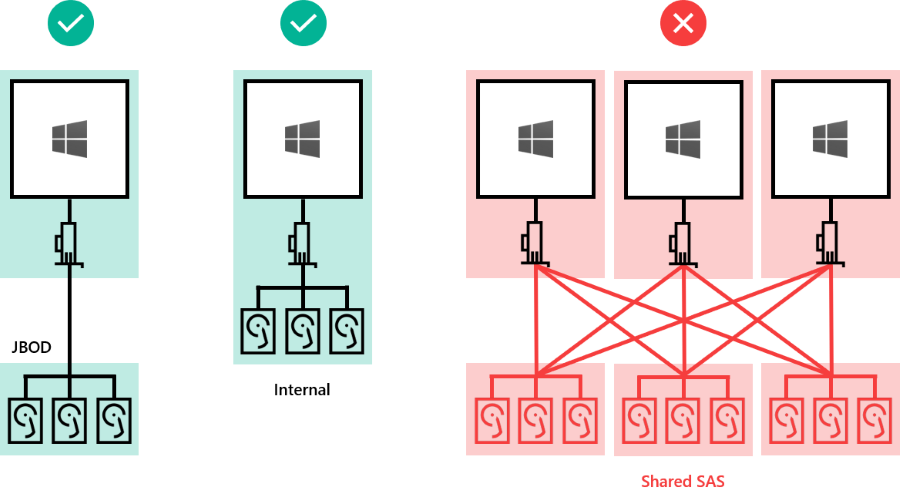

Spazi di archiviazione diretta funziona con unità SATA, SAS, NVMe o memoria persistente collegate fisicamente a un solo server. Per altre informazioni sulla scelta delle unità, vedere gli articoli Scelta delle unità e Informazioni e distribuzione della memoria persistente.

Nota

Quando si usano tutte le unità flash per la capacità di archiviazione, i vantaggi della memorizzazione nella cache del pool di archiviazione saranno limitati. Altre informazioni sulla cache del pool di archiviazione.

Ecco come connettere le unità per Spazi di archiviazione diretta:

Le unità possono essere interne al server o in un enclosure esterno connesso a un solo server. Per il mapping e l'identificazione degli slot è necessario SCSI Enclosure Services (SES) per il mapping e l'identificazione degli slot. Ogni enclosure esterno deve presentare un identificatore univoco (ID univoco).

Il numero minimo di unità di capacità necessarie varia in base allo scenario di distribuzione. Se si prevede di usare la cache del pool di archiviazione, devono essere presenti almeno 2 dispositivi cache per server.

È possibile distribuire Spazi di archiviazione diretta in un cluster di server fisici o in cluster guest di macchine virtuali (VM). È possibile configurare la progettazione di Spazi di archiviazione diretta per scenari di prestazioni, capacità o bilanciati in base alla selezione di dispositivi di archiviazione fisici o virtuali. Le distribuzioni virtualizzate sfruttano le prestazioni e la resilienza sottostanti del cloud privato o pubblico. Spazi di archiviazione diretta distribuiti nei cluster guest delle macchine virtuali consente di usare soluzioni a disponibilità elevata all'interno dell'ambiente virtuale.

Le sezioni seguenti descrivono i requisiti minimi delle unità per le distribuzioni fisiche e virtuali.

Questa tabella mostra il numero minimo di unità disco per la capacità minima per tipo per le distribuzioni hardware, come Azure Local versione 21H2 o successiva e Windows Server.

| Tipo di unità presente (solo capacità) | Unità minime necessarie (Windows Server) | Numero minimo di unità richieste (Azure locale) |

|---|---|---|

| Tutta la memoria persistente (stesso modello) | 4 unità memoria persistente | 2 unità memoria persistente |

| Tutti i NVMe (stesso modello) | 4 NVMe | 2 NVMe |

| Tutte le unità SSD (stesso modello) | 4 UNITÀ SSD | 2 UNITÀ SSD |

Se si usa la cache del pool di archiviazione, per la cache devono essere configurate almeno 2 unità. La tabella mostra il numero minimo di unità necessarie per le distribuzioni sia di Windows Server che di Azure Local usando 2 o più nodi.

| Tipo di unità presente | Unità minime necessarie |

|---|---|

| Memoria persistente + NVMe o SSD | 2 unità memoria persistente + 4 NVMe o SSD |

| NVMe + SSD | 2 NVMe + 4 SSD |

| NVMe + HDD | 2 NVMe + 4 HDD |

| SSD + HDD | 2 unità SSD + 4 HDD |

Importante

La cache del pool di archiviazione non può essere usata con Azure Local in una distribuzione a nodo singolo.

Questa tabella mostra il numero minimo di unità per tipo per le distribuzioni virtuali, ad esempio macchine virtuali guest di Windows Server o Windows Server Azure Edition.

| Tipo di unità presente (solo capacità) | Unità minime necessarie |

|---|---|

| Dischi rigidi virtuali | 2 |

Suggerimento

Per migliorare le prestazioni delle macchine virtuali guest durante l'esecuzione su Azure Local o Windows Server, è consigliabile utilizzare la cache di lettura in memoria CSV per le operazioni di lettura non buffered.

Se si usa Spazi di archiviazione diretta in un ambiente virtuale, è necessario prendere in considerazione:

Altre informazioni sulla distribuzione di spazi di archiviazione diretta tramite macchine virtuali e archiviazione virtualizzata.

| Massimi | Windows Server 2019 o versione successiva | Windows Server 2016 |

|---|---|---|

| Capacità non elaborata per server | 400 TB | 100 TB |

| Capacità del pool | 4 PB (4,000 TB) | 1 PB |

Eventi

29 apr, 14 - 30 apr, 19

Join the ultimate Windows Server virtual event April 29-30 for deep-dive technical sessions and live Q&A with Microsoft engineers.

Sign up now