適用対象: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

ヒント

Microsoft Fabric の Data Factory (企業向けのオールインワン分析ソリューション) を試してみてください。 Microsoft Fabric では、データ移動からデータ サイエンス、リアルタイム分析、ビジネス インテリジェンス、レポートまで、あらゆるものをカバーしています。 無料で新しい試用版を開始する方法については、こちらを参照してください。

Azure Data Factory へようこそ この記事は、最初のデータ ファクトリとパイプラインを 5 分以内に作成するのに役立ちます。

この記事の Azure Resource Manager テンプレート (ARM テンプレート) は、必要なものをすべて作成して構成します。 その後、デモ データ ファクトリに移動し、パイプラインをトリガーして、いくつかのサンプル データをある Azure Blob Storage フォルダーから別の Azure Blob Storage フォルダーに移動できます。

前提条件

Azure サブスクリプションをお持ちでない場合は、開始する前に 無料アカウント を作成してください。

動画の概要

次のビデオでは、この記事のサンプルのチュートリアルを示します。

手順 1: デモを使用してリソースを作成する

このデモ シナリオでは、データ ファクトリの コピー アクティビティ を使用して、moviesDB2.csv という名前の BLOB を Azure Blob Storage の入力フォルダーから出力フォルダーにコピーします。 実際のシナリオでは、このコピー操作は、サービスで使用できる多数のサポートされているデータ ソースとシンクの間に存在する可能性があります。 また、データに変換が含まれる場合もあります。

次のボタンを選択します。

ボタンを選択すると、次の Azure リソースが作成されます。

- Azure Data Factory アカウント

- 1 つのコピー アクティビティが存在するパイプラインを含むデータ ファクトリ

- moviesDB2.csv がソースとして入力フォルダーにアップロードされた Azure Blob Storage アカウント

- データ ファクトリを Blob Storage に接続するためのリンクされたサービス

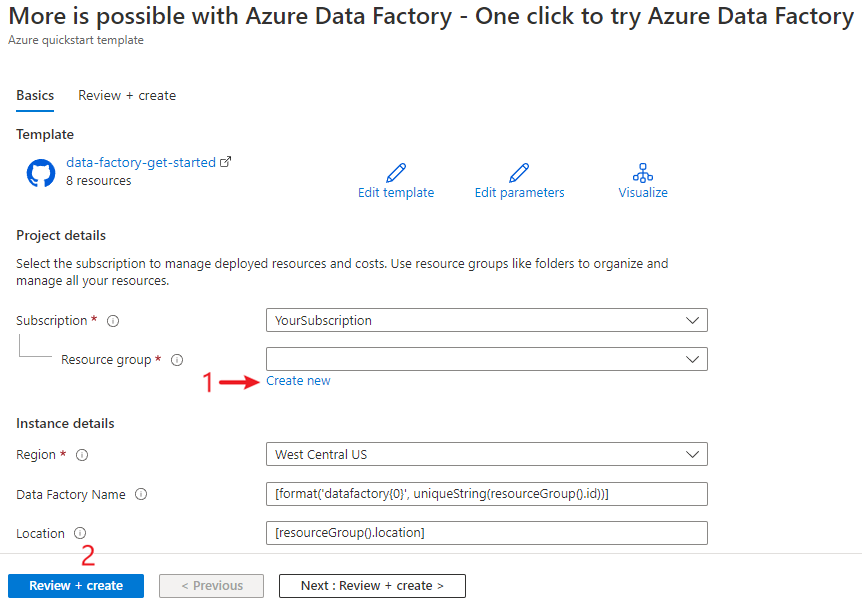

テンプレートをデプロイするための構成ページが表示されます。 このページでの手順:

[リソース グループ] で、[新規作成] を選択してリソース グループを作成します。 他のすべての値は既定値のままにしておくことができます。

[ 確認と作成] を選択し、[ 作成 ] を選択してリソースをデプロイします。

Note

テンプレートをデプロイするユーザーは、マネージド ID にロールを割り当てる必要があります。 この手順には、所有者、ユーザー アクセス管理者、またはマネージド ID オペレーター ロールを通じて付与できるアクセス許可が必要です。

このデモのすべてのリソースは新しいリソース グループに作成されるため、後で簡単にクリーンアップできます。

手順 2: デプロイされているリソースを確認する

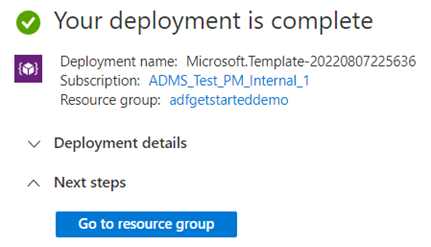

デプロイが正常に完了したことを示すメッセージで、[ リソース グループに移動] を選択します。

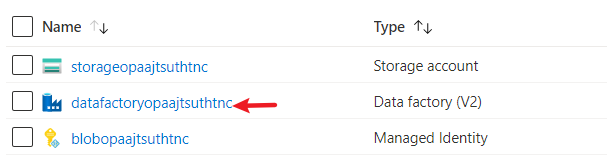

リソース グループには、デプロイによって作成された新しいデータ ファクトリ、Blob Storage アカウント、およびマネージド ID が含まれます。 リソース グループ内のデータ ファクトリを選択して表示します。

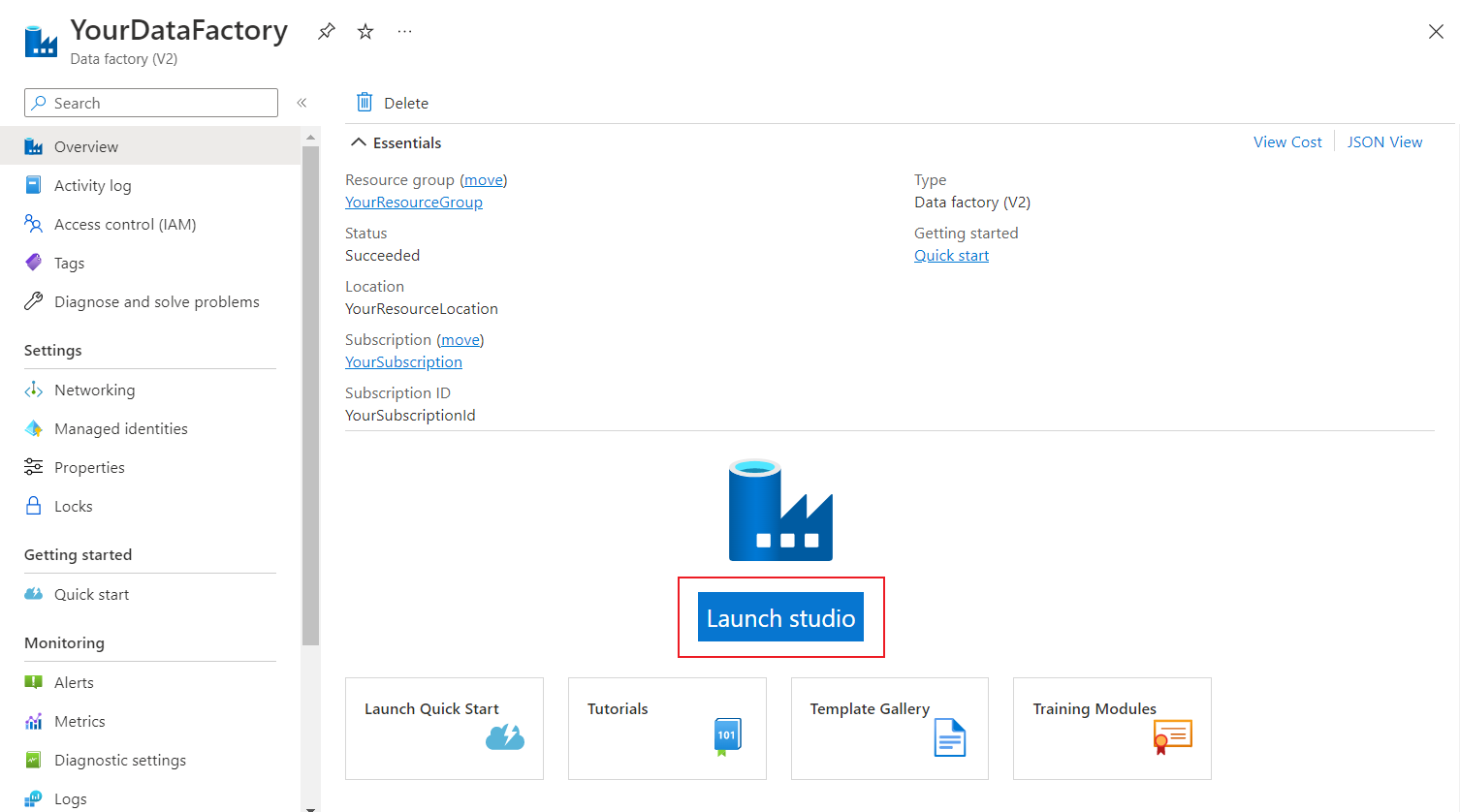

[ Launch studio]\(スタジオの起動 \) ボタンを選択します。

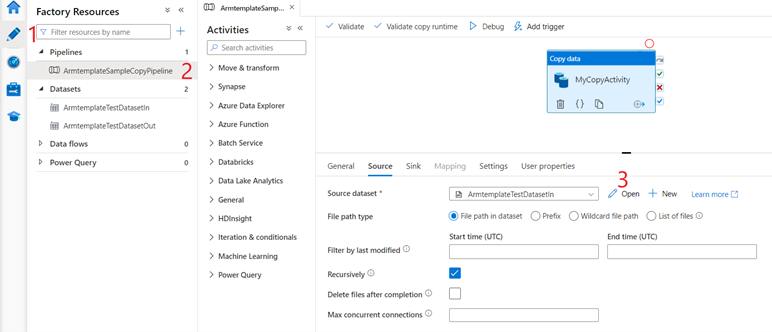

Azure Data Factory Studio で次の手順を実行します。

- [ 作成者 ] タブの

![[作成者] タブを選択します](media/quickstart-get-started/author-button.png) 。

。 - テンプレートが作成したパイプラインを選択します。

- [開く] を選択して、ソース データを確認します。

- [ 作成者 ] タブの

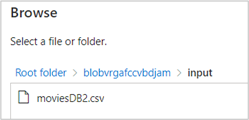

ソース データセットで、[ 参照 ] を選択して、デモ用に作成された入力ファイルを表示します。

![[参照] ボタンが強調表示されているソース データセットのスクリーンショット。](media/quickstart-get-started/source-dataset-browse.png)

入力フォルダーに既にアップロードされている moviesDB2.csv ファイルをメモします。

手順 3: デモ パイプラインをトリガーして実行する

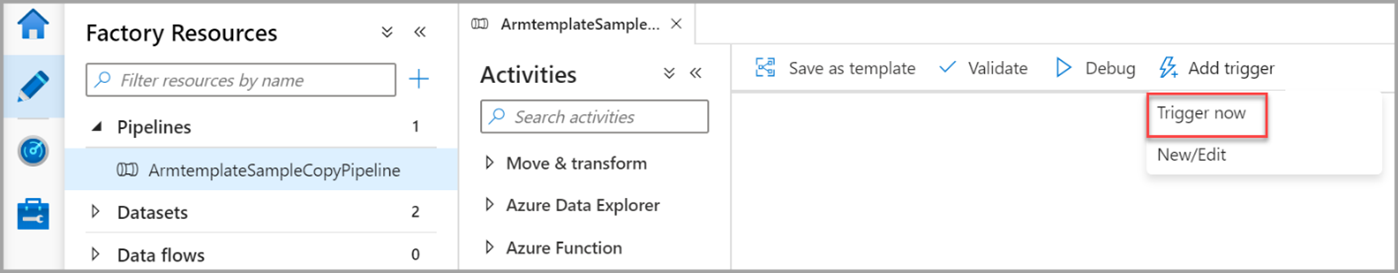

[ トリガーの追加] を選択し、[ 今すぐトリガー] を選択します。

右側のウィンドウで、[ パイプラインの実行] で [ OK] を選択します。

パイプラインの監視

[監視] タブ

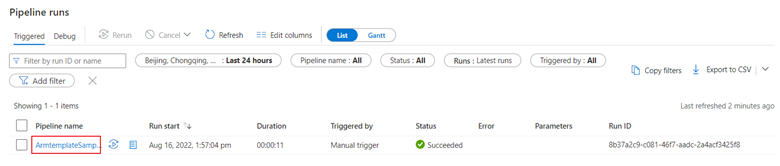

![[監視] タブ](media/quickstart-get-started/monitor-button.png) を選択します。 このタブには、開始時刻や状態など、パイプラインの実行の概要が表示されます。

を選択します。 このタブには、開始時刻や状態など、パイプラインの実行の概要が表示されます。

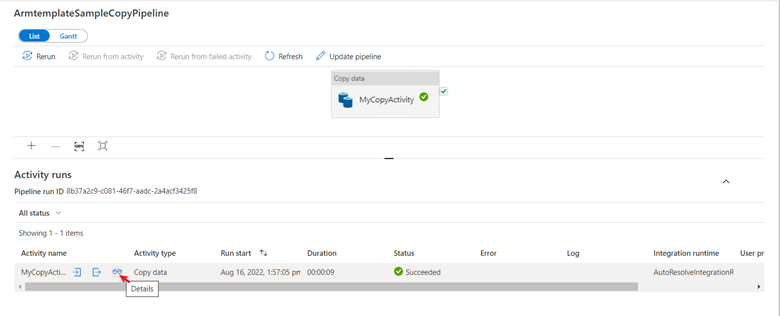

このクイック スタートでは、パイプラインに含まれるアクティビティの種類は 1 つだけです。 データのコピーです。 パイプライン名を選択して、コピー アクティビティの実行結果の詳細を表示します。

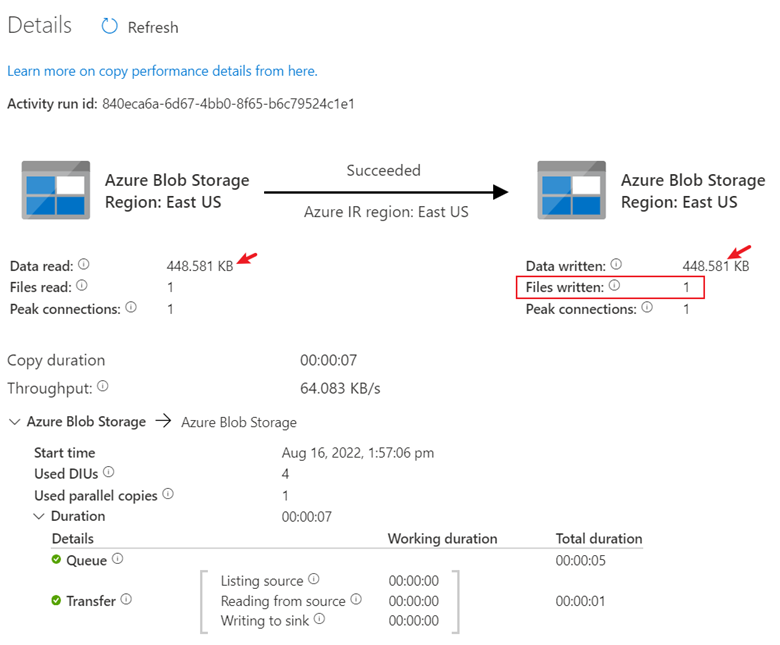

詳細アイコンを選択すると、詳細なコピー プロセスが表示されます。 結果では、データの読み取りとデータの書き込みサイズは同じであり、1 つのファイルが読み書きされました。 この情報は、すべてのデータが正常にコピー先にコピーされたことを証明します。

リソースをクリーンアップする

この記事で作成したすべてのリソースは、次の 2 つの方法のいずれかでクリーンアップできます。

1 つは Azure リソース グループを削除する方法で、この場合、そのリソース グループに含まれているすべてのリソースが対象となります。

一部のリソースをそのまま保持する場合は、リソース グループに移動し、削除する特定のリソースのみを削除します。

たとえば、このテンプレートを使用して別のチュートリアルで使用するデータ ファクトリを作成する場合は、他のリソースを削除できますが、データ ファクトリのみを保持できます。

関連コンテンツ

この記事では、コピー アクティビティを含むパイプラインを含むデータ ファクトリを作成しました。 Azure Data Factory の詳細については、次の記事とトレーニング モジュールに進んでください。