Windows Data Science Virtual Machine (DSVM) は強力なデータ サイエンス開発環境であり、データ探索およびモデリングのタスクをサポートします。 この環境には、いくつかの一般的なデータ分析ツールが事前に構築され、バンドルされているため、オンプレミス、クラウド、またはハイブリッドのデプロイの分析を簡単に開始できます。

DSVM は Azure サービスと密接に連携します。 これは、Azure 上の Azure Synapse (旧称 SQL DW)、Azure Data Lake、Azure Storage、または Azure Cosmos DB に既に格納されているデータを読み取って処理することができます。 Azure Machine Learning など、その他の分析ツールを利用することもできます。

この記事では、DSVM を使用して、データ サイエンス タスクの処理と、他の Azure サービスとのやり取りの両方を行う方法について説明します。 DSVM で対応できるタスクのサンプルを次に示します。

- Jupyter Notebook を使用し、ブラウザーで Python 2、Python 3、Microsoft R を使用してデータの実験を行う (Microsoft R は、ハイ パフォーマンスを実現するように設計されたエンタープライズ対応バージョンの R です)。

- DSVM 上で Microsoft Machine Learning Server および Python を使用してローカルでデータの探索とモデルの開発を行う。

- Azure portal または PowerShell を使用して Azure リソースを管理する。

- DSVM 上のマウント可能なドライブとして Azure Files 共有を使用して、ストレージ スペースを拡張し、大規模なデータセットおよびコードをチーム全体で共有する。

- GitHub を使用してチームでコードを共有する。 プレインストールされている Git クライアント (Git Bash および Git GUI) を使用してリポジトリにアクセスする。

- Azure のデータと分析サービスにアクセスする。

- Azure Blob Storage

- Azure Cosmos DB (アジュール コスモス データベース)

- Azure Synapse (旧称 SQL DW)

- Azure SQL データベース

- DSVM にプレインストールされている Power BI Desktop インスタンスを使用してレポートとダッシュボードを作成し、それらをクラウドにデプロイする。

- 仮想マシンに追加のツールをインストールする。

注

この記事に一覧したデータ ストレージ サービスおよび分析サービスの多くには、追加の使用料金が適用されます。 詳細については、Azure の価格に関するページをご覧ください。

前提条件

- Azure サブスクリプション。 Azure サブスクリプションをお持ちでない場合は、開始する前に 無料アカウント を作成してください。

- Azure portal 上のプロビジョニングされた DSVM。 詳細については、仮想マシンの作成 リソースを参照してください。

注

Azure を操作するには、Azure Az PowerShell モジュールを使用することをお勧めします。 作業を始めるには、「Azure PowerShell をインストールする」を参照してください。 Az PowerShell モジュールに移行する方法については、「AzureRM から Az への Azure PowerShell の移行」を参照してください。

Jupyter Notebook を使用する

Jupyter Notebook には、データ探索とモデリング用のブラウザーベースの IDE が用意されています。 Jupyter Notebook では Python 2、Python 3、R のいずれも使用することができます。

Jupyter Notebook を開始するには、 [スタート] メニューまたはデスクトップで [Jupyter Notebook] アイコンを選択します。 DSVM コマンド プロンプトで、既存のノートブックをホストするディレクトリ、または新しいノートブックを作成するディレクトリからコマンド jupyter notebook を実行することもできます。

Jupyter を起動したら、/notebooks ディレクトリに移動します。 このディレクトリは、DSVM に事前にパッケージ化されたノートブックの例をホストします。 次のことを実行できます。

- ノートブックを選択してコードを表示します。

- Shift+Enter キーを押して、各セルを実行します。

- [セル]>[実行] の順に選択して、ノートブック全体を実行します。

- 新しいノートブックを作成します。そのためには、Jupyter アイコン (左上隅) を選択し、[新規] ボタンを選択して、ノートブックの言語 (カーネルとも呼ばれます) を選択します。

注

現在、Jupyter では Python 2.7、Python 3.6、R、Julia、PySpark カーネルがサポートされています。 R カーネルは、オープンソース R と Microsoft R の両方でのプログラミングをサポートしています。ノートブックでは、選択したライブラリを使用して、データの探索、モデルの構築、そのモデルのテストを行うことができます。

Microsoft Machine Learning Server を使用してデータを探索し、モデルを開発する

注

Machine Learning Server スタンドアロンのサポートは 2021 年 7 月 1 日に終了しました。 これは、2021 年 6 月 30 日以降、DSVM イメージから削除されています。 既存のデプロイでも引き続きソフトウェアにアクセスできますが、サポートは、2021 年 7 月 1 日に終了しました。

R および Python を使用して、DSVM 上で直接データ分析を実行できます。

R の場合、R Tools for Visual Studio を使用できます。 Microsoft は、オープン ソース CRAN R リソースに加えて、他のライブラリも提供しています。 これらのライブラリを使用すると、スケーラブルな分析と、並列チャンク分析のメモリ サイズ制限を超える大量のデータを分析する機能の両方が可能になります。

Python の場合、IDE (たとえば、Python Tools for Visual Studio (PTVS) 拡張機能がプレインストールされている Visual Studio Community Edition など) を使用できます。 既定では、ルート Conda 環境である Python 3.6 のみが PTVS で構成されます。 Anaconda Python 2.7 を有効にするには、次の手順を行います。

- バージョンごとにカスタム環境を作成します。 [ツール]>[Python ツール]>[Python 環境] の順に移動し、Visual Studio Community エディションで [+ カスタム] を選択します。

- 説明を入力し、環境プレフィックス パスを設定します (Anaconda Python 2.7 の場合は c:\anaconda\envs\python2)。

- [自動検出]>[適用] の順に選択して環境を保存します。

Python 環境の作成方法の詳細については、PTVS のドキュメント リソースを参照してください。

これで、新しい Python プロジェクトを作成できるようになりました。 [ファイル]>[新規]>[プロジェクト]>[Python] の順に選択し、ビルドする Python アプリケーションの種類を選択します。 [Python 環境] を右クリックして、[Python 環境の追加/削除] を選択すると、現在のプロジェクトの Python 環境を目的のバージョン (Python 2.7 または 3.6) に設定できます。 PTVS の操作の詳細については、製品のドキュメントを参照してください。

Azure のリソースを管理する

DSVM を使用すると、仮想マシン上でローカルに分析ソリューションを構築できます。 また、Azure クラウド プラットフォーム上のサービスには、アクセスすることができます。 Azure には、コンピューティング、ストレージ、データ分析など、DSVM から管理およびアクセスできるいくつかのサービスが用意されています。

Azure サブスクリプションとクラウド リソースを管理するには、次の 2 つのオプションを使用できます。

ブラウザーで Azure portal にアクセスします。

PowerShell スクリプトを使用します。 デスクトップ上のショートカットから、または [スタート] メニューから Azure PowerShell を実行します。 詳細については、Microsoft Azure PowerShell のドキュメント リソースを参照してください。

共有ファイル システムを使用してストレージを拡張する

データ サイエンティストは、大きなデータセットやコードなどのリソースをチーム内で共有することができます。 DSVM には約 45 GB の使用可能な領域があります。 ストレージを拡張するには、Azure Files を使用できます。これを 1 つ以上の DSVM インスタンスにマウントするか、または REST API 経由でアクセスします。 また、Azure portal を使用するか、または Azure PowerShell を使用して、専用のデータ ディスクを追加することもできます。

注

Azure File 共有の最大領域は、5 TB です。 各ファイルのサイズは、1 TB に制限されます。

次の Azure PowerShell スクリプトは、Azure Files 共有を作成します。

# Authenticate to Azure.

Connect-AzAccount

# Select your subscription

Get-AzSubscription –SubscriptionName "<your subscription name>" | Select-AzSubscription

# Create a new resource group.

New-AzResourceGroup -Name <dsvmdatarg>

# Create a new storage account. You can reuse existing storage account if you want.

New-AzStorageAccount -Name <mydatadisk> -ResourceGroupName <dsvmdatarg> -Location "<Azure Data Center Name For eg. South Central US>" -Type "Standard_LRS"

# Set your current working storage account

Set-AzCurrentStorageAccount –ResourceGroupName "<dsvmdatarg>" –StorageAccountName <mydatadisk>

# Create an Azure Files share

$s = New-AzStorageShare <<teamsharename>>

# Create a directory under the file share. You can give it any name

New-AzStorageDirectory -Share $s -Path <directory name>

# List the share to confirm that everything worked

Get-AzStorageFile -Share $s

Azure Files 共有は、Azure 内の任意の仮想マシンにマウントできます。 待機時間とデータ転送料金の発生を回避するために、VM とストレージ アカウントを同じ Azure データ センターに配置することをお勧めします。 次の Azure PowerShell コマンドは、DSVM にドライブをマウントします。

# Get the storage key of the storage account that has the Azure Files share from the Azure portal. Store it securely on the VM to avoid being prompted in the next command.

cmdkey /add:<<mydatadisk>>.file.core.windows.net /user:<<mydatadisk>> /pass:<storage key>

# Mount the Azure Files share as drive Z on the VM. You can choose another drive letter if you want.

net use z: \\<mydatadisk>.file.core.windows.net\<<teamsharename>>

このドライブには、VM 上の通常のドライブと同様にアクセスできます。

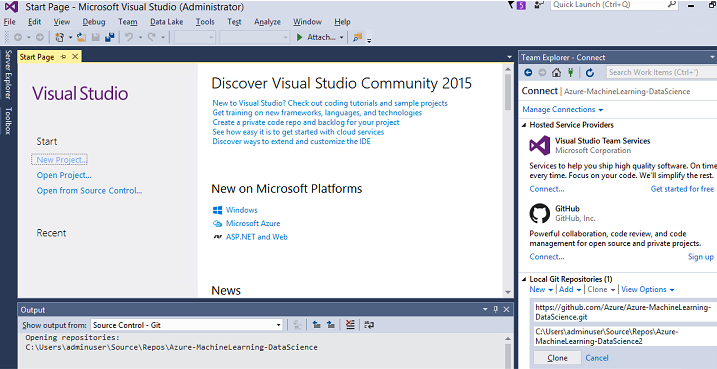

GitHub でコードを共有する

GitHub コード リポジトリは、開発者コミュニティで共有される多くのツールのコード サンプルとコード ソースをホストします。 GitHub には、コード ファイルのバージョンを追跡して保存する技術として Git が使用されています。 GitHub は、独自のリポジトリを作成するためのプラットフォームとしても機能します。 独自のリポジトリには、チームで共有されるコードとドキュメントを格納できます。また、バージョン管理を実装したり、コードの表示や投稿を行う関係者のアクセス許可を制御したりすることもできます。 GitHub では、チーム内のコラボレーション、コミュニティによって開発されたコードの使用、コミュニティへのコードの投稿がサポートされます。 Git の詳細については、GitHub のヘルプ ページを参照してください。

DSVM には、GitHub リポジトリにアクセスするためのクライアント ツールがコマンド ラインと GUI に読み込まれています。 Git Bash コマンドライン ツールは、Git と GitHub で動作します。 Visual Studio は DSVM にインストールされ、Git 拡張機能を備えています。 [スタート] メニューとデスクトップには、これらのツールのアイコンがあります。

GitHub リポジトリからコードをダウンロードするには、git clone コマンドを使用します。 Microsoft によって発行されたデータ サイエンス リポジトリを現在のディレクトリにダウンロードするには、Git Bash で次のコマンドを実行します。

git clone https://github.com/Azure/DataScienceVM.git

Visual Studio では、同じクローン操作を処理できます。 次のスクリーンショットは、Visual Studio で Git と GitHub のツールにアクセスする方法を示しています。

GitHub リポジトリでは、使用可能な github.com リソースを操作できます。 詳細については、GitHub チート シート リソースを参照してください。

Azure のデータ サービスと分析サービスにアクセスする

Azure Blob Storage

Azure Blob Storage は、大規模データと小規模データのどちらにも対応できる信頼性と経済性に優れたクラウド ストレージ サービスです。 このセクションでは、データを BLOB ストレージに移動し、Azure BLOB に格納されているデータにアクセスする方法について説明します。

前提条件

Azure Portal で作成された Azure BLOB ストレージ アカウント。

次のコマンドを使用して、コマンドライン AzCopy ツールがプレインストールされていることを確認します。

C:\Program Files (x86)\Microsoft SDKs\Azure\AzCopy\azcopy.exeazcopy.exe をホストするディレクトリは既に PATH 環境変数に含まれているため、このツールの実行時に完全なコマンド パスを入力せずに済みます。 AzCopy ツールの詳細については、AzCopy のドキュメントを参照してください。

Azure Storage Explorer ツールを起動します。 これは Storage Explorer の Web ページからダウンロードできます。

VM から Azure BLOB にデータを移動する: AzCopy

ローカル ファイルと BLOB ストレージとの間のデータ移動には、次のように、コマンド ラインまたは PowerShell から AzCopy を使用します。

AzCopy /Source:C:\myfolder /Dest:https://<mystorageaccount>.blob.core.windows.net/<mycontainer> /DestKey:<storage account key> /Pattern:abc.txt

- C:\myfolder を、ファイルをホストするディレクトリ パスに置き換えます

- mystorageaccount を Blob Storage アカウント名に置き換えます

- mycontainer をコンテナー名に置き換えます

- storage account key を自分の Blob ストレージ アクセス キーに置き換えます

ストレージ アカウントの資格情報は、Azure portal で確認できます。

AzCopy コマンドは、PowerShell またはコマンド プロンプトから実行します。 AzCopy コマンドの例を次に示します。

# Copy *.sql from a local machine to an Azure blob

"C:\Program Files (x86)\Microsoft SDKs\Azure\AzCopy\azcopy" /Source:"c:\Aaqs\Data Science Scripts" /Dest:https://[ENTER STORAGE ACCOUNT].blob.core.windows.net/[ENTER CONTAINER] /DestKey:[ENTER STORAGE KEY] /S /Pattern:*.sql

# Copy back all files from an Azure blob container to a local machine

"C:\Program Files (x86)\Microsoft SDKs\Azure\AzCopy\azcopy" /Dest:"c:\Aaqs\Data Science Scripts\temp" /Source:https://[ENTER STORAGE ACCOUNT].blob.core.windows.net/[ENTER CONTAINER] /SourceKey:[ENTER STORAGE KEY] /S

AzCopy コマンドを実行してファイルを Azure BLOB にコピーすると、Azure Storage Explorer にファイルが表示されます。

VM から Azure BLOB にデータを移動する: Azure Storage Explorer

Azure Storage Explorer を使用して、VM 内のローカル ファイルからデータをアップロードすることもできます。

データをコンテナーにアップロードするには、アップロード先のコンテナーを選択し、[アップロード] ボタンを選択します。

[ファイル] ボックスの右側にある省略記号 (...) を選択し、アップロードする 1 つ以上のファイルをファイル システムから選択した後、[アップロード] を選択して、ファイルのアップロードを開始します。

Azure BLOB からデータを読み取る: Python ODBC

BlobService ライブラリを使用すると、Jupyter Notebook または Python プログラム内で BLOB から直接データを読み取ることができます。 まず、必須のパッケージをインポートします。

import pandas as pd

from pandas import Series, DataFrame

import numpy as np

import matplotlib.pyplot as plt

from time import time

import pyodbc

import os

from azure.storage.blob import BlobService

import tables

import time

import zipfile

import random

BLOB ストレージ アカウント資格情報を接続し、BLOB からデータを読み取ります。

CONTAINERNAME = 'xxx'

STORAGEACCOUNTNAME = 'xxxx'

STORAGEACCOUNTKEY = 'xxxxxxxxxxxxxxxx'

BLOBNAME = 'nyctaxidataset/nyctaxitrip/trip_data_1.csv'

localfilename = 'trip_data_1.csv'

LOCALDIRECTORY = os.getcwd()

LOCALFILE = os.path.join(LOCALDIRECTORY, localfilename)

#download from blob

t1 = time.time()

blob_service = BlobService(account_name=STORAGEACCOUNTNAME,account_key=STORAGEACCOUNTKEY)

blob_service.get_blob_to_path(CONTAINERNAME,BLOBNAME,LOCALFILE)

t2 = time.time()

print(("It takes %s seconds to download "+BLOBNAME) % (t2 - t1))

#unzip downloaded files if needed

#with zipfile.ZipFile(ZIPPEDLOCALFILE, "r") as z:

# z.extractall(LOCALDIRECTORY)

df1 = pd.read_csv(LOCALFILE, header=0)

df1.columns = ['medallion','hack_license','vendor_id','rate_code','store_and_fwd_flag','pickup_datetime','dropoff_datetime','passenger_count','trip_time_in_secs','trip_distance','pickup_longitude','pickup_latitude','dropoff_longitude','dropoff_latitude']

print 'the size of the data is: %d rows and %d columns' % df1.shape

データはデータ フレームとして読み取られます。

Azure Synapse Analytics とデータベース

Azure Synapse Analytics は、エンタープライズ クラスの SQL Server エクスペリエンスを備えたエラスティックな "サービスとしてのデータ ウェアハウス" です。 Azure Synapse Analytics をプロビジョニングする方法については、こちらのリソースで説明しています。 Azure Synapse Analytics をプロビジョニングした後に Azure Synapse Analytics 内のデータを使用して、データのアップロード、探索、モデリングを行う方法については、こちらのチュートリアルで説明しています。

Azure Cosmos DB (アジュール コスモス データベース)

Azure Cosmos DB は、クラウドベースの NoSQL データベースです。 これは、たとえば、JSON ドキュメントを処理したり、ドキュメントを格納してクエリを実行したりすることができます。 次の手順の例は、DSVM から Azure Cosmos DB にアクセスする方法を示しています。

Azure Cosmos DB Python SDK は DSVM に既にインストールされています。 これを更新するには、コマンド プロンプトから

pip install pydocumentdb --upgradeを実行します。Azure portal で Azure Cosmos DB アカウントとデータベースを作成します。

Microsoft ダウンロード センターから Azure Cosmos DB データ移行ツールをダウンロードし、選択したディレクトリに抽出します。

移行ツールに次のコマンド パラメーターを使用して、パブリック BLOB に格納されている JSON データ (火山に関するデータ) を Azure Cosmos DB にインポートします。 (Azure Cosmos DB データ移行ツールをインストールしたディレクトリから dtui.exe を使用します)。これらのパラメーターでインポート元とインポート先の場所を入力します。

/s:JsonFile /s.Files:https://data.humdata.org/dataset/a60ac839-920d-435a-bf7d-25855602699d/resource/7234d067-2d74-449a-9c61-22ae6d98d928/download/volcano.json /t:DocumentDBBulk /t.ConnectionString:AccountEndpoint=https://[DocDBAccountName].documents.azure.com:443/;AccountKey=[[KEY];Database=volcano /t.Collection:volcano1

データをインポートしたら、Jupyter にアクセスして、DocumentDBSample というタイトルのノートブックを開くことができます。 これには、Azure Cosmos DB にアクセスし、何らかの基本的なクエリを処理する Python コードが含まれています。 Azure Cosmos DB の詳細については、Azure Cosmos DB サービスのドキュメント ページを参照してください。

Power BI レポートとダッシュボードを使用する

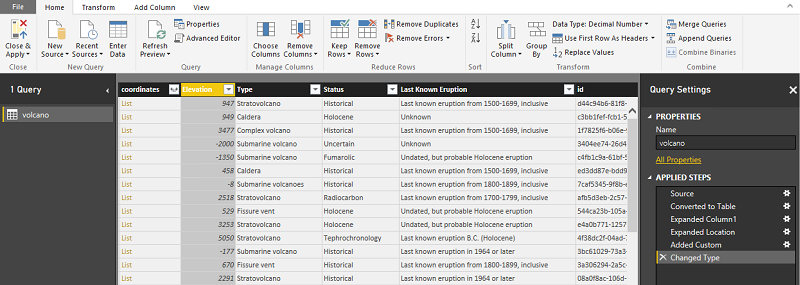

先ほど示した Azure Cosmos DB の例での Volcano JSON ファイルを Power BI Desktop で視覚化すると、データ自体に関する分析情報を視覚的に把握することができます。 詳細な手順については、Power BI の記事で説明しています。 大まかな手順を次に示します。

- Power BI Desktop を開き、[データの取得] を選択します。 次の URL を指定します:

https://cahandson.blob.core.windows.net/samples/volcano.json。 - リストとしてインポートされた JSON レコードが表示されます。 リストをテーブルに変換して、Power BI で操作できるようにします。

- [展開] (矢印) アイコンを選択して、列を展開します。

- 位置は、Record フィールドです。 そのレコードを展開し、coordinates のみを選択してください。 [座標] はリスト列です。

- 新しい列を追加して、リスト座標列をコンマ区切りの LatLong 列に変換します。 式

Text.From([coordinates]{1})&","&Text.From([coordinates]{0})を使用して、座標リスト フィールド内の 2 つの要素を連結します。 - Elevation 列を 10 進数に変換し、[閉じる] ボタンと [適用] ボタンを選択します。

上記の手順の代わりとして次のコードを使用できます。 これは、データ変換をクエリ言語で記述するために Power BI の詳細エディターで使用される手順をスクリプト化したものです。

let

Source = Json.Document(Web.Contents("https://cahandson.blob.core.windows.net/samples/volcano.json")),

#"Converted to Table" = Table.FromList(Source, Splitter.SplitByNothing(), null, null, ExtraValues.Error),

#"Expanded Column1" = Table.ExpandRecordColumn(#"Converted to Table", "Column1", {"Volcano Name", "Country", "Region", "Location", "Elevation", "Type", "Status", "Last Known Eruption", "id"}, {"Volcano Name", "Country", "Region", "Location", "Elevation", "Type", "Status", "Last Known Eruption", "id"}),

#"Expanded Location" = Table.ExpandRecordColumn(#"Expanded Column1", "Location", {"coordinates"}, {"coordinates"}),

#"Added Custom" = Table.AddColumn(#"Expanded Location", "LatLong", each Text.From([coordinates]{1})&","&Text.From([coordinates]{0})),

#"Changed Type" = Table.TransformColumnTypes(#"Added Custom",{{"Elevation", type number}})

in

#"Changed Type"

これで Power BI データ モデルのデータができました。 ご利用の Power BI Desktop インスタンスは、次のように表示されます。

このデータ モデルを使用してレポートと視覚化の作成を開始できます。 レポートを作成する方法については、こちらの Power BI の記事で説明しています。

DSVM を動的にスケーリングする

プロジェクトのニーズを満たすために、DSVM をスケールアップおよびスケールダウンできます。 夜間や週末に VM を使用する必要がない場合は、Azure portal から VM をシャットダウンすることができます。

注

VM 上でオペレーティング システムのシャットダウン ボタンを使用しただけであっても、コンピューティング料金が発生します。 代わりに、Azure portal または Cloud Shell を使用して DSVM の割り当てを解除する必要があります。

大規模な分析プロジェクトの場合、より多くの CPU、メモリ、またはディスク容量が必要になる場合があります。 その場合は、コンピューティングと予算のニーズを満たすさまざまな CPU コア数、メモリ容量、ディスクの種類 (ソリッド ステート ドライブなど)、ディープ ラーニング用の GPU ベースのインスタンスを備えた VM を見つけることができます。 「Azure Virtual Machines の価格」ページには、VM とその時間単位のコンピューティング料金の一覧が示されています。

ツールをさらに追加する

DSVM には、多くの一般的なデータ分析ニーズに対応できる事前構築済みのツールが用意されています。 これにより、環境を個別にインストールして構成する必要がないため、時間を節約できます。 また、使用したリソースについてのみ料金を支払うため、コストも節約できます。

この記事の中で取り上げた他の Azure データ サービスと Azure 分析サービスを使用して、分析環境を強化することができます。 場合によっては、特定の独自のパートナー ツールなど、他のツールが必要になることがあります。 必要なツールをインストールするには、仮想マシンに対する完全な管理アクセス権が必要です。 プレインストールされていない他のパッケージを Python および R にインストールすることもできます。 Python の場合、conda または pip を使用できます。 R の場合は、R コンソールで install.packages() を使用することも、IDE を使用して [パッケージ]>[パッケージのインストール] の順に選択することもできます。

ディープ ラーニング

フレームワーク ベースのサンプルに加えて、DSVM で検証された包括的なチュートリアルのセットを取得できます。 これらのチュートリアルは、イメージや、テキストまたは言語分析の分野でディープ ラーニング アプリケーションの開発をすぐに開始するのに役立ちます。

さまざまなフレームワークでのニューラル ネットワークの実行: このチュートリアルは、あるフレームワークから別のフレームワークにコードを移行する方法を示します。 フレームワーク間でモデルと実行時のパフォーマンスを比較する方法も示します。

イメージ内で製品を検出するエンド ツー エンドのソリューションをビルドするための攻略ガイド: イメージの検出手法では、イメージ内のオブジェクトを特定して分類できます。 このテクノロジには、多くの実際のビジネス ドメインに大きなメリットをもたらす可能性があります。 たとえば、小売り業者は、この手法を使用して、顧客が棚から選ぶ製品を特定できます。 この情報は、小売店が製品の在庫を管理するのに役立ちます。

音声のディープ ラーニング: このチュートリアルでは、都市音声データセットで発生する音声イベントを検出するためのディープ ラーニング モデルをトレーニングする方法を説明します。 また、音声データを操作する方法の概要についても説明します。

テキスト ドキュメントの分類: このチュートリアルでは、2 つのニューラル ネットワーク アーキテクチャを構築してトレーニングする方法を示します。Hierarchical Attention Network と Long Short Term Memory (LSTM) ネットワークです。 これらのニューラル ネットワークでは、ディープ ラーニング用の Keras API を使用して、テキスト ドキュメントを分類します。

まとめ

この記事では、Microsoft Data Science Virtual Machine 上でできることの一部について説明しました。 DSVM を効果的な分析環境にするためにできることは他にも多数あります。

![アップロードされた CSV ファイルが表示されている [ストレージ アカウント] を示すスクリーンショット。](media/vm-do-ten-things/azcopy-run-finshed-storage-explorer-v3.png?view=azureml-api-2)

![Azure Storage Explorer の [アップロード] ボタンを示すスクリーンショット。](media/vm-do-ten-things/storage-accounts.png?view=azureml-api-2)

![[ファイルのアップロード] ダイアログ ボックスを示すスクリーンショット。](media/vm-do-ten-things/upload-files-to-blob.png?view=azureml-api-2)