Von Bedeutung

2027 年 9 月 30 日に、ネットワーク セキュリティ グループ (NSG) フロー ログは廃止されます。 この提供終了の一環として、2025 年 6 月 30 日以降新しい NSG フロー ログを作成できなくなります。 NSG フロー ログの制限を克服するために、仮想ネットワーク フロー ログに移行することをお勧めします。 提供終了日を過ぎると、NSG フロー ログで有効になっているトラフィック分析はサポートされなくなり、サブスクリプション内の既存の NSG フロー ログ リソースが削除されます。 ただし、NSG フロー ログ のレコードは削除されないため、それぞれの保持ポリシーに従い続けます。 詳細については、公式告知を参照してください。

ネットワーク セキュリティ グループ フロー ログの情報を使用して、Azure ネットワーク インターフェイスのイングレスおよびエグレス IP トラフィックを把握できます。 フロー ログには、ネットワーク セキュリティ グループの規則ごとの送信および受信フロー、フローが適用されているネットワーク インターフェイス、フローに関する 5 組の情報 (送信元/送信先 IP、送信元/送信先ポート、プロトコル)、トラフィックが許可されたか拒否されたかが示されます。

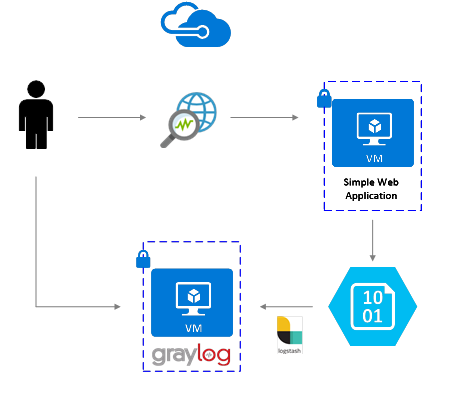

ネットワークの複数のネットワーク セキュリティ グループでフロー ログを有効にすることができます。 複数のネットワーク セキュリティ グループでフロー ログを有効にすると、ログを解析し、ログから洞察を得ることが難しくなる可能性があります。 この記事では、Graylog (オープン ソースのログ管理および分析ツール) と Logstash (オープン ソースのサーバー側データ処理パイプライン) を使用して、これらのネットワーク セキュリティ グループ フロー ログを一元的に管理するソリューションについて説明します。

Warnung

次の手順は、フロー ログのバージョン 1 に使用できます。 詳細については、「ネットワーク セキュリティ グループのフローのログ記録の概要」を参照してください。 次の手順は、変更しなければ、ログ ファイルのバージョン 2 で使用できません。

シナリオ

Network Watcher を使用して、ネットワーク セキュリティ グループ フロー ログを有効にします。 フロー ログは Azure Blob Storage に送信されます。 Logstash プラグインを使用して、Blob Storage のフロー ログに接続して処理し、Graylog に送信します。 フロー ログが Graylog に保存されたら、ログを分析し、カスタマイズされたダッシュボードで視覚化できます。

インストール手順

ネットワーク セキュリティ グループ フロー ログを有効にする

このシナリオでは、アカウント内の少なくとも 1 つのネットワーク セキュリティ グループで、ネットワーク セキュリティ グループ フロー ログが有効になっている必要があります。 ネットワーク セキュリティ グループ フロー ログを有効にする手順については、「ネットワーク セキュリティ グループのフローのログ記録の概要」をご覧ください。

Graylog をセットアップする

この例では、Graylog と Logstash はどちらも Azure にデプロイされた Ubuntu Server 上で構成されます。

この例では、最小のGraylogセットアップ(つまり、Graylogの単一のインスタンス)を使用していますが、Graylogは、システムと本番環境のニーズに応じてリソース間でスケーリングするように設計できます。 アーキテクチャに関する考慮事項や詳細なアーキテクチャ ガイドについては、Graylog のドキュメントおよびアーキテクチャ ガイドを参照してください。

Graylog は、プラットフォームと基本設定に応じて、さまざまな方法でインストールできます。 使用可能なインストール方法の一覧については、Graylog の公式ドキュメントを参照してください。 Graylog サーバー アプリケーションは、Linux ディストリビューションで実行されます。前提条件は次のとおりです。

- Java SE 8 以降 - JDK のインストール ドキュメント

- Elastic Search 2.x (2.1.0 以降) - Elasticsearch のインストール ドキュメント

- MongoDB 2.4 以降 - MongoDB のインストール ドキュメント

Logstash のインストール

Logstash を使用して、JSON 形式のフロー ログをフロー タプル レベルにフラット化します。 フロー ログをフラット化すると、ログの整理と Graylog での検索が容易になります。 次の手順は、Ubuntu で Logstash をインストールするために使用します。 このパッケージを Red Hat Enterprise Linux にインストールする方法については、「パッケージ リポジトリからのインストール - yum」を参照してください。

Logstash をインストールするには、次のコマンドを実行します。

wget -qO - https://artifacts.elastic.co/GPG-KEY-elasticsearch | sudo gpg --dearmor -o /usr/share/keyrings/elastic-keyring.gpg sudo apt-get install apt-transport-https echo "deb [signed-by=/usr/share/keyrings/elastic-keyring.gpg] https://artifacts.elastic.co/packages/8.x/apt stable main" | sudo tee -a /etc/apt/sources.list.d/elastic-8.x.list sudo apt-get update && sudo apt-get install logstashフロー ログを解析し、Graylog に送信するように Logstash を構成します。 logstash.conf ファイルを作成します。

sudo touch /etc/logstash/conf.d/logstash.conf次のコンテンツをファイルに追加します。 ストレージ アカウントの詳細が反映されるように、

storage_account_name、storage_access_key、およびcontainerの値を変更します。input { azureblob { storage_account_name => "mystorageaccount" storage_access_key => "NrUZmx7pJSKaRJzvQbeiZWi5nBRWOTr7Wwr9DrvK7YtDBrADYxT1y0oEExtSlkDnGRt7qcRiZzEBCCyRYND8SxSt" container => "insights-logs-networksecuritygroupflowevent" registry_create_policy => "start_over" codec => "json" file_head_bytes => 21 file_tail_bytes => 9 # Possible options: `do_not_break`, `with_head_tail`, `without_head_tail` break_json_down_policy => 'with_head_tail' break_json_batch_count => 2 interval => 5 } } filter { split { field => "[records]" } split { field => "[records][properties][flows]"} split { field => "[records][properties][flows][flows]"} split { field => "[records][properties][flows][flows][flowTuples]" } mutate { split => { "[records][resourceId]" => "/"} add_field =>{ "Subscription" => "%{[records][resourceId][2]}" "ResourceGroup" => "%{[records][resourceId][4]}" "NetworkSecurityGroup" => "%{[records][resourceId][8]}" } convert => {"Subscription" => "string"} convert => {"ResourceGroup" => "string"} convert => {"NetworkSecurityGroup" => "string"} split => { "[records][properties][flows][flows][flowTuples]" => ","} add_field => { "unixtimestamp" => "%{[records][properties][flows][flows][flowTuples][0]}" "srcIp" => "%{[records][properties][flows][flows][flowTuples][1]}" "destIp" => "%{[records][properties][flows][flows][flowTuples][2]}" "srcPort" => "%{[records][properties][flows][flows][flowTuples][3]}" "destPort" => "%{[records][properties][flows][flows][flowTuples][4]}" "protocol" => "%{[records][properties][flows][flows][flowTuples][5]}" "trafficflow" => "%{[records][properties][flows][flows][flowTuples][6]}" "traffic" => "%{[records][properties][flows][flows][flowTuples][7]}" } add_field => { "time" => "%{[records][time]}" "systemId" => "%{[records][systemId]}" "category" => "%{[records][category]}" "resourceId" => "%{[records][resourceId]}" "operationName" => "%{[records][operationName}}" "Version" => "%{[records][properties][Version}}" "rule" => "%{[records][properties][flows][rule]}" "mac" => "%{[records][properties][flows][flows][mac]}" } convert => {"unixtimestamp" => "integer"} convert => {"srcPort" => "integer"} convert => {"destPort" => "integer"} add_field => { "message" => "%{Message}" } } date { match => ["unixtimestamp" , "UNIX"] } } output { stdout { codec => rubydebug } udp { host => "127.0.0.1" port => 12201 } }用意されている Logstash 構成ファイルは、input、filter、output の 3 つの部分で構成されます。 入力セクションでは、Logstashが処理するログの入力ソースを指定します - この場合、Azureブログ入力プラグイン(次の手順でインストール)を使用して、BLOBストレージに保存されているネットワークセキュリティグループフローログJSONファイルにアクセスできるようになります。

filter セクションは、個々のフロー タプルとそれに関連付けられたプロパティが別の Logstash イベントになるように、各フロー ログ ファイルをフラット化します。

最後に、output セクションは、各 Logstash イベントを Graylog サーバーに転送します。 特定のニーズに合わせるために、Logstash 構成ファイルは適宜変更を加えてください。

注

前の構成ファイルでは、Graylog サーバーがローカル ホスト ループバック IP アドレス 127.0.0.1 に 構成されているものと想定しています。 そうでない場合は、出力セクションのホスト パラメーターを正しい IP アドレスに変更してください。

Logstash のインストールの詳しい手順については、Logstash のドキュメントを参照してください。

Azure Blob Storage 向けの Logstash 入力プラグインをインストールする

Logstash プラグインを使用すると、指定された BLOB ストレージ アカウントからフロー ログに直接アクセスできます。 プラグインをインストールするには、既定の Logstash インストール ディレクトリ (この例では /usr/share/logstash/bin) から次のコマンドを実行します。

cd /usr/share/logstash/bin

sudo ./logstash-plugin install logstash-input-azureblob

このプラグインの詳細については、こちらのドキュメントを参照してください。

Logstash から Graylog への接続を設定する

Logstash を使用してフロー ログへの接続を確立し、Graylog サーバーを設定しました。次に、受信ログ ファイルを受け入れるように Graylog を構成する必要があります。

構成済みの URL を使用して、Graylog サーバーの Web インターフェイスに移動します。 インターフェイスにアクセスするには、ブラウザーで

http://<graylog-server-ip>:9000/を参照します。設定ページに移動するには、右側の上部のナビゲーション バーにある [システム ] ドロップダウン メニューを選択し、[ 入力] を選択します。 または、

http://<graylog-server-ip>:9000/system/inputsに移動します。新しい入力を開始するには、 [Select input](入力の選択) ドロップダウンで [GELF UDP] を選択し、フォームに入力します。 GELF は Graylog Extended Log Format の略です。 GELF 形式は Graylog によって開発されました。 この形式の利点の詳細については、Graylog のドキュメントを参照してください。

Graylog サーバーが構成されている IP に入力をバインドする必要があります。 IP アドレスは、Logstash 構成ファイルの UDP 出力の host フィールドと一致する必要があります。 既定のポートは 12201 です。 ポートが、Logstash 構成ファイルで指定されている UDP 出力の port フィールドと一致することを確認します。

Graylog のメッセージ入力の詳細については、こちらのドキュメントを参照してください。

これらの構成を行ったら、

sudo systemctl start logstash.serviceコマンドを使用して、Logstash を起動し、フロー ログの読み取りを開始できます。

Graylog のメッセージを検索する

Graylogサーバーがメッセージを収集するのをしばらく待つと、メッセージを検索できます。 Graylogサーバーに送信されるメッセージを確認するには、 入力 設定ページから、作成したGELF UDP入力の[受信したメッセージを表示]ボタンを選択します。

青色 の%{Message} リンクを選択してメッセージを展開し、フロー タプルのパラメーターを表示します。

検索対象にする特定のメッセージ フィールドを選択していない場合、既定ではすべてのメッセージ フィールドが検索に含まれます。 特定のメッセージ (つまり、特定のソース IP からのフロー タプル) を検索する場合は、文書化されているように Graylog 検索クエリ言語を使用できます

Graylog を使用したネットワーク セキュリティ グループ フロー ログの分析

Graylog の設定が完了したので、その機能を使用してフロー ログ データの理解を深めることができます。 1 つの方法として、ダッシュボードを使用してデータの特定のビューを作成します。

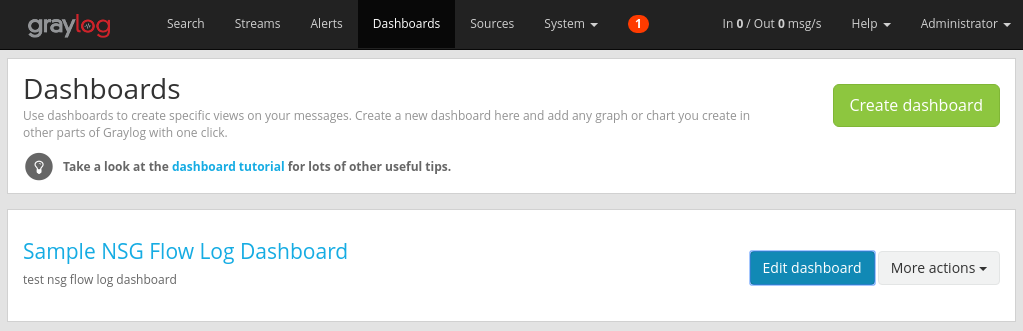

ダッシュボードの作成

上部のナビゲーション バーで、 [Dashboards](ダッシュボード) を選択するか、

http://<graylog-server-ip>:9000/dashboards/に移動します。そこから、緑色の [ダッシュボードの作成 ] ボタンを選択し、ダッシュボードのタイトルと説明を短いフォームに入力します。 [Save](保存) をクリックして、新しいダッシュボードを作成します。 次の図のようなダッシュボードが表示されます。

ウィジェットを追加する

ダッシュボードのタイトルを選択して表示できますが、ウィジェットを追加していないため、現在は空です。 ダッシュボードに追加する使いやすい便利なウィジェットとして、Quick Values グラフがあります。このグラフには、選択したフィールドの値の一覧と値分布が表示されます。

上部のナビゲーション バーにある [Search](検索) をクリックして、フロー ログを受信している UDP 入力の検索結果に戻ります。

画面の左側の [Search result](検索結果) パネルで、[Fields](フィールド) タブを見つけます。このタブには、受信フロー タプルの各メッセージのさまざまなフィールドが表示されます。

視覚化する目的のパラメーターを選択します (この例では、IP ソースを選択しています)。 使用可能なウィジェットの一覧を表示するには、フィールドの左側にある青いドロップダウン矢印を選択し、 [クイック値 ] を選択してウィジェットを生成します。

ウィジェットの右上隅にある [Add to dashboard](ダッシュボードに追加) をクリックし、対応するダッシュボードを選択して追加します。

ダッシュボードに戻ると、追加したウィジェットが表示されます。

ヒストグラムやカウントなど、他のさまざまなウィジェットをダッシュボードに追加して、重要なメトリックを追跡できます。

ダッシュボードとその他の種類のウィジェットの詳細については、Graylog のドキュメントを参照してください。

Network Watcher を Graylog と統合することで、ネットワーク セキュリティ グループ フロー ログを簡単かつ一元的に管理し、視覚化できるようになりました。 Graylog には、ストリームやアラートなどの強力な機能が多数用意されています。これらの機能を使用してフロー ログを詳細に管理し、ネットワーク トラフィックの理解を深めることができます。 Graylog をセットアップし、Azure に接続したので、提供される他の機能を引き続き自由に探索してください。