HBv3 シリーズの仮想マシンの概要

注意

この記事では、間もなくサポート終了 (EOL) 状態になる Linux ディストリビューションである CentOS について説明します。 適宜、使用と計画を検討してください。 詳細については、「CentOS のサポート終了に関するガイダンス」を参照してください。

適用対象: ✔️ Linux VM ✔️ Windows VM ✔️ フレキシブル スケール セット ✔️ 均一スケール セット

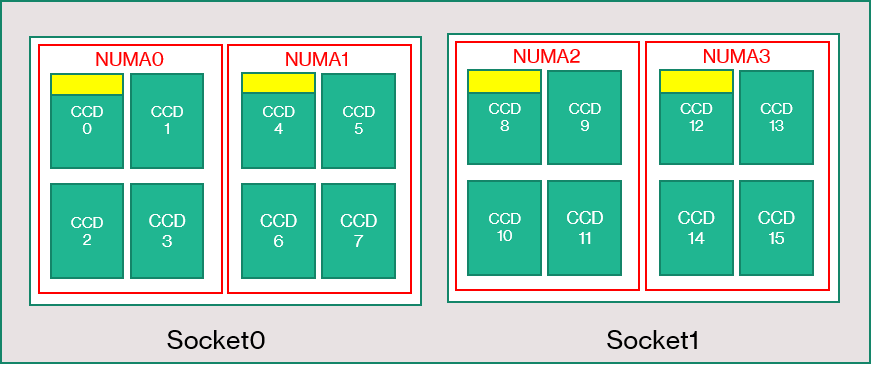

HBv3 シリーズのサーバーは 64 コア EPYC 7V73X CPU を 2 個搭載しており、AMD 3D V-Cache を搭載した "Zen3" の物理コア数は合計で 128 個となります。 同時マルチスレッド (SMT) は HBv3 では無効になっています。 これらの 128 個のコアは 16 個のセクション (ソケットあたり 8 個) に分けられ、各セクションに含まれる 8 個のプロセッサ コアが 96 MB の L3 キャッシュに一様にアクセスできます。 Azure HBv3 サーバーでは、次の AMD BIOS 設定も実行されます。

Nodes per Socket (NPS) = 2

L3 as NUMA = Disabled

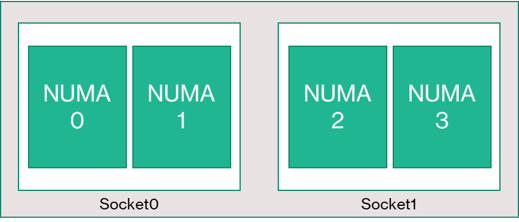

NUMA domains within VM OS = 4

C-states = Enabled

その結果、サーバーを起動する 4 つの NUMA ドメイン (ソケットあたり 2 つ) は、それぞれのサイズが 32 コアになります。 各 NUMA は、3200 MT/秒で動作する 4 つのチャネルの物理 DRAM に直接アクセスできます。

Azure ハイパーバイザーが VM に干渉することなく動作する余地を与えるため、予備としてサーバーあたり 8 個の物理コアを確保しています。

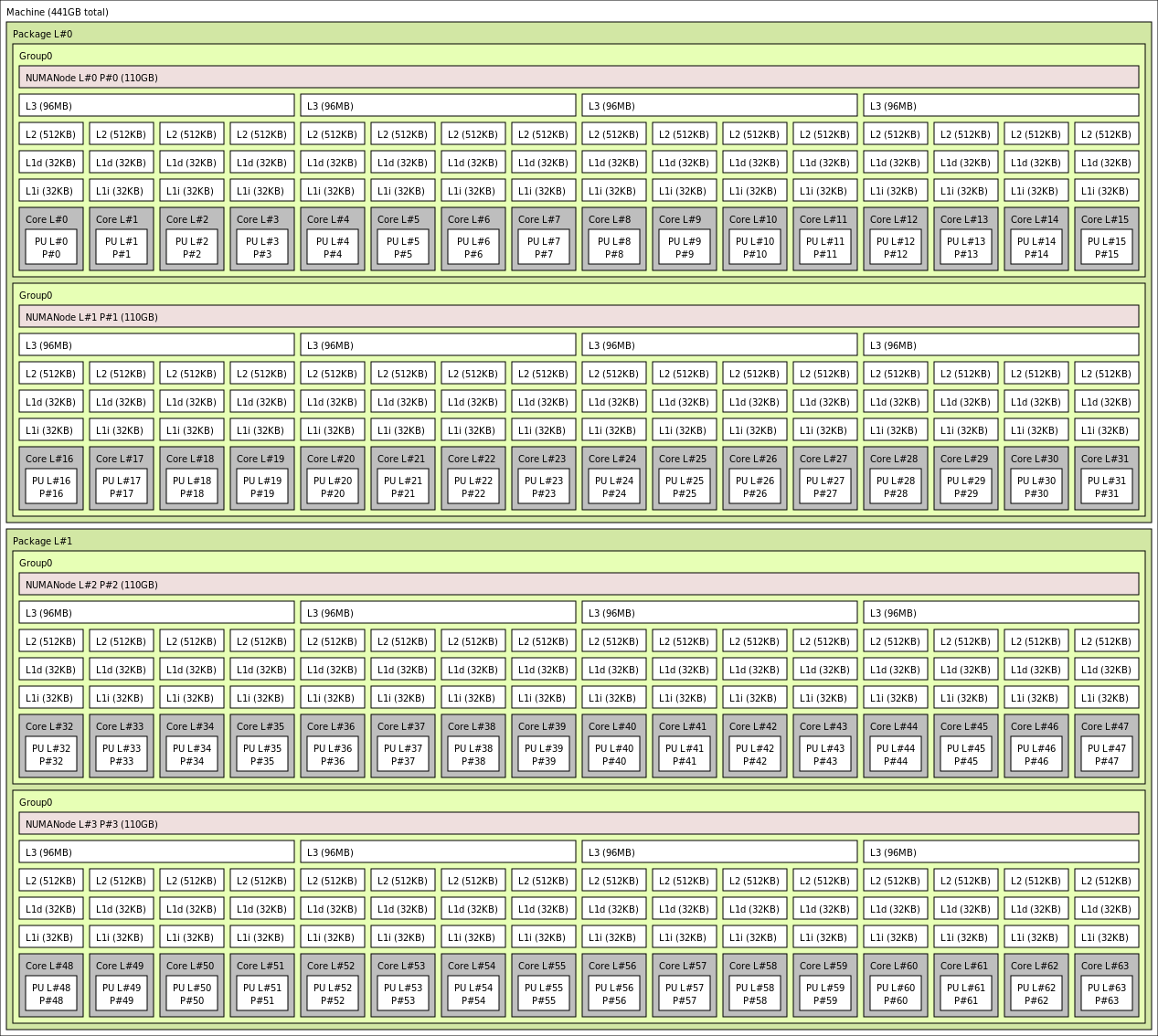

VM のトポロジ

次の図は、サーバーのトポロジを示しています。 これらの 8 つのハイパーバイザー ホスト コア (黄色) が両方の CPU ソケットに対して対称的に予約されており、各 NUMA ドメインにある特定の Core Complex Die (CCD) の最初の 2 つのコアが使用されています。残りのコアは、HBv3 シリーズ VM 用になります (緑色)。

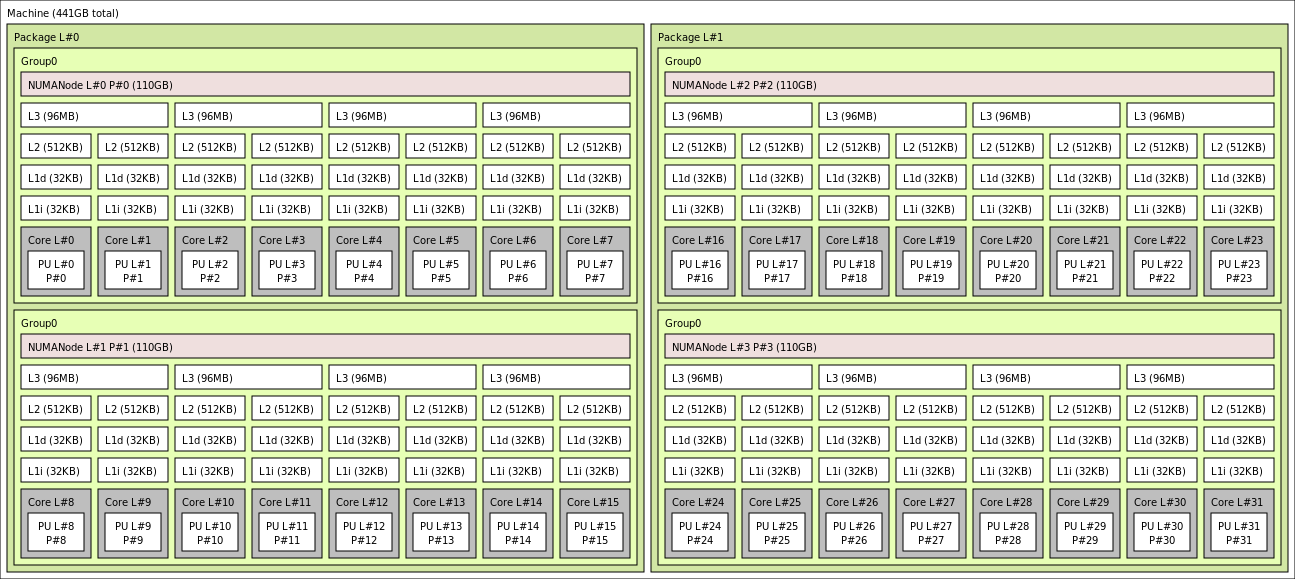

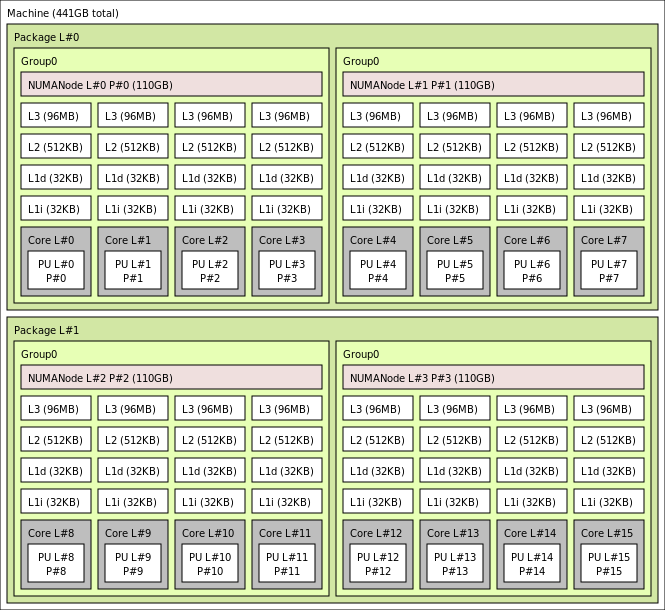

CCD 境界は NUMA 境界と同等ではありません。 HBv3 では、ホスト サーバー レベルとゲスト VM 内の両方で、4 つの連続する (4) CCD のグループが NUMA ドメインとして構成されます。 したがって、すべての HBv3 VM サイズは、示すように OS とアプリケーションに表示される 4 つの NUMA ドメインを公開します。 4 つの ユニフォームNUMA ドメインは、個別のHBv3 VM サイズによってコアの数がそれぞれ違います。

各 HBv3 VM のサイズは、次のように、AMD EPYC 7003 シリーズの各種 CPU の物理レイアウト、機能、パフォーマンスに類似しています。

| HBv3 シリーズ VM のサイズ | NUMA ドメイン | NUMA ドメインごとのコア数 | AMD EPYC との類似性 |

|---|---|---|---|

| Standard_HB120rs_v3 | 4 | 30 | デュアル ソケット EPYC 7773X |

| Standard_HB120-96rs_v3 | 4 | 24 | デュアル ソケット EPYC 7643 |

| Standard_HB120-64rs_v3 | 4 | 16 | デュアル ソケット EPYC 7573X |

| Standard_HB120-32rs_v3 | 4 | 8 | デュアル ソケット EPYC 7373X |

| Standard_HB120-16rs_v3 | 4 | 4 | デュアル ソケット EPYC 72F3 |

注意

制約付きコア VM のサイズでは、VM に公開される物理コアの数のみ減少します。 すべてのグローバル共有アセット (RAM、メモリ帯域幅、L3 キャッシュ、GMI および xGMI 接続、InfiniBand、Azure イーサネット ネットワーク、ローカル SSD) は一定のままです。 これにより、お客様は特定のワークロードまたはソフトウェア ライセンスのニーズに合わせて最適な VM サイズを選択できます。

各 HBv3 VM サイズの仮想 NUMA マッピングは、基になる物理 NUMA トポロジにマップされます。 ハードウェア トポロジが誤って抽象化される可能性はありません。

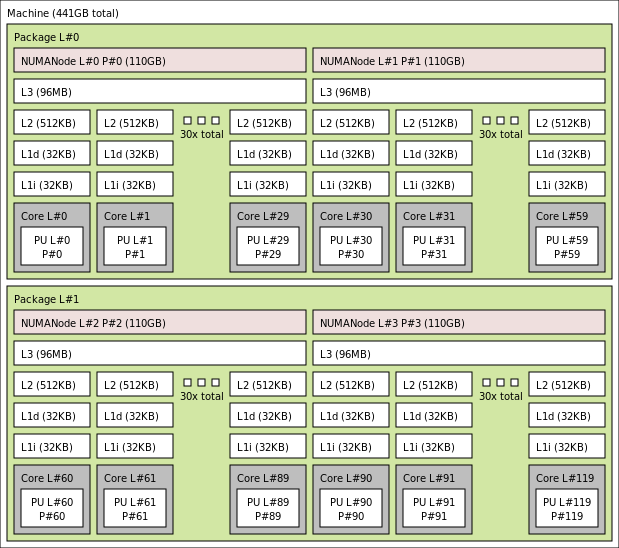

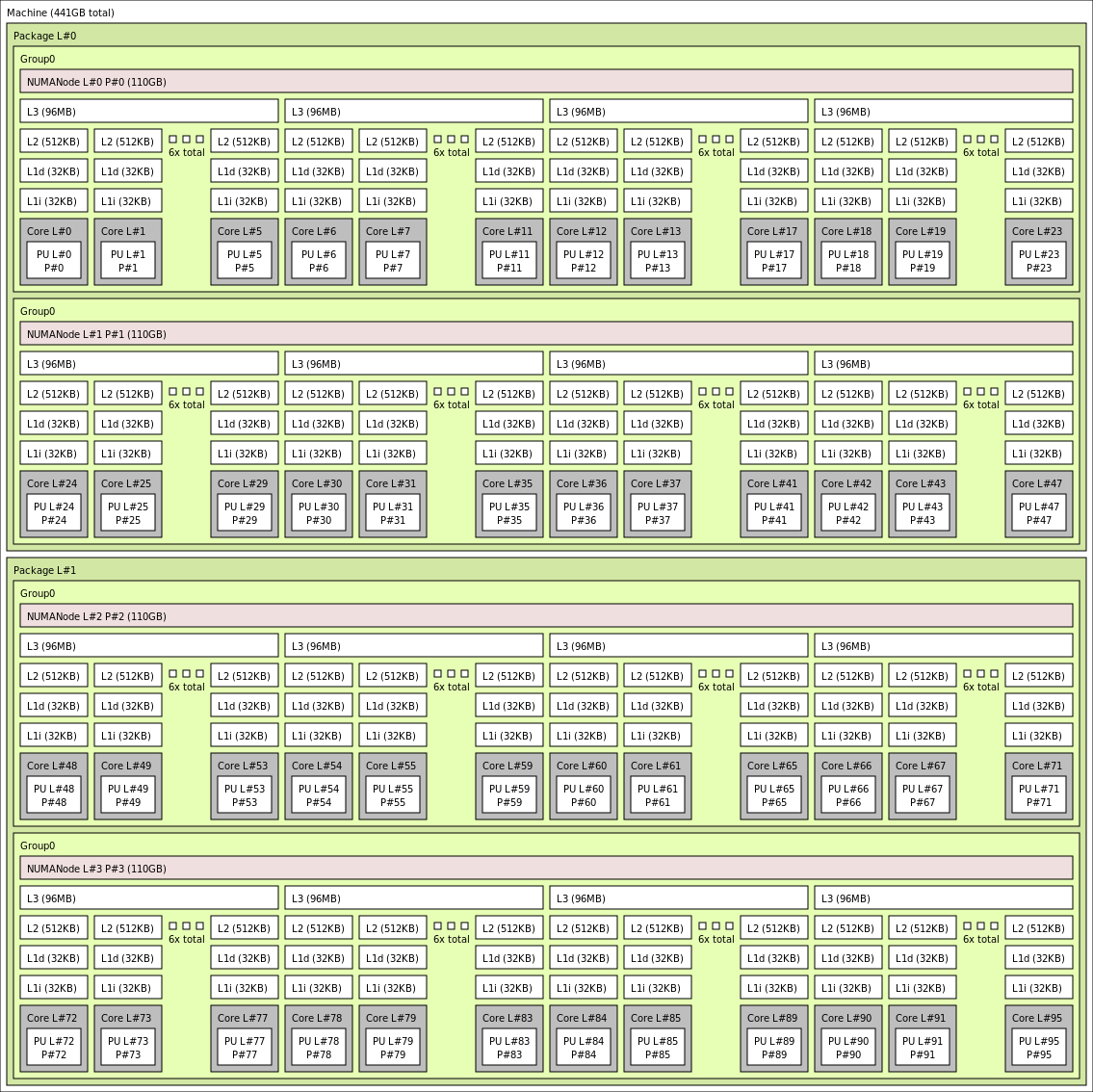

各種の HBV3 VM サイズの正確なトポロジは、lstopo の出力を使用して次のように表示されます。

lstopo-no-graphics --no-io --no-legend --of txt

クリックして Standard_HB120rs_v3 の lstopo 出力を表示

クリックして Standard_HB120rs-96_v3 の lstopo 出力を表示

クリックして Standard_HB120rs-64_v3 の lstopo 出力を表示

クリックして Standard_HB120rs-32_v3 の lstopo 出力を表示

クリックして Standard_HB120rs-16_v3 の lstopo 出力を表示

InfiniBand ネットワーク

HBv3 VM では Nvidia Mellanox HDR InfiniBand ネットワーク アダプター (ConnectX-6) も最大 200 Gb/秒で動作しています。NIC は SRIOV 経由で VM に渡されるため、ネットワーク トラフィックがハイパーバイザーをバイパスできます。 その結果、標準の Mellanox OFED ドライバーが、ベアメタル環境と同様に HBv3 VM にロードされます。

HBv3 VM では、アダプティブ ルーティング、標準の RC および UD トランスポートと一緒に Dynamic Connected Transport (DCT)、ConnectX-6 アダプターのオンボード プロセッサへのハードウェアベースの MPI コレクティブのオフロードもサポートされています。 これらの機能により、アプリケーションのパフォーマンス、スケーラビリティ、および整合性が向上するため、それらを使用することをお勧めします。

一時ストレージ

HBv3 VM の特徴は、物理的にローカルの 3 つの SSD デバイスです。 1 つのデバイスがページ ファイルとして機能するよう事前フォーマットされており、VM 内に汎用 "SSD" デバイスとして表示されました。

他の 2 つのより大きな SSD は、NVMeDirect を介した未フォーマットのブロック NVMe デバイスとして提供されています。 ブロック NVMe デバイスはハイパーバイザーをバイパスするので、帯域幅が大きく、IOPS が向上し、IOP あたりの待機時間が短いです。

ストライピングされた配列でペアになっている場合、NVMe SSD では最大 7 GB/秒の読み取りと 3 GB/秒の書き込みが可能で、最大 186,000 の IOPS (読み取り) と 201,000 の IOPS (書き込み) というディープ キューの深さが提供されます。

ハードウェア仕様

| ハードウェア仕様 | HBv3 シリーズ VM |

|---|---|

| コア | 120、96、64、32、または 16 (SMT 無効) |

| CPU | AMD EPYC 7V73X |

| CPU 周波数 (非 AVX) | 3.0 GHz (すべてのコア)、3.5 GHz (最大 10 コア) |

| メモリ | 448 GB (コアあたりの RAM は VM のサイズによって異なる) |

| ローカル ディスク | 960 GB NVMe × 2 (ブロック)、480 GB SSD (ページ ファイル) |

| Infiniband | 200 Gb/s Mellanox ConnectX-6 HDR InfiniBand |

| ネットワーク | 50 GB/秒イーサネット (40 GB/秒使用可能) Azure 第 2 世代 SmartNIC |

ソフトウェア仕様

| ソフトウェア仕様 | HBv3 シリーズ VM |

|---|---|

| 最大 MPI ジョブ サイズ | 36,000 コア (1 つの仮想マシン スケール セットに 300 の VM、singlePlacementGroup=true) |

| MPI のサポート | HPC-X、Intel MPI、OpenMPI、MVAPICH2、MPICH |

| その他のフレームワーク | UCX、libfabric、PGAS |

| Azure Storage のサポート | Standard および Premium のディスク (最大 32 ディスク) |

| SRIOV RDMA の OS サポート | CentOS または RHEL 7.9 以降、Ubuntu 18.04 以降、SLES 15.4、WinServer 2016 以降 |

| パフォーマンス向上のために推奨される OS | CentOS 8.1、Windows Server 2019 以降 |

| Orchestrator のサポート | Azure CycleCloud、Azure Batch、AKS。クラスター構成オプション |

注意

Windows Server 2012 R2 は、HBv3、および 64 個を超える (仮想または物理) コアを備えたその他の VM ではサポートされていません。 詳細については、「Windows Server 上の Hyper-V でサポートされている Windows ゲスト オペレーティング システム」をご覧ください。

重要

このドキュメントでは、サポート終了 (EOL) が近い、また既にサポートが終了した Linux のリリース バージョンを参照しています。 より新しいバージョンへの更新をご検討ください。

次のステップ

- Azure Compute Tech Community のブログで、最新の発表、HPC ワークロードの例、およびパフォーマンスの結果について参照します。

- HPC ワークロードの実行をアーキテクチャの面から見た概要については、「Azure でのハイ パフォーマンス コンピューティング (HPC)」をご覧ください。

フィードバック

以下は間もなく提供いたします。2024 年を通じて、コンテンツのフィードバック メカニズムとして GitHub の issue を段階的に廃止し、新しいフィードバック システムに置き換えます。 詳細については、「https://aka.ms/ContentUserFeedback」を参照してください。

フィードバックの送信と表示