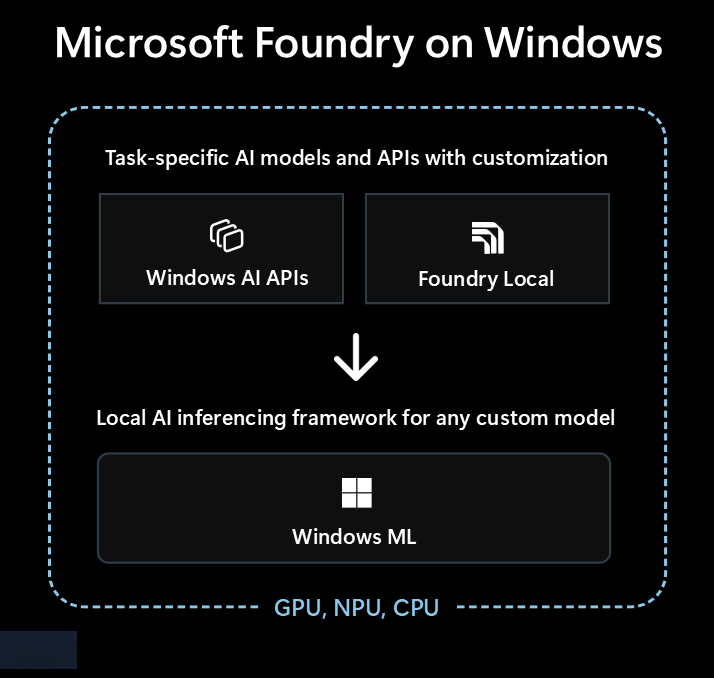

Microsoft Foundry on Windows は、ローカル AI 機能を Windows アプリに統合する開発者向けの優れたソリューションです。

Microsoft Foundry on Windows はデベロッパーに...

Windows および すぐに使用できるAIモデルとAPI - 任意のモデルをローカルで実行するための AI 推論フレームワークWindows ML

AI を初めて使用する場合でも、経験豊富な機械学習 (ML) の専門家でも、 Microsoft Foundry on Windows には何かがあります。

すぐに使用できる AI モデルと API

アプリでは、次のローカル AI モデルと API を 1 時間以内に簡単に使用できます。 モデル ファイルの配布とランタイムは Microsoft によって処理され、モデルはアプリ間で共有されます。 これらのモデルと API を使用すると、数行のコードしか必要とされません。ML の専門知識は必要とされません。

| モデルの種類または API | それはなんですか | オプションとサポートされているデバイス |

|---|---|---|

| 大規模言語モデル (LLM) | 生成テキスト モデル |

AI APIs経由の Phi Silica (微調整をサポート) または 20 以上の OSS LLM モデルFoundry Local 詳細については、「 ローカル LLM」 を参照してください。 |

| 画像の説明 | 画像の自然言語テキストの説明を取得する | AI APIsを使用した画像の説明(Copilot+ PC) |

| Image Foreground Extractor | 画像の前景をセグメント化する | AI APIsを利用したCopilot+対応のPC用画像フォアグラウンドエクストラクター |

| 画像生成 | テキストから画像を生成する | AI APIsを使用した画像の生成(Copilot+ PC) |

| イメージオブジェクトの消去 | イメージからオブジェクトを消去する | AI APIsを使用したイメージ オブジェクトの消去(Copilot+ PC) |

| 画像オブジェクト抽出器 | 画像内の特定のオブジェクトをセグメント化する | AI APIsを使ったイメージオブジェクトエクストラクター(Copilot+ PCs) |

| 画像の超解像度 | 画像の解像度を上げる | AI APIs |

| セマンティック検索 | 意味的にテキストと画像を検索する | AI APIsを使用したアプリ コンテンツ検索(Copilot+ PC) |

| 音声認識 | 音声をテキストに変換する |

Foundry Local経由のささやきまたは Windows SDK による音声認識 詳細については 、「音声認識」 を参照してください。 |

| テキスト認識 (OCR) | 画像からテキストを認識する | AI APIsによる OCR(Copilot+ PC) |

| ビデオのスーパー解像度 (VSR) | ビデオの解像度を上げる | AI APIs |

他のモデルを使用する Windows ML

Hugging Face やその他のソースからさまざまなモデルを使用したり、独自のモデルをトレーニングしたり、Windows MLを使用して Windows 10 以降の PC でローカルに実行したりできます (モデルの互換性とパフォーマンスはデバイスのハードウェアによって異なります)。

詳細については、Windows MLで使用するモデルの検索またはトレーニングに関するページを参照してください。

どのオプションから始めるか

このデシジョン ツリーに従って、アプリケーションとシナリオに最適なアプローチを選択します。

組み込みの Windows AI APIs がシナリオに対応していて、Copilot+ PC をターゲットにしているかどうかを確認します。 これは、最小限の開発作業で市場への最速の道です。

Windows AI APIs 必要なものがない場合、または Windows 10 以降をサポートする必要がある場合は、LLM または音声テキスト変換のシナリオの Foundry Local を検討してください。

カスタム モデルが必要な場合、Hugging Face やその他のソースから既存のモデルを活用したい場合、または上記のオプションでカバーされていない特定のモデル要件がある場合、 Windows ML は独自のモデルを検索またはトレーニングする柔軟性を提供します (また、Windows 10 以降をサポートしています)。

アプリでは、これらの 3 つのテクノロジをすべて組み合わせて使用することもできます。

ローカル AI で利用できるテクノロジ

Microsoft Foundry on Windowsでは、次のテクノロジを使用できます。

| ウィンドウズ AI APIs | Foundry Local | Windows ML | |

|---|---|---|---|

| それはなんですか | Copilot+ PC 用に最適化された、さまざまな種類のタスクにわたるすぐに使用できる AI モデルと API | すぐに使用できる LLM と音声テキスト変換モデル | ONNX Runtime 検索またはトレーニングするモデルを実行するためのフレームワーク |

| サポートされているデバイス | Copilot+ PC | Windows 10 以降の PC とクロスプラットフォーム (使用可能なハードウェアによってパフォーマンスが異なりますが、すべてのモデルが使用可能なわけではありません) |

Windows 10 以降の PC、およびオープンソースによるクロスプラットフォーム ONNX Runtime (パフォーマンスは使用可能なハードウェアによって異なります) |

| 使用可能なモデルの種類と API |

LLM 画像の説明 Image Foreground Extractor 画像生成 イメージオブジェクトの消去 画像オブジェクト抽出器 画像の超解像度 セマンティック検索 テキスト認識 (OCR) ビデオのスーパー解像度 |

LLM (複数) 音声テキスト変換 20 以上の使用可能なモデルを参照する |

独自のモデルを検索またはトレーニングする |

| モデルの分布 | Microsoft がホストし、実行時に取得し、アプリ間で共有する | Microsoft がホストし、実行時に取得し、アプリ間で共有する | アプリによって処理される配布 (アプリ ライブラリはアプリ 間でモデルを共有できます) |

| 詳細情報 | AI APIsドキュメントを読む | Foundry Localドキュメントを読む | Windows MLドキュメントを読む |

Microsoft Foundry on Windowsには、VISUAL Studio Code のAI Toolkitや AI Dev Gallery などの開発者ツールも含まれており、AI 機能の構築を成功させるために役立ちます。

Visual Studio Code のAI Toolkitは、パフォーマンスを向上させ、DirectML を介してスケーリングするためのハードウェア アクセラレーションへのアクセスを含め、AI モデルをローカルでダウンロードして実行できるようにする VS Code 拡張機能です。 AI Toolkitは、次の場合にも役立ちます。

- 直感的なプレイグラウンドまたは REST API を使用したアプリケーションでのモデルのテスト。

- AI モデルをローカルまたはクラウド (仮想マシン上) の両方で微調整して、新しいスキルを作成し、応答の信頼性を向上させ、応答のトーンと形式を設定します。

- Phi-3 や Mistral などの一般的な小言語モデル (SLB) を微調整します。

- クラウドまたはデバイス上で実行されるアプリケーションを使用して、AI 機能をデプロイします。

- DirectML を使用して AI 機能を使用してパフォーマンスを向上させるために、ハードウェア アクセラレーションを活用します。 DirectML は、Windows デバイス ハードウェアがデバイス GPU または NPU を使用して ML モデルのパフォーマンスを高速化できるようにする低レベルの API です。 DirectML と ONNX Runtime のペアリングは、通常、開発者がハードウェアで高速化された AI を大規模にユーザーに提供するための最も簡単な方法です。 詳細情報: DirectML の概要。

- モデル変換機能を使用して、NPU で使用するモデルを量子化して検証する

ローカル AI を活用するためのアイデア

Windows アプリがローカル AI を利用して機能とユーザー エクスペリエンスを強化する方法には、次のようなものがあります。

- アプリでは 、Generative AI LLM モデルを使用 して、集計、書き換え、レポート作成、または拡張するための複雑なトピックを理解できます。

- アプリでは 、LLM モデルを使用 して、自由形式のコンテンツを、アプリが理解できる構造化された形式に変換できます。

- アプリでは セマンティック検索モデルを使用 できます。これにより、ユーザーは意味によってコンテンツを検索し、関連するコンテンツをすばやく検索できます。

- アプリでは、自然言語処理モデルを使用して複雑な自然言語要件を推論し、ユーザーの質問を実行するためのアクションを計画および実行できます。

- アプリでは、画像操作モデルを使用して、画像をインテリジェントに変更したり、件名を消去または追加したり、スケールアップしたり、新しいコンテンツを生成したりできます。

- アプリでは、予測診断モデルを使用して、問題を特定して予測し、ユーザーを誘導したり、問題を解決したりするのに役立ちます。

クラウド AI モデルの使用

ローカル AI 機能の使用が適切なパスではない場合は、 クラウド AI モデルとリソースを使用 することがソリューションになる可能性があります。

責任ある AI プラクティスを使用する

Windows アプリに AI 機能を組み込むときは常に、Windows での責任ある生成型 AI アプリケーションと機能の開発に関するガイダンスに従うことを強くお勧めします。