Databricks의 AI 및 Machine Learning

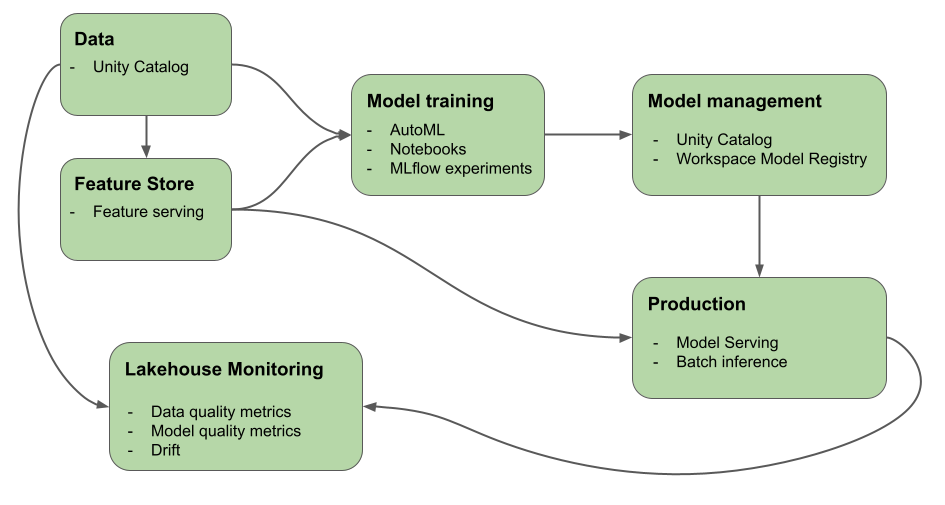

이 문서에서는 AI 및 ML 워크플로를 빌드하고 모니터링하는 데 도움이 되는 Azure Databricks가 제공하는 도구에 대해 설명합니다. 다이어그램은 이러한 구성 요소가 함께 작동하여 모델 개발 및 배포 프로세스를 구현하는 데 도움이 되는 방법을 보여 줍니다.

기계 학습 및 딥 러닝에 Databricks를 사용하는 이유는 무엇인가요?

Azure Databricks를 사용하면 ML 파이프라인 전체에서 엔드 투 엔드 거버넌스를 사용하여 단일 플랫폼에서 전체 ML 수명 주기를 구현할 수 있습니다. Azure Databricks에는 ML 워크플로를 지원하는 다음과 같은 기본 제공 도구가 포함되어 있습니다.

- 데이터, 기능, 모델 및 함수에 대한 거버넌스, 검색, 버전 관리 및 액세스 제어를 위한 Unity 카탈로그 입니다.

- 데이터 모니터링을 위한 Lakehouse 모니터링.

- 기능 엔지니어링 및 서비스.

- 모델 수명 주기 지원:

- 자동화된 모델 학습을 위한 Databricks AutoML 입니다.

- 모델 개발 추적을 위한 MLflow입니다.

- 모델 관리를 위한 Unity 카탈로그 입니다.

- 고가용성, 대기 시간이 짧은 모델을 제공하는 Databricks 모델 서비스. 여기에는 다음을 사용하여 LLM을 배포하는 것이 포함됩니다.

- 모델 예측 품질 및 드리프트를 추적하는 Lakehouse 모니터링

- 자동화된 워크플로 및 프로덕션 준비 ETL 파이프라인을 위한 Databricks 워크플로 입니다.

- 코드 관리 및 Git 통합을 위한 Databricks Git 폴더입니다.

Databricks에 대한 딥 러닝

딥 러닝 애플리케이션에 대한 인프라 구성은 어려울 수 있습니다.

Machine Learning 용 Databricks Runtime은 TensorFlow, PyTorch 및 Keras와 같은 가장 일반적인 딥 러닝 라이브러리의 호환되는 기본 제공 버전이 있는 클러스터와 Petastorm, Hyperopt 및 Horovod와 같은 지원 라이브러리를 사용하여 이를 처리합니다. Databricks 런타임 ML 클러스터에는 드라이버 및 지원 라이브러리를 사용하여 미리 구성된 GPU 지원도 포함됩니다. 또한 Ray와 같은 라이브러리를 지원하여 ML 워크플로 및 AI 애플리케이션의 크기를 조정하기 위한 컴퓨팅 처리를 병렬화합니다.

Databricks 런타임 ML 클러스터에는 드라이버 및 지원 라이브러리를 사용하여 미리 구성된 GPU 지원도 포함됩니다. Databricks 모델 서비스를 사용하면 추가 구성 없이 딥 러닝 모델에 대해 확장 가능한 GPU 엔드포인트를 만들 수 있습니다.

기계 학습 애플리케이션의 경우 Databricks에서 Machine Learning을 위한 Databricks Runtime을 실행하는 클러스터를 사용하는 것을 권장합니다. Databricks 런타임 ML을 사용하여 클러스터 만들기를 참조하세요.

Databricks에서 딥 러닝을 시작하려면 다음을 참조하세요.

Databricks의 LLM(대규모 언어 모델) 및 생성 AI

Machine Learning용 Databricks 런타임에는 미리 학습된 기존 모델 또는 기타 오픈 소스 라이브러리를 워크플로에 통합할 수 있는 Hugging Face Transformers 및 LangChain과 같은 라이브러리가 포함되어 있습니다. Databricks MLflow 통합을 사용하면 변환기 파이프라인, 모델 및 처리 구성 요소와 함께 MLflow 추적 서비스를 쉽게 사용할 수 있습니다. 또한 Azure Databricks 워크플로에서 John Snow Labs와 같은 파트너의 OpenAI 모델 또는 솔루션을 통합할 수 있습니다.

Azure Databricks를 사용하면 특정 작업에 대한 데이터에 대한 LLM을 사용자 지정할 수 있습니다. Hugging Face 및 DeepSpeed와 같은 오픈 소스 도구를 지원하면 기본 LLM을 효율적으로 사용하고 고유한 데이터로 학습하여 특정 작업기본 및 워크로드에 대한 정확도를 향상시킬 수 있습니다. 그런 다음, 생성 AI 애플리케이션에서 사용자 지정 LLM을 활용할 수 있습니다.

또한 Databricks는 서비스 엔드포인트에서 최신 오픈 모델에 액세스하고 쿼리할 수 있는 파운데이션 모델 API 및 외부 모델을 제공합니다. 개발자는 파운데이션 모델 API를 사용하여 자체 모델 배포를 기본 않고도 고품질의 생성 AI 모델을 활용하는 애플리케이션을 빠르고 쉽게 빌드할 수 있습니다.

SQL 사용자의 경우 Databricks는 SQL 데이터 분석가가 데이터 파이프라인 및 워크플로 내에서 직접 OpenAI를 비롯한 LLM 모델에 액세스하는 데 사용할 수 있는 AI 함수를 제공합니다. Azure Databricks의 AI 함수를 참조 하세요.

Machine Learning용 Databricks Runtime

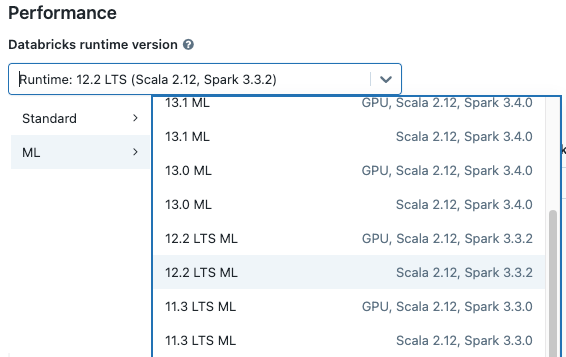

Machine Learning용 Databricks Runtime(Databricks Runtime ML)은 가장 일반적인 ML 및 DL 라이브러리를 포함하여 미리 빌드된 기계 학습 및 딥 러닝 인프라를 사용하여 클러스터를 만드는 것을 자동화합니다. Databricks Runtime ML의 각 버전에 있는 라이브러리의 전체 목록은 릴리스 정보를 참조하세요.

기계 학습 워크플로를 위해 Unity 카탈로그의 데이터에 액세스하려면 클러스터에 대한 액세스 모드가 단일 사용자(할당됨)여야 합니다. 공유 클러스터는 Machine Learning용 Databricks Runtime과 호환되지 않습니다. 또한 Databricks Runtime ML은 TableACLs 클러스터 또는 로 설정된 true클러스터 spark.databricks.pyspark.enableProcessIsolation config 에서 지원되지 않습니다.

Databricks Runtime ML을 사용하여 클러스터 만들기

클러스터를 만들 때 Databricks 런타임 버전 드롭다운 메뉴에서 Databricks 런타임 ML 버전을 선택합니다. CPU 및 GPU 지원 ML 런타임을 모두 사용할 수 있습니다.

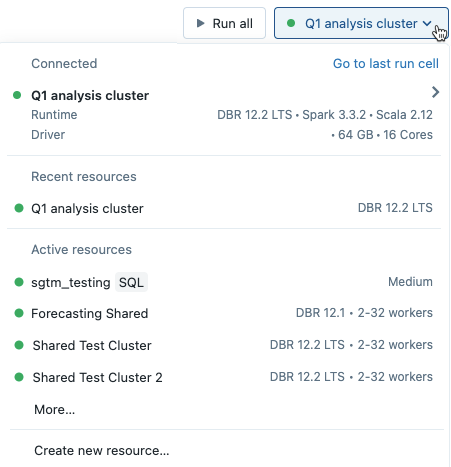

Notebook의 드롭다운 메뉴에서 클러스터를 선택하면 클러스터 이름 오른쪽에 Databricks 런타임 버전이 표시됩니다.

GPU 사용 ML 런타임을 선택하는 경우 호환되는 드라이버 유형 및 작업자 유형을 선택하라는 메시지가 표시됩니다. 호환되지 않는 인스턴스 유형은 드롭다운 메뉴에서 회색으로 표시됩니다. GPU 사용 인스턴스 유형은 GPU 가속 레이블 아래에 나열됩니다 .

참고 항목

기계 학습 워크플로를 위해 Unity 카탈로그의 데이터에 액세스하려면 클러스터에 대한 액세스 모드 가 단일 사용자(할당됨)여야 합니다. 공유 클러스터는 Machine Learning용 Databricks Runtime과 호환되지 않습니다.

Databricks Runtime ML에 포함된 라이브러리

Databricks 런타임 ML에는 널리 사용되는 다양한 ML 라이브러리가 포함되어 있습니다. 라이브러리는 새로운 기능과 수정 사항을 포함하도록 각 릴리스와 함께 업데이트됩니다.

Databricks는 지원되는 라이브러리의 하위 집합을 최상위 계층 라이브러리로 지정했습니다. 이러한 라이브러리의 경우 Databricks는 각 런타임 릴리스를 사용하여 최신 패키지 릴리스로 업데이트하는 빠른 업데이트 주기를 제공합니다(종속성 충돌 금지). 또한 Databricks는 최상위 계층 라이브러리에 대한 고급 지원, 테스트 및 포함된 최적화를 제공합니다.

최상위 계층 및 기타 제공된 라이브러리의 전체 목록은 Databricks Runtime ML에 대한 릴리스 정보를 참조하세요.

다음 단계

시작하려면 다음을 참조하십시오.

Databricks Machine Learning에 대한 권장 MLOps 워크플로는 다음을 참조하세요.

주요 Databricks Machine Learning 기능에 대해 알아보려면 다음을 참조하세요.

피드백

출시 예정: 2024년 내내 콘텐츠에 대한 피드백 메커니즘으로 GitHub 문제를 단계적으로 폐지하고 이를 새로운 피드백 시스템으로 바꿀 예정입니다. 자세한 내용은 다음을 참조하세요. https://aka.ms/ContentUserFeedback

다음에 대한 사용자 의견 제출 및 보기