Merk

Tilgang til denne siden krever autorisasjon. Du kan prøve å logge på eller endre kataloger.

Tilgang til denne siden krever autorisasjon. Du kan prøve å endre kataloger.

Denne opplæringen inntar data i Fabric lakehouses i delta lake format. Vi definerer noen viktige begreper her:

Lakehouse - En lakehouse er en samling av filer, mapper og / eller tabeller som representerer en database over en datainnsjø. Spark-motoren og SQL-motoren bruker lakehouse-ressurser for behandling av store data. Når du bruker deltaformaterte tabeller med åpen kildekode, omfatter denne behandlingen forbedrede ACID-transaksjonsfunksjoner.

Delta Lake – Delta Lake er et lagringslag med åpen kildekode som bringer ACID-transaksjoner, skalerbar metadatabehandling og gruppe- og strømming av databehandling til Apache Spark. Som et datatabellformat utvider Delta Lake Parquet-datafiler med en filbasert transaksjonslogg for ACID-transaksjoner og skalerbar metadatabehandling.

Azure Open Datasets er kuraterte offentlige datasett som legger til scenariospesifikke funksjoner i maskinlæringsløsninger. Dette fører til mer nøyaktige modeller. Åpne datasett er skyressurser som befinner seg på Microsoft Azure Storage. Apache Spark, REST API, Data Factory og andre verktøy har tilgang til Åpne datasett.

I denne opplæringen bruker du Apache Spark til å:

- Les data fra Azure Open Datasets-beholdere.

- Skriv inn data i et fabric lakehouse delta-bord.

Forutsetninger

Få et Microsoft Fabric-abonnement. Eller registrer deg for en gratis prøveversjon av Microsoft Fabric.

Logg på Microsoft Fabric.

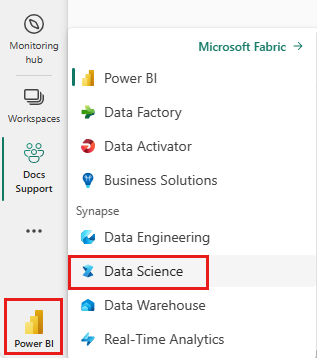

Bytt til Fabric ved å bruke erfaringsbryteren nederst til venstre på hjemmesiden din.

- Legg til et lakehouse i denne notatblokken. I denne opplæringen laster du først ned data fra en offentlig blob. Deretter lagres dataene i den lakehouse-ressursen.

Følg med i en notatblokk

Notatblokken 1-inntak-data.ipynb følger med denne opplæringen.

Hvis du vil åpne den medfølgende notatblokken for denne opplæringen, følger du instruksjonene i Klargjør systemet for opplæringer for datavitenskap for å importere notatblokken til arbeidsområdet.

Hvis du heller vil kopiere og lime inn koden fra denne siden, kan du opprette en ny notatblokk.

Pass på at du fester et lakehouse til notatblokken før du begynner å kjøre kode.

Bankfrafallsdata

Datasettet inneholder informasjon om frafallsstatus for 10 000 kunder. Det inneholder også attributter som kan påvirke churn - for eksempel:

- Kredittpoengsum

- Geografisk plassering (Tyskland, Frankrike, Spania)

- Kjønn (mann, kvinne)

- Alder

- Tenure (antall år kunden var en klient i denne banken)

- Kontosaldo

- Beregnet lønn

- Antall produkter som en kunde har kjøpt gjennom banken

- Kredittkortstatus (om en kunde har et kredittkort eller ikke)

- Aktiv medlemsstatus (om kunden har en aktiv bankkundestatus)

Datasettet inneholder også disse kolonnene:

- radnummer

- kunde-ID

- kundenavn

Disse kolonnene bør ikke ha noen innflytelse på en kundes beslutning om å forlate banken.

Avslutning av en kundebankkonto definerer frafall av kunden. Datasettkolonnen exited refererer til kundens oppgivelse. Lite kontekst om disse attributtene er tilgjengelig, så du må fortsette uten bakgrunnsinformasjon om datasettet. Målet vårt er å forstå hvordan disse attributtene bidrar til statusen exited .

Eksempel på datasettrader:

| "CustomerID" | "Etternavn" | "CreditScore" | "Geografi" | "Kjønn" | "Alder" | "Tenure" | "Balanse" | "NumOfProducts" | "HasCrCard" | "IsActiveMember" | "EstimatedSalary" | "Avsluttet" |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 15634602 | Hargrave | 619 | Frankrike | Kvinnelig | 42 | 2 | 0.00 | 1 | 1 | 1 | 101348.88 | 1 |

| 15647311 | Ås | 608 | Spania | Kvinnelig | 41 | 1 | 83807.86 | 1 | 0 | 1 | 112542.58 | 0 |

Last ned datasett og last opp til lakehouse

Tips

Når du definerer følgende parametere, kan du enkelt bruke denne notatblokken med forskjellige datasett:

IS_CUSTOM_DATA = False # if TRUE, dataset has to be uploaded manually

DATA_ROOT = "/lakehouse/default"

DATA_FOLDER = "Files/churn" # folder with data files

DATA_FILE = "churn.csv" # data file name

Følgende kodesnutt laster ned en offentlig tilgjengelig versjon av datasettet, og lagrer deretter denne ressursen i et Fabric Lakehouse:

Viktig

Pass på at du legger til et lakehouse i notatblokken før du kjører den. Hvis du ikke gjør dette, resulterer det i en feil.

import os, requests

if not IS_CUSTOM_DATA:

# Download demo data files into lakehouse if not exist

remote_url = "https://synapseaisolutionsa.z13.web.core.windows.net/data/bankcustomerchurn"

file_list = [DATA_FILE]

download_path = f"{DATA_ROOT}/{DATA_FOLDER}/raw"

if not os.path.exists("/lakehouse/default"):

raise FileNotFoundError(

"Default lakehouse not found, please add a lakehouse and restart the session."

)

os.makedirs(download_path, exist_ok=True)

for fname in file_list:

if not os.path.exists(f"{download_path}/{fname}"):

r = requests.get(f"{remote_url}/{fname}", timeout=30)

with open(f"{download_path}/{fname}", "wb") as f:

f.write(r.content)

print("Downloaded demo data files into lakehouse.")

Relatert innhold

Du bruker dataene du nettopp inntok i: