Delta Lake logger i Warehouse i Microsoft Fabric

Gjelder for:✅ Lager i Microsoft Fabric

Lager i Microsoft Fabric er bygget opp åpne filformater. Brukertabeller lagres i parquet-filformat, og Delta Lake-logger publiseres for alle brukertabeller.

Delta Lake-loggene åpner direkte tilgang til lagerets brukertabeller for enhver motor som kan lese Delta Lake-tabeller. Denne tilgangen er begrenset til skrivebeskyttet for å sikre at brukerdataene opprettholder ACID-transaksjonssamsvar. Alle innsettinger, oppdateringer og slettinger i dataene i tabellene må utføres via lageret. Når en transaksjon er utført, startes en systembakgrunnsprosess for å publisere den oppdaterte Delta Lake-loggen for de berørte tabellene.

Slik får du OneLake-bane

Følgende trinn beskriver hvordan du får OneLake-banen fra en tabell i et lager:

Åpne Warehouse i Microsoft Fabric-arbeidsområdet.

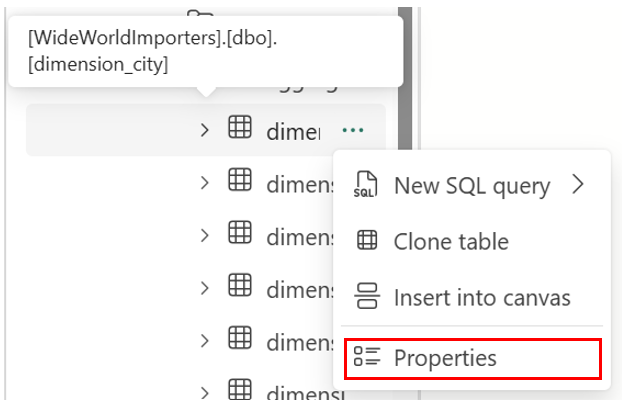

I Objektutforsker finner du flere alternativer (...) i en valgt tabell i Tabeller-mappen. Velg Egenskaper-menyen.

Egenskaper-ruten viser følgende informasjon ved valg:

- Name

- Format

- Type

- Nettadresse

- Relativ bane

- ABFS-bane

Slik får du deltasjøens loggbane

Du kan finne Delta Lake-logger via følgende metoder:

Delta Lake-logger kan spørres gjennom snarveier som er opprettet i et lakehouse. Du kan vise filene ved hjelp av en Microsoft Fabric Spark Notebook eller Lakehouse Explorer i Synapse Dataingeniør ing i Microsoft Fabric-portalen.

Delta Lake-logger finner du via Azure Storage Explorer, via Spark-tilkoblinger, for eksempel Power BI Direct Lake-modus, eller ved hjelp av en annen tjeneste som kan lese deltatabeller.

Delta Lake-logger finner du i mappen for

_delta_loghver tabell gjennom OneLake Explorer i Windows, som vist i følgende skjermbilde.

Pause delta lake logg publisering

Publisering av Delta Lake-logger kan stanses midlertidig og gjenopptas om nødvendig. Når publiseringen er stanset midlertidig, ser Microsoft Fabric-motorer som leser tabeller utenfor lageret, dataene slik de var før pausen. Den sikrer at rapportene forblir stabile og konsekvente, noe som gjenspeiler data fra alle tabeller slik de eksisterte før eventuelle endringer ble gjort i tabellene. Når dataoppdateringene er fullført, kan du gjenoppta Publisering av Delta Lake Log for å gjøre alle nylige dataendringer synlige for andre analytiske motorer. Et annet brukstilfelle for midlertidig publisering av Delta Lake-loggen er når brukere ikke trenger interoperabilitet med andre databehandlingsmotorer i Microsoft Fabric, da det kan bidra til å spare på databehandlingskostnader.

Syntaksen for å stanse deltasjøens loggpublisering midlertidig og fortsette, er som følger:

ALTER DATABASE CURRENT SET DATA_LAKE_LOG_PUBLISHING = PAUSED | AUTO

Eksempel: pause og gjenoppta loggpublisering av Delta Lake

Hvis du vil stanse deltasjøens loggpublisering midlertidig, bruker du følgende kodesnutt:

ALTER DATABASE CURRENT SET DATA_LAKE_LOG_PUBLISHING = PAUSED

Spørringer til lagertabeller på det gjeldende lageret fra andre Microsoft Fabric-motorer (for eksempel spørringer fra en Lakehouse) viser nå en versjon av dataene slik de var før delta lake-loggpublisering settes på pause. Lagerspørringer viser fortsatt den nyeste versjonen av data.

Bruk følgende kodesnutt for å gjenoppta deltasjøens loggpublisering:

ALTER DATABASE CURRENT SET DATA_LAKE_LOG_PUBLISHING = AUTO

Når tilstanden endres tilbake til AUTO, publiserer Fabric Warehouse-motoren logger over alle nylige endringer i tabeller på lageret, slik at andre analytiske motorer i Microsoft Fabric kan lese den nyeste versjonen av data.

Kontrollere statusen for deltasjøens loggpublisering

Hvis du vil kontrollere gjeldende tilstand for deltasjøens loggpublisering på alle lagrene for gjeldende arbeidsområde, bruker du følgende kodesnutt:

SELECT [name], [DATA_LAKE_LOG_PUBLISHING_DESC] FROM sys.databases

Begrensninger

- Tabellnavn kan bare brukes av Spark og andre systemer hvis de bare inneholder disse tegnene: A-Z a-z 0-9 og understrekingstegn.

- Kolonnenavn som skal brukes av Spark og andre systemer, kan ikke inneholde:

- Mellomrom

- faner

- vogn returnerer

- [

- ,

- ;

- {

- }

- (

- )

- =

- ]