De Azure CNI Overlay-netwerken configureren in Azure Kubernetes Service (AKS)

De traditionele Azure Container Networking Interface (CNI) wijst een VNet-IP-adres toe aan elke pod. Het wijst dit IP-adres toe vanuit een vooraf gereserveerde set IP-adressen op elk knooppunt of een afzonderlijk subnet dat is gereserveerd voor pods. Voor deze aanpak is het plannen van IP-adressen vereist en kan dit leiden tot uitputting, wat problemen veroorzaakt bij het schalen van uw clusters naarmate de vraag naar uw toepassing toeneemt.

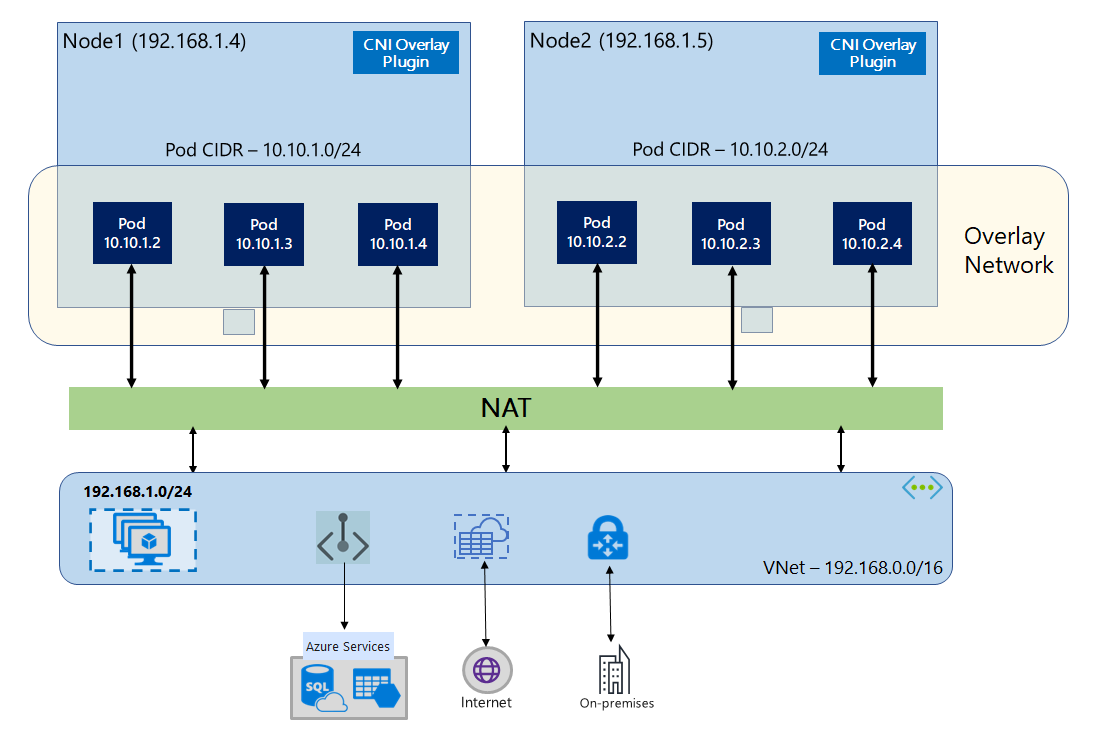

Met Azure CNI-overlay worden de clusterknooppunten geïmplementeerd in een VNet-subnet (Virtual Network) van Azure. Pods worden toegewezen IP-adressen van een privé-CIDR logisch anders dan het VNet dat als host fungeert voor de knooppunten. Pod- en knooppuntverkeer binnen het cluster maken gebruik van een Overlay-netwerk. Network Address Translation (NAT) gebruikt het IP-adres van het knooppunt om resources buiten het cluster te bereiken. Deze oplossing bespaart een aanzienlijke hoeveelheid VNet-IP-adressen en stelt u in staat om uw cluster te schalen naar grote grootten. Een extra voordeel is dat u de privé-CIDR opnieuw kunt gebruiken in verschillende AKS-clusters, waardoor de IP-ruimte die beschikbaar is voor toepassingen in containers in Azure Kubernetes Service (AKS) wordt uitgebreid.

Overzicht van Overlay-netwerken

In Overlay-netwerken krijgen alleen de Kubernetes-clusterknooppunten IP-adressen van subnetten toegewezen. Pods ontvangen IP-adressen van een persoonlijke CIDR die is opgegeven op het moment dat het cluster is gemaakt. Aan elk knooppunt wordt een /24 adresruimte toegewezen die is uitgesneden uit dezelfde CIDR. Extra knooppunten die zijn gemaakt wanneer u een cluster uitschaalt, ontvangen /24 automatisch adresruimten van dezelfde CIDR. Azure CNI wijst IP-adressen toe aan pods vanuit deze /24 ruimte.

Er wordt een afzonderlijk routeringsdomein gemaakt in de Azure-netwerkstack voor de privé-CIDR-ruimte van de pod, waarmee een Overlay-netwerk wordt gemaakt voor directe communicatie tussen pods. Het is niet nodig om aangepaste routes in te richten op het clustersubnet of een inkapselingsmethode te gebruiken om verkeer tussen pods te tunnelen. Dit biedt connectiviteitsprestaties tussen pods op dezelfde manier als virtuele machines in een VNet. Workloads die in de pods worden uitgevoerd, zijn niet eens op de hoogte dat het bewerken van netwerkadressen plaatsvindt.

Communicatie met eindpunten buiten het cluster, zoals on-premises en gekoppelde VNets, gebeurt met behulp van het IP-adres van het knooppunt via NAT. Azure CNI vertaalt het bron-IP-adres (Overlay-IP van de pod) van het verkeer naar het primaire IP-adres van de VIRTUELE machine, waardoor de Azure-netwerkstack het verkeer naar de bestemming kan routeren. Eindpunten buiten het cluster kunnen niet rechtstreeks verbinding maken met een pod. U moet de toepassing van de pod publiceren als een Kubernetes Load Balancer-service om deze bereikbaar te maken op het VNet.

U kunt uitgaande (uitgaande) connectiviteit met internet bieden voor Overlay-pods met behulp van een Standard SKU Load Balancer of Managed NAT Gateway. U kunt ook uitgaand verkeer beheren door het naar een firewall te leiden met behulp van door de gebruiker gedefinieerde routes in het clustersubnet.

U kunt toegangsbeheerobjectconnectiviteit met het cluster configureren met behulp van een ingangscontroller, zoals Nginx of HTTP-toepassingsroutering. U kunt geen toegangsbeheerobjectconnectiviteit configureren met behulp van Azure-app Gateway. Zie Beperkingen met Azure CNI-overlay voor meer informatie.

Verschillen tussen Kubenet en Azure CNI-overlay

Net als Azure CNI Overlay wijst Kubenet IP-adressen toe aan pods vanuit een adresruimte die logisch verschilt van het VNet, maar het heeft schaalaanpassing en andere beperkingen. De onderstaande tabel bevat een gedetailleerde vergelijking tussen Kubenet en Azure CNI Overlay. Als u geen VNet-IP-adressen wilt toewijzen aan pods vanwege een tekort aan IP-adressen, raden we u aan Azure CNI-overlay te gebruiken.

| Gebied | Azure CNI-overlay | Kubenet |

|---|---|---|

| Clusterschaal | 5000 knooppunten en 250 pods/knooppunten | 400 knooppunten en 250 pods/knooppunten |

| Netwerkconfiguratie | Eenvoudig- geen extra configuraties vereist voor podnetwerken | Complex: vereist routetabellen en UDR's in het clustersubnet voor podnetwerken |

| Prestaties van podconnectiviteit | Prestaties op basis van vm's in een VNet | Extra hop voegt latentie toe |

| Kubernetes-netwerkbeleid | Azure-netwerkbeleid, Calico, Cilium | Calico |

| Ondersteunde besturingssysteemplatforms | Linux en Windows Server 2022, 2019 | Alleen Linux |

PLANNING van IP-adressen

- Clusterknooppunten: zorg er bij het instellen van uw AKS-cluster voor dat uw VNet-subnetten voldoende ruimte hebben om te groeien voor toekomstige schaalaanpassing. U kunt elke knooppuntgroep toewijzen aan een toegewezen subnet. Een

/24subnet kan maximaal 251 knooppunten bevatten, omdat de eerste drie IP-adressen zijn gereserveerd voor beheertaken. - Pods: De Overlay-oplossing wijst een

/24adresruimte toe voor pods op elk knooppunt vanuit de persoonlijke CIDR die u opgeeft tijdens het maken van het cluster. De/24grootte is vast en kan niet worden verhoogd of verlaagd. U kunt maximaal 250 pods uitvoeren op een knooppunt. Zorg er bij het plannen van de adresruimte voor pods voor dat de privé-CIDR groot genoeg is om adresruimten te bieden/24voor nieuwe knooppunten om toekomstige clusteruitbreiding te ondersteunen.- Houd rekening met de volgende factoren bij het plannen van IP-adresruimte voor pods:

- Dezelfde CIDR-ruimte voor pods kan worden gebruikt op meerdere onafhankelijke AKS-clusters in hetzelfde VNet.

- De CIDR-ruimte voor pods mag niet overlappen met het clustersubnetbereik.

- CiDR-ruimte voor pods mag niet overlappen met rechtstreeks verbonden netwerken (zoals VNet-peering, ExpressRoute of VPN). Als extern verkeer bron-IP-adressen in het podCIDR-bereik heeft, moet het worden omgezet naar een niet-overlappend IP-adres via SNAT om te communiceren met het cluster.

- Houd rekening met de volgende factoren bij het plannen van IP-adresruimte voor pods:

- Kubernetes-serviceadresbereik: de grootte van het serviceadres CIDR is afhankelijk van het aantal clusterservices dat u wilt maken. Het moet kleiner zijn dan

/12. Dit bereik mag niet overlappen met het CIDR-bereik van de pod, het clustersubnetbereik en het IP-bereik dat wordt gebruikt in gekoppelde VNets en on-premises netwerken. - IP-adres van kubernetes DNS-service: dit IP-adres bevindt zich binnen het Kubernetes-serviceadresbereik dat wordt gebruikt door clusterservicedetectie. Gebruik niet het eerste IP-adres in uw adresbereik, omdat dit adres wordt gebruikt voor het

kubernetes.default.svc.cluster.localadres.

Belangrijk

De privé-CIDR-bereiken die beschikbaar zijn voor de Pod CIDR worden gedefinieerd in RFC 1918. Hoewel het gebruik van openbare IP-bereiken niet wordt geblokkeerd, worden ze beschouwd als buiten het ondersteuningsbereik van Microsoft. U wordt aangeraden privé-IP-bereiken te gebruiken voor POD CIDR.

Netwerkbeveiligingsgroepen

Pod-naar-podverkeer met Azure CNI-overlay wordt niet ingekapseld en regels voor subnetbeveiligingsgroepen worden toegepast. Als de subnet-NSG regels voor weigeren bevat die van invloed zijn op het CIDR-verkeer van de pod, moet u ervoor zorgen dat de volgende regels zijn ingesteld om de juiste clusterfunctionaliteit te garanderen (naast alle AKS-vereisten voor uitgaand verkeer):

- Verkeer van het knooppunt CIDR naar het knooppunt CIDR op alle poorten en protocollen

- Verkeer van het knooppunt CIDR naar de POD CIDR op alle poorten en protocollen (vereist voor routering van serviceverkeer)

- Verkeer van de POD CIDR naar de POD CIDR op alle poorten en protocollen (vereist voor pod-naar-pod- en pod-naar-serviceverkeer, inclusief DNS)

Verkeer van een pod naar een bestemming buiten het CIDR-blok van de pod maakt gebruik van SNAT om het bron-IP-adres in te stellen op het IP-adres van het knooppunt waarop de pod wordt uitgevoerd.

Als u verkeer tussen workloads in het cluster wilt beperken, raden we u aan netwerkbeleid te gebruiken.

Maximum aantal pods per knooppunt

U kunt het maximum aantal pods per knooppunt configureren op het moment dat het cluster wordt gemaakt of wanneer u een nieuwe knooppuntgroep toevoegt. De standaardinstelling voor Azure CNI-overlay is 250. De maximumwaarde die u kunt opgeven in Azure CNI Overlay is 250 en de minimumwaarde is 10. De maximale pods per knooppuntwaarde die tijdens het maken van een knooppuntgroep zijn geconfigureerd, zijn alleen van toepassing op de knooppunten in die knooppuntgroep.

Een netwerkmodel kiezen dat moet worden gebruikt

Azure CNI biedt twee IP-adresseringsopties voor pods: de traditionele configuratie waarmee VNet-IP's worden toegewezen aan pods en Overlay-netwerken. De keuze welke optie u voor uw AKS-cluster wilt gebruiken, is een balans tussen flexibiliteit en geavanceerde configuratiebehoeften. De volgende overwegingen helpen om een overzicht te geven wanneer elk netwerkmodel mogelijk het meest geschikt is.

Gebruik Overlay-netwerken wanneer:

- U wilt schalen naar een groot aantal pods, maar u hebt beperkte IP-adresruimte in uw VNet.

- De meeste podcommunicatie bevindt zich in het cluster.

- U hebt geen geavanceerde AKS-functies nodig, zoals virtuele knooppunten.

Gebruik de traditionele VNet-optie wanneer:

- U hebt beschikbare IP-adresruimte.

- De meeste podcommunicatie is naar resources buiten het cluster.

- Resources buiten het cluster moeten pods rechtstreeks bereiken.

- U hebt geavanceerde AKS-functies nodig, zoals virtuele knooppunten.

Beperkingen met Azure CNI-overlay

Azure CNI Overlay heeft de volgende beperkingen:

- U kunt Application Gateway niet gebruiken als een ingangscontroller (AGIC) voor een Overlay-cluster.

- U kunt Application Gateway voor containers niet gebruiken voor een Overlay-cluster.

- Beschikbaarheidssets voor virtuele machines (VMAS) worden niet ondersteund voor Overlay.

- U kunt virtuele machines uit de DCsv2-serie niet gebruiken in knooppuntgroepen. Als u wilt voldoen aan de vereisten voor Confidential Computing, kunt u in plaats daarvan vertrouwelijke VM's uit de DCasv5- of DCadsv5-serie gebruiken.

- Als u uw eigen subnet gebruikt om het cluster te implementeren, moeten de namen van het subnet, het VNET en de resourcegroep die het VNET bevat, 63 tekens of minder zijn. Dit komt van het feit dat deze namen worden gebruikt als labels in AKS-werkknooppunten en daarom worden onderworpen aan kubernetes-labelsyntaxisregels.

Overlayclusters instellen

Notitie

U moet CLI-versie 2.48.0 of hoger hebben om het --network-plugin-mode argument te kunnen gebruiken. Voor Windows moet de nieuwste Azure CLI-extensie aks-preview zijn geïnstalleerd en kunt u de onderstaande instructies volgen.

Maak een cluster met Azure CNI Overlay met behulp van de az aks create opdracht. Zorg ervoor dat u het argument --network-plugin-mode gebruikt om een overlaycluster op te geven. Als de POD CIDR niet is opgegeven, wijst AKS een standaardruimte toe: viz. 10.244.0.0/16.

clusterName="myOverlayCluster"

resourceGroup="myResourceGroup"

location="westcentralus"

az aks create \

--name $clusterName \

--resource-group $resourceGroup \

--location $location \

--network-plugin azure \

--network-plugin-mode overlay \

--pod-cidr 192.168.0.0/16 \

--generate-ssh-keys

Een nieuwe knooppuntpool toevoegen aan een toegewezen subnet

Nadat u een cluster hebt gemaakt met Azure CNI Overlay, kunt u een andere knooppuntpool maken en de knooppunten toewijzen aan een nieuw subnet van hetzelfde VNet. Deze benadering kan handig zijn als u de ip-adressen voor inkomend of uitgaand verkeer van de host wilt beheren van/naar doelen in hetzelfde VNET of gekoppelde VNets.

clusterName="myOverlayCluster"

resourceGroup="myResourceGroup"

location="westcentralus"

nodepoolName="newpool1"

subscriptionId=$(az account show --query id -o tsv)

vnetName="yourVnetName"

subnetName="yourNewSubnetName"

subnetResourceId="/subscriptions/$subscriptionId/resourceGroups/$resourceGroup/providers/Microsoft.Network/virtualNetworks/$vnetName/subnets/$subnetName"

az aks nodepool add --resource-group $resourceGroup --cluster-name $clusterName \

--name $nodepoolName --node-count 1 \

--mode system --vnet-subnet-id $subnetResourceId

Dual-stack-netwerken

U kunt uw AKS-clusters implementeren in een dual-stackmodus wanneer u Overlay-netwerken en een virtueel Azure-netwerk met twee stacks gebruikt. In deze configuratie ontvangen knooppunten zowel een IPv4- als IPv6-adres van het subnet van het virtuele Azure-netwerk. Pods ontvangen zowel een IPv4- als IPv6-adres van een logisch andere adresruimte naar het subnet van het virtuele Azure-netwerk van de knooppunten. NAT (Network Address Translation) wordt vervolgens zo geconfigureerd dat de pods resources kunnen bereiken in het virtuele Azure-netwerk. Het bron-IP-adres van het verkeer is NAT naar het primaire IP-adres van het knooppunt van dezelfde familie (IPv4 naar IPv4 en IPv6 naar IPv6).

Vereisten

- U moet Azure CLI 2.48.0 of hoger hebben geïnstalleerd.

- Kubernetes versie 1.26.3 of hoger.

Beperkingen

De volgende functies worden niet ondersteund met dual-stack-netwerken:

- Azure-netwerkbeleid

- Calico-netwerkbeleid

- NAT-gateway

- Invoegtoepassing voor virtuele knooppunten

Een AKS-cluster met twee stacks implementeren

De volgende kenmerken zijn beschikbaar ter ondersteuning van clusters met dubbele stack:

--ip-families: maakt gebruik van een door komma's gescheiden lijst met IP-families om het cluster in te schakelen.- Alleen

ipv4ofipv4,ipv6worden ondersteund.

- Alleen

--pod-cidrs: Maakt gebruik van een door komma's gescheiden lijst met IP-adresbereiken voor CIDR-notatie om POD-IP-adressen toe te wijzen.- Het aantal en de volgorde van bereiken in deze lijst moeten overeenkomen met de waarde die is opgegeven.

--ip-families - Als er geen waarden worden opgegeven, wordt de standaardwaarde

10.244.0.0/16,fd12:3456:789a::/64gebruikt.

- Het aantal en de volgorde van bereiken in deze lijst moeten overeenkomen met de waarde die is opgegeven.

--service-cidrs: Maakt gebruik van een door komma's gescheiden lijst met IP-adresbereiken voor CIDR-notatie om service-IP-adressen toe te wijzen.- Het aantal en de volgorde van bereiken in deze lijst moeten overeenkomen met de waarde die is opgegeven.

--ip-families - Als er geen waarden worden opgegeven, wordt de standaardwaarde

10.0.0.0/16,fd12:3456:789a:1::/108gebruikt. - Het toegewezen IPv6-subnet

--service-cidrsmag niet groter zijn dan een /108.

- Het aantal en de volgorde van bereiken in deze lijst moeten overeenkomen met de waarde die is opgegeven.

Een AKS-cluster met dubbele stack maken

Maak een Azure-resourcegroep voor het cluster met behulp van de opdracht [

az group create][az-group-create].az group create --location <region> --name <resourceGroupName>Maak een AKS-cluster met dubbele stack met behulp van de

az aks createopdracht waarop de--ip-familiesparameter is ingesteldipv4,ipv6.az aks create \ --location <region> \ --resource-group <resourceGroupName> \ --name <clusterName> \ --network-plugin azure \ --network-plugin-mode overlay \ --ip-families ipv4,ipv6 \ --generate-ssh-keys

Een voorbeeldworkload maken

Zodra het cluster is gemaakt, kunt u uw workloads implementeren. In dit artikel wordt een voorbeeld van een workloadimplementatie van een NGINX-webserver beschreven.

Een NGINX-webserver implementeren

De invoegtoepassing voor toepassingsroutering is de aanbevolen manier voor inkomend verkeer in een AKS-cluster. Zie Voor meer informatie over de invoegtoepassing voor toepassingsroutering en een voorbeeld van het implementeren van een toepassing met de invoegtoepassing beheerde NGINX met de invoegtoepassing voor toepassingsroutering.

De workload beschikbaar maken via een LoadBalancer typeservice

Belangrijk

Er zijn momenteel twee beperkingen met betrekking tot IPv6-services in AKS.

- Azure Load Balancer verzendt statustests naar IPv6-bestemmingen vanaf een koppelingsadres. In Azure Linux-knooppuntgroepen kan dit verkeer niet worden gerouteerd naar een pod, zodat verkeer dat naar IPv6-services stroomt die zijn geïmplementeerd,

externalTrafficPolicy: Clustermislukt. IPv6-services moeten worden geïmplementeerd metexternalTrafficPolicy: Local, waardoorkube-proxyde test op het knooppunt reageert. - Vóór Kubernetes versie 1.27 wordt alleen het eerste IP-adres voor een service ingericht voor de load balancer, zodat een dual-stack-service alleen een openbaar IP-adres ontvangt voor de eerst vermelde IP-familie. Als u een service met twee stacks voor één implementatie wilt bieden, maakt u twee services die gericht zijn op dezelfde selector, één voor IPv4 en één voor IPv6. Dit is geen beperking meer in kubernetes 1.27 of hoger.

Stel de NGINX-implementatie beschikbaar met behulp van de

kubectl expose deployment nginxopdracht.kubectl expose deployment nginx --name=nginx-ipv4 --port=80 --type=LoadBalancer' kubectl expose deployment nginx --name=nginx-ipv6 --port=80 --type=LoadBalancer --overrides='{"spec":{"ipFamilies": ["IPv6"]}}'U ontvangt een uitvoer met de weergegeven services.

service/nginx-ipv4 exposed service/nginx-ipv6 exposedZodra de implementatie beschikbaar is en de

LoadBalancerservices volledig zijn ingericht, haalt u de IP-adressen van de services op met behulp van dekubectl get servicesopdracht.kubectl get servicesNAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE nginx-ipv4 LoadBalancer 10.0.88.78 20.46.24.24 80:30652/TCP 97s nginx-ipv6 LoadBalancer fd12:3456:789a:1::981a 2603:1030:8:5::2d 80:32002/TCP 63sControleer de functionaliteit via een opdrachtregelwebaanvraag van een host die geschikt is voor IPv6. Azure Cloud Shell is niet geschikt voor IPv6.

SERVICE_IP=$(kubectl get services nginx-ipv6 -o jsonpath='{.status.loadBalancer.ingress[0].ip}') curl -s "http://[${SERVICE_IP}]" | head -n5<!DOCTYPE html> <html> <head> <title>Welcome to nginx!</title> <style>

Dual-stack-netwerken met Azure CNI Powered by Cilium - (preview)

U kunt uw AKS-clusters met twee stacks implementeren met Azure CNI Powered by Cilium. Hiermee kunt u ook uw IPv6-verkeer beheren met de Cilium Network Policy-engine.

Belangrijk

AKS preview-functies zijn beschikbaar op selfservice, opt-in basis. Previews worden geleverd 'zoals is' en 'als beschikbaar' en ze worden uitgesloten van de serviceovereenkomsten en beperkte garantie. AKS-previews worden gedeeltelijk gedekt door klantondersteuning op basis van best effort. Daarom zijn deze functies niet bedoeld voor productiegebruik. Zie de volgende ondersteuningsartikelen voor meer informatie:

Vereisten

- U moet de nieuwste versie van de AKS Preview-extensie hebben.

- U moet Kubernetes versie 1.29 of hoger hebben.

De Azure CLI-extensie aks-preview installeren

Installeer de aks-preview-extensie met behulp van de

az extension addopdracht.az extension add --name aks-previewWerk bij naar de nieuwste versie van de extensie die is uitgebracht met behulp van de

az extension updateopdracht.az extension update --name aks-preview

De functievlag 'AzureOverlayDualStackPreview' registreren

Registreer de

AzureOverlayDualStackPreviewfunctievlag met behulp van deaz feature registeropdracht.az feature register --namespace "Microsoft.ContainerService" --name "AzureOverlayDualStackPreview"Het duurt enkele minuten voordat de status Geregistreerd wordt weergegeven.

Controleer de registratiestatus met behulp van de

az feature showopdracht:az feature show --namespace "Microsoft.ContainerService" --name "AzureOverlayDualStackPreview"Wanneer de status Geregistreerd weergeeft, vernieuwt u de registratie van de Microsoft.ContainerService-resourceprovider met behulp van de

az provider registeropdracht.az provider register --namespace Microsoft.ContainerService

Overlay-clusters instellen met Azure CNI Powered by Cilium

Maak een cluster met Azure CNI Overlay met behulp van de az aks create opdracht. Zorg ervoor dat u het argument --network-dataplane cilium gebruikt om het gegevensvlak Cilium op te geven.

clusterName="myOverlayCluster"

resourceGroup="myResourceGroup"

location="westcentralus"

az aks create \

--name $clusterName \

--resource-group $resourceGroup \

--location $location \

--network-plugin azure \

--network-plugin-mode overlay \

--network-dataplane cilium \

--ip-families ipv4,ipv6 \

--generate-ssh-keys\

Zie Azure CNI Powered by Cilium voor meer informatie over Azure CNI Powered by Cilium.

Dual-stack-netwerkknooppuntpools in Windows - (preview)

U kunt uw AKS-clusters met dubbele stack implementeren met Windows-knooppuntpools.

Belangrijk

AKS preview-functies zijn beschikbaar op selfservice, opt-in basis. Previews worden geleverd 'zoals is' en 'als beschikbaar' en ze worden uitgesloten van de serviceovereenkomsten en beperkte garantie. AKS-previews worden gedeeltelijk gedekt door klantondersteuning op basis van best effort. Daarom zijn deze functies niet bedoeld voor productiegebruik. Zie de volgende ondersteuningsartikelen voor meer informatie:

De Azure CLI-extensie aks-preview installeren

Installeer de aks-preview-extensie met behulp van de

az extension addopdracht.az extension add --name aks-previewWerk bij naar de nieuwste versie van de extensie die is uitgebracht met behulp van de

az extension updateopdracht.az extension update --name aks-preview

De functievlag 'AzureOverlayDualStackPreview' registreren

Registreer de

AzureOverlayDualStackPreviewfunctievlag met behulp van deaz feature registeropdracht.az feature register --namespace "Microsoft.ContainerService" --name "AzureOverlayDualStackPreview"Het duurt enkele minuten voordat de status Geregistreerd wordt weergegeven.

Controleer de registratiestatus met behulp van de

az feature showopdracht:az feature show --namespace "Microsoft.ContainerService" --name "AzureOverlayDualStackPreview"Wanneer de status Geregistreerd weergeeft, vernieuwt u de registratie van de Microsoft.ContainerService-resourceprovider met behulp van de

az provider registeropdracht.az provider register --namespace Microsoft.ContainerService

Een Overlay-cluster instellen

Maak een cluster met Azure CNI Overlay met behulp van de az aks create opdracht.

clusterName="myOverlayCluster"

resourceGroup="myResourceGroup"

location="westcentralus"

az aks create \

--name $clusterName \

--resource-group $resourceGroup \

--location $location \

--network-plugin azure \

--network-plugin-mode overlay \

--ip-families ipv4,ipv6 \

--generate-ssh-keys\

Een Windows-knooppuntpool toevoegen aan het cluster

Voeg een Windows-knooppuntpool toe aan het cluster met behulp van de opdracht [az aks nodepool add][az-aks-nodepool-add].

az aks nodepool add \

--resource-group $resourceGroup \

--cluster-name $clusterName \

--os-type Windows \

--name winpool1 \

--node-count 2

Volgende stappen

Zie De IPAM-modi en Dataplane Technology van Azure Kubernetes Service (AKS) upgraden voor informatie over het upgraden van bestaande clusters naar Azure CNI-overlay.

Zie De CNI-invoegtoepassing (Bring Your Own Container Network Interface) voor meer informatie over het gebruik van AKS met uw eigen CNI-invoegtoepassing (Container Network Interface).

Azure Kubernetes Service