Logboekregistratie inschakelen in Azure Machine Learning Designer-pijplijnen

In dit artikel leert u hoe u logboekcode toevoegt aan designer-pijplijnen. U leert ook hoe u deze logboeken kunt weergeven met behulp van de Azure Machine Learning-studio webportal.

Zie Uitvoeringen en metrische gegevens van Azure Machine Learning-experimenten bewaken voor meer informatie over het vastleggen van metrische gegevens met behulp van de SDK-ontwerpervaring.

Logboekregistratie inschakelen met Python-script uitvoeren

Gebruik het onderdeel Python-script uitvoeren om logboekregistratie in designer-pijplijnen in te schakelen. Hoewel u elke waarde met deze werkstroom kunt vastleggen, is het vooral handig om metrische gegevens van het onderdeel Evaluate Model te registreren om de modelprestaties in uitvoeringen bij te houden.

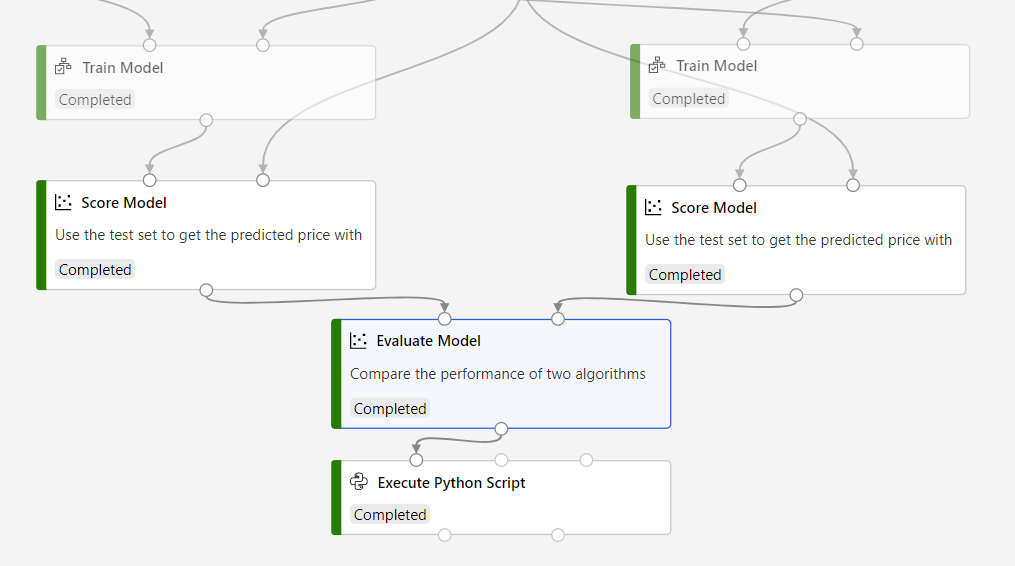

In het volgende voorbeeld ziet u hoe u de gemiddelde kwadratische fout van twee getrainde modellen kunt vastleggen met behulp van de onderdelen Evaluate Model en Execute Python Script.

Koppel een onderdeel Python-script uitvoeren aan de uitvoer van het onderdeel Evaluate Model .

Plak de volgende code in de python-scriptcode-editor uitvoeren om de gemiddelde absolute fout voor uw getrainde model te registreren. U kunt een vergelijkbaar patroon gebruiken om een andere waarde in de ontwerpfunctie te registreren:

VAN TOEPASSING OP:

Python SDK azureml v1

Python SDK azureml v1# dataframe1 contains the values from Evaluate Model def azureml_main(dataframe1=None, dataframe2=None): print(f'Input pandas.DataFrame #1: {dataframe1}') from azureml.core import Run run = Run.get_context() # Log the mean absolute error to the parent run to see the metric in the run details page. # Note: 'run.parent.log()' should not be called multiple times because of performance issues. # If repeated calls are necessary, cache 'run.parent' as a local variable and call 'log()' on that variable. parent_run = Run.get_context().parent # Log left output port result of Evaluate Model. This also works when evaluate only 1 model. parent_run.log(name='Mean_Absolute_Error (left port)', value=dataframe1['Mean_Absolute_Error'][0]) # Log right output port result of Evaluate Model. The following line should be deleted if you only connect one Score component to the` left port of Evaluate Model component. parent_run.log(name='Mean_Absolute_Error (right port)', value=dataframe1['Mean_Absolute_Error'][1]) return dataframe1,

Deze code maakt gebruik van de Azure Machine Learning Python SDK om waarden te registreren. Het maakt gebruik van Run.get_context() om de context van de huidige uitvoering op te halen. Vervolgens worden waarden in die context geregistreerd met de methode run.parent.log(). Deze gebruikt parent om waarden vast te registreren bij de bovenliggende pijplijnuitvoering in plaats van de onderdeeluitvoering.

Zie Logboekregistratie in Azure Machine Learning-trainingsuitvoeringen inschakelen voor meer informatie over het gebruik van de Python SDK voor het vastleggen van waarden.

Logboeken weergeven

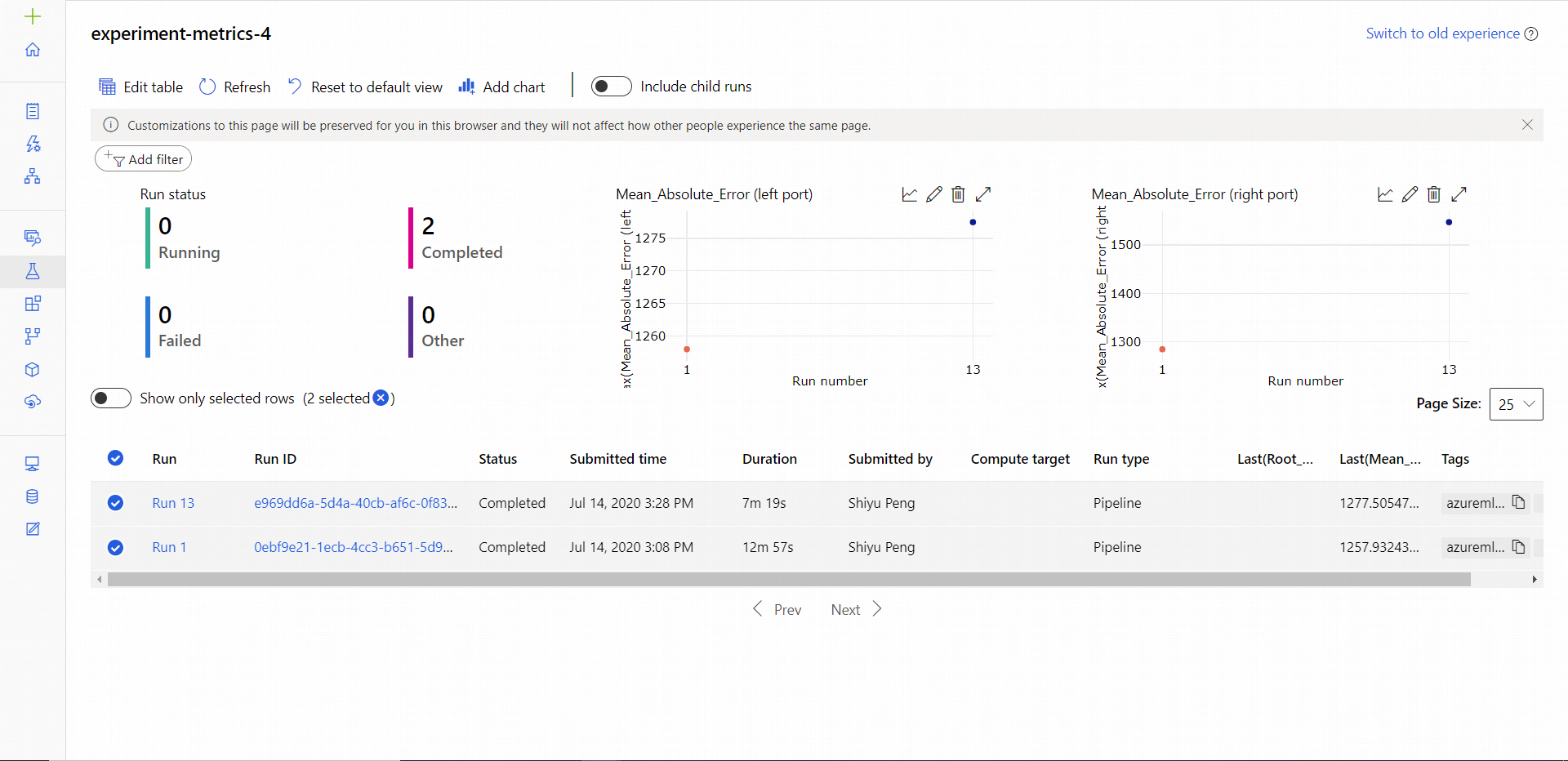

Nadat de pijplijn is uitgevoerd, ziet u de Mean_Absolute_Error op de pagina Experimenten.

Navigeer naar de sectie Taken .

Selecteer uw experiment.

Selecteer de taak in uw experiment die u wilt weergeven.

Selecteer Metrische gegevens.

Volgende stappen

In dit artikel hebt u geleerd hoe u logboeken gebruikt in de ontwerpfunctie. Zie de volgende gerelateerde artikelen voor de volgende stappen:

- Zie Fouten opsporen & in ML-pijplijnen voor meer informatie over het oplossen van problemen met ontwerppijplijnen.

- Zie Logboekregistratie in Azure Machine Learning-trainingsuitvoeringen inschakelen voor meer informatie over het gebruik van de Python SDK-SDK om metrische gegevens te registreren in de SDK-ontwerpervaring.

- Meer informatie over het gebruik van Python-script uitvoeren in de ontwerpfunctie.