Podstawowe pojęcia dotyczące usługi Azure Kubernetes Service (AKS)

W tym artykule opisano podstawowe pojęcia związane z usługą Azure Kubernetes Service (AKS), zarządzaną usługą Kubernetes, której można użyć do wdrażania i obsługi konteneryzowanych aplikacji na dużą skalę na platformie Azure.

Co to jest platforma Kubernetes?

Kubernetes to platforma orkiestracji kontenerów typu open source do automatyzacji wdrażania, skalowania i zarządzania konteneryzowanymi aplikacjami. Aby uzyskać więcej informacji, zobacz oficjalną dokumentację platformy Kubernetes.

Co to jest usługa AKS?

Usługa AKS to zarządzana usługa Kubernetes, która upraszcza wdrażanie i skalowanie konteneryzowanych aplikacji oraz zarządzanie nimi przy użyciu platformy Kubernetes. Aby uzyskać więcej informacji, zobacz Co to jest usługa Azure Kubernetes Service (AKS)?

Składniki klastra

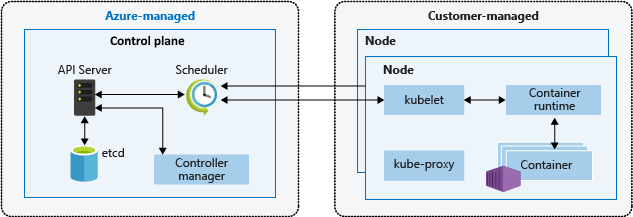

Klaster usługi AKS jest podzielony na dwa główne składniki:

- Płaszczyzna sterowania: Płaszczyzna sterowania zapewnia podstawowe usługi Kubernetes i aranżację obciążeń aplikacji.

- Węzły: węzły są podstawowymi maszynami wirtualnymi, które uruchamiają aplikacje.

Płaszczyzna sterowania

Zarządzana płaszczyzna sterowania platformy Azure składa się z kilku składników, które ułatwiają zarządzanie klastrem:

| Składnik | opis |

|---|---|

| kube-apiserver | Serwer interfejsu API (kube-apiserver) uwidacznia interfejs API Kubernetes w celu umożliwienia żądań do klastra z wewnątrz klastra i poza nim. |

| etcd | Etcd to magazyn o wysokiej dostępności klucz-wartość, który pomaga zachować stan klastra Kubernetes i konfiguracji. |

| kube-scheduler | Harmonogram (kube-scheduler) pomaga podejmować decyzje dotyczące planowania, obserwując nowe zasobniki bez przypisanego węzła i wybierając dla nich węzeł do uruchomienia. |

| kube-controller-manager | Menedżer kontrolera (kube-controller-manager) uruchamia procesy kontrolera, takie jak zauważenie i reagowanie, gdy węzły zejdą w dół. |

| cloud-controller-manager | Menedżer kontrolera chmury (cloud-controller-manager) osadza logikę sterowania specyficzną dla chmury w celu uruchamiania kontrolerów specyficznych dla dostawcy chmury. |

Węzły

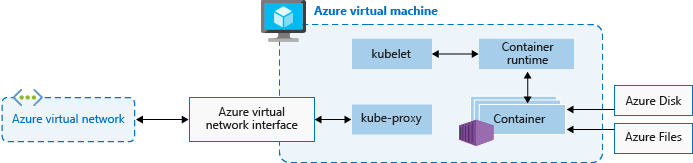

Każdy klaster usługi AKS ma co najmniej jeden węzeł, czyli maszynę wirtualną platformy Azure, która uruchamia składniki węzła Kubernetes. Następujące składniki są uruchamiane w każdym węźle:

| Składnik | opis |

|---|---|

| kubelet | Narzędzie kubelet zapewnia, że kontenery są uruchomione w zasobniku. |

| kube-proxy | Serwer proxy kube-proxy to serwer proxy sieci, który obsługuje reguły sieci w węzłach. |

| środowisko uruchomieniowe kontenera | Środowisko uruchomieniowe kontenera zarządza wykonywaniem i cyklem życia kontenerów. |

Konfiguracja węzła

Rozmiar i obraz maszyny wirtualnej

Rozmiar maszyny wirtualnej platformy Azure dla węzłów definiuje procesory CPU, pamięć, rozmiar i dostępny typ magazynu, taki jak dyski SSD o wysokiej wydajności lub zwykły dysk TWARDY. Wybrany rozmiar maszyny wirtualnej zależy od wymagań dotyczących obciążenia i liczby zasobników, które mają być uruchamiane w każdym węźle. Aby uzyskać więcej informacji, zobacz Obsługiwane rozmiary maszyn wirtualnych w usłudze Azure Kubernetes Service (AKS).

W usłudze AKS obraz maszyny wirtualnej dla węzłów klastra jest oparty na systemie Ubuntu Linux, Azure Linux lub Windows Server 2022. Podczas tworzenia klastra usługi AKS lub skalowania w poziomie liczby węzłów platforma Azure automatycznie tworzy i konfiguruje żądaną liczbę maszyn wirtualnych. Węzły agenta są rozliczane jako standardowe maszyny wirtualne, więc wszelkie rabaty na rozmiar maszyn wirtualnych, w tym rezerwacje platformy Azure, są automatycznie stosowane.

Dyski systemu operacyjnego

Domyślne ustalanie rozmiaru dysku systemu operacyjnego jest używane tylko w nowych klastrach lub pulach węzłów, gdy efemeryczne dyski systemu operacyjnego nie są obsługiwane i nie określono domyślnego rozmiaru dysku systemu operacyjnego. Aby uzyskać więcej informacji, zobacz Domyślny rozmiar dysku systemu operacyjnego i efemeryczny dysk systemu operacyjnego.

Rezerwacje zasobów

Usługa AKS używa zasobów węzłów, aby ułatwić działanie węzłów w ramach klastra. To użycie może spowodować rozbieżność między całkowitymi zasobami węzła a zasobami allocatable w usłudze AKS. Aby zachować wydajność i funkcjonalność węzła, usługa AKS rezerwuje dwa typy zasobów, procesor CPU i pamięć w każdym węźle. Aby uzyskać więcej informacji, zobacz Rezerwacje zasobów w usłudze AKS.

System operacyjny

Usługa AKS obsługuje systemy operacyjne Ubuntu 22.04 i Azure Linux 2.0 jako system operacyjny węzła dla pul węzłów systemu Linux. W przypadku pul węzłów systemu Windows usługa AKS obsługuje system operacyjny Windows Server 2022 jako domyślny system operacyjny. System Windows Server 2019 jest wycofywany po zakończeniu działania platformy Kubernetes w wersji 1.32 i nie jest obsługiwany w przyszłych wersjach. Jeśli musisz uaktualnić wersję systemu operacyjnego Windows, zobacz Uaktualnianie z systemu Windows Server 2019 do systemu Windows Server 2022. Aby uzyskać więcej informacji na temat korzystania z systemu Windows Server w usłudze AKS, zobacz Zagadnienia dotyczące kontenera systemu Windows w usłudze Azure Kubernetes Service (AKS).

Środowisko uruchomieniowe kontenera

Środowisko uruchomieniowe kontenera to oprogramowanie, które wykonuje kontenery i zarządza obrazami kontenerów w węźle. Środowisko uruchomieniowe ułatwia abstrakcję wywołań sys-calls lub funkcji specyficznych dla systemu operacyjnego w celu uruchamiania kontenerów w systemie Linux lub Windows. W przypadku pul węzłów containerd systemu Linux jest używany na platformie Kubernetes w wersji 1.19 lub nowszej. W przypadku pul węzłów containerd systemu Windows Server 2019 i 2022 jest ogólnie dostępna i jest jedyną opcją środowiska uruchomieniowego na platformie Kubernetes w wersji 1.23 lub nowszej.

Zasobniki

Zasobnik to grupa co najmniej jednego kontenera, który współużytkuje te same zasoby sieciowe i magazynowe oraz specyfikację sposobu uruchamiania kontenerów. Zasobniki zazwyczaj mają mapowanie 1:1 z kontenerem, ale można uruchamiać wiele kontenerów w zasobniku.

Pule węzłów

W usłudze AKS węzły tej samej konfiguracji są grupowane razem w pule węzłów. Te pule węzłów zawierają bazowe zestawy skalowania maszyn wirtualnych i maszyny wirtualne, które uruchamiają aplikacje. Podczas tworzenia klastra usługi AKS należy zdefiniować początkową liczbę węzłów i ich rozmiar (SKU), która tworzy pulę węzłów systemowych. Pule węzłów systemowych służą głównemu celowi hostowania krytycznych zasobników systemu, takich jak CoreDNS i konnectivity. Aby obsługiwać aplikacje o różnych wymaganiach obliczeniowych lub magazynowych, można utworzyć pule węzłów użytkownika. Pule węzłów użytkownika służą głównemu celowi hostowania zasobników aplikacji.

Aby uzyskać więcej informacji, zobacz Tworzenie pul węzłów w usłudze AKS i Zarządzanie pulami węzłów w usłudze AKS.

Grupa zasobów węzła

Podczas tworzenia klastra usługi AKS w grupie zasobów platformy Azure dostawca zasobów usługi AKS automatycznie tworzy drugą grupę zasobów o nazwie grupa zasobów węzła. Ta grupa zasobów zawiera wszystkie zasoby infrastruktury skojarzone z klastrem, w tym maszyny wirtualne, zestawy skalowania maszyn wirtualnych i magazyn.

Aby uzyskać więcej informacji, zobacz następujące zasoby:

- Dlaczego dwie grupy zasobów są tworzone za pomocą usługi AKS?

- Czy mogę podać własną nazwę dla grupy zasobów węzła usługi AKS?

- Czy mogę modyfikować tagi i inne właściwości zasobów w grupie zasobów węzła usługi AKS?

Przestrzenie nazw

Zasoby platformy Kubernetes, takie jak zasobniki i wdrożenia, są logicznie grupowane w przestrzenie nazw, aby podzielić klaster usługi AKS i utworzyć, wyświetlić lub zarządzać dostępem do zasobów.

Następujące przestrzenie nazw są domyślnie tworzone w klastrze usługi AKS:

| Przestrzeń nazw | opis |

|---|---|

| default | Domyślna przestrzeń nazw umożliwia rozpoczęcie korzystania z zasobów klastra bez tworzenia nowej przestrzeni nazw. |

| kube-node-lease | Przestrzeń nazw kube-node-lease umożliwia węzłom komunikowanie się ich dostępności z płaszczyzną sterowania. |

| kube-public | Publiczna przestrzeń nazw kube-public nie jest zwykle używana, ale może służyć do tego, aby zasoby były widoczne w całym klastrze przez dowolnego użytkownika. |

| kube-system | Przestrzeń nazw kube-system jest używana przez platformę Kubernetes do zarządzania zasobami klastra, takimi jak coredns, konnectivity-agenti metrics-server. |

Tryby klastra

W usłudze AKS można utworzyć klaster z trybem automatycznym (wersja zapoznawcza) lub standardowym . Usługa AKS Automatic zapewnia bardziej w pełni zarządzane środowisko zarządzania konfiguracją klastra, w tym węzły, skalowanie, zabezpieczenia i inne wstępnie skonfigurowane ustawienia. Usługa AKS Standard zapewnia większą kontrolę nad konfiguracją klastra, w tym możliwość zarządzania pulami węzłów, skalowaniem i innymi ustawieniami.

Aby uzyskać więcej informacji, zobacz Porównanie funkcji automatycznych i standardowych usługi AKS.

Warstwy cenowe

Usługa AKS oferuje trzy warstwy cenowe do zarządzania klastrami: Bezpłatna, Standardowa i Premium. Wybrana warstwa cenowa określa funkcje dostępne do zarządzania klastrem.

Aby uzyskać więcej informacji, zobacz Warstwy cenowe do zarządzania klastrem usługi AKS.

Obsługiwane wersje platformy Kubernetes

Aby uzyskać więcej informacji, zobacz Obsługiwane wersje platformy Kubernetes w usłudze AKS.

Następne kroki

Aby uzyskać więcej podstawowych pojęć dotyczących usługi AKS, zobacz następujące zasoby:

Azure Kubernetes Service

Opinia

Dostępne już wkrótce: W 2024 r. będziemy stopniowo wycofywać zgłoszenia z serwisu GitHub jako mechanizm przesyłania opinii na temat zawartości i zastępować go nowym systemem opinii. Aby uzyskać więcej informacji, sprawdź: https://aka.ms/ContentUserFeedback.

Prześlij i wyświetl opinię dla