Nuta

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować zalogować się lub zmienić katalogi.

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować zmienić katalogi.

DOTYCZY: Wszystkich poziomów zarządzania API

Punkty końcowe modeli AI wdrożone w Microsoft Foundry można zaimportować do instancji usługi API Management jako interfejsy API. Użyj zasad bramy sztucznej inteligencji i innych funkcji w usłudze API Management, aby uprościć integrację, zwiększyć czytelność i zwiększyć kontrolę nad punktami końcowymi modelu.

Dowiedz się więcej o zarządzaniu interfejsami API sztucznej inteligencji w usłudze API Management:

Opcje zgodności klienta

Usługa API Management obsługuje dwie opcje zgodności klienta dla interfejsów API sztucznej inteligencji firmy Microsoft Foundry. Podczas importowania interfejsu API przy użyciu kreatora wybierz opcję odpowiednią dla wdrożenia modelu. Opcja określa, jak klienci wywołują interfejs API i jak wystąpienie usługi API Management kieruje żądania do usług związanych ze sztuczną inteligencją.

Azure OpenAI — zarządzanie usługą Azure OpenAI we wdrożeniach modeli rozwiązania Microsoft Foundry.

Klienci nazywają wdrożenie w punkcie końcowym,

/openaitakim jak/openai/deployments/my-deployment/chat/completions. Nazwa wdrożenia jest przekazywana w ścieżce żądania. Użyj tej opcji, jeśli usługa sztucznej inteligencji obejmuje tylko wdrożenia modelu Azure OpenAI.Azure AI — zarządzanie punktami końcowymi modelu w rozwiązaniu Microsoft Foundry udostępnianymi za pośrednictwem interfejsu API wnioskowania modelu AI platformy Azure.

Klienci odwołują się do wdrożenia w punkcie końcowym

/models, takim jak/my-model/models/chat/completions. Nazwa wdrożenia jest przekazywana w treści żądania. Użyj tej opcji, jeśli chcesz elastycznie przełączać się między modelami udostępnianymi za pomocą interfejsu API wnioskowania modelu AI w Azure a tymi wdrożonymi w Azure OpenAI w Foundry Models.

Wymagania wstępne

Istniejąca instancja usługi API Management. Utwórz go, jeśli jeszcze tego nie zrobiono.

Usługa Azure AI w ramach subskrypcji z wdrożonym co najmniej jednym modelem. Przykłady obejmują modele wdrożone w rozwiązaniu Microsoft Foundry lub Azure OpenAI.

Importowanie interfejsu API usługi Microsoft Foundry przy użyciu portalu

Wykonaj poniższe kroki, aby zaimportować interfejs API AI do usługi API Management.

Podczas importowania interfejsu API usługa API Management automatycznie konfiguruje:

- Operacje dla poszczególnych punktów końcowych REST API

- Tożsamość przypisana przez system z niezbędnymi uprawnieniami dostępu do wdrożenia usługi sztucznej inteligencji.

- Zasób backend i zasadę set-backend-service, które kierują żądania interfejsu API do punktu końcowego usługi AI.

- Uwierzytelnianie w zapleczu systemowym za pomocą tożsamości zarządzanej przypisanej przez system do wystąpienia.

- (opcjonalnie) Zasady ułatwiające monitorowanie interfejsu API i zarządzanie nim.

Aby zaimportować interfejs API usługi Microsoft Foundry do usługi API Management:

Na portalu Azure przejdź do instancji zarządzania API.

W menu po lewej stronie, w obszarze APIs, wybierz APIs>+ Dodaj API.

W obszarze Utwórz z zasobu platformy Azure wybierz pozycję Microsoft Foundry.

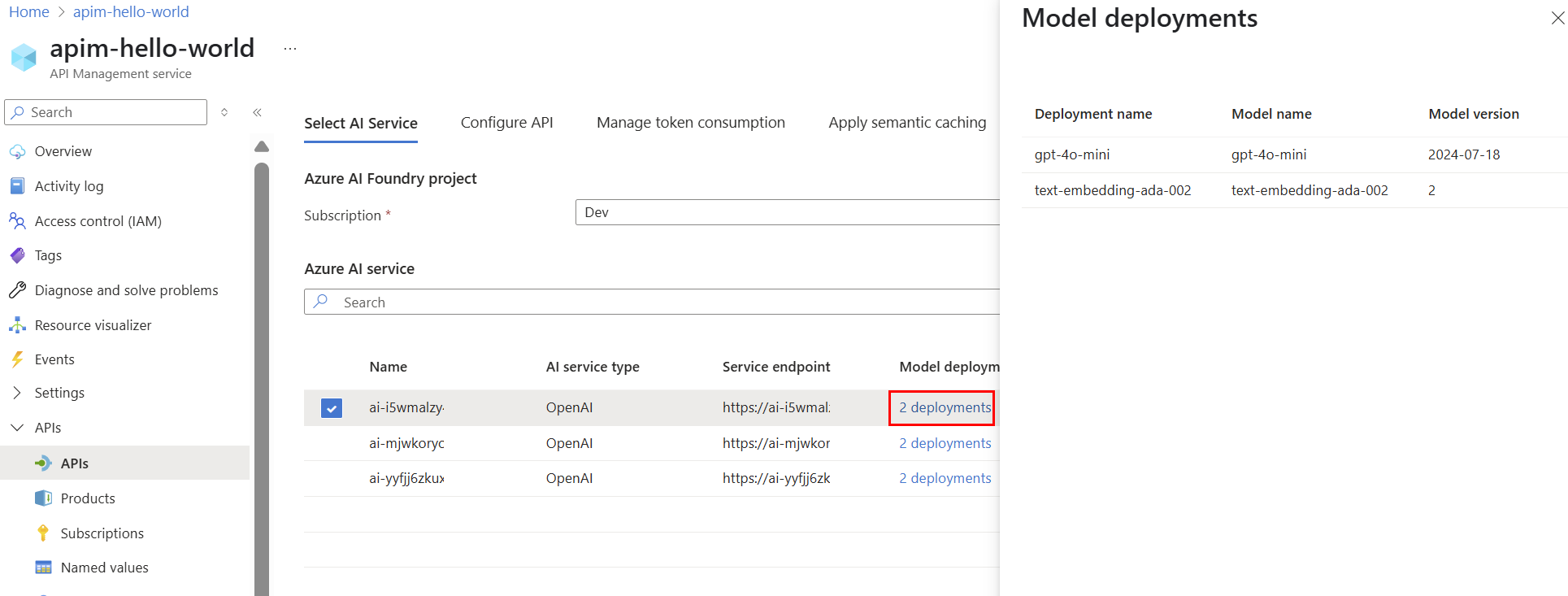

Na karcie Wybierz usługę AI :

- Wybierz subskrypcję , w której chcesz wyszukać usługi sztucznej inteligencji. Aby uzyskać informacje o wdrożeniach modelu w usłudze , wybierz link wdrożenia obok nazwy usługi.

- Wybierz usługę sztucznej inteligencji.

- Wybierz Dalej.

- Wybierz subskrypcję , w której chcesz wyszukać usługi sztucznej inteligencji. Aby uzyskać informacje o wdrożeniach modelu w usłudze , wybierz link wdrożenia obok nazwy usługi.

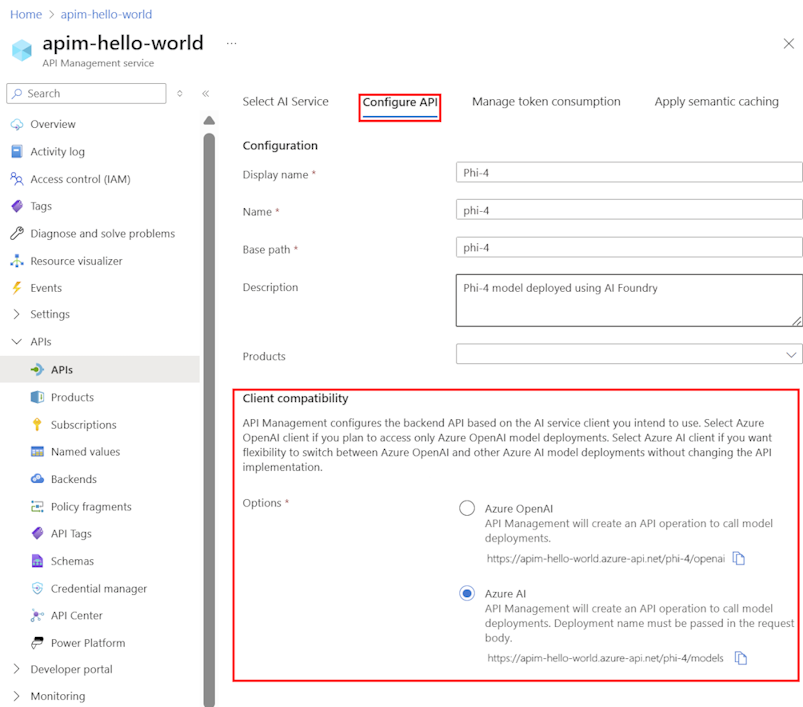

Na karcie Konfiguracja API :

Wprowadź nazwę wyświetlaną i opcjonalny opis dla API.

W ścieżce podstawowej wprowadź ścieżkę używaną przez wystąpienie usługi API Management w celu uzyskania dostępu do punktu końcowego wdrożenia.

Opcjonalnie wybierz co najmniej jeden produkt do skojarzenia z interfejsem API.

W obszarze Zgodność klienta wybierz jedną z następujących opcji na podstawie typów klientów, które mają być obsługiwane. Aby uzyskać więcej informacji, zobacz Opcje zgodności klienta .

- Azure OpenAI — wybierz tę opcję, jeśli klienci muszą uzyskiwać dostęp tylko do usługi Azure OpenAI we wdrożeniach modelu rozwiązania Microsoft Foundry.

- Azure AI — wybierz tę opcję, jeśli klienci muszą uzyskać dostęp do innych modeli w firmie Microsoft Foundry.

Wybierz Dalej.

Na karcie Zarządzanie użyciem tokenu opcjonalnie wprowadź ustawienia lub zaakceptuj wartości domyślne, które definiują następujące zasady, aby ułatwić monitorowanie interfejsu API i zarządzanie nim:

Na karcie Zastosuj buforowanie semantyczne opcjonalnie wprowadź ustawienia lub zaakceptuj ustawienia domyślne, które definiują zasady, aby pomóc zoptymalizować wydajność i zmniejszyć opóźnienie dla interfejsu API:

W Bezpieczeństwo Zawartości AI możesz wprowadzić ustawienia lub zaakceptować wartości domyślne, aby skonfigurować usługę Azure AI Content Safety do blokowania treści z niebezpieczną zawartością.

Wybierz opcję Przejrzyj.

Po zweryfikowaniu ustawień wybierz pozycję Utwórz.

Testuj API sztucznej inteligencji

Aby upewnić się, że interfejs API sztucznej inteligencji działa zgodnie z oczekiwaniami, przetestuj go w konsoli testowej usługi API Management.

Wybierz interfejs API utworzony w poprzednim kroku.

Wybierz kartę Test.

Wybierz operację zgodną z wdrożeniem modelu. Na stronie są wyświetlane pola parametrów i nagłówków.

Wprowadź parametry i nagłówki zgodnie z potrzebami. W zależności od operacji może być konieczne skonfigurowanie lub zaktualizowanie treści żądania.

Uwaga / Notatka

W konsoli testowej usługa API Management automatycznie wypełnia nagłówek Ocp-Apim-Subscription-Key i konfiguruje klucz subskrypcji dla wbudowanej subskrypcji o pełnym dostępie. Ten klucz umożliwia dostęp do wszystkich interfejsów API w instancji zarządzania API. Opcjonalnie wyświetl nagłówek Ocp-Apim-Subscription-Key, wybierając ikonę "oko" znajdującą się obok żądania HTTP.

Wybierz Wyślij.

Po pomyślnym zakończeniu testu zaplecze odpowiada z pomyślnym kodem odpowiedzi HTTP i pewnymi danymi. Dołączane do odpowiedzi to dane użycia tokenu, które ułatwiają monitorowanie użycia tokenów modelu językowego i zarządzanie nim.

Treści powiązane

- Ograniczenia importu interfejsu API

- Importowanie specyfikacji interfejsu OpenAPI

- Importuj API SOAP

- Importowanie interfejsu API protokołu SOAP i przekształcenie go na interfejs API REST

- Importowanie API usługi aplikacji

- Importowanie interfejsu API aplikacji kontenera

- Importuj WebSocket API

- Zaimportuj GraphQL API

- Importowanie schematu GraphQL i konfigurowanie rozpoznawania pól

- Zaimportuj API aplikacji funkcji

- Importowanie interfejsu API aplikacji logicznej

- Importowanie usługi Service Fabric

- Importowanie interfejsu API usługi Azure AI Foundry

- Importowanie interfejsu API usługi Azure OpenAI

- Importowanie interfejsu API LLM

- Importowanie interfejsu API OData

- Eksportowanie interfejsu API REST jako serwera MCP

- Uwidacznia istniejący serwer MCP

- Importowanie interfejsu API agenta A2A

- Importowanie metadanych sap OData

- Zaimportuj API gRPC

- Edytowanie interfejsu API