Co to są polecenia niestandardowe?

Ważne

Polecenia niestandardowe zostaną wycofane 30 kwietnia 2026 r. Od 30 października 2023 r. nie można tworzyć nowych aplikacji poleceń niestandardowych w programie Speech Studio. W związku z tą zmianą usługa LUIS zostanie wycofana 1 października 2025 r. Od 1 kwietnia 2023 r. nie można tworzyć nowych zasobów usługi LUIS.

Aplikacje, takie jak asystentzy głosowi , słuchają użytkowników i podejmują działania w odpowiedzi, często przemawiając z powrotem. Używają mowy do tłumaczenia tekstu w celu transkrypcji mowy użytkownika, a następnie podejmują działania na temat języka naturalnego zrozumienia tekstu. Ta akcja często zawiera mówione dane wyjściowe z asystenta wygenerowanego za pomocą tekstu na mowę. Urządzenia łączą się z asystentami za pomocą obiektu zestawu SPEECH SDK DialogServiceConnector .

Polecenia niestandardowe ułatwiają tworzenie rozbudowanych aplikacji poleceń głosowych zoptymalizowanych pod kątem środowisk interakcji z pierwszym głosem. Zapewnia ujednolicone środowisko tworzenia, automatyczny model hostingu i stosunkowo niższą złożoność. Polecenia niestandardowe ułatwiają skoncentrowanie się na tworzeniu najlepszego rozwiązania dla scenariuszy poleceń głosowych.

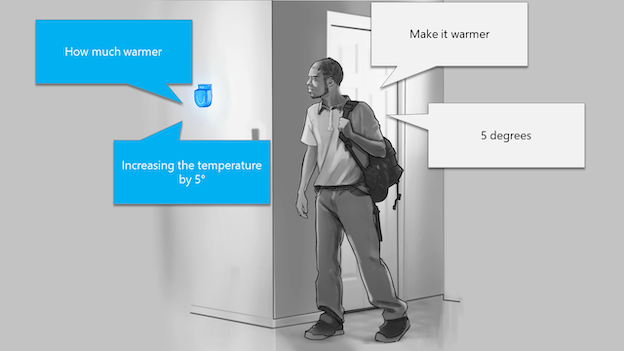

Polecenia niestandardowe najlepiej nadają się do wykonywania zadań lub scenariuszy sterowania poleceniami, takich jak "Włącz światło narzutowe" lub "Rozgrzej go o 5 stopni". Polecenia niestandardowe są odpowiednie dla urządzeń Internetu rzeczy (IoT), urządzeń otoczenia i bezgłównych. Przykłady obejmują rozwiązania dla branży hotelarskiej, detalicznej i motoryzacyjnej, w których chcesz sterować głosem środowiska dla gości, zarządzania zapasami w sklepie lub funkcji w samochodzie.

Jeśli interesuje Cię tworzenie złożonych aplikacji konwersacyjnych, zachęcamy do wypróbowania platformy Bot Framework przy użyciu rozwiązania Asystent wirtualny. Możesz dodać głos do dowolnego bota platformy botów przy użyciu usługi Direct Line Speech.

Dobrzy kandydaci do poleceń niestandardowych mają stałe słownictwo z dobrze zdefiniowanymi zestawami zmiennych. Na przykład zadania automatyzacji domu, takie jak sterowanie termostatem, są idealne.

Wprowadzenie do poleceń niestandardowych

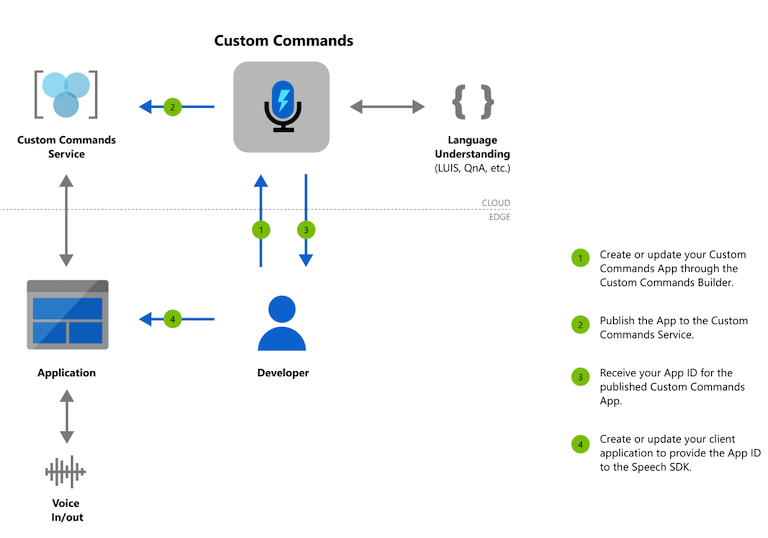

Naszym celem za pomocą poleceń niestandardowych jest zmniejszenie obciążenia poznawczego, aby poznać wszystkie różne technologie i skupić się na tworzeniu aplikacji poleceń głosowych. Pierwszym krokiem użycia poleceń niestandardowych do utworzenia zasobu usługi Mowa. Możesz utworzyć aplikację Polecenia niestandardowe w programie Speech Studio i opublikować ją, po czym aplikacja na urządzeniu może komunikować się z nią przy użyciu zestawu SPEECH SDK.

Przepływ tworzenia dla poleceń niestandardowych

Postępuj zgodnie z naszym przewodnikiem Szybki start, aby w mniej niż 10 minutach uruchomić swoją pierwszą aplikację poleceń niestandardowych.

Po zakończeniu pracy z przewodnikiem Szybki start zapoznaj się z naszymi przewodnikami z instrukcjami, aby uzyskać szczegółowe instrukcje dotyczące projektowania, opracowywania, debugowania, wdrażania i integrowania aplikacji poleceń niestandardowych.