Ręczne ocenianie monitów w środowisku zabaw usługi Azure AI Studio

Ważne

Niektóre funkcje opisane w tym artykule mogą być dostępne tylko w wersji zapoznawczej. Ta wersja zapoznawcza jest udostępniana bez umowy dotyczącej poziomu usług i nie zalecamy korzystania z niej w przypadku obciążeń produkcyjnych. Niektóre funkcje mogą być nieobsługiwane lub ograniczone. Aby uzyskać więcej informacji, zobacz Uzupełniające warunki korzystania z wersji zapoznawczych platformy Microsoft Azure.

Po rozpoczęciu pracy z inżynierią monitu należy przetestować różne dane wejściowe pojedynczo, aby ocenić skuteczność monitu może być bardzo czasochłonna. Jest to spowodowane tym, że ważne jest sprawdzenie, czy filtry zawartości działają odpowiednio, czy odpowiedź jest dokładna i nie tylko.

Aby ten proces był prostszy, możesz użyć oceny ręcznej w usłudze Azure AI Studio, narzędzia do oceny umożliwiającego ciągłą iterację i ocenę monitu względem danych testowych w jednym interfejsie. Możesz również ręcznie ocenić dane wyjściowe, odpowiedzi modelu, aby ułatwić uzyskanie zaufania do monitu.

Ocena ręczna może pomóc ci zrozumieć, jak dobrze działa monit i iterować po wyświetleniu monitu, aby upewnić się, że osiągniesz żądany poziom ufności.

Z tego artykułu dowiesz się, jak wykonywać następujące elementy:

- Generowanie wyników oceny ręcznej

- Ocenianie odpowiedzi modelu

- Iterowanie po wyświetleniu monitu i ponownej oceny

- Zapisywanie i porównywanie wyników

- Ocena za pomocą wbudowanych metryk

Wymagania wstępne

Aby wygenerować wyniki oceny ręcznej, należy przygotować następujące elementy:

Testowy zestaw danych w jednym z następujących formatów: csv lub jsonl. Jeśli nie masz dostępnego zestawu danych, umożliwiamy również ręczne wprowadzanie danych z interfejsu użytkownika.

Wdrożenie jednego z następujących modeli: modele GPT 3.5, modele GPT 4 lub Modele Davinci. Aby dowiedzieć się więcej na temat tworzenia wdrożenia, zobacz Wdrażanie modeli.

Uwaga

Ocena ręczna jest obecnie obsługiwana tylko w przypadku modeli usługi Azure OpenAI dla typów zadań czatu i ukończenia.

Generowanie wyników oceny ręcznej

W obszarze Plac zabaw wybierz pozycję Ocena ręczna , aby rozpocząć proces ręcznego przeglądania odpowiedzi modelu na podstawie danych testowych i monitowania. Monit zostanie automatycznie przeniesiony do oceny ręcznej, a teraz wystarczy dodać dane testowe, aby ocenić monit.

Można to zrobić ręcznie przy użyciu pól tekstowych w kolumnie Dane wejściowe .

Możesz również zaimportować dane , aby wybrać jeden z poprzednich istniejących zestawów danych w projekcie lub przekazać zestaw danych, który jest w formacie CSV lub JSONL. Po załadowaniu danych zostanie wyświetlony monit o odpowiednie mapowanie kolumn. Po zakończeniu i wybraniu pozycji Importuj dane są wypełniane odpowiednio w poniższych kolumnach.

Uwaga

Do oceny ręcznej można dodać aż 50 wierszy wejściowych. Jeśli dane testowe mają więcej niż 50 wierszy wejściowych, przekażemy pierwsze 50 w kolumnie wejściowej.

Po dodaniu danych możesz uruchomić polecenie , aby wypełnić kolumnę danych wyjściowych odpowiedzią modelu.

Ocenianie odpowiedzi modelu

Możesz podać kciuk w górę lub w dół do każdej odpowiedzi w celu oceny danych wyjściowych monitu. Na podstawie podanych ocen można wyświetlić te wyniki odpowiedzi w podsumowaniach na pierwszy rzut oka.

Iterowanie po wyświetleniu monitu i ponownej oceny

Na podstawie podsumowania możesz wprowadzić zmiany w wierszu polecenia. Aby edytować konfigurację monitu, możesz użyć powyższych kontrolek monitu. Może to być aktualizacja komunikatu systemowego, zmiana modelu lub edytowanie parametrów.

Po wprowadzeniu zmian możesz ponownie uruchomić wszystkie elementy, aby zaktualizować całą tabelę lub skupić się na ponownym uruchamianiu określonych wierszy, które nie spełniały oczekiwań po raz pierwszy.

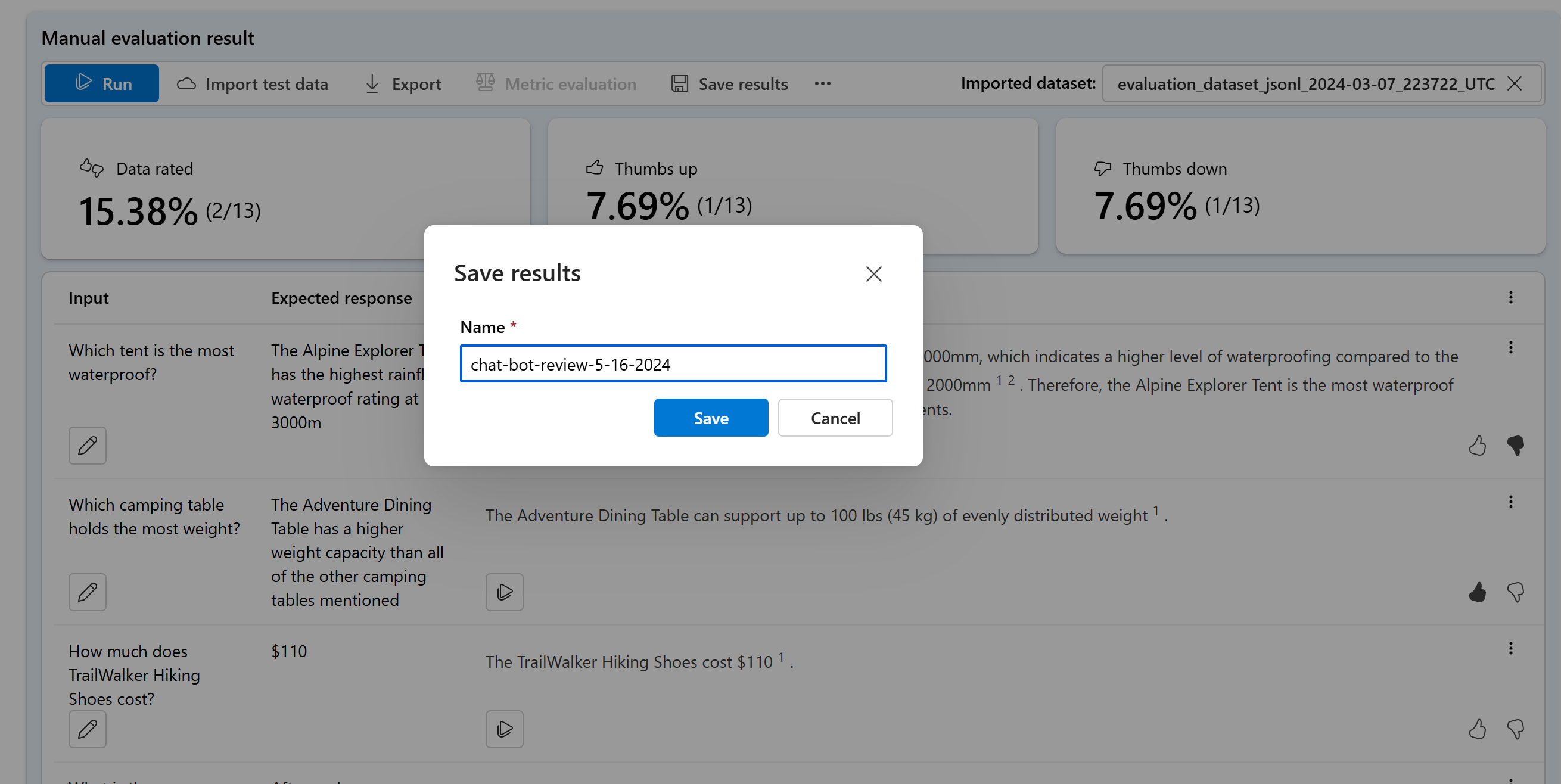

Zapisywanie i porównywanie wyników

Po wypełnieniu wyników możesz zapisać wyniki , aby udostępnić postęp zespołowi lub kontynuować ręczną ocenę z miejsca, w którym została przerwana później.

Możesz również porównać kciuki w górę i w dół w różnych ocenach ręcznych, zapisując je i wyświetlając je na karcie Ocena w obszarze Ocena ręczna.

Następne kroki

Dowiedz się więcej na temat oceniania generowanych aplikacji sztucznej inteligencji:

- Ocena generowanych aplikacji sztucznej inteligencji przy użyciu narzędzia Azure AI Studio lub zestawu SDK

- Wyświetlanie wyników oceny

Dowiedz się więcej o technikach ograniczania szkód.