Narzędzie LLM dla przepływów w usłudze Azure AI Studio

Ważne

Elementy oznaczone (wersja zapoznawcza) w tym artykule są obecnie dostępne w publicznej wersji zapoznawczej. Ta wersja zapoznawcza jest udostępniana bez umowy dotyczącej poziomu usług i nie zalecamy korzystania z niej w przypadku obciążeń produkcyjnych. Niektóre funkcje mogą być nieobsługiwane lub ograniczone. Aby uzyskać więcej informacji, zobacz Uzupełniające warunki korzystania z wersji zapoznawczych platformy Microsoft Azure.

Aby używać dużych modeli językowych (LLM) do przetwarzania języka naturalnego, należy użyć narzędzia LLM przepływu monitu.

Uwaga

Aby osadzić w celu przekonwertowania tekstu na gęste reprezentacje wektorów dla różnych zadań przetwarzania języka naturalnego, zobacz Osadzanie narzędzia.

Wymagania wstępne

Przygotuj monit zgodnie z opisem w dokumentacji narzędzia Monituj. Narzędzie LLM i narzędzie Monit obsługują szablony Jinja . Aby uzyskać więcej informacji i najlepszych rozwiązań, zobacz Monituj techniki inżynieryjne.

Kompilowanie za pomocą narzędzia LLM

Tworzenie lub otwieranie przepływu w usłudze Azure AI Studio. Aby uzyskać więcej informacji, zobacz Tworzenie przepływu.

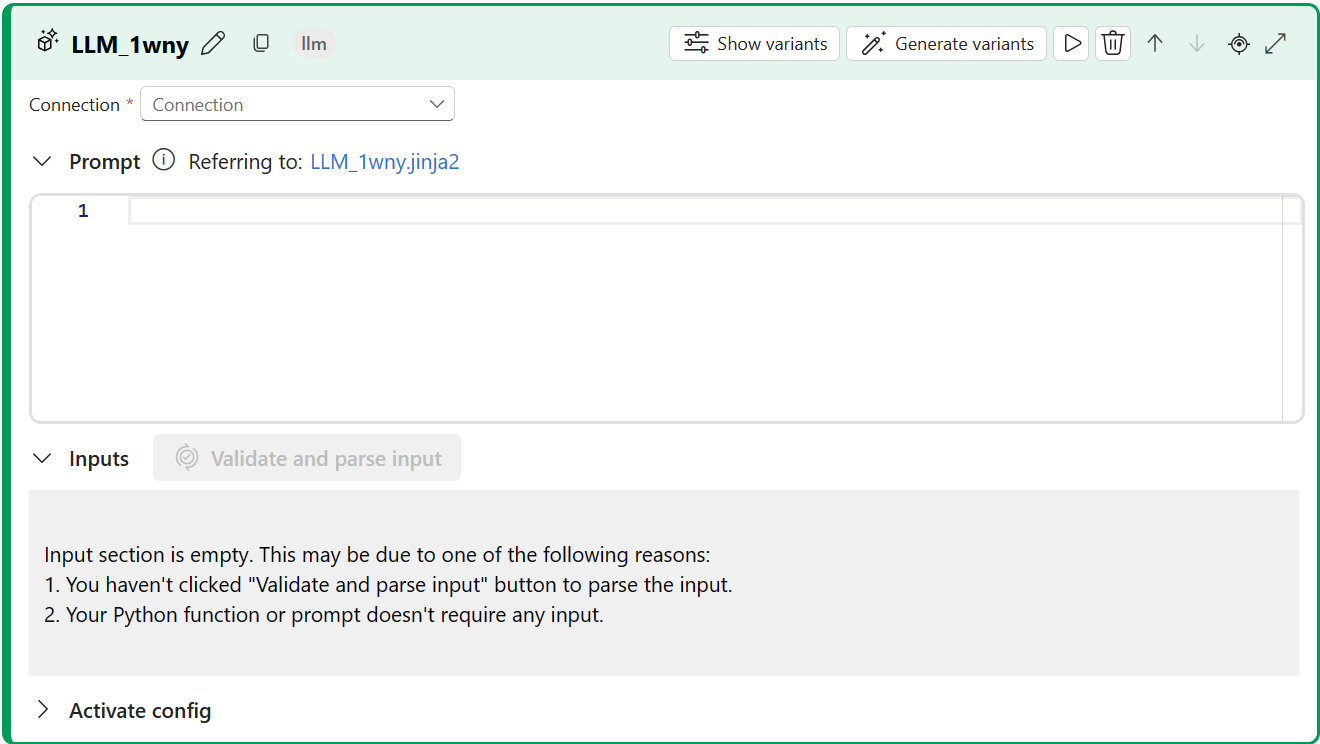

Wybierz pozycję + LLM, aby dodać narzędzie LLM do przepływu.

Wybierz połączenie z jednym z zaaprowizowanych zasobów. Na przykład wybierz pozycję Default_AzureOpenAI.

Z listy rozwijanej Interfejs API wybierz pozycję Czat lub ukończenie.

Wprowadź wartości parametrów wejściowych narzędzia LLM opisanych w tabeli Wprowadzanie tekstu. Jeśli wybrano interfejs API czatu, zobacz tabelę Dane wejściowe czatu. Jeśli wybrano interfejs API uzupełniania, zobacz tabelę Wprowadzanie tekstu. Aby uzyskać informacje na temat przygotowywania danych wejściowych monitu, zobacz Wymagania wstępne.

Dodaj więcej narzędzi do przepływu zgodnie z potrzebami. Możesz też wybrać pozycję Uruchom , aby uruchomić przepływ.

Dane wyjściowe są opisane w tabeli Dane wyjściowe.

Dane wejściowe

Dostępne są następujące parametry wejściowe.

Wprowadzanie tekstu

| Nazwisko | Pisz | Opis | Wymagania |

|---|---|---|---|

| monit | string | Monit tekstowy dla modelu językowego. | Tak |

| model, deployment_name | string | Model językowy do użycia. | Tak |

| max_tokens | integer | Maksymalna liczba tokenów do wygenerowania w zakończeniu. Wartość domyślna to 16. | Nie. |

| temperature | liczba zmiennoprzecinkowa | Losowość wygenerowanego tekstu. Wartość domyślna to 1. | Nie. |

| zatrzymać | lista | Sekwencja zatrzymywania wygenerowanego tekstu. Wartość domyślna to null. | Nie. |

| przyrostek | string | Tekst dołączony na końcu ukończenia. | Nie. |

| top_p | liczba zmiennoprzecinkowa | Prawdopodobieństwo użycia najlepszego wyboru z wygenerowanych tokenów. Wartość domyślna to 1. | Nie. |

| logprobs | integer | Liczba prawdopodobieństwa dziennika do wygenerowania. Wartość domyślna to null. | Nie. |

| echo | boolean | Wartość wskazująca, czy należy powtórzyć monit w odpowiedzi. Wartość domyślna to „fałsz”. | Nie. |

| presence_penalty | liczba zmiennoprzecinkowa | Wartość, która kontroluje zachowanie modelu w odniesieniu do powtarzających się fraz. Wartość domyślna to 0. | Nie. |

| frequency_penalty | liczba zmiennoprzecinkowa | Wartość, która kontroluje zachowanie modelu w zakresie generowania rzadkich fraz. Wartość domyślna to 0. | Nie. |

| best_of | integer | Liczba najlepszych uzupełnień do wygenerowania. Wartość domyślna to 1. | Nie. |

| logit_bias | słownik | Stronnicza stronnicza logit dla modelu językowego. Wartość domyślna to pusty słownik. | Nie. |

Dane wejściowe czatu

| Nazwisko | Pisz | Opis | Wymagania |

|---|---|---|---|

| monit | string | Monit tekstowy, na który powinien odpowiadać model językowy. | Tak |

| model, deployment_name | string | Model językowy do użycia. | Tak |

| max_tokens | integer | Maksymalna liczba tokenów do wygenerowania w odpowiedzi. Wartość domyślna to inf. | Nie. |

| temperature | liczba zmiennoprzecinkowa | Losowość wygenerowanego tekstu. Wartość domyślna to 1. | Nie. |

| zatrzymać | lista | Sekwencja zatrzymywania wygenerowanego tekstu. Wartość domyślna to null. | Nie. |

| top_p | liczba zmiennoprzecinkowa | Prawdopodobieństwo użycia najlepszego wyboru z wygenerowanych tokenów. Wartość domyślna to 1. | Nie. |

| presence_penalty | liczba zmiennoprzecinkowa | Wartość, która kontroluje zachowanie modelu w odniesieniu do powtarzających się fraz. Wartość domyślna to 0. | Nie. |

| frequency_penalty | liczba zmiennoprzecinkowa | Wartość, która kontroluje zachowanie modelu w zakresie generowania rzadkich fraz. Wartość domyślna to 0. | Nie. |

| logit_bias | słownik | Stronnicza stronnicza logit dla modelu językowego. Wartość domyślna to pusty słownik. | Nie. |

Dane wyjściowe

Dane wyjściowe różnią się w zależności od interfejsu API wybranego dla danych wejściowych.

| interfejs API | Typ zwracany | opis |

|---|---|---|

| Zakończenie | string | Tekst jednego przewidywanego ukończenia. |

| Czat | string | Tekst jednej odpowiedzi konwersacji. |