W tym artykule omówiono zagadnienia dotyczące architektury platformy Azure związane z analizą i implementacją wspólnego zestawu klasyfikacji warstw wysokiego ryzyka dotyczących mechanizmów kontroli zarządzania ryzykiem bezpieczeństwa informacji (ISRM).

Architektura

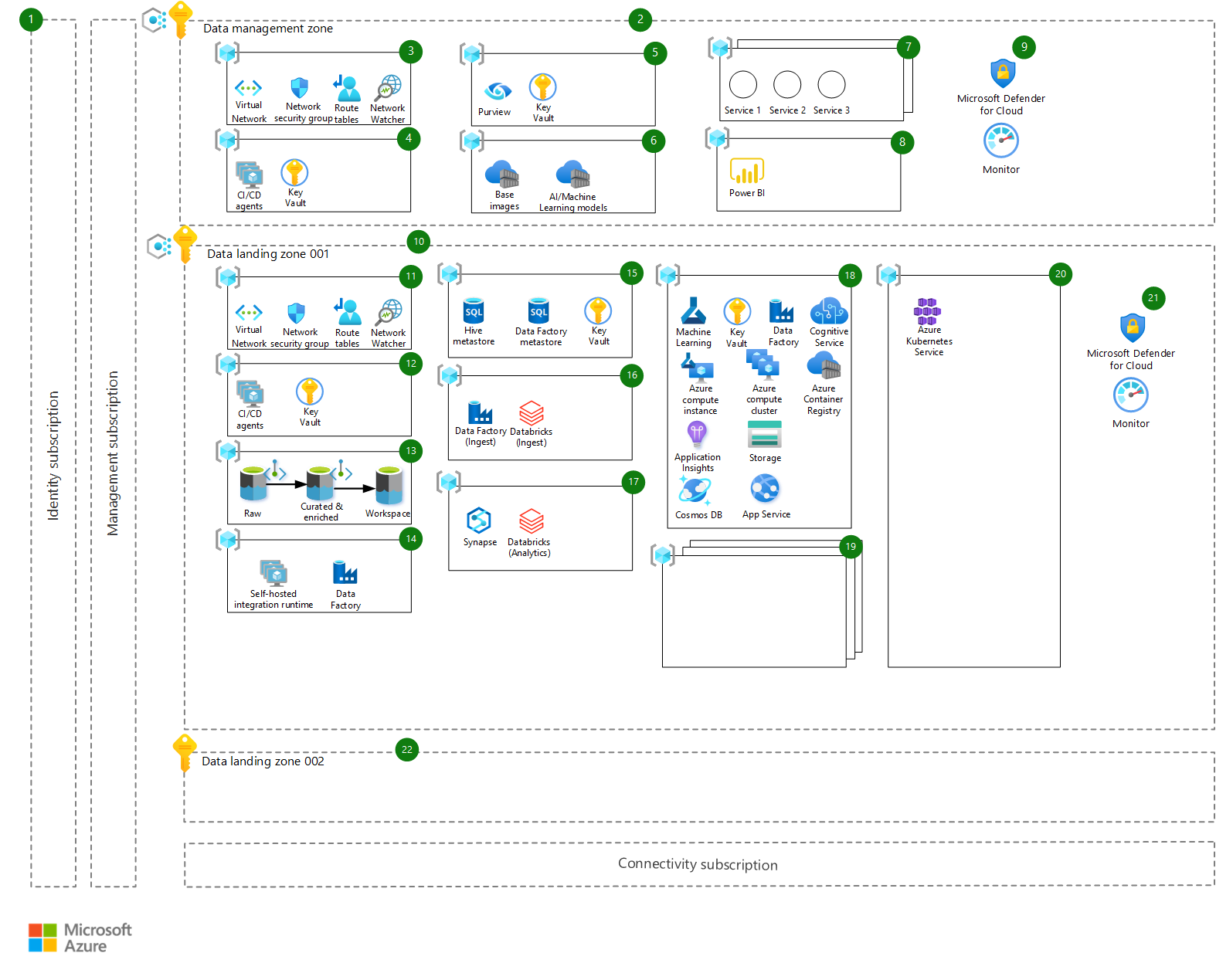

Architektura jest pokazana na tym diagramie i jest zgodna z zasadą stref docelowych w skali przedsiębiorstwa, w szczególności architektury referencyjnej analizy i sztucznej inteligencji w skali przedsiębiorstwa.

Pobierz plik programu Visio z tą architekturą.

Przepływ pracy

Architektura składa się z przepływu pracy opisanego w poniższych sekcjach. Każdy składnik architektury ma odpowiednią liczbę na diagramie. Opisujemy główny cel składnika, sposób jego dopasowania do architektury oraz inne ważne zagadnienia, które należy wziąć pod uwagę podczas wdrażania:

- Subskrypcje platformy — podstawowe subskrypcje platformy Azure, które zapewniają zarządzanie, łączność i tożsamość za pośrednictwem identyfikatora Entra firmy Microsoft. Nie przedstawiono ich bardziej szczegółowo i zakłada się, że są one gotowe i dostępne w ramach podstawowej konfiguracji w skali przedsiębiorstwa.

Zarządzanie danymi

- Strefa zarządzania danymi — strefa zarządzania danymi jest odpowiedzialna za nadzór nad danymi na całej platformie i wymusza zabezpieczenia w celu zapewnienia większej elastyczności podrzędnej w strefach docelowych danych. Ma własną subskrypcję i hosty scentralizowane usługi, takie jak katalogowanie danych, monitorowanie, inspekcje itd. To środowisko jest wysoce kontrolowane i podlega rygorystycznym inspekcjom. Wszystkie typy klasyfikacji danych są przechowywane w centralnym wykazie danych (Azure Purview). W zależności od metadanych wymuszane są różne zasady i wzorce dostępu. Dla całej dzierżawy istnieje tylko jedna subskrypcja strefy zarządzania danymi. Strefa zarządzania danymi jest równorzędna (za pośrednictwem komunikacji równorzędnej sieci wirtualnej) ze wszystkimi innymi strefami docelowymi danych. Prywatne punkty końcowe są używane zawsze, gdy jest to możliwe, aby upewnić się, że wdrożone usługi nie są dostępne za pośrednictwem publicznego Internetu.

- Grupa zasobów sieciowych — sieci wirtualne platformy Azure, sieciowe grupy zabezpieczeń i wszystkie inne zasoby związane z siecią potrzebne do strefy zarządzania danymi są aprowizowane w grupie zasobów sieciowych.

- Grupa zasobów wdrożenia — grupa zasobów wdrożenia hostuje prywatnych agentów ciągłej integracji/ciągłego wdrażania usługi Azure DevOps (maszyn wirtualnych) potrzebnych dla strefy zarządzania danymi i usługi Key Vault do przechowywania wszelkich wpisów tajnych związanych z wdrażaniem.

- Grupa zasobów ładu danych — usługa Azure Purview jest używana jako rozwiązanie do zarządzania danymi i wykazu danych i służy do wymuszania niezbędnych barier zabezpieczających dla zestawów danych w celu przestrzegania wymagań dotyczących danych i przepisów dotyczących danych, które są nakładane przez prawo lub inne podmioty. Usługa Purview jest hostowana centralnie w tej grupie zasobów wraz z wystąpieniem usługi Key Vault do przechowywania wpisów tajnych.

- Scentralizowane zasoby — scentralizowane zasoby hostują ważne i cenne zasoby, które są kluczowe dla platformy, takie jak:

- Rejestry kontenerów platformy Azure hostujące obrazy podstawowe używane w usłudze Azure Machine Edukacja produktów danych (obrazy, które zostały wcześniej zeskanowane i wolne od luk w zabezpieczeniach)

- Sztuczna inteligencja/maszyna Edukacja modele, które są publikowane i udostępniane konsumentom na platformie (dzięki czemu można je wdrożyć w co najmniej jednej strefie docelowej danych w razie potrzeby).

- Dodatkowe usługi — wszystkie inne usługi , które powinny być scentralizowane, mogą być hostowane w jednej z tych grup zasobów, które mogą obejmować scentralizowane wystąpienia usługi Azure API Management, oprogramowanie innych firm itd.

- Grupa zasobów wizualizacji danych — ta grupa zasobów hostuje rozwiązania do wizualizacji danych współużytkowane przez strefy docelowe danych. Rozwiązaniami mogą być usługi Power BI, Tableau lub inne rozwiązanie do wizualizacji.

- Dodatkowe mechanizmy kontroli infrastruktury i ładu — Microsoft Defender dla Chmury i Azure Monitor są używane jako podstawowe rozwiązania do zabezpieczeń i monitorowania.

Strefy docelowe danych

Strefa docelowa danych 001 — strefa docelowa danych to subskrypcja reprezentująca jednostkę skalowania na platformie danych. Strefy docelowe danych są wdrażane na podstawie architektury podstawowej strefy docelowej danych (strategii), w tym wszystkich kluczowych możliwości hostowania platformy analizy i sztucznej inteligencji. W środowisku może znajdować się jedna lub wiele stref docelowych danych. Usługa Azure Policy jest stosowana w celu zapewnienia bezpieczeństwa dostępu i konfiguracji różnych usług platformy Azure. Strefa docelowa danych jest równorzędna (za pośrednictwem komunikacji równorzędnej sieci wirtualnej) ze wszystkimi innymi strefami docelowymi danych i strefą zarządzania danymi. Prywatne punkty końcowe są używane zawsze, gdy jest to możliwe, aby upewnić się, że wdrożone usługi nie są dostępne za pośrednictwem publicznego Internetu.

Grupa zasobów sieciowych — sieci wirtualne platformy Azure, sieciowe grupy zabezpieczeń i wszystkie inne zasoby związane z siecią wymagane dla strefy docelowej danych są aprowizowane w tej grupie zasobów.

Grupa zasobów wdrożenia — grupa zasobów wdrożenia hostuje prywatnych agentów ciągłej integracji/ciągłego wdrażania usługi Azure DevOps (maszyn wirtualnych) wymaganych dla strefy docelowej danych i usługi Key Vault do przechowywania wszelkich wpisów tajnych związanych z wdrażaniem.

Grupa zasobów magazynu danych — grupa zasobów magazynu danych zawiera główne konta magazynu danych dla tej strefy docelowej danych wdrożone jako usługa Azure Data Lake Storage Gen2 z hierarchiczną przestrzenią nazw. Są one rozłożone na trzy główne obszary:

- Nieprzetworzone — dane są pozyskiwane ze źródła danych w jego pierwotnym stanie

- Wyselekcjonowane i wzbogacone — dane są czyszczone, weryfikowane i agregowane

- Obszar roboczy — określone produkty danych mogą przechowywać swoje zestawy danych lub dane wyjściowe modeli Edukacja maszyny itd.

Strzałki na diagramach pokazują oczekiwany przepływ danych, od nieprzetworzonych danych do wyselekcjonowanych i wzbogaconych (zaufanych) danych oraz do obszaru roboczego na potrzeby eksploracji, analizy i udostępniania dodatkowej wartości z produktu danych.

Grupa zasobów integracji danych — grupa zasobów integracji danych hostuje usługę Azure Data Factory, która współużytkuje łączność z lokalnym własnym środowiskiem Integration Runtime (SHIR). Jej głównym celem jest nawiązanie łączności. Inne wystąpienia usługi Data Factory ponownie są używane, aby łączność była utrzymywana tylko w jednym miejscu. Innym celem jest hostowanie własnego środowiska Integration Runtime dla usługi Azure Purview w celu uzyskania dostępu do źródeł danych w tej strefie docelowej danych na potrzeby skanowania.

Grupa zasobów zarządzania metadanymi — grupa zasobów zarządzania metadanymi hostuje metadane dla usługi Azure Databricks (magazynu metadanych Hive) i potoków pozyskiwania i przetwarzania usługi Azure Data Factory. Hostuje również usługę Key Vault do przechowywania wpisów tajnych na potrzeby uzyskiwania dostępu do tych danych. Usługa Azure SQL Database służy do hostowania metadanych.

Grupa zasobów pozyskiwania danych — grupa zasobów pozyskiwania danych hostuje wystąpienie usługi Azure Data Factory, w którym są wdrażane wszystkie potoki pozyskiwania danych specyficzne dla domeny danych. Usługa Azure Databricks jest używana jako aparat przetwarzania do ładowania i przekształcania danych oraz przechowywania ich na kontach usługi Data Lake.

Grupa zasobów analizy — grupa zasobów analizy obejmuje dwie usługi udostępnione na potrzeby dalszej analizy i eksploracji danych: Azure Synapse i Azure Databricks. Obie te usługi zapewniają rozbudowane zasoby obliczeniowe i skalowanie na potrzeby masowej eksploracji i analizy danych.

Grupa zasobów produktu danych — grupa zasobów produktu danych jest strategią produktu danych z grupą zasobów zawierającą podstawowe zasoby platformy Azure, których może potrzebować produkt danych. Wdrożenie powinno być konfigurowalne za pośrednictwem potoku usługi Azure DevOps na podstawie konkretnych potrzeb firmy. Podstawowe usługi platformy Azure wdrożone w tym miejscu są następujące:

- Obszar roboczy usługi Azure Machine Edukacja jako podstawa dla dowolnego projektu uczenia maszynowego w przedsiębiorstwie z powiązanymi usługami, takimi jak Key Vault (do przechowywania wpisów tajnych)

- Szczegółowe informacje aplikacji (na potrzeby monitorowania modelu)

- Azure Storage (do przechowywania zestawów danych)

- Usługa Azure Container Registry do przechowywania obrazów modeli podczas programowania

Usługi Cognitive Services są wdrażane jako pakiet zapewniający dostęp interfejsu API do wielu usług opartych na sztucznej inteligencji, a usługa Azure Machine Edukacja wystąpienia obliczeniowego i klastry obliczeniowe są używane do celów tworzenia, tworzenia modeli i testowania. Usługa Azure Data Factory służy do organizowania wsadowego oceniania modeli w razie potrzeby. aplikacja systemu Azure Service i Azure Cosmos DB zapewniają dodatkową warstwę wdrożenia produktu danych, w której można hostować niestandardową aplikację lub interfejs API z własnym wewnętrznym magazynem danych.

Branże regulowane zwykle mają ścisłe ograniczenia dostępu do danych i zwykle zezwalają na hostowane dane produkcyjne tylko w środowisku produkcyjnym. Z tego powodu cykl projektowania produktów danych występuje tylko w strefie docelowej danych produkcyjnych, a oddzielne środowisko lub grupa zasobów są aprowidowane na potrzeby programowania, testowania i wdrażania.

Dodatkowe produkty danych — te grupy zasobów hostuje inne produkty danych, ponieważ jedna strefa docelowa danych może hostować jeden lub wiele produktów danych.

Współużytkowana grupa zasobów obliczeniowych — wszystkie współużytkowane zasoby obliczeniowe wymagane do hostowania i wdrażania produktów danych są aprowizowane w ramach tej grupy zasobów. Przykładem jest klaster usługi Azure Kubernetes Service.

Dodatkowe mechanizmy kontroli infrastruktury i ład — Microsoft Defender dla Chmury i Azure Monitor są używane jako podstawowe rozwiązania do zabezpieczeń i monitorowania.

Strefa docelowa danych 002 — ta strefa docelowa jest symbolem zastępczym dodatkowych subskrypcji platformy Azure, które będą używane do hostowania nowych stref docelowych danych. Są one oparte na kryteriach wymienionych wcześniej, takich jak wymagania dotyczące rezydencji danych lub innej jednostki biznesowej, która ma własny zespół funkcjonalny i zestaw przypadków użycia do dostarczenia.

Składniki

- Tożsamość Microsoft Entra

- Azure Purview

- Azure Virtual Network

- Azure DevOps

- Azure Container Registry

- Azure Machine Learning

- Microsoft Defender dla Chmury

- Azure Monitor

- Azure Policy

- Azure Data Lake Storage

- Azure Data Factory

- Azure SQL Database

- Azure Databricks

- Azure Synapse Analytics

- Azure Kubernetes Service

Alternatywy

W organizacjach rozproszonych grupy biznesowe działają niezależnie i mają wysoki stopień autonomii. W związku z tym mogą rozważyć alternatywny projekt rozwiązania z pełną izolacją przypadków użycia w strefach docelowych platformy Azure, udostępniając minimalny zestaw typowych usług. Mimo że ten projekt umożliwia szybki start, wymaga wysokiego nakładu pracy ze strony organizacji IT i ISRM, ponieważ projektowanie poszczególnych przypadków użycia może szybko odbiegać od projektów strategii. Ponadto wymaga to niezależnych procesów isRM i inspekcji dla każdego z produktów sztucznej inteligencji i maszyny Edukacja hostowanych na platformie Azure.

Szczegóły scenariusza

Skalowanie inicjatyw sztucznej inteligencji i uczenia maszynowego w regulowanych środowiskach stanowi znaczące wyzwania dla organizacji, bez względu na ich dojrzałość cyfrową i rozmiar. W tym artykule omówiono kluczowe decyzje dotyczące architektury, które należy wziąć pod uwagę podczas wdrażania usług inżynierii danych i uczenia maszynowego platformy Azure w branżach regulowanych. Decyzje te opierają się na tym, czego dowiedzieliśmy się z niedawnego wdrożenia w globalnej firmie nauk o życiu i opiece zdrowotnej z listy Fortune 500.

Architektura przedstawiona w tym artykule jest zgodna z projektem architektury referencyjnej analizy i sztucznej inteligencji w skali przedsiębiorstwa i była jedną z pierwszych implementacji.

Jeśli skonfigurujesz projekty nauki o danych i opracujesz modele uczenia maszynowego w środowiskach nauk o życiu i opiece zdrowotnej, w prawie wszystkich przypadkach będziesz potrzebować dostępu do źródeł danych o dużym wpływie na działalność biznesową (HBI). Na przykład te źródła mogą być informacjami protokołu badania klinicznego bez danych pacjentów, formuł chemicznych cząsteczki lub tajemnic procesów produkcyjnych.

W branżach regulowanych systemy IT są klasyfikowane na podstawie klasyfikacji źródeł danych, do których te systemy uzyskują dostęp. Sztuczna inteligencja i środowiska uczenia maszynowego działające na platformie Azure są klasyfikowane jako HBI i muszą być zgodne z szerokim zestawem zasad i mechanizmów kontroli isRM.

Zasady projektowania

Ta architektura jest oparta na następujących zasadach:

- Skala przedsiębiorstwa to podejście architektoniczne i implementacja referencyjna zgodna z planem działania platformy Azure i częścią przewodnika Microsoft Cloud Adoption Framework (CAF). Umożliwia efektywne konstruowanie i operacjonalizacja stref docelowych na platformie Azure na dużą skalę. Nazwa strefy docelowej jest używana jako granica, w której nowe lub zmigrowane aplikacje lądują na platformie Azure. W tym scenariuszu odnosi się również do części platformy danych, które są używane do hostowania danych oraz modeli AI i Machine Edukacja.

- Tradycyjne architektury platform danych monolitycznych mają nieodłączne ograniczenie, które spowalnia dostarczanie funkcji i wartości. Opisana tutaj architektura umożliwia organizacjom skalowanie ich majątku danych i rozwiązywanie problemów ze scentralizowanym monolitycznym magazynem typu data lake przy użyciu zdecentralizowanego podejścia z separacją własności (siatka danych). Takie podejście umożliwia organizacjom skalowanie do tysięcy potoków pozyskiwania i produktów danych, przy jednoczesnym zachowaniu bezpieczeństwa i konserwacji platformy danych przez oddzielenie podstawowej platformy danych i usług zarządzania danymi (wdrożonych w oddzielnej strefie docelowej nazywanej strefą zarządzania danymi) z domen danych i produktów danych (wdrożonych w co najmniej jednej strefie docelowej danych).

- Subskrypcje są używane jako jednostki zarządzania i skalowania dostosowane do potrzeb i priorytetów biznesowych. Skalowanie jest osiągane przez udostępnienie nowych subskrypcji (stref docelowych danych) jednostkom biznesowym na podstawie kryteriów, takich jak różne osoby biorące udział w projekcie biznesowym, różne cele biznesowe i wymagania dotyczące rezydencji danych (gdzie dane muszą być hostowane w określonym regionie geograficznym).

- Usługa Azure Policy służy do zapewniania barier zabezpieczających i zapewniania ciągłej zgodności w firmowym krajobrazie IT.

- Pojedyncza płaszczyzna kontroli i zarządzania (za pośrednictwem witryny Azure Portal) zapewnia spójne środowisko we wszystkich zasobach platformy Azure i kanałach aprowizacji podlegających kontroli dostępu opartej na rolach i sterowanych zasadami. Usługi i możliwości platformy Natywne dla platformy Azure są używane zawsze, gdy jest to możliwe.

- Zespoły współzadacjonalne biorą na własność projekt, programowanie i operacje, aby skrócić czas obrotu i elastyczność w obrębie platformy. Podstawowe zasady, takie jak DevOps, Infrastruktura jako kod (IaC) i odporne projekty, służą do unikania błędów ludzkich i pojedynczych punktów awarii.

- Eksperci ds. domen i źródeł danych mogą używać domen danych do ściągania zasobów danych z platformy Azure, środowisk zewnętrznych lub lokalnych. Domena danych jest grupą zasobów w strefie docelowej danych, która może być używana przez zespoły wielofunkcyjne do pozyskiwania danych niestandardowych. W strefie docelowej danych może znajdować się jedna lub wiele domen danych. Domeny danych można wyświetlać podobnie do domen w projekcie opartym na domenach, gdzie zapewniają granicę kontekstu i są wystarczające i odizolowane. Przykładem domeny danych są dane badań klinicznych lub dane łańcucha dostaw.

Potencjalne przypadki użycia

Zagadnienia dotyczące architektury omówione w tym artykule mają swoje źródło w branży nauk życiowych i opieki zdrowotnej. Są one jednak również istotne dla organizacji w innych branżach regulowanych, w tym w następujących branżach:

- Usługi finansowe

- Świadczeniodawców

- Przemysł naftowy

Implementacja architektury referencyjnej analizy i sztucznej inteligencji w skali przedsiębiorstwa w środowiskach regulowanych jest zgodna z podobnymi wzorcami projektowymi.

Kwestie wymagające rozważenia

Te zagadnienia implementują filary struktury Azure Well-Architected Framework, która jest zestawem wytycznych, które mogą służyć do poprawy jakości obciążenia. Aby uzyskać więcej informacji, zobacz Microsoft Azure Well-Architected Framework.

W tej sekcji omówimy wnioski wyciągnięte z implementacji architektury opisanej wcześniej w nauce o życiu i środowisku regulowanym przez opiekę zdrowotną. Omówimy również zagadnienia dotyczące projektowania wysokiego poziomu w celu spełnienia typowych mechanizmów kontroli i zasad usługi ISRM.

Zabezpieczenia

Zabezpieczenia zapewniają ochronę przed celowymi atakami i nadużyciami cennych danych i systemów. Aby uzyskać więcej informacji, zobacz Omówienie filaru zabezpieczeń.

Środowiska

W środowiskach regulowanych systemy IT sklasyfikowane jako HBI muszą mieć wiele segregowanych środowisk, takich jak programowanie, jakość i produkcja lub podobne. Dostęp do chronionych źródeł danych jest autoryzowany tylko w środowiskach certyfikowanych w środowisku produkcyjnym.

Ponieważ tworzenie sztucznej inteligencji i uczenia maszynowego wymaga dostępu do poufnych zestawów danych, różne etapy procesu operacji uczenia maszynowego, takie jak kompilowanie modelu, trenowanie i wnioskowanie (lub podobne), wszystkie mają miejsce w środowisku produkcyjnym. Środowiska programistyczne i jakości są zwykle ograniczone do infrastruktury, operacji i typu inżynierii danych, aby zapewnić ciągłe ulepszenia w miarę dostępności nowych usług i funkcji platformy Azure.

Działania związane ze sztuczną inteligencją i opracowywaniem danych powinny być przeprowadzane w środowiskach produkcyjnych, z wyjątkiem piaskownicy lub wczesnej pracy eksploracyjnej.

Szyfrowanie

Systemy IT, które uzyskują dostęp, przechowują i przetwarzają poufne dane biznesowe, muszą implementować określone wymagania dotyczące zarządzania kluczami szyfrowania, takie jak fiPS 140-2 poziom 2 lub 3 zasady z integracją kluczy zarządzanych przez klienta (CMK). Chronione dane muszą być zawsze szyfrowane w spoczynku i podczas przesyłania przy użyciu protokołów TLS 1.2 lub nowszych.

Podczas projektowania architektury wymagana jest staranna analiza obsługi i integracji usług platformy Azure z infrastrukturą cmK organizacji. Wszelkie wyjątki od szyfrowania danych muszą być udokumentowane. Obsługa dostawców sprzętowego modułu zabezpieczeń (HSM) jest zawsze rozszerzana, a dodatkowe informacje można znaleźć w artykule Azure Key Vault Managed Hardware Security Module (Moduł zabezpieczeń sprzętu usługi Azure Key Vault).

Projekt sieci i ogrodzenie pierścieniowe

Środowiska sztucznej inteligencji i uczenia maszynowego muszą mieć wdrożone ogrodzenie pierścieniowe z zaimplementowaną segmentacją sieci i mechanizmami kontroli dostępu do sieci. Komunikacja sieciowa między składnikami architektury jest ograniczona do wymaganych przepływów danych i podstawowej infrastruktury do działania w podejściu dozwolonym. Należy zastosować analizę opartą na sygnaturach i analizę opartą na zachowaniu.

Wymuszanie kontroli dostępu do sieci w kilku warstwach architektury, w tym usługi Azure Firewalls, inspekcja przychodzącej i wychodzącej łączności sieciowej, sieciowych grup zabezpieczeń i dostępu do punktu końcowego aplikacji internetowej chronionego za pomocą zapory aplikacji internetowej .

Zarządzanie autoryzacją

Środowiska sztucznej inteligencji i uczenia maszynowego działające na platformie Azure muszą być zintegrowane z głównym systemem aprowizacji kont organizacji, w którym żądania udzielenia dostępu do krytycznych aplikacji biznesowych są przesyłane, zatwierdzane i poddawane inspekcji.

Oczekuje się, że systemy aprowizacji kont będą łączyć się z usługami Active Directory i Microsoft Entra ID w organizacji, tak aby role autoryzacji biznesowej mapowane na odpowiednie grupy zabezpieczeń usługi Active Directory i firmy Microsoft Entra.

Środowiska sztucznej inteligencji i uczenia maszynowego są zgodne z modelem kontroli dostępu opartej na rolach. Autoryzacje kontroli poziomu dostępu zapewniają, że użytkownicy mogą wykonywać tylko zadania i akcje dla ich roli i wymagań biznesowych. Przypadki użycia uczenia maszynowego powinny być wysoce segregowane, ponieważ analitycy danych pracujący w konkretnym przypadku użycia mogą uzyskiwać dostęp tylko do części zasobów tego przypadku użycia, zgodnie z zasadą najniższych uprawnień. Te zasoby mogą obejmować:

- Konta magazynu

- Obszary robocze usługi Azure Machine Learning

- Wystąpienia obliczeniowe

Kontrola dostępu oparta na rolach używa grup zabezpieczeń w usłudze Microsoft Entra ID.

Uwierzytelnianie wieloskładnikowe

Uwierzytelnianie wieloskładnikowe musi być wdrożone i zaimplementowane w celu uzyskania dostępu do wszystkich środowisk działających na platformie Azure i sklasyfikowanych jako duży wpływ na działalność biznesową. Uwierzytelnianie wieloskładnikowe można wymusić przy użyciu usług uwierzytelniania wieloskładnikowego firmy Microsoft. Punkty końcowe aplikacji — w tym Azure DevOps, Azure Management Portal, Azure Machine Edukacja, Azure Databricks i Azure Kubernetes Services — powinny być konfigurowane w zasadach kontroli dostępu uwierzytelniania wieloskładnikowego.

Uwierzytelnianie wieloskładnikowe musi być wymuszane dla wszystkich użytkowników, w tym menedżerów usług platformy Azure, inżynierów danych i analityków danych.

Doskonałość operacyjna

Doskonałość operacyjna obejmuje procesy operacyjne, które wdrażają aplikację i działają w środowisku produkcyjnym. Aby uzyskać więcej informacji, zobacz Omówienie filaru doskonałości operacyjnej.

Rejestrowanie i monitorowanie

Wszystkie usługi platformy Azure muszą pozyskiwać zdarzenia zabezpieczeń do platformy SOC (Security Operations Center) organizacji, a należy zarejestrować następujące zdarzenia zabezpieczeń:

- Pomyślne i nieudane próby uwierzytelnienia

- Dostęp do poufnych danych

- Zmiany zasad zabezpieczeń

- Zmiany w grupach użytkowników administracyjnych, użytkownikach lub rolach

- Poufne transfery danych do lokalizacji zewnętrznych, jeśli ma to zastosowanie

- Aktywacja i dezaktywacja systemów ochrony, takich jak kontrola dostępu oparta na atrybutach (ABAC)

- Zaktualizowano dostęp do dzienników i przerwy w rejestrowaniu

Dzienniki zabezpieczeń platformy Azure można pozyskiwać do soc za pomocą różnych wzorców:

- Centralny obszar roboczy usługi Azure Log Analytics

- Centrum zdarzeń połączone z systemami platform SOC, takimi jak Splunk

- Maszyna wirtualna z systemem Windows i inne zasoby obliczeniowe wdrożone za pomocą agentów SOC

DevOps

W środowiskach regulowanych systemy IT muszą przestrzegać rygorystycznych procesów kontroli jakości w stylu kaskadowym, z formalnymi zatwierdzeniami (lub bramami) między fazami procesu — takimi jak specyfikacje wymagań użytkownika, specyfikacje funkcjonalne, projekt i specyfikacje testowania lub podobne — z obszerną i czasochłonną dokumentacją pomocniczą.

Środowiska platformy Azure i programowanie nauki o danych są zgodne z procesami iteracyjnymi, zakotwiczonymi w kulturze DevOps. Znaczne nakłady pracy związane ze skalowaniem sztucznej inteligencji i inicjatywami uczenia maszynowego polegają na komunikowaniu filarów organizacji DevOps i tworzeniu zautomatyzowanego kompleksowego mapowania możliwości śledzenia między epikami, funkcjami, historiami użytkowników, planami testów i potokami ciągłej integracji/ciągłego wdrażania oraz wymaganymi jednostkami kontroli jakości i dowodami.

Efektywność wydajności

Efektywność wydajności to możliwość skalowania obciążenia w celu zaspokojenia zapotrzebowania użytkowników w wydajny sposób. Aby uzyskać więcej informacji, zobacz Omówienie filaru wydajności.

Aby skalować sztuczną inteligencję i uczenie maszynowe w regulowanych środowiskach oraz prowadzić szybkie wdrażanie w obszarach biznesowych organizacji, zalecamy zaprojektowanie i wdrożenie struktury wdrażania w celu mierzenia, monitorowania i oceniania wartości utworzonej przez usługi platformy Azure. Na podstawie naszego przykładu nauk o życiu i branży opieki zdrowotnej następujące dźwignie biznesowe i kluczowe wskaźniki wydajności (KPI) zostały ocenione:

Skalowalność — aby zapewnić, że architektura platformy Azure może być skalowana wraz z wymaganiami biznesowymi, niezależnie od punktu skalowania, sugerowane są następujące kluczowe wskaźniki wydajności:

- Liczba wystąpień obliczeniowych oraz łączna ilość używanego magazynu i pamięci

- Liczba uruchomionych eksperymentów

- Liczba wdrożonych modeli

Przyspieszanie opracowywania sztucznej inteligencji — w celu przyspieszenia opracowywania rozwiązań sztucznej inteligencji i uczenia maszynowego sugerowane są następujące wskaźniki KPI:

- Liczba różnych jednostek biznesowych zużywających sztuczną inteligencję platformy Azure i usługi uczenia maszynowego

- Liczba użytkowników dołączonych, na kategorię — na przykład inżynierów danych, analityków danych, analityków danych obywateli i użytkowników biznesowych

- Liczba uruchomionych eksperymentów

- Czas między dołączaniem użytkowników a aktywnym użyciem

- Czas aprowizacji usług — od żądania zmiany konfiguracji do ukończenia aprowizacji usług

Zgodność — aby zapewnić ciągłą zgodność wdrożonych rozwiązań sztucznej inteligencji i uczenia maszynowego, sugerowane są następujące kluczowe wskaźniki wydajności:

- Ogólne współzadowolenie z odpowiednimi kontrolkami ISRM

- Liczba ostrzeżeń dotyczących luk w zabezpieczeniach

- Liczba zdarzeń zabezpieczających w ostatnim okresie

Środowisko użytkownika — aby zapewnić dostępność wysokiej jakości i spójnych środowisk użytkownika, sugerowane są następujące wskaźniki KPI:

- Liczba żądań pomocy technicznej użytkowników

- Wynik promotora netto (NPS)

Secure Foundations — aby zapewnić bezpieczeństwo i bezpieczeństwo fundamentów, sugerowane są następujące kluczowe wskaźniki wydajności:

- Czas pracy usług krytycznych

- Liczba zgłoszonych zdarzeń związanych z dostępnością wydajności

Optymalizacja kosztów

Optymalizacja kosztów dotyczy sposobów zmniejszenia niepotrzebnych wydatków i poprawy wydajności operacyjnej. Aby uzyskać więcej informacji, zobacz Omówienie filaru optymalizacji kosztów.

Zarządzanie kosztami jest ważną częścią projektowania w implementacji skalowalnych platform sztucznej inteligencji i uczenia maszynowego, ponieważ koszty działania nie są zgodne z prostymi i przewidywalnymi wzorcami. Koszt jest oparty głównie na liczbie i rozmiarze eksperymentów sztucznej inteligencji i uczenia maszynowego wykonywanych na platformie, a dokładniej na liczbie i jednostkach SKU zasobów obliczeniowych używanych w trenowaniu modelu i wnioskowaniu.

Poniżej przedstawiono kilka rozwiązań, które zalecamy:

- Przypisz każdy przypadek użycia oraz sztuczną inteligencję i uczenie maszynowe własnego budżetu usług platformy Azure, co jest dobrym rozwiązaniem w zakresie zarządzania kosztami.

- Ustanów przejrzysty model kosztów dla usług udostępnionych platformy.

- Używaj tagów spójnie, aby skojarzyć przypadki użycia i zasoby produktów z centrami kosztów.

- Skorzystaj z usług Azure Advisor i Azure Budget, aby dowiedzieć się, gdzie zasoby nie są używane w najbardziej optymalny sposób i regularnie przeglądać konfiguracje.

Współautorzy

Ten artykuł jest obsługiwany przez firmę Microsoft. Pierwotnie został napisany przez następujących współautorów.

Główny autor:

- Eran Sagi | Architekt rozwiązań sztucznej inteligencji

Następne kroki

Dowiedz się, jak trenować i wdrażać modele oraz zarządzać cyklem życia uczenia maszynowego za pomocą usługi Azure Machine Edukacja. Samouczki, przykłady kodu, dokumentacja interfejsu API i inne dostępne tutaj:

Dowiedz się, jak zaimplementować strefę docelową o skali przedsiębiorstwa na potrzeby analizy danych i sztucznej inteligencji na platformie Azure:

Dokumentacja produktu:

Powiązane zasoby

Artykuły o centrum architektury platformy Azure: