Akcelerator strefy docelowej obliczeń o wysokiej wydajności (HPC) platformy Azure

Akcelerator strefy docelowej obliczeń o wysokiej wydajności (HPC) automatyzuje wdrażanie środowiska. To środowisko zapewnia podstawową strukturę, którą można dostosować w celu utworzenia kompleksowego mechanizmu wdrażania kompletnego rozwiązania klastra HPC na platformie Azure. Akcelerator to kolekcja skryptów i szablonów typu open source, które mogą przygotować strefy docelowe w skali przedsiębiorstwa. Może ona zapewnić konkretne podejście architektoniczne i implementację referencyjną zgodną z architekturą i najlepszymi rozwiązaniami przewodnika Cloud Adoption Framework.

Klienci wdrażają obliczenia HPC na różne sposoby, aby odpowiadać ich potrzebom biznesowym, i można dostosować akcelerator strefy docelowej HPC do tworzenia architektury pasującą do Twoich potrzeb. Użycie akceleratora pomaga umieścić organizację na drodze do zrównoważonej skali.

Implementowanie strefy docelowej w skali przedsiębiorstwa

Akcelerator strefy docelowej HPC zakłada, że zaczynasz od strefy docelowej o skali przedsiębiorstwa, która została pomyślnie zaimplementowana. Aby uzyskać więcej informacji na temat tego wymagania wstępnego, zobacz następujące artykuły:

- Rozpoczynanie pracy ze strefami docelowymi w skali przedsiębiorstwa w przewodniku Cloud Adoption Framework

- Implementowanie stref docelowych w skali przedsiębiorstwa w usłudze Cloud Adoption Framework na platformie Azure

Co zapewnia akcelerator strefy docelowej HPC

Podejście do stref docelowych akceleratora strefy docelowej HPC zapewnia następujące zasoby w projekcie:

- Podejście modułowe, dzięki czemu można dostosować zmienne środowiskowe

- Wskazówki dotyczące projektowania ułatwiające ocenę krytycznych decyzji

- Architektura strefy docelowej

- Implementacja obejmująca następujące elementy:

- Możliwe do wdrożenia odwołanie umożliwiające utworzenie środowiska dla wdrożenia HPC

- Implementacja referencyjna HPC zatwierdzona przez firmę Microsoft w celu przetestowania wdrożonego środowiska

Wytyczne dotyczące projektowania dla energii, produkcji i finansów

Architektury stref docelowych różnią się w zależności od sektora biznesowego, a także różnią się w zależności od organizacji. W tej sekcji wymieniono artykuły według sektora, które zawierają wskazówki dotyczące tworzenia strefy docelowej:

Energia (Ropa naftowa i gaz)

- Rozliczenia platformy Azure i dzierżawy firmy Microsoft dla energii HPC

- Zarządzanie tożsamościami i dostępem dla usługi Azure HPC w środowisku energetycznym

- Zarządzanie usługą Azure HPC w branży energetycznej

- Topologia sieci i łączność dla usługi Azure HPC w energii

- Automatyzacja platformy i metodyka DevOps dla usługi Azure HPC w zakresie energii

- Organizacja zasobów dla HPC w branży energetycznej

- Nadzór nad hpc w branżach energetycznych

- Zabezpieczenia hpc platformy Azure w energetyce

- Obliczanie obciążeń aplikacji HPC na dużą skalę na maszynach wirtualnych platformy Azure

- Magazyn dla środowisk energetycznych HPC

Manufacturing

- Produkcja rozliczeń platformy Azure HPC i dzierżaw usługi Active Directory

- Zarządzanie tożsamościami i dostępem platformy Azure na potrzeby obliczeń HPC w produkcji

- Zarządzanie hpc w branży produkcyjnej

- Produkcja topologii sieci HPC i łączności

- Automatyzacja platformy i metodyka DevOps dla usługi Azure HPC w branży produkcyjnej

- Produkcja organizacji zasobów HPC

- Nadzór nad platformą Azure na potrzeby produkcji HPC

- Bezpieczeństwo hpc w branżach produkcyjnych

- Produkcja magazynu HPC

Finanse

- Oferty rozliczeniowe platformy Azure i dzierżawy usługi Active Directory dla finansów HPC

- Zarządzanie tożsamościami i dostępem na platformie Azure w usłudze HPC

- Zarządzanie hpc w sektorze finansowym

- Topologia sieci i łączność hpc w sektorze finansowym

- Automatyzacja platformy i metodyka DevOps dla HPC w sektorze finansowym

- Organizacja zasobów dla usługi Azure HPC w sektorze finansowym

- Nadzór nad finansami HPC

- Bezpieczeństwo hpc w sektorze finansowym

- Magazyn dla HPC w sektorze finansowym

Wskazówki dotyczące projektowania dotyczące wybierania obliczeń HPC dla obciążeń sztucznej inteligencji

Wybór odpowiedniej jednostki SKU zoptymalizowanej pod kątem procesora GPU pod kątem obciążeń sztucznej inteligencji jest ważne w celu optymalizacji wydajności i kontrolowania kosztów. Firma Microsoft oferuje wiele różnych jednostek SKU zoptymalizowanych pod kątem obciążeń, które korzystają z większej mocy procesora GPU. Podczas wybierania odpowiedniej jednostki SKU dla obciążeń sztucznej inteligencji należy wziąć pod uwagę kilka zagadnień. Mniejsze obciążenia mogą korzystać tylko z części procesora CPU, procesora GPU i przepustowości bardziej zaawansowanych jednostek SKU, takich jak NDv4. W przypadku mniejszych zadań warto rozważyć inne jednostki SKU obliczeniowe, takie jak NCv4 i NDv2. Poniżej przedstawiono kilka zagadnień dotyczących wybierania odpowiedniej jednostki SKU zoptymalizowanej pod kątem procesorów GPU dla obciążeń sztucznej inteligencji:

- Punktowanie kontrolne. Podczas uruchamiania modeli uczenia maszynowego należy wziąć pod uwagę czynniki, takie jak interwał punktu kontrolnego. Może to mieć wpływ na wydajność procesora GPU w fazie trenowania. Zachowanie równowagi między wydajnością magazynu a utrzymywaniem płynnych operacji procesora GPU. Monitorowanie użycia procesora GPU.

- Wnioskowania. Wymagania dotyczące wnioskowania różnią się od wymagań szkoleniowych, a możliwe wyższe obciążenie procesora CPU może maksymalnie przewyższać wydajność procesora CPU. Podczas wybierania jednostki SKU obliczeniowej należy wziąć pod uwagę wymagania dotyczące wnioskowania modelu. Monitoruj użycie procesora CPU.

- Trenowanie. Należy wziąć pod uwagę wymagania modelu podczas trenowania, monitorując użycie procesora CPU i procesora GPU.

- Ustalanie rozmiaru zadania. Podczas rozważania jednostki SKU obliczeniowej dla obciążeń sztucznej inteligencji należy wziąć pod uwagę rozmiar zadania. Mniejsze zadania, takie jak te w przybliżeniu OPT 1.3B, mogą nie korzystać z większych rozmiarów jednostek SKU i mogą pozostawić bezczynność procesora CPU i procesora GPU w zależności od etapu zadania (wnioskowanie, trenowanie).

- Przepustowości. Większa, niższa przepustowość opóźnienia może być kosztem, gdy nie jest używana. Rozważ użycie narzędzia InfiniBand tylko dla największych modeli, które będą wymagały dodatkowej przepustowości.

Wyświetlanie rozmiarów maszyn wirtualnych zoptymalizowanych pod kątem procesora GPU platformy Azure.

Przykład: koncepcyjna architektura referencyjna dla energii

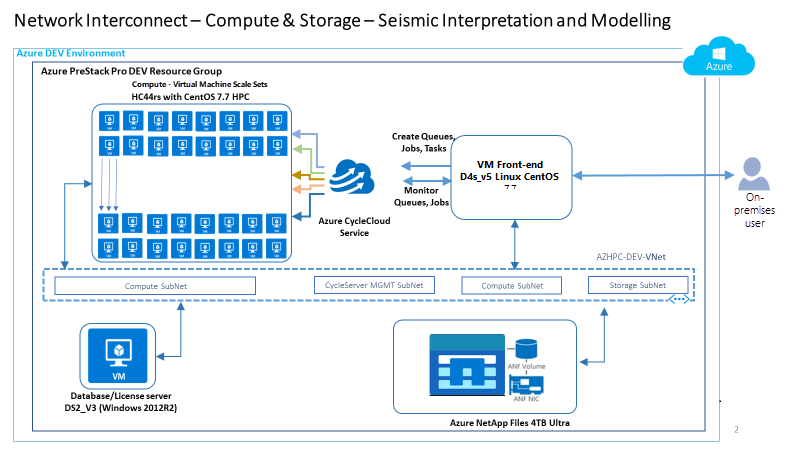

Poniższa architektura referencyjna koncepcyjna to przykład pokazujący obszary projektowe i najlepsze rozwiązania dotyczące środowisk energetycznych .

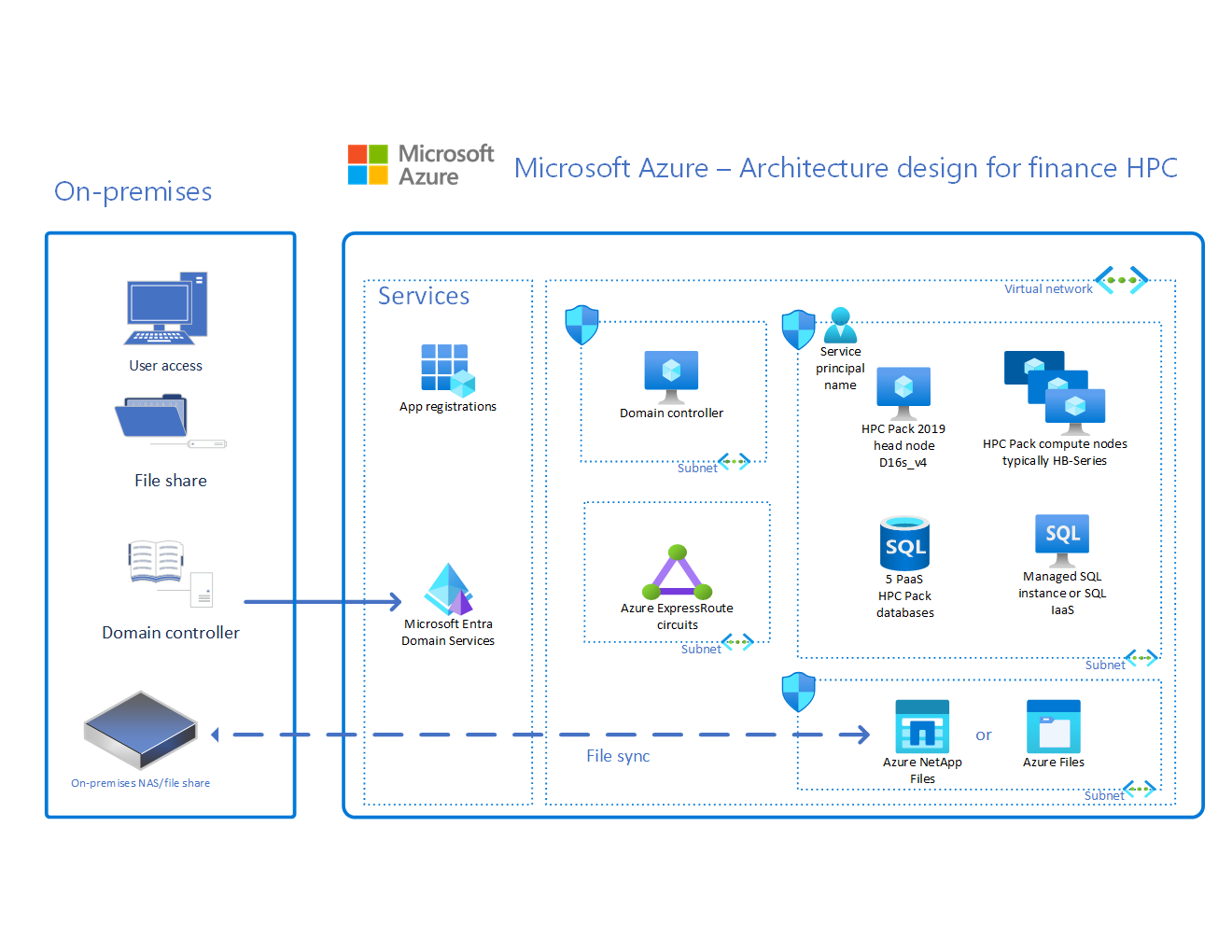

Przykład: architektura referencyjna koncepcyjna dla finansów

Poniższa architektura referencyjna koncepcyjna to przykład pokazujący obszary projektowe i najlepsze rozwiązania dotyczące środowisk finansowych .

Przykład: koncepcyjna architektura referencyjna dla produkcji

Poniższa architektura referencyjna koncepcyjna to przykład pokazujący obszary projektowe i najlepsze rozwiązania dotyczące środowisk produkcyjnych .

Uzyskiwanie akceleratora strefy docelowej HPC

Akcelerator strefy docelowej HPC jest dostępny w witrynie GitHub: Akcelerator platformy Azure HPC OnDemand

Następne kroki

Aby zapoznać się z zagadnieniami i zaleceniami dotyczącymi architektury akceleratora strefy docelowej HPC, zapoznaj się z krytycznymi obszarami projektowymi akceleratora strefy docelowej HPC w usłudze Azure Identity and Access Management.