Nuta

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować się zalogować lub zmienić katalog.

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować zmienić katalogi.

Usługa Azure Container Apps zapewnia dostęp do procesorów GPU na żądanie bez konieczności zarządzania podstawową infrastrukturą. Jako funkcja bezserwerowa płacisz tylko za używane procesory GPU. Po włączeniu liczba procesorów GPU używanych dla aplikacji rośnie i spada w celu spełnienia wymagań dotyczących obciążenia aplikacji. Bezserwerowe procesory GPU umożliwiają bezproblemowe uruchamianie obciążeń z automatycznym skalowaniem, zoptymalizowanym zimnym startem, rozliczeniami na sekundę ze skalowaniem w dół do zera, gdy nie są używane, i zmniejszenie nakładu pracy operacyjnej.

Bezserwerowe procesory GPU są obsługiwane tylko w przypadku profilów obciążeń Zużycie. Ta funkcja nie jest obsługiwana w środowiskach tylko do użycia.

Uwaga

Aby uzyskać dostęp do GPU, należy zażądać przydziałów na GPU. Żądanie limitu przydziału procesora GPU można przesłać za pośrednictwem zgłoszenia do pomocy technicznej klienta.

Świadczenia

Bezserwerowe procesory GPU przyspieszają opracowywanie sztucznej inteligencji, umożliwiając skoncentrowanie się na podstawowym kodzie sztucznej inteligencji i mniej na zarządzaniu infrastrukturą podczas korzystania z procesorów GPU. Ta funkcja zapewnia opcję warstwy pośredniej między katalogiem modeli Azure AI a bezserwerowymi interfejsami API oraz modelami hostingu na zarządzanych zasobach obliczeniowych.

Bezserwerowa obsługa procesora GPU usługi Container Apps zapewnia pełny nadzór nad danymi, ponieważ dane nigdy nie opuszczają granic kontenera, zapewniając jednocześnie zarządzaną, bezserwerową platformę, z której można tworzyć aplikacje.

Używając bezserwerowych procesorów GPU w usłudze Container Apps, Twoje aplikacje otrzymują:

Procesory GPU skalowane do zera: obsługa automatycznego skalowania bezserwerowego procesorów GPU NVIDIA A100 i NVIDIA T4.

Rozliczanie za sekundę: płacisz tylko za używane zasoby obliczeniowe procesora GPU.

Wbudowany nadzór nad danymi: Dane nigdy nie opuszczają granicy kontenera.

Elastyczne opcje obliczeniowe: możesz wybrać typy procesorów GPU NVIDIA A100 lub T4.

Warstwa środkowa na potrzeby tworzenia sztucznej inteligencji: wprowadź własny model na zarządzanej, bezserwerowej platformie obliczeniowej.

Typowe scenariusze

W poniższych scenariuszach opisano typowe przypadki użycia bezserwerowych procesorów GPU.

Wnioskowanie w czasie rzeczywistym i wsadowe: używaj niestandardowych modeli typu open source z szybkim czasem uruchamiania, automatycznym skalowaniem i modelem rozliczeniowym na sekundę. Bezserwerowe procesory GPU są idealne dla aplikacji dynamicznych. Płacisz tylko za zasoby obliczeniowe, z których korzystasz, a aplikacje są automatycznie skalowane w poziomie, aby sprostać zapotrzebowaniu.

Scenariusze uczenia maszynowego: znacznie przyspieszają aplikacje implementujące dostosowane niestandardowe modele sztucznej inteligencji, uczenie głębokie, sieci neuronowe lub analizę danych na dużą skalę.

High-Performance Computing (HPC): użyj procesorów GPU jako zasobów dla dużych wymagań obliczeniowych w aplikacjach, które wymagają złożonych obliczeń i symulacji, takich jak obliczenia naukowe, modelowanie finansowe lub prognozowanie pogody.

Renderowanie i wizualizacja: użyj procesorów GPU, aby przyspieszyć proces renderowania i włączyć wizualizację w czasie rzeczywistym w aplikacjach obejmujących renderowanie 3D, przetwarzanie obrazów lub transkodowanie wideo.

Analiza danych big data: procesory GPU mogą przyspieszyć przetwarzanie i analizę danych wśród ogromnych zestawów danych.

Kwestie wymagające rozważenia

Podczas korzystania z bezserwerowych procesorów GPU należy pamiętać o następujących elementach:

Wersja CUDA: bezserwerowe procesory GPU obsługują najnowszą wersję CUDA.

Ograniczenia pomocy technicznej:

- Tylko jeden kontener w aplikacji może używać procesora GPU jednocześnie. Jeśli masz wiele kontenerów w aplikacji, pierwszy kontener uzyskuje dostęp do procesora GPU.

- Wiele aplikacji może współużytkować ten sam profil obciążenia procesora GPU, ale każda z nich wymaga własnej repliki.

- Repliki wielo i ułamkowe procesora GPU nie są obsługiwane.

- Pierwszy kontener w aplikacji uzyskuje dostęp do procesora GPU.

Adresy IP: GPU konsumpcyjne używają jednego adresu IP na replikę podczas konfigurowania integracji z własną siecią wirtualną.

Obsługiwane regiony

Bezserwerowe procesory GPU są dostępne w następujących regionach:

| Rejon | A100 | T4 |

|---|---|---|

| Australia Wschodnia | Tak | Tak |

| Brazylia Południowa | Tak | Tak |

| Indie Środkowe | Nie. | Tak |

| Wschodnie stany USA | Tak | Tak |

| Francja Środkowa | Nie. | Tak |

| Włochy Północne | Tak | Tak |

| Japonia Wschodnia | Nie. | Tak |

| Północno-środkowe stany USA | Nie. | Tak |

| Południowo-środkowe stany USA | Nie. | Tak |

| Azja Południowo-Wschodnia | Nie. | Tak |

| Indie Południowe | Nie. | Tak |

| Szwecja Środkowa | Tak | Tak |

| Europa Zachodnia1 | Nie. | Tak |

| Zachodnie stany USA | Tak | Tak |

| Zachodnie stany USA 2 | Nie. | Tak |

| Zachodnie stany USA 3 | Tak | Tak |

1 Aby dodać profil obciążenia procesora GPU bezserwerowego T4 w regionie Europa Zachodnia, należy utworzyć nowe środowisko profilu obciążenia.

Korzystanie z procesorów GPU bezserwerowych

Podczas tworzenia aplikacji kontenera za pośrednictwem witryny Azure Portal możesz skonfigurować kontener do korzystania z zasobów procesora GPU.

Na karcie Kontener procesu tworzenia ustaw następujące ustawienia:

W sekcji Alokacja zasobów kontenera zaznacz pole wyboru GPU .

W polu Typ procesora GPU wybierz opcję NVIDIA A100 lub NVIDIA T4.

Zarządzanie profilem obciążenia bezserwerowego procesora GPU

Bezserwerowe GPU działają zgodnie z profilami obciążenia GPU opartymi na zużyciu. Zarządzasz profilem obciążenia zużycia GPU w taki sam sposób, jak każdym innym profilem obciążenia. Profil obciążenia można zarządzać przy użyciu interfejsu wiersza polecenia lub witryny Azure Portal.

Żądanie bezserwerowego limitu przydziału procesora GPU

Uwaga

Klienci z umowami Enterprise Agreement i płatnością zgodnie z rzeczywistym użyciem mają domyślnie włączone limity przydziału A100 i T4.

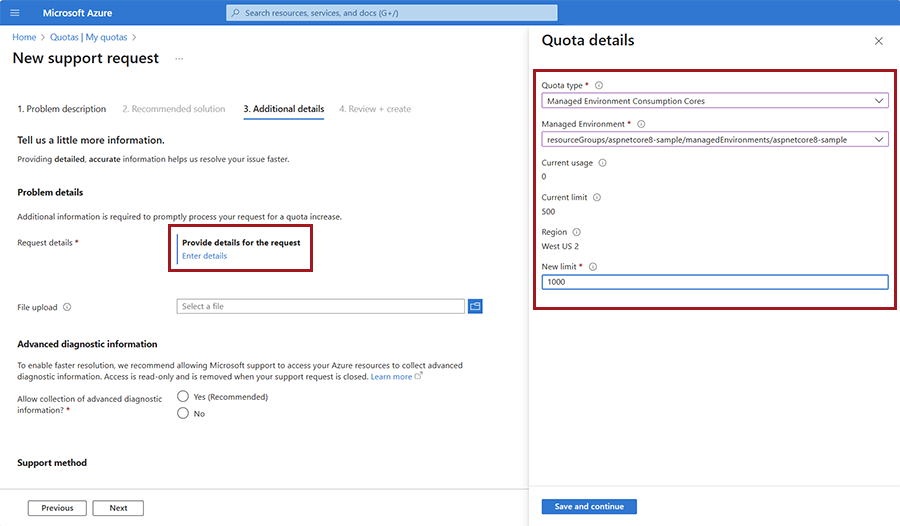

Aby uzyskać dostęp do tej funkcji, potrzebujesz bezserwerowego limitu przydziału procesora GPU. Żądanie limitu przydziału procesora GPU można przesłać za pośrednictwem zgłoszenia do pomocy technicznej klienta. Podczas otwierania zgłoszenia do pomocy technicznej dla żądania limitu przydziału procesora GPU wybierz następujące opcje:

Otwórz formularz Nowy wniosek o pomoc techniczną w witrynie Azure Portal.

Wprowadź następujące wartości w formularzu:

Majątek Wartość Typ problemu Wybierz pozycję Limity usług i subskrypcji (limity przydziału) Subscription Wybierz swoją subskrypcję. Typ limitu przydziału Wybierz aplikacje kontenerowe. Wybierz Dalej.

W oknie Dodatkowe szczegóły wybierz pozycję Wprowadź szczegóły , aby otworzyć okno szczegółów żądania.

W obszarze Typ limitu wybierz pozycję Konsumpcja środowiska zarządzanego NCA100 GPUs lub Konsumpcja środowiska zarządzanego T4 GPUs. Wprowadź inne wartości.

Wybierz przycisk Zapisz i kontynuuj.

Wypełnij pozostałe odpowiednie szczegóły w oknie Dodatkowe szczegóły .

Wybierz Dalej.

Wybierz Utwórz.

Ulepszanie zimnego uruchamiania procesora GPU

Możesz znacznie poprawić czas zimnego startu, włączając przesyłanie strumieniowe artefaktów i lokalizowanie dużych plików, takich jak duże modele językowe, w instalacji magazynu.

Przesyłanie strumieniowe artefaktów: usługa Azure Container Registry oferuje przesyłanie strumieniowe obrazów, co może znacznie przyspieszyć czas uruchamiania obrazu. Aby korzystać z przesyłania strumieniowego artefaktów, musisz hostować obrazy kontenerów w Azure Container Registry wersji Premium.

Punkty montowania pamięci: Zmniejsz skutki opóźnienia sieci, przechowując duże pliki na koncie usługi Azure Storage skojarzonym z aplikacją kontenerową.

Wdrażanie modeli foundry na bezserwerowych procesorach GPU (wersja zapoznawcza)

Bezserwerowe procesory GPU usługi Azure Container Apps obsługują teraz modele usługi Azure AI Foundry w publicznej wersji zapoznawczej. Modele rozwiązania Azure AI Foundry mają dwie opcje wdrażania:

Bezserwerowe interfejsy API, które zapewniają rozliczanie zgodnie z rzeczywistym użyciem dla niektórych z najpopularniejszych modeli.

Zarządzane zasoby obliczeniowe , które umożliwiają wdrożenie pełnego wyboru modeli Foundry przy użyciu cennika płatności za procesor GPU.

Usługa bezserwerowych GPU w Azure Container Apps oferuje zrównoważoną opcję wdrażania pomiędzy bezserwerowymi interfejsami API a zarządzanymi obliczeniami, umożliwiającą wdrażanie modeli Foundry. Ta opcja jest dostępna na żądanie ze skalowaniem bezserwerowym, które zmniejsza się do zera, gdy nie jest używane i odpowiada wymaganiom dotyczącym rezydencji danych. W przypadku bezserwerowych systemów GPU korzystanie z modeli Foundry zapewnia elastyczność uruchamiania dowolnego obsługiwanego modelu z automatycznym skalowaniem, płatnością za sekundę, pełnym ładem danych, gotową obsługą sieci i zabezpieczeń przedsiębiorstwa.

Obsługiwane są modele językowe typu MLFLOW . Aby wyświetlić listę MLFLOW modeli, przejdź do listy modeli dostępnych w rejestrze azureml. Aby zlokalizować modele, dodaj filtr dla MLFLOW modeli, wykonując następujące kroki:

Wybierz Filtruj.

Wybierz Dodaj filtr.

W przypadku reguły filtru wprowadź typ = MLFLOW.

W przypadku modeli wymienionych tutaj w repozytorium usługi Azure Container Apps można wdrożyć je bezpośrednio w bezserwerowych procesorach GPU bez konieczności kompilowania własnego obrazu przy użyciu następującego polecenia interfejsu wiersza polecenia:

az containerapp up \

--name <CONTAINER_APP_NAME> \

--location <LOCATION> \

--resource-group <RESOURCE_GROUP_NAME> \

--model-registry <MODEL_REGISTRY_NAME> \

--model-name <MODEL_NAME> \

--model-version <MODEL_VERSION>

W przypadku dowolnego modelu, który nie znajduje się na tej liście, musisz:

Pobierz szablon GitHub dla obrazu modelu z repozytorium Azure Container Apps.

Zmodyfikuj plik score.py, aby był zgodny z typem modelu. Skrypt oceniania (o nazwie score.py) definiuje sposób interakcji z modelem. W poniższym przykładzie pokazano , jak używać niestandardowego pliku score.py.

Skompiluj obraz i wdróż go w rejestrze kontenerów.

Użyj poprzedniego polecenia interfejsu wiersza polecenia, aby wdrożyć model na bezserwerowych procesorach GPU, ale określ parametr

--image. W przypadku korzystania z parametrów--model-registry,--model-namei--model-version, kluczowe zmienne środowiskowe są ustawiane w celu optymalizacji zimnego startu aplikacji.

Prześlij opinię

Przesyłanie problemów do repozytorium GitHub usługi Azure Container Apps.